[Bemerkung: Alle der zahlreichen Hervorhebungen in diesem Beitrag sind aus dem Original übernommen! Anm. d. Übers.]

Die widerlegte CAGW-Hypothese ging davon aus, dass der gestiegene atmosphärische CO2-Gehalt durch die Verbrennung fossiler Treibstoffe eine gefährliche runaway-globale Erwärmung auslöst. Die vermeintlichen Beweise für diesen Betrug sind lediglich Klima-Computermodelle, welche die gegenwärtige gemessene Erwärmung drastisch übertreiben, im Mittel um 300% bis 500%. In diese Klimamodelle gehen absichtlich viel zu hohe Werte der Klima-Sensitivität von CO2 ein, und sie sind so programmiert, dass sie falschen Alarm geben.

Seit Mitte der 1990er Jahre hat sich die globale Erwärmung verlangsamt, so dass die Klima-Alarmisten jetzt behaupteten, dass der gestiegene atmosphärische CO2-Gehalt zu extremerem und chaotischerem Wetter führen werde. Es gibt aber vielfache Beweise, dass diese Behauptung ebenfalls falsch ist (hier). In Wirklichkeit ist das Wetter weniger chaotisch geworden (hier).

Der Betrug ist reichlich belegt durch den Mann’schen Hockeyschläger (MBH98 etc.), die Klimagate-E-Mails, willkürliche Veränderungen historischer Temperaturaufzeichnungen und nicht zuletzt durch das aggressive Vorgehen der Klima-Extremisten.

All das sind hinreichende Beweise dafür, dass die/der durch CO2 verursachte globale Erwärmung/Klimawandel eine falsche Krise ist.

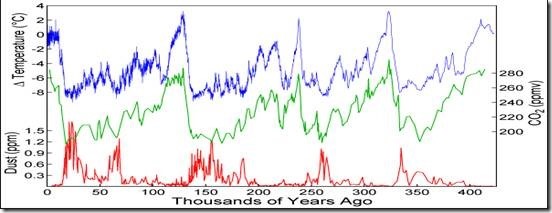

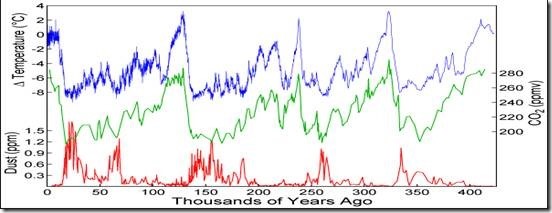

In früheren geologischen Epochen waren die atmosphärischen CO2-Konzentrationen sehr viel höher als heute, und zu einer runaway-globalen Erwärmung ist es während der Milliarden Jahre der Erdgeschichte niemals gekommen. Es gab geologische Epochen, während derer es viel wärmer und auch viel kälter war als heute. Die Erde befindet sich derzeit in einer glazialen Epoche. In einer solchen überdecken Kilometer dicke Eisschilde den Planeten etwa 100.000 Jahre lang. Sie wird von Zwischeneiszeiten unterbrochen, die jeweils etwa 10.000 Jahre dauern. Derzeit befindet sich die Erde in einer warmen Zwischeneiszeit, aber die letzte Vereisung endete schon vor 10.000 Jahren. Daraus lässt sich folgern, dass eine weitere Vereisungs-Epoche auf der Erde fällig ist.

Während der Mittelalterlichen Warmzeit etwa vom Jahre 900 bis zum Jahre 1300 lagen die Temperaturen viel höher als heute. Danach suchte die Kleine Eiszeit die Menschheit heim, etwa von 1300 bis 1850. Sie brachte enorme Leiden und den Tod von Millionen Menschen mit sich.

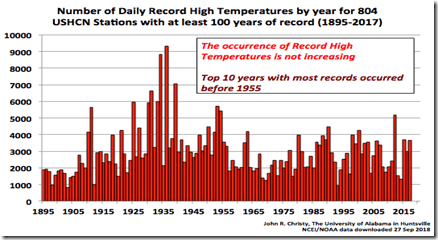

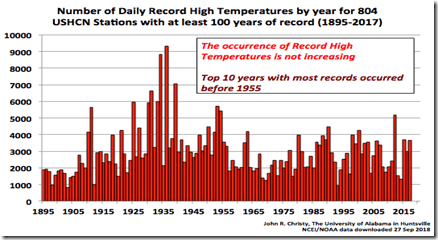

Aus den USA gibt es einige der besten Temperaturdaten der Welt. Die höchsten Temperaturen traten hier in den 1930er Jahren auf, bevor die Verbrennung fossiler Treibstoffe etwa ab 1940 in Fahrt kam:

Die Verbrennung fossiler Treibstoffe verstärkte sich zu Beginn des 2.Weltkriegs erheblich. Trotzdem gab es von 1940 bis 1977 eine signifikante ABKÜHLUNG! Diese eine Beobachtung reicht schon aus, um die CAGW-Hypothese zu widerlegen – die globalen Temperaturen steigen NICHT katastrophal infolge des zunehmenden CO2-Gehaltes.

Selbst wenn man einmal annimmt, dass die GESAMTE globale Erwärmung einem gestiegenen atmosphärischen CO2-Gehalt zugeordnet werden kann, berechneten die folgenden beiden Studien die MAXIMALE Klima-Sensitivität auf eine hypothetische atmosphärische CO2-Verdoppelung mit etwa 1°C, was viel zu wenig ist, um eine katastrophale globale Erwärmung auszulösen:

Christy und McNider (2017) analysierten Temperaturdaten aus der unteren Troposphäre seit 1979 (hier).

Lewis und Curry (2018) analysierten den HadCRUT4v5-Datensatz der Temperatur an der Erdoberfläche seit 1850 (hier)

Dieses 1°C pro Verdoppelung ist kein Mittelwert, sondern ein MAXIMUM der Klima-Sensitivität, da ein Teil der oder auch die gesamte beobachtete Erwärmung natürlichen Ursachen geschuldet sein könnte. Noch einmal: In die vom IPCC und anderen Alarmisten herangezogenen Klima-Computermodelle geht eine um das 3- bis 5-fache höhere Klima-Sensitivität ein, damit diese Modelle falsche Ängste bzgl. einer gefährlichen globalen Erwärmung erzeugen.

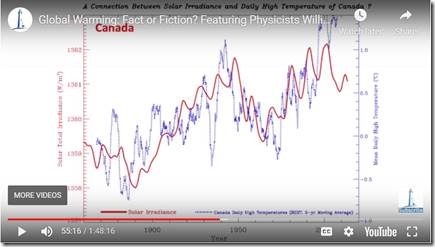

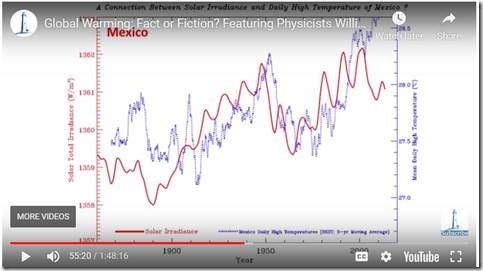

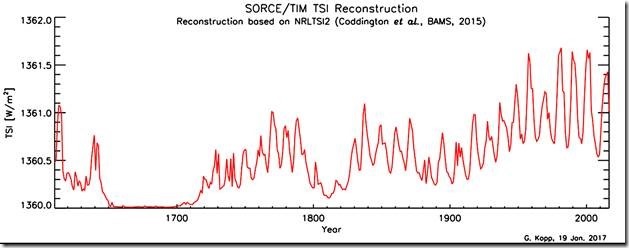

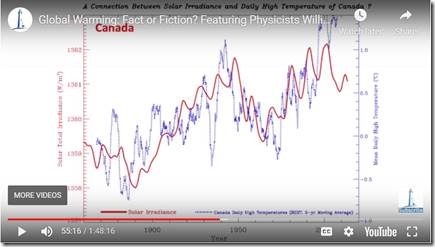

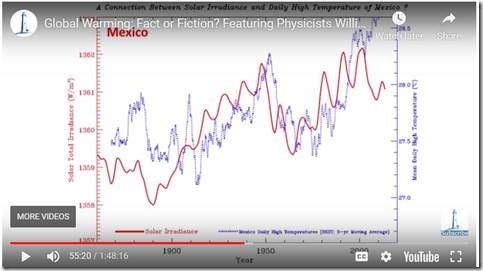

Es ist aufgrund der derzeitigen Beweislage höchst wahrscheinlich, dass die Sonnenaktivität und nicht das atmosphärische CO2 der primäre Treiber der Temperatur auf der Erde ist (hier). In diesem neuesten Video des Astrophysikers Willie Soon zeigt der die Relation zwischen Sonne und Klima ebenso wie die Belege für diese Relation. Es gibt eine starke Korrelation zwischen den täglichen Temperatur-Höchstwerten und der Gesamt-solaren Einstrahlung (TSI; 54:51 im Video:

… in den USA:

in Kanada (55:16):

und Mexiko (55:20):

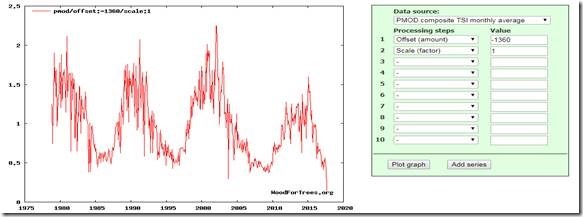

Die TSI liegt derzeit nahe 1360 W/m² und damit auf einem ähnlichen Niveau wie in den Tiefen sehr kalter Epochen wie etwa zwischen den Jahren 1700 und 1800. Die Temperaturen dürften daher in naher Zukunft sinken – vielleicht ist dies jetzt schon im Gange.

Wir wissen genau, dass sich die Sonne derzeit am Ende des Sonnenzyklus‘ 24 (SC24) befindet, dem schwächsten seit dem Dalton Minimum (ca. 1800+), und es wird erwartet, dass auch der SC25 sehr schwach ausfällt. Wir wissen ebenfalls, dass sowohl das Dalton- als auch das Maunder-Minimum (~1650 bis ~1700) sehr kalte Epochen waren, die erhebliches menschliches Leiden mit sich brachten.

Die globale Temperatur wird mit Sicherheit NICHT primär getrieben durch einen steigenden CO2-Gehalt in der Luft, weil Änderungen desselben globalen Temperaturänderungen zeitlich HINTERHER laufen. Das geht sowohl aus Proxys in Eisbohrkernen als auch in modernen Daten-Aufzeichnungen hervor. Dem Eisbohrkern aus Wostok zufolge beträgt die zeitliche Verzögerung einer Änderung des CO2-Gehaltes nach einer Erwärmung etwa 800 Jahre (hier).

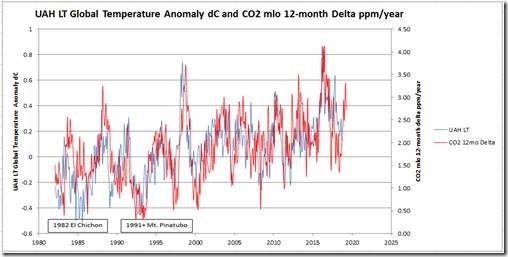

Im Januar 2008 veröffentlichte Allan MacRae die folgenden bedeutenden Beobachtungen in dieser Studie mit dem Titel „Carbon Dioxide Is Not The Primary Cause Of Global Warming”, Januar 2008 (Link).

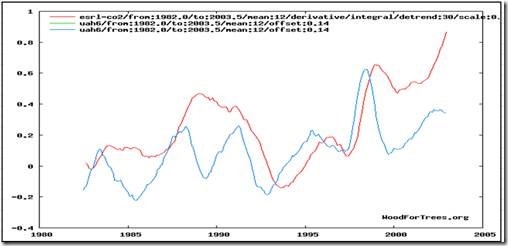

a) Die Abfolge der Änderungen des atmosphärischen CO2-Gehaltes (dCO2/dt) folgt weitgehend den Änderungen der globalen Temperatur.

b) Daher erfolgen die Änderungen des atmosphärischen CO2-Gehaltes der Integration von dCO2/dt zufolge ~ 9 Monate nach Änderungen der Temperatur.*

[*Das habe ich inhaltlich nicht verstanden. Erst war von 800 Jahren die Rede, jetzt von 9 Monaten. Wo liegt der Denkfehler? Anm. d. Übers.]

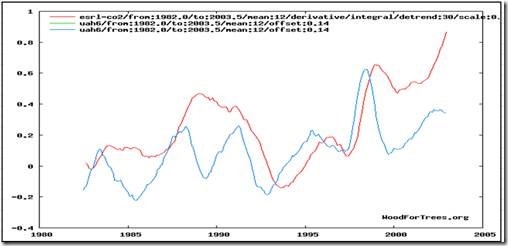

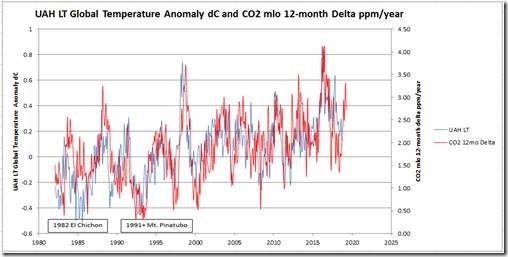

Die sehr enge Relation zwischen dCO2/dt (rot) und der globalen Temperatur (blau) tritt eindeutig hervor. Große Vulkanausbrüche (einige VE15- und die meisten VE16-Ereignisse) unterbrechen die Relation.

Die Integration der dCO2/dt-Daten ergibt die Änderungen des atmosphärischen CO2-Gehaltes, welche den Änderungen der Temperatur um ~ 9 Monate hinterher laufen.

Obige Graphiken enthalten Werte der am Mauna Loa gemessenen CO2-Daten. Ähnliche Ergebnisse zeigen sich in globalen CO2-Daten wie in Mac Rae (2008). Die Auswirkung großer Vulkanausbrüche ist offensichtlich.

Das 12-monatige Delta des CO2-Verlaufs spiegelt die „jahreszeitliche Sägezahn-Kurve“ in der Keeling-Kurve.

Die ~9-monatigen Verzögerungen atmosphärischer CO2-Änderungen (rot) nach Temperaturänderungen (blau) ist offensichtlich.

(Link)

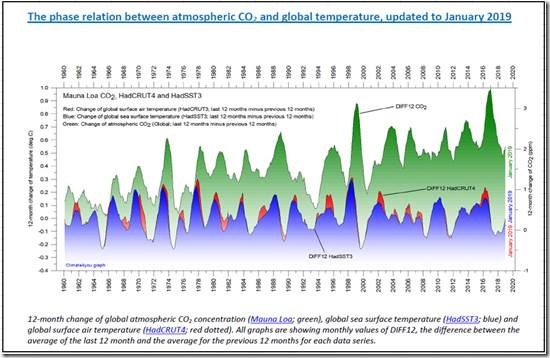

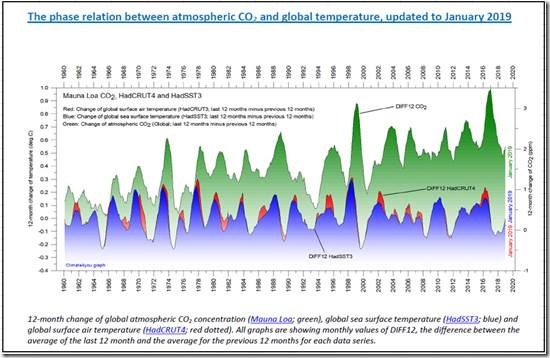

Im Jahre 2013 machten Humlum, Stordahl und Solheim eine ähnliche Entdeck ung: dass nämlich atmosphärische CO2-Änderungen der globalen Wasser- und Lufttemperatur um 9 bis 12 Monate hinterher laufen. Referenz: Die Studie mit dem Titel „The phase relation between atmospheric carbon dioxide and global temperature“ (Link):

a)Änderungen des globalen atmosphärischen CO2-Gehaltes laufen Änderungen der globalen Wassertemperatur um 11 bis 12 Monate hinterher

b) Änderungen des globalen atmosphärischen CO2-Gehaltes laufen Änderungen der globalen bodennahen Lufttemperatur um 9,5 bis 10 Monate hinterher.

c) Änderungen des globalen atmosphärischen CO2-Gehaltes laufen Änderungen der globalen niedertroposphärischen Lufttemperatur um etwa 9 Monate hinterher.

Die Phasen-Relation zwischen CO2-Gehalt der Atmosphäre und der Temperatur, Januar 2013:

Unsere prognostischen Ergebnisse erweisen sich im Nachhinein als exzellent. Das IPCC und seine Gefolgsleute lagen konsistent falsch.

Die Fähigkeit der Prognose ist die vermutlich beste objektive Maßzahl wissenschaftlicher Kompetenz. Das IPCC und dessen globale Erwärmung-Alarmisten sind konsistent gescheitert – keine einzige ihrer ängstigenden Prognosen bzgl. globale Erwärmung/Klimawandel ist eingetreten (hier).

Im Jahre 2002 schrieben die Autoren Dr. Sallie Baliunas (Astrophysikerin), Dr. Tim Patterson (Paläoklimatologe) und Allan MacRae hier:

„Die Klimawissenschaft stützt nicht die Theorie einer katastrophalen, vom Menschen verursachten globalen Erwärmung – die vermeintliche Erwärmungs-Krise existiert nicht.

Die ultimative Agenda der Kyoto-Propagandisten lautet, fossile Treibstoffe zu eliminieren, aber dies würde zu einer katastrophalen Verknappung der globalen Energieversorgung führen – die verschwenderischen, ineffizienten, von den Propagandisten ins Spiel gebrachten Lösungen bzgl. Energie können einfach kein Ersatz für fossile Treibstoffe sein“.

Beide Statements sind ganz offenbar bis dato zutreffend. Trotz einer Zunahme der Verbrennung fossiler Treibstoffe, vor allem ab dem Jahr 1940, und eines gemessenen gestiegenen atmosphärischen CO2-Gehaltes seit 1958 kam es lediglich zu sehr vorteilhaften Steigerungen der Erntemengen und einer milden, günstigen globalen Erwärmung.

Trotz der nunmehr Jahrzehnte langen Kampagne zur Eliminierung fossiler Treibstoffe haben diese immer noch einen Anteil von 85% an der globalen Primärenergie. Der Rest geht zumeist auf das Konto von Kern- und Wasserkraft. Trotz Zehner-Billionen an Subventionen verschwendeter Dollars deckt grüne Energie nur 4% der globalen Primärenergie. Infolge ihrer Intermittenz reduzieren grüne Energie-Programme bei der Einspeisung in das Netz nicht einmal deutlich die CO2-Emissionen, muss doch zu fast 100% eine Reserve, üblicherweise fossil erzeugt, bereit gehalten werden, die sofort abrufbar sein muss, wenn der Wind nicht weht und/oder die Sonne nicht scheint.

Entgegen der grünen Propaganda ist die CO2-Konzentration viel zu niedrig; auf der Erde ist es kälter als es für die Menschheit und die Umwelt optimal wäre.

Die atmosphärische CO2-Konzentration ist keineswegs zu hoch – sie ist vielmehr viel zu niedrig für optimales Pflanzenwachstum und den Getreideanbau – und viel zu niedrig für das fortgesetzte terrestrische Leben der Erde (hier). CO2-Reduktions- und Abscheidungs-Programme sind nicht nur falsch, sondern kostspielig, destruktiv und idiotisch [imbecilic].

Durch kaltes Wetter kommen 20 mal so viele Menschen zu Tode als durch warmes oder gar heißes Wetter (hier). In den USA belaufen sich exzessive Todesfälle im Winter im Mittel auf etwa 100.000 pro Jahr, das ist äquivalent zu 9 bis 11 Menschen pro Woche über 17 Wochen IN JEDEM JAHR!

Exzessive Todesfälle im Winter werden berechnet als die Differenz zwischen Todesfällen während der vier Wintermonate (auf der Nordhemisphäre Dezember bis März) und der Anzahl der Todesfälle in den acht übrigen Monaten.

Exzessive Winter-Todesfälle treten weltweit auf, sogar in warmen Ländern wie Thailand und Brasilien. Einer vermutlich niedrig angesetzten Schätzung zufolge beläuft sich diese Anzahl auf etwa zwei Millionen Seelen pro Jahr weltweit.

In England und Wales kam es im Winter 2017/18 zu über 50.000 exzessiven Winter-Todesfällen – das ist eine Rate, die etwa DREI MAL SO HOCH liegt wie das Pro-Kopf-Mittel in den USA und Kanada. Proportional sind das in UK etwa 35.000 mehr Todesfälle als es der mittleren Rate der USA und von Kanada entsprechen würde. Exzessiv hohe Energiekosten in UK aufgrund einer völlig verfehlten globale-Erwärmung-/anti-Fracking-Hysterie sind eine wesentliche Ursache dafür – befeuert durch globale-Erwärmung-Alarmisten und deren korrupte Handlanger in Regierungen und Institutionen.

Prognosen einer unmittelbar bevorstehenden globalen Abkühlung, die jetzt jederzeit beginnen kann

Allan MacRae veröffentlichte am 1. September 2002 auf der Grundlage einer Konversation mit Dr. Tim Patterson die Prognose, wonach eine globale Abkühlung wie im Zeitraum ~1940 bis 1977 ab dem Jahr 2020 bis 2030 wieder einsetzen würde (hier):

„Während der letzten eintausend Jahre zeigten die globalen Temperaturen eine starke Korrelation mit Variationen der Sonnenaktivität. Diese Erwärmungs- und Abkühlungs-Phasen waren mit Sicherheit nicht verursacht durch Variationen des atmosphärischen CO2-Gehaltes, weil fossile Treibstoffe bis zum 20. Jahrhundert keine Rolle spielten.

Die Temperaturen im 20. Jahrhundert korrelieren auch kaum mit dem atmosphärischen CO2-Niveau, welches über das gesamte Jahrhundert hinweg gestiegen ist. Allerdings erfolgte ein großer Teil der beobachteten Erwärmung im 20. Jahrhundert vor dem Jahr 1940. Dem folgte eine Abkühlung von 1940 bis 1977 und mehr Erwärmung ab 1977. Da 80% des anthropogenen CO2 erst nach 1940 erzeugt worden war – warum war die Erwärmung davor eingetreten? Außerdem, warum die Abkühlung zwischen 1940 und 1977 bei steigendem CO2-Niveau? Noch einmal, diese Erwärmungs- und Abkühlungs-Trends korrelieren sehr gut mit Variationen der Sonnenaktivität.

Erst seit dem Jahr 1977 korreliert die Erwärmung mit gestiegenem CO2-Gehalt, aber auch die Sonnenaktivität hat während dieses Zeitraumes zugenommen. Diese Erwärmung wurde lediglich an der Erdoberfläche gemessen, und Satelliten maßen in Höhen zwischen 1,5 und 8 Kilometern kaum oder gar keine Erwärmung. Dies ist inkonsistent mit CO2 als primären Treiber von Erwärmung. Falls die Sonnenaktivität der Haupt-Treiber der Temperatur der bodennahen Luftschichten ist und nicht das CO2, sollte es zwischen 2020 und 2030 zur nächsten Abkühlungs-Periode kommen“.

Während der letzten ~fünf Jahre schrieb MacRea, dass die globale Abkühlung eher um das Jahr 2020 beginnen würde als später. Diese globale Abkühlung wird sporadisch einsetzen, an verschiedenen Orten der Welt. Ähnliche Prognosen einer globalen Abkühlung sind im Anhang gelistet.

Es ist bemerkenswert, dass das Aussäen von Getreide einen Monat später als üblich in den nördlichen zentralen US-Staaten erfolgte, und zwar sowohl in diesem als auch im vorigen Jahr. Im Jahre 2019 wurden viel mehr Kälte- als Wärmerekorde in den USA verzeichnet – während der letzten 30 und 365 Tage sowie dieses Jahr bis dato (hier). Diese Ereignisse mögen einfach nur Wetter gewesen sein, nicht Klima – oder sie könnten als frühe Indikatoren einer globalen Abkühlung stehen.

[Dazu passt ganz aktuell die gemessene Temperatur am Flughafen von Denver, Colorado: dort wurden am Morgen des 31. Oktober (Ortszeit) -20 Grad gemessen, ein Wert, der fast um Größenordnungen unter dem bisherigen Oktober-Rekord liegt. Anm. d. Übers.]

Das US-Landwirtschaftsministerium veröffentlicht wöchentlich einen Ernte-Report:

[Aus diesem Report zitieren die Autoren ausführlich die Auswirkungen auf verschiedene Getreidesorten. Insgesamt ist allgemein von schweren Ernteverlusten durch Kälte während der letzten Jahre die Rede, deren Ausmaß zumindest für dieses Jahr noch gar nicht abzuschätzen ist. Die graphische Darstellung der jeweiligen Erntemengen zeigt durchweg während der letzten Jahre fallende Tendenz.

Auf eine Detaillierte Übersetzung wird hier verzichtet. Die Belege sind aber eindeutig. Und die aktuelle Kältewelle in den USA wird sich vorerst fortsetzen. Anm. d, Übers.]

Summary and Conclusions

Es ist bemerkenswert, dass das Aussähen in den Getreide-Gebieten der nördlichen USA erst einen Monat später als üblich erfolgen konnte, sowohl in diesem als auch im vorigen Jahr. Während die Ernte im Jahre 2018 noch durch warmes Sommerwetter gerettet werden konnte, wurde die Ernte von Mais und Sojabohnen in den nördlichen USA in diesem Jahr durch einen kalten Sommer und sehr früh einbrechendem kalten Wetter schwer beeinträchtigt.

Anhang – andere Prognosen globaler Abkühlung in chronologischer Reihenfolge seit 2003:

Im Jahre 2003 verfasste Dr. Theodor Landscheidt eine Studie, in welcher er eine ernsthafte Abkühlung prognostizierte (hier):

„Eine genaue Analyse der variierenden Sonnenaktivität über die letzten beiden Jahrtausende deutet darauf hin, dass es im Gegensatz zu Spekulationen des IPCC bzgl. einer vom Menschen verursachten Erwärmung um bis zu 5,8°C während der nächsten 100 Jahre zu einer langen Periode eines kühlen Klimas kommt, wobei die kälteste Phase um das Jahr 2030 zu erwarten ist“.

[Einschub des Übersetzers: Seines Wissens nach ist dies die erste ernst zu nehmende Prognose einer Abkühlung. Darum kam der Gedanke auf, diese Kaltphase als das „Landscheidt-Minimum“ zu bezeichnen. – Ende Einschub]

Im Jahre 2005 prognostizierte Piers Corbyn Abkühlung bis zum Jahr 2040 (hier):

Am 2. Februar 2005 hielt Piers Corbyn einen Vortrag am Institute of Physics Energy Management Group. Darin führte er u. A. aus:

„Während der nächsten 5 bis 10 Jahre wird sich die Erwärmung wahrscheinlich halten, da es zu einer trans-polaren Verschiebung [?] kommt. Dem wird eine Verlagerung des magnetischen Pols weg vom geographischen Pol folgen ebenso wie eine Abnahme der Sonnenaktivität, einer Verlagerung des Golfstromes nach Süden und merkliche Abkühlung der Welt bis zum Jahre 2040“.

Im Jahre 2006 prognostizierte die NASA, dass der „Sonnenzyklus 25 mit seinem Höhepunkt um das Jahr 2022 einer der schwächsten Zyklen seit Jahrhunderten sein könnte (hier).

Im Jahre 2006 stellten Khabibullo Abdusamatov et al. an der Russian Academy of Science fest (hier):

„Globale Abkühlung sollte sich auf der Erde über die nächsten 50 Jahre einstellen. Sie könnte ernste Konsequenzen haben, bevor es zu Beginn des 22. Jahrhunderts wieder wärmer wird. …

Auf der Grundlage unserer Forschungen bzgl. solarer Emissionen entwickelten wir ein Szenario einer globalen Abkühlung bis Mitte dieses Jahrhunderts sowie nachfolgend einen regulären, 200 Jahre währenden Zyklus der Erwärmung mit Beginn des 22. Jahrhunderts“.

Khabibullo Abdusamatov sagte, dass er und seine Kollegen zu dem Ergebnis gekommen seien, dass eine Periode globaler Abkühlung ähnlich derjenigen zum Ende des 17. Jahrhunderts – als Kanäle in den Niederlanden zufroren und man landwirtschaftlich genutzte Gebiete in Grönland [!] aufgeben musste – im Zeitraum 2012 bis 2015 beginnen und ihren Höhepunkt im Zeitraum 2055 bis 2060 erreichen könnte. Dieser zukünftige Klimawandel dürfte seiner Ansicht nach sehr ernste Konsequenzen haben. Daher sollten die Behörden sich heute schon darauf vorbereiten, weil „die Klima-Abkühlung verbunden ist mit sich ändernden Temperaturen, vor allem in nördlichen Ländern.

„Schaut man sich einem genauer die Vergangenheit der Sonne an, dann erkennt man, dass wir in einer Epoche mit einer anomal hohen Sonnenaktivität leben. Derartige Perioden dauern aber nicht lange, vielleicht 50 bis 100 Jahre, bevor es zu einem Einbruch kommt. Einen solchen Einbruch würde ich in naher Zukunft erwarten“.

Leif Svalgaard, Stanford University, stellte im Jahre 2006 fest (hier):

„Die Anzahl der Sonnenflecken wird im nächsten Jahrzehnt drastisch abnehmen. Die Sonnenfleckenzahl wird extrem klein werden, und wenn die Sonne einbricht, wird dieser Einbruch markant sein. Er dürfte eine Abkühlung der Erde auslösen“.

[Bemerkenswert an diesen Prognosen bzgl. der Sonnenaktivität ist, dass sie bereits eingetroffen sind – ganz im Gegensatz zu den Prophezeiungen des IPCC. Also dürften auch die Folgerungen der Forscher daraus eine ziemlich hohe Eintrittswahrscheinlichkeit aufweisen. Anm. d. Übers.]

Link: https://wattsupwiththat.com/2019/10/27/the-real-climate-crisis-is-not-global-warming-it-is-cooling-and-it-may-have-already-started/

Übersetzt von Chris Frey EIKE