Nachdem in den Teilen 1-4 die aktuelle Situation bei der Stromerzeugung analysiert worden war, wird hier untersucht, wie der künftige Energiemix im Jahre 2038 voraussichtlich aussehen soll und welche Veränderungen dies auf unser Stromversorgungssystems haben würde. Da Vorhersagen der Zukunft bekanntlich riskant sind, begnügen wir uns stattdessen mit einer vom Anspruch her deutlich bescheideneren „Was-wäre-Wenn“-Betrachtung. Zunächst müssen hierfür einige Annahmen getroffen werden. Wir gehen dabei von folgendem Szenario aus:

– Der Verbrauch von Strom verbleibt unverändert auf dem Niveau des Jahres 2018

– 2038 gibt es in Deutschland keine fossil betriebenen Kraftwerke und auch keine Kernenergie mehr

– Es gibt keinen weiteren Ausbau von Wasserkraft-, Biomasse- und Hausmüllkraftwerken: Die von diesen Quellen erzeugten Strommengen werden als konstant angenommen.

– Der Ausbau der Fotovoltaik wird wegen der ungleich höheren Kosten (nach heutigen Fördersätzen ist Solarstrom dreimal so teuer wie Windstrom) bei 100.000 MW gedeckelt.

– Der gesamte restliche Bedarf muss also durch Windstrom gedeckt werden. Aufgrund der begrenzten Ausbaumöglichkeiten auf See (Erhalt der Zugänglichkeit der Häfen Bremen und Hamburg für den Schiffsverkehr!) bleibt es beim heutigen Verhältnis zwischen Onshore- und Offshoreproduktion.

– Unterstellt wird, dass die Wetterverhältnisse sowie das Verbrauchsverhalten Deutschlands im Jahr 2038 exakt denjenigen des Jahres 2018 entsprechend. Dies ermöglicht es, die Zahlenwerte von 2018 als Basis einer Projektion in die Zukunft zu verwenden. Betrachtet werden die Anforderungen an die Infrastruktur, d.h. die Kapazitäten des Stromnetzes, die Speicher und die Backup-Kraftwerke.

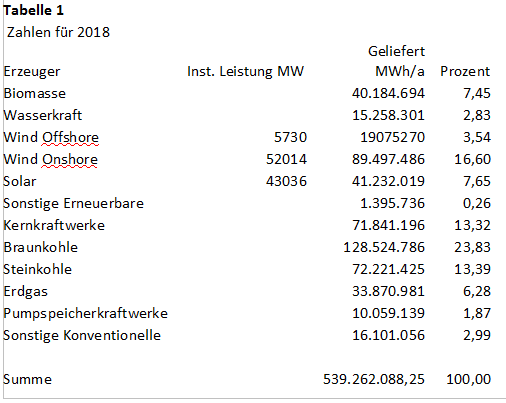

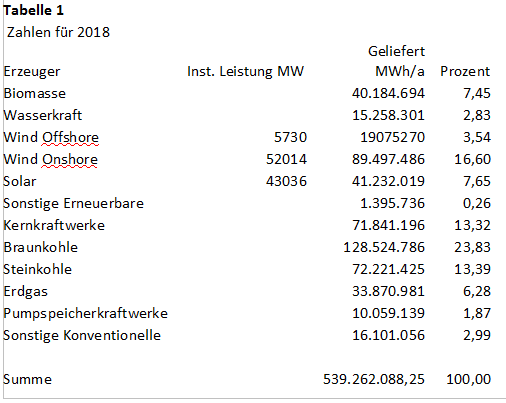

Die Zahlen – 2018 und 2038

Den Daten der Bundesnetzagentur zufolge lieferten Deutschlands Stromerzeuger im Jahr 2018 die folgenden Strommengen ins Netz:

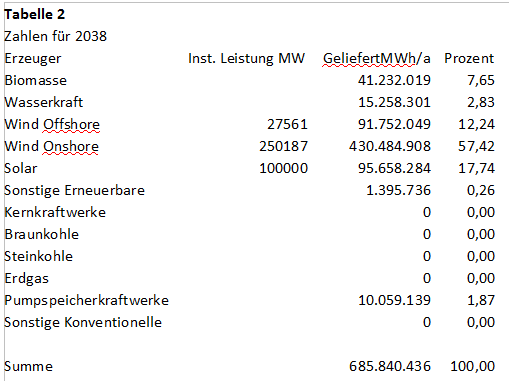

Ausgehend von den oben dargelegten Annahmen würden sich die Zahlen für 2038 nach Wegfall der fossilen und Kernkraftwerke dann zunächst wie folgt darstellen:

In diesen Zahlen sind Speicherverluste von 70 % für die ständig erforderliche Ein- und Ausspeicherung von Strom zur Stabilisierung der Versorgung (auf Tages-, Monats- und Jahresbasis) bereits berücksichtigt, siehe weiter unten. Im Bereich Fotovoltaik entspricht die Steigerung von 43.036 MW auf ca. 100.000 MW einem Multiplikator von 2,32, der auch für die eingespeiste Strommenge zugrunde gelegt wird. Bei Offshore- ebenso wie bei Onshorewind als den Haupt-Leistungsträgern der künftigen Stromversorgung wurde zur Anpassung an die erforderliche Stromerzeugung eine Steigerung der installierten Leistung um den Faktor 4,81 vorgenommen. Wie weiter unten noch erläutert wird, sind darin auch die Speicherverluste berücksichtigt, die durch entsprechende Überproduktion kompensiert werden müssen. Wegen der Schwankungen von Wind- und Solarstromerzeugung werden in „guten Zeiten“ sowohl Wind- als auch Solarstrom in Mengen produziert werden, die den eigentlichen Netzbedarf deutlich überschreiten. Dadurch wird die Frage der Speicherung akut. Leider verfügt Deutschland nicht einmal näherungsweise über die Speicherkapazitäten, die für die Bewältigung der dann anfallenden Mengen ausreichen würden. Bis zur Bereitstellung entsprechender Kapazitäten stellt sich natürlich die Frage, was bei einer über dem Netzbedarf liegenden Stromerzeugung mit der Produktion der übrigen „Erneuerbaren“ Wasserkraft, Biomasse, Pumpspeicherkraftwerke sowie den „Sonstigen Erneuerbaren“ geschieht. Selbst Solar und Wind könnten miteinander in Konflikt darüber geraten, wer bei einem Überangebot noch ins Netz einspeisen darf. Während die Erzeuger von Strom aus Biomasse sowie zumindest ein Teil der „Sonstigen“ für ihre vorhandenen Anlagen auf gesetzlich zugesicherte Abnahmegarantien pochen dürfen, werden die nicht geförderten Betreiber von Wasserkraftwerken sowie Pumpspeicherkraftwerken ihren Betrieb vermutlich wegen Unrentabilität einstellen müssen.

Wie speichern?

Unheilbare Erbkrankheit der Stromerzeuger Wind und Solar ist die Tatsache, dass sie vom Wetter abhängen. Der so „geerntete“ Strom müsste prinzipiell sofort genutzt werden, wenn er anfällt. Da dies in einer modernen Industriegesellschaft nicht möglich ist, müsste bei Überproduktion Strom gespeichert werden, um in Mangelsituationen zur Verfügung zu stehen. Um Antworten bezüglich des „Wie“ haben sich die Verfechter von Wind- und Solarenergie bisher herumgedrückt. Stattdessen kommen Sprüche wie „Eine relevante Dimension erreicht der Speicherbedarf ab einem regenerativen Anteil von 60–80 % an der Stromversorgung; bei geringeren Anteilen sind Flexibilitätsoptionen“ wie

– Lastmanagement (in Wahrheit das „Totlegen“ ganzer Stadtviertel),

– flexibler Betrieb von konventionellen Kraftwerken (ist ab 2038 nicht mehr möglich)

– Ausbau der Stromnetze (hierauf wird weiter unten eingegangen)

dann die angeblich ökonomisch zweckmäßigeren Optionen zum Ausgleich der Schwankungen.

Tatsache ist jedoch, dass angesichts der stark fluktuierenden Erzeugung von Sonne und Wind Speicher zur Verfügung gestellt werden müssten, welche bei den (oft sehr heftigen) Leistungsspitzen den Überschuss aufnehmen, um ihn dem Netz dann in Flauteperioden wieder zur Verfügung zu stellen. Damit stellt sich die Frage nach den hierfür verfügbaren Technologien sowie die nach ihrem Wirkungsgrad.

Die Kapazität der hierfür zur Verfügung stehenden Pumpspeicher ist völlig unzureichend und lässt sich im Prinzip nicht erweitern. Batterien sind angesichts der geforderten Größenordnungen indiskutabel: So könnte beispielsweise die gesamte Batterie-Jahresproduktion von Tesla die USA gerade einmal für drei Minuten mit Strom versorgen.

Als Alternative wird die Umwandlung von überschüssigem „EE“-Strom in sogenanntes „Windgas“ mit anschließender Rückverstromung in Gaskraftwerken propagiert. Diese Technologien sind jedoch weder erprobt noch ausgereift, und von durchkalkulierten Kostenbetrachtungen kann beim aktuellen Stand der Technik keine Rede sein.

Wie könnten 100 % „erneuerbar“ im Jahr 2038 demnach aussehen?

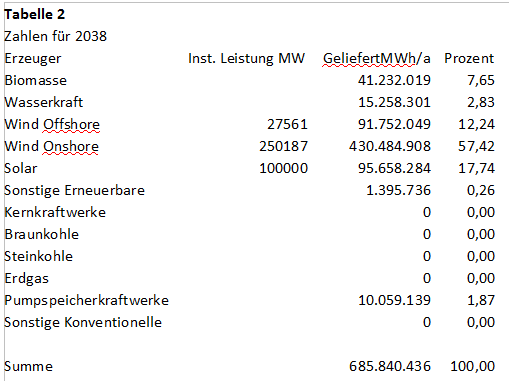

Als erstes war zu klären, welche minimale Speicherkapazität für die Überbrückung von „Dunkelflaute“-Perioden (also bei gleichzeitiger Unterdeckung von Wind- und Solarproduktion) benötigt wird. Unmittelbar damit verknüpft ist die Frage, wie oft und in welchen Mengen Strom in diese Speicher ein- und ausgespeichert werden muss, denn solche Wechsel erfolgen teils mehrfach täglich. Bei dieser Betrachtungsweise müssen die zusätzlich zur Netzlast ständig auftretenden kleineren und größeren Verluste beim Nachladen der Speicher kompensiert werden. Basis der Kalkulationen sind die viertelstündlichen Erzeugungs- und Verbrauchswerte des Referenzjahres 2018 unter Berücksichtigung entsprechender Multiplikatoren. Dabei ging es um die Ermittlung derjenigen Stromerzeugungskapazitäten, die bei einem Speicherwirkungsgrad von 30 % ausreichen würden, um die erforderlichen Energiemengen in den Pufferspeicher einzuspeisen, damit dessen Energiebilanz nach einem Jahr Betrieb exakt ausgeglichen ist, Bild 2.

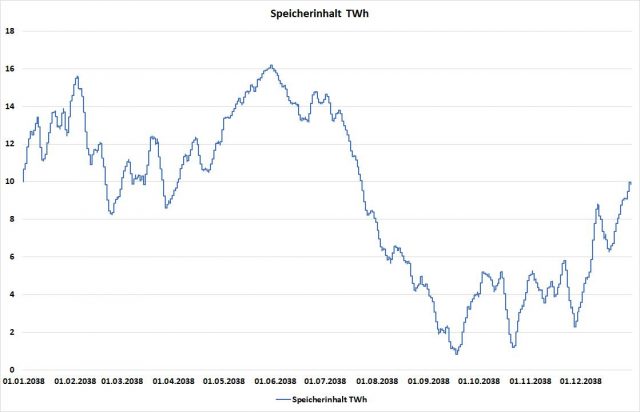

Bild 2. Simulierter Verlauf des Speicherinhalts im Verlauf des Jahres 2038 bei 100% EE-Strom und einem Speicherwirkungsgrad von 30 % (Berechnung und Grafik: Autor, Daten)

Zum Verlauf des Speicherinhalts in Bild 2 ist anzumerken, dass der kritische Zeitraum – mit den höchsten Speicherdefiziten von rund neun TWh – erst in der zweiten Jahreshälfte auftrat. Dieses Defizit entspricht dem Gesamtbedarf von etwa sechs Tagen „Dunkelflaute“, d.h. mit mehr oder weniger vollständigem Ausfall der Produktion von Wind- und Solaranlagen. Dazu ist anzumerken, dass 2018 augenscheinlich ein Jahr mit eher wenigen bzw. kurzen Dunkelflaute-Perioden war, denn in anderen Jahren können diese auch schon mal bis zu zwei Wochen andauern. Die Kapazität der Speichermöglichkeiten sollte deshalb bei mindestens 30 bis 40 TWh liegen, um auch in worst-case-Situationen die Versorgung des Landes sicherstellen zu können. Die aktuelle Speicherkapazität der in Deutschland vorhandenen Pumpspeicherkraftwerke liegt dagegen bei lediglich 37,7 GWh, das ist nur rund ein Tausendstel davon. Das Schließen dieser Lücke ist mit keiner derzeit praktikablen Technologie mach- oder finanzierbar. Hier ist definitiv und absolut Ende Gelände für das Märchen von der deutschen Energiewende mithilfe von Wind- und Solarstrom. Kein Wunder also, dass die politisch-ideologischen Verfechter dieses (Alp)-Traums auf entsprechende Fragen hin so tun, als werde dies erst in vielen Jahren akut…

Speichermengen und Speicherverluste

Als nächstes stellt sich die Frage, welche Energiemengen denn im Laufe eines Jahres aufgrund des ständigen Wechsels zwischen Überproduktion und Mangels ein- und ausgespeichert werden müssen und welche Verluste dabei auftreten. Die derzeit üblicherweise verwendeten Pumpspeicherkraftwerke haben einen Wirkungsgrad von lediglich 70 %, d.h. rund ein Drittel der gespeicherten Energie geht verloren. Es gibt allerdings weder in Deutschland noch in Europa ausreichende Ausbaumöglichkeiten. Das gilt auch für die Märchen über die angeblichen Reservemöglichkeiten in Norwegen und Schweden, die von interessierter Seite hartnäckig ins Spiel gebracht werden. Norwegen hat derzeit keine nennenswerten Pumpspeicherkraftwerke, und die Bevölkerung, welche ihre schlechten Erfahrungen mit deutschen Besatzern im zweiten Weltkrieg – um es vorsichtig zu formulieren – nicht vergessen hat, würde sich gegen eine Verschandelung ihrer Natur zugunsten Deutschlands höchst energisch zur Wehr setzen. Außerdem gibt es auch bereits Interesse und auch Leitungsprojekte seitens Dänemark, Großbritannien und den Niederlanden. Liebe Deutsche, ziehen Sie bitte eine Nummer und stellen sich hinten an.

Als Alternative wird immer wieder Wasserstoff bzw. „Windgas“ ins Spiel gebracht. Grundlage der Erzeugung von Windgas ist die Aufspaltung von Wasser, um Wasserstoff zu gewinnen. Dieser könnte dann gespeichert oder zu Methan umgesetzt und bei Strommangel zum Antrieb von Gasturbinen verwendet werden. Während die Speicherverluste beim Pumpspeichern im Mittel bei 30 % liegen, kann man bei der „Windgas“-Schiene von mindestens 70 % ausgehen, auch wenn dies in der zitierten Quelle optimistischer dargestellt wird. Diese Verluste müssen durch entsprechend höhere Stromproduktion ausgeglichen werden, damit dem Netz die jeweils für die Versorgung des Landes benötigten Mengen auch bedarfsgerecht zur Verfügung gestellt werden können

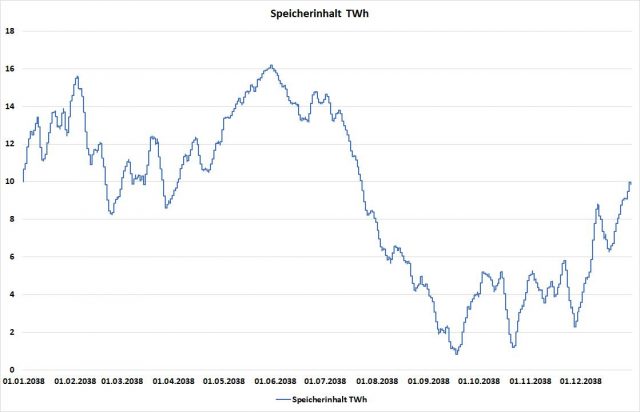

Diese Verfahren stehen derzeit zumeist nur im Labor- oder Technikumsmaßstab zur Verfügung. Sie sind weder ausgereift noch großtechnisch erprobt und zudem weitab von vertretbarer Wirtschaftlichkeit. Eigentlich gibt es daher gar keine vertretbaren Speichermöglichkeiten. Kein vernünftiger Mensch würde auf die Idee kommen, das funktionierende Stromerzeugungssystem einer Industrienation in die Tonne zu treten, ohne eine im industriellen Maßstab ausgereifte, bewährte und kaufmännisch durchkalkulierbare Alternative zur Hand zu haben. Unsere Regierung will jedoch genau das tun. Um die Auswirkungen dieses Wahnsinn zu verdeutlichen, wird hier der Form halber ein Simulationsbeispiel durchgerechnet (Bild 3).

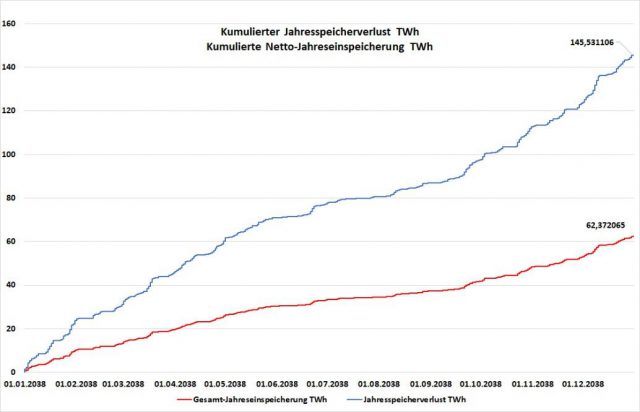

Bild 3. Speichersimulation: Im Verlauf des Jahres 2038 auftretender kumulierter jährlicher Energietransfer durch die Speicher sowie der dabei auftretende Verlust in TWh (Berechnung und Grafik: Autor, Daten)

Das Bild 3 verdeutlicht, dass die aufgrund des schlechten Wirkungsgrads der Speicherkette auftretenden jährlichen Verluste bei 145 TWh liegen, das ist mehr als ein volles Viertel (26,9 %) der gesamten Jahresproduktion. Oder anders ausgedrückt: Es ist fast soviel wie die gesamte Jahresproduktion von 158 TWh, welche die gesamte von Deutschland bisher für Kosten von rund 1 Billion € installierte Erzeugungskapazität von Wind- und Solarstrom im Jahr 2018 überhaupt lieferte. Anders ausgedrückt. Wir müssen voraussichtlich nochmals eine zusätzliche Billion € allein nur dafür ausgeben, um die künftig auftretenden Speicherverluste auszugleichen.

Erzeugungsleistungen und Netzkapazitäten

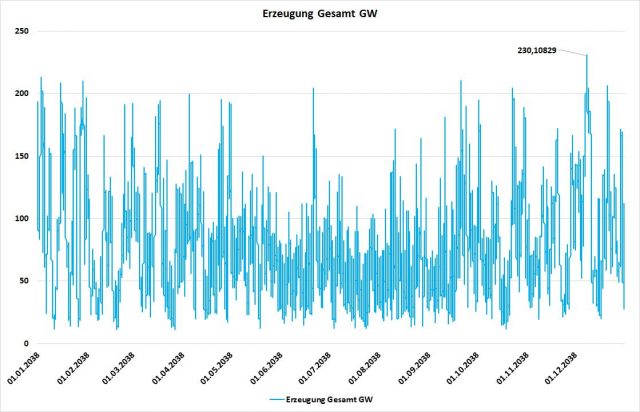

Schon der Blick auf die Tabellen 1 und 2 zeigt, dass sich bei der geplanten Umstellung der gesamten Stromerzeugung auf „erneuerbare“ Erzeugung mit Schwerpunkt auf Sonne und Wind die zu installierende Gesamtkapazität bei den letztgenannten Quellen von ca. 101 GW auf künftig 377,748 GW mehr als verdreifachen wird. Dies bedeutet, dass die Stromleitungen bei den unausweichlichen Schwankungen dieser Erzeuger in den Spitzenzeiten – d.h. bei viel Sonne und Wind – ein wesentlich höheres Stromaufkommen zu bewältigen haben werden als bisher, Bild 4.

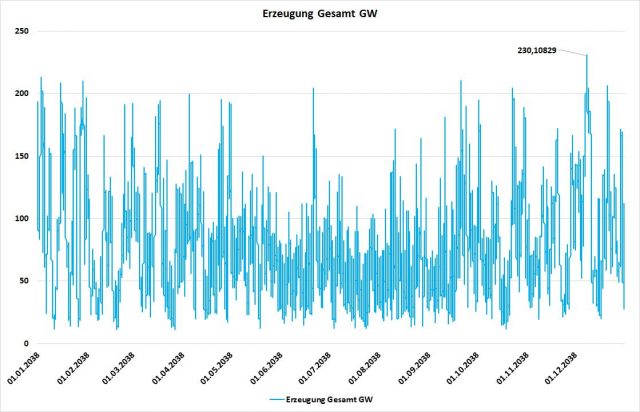

Bild 4. Simulation des Verlaufs der Stromerzeugung bei 100 % „EE“-Strom im Jahr 2038 (Berechnung und Grafik: Autor, Daten)

Die Darstellung in Bild 4 zeigt deutlich das wilde Auf und Ab („Zappelstrom“) der Erzeugung mit Ausschlägen zwischen lediglich 11,6 GW und Maximalwerten bis hinauf zu 230 GW. Letzteres bedeutet jedoch, dass mit der Konzentration auf Wind und Sonne als Hauptlieferanten unser gesamtes Stromnetz von den Hochspannungs-Ferntransportleitungen bis herab zu den Mittelspannungs- und Ortsnetzen in seiner Gesamtlänge von 1,8 Mio. km komplett erneuert und verstärkt werden müsste. Dieses Gesamtnetz ist nur für etwa 85-90 GW Erzeugungs- und Verbrauchsleistung ausgelegt. Es müsste daher zumindest in wesentlichen Teilen um den Faktor 3 verstärkt werden, da zusätzlich zur Versorgung der üblichen Verbraucher auch die noch zu errichtenden Umwandler und Speicher versorgt werden müssten. Ganz zu schweigen von den ebenfalls noch längst nicht in der benötigten Anzahl vorhandenen Gaskraftwerken, welche in Flautezeiten die reibungslose Versorgung aufrechterhalten müssten.

Dass es hierbei nicht genügen wird, nur die ca. 35.000 km langen Übertragungsnetze (380/ 220 kV) auszubauen, erklärt sich dadurch, dass nur wenige EE-Erzeuger direkt auf dieser Spannungsebene einspeisen. Die meisten Windparks und größeren Solaranlagen speisen in die Verteilnetze der Hochspannungs- (110 kV) oder der Mittelspannungsebene ein, während private Fotovoltaikanlagen in der Regel auf der Ortsnetzebene (400 V) angeschlossen sind. Beim Ausbau der Erzeugung von Wind- und Solarstrom wird man um eine weiträumige Verstärkung insbesondere der Hochspannungsnetze (aktuelle Länge ca. 96.000 km) sowie der Mittelspannungsnetze (ca. 510.000 km) nicht herumkommen. Mit einigen wenigen 1.000 km „Stromautobahnen“ der Höchstspannungsebene, wie es dem Bürger derzeit unter Bezeichnungen wie „Süd-Link“ vorgegaukelt wird, ist es keinesfalls getan. Statt mittlerer bis höherer zweistelliger Milliardenbeträge wird man dann daher mit Kostengrößenordnungen > 500 Milliarden bis in den Billionenbereich kalkulieren müssen. Dass diese Annahmen realistisch sind, ergibt sich aus der folgenden Betrachtung: Die Transportkapazität von Südlink liegt bei nur 2 GW, während das Investitionsvolumen bei rund 10 Mrd. € liegt. Wenn dies dann in der Presse als „eine Hauptschlagader der Energiewende“ dargestellt wird, bekommt man eine Vorstellung davon, in welchem Umfang das deutsche Volk hier von den Verantwortlichen hinter die Fichte geführt wird. Schließlich zeigt die hier vorgestellte Analyse, dass unsere Netze demnächst statt ca. 85 GW mindestens 230 GW bewältigen müssen. Rechnerisch ergibt sich allein hieraus ein voraussichtlicher Investitionsbedarf von rund 700 Mrd. €. Und es geht ja erst um die Höchstspannungsebene. Für die darunterliegenden Ebenen lassen sich zum jetzigen Zeitpunkt keine auch nur annähernd belastbaren Zahlen oder Schätzungen finden. Man darf jedoch annehmen, dass der entsprechende Aufwand mindestens in der gleichen Größenordnung liegen dürfte wie für die Höchstspannungsebene.

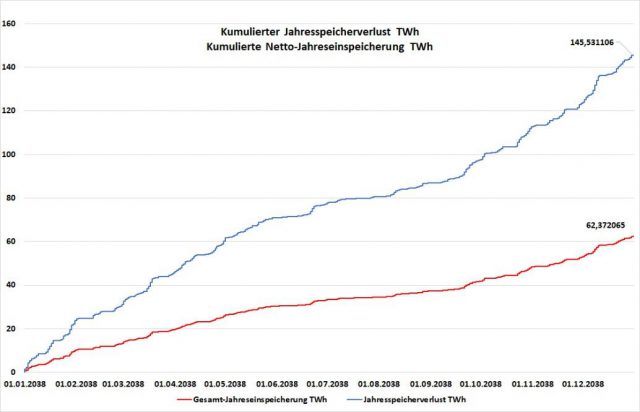

Speicherung und Rückumwandlung

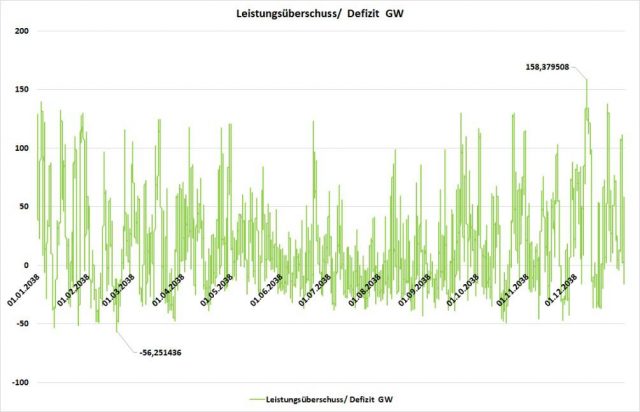

Eine ebenfalls völlig ungeklärte Fragestellung der „Energiewende“ betrifft die erforderlichen Kapazitäten für die Speicherung von überschüssigem Strom in Zeiten hoher Wind- und Solarerzeugung. Als erstes ist die Frage zu klären, um welche Kapazitäten es hierbei denn überhaupt geht, Bild 5.

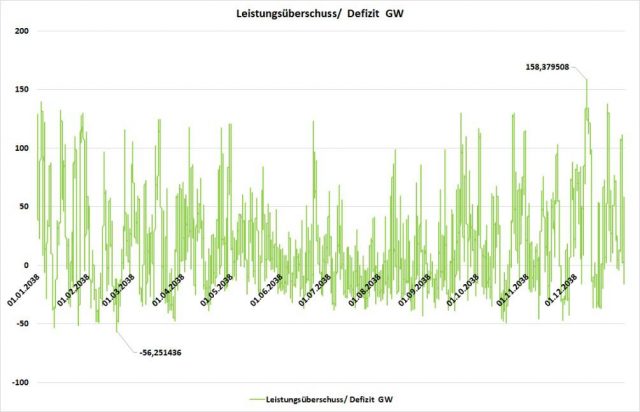

Bild 5. Simulation des Verlaufs der Produktion von überschüssigen – d.h. über der jeweiligen Netzlast liegenden – Strommengen bzw. des im umgekehrten Fall durch Gasturbinen zu deckenden Stromdefizits im Jahr 2038 (Berechnung und Grafik: Autor, Daten)

Zur Ermittlung der in Bild 5 dargestellten Über- bzw. Unterdeckung wurde die jeweils produzierte Leistung abzüglich des jeweiligen Netzbedarfs viertelstundengenau miteinander verrechnet. Auch hier zeigt sich das für „EE-Zappelstrom“ typische Bild eines wilden Hin und Her, wobei das Problem nicht nur auf dem ständigen Wechsel zwischen Über- und Unterdeckung beruht, sondern auch auf den geradezu atemberaubenden Laständerungsgeschwindigkeiten (Gradienten). Dazu in einem späteren Kapitel mehr. Zunächst ist festzuhalten, dass die Höhe der Überschüsse bei bis zu 158 GW liegt. Die hierfür installierten Wandler (Elektrolyseure) müssen imstande sein, dieses Stromangebot augenblicklich zu verarbeiten und in eine speicherbare Energieform zu überführen. Bei Speicherkraftwerken beträfe dies die maximale Leistungsaufnahme der eingesetzten Pumpen. Diese liegt in Deutschland bei insgesamt lediglich 6,5 GW, d.h. bei lediglich einem Vierundzwanzigstel des erforderlichen Werts. Mehr ist nicht machbar, die Topologie Deutschlands (sowie Bürgerinitiativen) erlauben keine Ausbaumöglichkeiten. Ebenso sieht es auch in den direkten Nachbarländern aus. Selbst in den Alpenrepubliken Österreich und Schweiz, wo man noch am ehesten Hochtäler fluten und in Pumpspeicherbecken verwandeln könnte, sind die vorhandenen Kapazitäten ausgereizt und Neubauten nicht in Sicht. Der Spruch der früheren Schweizer Bundespräsidentin Doris Leuthard von der „Schweiz als Batterie Europas“ hat sich schon längst als Geschwätz entpuppt. Dass in Norwegen, wohin derzeit ein direktes Seekabel mit der Bezeichnung „NordLink“ verlegt wird, wohl kaum Bereitschaft zu finden sein wird, größere Naturzerstörungen in Kauf zu nehmen, wurde bereits weiter oben erläutert. Eine kurze Kapazitäts- und Kostenbetrachtung zeigt, dass NordLink bei geschätzten Kosten von bis 2 Mrd. € eine Kapazität von lediglich 1,4 GW bietet. Für den Transport der benötigten 158 GW bräuchte man daher insgesamt 113 Kabel des NordLink-Typs, verbunden mit Kosten von 226 Mrd. €. Wohlgemerkt: Nur allein für die Seeverbindungen. In Norwegen ist die Wasserkraft vor allem im Norden angesiedelt und das Verlegen von „diskreten“ Erdkabeln angesichts der felsigen, oft aus nacktem Granit bestehenden Landschaft utopisch, die Kosten wären astronomisch. Gegen Freileitungen mit den benötigten Gesamtkapazitäten würde das Volk garantiert Sturm laufen.

Betrachtet man alternativ die Möglichkeiten der Produktion und Nutzung von Windgas, so findet man auf Wikipedia eine Zusammenstellung von Projekten mit insgesamt 17 Anlagen, die zusammengenommen auf gerade einmal 17 MW Leistung kommen. Benötigt würden aber 158 GW, das ist rund das zehntausendfache(!). Bei vielen der Anlagen handelt es sich um Forschungs- oder Demonstratorsysteme, die nicht als marktreif und skalierbar einzustufen sind. Wissenschaftliche Veröffentlichungen sprechen von Entwicklungszeiträumen von bis zu 10 Jahren, um Anlagen mit einer Leistungsgrößenordnung von ca. 20 MW zu erstellen. Ob und wann diese Technologie in Größenordnungen verfügbar sein wird, die Deutschland überhaupt erst die Abkehr von Kohle- und Kernkraft ermöglichen würde, steht in den Sternen. Über Machbarkeiten oder Kosten kann auch hier nur spekuliert werden. Doch höheren Orts ist man offenkundig überzeugt:

Die Energiewende in ihrem Lauf hält weder Ochs noch Esel auf.

In den nächsten Kapiteln geht es um Gaskraftwerke, Ausbaugrenzen der Windenergie in Deutschland und erzielbare CO2-Einsparungen.

Fred F. Mueller

Hintergrundliteratur

Limburg, M.; Mueller, F.: Strom ist nicht gleich Strom TvR Medienverlag, Jena, ISBN 978-3-940431-54-7