Temperaturmessung: Rekord unbrauchbar

Wurde sie gerade noch einmal abgewendet, diese schreckliche Klimakatastrophe? Zumindest in Lingen? Das war – zur Erinnerung – bei jener Hitzewelle vor kurzem bekanntlich Deutschlands heißester Ort. Eine Station des Deutschen Wetterdienstes registrierte am 25. Juli der Wert von 42,6 °C, der von Medien und Potsdamer Klimakatastrophisten als Vorstufe zur Wetterhölle erklärt wurde.

Doch jetzt hat der private Wetterdienst »Wetter online« diesen Wert zurückgezogen: Rekord unbrauchbar. »Bezüglich des Standorts gibt es aber so viel berechtigte Kritik, dass Wetter online diesen Rekordwert nicht anerkennt.«

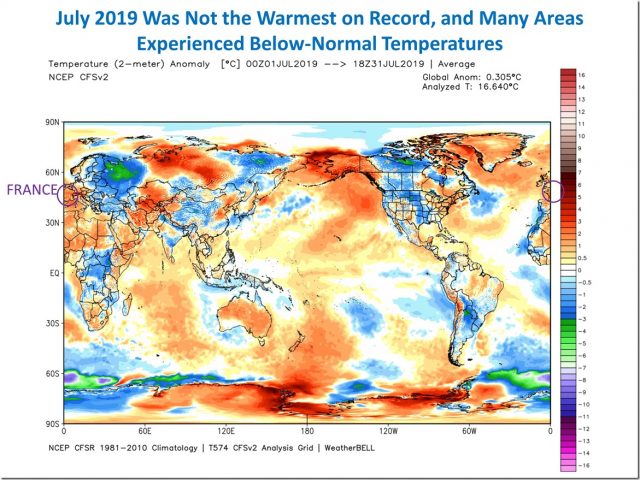

Historisch sei die Hitze im letzten Julidrittel ohne Zweifel gewesen, bekundet Wetter online. In Geilenkirchen wurde der alte Rekord von 40,3° am 24. Juli mit 40,5° knapp überboten. Danach hatten verschiedene Stationen mehr als 40° gemeldet. »So etwas hat es in Deutschland seit Beginn der regelmäßigen Wetteraufzeichnungen nicht gegeben.«

In Duisburg und Tönisvorst zeigte das Thermometer 41,2° an. Lingen kam dann in die Schlagzeilen mit 42,6°. Doch diese Messstelle in Lingen erfüllt jetzt nicht mehr den Standard der Weltorganisation für Meteorologie WMO. Denn es ist nicht egal, wo und wie das Thermometer steht und die Umgebung beschaffen sein soll. Der Messfühler muss abgeschattet sein, so dass er nicht von der Sonnenstrahlung oder der Wärmeabstrahlung eines Mauerwerkes beeinflusst wird. Er muss zudem ausreichend belüftet werden.Doch gerade im Umfeld der Station in Lingen wuchsen die Büsche in den vergangenen Jahren so, dass rund um die Wetterstation eine Wärmeinsel entstand, in der Wärme gestaut wurde. Höhere Temperaturen sind also nicht weiter verwunderlich. Die Station in Lingen geriet schon in den vergangenen Jahren in die Kritik, weil der Unterschied der Messwerte zu den umliegenden Stationen von Jahr zu Jahr größer wurde. Wetterunternehmer Jörg Kachelmann kritisierte den Standort der Station schon seit längerem; er wusste um den Effekt der Wärmeinseln.

Auch der Deutsche Wetterdienst DWD plante seit einigen Jahren, die Station zu verlegen. Allerdings fürchtet der Dienst die politischen Folgen einer solchen Verlegung. Wetter online: »Erkennt man den Wert nicht an, rücken »Klimawandelleugner« auf den Plan und erklären, dass es nach dem Medienhype gar nicht so heiß gewesen sei. Wird er für ungültig erklärt, wären wohl schnell unangenehme Fragen zur Standardqualität im Allgemeinen aufgetaucht.«

Denn Temperaturmessungen sind nach einem alten Spruch von Meteorologen das größte Problem dieser Zunft. Wo wird gemessen? Jeder kennt das: Steht in einem Zimmer das Thermometer nah an einem Ofen, ist es wärmer als in der Ecke gegenüber. Wo also ist die wahre Zimmertemperatur?

Die Vorschriften für offizielle Temperaturmessungen sehen einen Standort der Wetterhäuschen zwei Meter über dem Boden auf einer freien Fläche vor. Der Messfühler muss abgeschattet sein, ein Ventilator die Luft durchwedeln. Das Thermometer soll nicht die eigene Wärme messen, sondern die der Luft.

Besonders delikat sind Vergleiche der Temperaturentwicklung über vergangenen Jahrzehnte oder gar Jahrhunderte hinweg. Messtechnik ändert sich, ebenso wandeln sich die Gegebenheiten rund um die Messstationen. Häuser werden gebaut oder Wände hochgezogen, die die Temperaturen in der Umgebung verändern. Häufig muss der Wetterdienst auch den Standort seiner Station verändern. Messstationen mussten umgestellt werden, weil die Ableser laut Protokoll des Wetterdienstes unfähig waren, regelmäßig die Werte abzulesen und weiterzugeben.So wurde die Station in Bad Dürkheim, in der Rheinebene nahe dem Pfälzer Wald gelegen, mehrfach verlegt. »Am 13.9.1977 wurden die Beobachtungen an der jetzigen Station wegen Unfähigkeit des Beobachters eingestellt.« Zwei Monate später wurde ein neuer Beobachter gefunden und die Station wieder entsprechend verlegt. Da auch dieser Beobachter ausschied, ruhte die Station vom vom 21.10.1987 bis 14.4.1988. Die Station meldete rückgängige Temperaturen. Es ist also ein sehr schwieriges Unterfangen, Temperaturmesswerte über viele Jahre zu vergleichen. Meteorologen versuchen daher, stark schwankende Daten durch statistische Verfahren zu »homogenisieren«, etwas böse ausgedrückt: passend zu machen.

Wie schwierig, ja unmöglich es ist, die Entwicklung von Temperaturen über die letzten 100, 200 Jahre sogar auf die Nachkommastelle genau anzugeben, zeigte einst die wichtige Arbeit von Michael Limburg, der als Ingenieur im Bereich der Messtechnik und Fehlerstatistik gearbeitet und die entsprechenden Erfahrungen gesammelt hat: »Analyse zur Bewertung und Fehlerabschätzung der globalen Daten für Temperatur und Meeresspiegel und deren Bestimmungsprobleme« lautete der etwas sperrige Titel.

Limburg ging in seiner Dissertation der Frage nach, ob die meteorologischen Daten der vergangenen 150 Jahre genau genug sind, um den Verlauf der »Globalen Mitteltemperatur« auf 1/10 Grad Celsius genau zu berechnen. Dieser Verlauf spielt in der aktuellen Klimadebatte eine wichtige Rolle; belegen die einen damit doch, dass es wärmer, die anderen, dass es kälter wird.

Doch die wichtige Frage ist: Lässt sich eine solche Aussage überhaupt treffen? Satelliten vermögen heute sehr genau alle möglichen Wetterdaten wie Temperaturen der verschiedenen Oberflächen zu messen. Sie gibt es allerdings erst seit etwa knapp 40 Jahren. Davor beruhen die Temperaturangaben auf Messungen unterschiedlicher Messstationen. Bei denen hängt es sehr davon ab, wo und wie die Thermometer angebracht sind. Über einer Wiesenfläche ergeben sich andere Temperaturen als über Asphaltflächen. Ziemlich schwierig, wenn man sehr unterschiedlich zustande gekommene Temperaturaufzeichnungen mit vielen dubiosen Angaben miteinander vergleichen und Trends herauslesen will.Das Ergebnis der Dissertation von Limburg:

»Dabei kam ich zu dem eindeutigen Ergebnis, dass die verwendeten historischen Wetter-Messdaten dies nicht erlauben. Ich fand heraus, dass die bei der Berechnung der globalen Mitteltemperatur unvermeidliche verbleibende Unsicherheit mindestens genau so groß ist wie die ganze offiziell angegebenen Änderung über 150 Jahre, wahrscheinlich aber sogar ein Vielfaches beträgt. Dies ergibt sich zwangsläufig bei Anwendung aller gängigen und vielfach erprobten Regeln der Messtechnik und der statistischen Fehlerrechnung.«

Dieses Ergebnis schreckte die prüfenden Professoren erheblich auf. Limburg weiter: »Die Arbeit stellte ja indirekt wesentliche Aussagen zur angeblichen ›menschengemachten Klimaerwärmung‹ und damit einen der Hauptgründe für die Förderung der sogenannten ›Erneuerbaren Energien‹ infrage. Für beide Themenkomplexe gibt es jedoch höchst umfangreiche Fördergelder. Vermutlich befürchteten die Verantwortlichen diesbezügliche Nachteile, falls sie einer Arbeit Platz und dem Autor einen akademischen Grad zugestanden, der dem bisherigem Dogma – und sei es auch nur indirekt – widersprach.«

Man kann sich vorstellen, wie der Blutdruck der Herren Prüfprofessoren hochschnellte. Die erste Kommission, die die Promotionsarbeit prüfen sollte, trat tatsächlich geschlossen zurück. Begründung: »Weitgehende politische Motivationder Arbeit«.

Um es kurz zu machen: Die Arbeit wurde nach einer hanebüchenen Odyssee schließlich abgelehnt. Es darf nicht belegbar sein, was nicht ins politische Konzept passt.

Nur die Entwicklung der Temperaturen über Jahrhunderte hinweg wird nach wie vor so genau angegeben, wie dies messtechnisch überhaupt nicht möglich ist. Doch ist sie ist Grundlage jener wilden These der Klimakatastrophe, auf der moderne Ablasshändler ihre Geschäfte aufbauen.

Der Beitrag erschien zuerst bei TE hier