97 Prozent der Klimawissenschaftler unterstützen die Aussage des Weltklimarates – dies wird denjenigen entgegengehalten, die im Spektrum der Klimawissenschaft zu Ergebnissen kommen, die dem Mainstream widersprechen. Insbesondere in Diskussionen mit Politikern, Journalisten, aber auch Klimaaktivisten ist dieser Hinweis das probate Mittel, um jeden Zweifel abzublocken. Zweifel etwa, ob es nicht auch natürliche Ursachen für einen Teil der Erwärmung gegeben haben könnte; ob nicht das CO2 in seiner Klimawirkung überschätzt sei; ob die Klimamodelle wirklich ein zureichendes Bild der realen Klimaentwicklung abgäben.

Der immer wieder zitierte 97-Prozent-Konsens beruht auf einer Arbeit von John Cook, einem australischen Psychologen, aus dem Jahr 2013. Cook hat klimawissenschaftliche Artikel aus den Jahren 1991 bis 2011 untersucht. Er stellte fest, dass 97 Prozent der Veröffentlichungen einen Zusammenhang zwischen Erwärmung und anthropogenem Einfluss annehmen. Schaut man sich die Studie Cooks allerdings etwas genauer an, stellt man fest, dass gerade mal 1,6 Prozent diesen menschlichen Einfluss mit mehr als 50 Prozent beziffern, die restlichen 95,4 Prozent sehen einen Zusammenhang, ohne ihn zu quantifizieren.

Die weit überwiegende Zahl der Wissenschaftler – ich zähle mich zu ihnen – sieht den CO2-Ausstoss durch den Menschen als eine von mehreren Ursachen für die globale Erwärmung der letzten 150 Jahre. Darunter sind einige, die den CO2-Beitrag auf weniger als 50 Prozent einschätzen, einige sicher auch auf 60 oder gar 80 Prozent. Der Uno-Weltklimarat (IPCC) behauptet in seinem Bericht aus dem Jahr 2018, dass ausschliesslich menschliche Aktivitäten für den Anstieg von 0,9 Grad Celsius seit 1850 ursächlich sind. Und landauf, landab verbreiten Politik und Medien, die Wissenschaftler seien sich zu 97 Prozent einig. Abweichende Meinungen werden damit als absurd oder skurril gebrandmarkt.

Da ist es doch interessant, einen Blick auf den letzten Bericht der American Meteorological Society aus dem Jahr 2017 zu werfen. 42 Prozent der befragten Meteorologen erachteten die Natur als bedeutsamere oder mindestens gleichwertige Ursache für die Erwärmung. 49 Prozent sehen den Menschen als Urheber im Vordergrund, allerdings vermuten auch hier nur 15 Prozent den Menschen als alleinig ursächlich: gegenüber der Untersuchung des Zeitraumes 1991 bis 2011 eine deutliche Steigerung, aber eben nur um 15 Prozent.

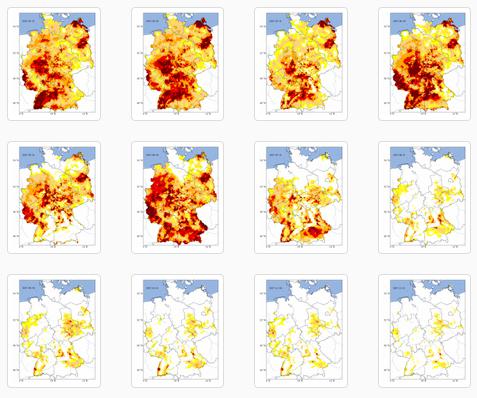

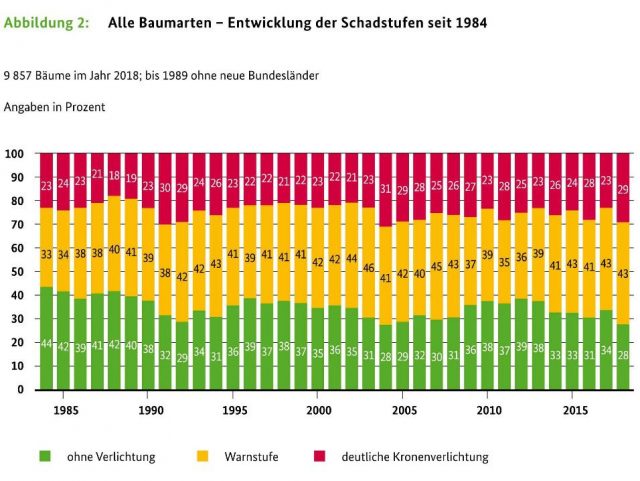

Nun werden naturwissenschaftliche Erkenntnisse nicht per Mehrheitsentscheid proklamiert. Gerade wenn sich zu politisch gehypten Themen eine unselige Allianz aus Politik, Medien und Wissenschaft bildet, wird es immer gefährlich. Auf dem Höhepunkt der Waldsterbensdebatte in den neunziger Jahren waren die wenigen abweichenden Wissenschaftler sehr schnell isoliert. Sie wurden von den Medien nicht mehr zitiert und von Forschungsmitteln abgeschnitten. Die Realität gab ihnen später recht.

Viele Menschen goutieren Schwarzweiss-aussagen, welche die komplizierte Welt so einfach wie möglich erklären. Von 97 zu 100 Prozent Konsens betreffend menschenverursachtes Klima ist es nur noch ein ganz kleiner Schritt, der alles kolossal vereinfacht und die Schuldfrage auch noch gleich löst. Dabei wird in der Klimawissenschaft mit so extremen Unsicherheiten operiert wie sonst nirgendwo. Sämtliche Klimaberichte strotzen nur so vor Unsicherheiten. Erkenntnisse werden mit Konfidenzbereichen ausgewiesen: «sehr wahrscheinlich», «wahrscheinlich» und «unwahrscheinlich». Man stelle sich vor, Galileo oder Einstein hätten ihre gesetzmässigen Erkenntnisse mit derart ungefähren Formeln begründet.

Sündenbock CO2

So gibt etwa der IPCC die entscheidende Grösse der Klimasensitivität – also die Temperaturentwicklung bei Verdoppelung des CO2-Gehalts der Luft von vorindustriellen 280 ppm auf zukünftige 560 ppm (parts per million) – mit einem Streubereich von 1,5 bis 4,5 Grad an. Bei 1,5 Grad könnten wir der Entwicklung mit Gelassenheit entgegensehen; bei 4,5 Grad droht eine katastrophale Entwicklung. Was gilt nun? Auch der Weltklimarat kann die Antwort nicht liefern. Für den Weltklimarat ist die Sache klar: Der Mensch ist zu 100 Prozent schuld. In früheren Berichten hiess es, CO2 determiniere das Klima seit 1950. Neuerdings ist man sich sehr sicher: Bereits seit 1850 gibt es nur einen Stellknopf für das sich seither erwärmende Erdklima: Die anthropogenen Einflüsse allein sind die Sünder, vornehmlich CO2.

Woher weiss man das? Aus Modellrechnungen, in denen bestimmte mögliche Einflüsse eingegeben werden. Aus Messungen weiss man indes lediglich, dass CO2 eine Klimasensitivität von 1,1 Grad bei einer Verdopplung des CO2-Gehalts hat. Aus Modellsimulationen kommt man inklusive Rückkopplungen auf den etwa dreifachen Wert. Die Sonnenaktivität wird mit nahe null berücksichtigt, denn man stellt fest, dass die gesamte Sonneneinstrahlung während des elfjährigen Sonnenzyklus nur unwesentlich schwankt. Zwar schwankt die UV-Strahlung im Prozentbereich und das Magnetfeld der Sonne im Verlauf der Jahrzehnte um 10 bis 20 Prozent. Da man aber einen Mechanismus, wonach ein schwankendes Magnetfeld oder auch eine schwankende UV-Strahlung die Erdatmosphäre stark beeinflussen können, nicht berücksichtigt, bleibt es bei der Aussage: Die Sonne macht kein Klima. Dass es Hunderte von wissenschaftlichen Arbeiten gibt, welche die Warmzeiten und Kaltzeiten der Menschheitsgeschichte mit der solaren Aktivität in Zusammenhang bringen, ist für das Uno-Gremium nicht von Bedeutung. Was nicht zur Theorie passt, wird einfach ignoriert.

Zweifellos gibt es auch noch den Einfluss ozeanischer zyklischer Strömungen, im Atlantik wie auch im Pazifik, auf das Temperaturgeschehen. Diese können innerhalb eines sechzigjährigen Zyklus um plus/minus 0,3 Grad schwanken. Man kann diese Zyklen mit den IPCC-Rechenmodellen immer noch nicht zutreffend berücksichtigen. Also schlägt man Erwärmungseffekte, die in den letzten dreissig Jahren hierdurch bedingt sind, einfach dem CO2 zu. So einfach geht das.

Und dann gibt es noch einen kühlenden Effekt, der in die Rechenmodelle eingeht: die Aerosole. Dabei handelt es sich um Staubteilchen und Tröpfchen zum Beispiel aus Schwefeldioxidemissionen. Dummerweise ist aber die Unsicherheit über die Wirkung der Aerosole extrem hoch. Sie streuen in den Modellen um den Faktor zehn und können in den Computerberechnungen immer so eingesetzt werden, dass CO2 und Realität zur Übereinstimmung gebracht werden können. Die Aerosole sind, samt ihrer Wirkung auf Wolken, der Joker im Spiel der Klimamodellierer: Man berücksichtigt sie je nach Bedarf – stärker oder schwächer oder auch gar nicht.

So gelingt es dann insgesamt, die CO2-Wirkung auf das Klima um den Faktor drei höherzuschrauben. Begründet wird dies mit der Annahme, dass CO2 zu einer Erwärmung der Ozeane führt und dass Wasserdampf einen viel stärkeren Einfluss auf das Klima zeitigt als CO2. Auch Wolken sollen angeblich modelltechnisch ein positives Feedback bewirken. Über diesen kleinen Umweg erreicht das CO2 seine allmächtige, das Klima fast im Alleingang steuernde Wirkung.

Doch was passiert, wenn die steigende Verdunstung der Meere zu mehr Wolkenbildung führt und Wolken sich insgesamt abkühlend auswirken? Man weiss es nicht, weil bislang die Rechenmodelle die Wolken nicht berechnen können.

Viel Unsicherheit also. Trotzdem ist man ganz fest dabei, die Politik zu überzeugen, dass das CO2 auf null gebracht werden muss, weil es in so dominanter Weise das Klima verändert.

Wie war es nur möglich, dass es in der mittelalterlichen Wärmeperiode von 900 bis 1150 ebenso warm war wie heute – und das bei tieferen CO2-Konzentrationen. Eine Reihe von Publikationen zeigt, dass die Erwärmung nicht nur ein Phänomen in Grönland oder Nordeuropa war, sondern alle Erdregionen weltweit umfasste.

So warm wie heute

Und wie konnte es dramatisch kühler werden während der Kleinen Eiszeit (1600 bis 1820), ohne dass das CO2 seine Finger im Spiel hatte? Hungerkatastrophen und Kriegen um schwindende Ressourcen fielen in jenem Zeitraum Millionen von Menschen zum Opfer. Warum sollte die Natur diese Schwankungen um mehrere Grad Celsius nach 1850 einfach eingestellt haben?

Das sind unangenehme Fragen. Daher hat es immer wieder Versuche gegeben, die Vergangenheit zu retuschieren. Das berühmteste Beispiel ist diehockey stick-Kurve von Michael Mann. Dabei wurden die Berechnungen so manipuliert, dass die mittelalterliche Warmzeit verschwindet und auch die Kleine Eiszeit als transitorisches kühles Lüftchen eingestuft werden konnte. Denn es stellte sich heraus, dass die Modelle, die an den Temperaturentwicklungen zwischen 1850 und heute angepasst wurden, die Vergangenheit vor 1850 nicht zutreffend wiedergeben konnten.

Weder die mittelalterliche Wärmeperiode noch die Kleine Eiszeit scheinen in den Modellrechnungen je existiert zu haben. Weil menschengemachte Emissionen aber die einzigen Stellschrauben in den Modellen sind, versagen diese, wenn die Ursachen der Klimaänderung natürlichen Ursprungs sind. Und so verwundert es nicht, dass die mittelalterliche Warmzeit, die so warm war wie die heutige Warmzeit, von ausserordentlich hoher Sonnenaktivität gekennzeichnet war. Eine Aktivität, die wir als solares Maximum auch für das 20. Jahrhundert feststellen: So aktiv wie im letzten Jahrhundert war die Sonne seit fast 2000 Jahren nicht mehr. Dass in der Kleinen Eiszeit die Sonne ihre Sonnenfleckenaktivität über ein halbes Jahrhundert vollständig einstellte (Maunder-Minimum), passt da ins Bild.

Wie schrecklich sind 0,9 Grad?

Die Basis für die heutige Erwärmung ist das Ende der Kleinen Eiszeit. Es war die kälteste Zeit in der Geschichte der letzten 10 000 Jahre. Doch ist das wirklich die richtige Basis für Klimaziele? Wer wollte dahin zurück? Nimmt man den Mittelwert der letzten 2000 Jahre, so wäre als Nulllinie eher das Klima zwischen 1940 und 1970 als Basis geeignet. Damit hätten wir bisher eine Erwärmung von 0,5 Grad festgestellt – eine Abweichung also vom langjährigen Mittelwert, die schon die zyklischen Temperaturschwankungen im Atlantik und im Pazifik von plus/minus 0,3 Grad mit sich bringen.

Mit der heute festzustellenden Erwärmung wären wir in der besten aller Klimawelten, wie uns ein Blick in die rund alle tausend Jahre stattfindenden Warmzeiten (minoisches, römisches und mittelalterliches Zeitalter) zeigt. Weil aber die katastrophalen Voraussagen der Klimamodelle, eine Erwärmung von 1,5 bis 4,5 Grad, in der Zukunft die Debatte bestimmen, müssen wir uns mit den Klimaprognosen beschäftigen.

Die Gleichgewichtsklimasensitivität ECS (Equilibrium Climate Sensitivity) beschreibt die Änderung des Temperaturniveaus durch eine Verdoppelung des CO2 von 280 auf 560 ppm nach Einstellen eines neuen Gleichgewichtes durch die Ozeane, was mehrere hundert Jahre beanspruchen dürfte. Hierfür gibt der IPCC die erwähnte Bandbreite von 1,5 bis 4,5 Grad Celsius an. Fast niemand in der Politik und in den Medien hat bislang offensiv kommuniziert, dass dies nach den Vorstellungen des IPCC ein über mehrere Jahrhunderte dauernder Prozess ist.

Doch wie wirkt sich eine Verdoppelung des CO2 in diesem Jahrhundert aus? Eine Antwort liefert uns die transiente Klimaantwort TCR (Transient Climate Response). Sie gibt uns die Änderung der Temperatur bei Verdoppelung des CO2-Gehaltes in der Luft an zum Zeitpunkt, in dem 560 ppm erreicht worden sind. Nehmen wir also an, dass bei einem jährlichen Zuwachs von 2 ppm CO2 der Wert (heute 411 ppm) in 75 Jahren erreicht werden wird, also im Jahre 2094. Dann beträgt der entsprechende Temperaturanstieg von 1850 bis 2094 nach Angaben des IPCC 1 bis 2,5 Grad. Als wahrscheinlichster Wert wird 1,8 Grad angegeben.

Das hört sich nicht besonders gefährlich an, wenn man bedenkt, dass hiervon schon angeblich 0,9 Grad durch bisherige CO2-Emissionen verursacht wurden. Natürlich bewegt sich im Modell des IPCC die Temperatur nach 2100 in Richtung 4,5 Grad, jedoch – immer unter der Voraussetzung, dass sich die Prognostiker nicht irren – in mehreren hundert Jahren. Wissen das unsere Politiker? Wissen das die Bürger?

Doch es wird noch besser. Mittlerweile sind die ECS- und TCR-Werte des Weltklimarates einer Erosion unterworfen. Sie schmelzen gleichsam mit den Alpengletschern.

Thorsten Mauritsen vom Max-Planck-Institut in Hamburg und Robert Pincus von der Colorado-Universität kamen 2017 in der ZeitschriftNature Climate Changezum Ergebnis, dass der ECS-Wert nur noch 1,79 Grad betrage und der TCR-Wert 1,32 Grad. Zu einem ähnlichen Ergebnis kamen die Klimaforscher Judith Curry und Nicholas Lewis 2018 in einer Veröffentlichung der American Meteorological Society (ECS: 1,7 Grad, TCR: 1,33 Grad). Diese beiden Arbeiten sind die zurzeit besten Abschätzungen der Auswirkungen des CO2-Anstiegs aus realen Betrachtungen.

Bemerkenswert bei beiden wissenschaftlichen Publikationen ist, dass sie sich am unteren Rand der Bandbreite, die der IPCC für die Temperaturentwicklung vorsieht, befinden. Alle Arbeiten zur Abschätzung der Sensitivität unseres Klimas aus tatsächlichen Beobachtungen kommen zu niedrigeren Empfindlichkeiten gegenüber CO2, als die Modelle des IPCC ergeben.

Bei einer ECS von 1,7 Grad langfristig und einer TCR von rund 1,3 Grad können wird die Klimakatastrophe bis 2100 getrost absagen. Damit die vom IPCC angestrebten 2 Grad nicht überschritten werden, dürften wir die 560 ppm nicht wesentlich überschreiten. Das bedeutet, dass die Emissionen in den nächsten hundert Jahren auf das vorindustrielle Niveau gesenkt werden müssen. Auch das ist eine gewaltige Herausforderung. Doch wir hätten viel mehr Zeit für eine nachhaltige Energiezukunft, mit welcher Technologie auch immer. Das Ziel wäre über drei Generationen, nicht über drei Legislaturperioden hinweg zu bewältigen.

Auf null bis 2050 – wirklich?

In Anbetracht der aussergewöhnlich hohen Unsicherheit, des Versagens der Klimamodelle und der immer deutlicher werdenden wissenschaftlichen Erkenntnisse, dass die Klimamodelle zu heiss laufen, bleibt eigentlich nur eine vernünftige Strategie. Es ist richtig, die CO2-Verminderung auf globaler Ebene anzustreben, aber wir müssen diese immer wieder am realen Erwärmungsprozess nachjustieren. Wenn sich wider Erwarten die Katastrophenszenarien des IPCC nicht in Luft auflösen, müssen wir auf drastischere CO2-Minderungs-Schritte vorbereitet sein. CO2-arme Technologien müssen auf jeden Fall entwickelt werden. Varianten gibt es viele: Kernfusion, inhärent sichere Kernkraftwerke, fossile Kraftwerke mit CO2-Sequestrierung und natürlich auch erneuerbare Energien. Es wäre ausgesprochen dumm, sich auf eine bestimmte Option zu versteifen und andere a priori auszuschliessen.

Wenn die Klimareaktion auf das CO2 bei einem TCR-Wert von 1,3 Grad liegt, haben wir bis 2100 Zeit, um das vorindustrielle Emissionsniveau zu erreichen. Dabei ist es unerheblich, ob Deutschland und Europa 2050 oder 2100 auf netto null kommen. Entscheidend ist: Was macht die Welt, und vor allem, was macht China? Zu glauben, dass China, wie in Paris versprochen, bis 2030 die CO2-Emissionen von 8,9 Milliarden Tonnen auf (nur!) 12,5 Milliarden Tonnen ansteigen lassen wird, um diese hernach in zwanzig Jahren auf null zu senken, wäre schon arg naiv. Chinas Regierung selbst rechnet im 2050 mit den gleichen Emissionen wie heute, was schon eine gewaltige Anstrengung voraussetzt. Oder entspricht es etwa der europäischen Logik, dass wir unsere Industriegesellschaft zerstören, damit China richtig aufblühen kann?

Der Weltklimarat oder die «Fridays for future» sind der KP von China so ziemlich egal. Für die Chinesen ist gut, was China nützt, darüber sollten wir uns keine Illusionen machen. Wie China mit internationalen Abkommen umspringt, zeigte erst kürzlich der Bruch des Montreal-Abkommens. Das Übereinkommen, das für China 2002 in Kraft getreten ist, verbietet die Produktion und das Inverkehrbringen von Ozonschicht-schädigenden FCKW. Seit 2013 stossen chinesische Fabriken wieder jährlich mehr als 7000 Tonnen der verbotenen Gase aus. Reaktionen der Weltgemeinschaft: null.

1600 Kohlekraftwerke werden zurzeit weltweit in 62 Ländern gebaut, die meisten übrigens durch chinesische Firmen und mit Hilfe chinesischer Kredite. Konkret heisst das gemäss derSouth China Morning Post:15 300 MW zusätzlicher Kohlestrom für Pakistan, 16 000 MW für Bangladesch, selbst Myanmar will mit zusätzlichen 5100 MW seine Wirtschaft anheizen. Insgesamt wird die Kohlekraftwerkskapazität weltweit nicht reduziert, sondern um 43 Prozent erweitert. Das ist keine theoretische Modellrechnung, sondern die Realität. Und in Deutschland proklamiert die Bundeskanzlerin netto null für 2050.

Katastrophenwarnungen gab es schon viele. Die einen bewahrheiten sich, andere nicht, oft kam es auch ganz anders, als man dachte. Das nächstliegende Szenarium aber wäre zurzeit: Die Welt stellt sich bis 2100 langsam um, und Deutschland stürzt in zehn Jahren ab.

=====================================

Prof. Dr. Fritz Vahrenholt hat in Chemie promoviert und ist Honorarprofessor an der Universität Hamburg. Als Vertreter der SPD war er Umweltsenator in Hamburg (1991 bis 1997). Unter Bundeskanzler Gerhard Schröder war er auch als Berater für Energiefragen auf Bundesebene tätig.

=================================================================

)* Anmerkung der EIKE-Redaktion :

Dieser Artikel ist zuerst erschienen in der WELTWOCHE Zürich : Fritz Vahrenholt, „Fabrikation von Wahrheiten“ | Sonderheft „Klimawandel für die Schule“, (11.07.2019) ; http://www.weltwoche.ch/

EIKE dankt der Redaktion der WELTWOCHE und dem Autor Fritz Vahrenholt für die Gestattung der ungekürzten Übernahme des Beitrages.

=================================================================