Der Juli 2019 war nicht der wärmste Juli jemals

Man würde denken, dass für eine solche Abschätzung nur die besten verfügbaren Daten herangezogen werden würden. Schließlich stammen die Angaben von offiziellen regierungsamtlichen Stellen (NOAA, WMO).

Aber die derzeitigen offiziellen Verkündigungen globaler Temperaturrekorde stammen von einer ziemlich limitierten Anzahl fehleranfälliger Thermometer, welche niemals dazu gedacht waren, globale Temperaturtrends zu ermitteln. Das globale Thermometer-Netzwerk weist drei große Probleme auf, wenn es um global gemittelte Temperaturwerte geht:

1) Der städtische Wärmeinseleffekt (UHI) hat zu einer graduellen Erwärmung der meisten Thermometer-Messstellen geführt wegen zunehmender Bebauung, der Einrichtung von Parkplätzen und Maßnahmen zu Air Conditioning, Autos usw. Diese Effekte sind lokaler Natur und nicht repräsentativ für die meisten globalen Festlandsgebiete (die zumeist weiterhin ländlich geprägt sind), und diese Erwärmung ist keinesfalls dem zunehmenden Kohlendioxid-Anteil in der Atmosphäre geschuldet. Weil die UHI-Erwärmung wie eine globale Erwärmung „aussieht“, ist es schwierig, diese aus den Daten zu entfernen. Tatsächlich sieht es so aus, als ob die Bemühungen der NOAA, UHI-kontaminierte Daten wie Daten aus ländlicher Umgebung aussehen zu lassen, den gegenteiligen Effekt hatten. Die beste Strategie wäre es, einfach die Daten der besten Thermometer-Standorte (in ländlicher Umgebung) heranzuziehen, aber genau das wird derzeit nicht gemacht.

2) Wassertemperaturen der Ozeane sind notorisch unsicher wegen wechselnder Messverfahren (vor langer Zeit Messungen mittels Eimer-Stichproben, dann Messungen der Temperatur in einströmendem Kühlwasser der Schiffsmotoren, Bojen und Satellitenmessungen erst seit 1983 usw.)

3) Sowohl Land- als auch Wassertemperaturen sind geographisch notorisch unvollständig. Wie kann man Temperaturen abschätzen in einem Gebiet von 1 Million Quadratmeilen, wo es keine einzige Messung gibt?

Es gibt bessere Möglichkeiten.

Ein vollständigeres Bild: Datensätze globaler Re-Analysen

An vielen Wettervorhersage-Zentren weltweit arbeiten Experten, welche eine Vielfalt von Daten aus allen möglichen Quellen auswerten und herausfinden, welche dieser Daten Wetterinformationen enthalten und welche nicht.

Aber wie können sie diesen Unterschied erkennen? Weil gute Daten zu guten Wettervorhersagen führen und schlechte Daten nicht.

Unter den Datenquellen sind Thermometer, Bojen und Schiffe (wie in den „offiziellen“ globalen Temperatur-Berechnungen), aber auch zusätzlich Daten von Wetterballonen, kommerziellen Flugzeugen und eine Vielfalt von Daten aus Satellitenmessungen.

Warum sollte jemand nicht von der Erdoberfläche stammende Daten verwenden, um bessere Messungen an der Oberfläche zu bekommen? Da das Wetter an der Oberfläche die Wetterbedingungen in der höheren Atmosphäre beeinflusst (und umgekehrt), kann man eine bessere Schätzung der globalen mittleren Temperatur erhalten, falls man Temperaturmessungen via Satelliten im globalen Maßstab in der freien Atmosphäre hat und auch in Regionen, in denen es gar keine Daten von der Oberfläche gibt. Aus Satellitendaten ableiten zu können, ob es sich um eine warme Luftmasse oder um eine kalte Luftmasse handelt, ist besser als überhaupt keine Daten zu haben.

Außerdem verlagern sich Wettersysteme. Und darin liegt auch der Sinn von Re-Analysen-Datensätzen: Weil all die verschiedenen Datenquellen sorgfältig durchforstet worden sind, um zu sehen, welche Mischung derselben zu den besten Wettervorhersagen führte (einschließlich Adjustierungen möglicher Instrumentenfehler und zeitlicher Verlagerung), wissen wir, dass die physikalische Konsistenz der verschiedenen eingehenden Daten ebenfalls optimiert waren.

Ein Teil dieses Verfahrens des Erstellens von Vorhersagen ist es, „Daten“ zu erhalten, wo es keine Daten gibt. Weil Wettersysteme unentwegt um die Welt ziehen, können die Gleichungen für Verlagerung, Thermodynamik und Feuchtigkeit herangezogen werden, um Temperaturwerte dort abzuschätzen, wo es keine Daten gibt, indem man vorhandene Daten in anderen Gebieten extrapoliert und dann beobachtet, wie sich das Wettersystem verhält, wenn es in Gebiete ohne Daten zieht. Darum wussten wir im Voraus, dass es in Frankreich einige außerordentlich heiße Tage geben würde, weil eine Luftmasse aus der Sahara bis nach Westeuropa vorankommen würde.

Diese Art der Extrapolation auf physikalischer Grundlage (nichts anderes ist Wettervorhersage) ist viel realistischer als beispielsweise die Temperaturen auf dem Festland rund um die Arktis zu messen und einfach zu raten, wie die Temperaturverhältnisse über dem kalten Meerwasser und dem Eis beschaffen sind, wo die Temperatur im Sommer selten deutlich über den Gefrierpunkt steigt. Tatsächlich ist dies eine der höchst fragwürdigen Verfahren von NASA GISS, um Daten aus datenfreien Gebieten zu erhalten.

Falls man denkt, dass das Re-Analyse-Verfahren fragwürdig klingt, weise ich nochmals darauf hin, dass genau dieses für die tägliche Wettervorhersage herangezogen wird. Zwar können wir uns über einige falsche Wettervorhersagen lustig machen, aber die objektiven Beweise zeigen, dass Vorhersagen für 2 bis 3 Tage im Voraus ziemlich genau sind, und sie werden mit der Zeit immer weiter verbessert.

Das Re-Analyse-Bild für den Juli 2019

Die einzigen Re-Analyse-Daten, die ich kenne und die fast in Echtzeit zu erhalten sind, stammen von WeatherBell.com und kommen vom Climate Forecast System der NOAA, Version 2 (CFSv2).

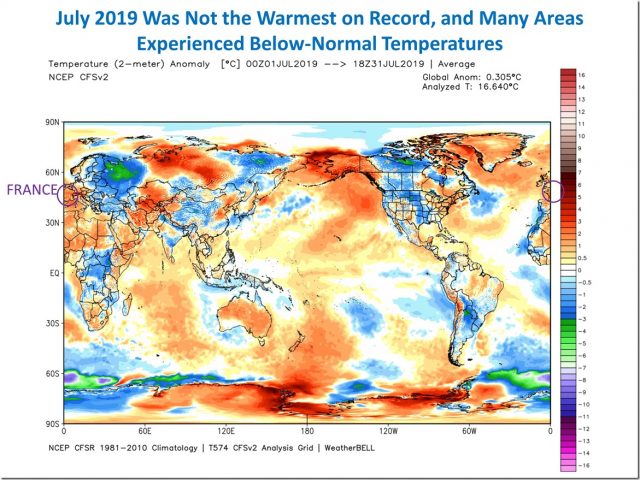

Die Graphik der Temperaturabweichungen vom Mittel des Zeitraumes 1981 bis 2010 zeigen für Juli 2019 eine globale mittlere Abweichung von lediglich etwas über 0,3°C über den Normalwerten:

Man beachte bei dieser Graphik, wie verzerrt die Berichterstattung in den Nachrichten war, als es um die vorübergehenden heißen Orte in Frankreich ging. Den Medienberichten zufolge sollen sie zur globalen mittleren Erwärmung beitragen. Ja, in Frankreich war es im Juli ungewöhnlich warm. Aber man betrachte die kalten Gebiete in Osteuropa und Westrussland. Wo gab es Berichte darüber? Was ist mit der Tatsache, dass es in den USA allgemein kälter als normal war?

Der Re-Analyse-Datensatz CFSv2 reicht nur bis zum Jahr 1979 zurück, und doch erkennt man, dass der Juli 2019 seit 41 Jahren an vierter Stelle der wärmsten Juli-Monate lag: in den Jahren 2016, 2002 und 2017 war es jeweils wärmer. Und eine Abweichung vom Mittelwert von +0,3°C ist nun wirklich nicht alarmierend.

Warum verwendet man bei der Verfolgung der globalen Temperaturen keine Re-Analyse-Datensätze?

Die Hauptbegrenzung der Re-Analyse-Datensätze liegt darin, dass sie meist nur bis 1979 zurück reichen, und ich glaube, dass mindestens einer bis 1950 zurückreicht. Da man bei der Berechnung globaler Temperaturtrends Daten so weit zurück reichend wie möglich haben will (zumindest bis zurück zum Jahr 1900 oder davor), können sie legitimerweise sagen, dass sie ihre eigenen Datensätze konstruieren wollen aus den längsten Datenreihen: von Thermometer-Messungen.

Aber der größte Teil der Erwärmung ereignete sich während der letzten 50 Jahre, und falls man versucht, die globale Temperatur mit Treibhausgas-Emissionen zu verlinken, scheint der Zeitraum seit 1979 ausreichend, da dies der Zeitraum mit den höchsten Treibhausgas-Emissionen ist.

Also schlage ich vor, dass man globale Re-Analyse-Datensätze heranzieht, weil diese ein genaueres Bild geben für Schätzungen globaler Temperaturänderungen zum Zwecke des Erkennens von Erwärmungstrends während der letzten 40 Jahre und diese zeitlich nach vorne zu extrapolieren. Es sind eindeutig die Datensätze mit der besten physikalischen Grundlage. Sie wurden optimiert, um die besten Wettervorhersagen zu erstellen und sind viel weniger anfällig für willkürliche Eingriffe in Gestalt von Adjustierungen und damit dafür, die vom Provider gewünschten Antworten zu liefern anstatt die Physik der Atmosphäre für diese Antworten zugrunde zu legen.

Link: https://wattsupwiththat.com/2019/08/02/july-2019-was-not-the-warmest-on-record/

Übersetzt von Chris Frey EIKE