Die Ritter der Apokalypse sind in der Schweiz eingetroffen. Nicht mehr lange und die Erde wird im Fegefeuer des menschengemachten Klimawandels schmelzen. Wer nicht zur Beichte war, wird in den ewigen Flammen untergehen. Macht Euch auf, Ihr CO2-Sünder. Geht den Weg der Buße, den Pfad der Reue, die Chaussee des Ablasshandels: Zahlt Steuern auf CO2, hört auf zu fliegen, geht zu Fuß, bleibt zuhause, wartet … und betet, denn das Ende ist nahe.

„Schweizer Forscher entkräften Argument von Klimwandel-Leugnern“, behauptet der Spiegel. Eine kühne Behauptung. Das öffentlich-rechtliche Plagiat der ARD hat die Behauptung übernommenund zum alten Hut weiterentwickelt: „Die Erkenntnisse der Berner Wissenschaftler sind nicht grundlegend neu“. Neu sei, dass die Studie von „Raphael Neukom und sein[em] Team“, die ganze Erde, also Land und Meer, abdecke, so darf Mojib Latif in der ARD ausführen, um dem Leser den Eindruck zu vermitteln, die neue Studie von „Raphael Neukom und sein[em] Team“, sei quasi schon als richtig erkannt, bevor sie veröffentlicht wurde, denn: „Es gab beispielsweise bereits kontinentale Rekonstruktionen, die ebenfalls zeigten, dass die Phasen nicht gleichzeitig waren“. Dieser Satz, von Stefan Brönnimann, den die ARD als „Bonner Wissenschaftler“ präsentiert, ist das, was Stewart Hall „high context language“ genannt hat, ein sprachlicher Niederschlag, den nur verstehen kann, wer das kleine Haus des Bonner Wissenschaftlers bewohnt.

Was uns die ARD und die anderen deutschen Qualitätsmedien heute weismachen wollen ist, dass „Raphael Neukom und sein Team“ etwas bestätigt haben, was es schon als Erkenntnis gab, so dass es keinen Sinn mehr macht, nicht an den menschengemachten Klimawandel zu glauben.

Bekennet Eure Sünden, ihr Ungläubigen, die ihr nicht an den menschengemachten Klimawandels glaubt, tut öffentlich Buße und beantragt die Aufnahme in die Sekte der Kreationisten, die denkt, die Erde sei vom Klima-Gott vor 2000 Jahren geschaffen worden.

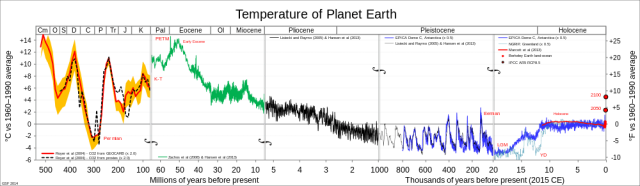

Denn, die Datenreihe, auf deren Grundlage „Raphael Neukom und sein Team“ gezeigt haben, dass „sich Warm- oder Kaltzeiten … nie auf der ganzen Welt gleichzeitig“ (Spiegel) entwickelt haben, dass „in früheren Zeiten … Klimaschwankungen vor allem regional und zu unterschiedlichen Zeiten“, nie aber gleichzeitig aufgetreten sind (Tagesschau), sie ist 2000 Jahre lang. Dass die „globale Erwärmung … beispiellos“ ist (Tagesschau) bzw. „Warm- oder Kaltzeiten“ mit Ausnahme von heute „nie auf der ganzen Erde gleichzeitig“ aufgetreten sind, diese umfassenden Behauptungen, sie beruhen auf einer Stichprobe von 0,00004% Erdgeschichte.

Das ist etwas wenig, um dem Ergebnis dieser Studie zu vertrauen.

Aber es gibt noch mehr Gründe, um den Humbug aus der Schweiz nicht zu glauben. Es beginnt damit, dass „Raphael Neukom und sein Team“ gegenüber der Tagesschau und in ihrem Text allen Ernstes ihr Ergebnis damit feiern, dass es „mit sechs unterschiedlichen statistischen Methoden … so vielen wie noch nie“ errechnet wurde. Normalerweise ist die Verwendung mehrerer statistischer Methoden entweder ein Indiz dafür, dass ein vermeintlicher Forscher nach der Methode sucht, die ihm das beste Ergebnis für seine Zwecke liefert, oder es ist ein Indiz dafür, dass der Gaul mit einem Datenfuzzi durchgegangen ist. Wenn man weiß, was man untersuchen will, weiß man auch, welche statistische Methode für die Untersuchung am besten geeignet ist.

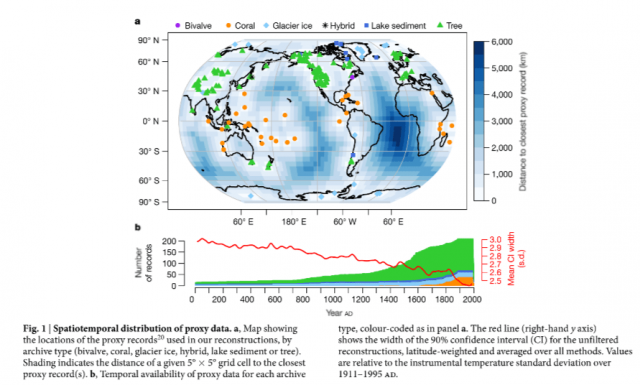

Die Ergebnisse der Studie von „Rapahel Neukom und sein[em] Team“, die in Nature Letter unter dem Titel „No evidence for globally coherent warm and cold periods over the preindustrial Commen Era“ veröffentlicht wurden, basieren auf den Daten der Pages 2K Datenbank, in der Ergebnisse unterschiedlicher Methoden, das vergangene Klima zu bestimmen, abgelegt sind, also die Ergebnisse aus der Untersuchung von Eisbohrkernen, aus der Analyse von Bäumen, Fluss- und See-Sedimenten, Gletschern und Korallenriffen. Der Datensatz ist ein Patchwork unterschiedlicher Erhebungsmethoden und somit auch unterschiedlicher Validität.

Als weiteren Datensatz benutzen „Raphael Neukom und sein Team“ den britischen HadCrut4-Datensatz, um eine globales Netz von Temperaturzellen errechnen zu können, simulieren zu können, dem sie die historischen Daten zuspielen. Wir haben vor einigen Tagen beschrieben, was es mit HadCrut4 und anderen Datensätzen, die die Erd-Temperatur abbilden sollen, auf sich hat.

Wenn man nun als Mensch, der mit normalem Verstand ausgestattet ist, von einer Analyse wie der hört, die „Raphael Neukom und sein Team“ durchgeführt haben, dann fällt als eine der ersten Fragen die folgende ein: In welchem zahlenmäßigen Verhältnis stehen Daten von vor 2000 Jahren zu Daten von heute? Es ist offenkundig, dass die Anzahl der Messdaten für die letzten 30 Jahre ein Vielfaches der Anzahl von Messdaten darstellt, die es für das 19. Jahrhundert gibt, geschweige denn für die Mittelalterliche Warmzeit oder die römische Warmzeit. Es ist darüber hinaus leicht einsichtig, dass die Menge der Daten, die für einen Zeitraum zur Verfügung stehen, das Vertrauen erhöht, das man in das hat, was zu dem entsprechenden Zeitraum gemessen wurde. Und für diejenigen, die den HadCrut4-Datensatz kennen, ist es spannend danach zu fragen, wie die Autoren damit umgegangen sind, dass es im HadCrut4-Datensatz viele leere Zellen gibt, für die keine Daten vorliegen, geschweige denn, historische Daten.

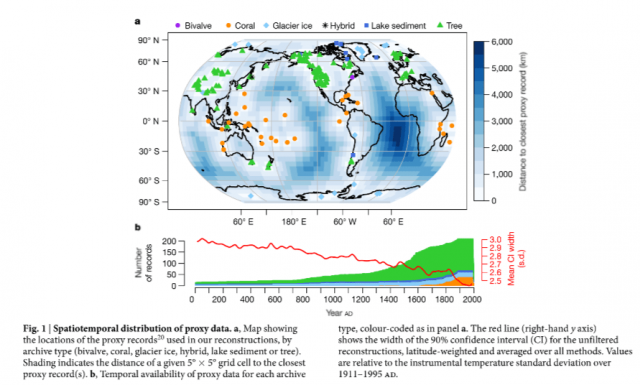

Zur Erläuterung: HadCrut4 teilt die Erde in Zellen von je fünf Längen- und Breitgraden Ausdehnung ein. Die Idee ist, für jede dieser Zellen mindestens eine verlässliche Messung zu haben, um die Gesamttemperatur der Erde dann aus der Kombination aller Zellen errechnen zu können. Die Wirklichkeit ist: Viele der Zellen sind schlicht leer, ein Problem, das auch „Raphael Neukom und sein Team“ nicht gelöst haben, wie die folgende Abbildung zeigt:

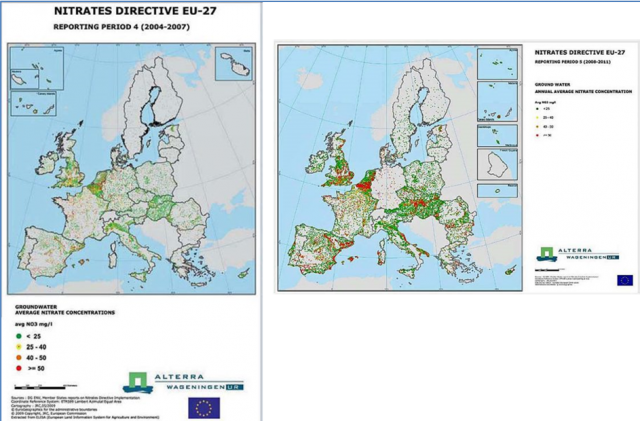

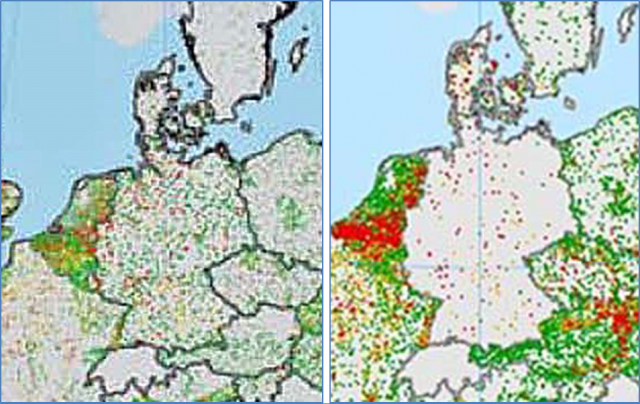

Oben sieht man in einem stark verzerrten Maßstab, die historischen Messdaten von „Raphael Neukom und sein[em] Team“. Die lustigen Punkte in lila, orange, hellblau, schwarz, dunkelblau und grün stellen die Daten dar, die 2000 Jahre Erdgeschichte abdecken sollen. Das machen sie ganz offenkundig nur für die nördliche Hemisphäre, während die südliche Hemisphäre weitgehend unerschlossen ist. Wenn die Ergebnisse von „Raphael Neukom und sein[em] Team“ verallgemeinerbar wären, dann sicher nicht für die südliche Hemisphäre. Eine weitere Nettigkeit, die aus HadCrut4 resultiert, versteckt sich in den unterschiedlichen „Blauschattierungen“, die die Entfernung der entsprechenden Zelle zum nächsten Messdatum angeben. Wie man sieht, sind die Ozeane nicht nur vom Weltall aus betrachtet blau, sondern auch im Modell von „Raphael Neukom und seine[em] Team“: Es handelt sich um leere Zellen, für die keinerlei Messwerte vorliegen. Die nächsten Zellen, die mit gemessenen Werten gefüllt sind, liegen in der Regel mehr als 3000 Kilometer entfernt.

Aber die Aussagen, die „Raphael Neukom und sein Team“ machen, sie sollen dennoch für die ganze Erde gelten. Die untere der beiden Abbildungen macht noch deutlicher, dass dieser Anspruch an Größenwahnsinn grenzt, denn die Verteilung der Messdaten ist, wie man es erwartet hätte: Je weiter zurück in der Zeit die Autoren gehen, desto spärlicher werden ihre Daten. Nicht wirklich das, was man eine verlässliche Datengrundlage nennt.

Ein Umstand, der auch „Raphael Neukom und sein[em] Team“ bewusst ist, denn sie schreiben:“

„An important caveat of our results is that the spatiotemporal distribution of high-resolution proxy data is inherently unequal and often sparse” (52).

Eine andere Art zu sagen: Die Daten sind Müll, die noch davon abgerundet wird, dass im ganzen Text keine Angaben dazu gemacht werden, wie verlässlich, valide, reliabel denn die Ergebnisse sind, die mit „sechs unterschiedlichen statistischen Methoden … so vielen wie noch nie“, errechnet wurden.

Was das schlechte Gefühl, das man mit Blick auf die Daten hat, zu einem mulmigen Gefühl mit Blick auf die Lauterkeit der Autoren und Peer Reviewer macht, ist das hier:

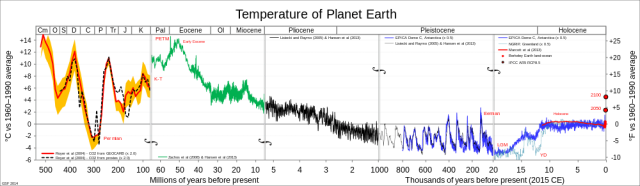

Die Datenreihe von „Raphael Neukom und sein[em] Team“ beginnt just zu einem Zeitpunkt, zu dem die Erde eine lange Phase der Abkühlung von rund 60 Millionen Jahren durchlaufen hat. Zufall oder bewusste Irreführung?

Für bewusste Irreführung spricht, was „Raphael Neukom und sein Team“ am Ende ihres Beitrags schreiben:

„Moreover, the spatial consistency seen in model simulations over the twentieth Century suggest that anthropogenic global warming is the cause of increased spatial temperature coherence relative to prior eras” (52).

Das ist Junk Science.

Denn „Raphael Neukom und sein Team“ haben keinerlei Maß für den menschlichen Einfluss in ihren Simulationen berücksichtigt. Sie werfen diese politisch-korrekte und wahrscheinlich für die Forschungsförderung relevante Behauptung in den Ring, um denen, die in Redaktionen nur darauf warten, ihr Klimahysterie-Garn weiterzuspinnen, Nahrung zu geben. Und natürlich wird in ARD und Spiegel sofort die CO2-Karte gespielt und behauptet, dass „Raphael Neukom und sein Team“ in ihrer „Studie“ gezeigt hätten, dass menschlicher Einfluss globale Erwärmung zum Ergebnis hat. Das haben Sie nicht. Wenn „Raphael Neukom und sein Team“ überhaupt etwas gezeigt haben, dann ihre Fähigkeit aus Datenlücken und spärlich in Zeit und Raum verteilten Messergebnissen eine konsistent Erzählung zu zimmern, die dem Zeitgeist, der in Redaktionen wütet, entspricht und den CO2-Ablasshandel ankurbelt.

Denn wisset, wer nicht seine Seele vom CO2-Fußabdruck freikauft, der wird im globalen Fegefeuer der Erde schmoren, auf ewig!

Der Beitrag erschien zuerst auf Science-Files hier