Bayern erGRÜNt

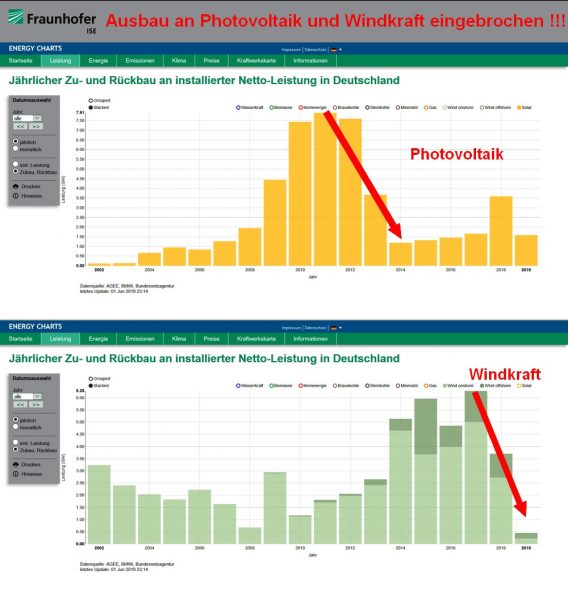

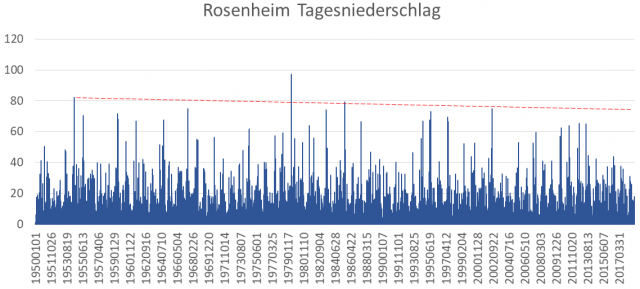

Mittlerweile rief die erste Bayerische Stadt (Erlangen) den Klimanotstand aus. Und auch der neue Ministerpräsident Söder hat – wohl durch Betrachten des Landtags-Wahlergebnisses – festgestellt, dass Bayern besonders (schlimm) vom Klimawandel getroffen sei. Anstatt sich besonnen zu informieren, dreht auch er nun ebenfalls durch – beziehungsweise wurde gleich populistisch wie sein Vorgänger – und fordert, die Kohlekraftwerke noch schneller als geplant vom Netz zu nehmen und durch teure, wie auch problematische Gaskraftwerke zu ersetzen [19]. Bleibt nur noch abzuwarten, wann auch ihn wie seinen Vorgänger, ebenfalls eine paulinische Erweckung überfällt und auch er die wegweisende, unfehlbare, große Führerfigur, Frau Merkel, bedingungslos anzuhimmeln beginnt und er ihr ebenfalls bescheinigt, sie wäre „einzigartig kompetent“ [22]. Einen „Kompetenzinhalt“ hat er schon übernommen: Bayern wird grüner (gemacht), als es die GRÜNEN fordern.

Da bei Problemen die Obrigkeit sich den Staat zuallererst vor Ansprüchen der Bürger schützt, wurde vorsichtshalber allerdings jegliche Unterstützung der Bürger für Klima-Schadensfälle gestrichen. Konsequenz: Da inzwischen alles nur noch die eine Ursache hat (die zum Himmel schreiende, falsche das gewüschte Ergebnis liefernde „Expertise“ eines Münchner Professors zur 5 m hohen Flutwelle in Simbach belegt es überdeutlich [20]), gibt es für Bürger vom Staat in solchen Fällen überhaupt keine mehr.

Der Bayerische Rundfunk hat sich des Themas seit Längerem angenommen und bringt regelmäßig Klimawandel-Propagandavideos [4] [5], um den Bürgern einzubläuen zu zeigen, wie wichtig und richtig das ist.

Reklamiert ein Bürger die „Reportagequalität“, behauptet gar, einiges wäre stark überzeichnet, würde ziemlich wahrscheinlich sogar nicht stimmen, weil recherchierbare Daten falsche Aussagen belegen, wird er belehrt, dass so etwas bei der überragenden Qualität der Öffentlichen gar nicht möglich ist und Kritik damit prinzipiell und ohne Nachprüfung unbegründet sei [3].

Nicht immer kommt es, wie bei den vom WDR/ARTE ganz offen als reine Klimawandel-Propaganda erstellten Reportagen so brachial herüber, obwohl auch der BR eine eigene Klima-Propagandasendereihe „fährt“, um die Bürger auf die richtige Doktrin einzustimmen:

BR Fernsehen, UNKRAUT 17.06.2019: Klimaschutz: Wann wacht die Politik auf?

Die Themen: Erderwärmung: Wie steht Bayern in Sachen Emissionen da? | Wald in Gefahr: Wie der Klimawandel unsere Bäume bedroht

In den meisten Fällen erfolgt es allerdings ganz subtil, dafür aber sicher nicht weniger wirkungsvoll. Deshalb die Gegendarstellung zu einem nicht schlimmen, aber eben typischem Beispiel.

Immer häufiger Extremniederschlag am Chiemsee

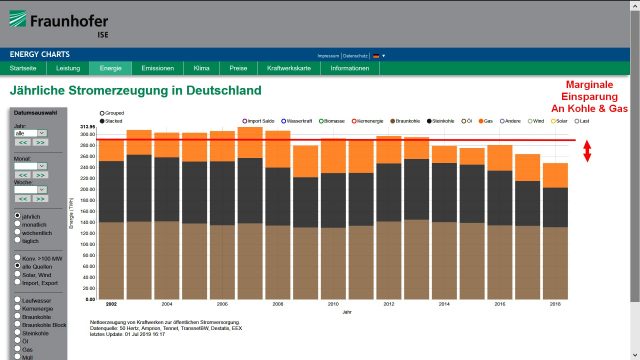

Im Chiemgau gibt es „seit ewigen Zeiten“ Überschwemmungen. Der BR berichtet darüber. Wo Überschwemmungen sind, kann der Klimawandel nicht weit sein. Denn wer sonst könnte solche verursachen? Nun, ganz so schlimm wird es nicht dargestellt. Überschwemmungen gab es – das wird zugestanden – auch früher schon. Aber: Es wird – wer hätte schon etwas anderes vermutet – immer schlimmer und schlimmer.

Bild 1 BR-Reportage zu Überschwemmungen im Chiemgau: BR Mediathek

In der Reportage interviewt der Sprecher einen dafür zuständigen „Staatsbediensteten“. Dieser ist aber penetrant nicht bereit, in die ihm wiederholt in den Mund gelegte Klimawandelhysterie einzustimmen.

Was macht man in einer solchen Reportage, wenn gerade das „Wichtigste“ noch fehlt? Man sucht so lange nach Personen, bis sich eine findet, die es besser – das heißt: richtig – weiß und vor der Kamera auch sagt. Solche, die die Natur täglich hautnah erleben, sind dafür prädestiniert, zum Beispiel aus der Landwirtschaft. Und ein solcher fährt im Video auch zufällig auf seinem Traktor vorbei und er weiß, was der „Staatsbedienstete“ sich weigert zu sagen:

Untermahlt von der bei solchen Sequenzen erforderlichen, düsteren und unheilschwangeren Musik kann er berichten:

Sprecher: … aber Landwirt … findet, dass sich etwas verändert hat.

Landwirt: … des is ja etz so, dass gerade die Starkregen wie mas die letzten Jahre etz ghabt hat, dass die scho extrem mehr wern … wie`s weiter wird, glaub i, woaß koaner ...

Diese Art der „Beweisführung“ durch Erleben, anstelle durch Daten, ist beim Klimawandel inzwischen so etwas wie ein Goldstandard [6]. Wobei die Anmerkung erlaubt sei, dass dies in der Klimafolgen-„Wissenschaft“ bereits als niveauvoll betrachtet werden muss. Denn eigentlich gilt es als ausreichender Beleg, eine mehr oder weniger honorige Person – gerne auch gut geschulte, einheimische Aktivisten – vor einer Strandkulisse ins Wasser zu stellen, um zum Beispiel den schlimmen Pegelanstieg zu zeigen [16] [24] [25]. Viele NGOs – auch Greenpeace usw. [6]– belegen auf diese Weise, was sie benötigen und niemand (außer dem Autor und anderen Wenigen) nimmt daran Anstoß.

Was der Landwirt fühlt, reicht dem BR

Nun anbei eine Wiederholung des immer gleichen Spiels: Was fühlt die selbsternannte Fachperson und berichtet der BR und was sagen dazu die (leicht recherchierbaren) Daten?

Wiederholung: Die befragte „Fachperson“ fühlt: … dass gerade die Starkregen in den letzten Jahren extrem mehr werden …

Was sagen Wetterdaten

Leider sind keine Daten von DWD-Wetterstation direkt am Chiemsee (mit abrufbaren Langzeitdaten) beim DWD frei zugänglich hinterlegt, aber darum herum finden sich welche.

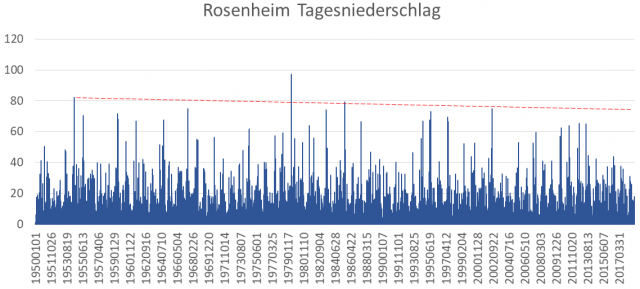

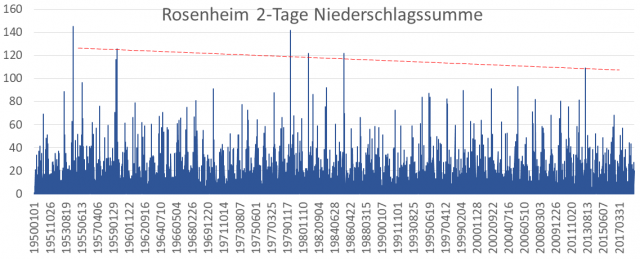

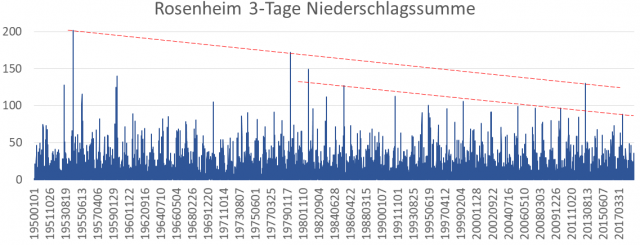

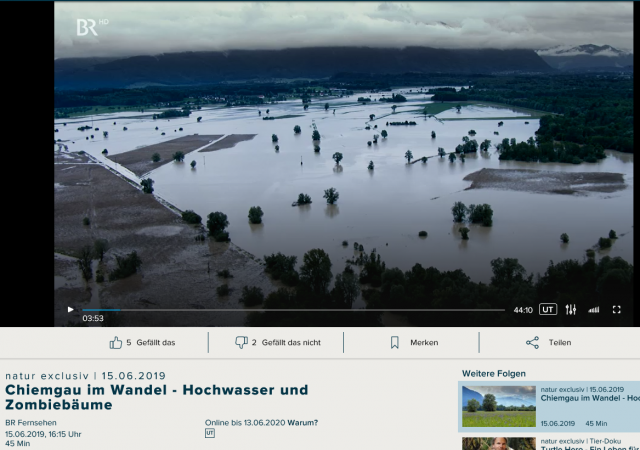

Zuerst vom ebenfalls oft und schlimm von Überschwemmungen getroffenen Rosenheim, ganz in der Nähe:

Bild 2 Rosenheim Tagesniederschlag 1950 -2018. Grafik vom Autor aus den DWD-Daten erstellt

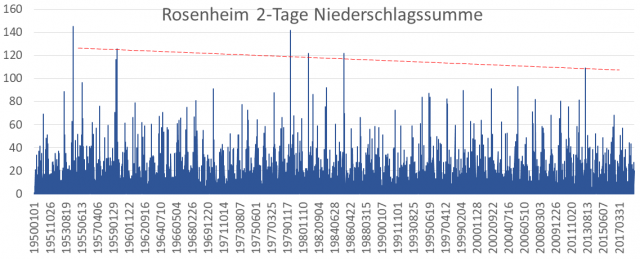

Bild 3 Rosenheim 2-Tage Niederschlagssumme 1950 -2018. Grafik vom Autor aus den DWD-Daten erstellt

Bild 4 Rosenheim 3-Tage Niederschlagssumme 1950 -2018. Grafik vom Autor aus den DWD-Daten erstellt

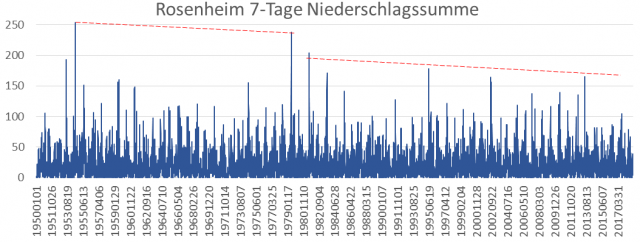

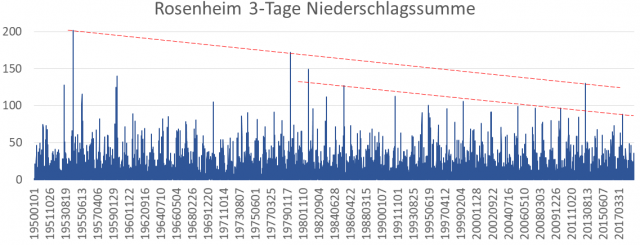

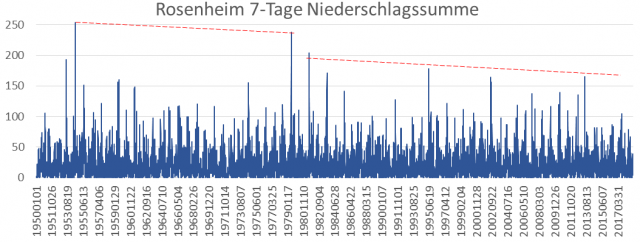

Bild 5 Rosenheim 7-Tage Niederschlagssumme 1950 -2018. Grafik vom Autor aus den DWD-Daten erstellt

Sichtungsergebnis der Stationsdaten

In keinem der drei Niederschlagssummen ist seit 1950 irgendwo eine Zunahme des Starkregens zu sehen; und schon gar nicht „in den letzten Jahren extrem mehr“. Seit der letzten, mittleren Niederschlagsspitze in 06.2013, also vor sechs Jahren hat der Extremniederschlag in allen Summen stark abgenommen.

Nun noch die vergleichende Auswertung vom Einzugsgebiet der Tiroler Ache (Haupt-Chiemseezufluss), bei Reit im Winkl.

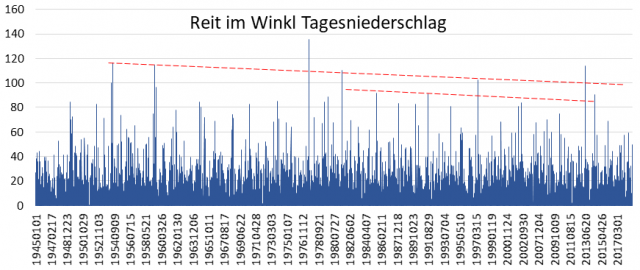

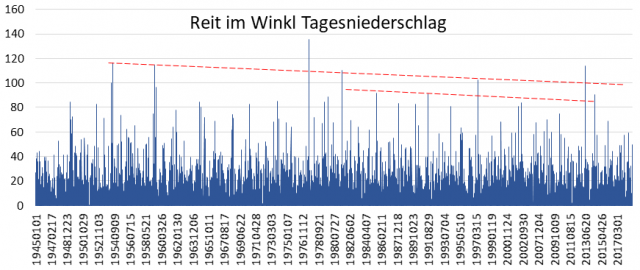

Bild 6 Reit im Winkl Tagesniederschlag 1945 -2018. Grafik vom Autor aus den DWD-Daten erstellt

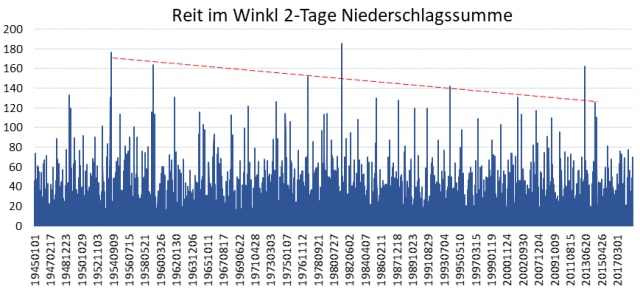

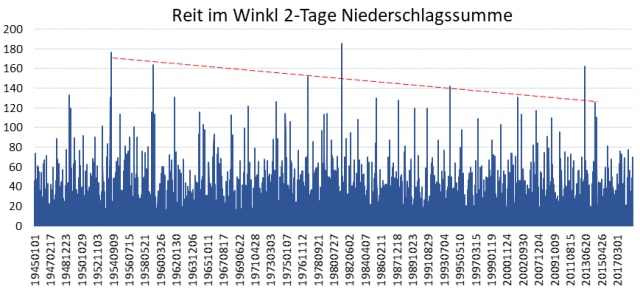

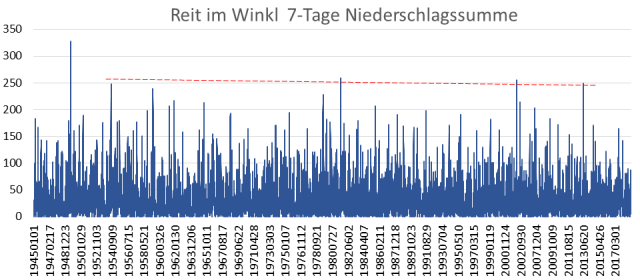

Bild 7 Reit im Winkl 2-Tage Niederschlagssumme 1945 -2018. Grafik vom Autor aus den DWD-Daten erstellt

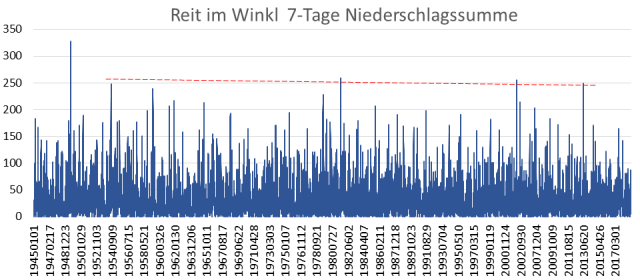

Bild 8 Reit im Winkl 7-Tage Niederschlagssumme 1945 -2018. Grafik vom Autor aus den DWD-Daten erstellt

Ergebnis

Reit im Winkl zeigt die gleichen Niederschlagsbilder wie Rosenheim. Auf keinen Fall eine Zunahme in den letzten Jahren, sondern ebenfalls eine stetige Abnahme.

Zur Abrundung nun noch Garmisch.

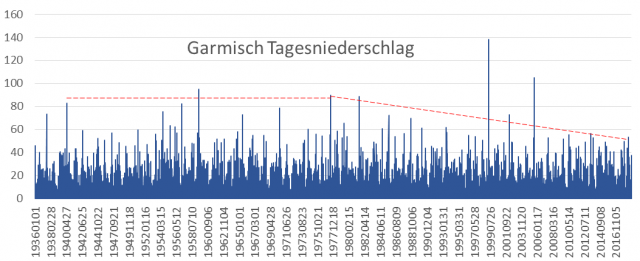

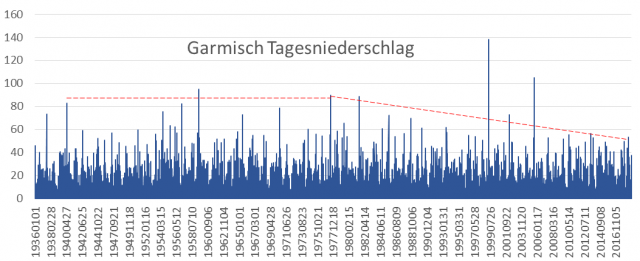

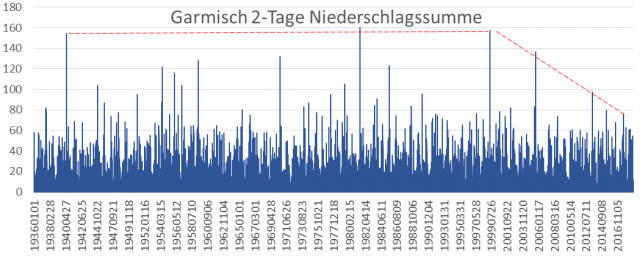

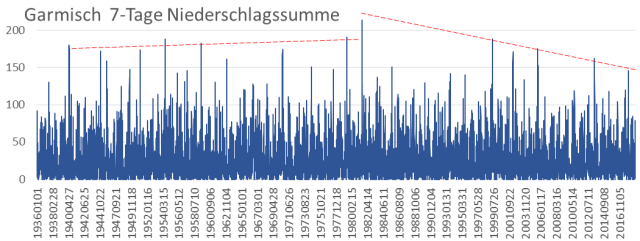

Bild 9 Garmisch Tagesniederschlag 1936 -2018. Grafik vom Autor aus den DWD-Daten erstellt

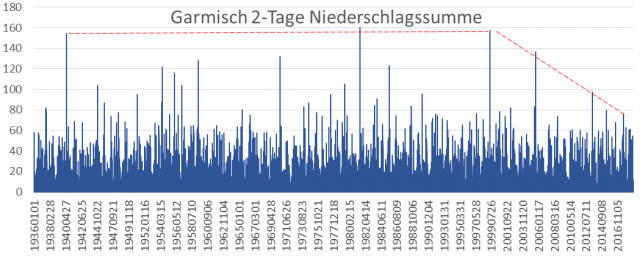

Bild 10 Garmisch 2-Tage Niederschlagssumme 1936 -2018. Grafik vom Autor aus den DWD-Daten erstellt

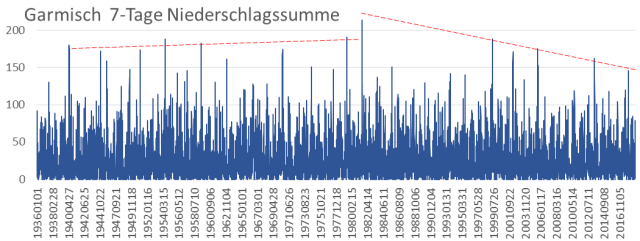

Bild 11 Garmisch 7-Tage Niederschlagssumme 1936 -2018. Grafik vom Autor aus den DWD-Daten erstellt

Ergebnis

Garmisch hat einen leicht abweichenden Verlauf, zeigt aber auch auf keinen Fall die berichteten „in den letzten Jahren extrem mehr“ Niederschlag. Der Tagesniederschlag (Bild 9) zeigt nur zusätzlich (wieder) die extreme Niederschlagsvarianz und wie solche vollkommen ohne irgendeine Vorwarnung oder Trend „aus dem Nichts“ auftauchen.

Die Niederschlagsverläufe der Chiemsee-Umgebung in Richtung der Berge zeigen: Der Bauer liegt mit seiner Aussage im Video daneben. Gefühlt ist eben nicht auch gewusst. Man könnte fast vermuten, dass der „Staatsbedienstete“ die Messdaten kennt und deshalb im Video so vorsichtig agiert.

Und das gilt nicht nur für Oberbayern, sondern zieht sich durch ganz Deutschland [7] [8].

Aber man braucht kein Hellseher zu sein, um zu ahnen, welche Aussage beim fernsehenden Publikum haften bleiben wird. Dies dank einer BR-Redaktion, welche die Wahrheit gar nicht wissen will.

Was weiß die Bayerische Regierung

Deren zuständiges Ministerium recherchiert, monitort und controllt inzwischen selbstverständlich auch den Klimawandel. Und darüber werden viele Berichte geschrieben. Einen gibt es vom Bayerischen Landesamt für Umwelt mit dem Titel:

[2] Hochwasser im Spiegel der Zeit

Daraus einige Angaben und Daten.

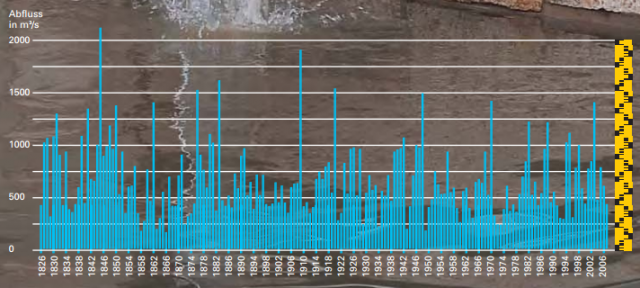

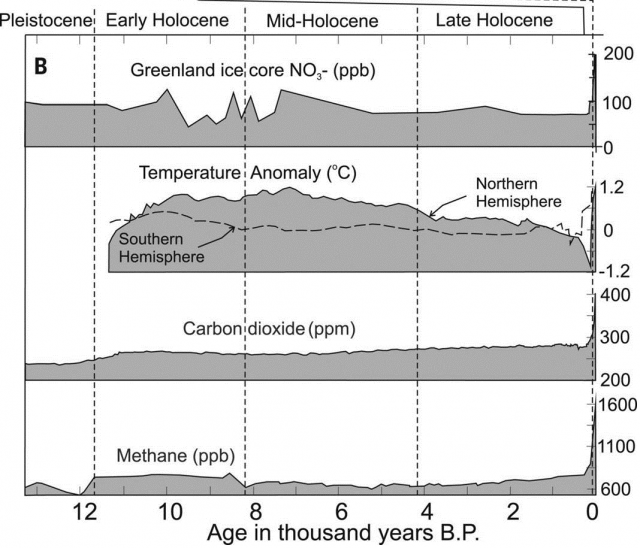

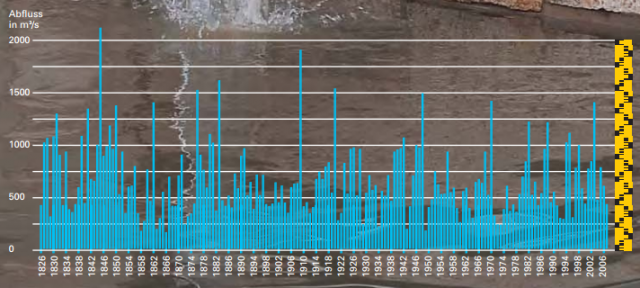

Zuerst nicht von Oberbayern, sondern vom Main die Hochwasserabflussmengen. Was EIKE-Leser bereits wissen, nehmen – seit es dank dem sich von der schlimmen, kleinen Eiszeit wieder etwas erwärmendem Klima – (nicht nur) am Main, die Hochwasser stetig ab.

Bild 12 [2] Main bei Würzburg. Jahres-Höchstabflüsse 1826 – 2007. Trendlinie vom Autor zugefügt

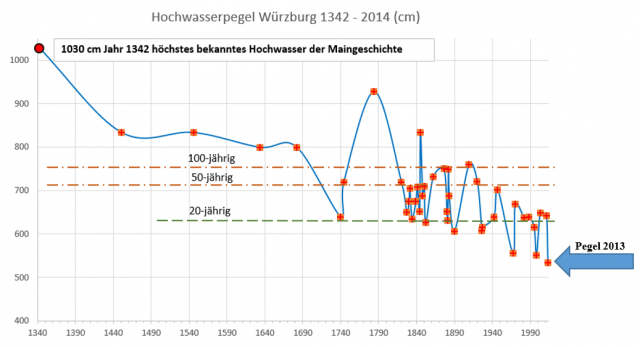

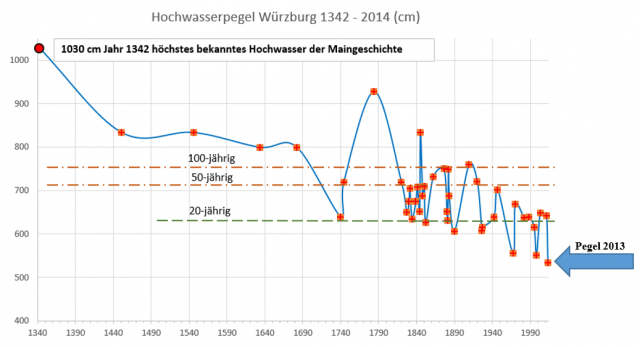

Noch besser lässt es sich an den Pegelständen sehen: So wenig Hochwasser wie in den letzten Jahrzehnten war noch nie. Trotzdem wurde 2013 bei Würzburg das Afrikafestival überschwemmt, weil die Stadt der Veranstaltung ein Überschwemmungsgebiet zugewiesen hatte. Doch der Schuldige war damals laut einer Zeitung natürlich der Klimawandel.

Bild 13 Main Historische Pegelstände Würzburg. 2013 wurde das Afrikafestival „wegen des Klimawandels, der immer höhere Hochwasser zur Folge hat“ (Artikel in einer Lokalzeitung) überschwemmt. Grafik vom Autor anhand der Pegelangaben erstellt

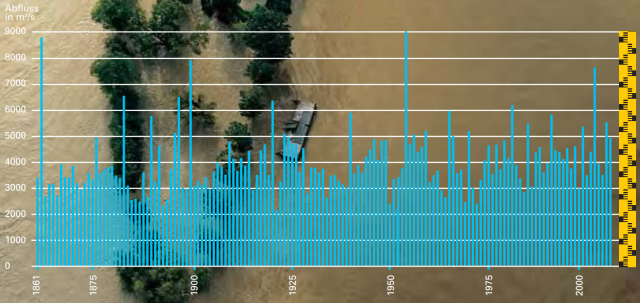

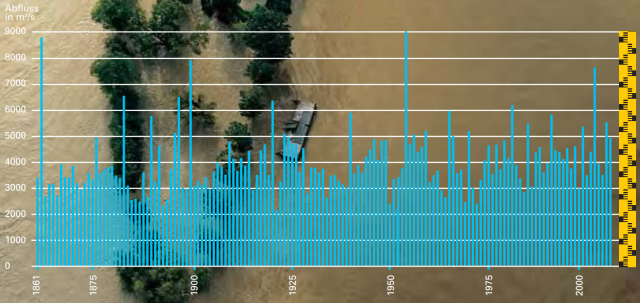

Nun wieder näher Richtung Oberbayern, Abflussmengen der Donau. Diese zeigen extreme Spitzen, aber ebenfalls keine Zunahme. Und alles, was kürzlich war, war in der (kälteren) Vergangenheit ebenfalls schon.

Bild 14 [2] Donau unterhalb Passau. Jahres-Hochstabflüsse 1861 – 2006, gemessen am Pegel Achleiten.

Anbei auch überregionale Fluß-Pegelbilder, um zu zeigen, wie die Auswirkungen solcher Höchstabflüsse konkret aussehen, vor allem aber auch um zu zeigen, dass die hohen und höchsten Flutpegel vor allem in der vor-industriellen, kalten Vergangenheit auftraten:

Bild 15 Pegel Main Aschaffenburg. Quelle: Wasserwirtschaftsamt Aschaffenburg, Homepage

Was man an den Pegelbildern sofort sieht: schlimme Hochwasser waren gerade und vorwiegend in der angeblich „natürlichen“, freundlichen, herbeigesehnten, vorindustriell kalten Zeit“ regelmäßige und häufige Ereignisse.

Ergänzend dazu Listungen aus der Schrift des Bayerischen Landesamtes für Umwelt [2]:

Isar bei München:

Überliefert sind große Hochwasser mit starken Verwüstungen aus den Jahren:

1400, 1401 , 1404, 1418, 1462, 1463, 1477, 1485 und 1491, 1589, 1624, 1633. 1729 standen das ganze Lehel und die Au unter Wasser. 1739 wiederum, aber viel höher – bis Thalkirchen bildete die Isar einen See. Weitere Hochwasser gab es 1778, 1783, 1786 drei, 1795 und 1802. 1807 riss das Hochwasser ein Achtel Grund der Au fort. 1813 ertranken hundert Schaulustige, als das Hochwasser die Ludwigsbrücke zum Einstürzen brachte. Weitere Hochwasser waren 1865, 1873 – Einsturz der Max-Joseph-Brücke – und 1875.

1899 riss ein Jahrhunderthochwasser die Prinzregentenbrücke und die MaxJoseph-Brücke ein – nur sechs Jahre

nach ihrer Fertigstellung.

Im 20. Jahrhundert suchten München große Hochwasser 1924, 1930, 1940, 1954 und 1999 (Pfingsthochwasser) heim. Das Augusthochwasser 2005 ist mit den großen Hochwassern der vergangenen Jahrhunderte vergleichbar.

Berchtesgaden

Im Berchtesgadener Talkessel sind viele historische Hochwässer dokumentiert. Besonders große Hochwässer herrschten 1269, 1386, 1403, im Juli 1508 und Oktober 1567, 1569, 1572, 1598, 1618/19, 1622, 1649, 1661, 1734, 1736, 1747, 1759, 1764, 1786, 1787, 1807, 1830, 1864, 1876, 1897, 1899, 1918 und 1920

1931 wurde in Schellenberg eine Pegelanlage eingerichtet. Nach den Pegelaufzeichnungen sind die Hochwässer 1954 und 1959 eindeutig mit Hochwasserspitzen von 3,50 m bzw. 3,59 m nachgewiesen. 1965 ließ man den Pegel in Schellenberg wieder auf und nahm einen neuen Pegel in Berchtesgaden in Betrieb.

Markante Wasserstände zeigen sich hier 1977, 1995, 2002 und 2005. 2002 wurde der Höchstwert von 2,95 m erreicht.

Expertenwissen

Trotzdem – beziehungsweise nicht unerwartet – kommt das Bayerischen Landesamtes für Umwelt nach Analyse der Niederschläge seit 1950 in der Schrift zu dem Ergebnis, dass Niederschlags-Extremereignisse in Oberbayern durch den Klimawandel bedingt zunehmen würden, schreibt aber gleich dazu, dass beim Niederschlag eine kurzfristige Betrachtung gar nicht aussagefähig ist: [2] … Ein Blick in die Hochwasserchronik der Stadt Passau zeigt aber, dass das Wetter und die Abflussbildung als hoch komplexes System mit vielen sich gegenseitig beeinflussenden Faktoren noch nie zur statistischen Mittelwertbildung geneigt haben. Nach Jahrzehnten mit nur moderat erhöhten Sommerabflüssen folgten immer wieder im Abstand von nur wenigen Jahren mehrere große, Schaden bringende Hochwasser hintereinander …

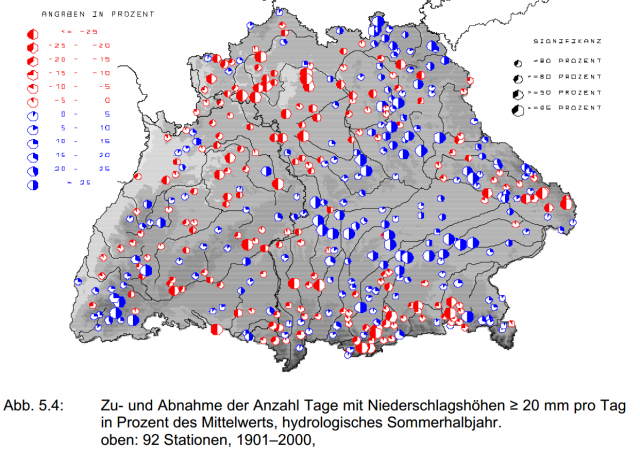

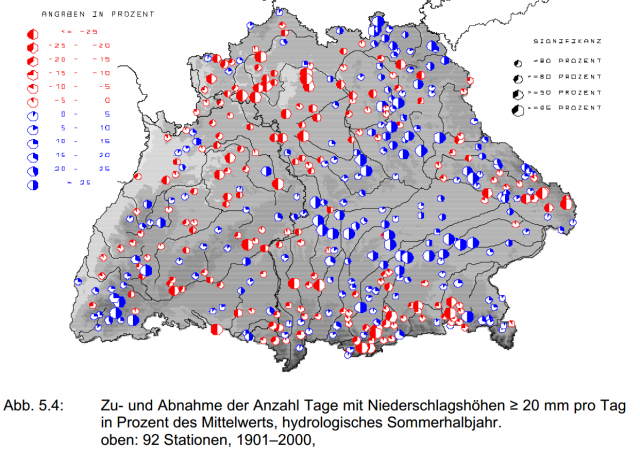

Um die Konfusion noch deutlicher zu machen, zeigt eine Auswertung der Schrift: [13] Monitoringbericht 2016 Niederschlag Zusätzliche Auswertungen für die KLIWA-Untersuchungsgebiete, des gleichen, Bayerischen Landesamtes für Umwelt, dass sich keine Signifikanz einer Zunahme zeigt, eher eine Abnahme [14]. Bestätigt wird dies durch eine Schrift des KLIWA-Projektes A 1.1.3 „Trenduntersuchungen extremer Niederschlagsereignisse in Baden-Württemberg und Bayern“ [19]:

… Im hydrologischen Winterhalbjahr zeigen die Starkniederschlagshöhen des Zeitraums 1931–2000 deutliche Zunahmen. Diese Zunahmen verstärken sich vereinzelt noch mit zunehmender Dauer (von 1 Tag bis 10 Tage) der Starkniederschläge. Regionale Schwerpunkte sind in Bayern die fränkischen Landesteile sowie Teile des Bayerischen Walds, in BadenWürttemberg der Schwarzwald sowie der Nordosten des Landes.

Im hydrologischen Sommerhalbjahr ist hingegen kein einheitlicher Trend bei den Starkniederschlägen festzustellen. Regionen mit einer Zunahme (z. B. Ostrand des Schwarzwaldes, Donautal, Teile Mittelfrankens) stehen große Gebiete mit einer Abnahme (z. B. Unterfranken, Südost-Bayern und Teile des Alpenvorlandes) bei insgesamt geringer Signifikanz gegenüber …

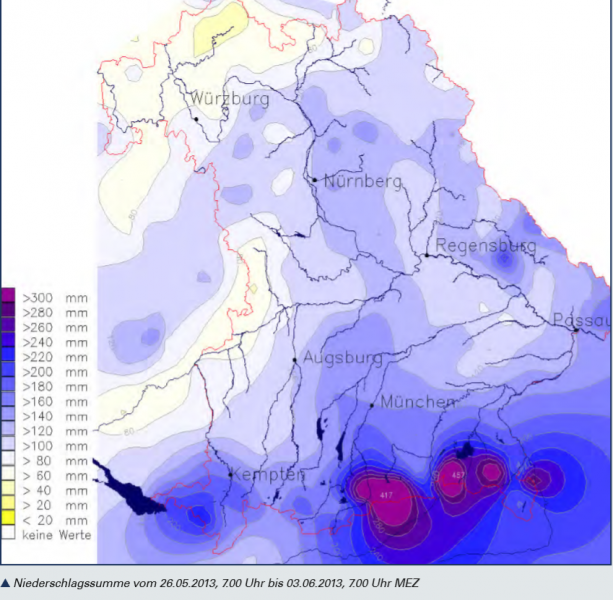

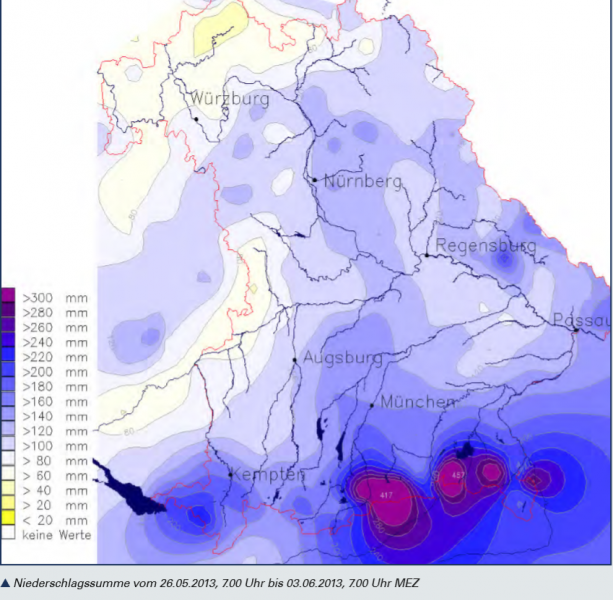

Dass das Überschwemmungsjahr 2013 ein Extrem war, zeigen die Bilder der Messstation von Reit im Winkl und das Bild der Niederschlagssummen vom 26.06.2013. Hier muss nochmals gesagt werden, dass der DWD für die Bürger nicht alle Daten zur Verfügung stellt. Viele der in der Schrift [15] gelisteten Messstation dieser Gegend finden sich im öffentlich zugänglichen DWD-Archiv nicht.

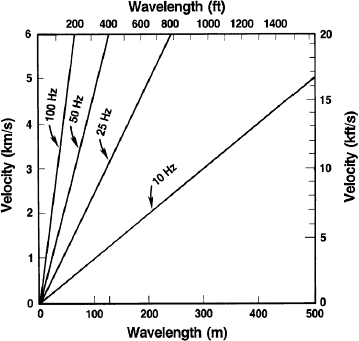

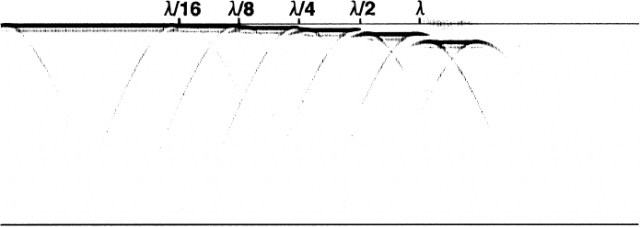

Bevor zur Betrachtung der Vergangenheit geschritten wird, anbei noch ein Bild, welches die Problematik von Niederschlags-Extremereignissen verdeutlicht: Sie sind sehr lokal begrenzt. Es hängt von der Lage weniger Messstationen ab, ob sie überhaupt erfasst und richtig gemessen werden, weshalb man es inzwischen mit Wetterradar macht.

Zwangsweise führt die Erfassung mit Wetterradar als Folge der höheren Abdeckung zu einer „schlimmen Erhöhung“ der Ereigniszahlen, also einem „unbestechlichen“ Beleg für den bereits wirkenden Klimawandel. Der DWD nutzt das auch entsprechend aus, und darf den Personal und Kontrollaufwand auszubauen.

Bild 24 [15] Lage der Starkniederschläge Ende Juli 2013

„Unnatürlich“ ist unser Wetter nur, wenn man die kältere Vergangenheit weglässt

Wie gezeigt wurde, „erklärt“ das Bayerische Landesamt für Umwelt, die Hochwasser in Oberbayern würden zunehmen, obwohl alte – und vor allem auch historische Daten und Pegelmarkierungen – eindringlich darauf hinweisen, wie oft und schlimmer solche gerade in der kälteren Vergangenheit gewütet haben. Dem Amt reicht jedoch eine Zählung von Ereignissen seit etwa 1950 (ungefähre Verfügbarkeit brauchbarer Messdaten) aus. Ein Zeitraum, der für Niederschlag wenig Relevanz hat, wie man nicht nur anhand der vorherigen und in einem früheren Artikel gezeigten Niederschlagsmessreihen sofort sehen kann [17].

Auch die Aussagen in den Informationsschriften über Zeiten vor 1950 belegen es deutlich:

… Obwohl die Donau zu den hochwasserreichsten Flüssen Europas zählt, ist selten das ganze Einzugsgebiet gleichzeitig von Hochwasser betroffen. Nur das Hochwasser von 1845 und die Tauflut von 1882/83 bewirkten Überschwemmungen auf fast der gesamten Fläche Aus alten Schriften geht hervor, dass auch das Hochwasser vom 28. Dezember 1882 bis 3. Januar 1883 beinahe das ganze Einzugsgebiet der bayerischen Donau umfasste. Es wird von einem Katastrophenhochwasser gesprochen.

… Verantwortlich für dieses extreme Hochwasser vom 31. Juli bis 6. August 1924 waren lang anhaltende starke Regenfälle von rund 40 Stunden, die das südliche und Teile des nördlichen Einzugsgebietes der bayerischen Donau von West nach Ost durchzogen.

Besonders betroffen war der Chiemgau. Hier fielen in 30 Stunden 300 mm Regen.

In allen anderen Fällen traten und treten Hochwasserschwerpunkte auf, zum Beispiel in Donauwörth, Regensburg oder Passau. Die Donau bis oberhalb Passau ist besonders im Winter prädestiniert für Hochwasser. Die größten wurden in den Jahren 1845, 1850, 1862 und 1882 beobachtet. Damals erreichte die Donau noch höhere Wasserstände als im März 1988.

Wie durch geschickte Statistik aus Datenmaterial das „Gewünschte“ „herausgelesen“ wird, hat der Autor ebenfalls bereits einmal aufgezeigt. Auch darin wurde übrigens eine „klimawandel-bedingte Zunahme“ durch eine zu kurze – und fehlende, historische – Betrachtung herausgelesen:

EIKE 22.08.2017: [18] Verschiebt der Klimawandel Europas Hochwässer dramatisch

Dabei gibt es auch sonst genügend Anzeichen für eine andere Aussage:

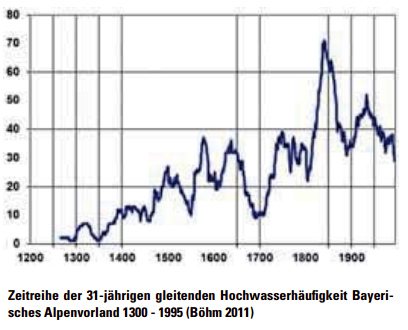

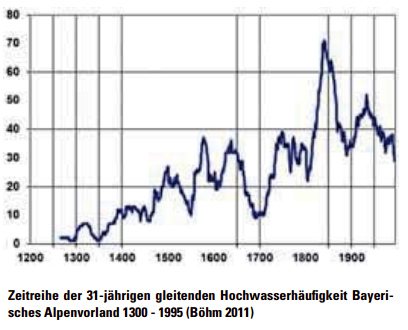

Eine Studie (zitiert aus [9]) wertete die Hochwasser-Häufigkeiten im Alpenvorland aus. Diese kam zu dem Schluss: Ausgerechnet als es kurz vor Beginn der Industrialisierung am kältesten war, waren nach dieser Studie die Hochwasser am häufigsten.

Bild 25 Darstellung der Hochwasserhäufigkeit im bayerischen Alpenvorland [9]

Geradezu ketzerisch ist die weitere Aussage in dieser Studie: [9]

„Die Hochwasserentwicklung zwischen dem 17. Jahrhundert und 1930 korreliert mit der Entwicklung der Sonnenflecken. Und das hoch signifikant“

Wie widersprüchlich dazu die Angaben in den offiziellen Publikationen sind, zeigt auch die die folgende Feststellung:

[19] …

Als Fazit bleibt festzustellen, dass eine regionalspezifische Zunahme der Starkniederschlagshöhen am deutlichsten in den Wintermonaten Oktober – April statistisch nachweisbar ist … während im Sommer weniger extreme Niederschläge auftraten …

Bild 26 [19] Verteilung von Veränderungen an Niederschlagshöhen >20 mm/Tag in Baden-Württemberg/Bayern

Wie man im Bild 26 sieht, fällt ausgerechnet das laut dem BR durch eine Zunahme besonders betroffene Oberbayern mit einer Abnahme im Sommerhalbjahr auf.

Macht aber nichts. Wie es „sein muss“, lässt sich simulieren:

[2] Ausmaß des künftigen Klimawandels

… Eine Verschiebung statistischer Mittelwerte und Verteilungen der Klimakenngrößen bedeutet auch eine Zunahme der Häufigkeit bisheriger Extremwerte. Eine Zunahme von Trockenperioden, aber auch von Starkniederschlägen, wird zwangsläufig eine Veränderung des Abflussgeschehens unserer Gewässer bewirken …

… Die in die Zukunft gerichtete Fragestellung, ob infolge des Klimawandels allgemein und in welchem Ausmaß mit einer Verschärfung des Hochwassergeschehens zu rechnen sein wird, ist mit Simulationsrechnungen untersucht worden. Dazu mussten zunächst die Szenarienergebnisse einer globalen Klimamodellierung über Regionalisierungsverfahren für einen nutzbaren Maßstab berechnet und daraus künftig mögliche Abflussganglinien simuliert und statistisch bewertet werden.

Die Berechnungsergebnisse lassen eine deutliche Zunahme der mittleren Hochwasserabflüsse, aber auch seltenerer Hochwasser, erwarten. Auch wenn die Auswertungen und die Modellannahmen mit Unsicherheiten behaftet sind, bestätigen verschiedene regionale Modellberechnungen diese Aussage. Allein aus Vorsorgegesichtspunkten ist daher von einer Hochwasserverschärfung durch die Klimaveränderung für die Zukunft auszugehen.

Nochmals Daten zur Gegend um den Chiemsee

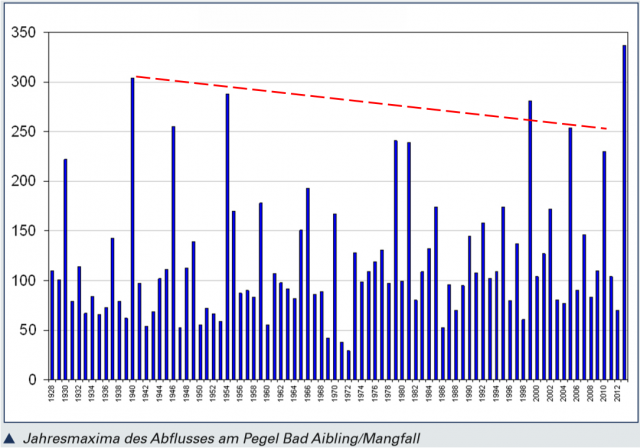

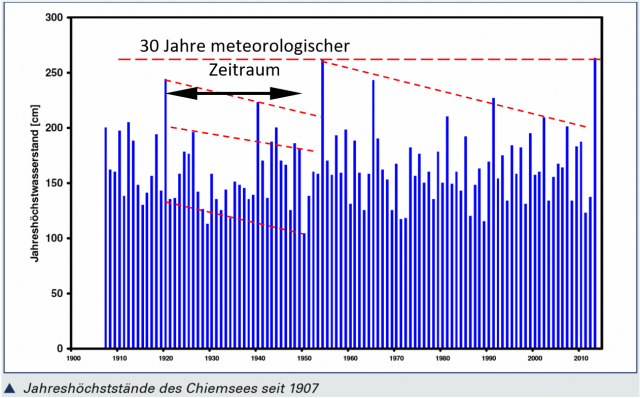

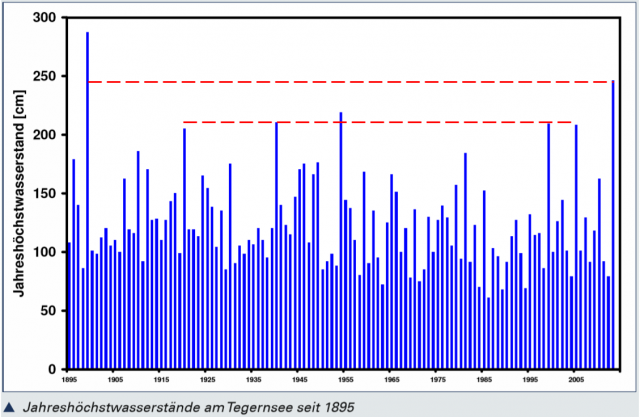

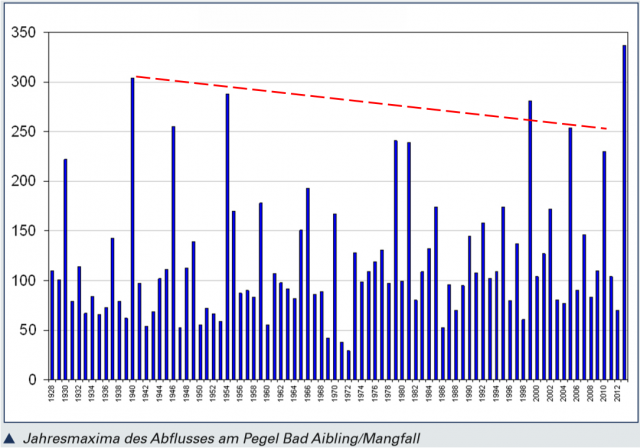

Im folgenden Bild 27 zeigt sich wieder die Variabilität, welche oft auch nach 100 Jahren Trend plötzlich ausreißt, ohne den langzeit-Trend zu stören, beziehungsweise, ob es der Beginn einer Änderung des Langzeittrends ist, weiß man vielleicht in 100 Jahren, niemals aber anhand einer der üblichen, kurzfristigen Analysen.

Bild 27 [15] Mangfall: Höchstes Hochwasser seit 1899. Trendlinien vom Autor zugefügt

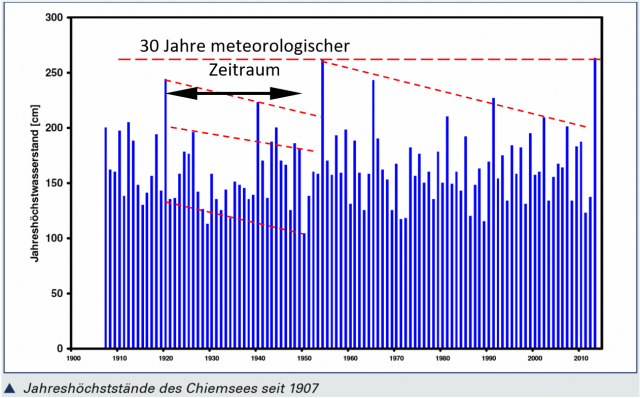

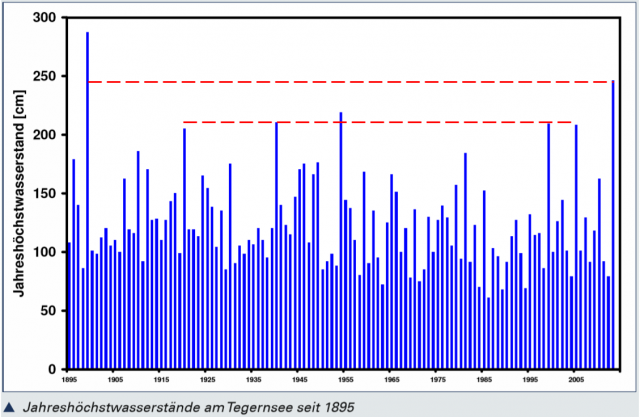

Bild 28 [15] Jahreshöchststände Chiemsee seit 1888. Trendlinien vom Autor zugefügt

Bild 29 [15] Jahreshöchststände Tegernsee seit 1895. Trendlinien vom Autor zugefügt

Bildunterschrift:

Auch am Tegernsee war der Wasserstand der höchste seit 1899. Damals wurde ein Scheitel von 287 cm erreicht.

Ergebnis

Die Niederschlagsverläufe der Messstationen zeigen bei der Langzeitbetrachtung keinen steigenden Trend.

Freud und Leid hängen nicht von der CO2-Vermeidung ab

Simbach ist wohl das bisher extremste Beispiel einer Gemeinde, welche für CO2-Vermeidung zur Rettung der Welt zwar einen Klimaaward erhielt, wichtige Maßnahmen, um ihre Bürger zu schützen jedoch unterließ [20]. Die Strafe war furchtbar.

Nürnberg machte es vor über 100 Jahren nach der Flut von 1909 wie folgt: [2] Bereits 1910 begann man mit der Planung einer Flutüberleitung in der Altstadt. Wegen der Widerstände wurde diese zu den Akten gelegt. Dann zerstörte der 2. Weltkrieg die Altstadt fast vollständig. Nun war es möglich, die Planung doch umzusetzen. 1962 war die Umsetzung fertig. Seitdem gab es in Nürnberg keine Überflutung mehr.

Das bedeutet aber nicht, dass es allgemein akzeptiert würde. Was früher für die Bürge katsstophal war, gilt heute als „beglückend natürlich“ und gut, weil man die grausamen Auswirkungen nicht erlebt hat:

[2] … Heute werden jedoch die Begradigung der Pegnitz, der technische Uferverbau mit Beton und Stahlträgern sowie der Verlust von Flussauen als Mängel empfunden …

Rosenheim in Oberbayern hatte ebenfalls das Glück der Geschichte: Ihr (Teile davon) schützender Damm wurde 2012, gerade ein Jahr vor der sonst unweigerlich folgenden Überflutung der Altstadt fertig:

Manche können sich kaum vorstellen, wie extrem Städte auch in Deutschland direkt in Überflutungsgebieten siedeln. Das ist schon fast so, wie in Japan in Tsunami-gefährdeten Gebieten, oder den Südsee-Atollen, wo die neuen Häuser nicht mehr wie früher auf Stelzen gebaut werden, und sich die Bewohner nun beim Westen über das Wasser im Wohnzimmer beklagen.

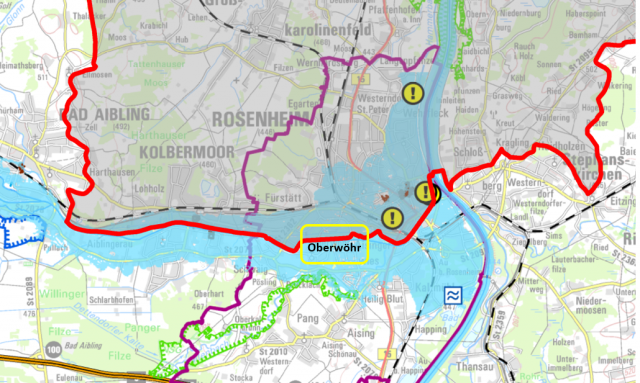

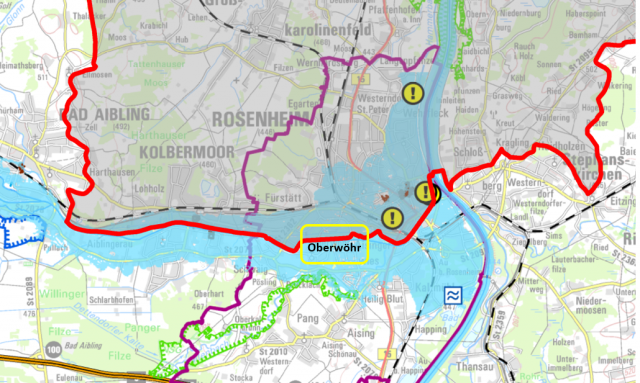

Bild 32 Überflutungsgefährdetes Gebiet von Rosenheim. Das im Bild 33 gezeigte Überschwemmungsgebiet Oberwöhr vom Autor gekennzeichnet. Quelle: LfU Bayern, Hochwasserkarten

Und so sieht es trotz Dämmen aus, wenn das seit Jahrhunderten regelmäßig flutende Wasser wiederkommt:

Noch weiter zurück in die Vergangenheit

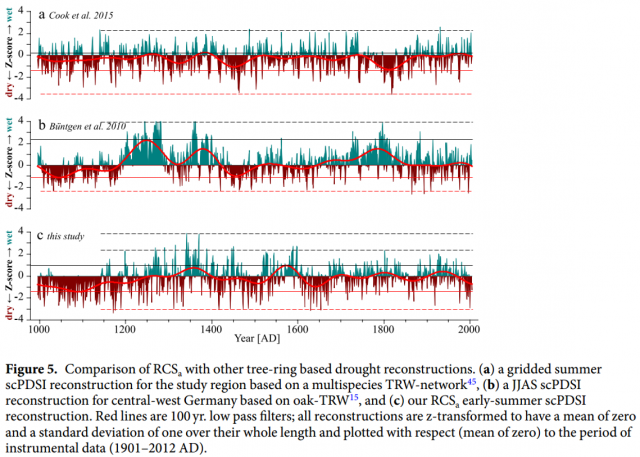

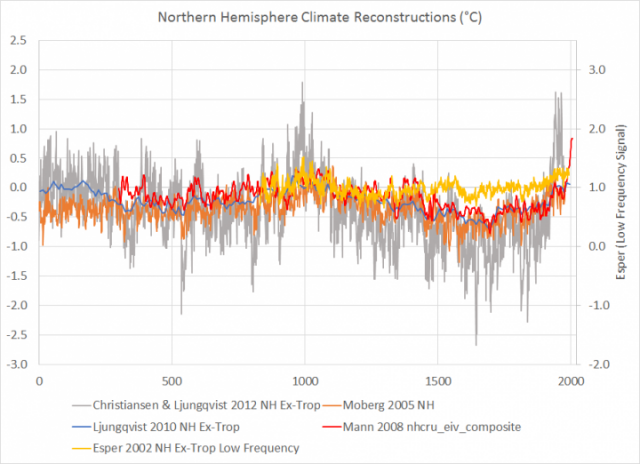

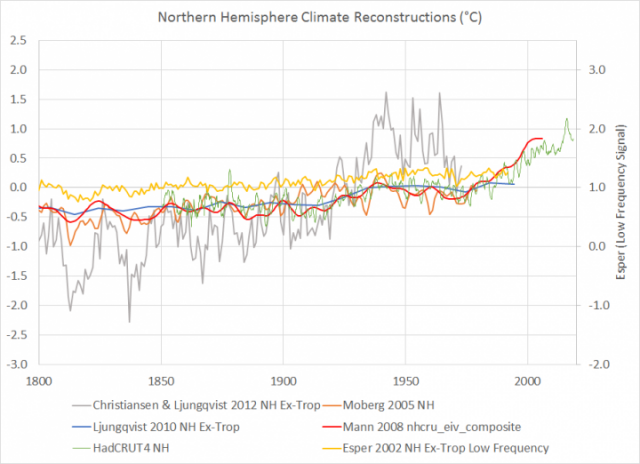

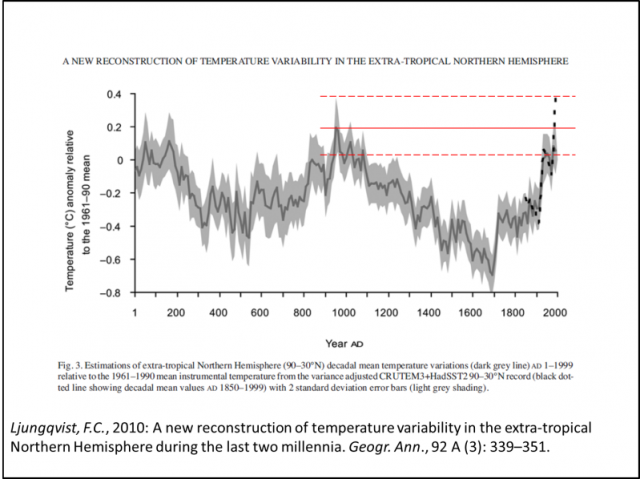

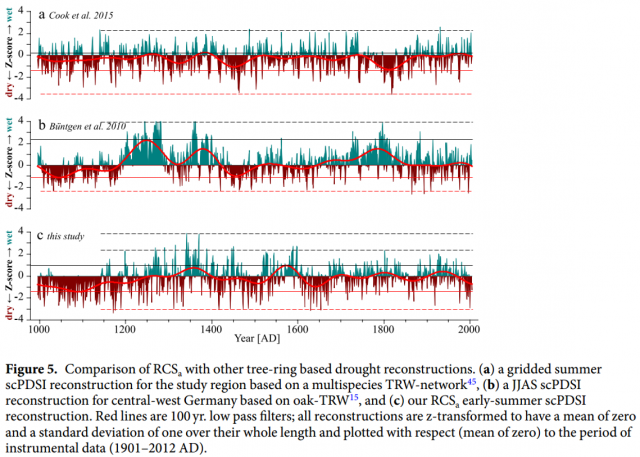

Es gibt Studien, die den Versuch wagen, Niederschläge der Vergangenheit zu ermitteln. Im folgenden Bild hat eine Studie drei Rekonstruktionen zusammengefasst.

Neben dem, dass sich die Rekonstruktionen zeitweise widersprechen – was die Probleme solcher Rekonstruktionsversuche überdeutlich aufzeigt -, zeigen alle trotzdem eines: Das aktuelle Wetter ist nicht entfernt extrem, „noch nie so gewesen“, oder gar schlimmer geworden.

Bild 34 [10] Niederschlagsverläufe Norddeutschland. Grenzlinien vom Autor zugefügt

Parodie am Rande: Hilft eine Zunahme der Überschwemmungen* den Biobauern?

Man könnte es fast meinen, wenn man liest, dass Hochwasser einst erwünscht, weil notwendig waren (der im Video interviewte „Staatsbedienstete“ spricht dieses Thema ebenfalls an):

[2] Bayerisches Landesamt für Umwelt, Schrift: Hochwasser im Spiegel der Zeit

Die Landwirtschaft strebte nur den Schutz vor schadbringenden Hochwassern im Sommer an, die Winterhochwasser dagegen, mit ihrer düngenden Wirkung, waren sogar erwünscht … Nach den Hochwasserereignissen um 1920 war durch die Zunahme des Schadenspotenzials in den Überschwemmungsgebieten ein größeres Schutzbedürfnis entstanden. Nun waren durch die aufkommende Verwendung von Kunstdünger in der Landwirtschaft die Winterhochwasser trotz ihrer düngenden Wirkung ebenfalls unerwünscht.

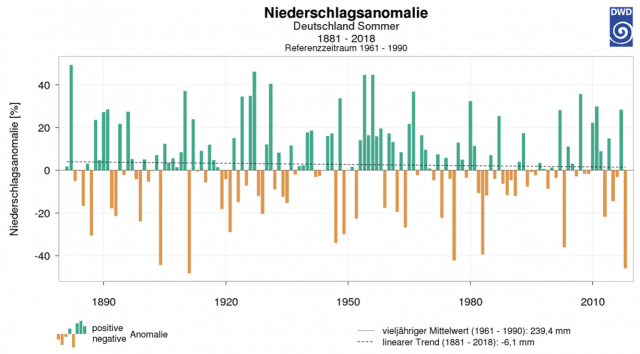

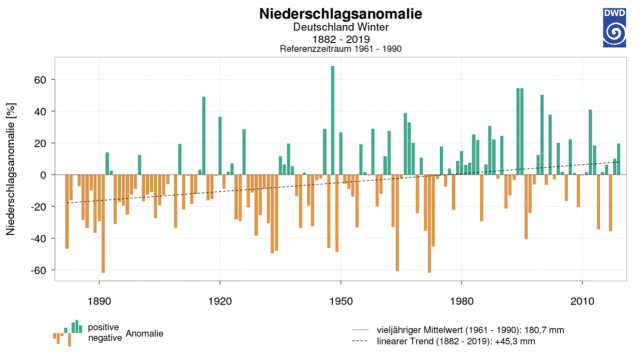

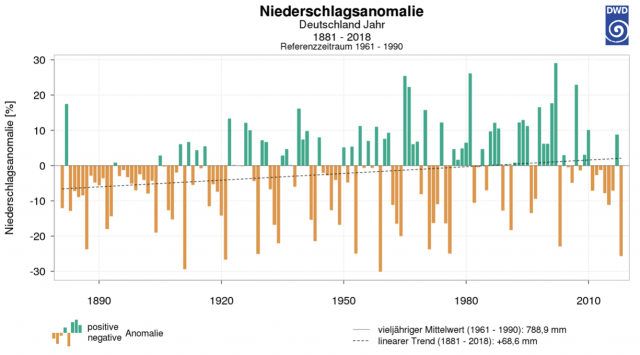

Das Klima hat zwischenzeitlich diesem, sicher über viele Jahrtausende bestehenden Wunsch nachgegeben, und den Niederschlag im Winter etwas erhöht, dafür im Sommer verringert.

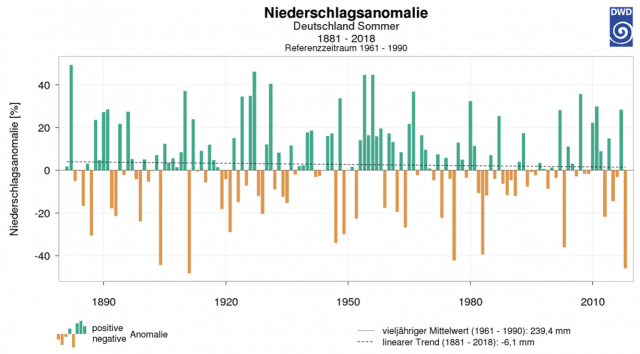

Bild 35 Deutschland, Sommerniederschlag Anomalie. Quelle: DWD Viewer

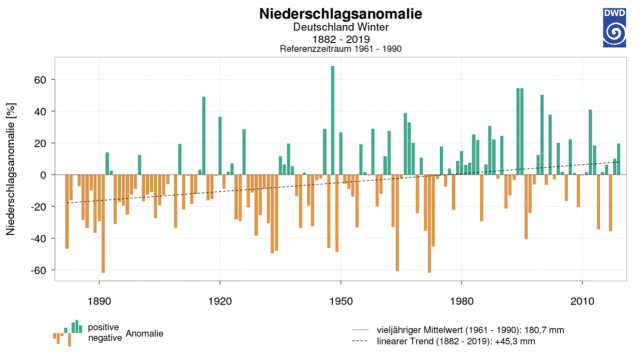

Bild 36 Deutschland, Winterniederschlag Anomalie. Quelle: DWD Viewer

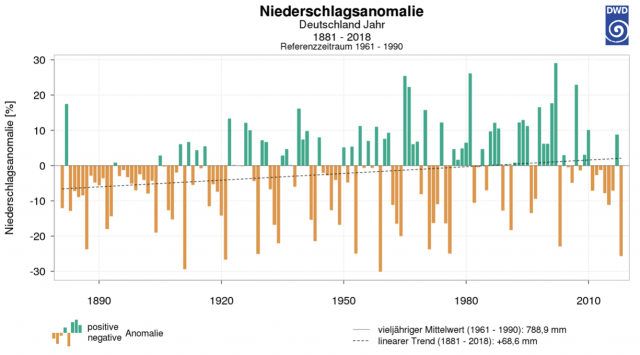

Bild 37 Deutschland, Jahresniederschlag Anomalie. Quelle: DWD Viewer

Dank der zwischenzeitlich entwickelten, modernen Agrartechnik allerdings zu spät, somit zur falschen Zeit. Außer man denkt GRÜN und will sowieso die moderne, erfolgreiche Landwirtschaft abschaffen. Dann muss man wegen dem durch die hohen Verluste des Bioanbaus enormen, zusätzlichem Platzbedarf auch wieder überschwemmungs-gedüngte Flussauen nutzen.

Es kann den inzwischen in Flussauen siedelnden Bewohnern also noch gehen wie den Autofahrern: Sie werden aus ihren Gebieten einfach vertrieben, weil man diese zur geforderten Ausweitung der Bio-Landwirtschaftsfläche benötigt. Da (auch fast entschädigungslose) Enteignung inzwischen wieder hoffähig geworden ist, wird einem solchen, GRÜNEN Wunsch keine der etablierten Parteien etwas dagegen setzen.

Trocknet unsere Heimat jetzt aus?

Diese Frage stellt unsere Agrarministerin, Frau Klöckner (Studium: Politikwissenschaft, katholische Theologie und Pädagogik) laut dem FOCUS: „Agrarministerin Klöckner über die Folgen der Hitze“.

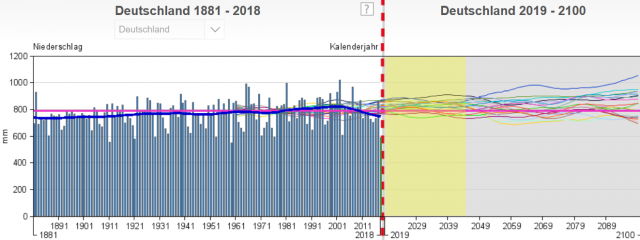

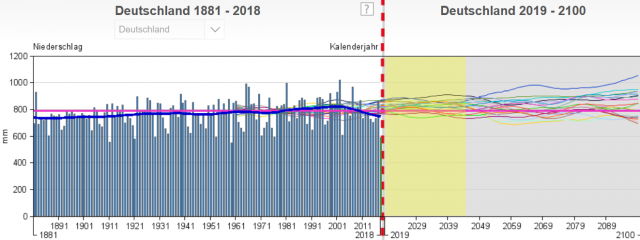

Wer keine Ahnung hat, kann ja mindestens Fragen (in den Raum) stellen. Einfacher wäre es gewesen, die DWD-Daten (Bilder 35 – 38) anzusehen (dauert ca. eine Minute) und die Antwort bis zum Jahr 2100 zu erhalten. Diese ist eindeutig: Nein. Zumindest aufgrund der Daten aktuell und der Vergangenheit, erhärtet anhand der Simulationen (sofern man solchen „Glauben“ schenkt).

Das ist unseren Minister*innen (und hier auch dem FOCUS) aber schon seit Längerem für das kärgliche Gehalt (und Pensions-Anwartschaft) wohl nicht mehr zuzumuten: Und ihrem Agrar-Minsterium fehlen ersatzweise wohl geeignete, externe Berater, die so etwas „Kompliziertes“ schaffen könnten.

Bild 38 Deutschland, Jahresniederschlag absolut mit „Vorschau“ zum Jahr 2100. Quelle: DWD Viewer

oQuellen

[1] BR Reportagevideo: Chiemgau im Wandel – Hochwasser und Zombiebäume

[2] Bayerisches Landesamt für Umwelt, Schrift: Hochwasser im Spiegel der Zeit

[3] EIKE 24. April 2019: Kiribati versinkt wieder, das ist professionell recherchiert

[4] EIKE 7. März 2018: Flashcrash Klimaalarm. Wer Klimaalarm posaunt, bekommt immer recht (Teil 2 und Abschluss)

[5] EIKE 12.06.2017: Fake News: Zuerst der SWR, nun der BR: Ein Südseeparadies versinkt im Meer. Öffentlich-Rechtliche Klimawandel-Agitation in Endlosschleife

[6] EIKE 10.05.2017: Die Volkshochschule Hannover und ihre Ausstellung: Wir alle sind Zeugen – Menschen im Klimawandel

[7] EIKE 04.06.2018: Nun überschwemmt der Klimawandel bereits unsere Städte. Alternativ: Hat Deutschland kein Geld mehr, um sich gegen normale (Un-)Wetter zu schützen?

[8] EIKE 18.04.2018: Beeinflussungen durch Starkregen nehmen in Deutschland nicht zu. Mit schlecht angewandter Statistik lässt sich aber das Gegenteil „zeigen“ (Teil 2)

[9] Uni Augsburg, Dr. O. Böhm, Publizierung: Das Hochwasser und die Sonnenflecken

Studie: Changes of regional climate variability in central Europe during the past 250 years

http://link.springer.com/article/10.1140%2Fepjp%2Fi2012-12054-6

[10] tobias scharnweber at al.: Removing the no-analogue bias in modern accelerated tree growth leads to stronger medieval drought

[11] Hochwassernachrichtendienst Bayern, Pegel Staudach

[12] EIKE 21.11.2015: Die bayerische Umweltministerin Frau Scharf: Extremwetter, Extrem-Hochwasser und die Unberechenbarkeit des Wetters nehmen zu. Doch stimmt das wirklich?

[13] Bayerisches Landesamt für Umwelt: Monitoringbericht 2016 Niederschlag Zusätzliche Auswertungen für die KLIWA-Untersuchungsgebiete

[14] EIKE 18.04.2018: Beeinflussungen durch Starkregen nehmen in Deutschland nicht zu. Mit schlecht angewandter Statistik lässt sich aber das Gegenteil „zeigen“ (Teil 1)

[15] Wasserwirtschafsamt Rosenheim (Homepage), Schrift: Das Hochwasser vom Juni 2013 Dokumentation

[16] EIKE 19. Juni 2019: Tuvalu versinkt mal wieder – nicht. UNO Generalsekretär posiert für das Time Magazin

[17] EIKE 03.06.2018: Früher war es schlimmes Wetter, heute macht das Gleiche mit Sicherheit der Klimawandel

[18] EIKE 22.08.2017: Verschiebt der Klimawandel Europas Hochwässer dramatisch

[19] LUBW KLIWA-Projekt A 1.1.3: Langzeitverhalten der Starkniederschläge in Baden-Württemberg und Bayern

Tagesschau 22.06.2019: Deutsche Klimaziele Söder will Kohleausstieg schon 2030

[20] EIKE 24.01.2017: Jahrtausendhochwasser am 01.06.2016 in Simbach – so entstehen Menetekel des Klimawandels

[21] EIKE: Klimagaga: Heißzeitkatastrophe im Berliner Grundwasser

[22] Die Welt 11.05.2019: „Einzigartig kompetent“ Seehofer lobt Merkel: „Sie ist in dieser Regierung die Beste“

[23] MSN 27.06.2019: Hitzewelle 2019: Mehrere Tote, neue Temperatur-Rekorde und die Aussichten

[24] YouTube Video: Wetterexperte Stefan Rahmstorf: „Wir verlieren die Kontrolle über das Klimasystem“

[25] YouTube Video, Volker Quaschning: Ist Kohlendioxid wirklich ein Klimakiller?