Großspeicher sind jedoch nur ein unbedeutender Teil der Elektroenergieindustrie und sind dazu verurteilt, dies auch in den kommenden Jahrzehnten zu tun.

[Auf Eike fanden Sie dazu u.a. den übersetzten Artikel „Energiespeicher sind noch nicht verfügbar, für einen Einsatz im Stromsystem“ wobei das „noch“unter Mythos abzulegen ist, der Übersetzer]

Im vergangenen Monat hat Senatorin Susan Collins aus Maine eine Gesetzesvorlage mit dem Titel „The Better Energy Storage Technology Act“ (Gesetz über bessere Energiespeicherungstechnologie) vorgelegt, in der 300 Millionen US-Dollar für die Entwicklung von Batterielösungen für elektrischen Strom vorgesehen sind. Collins erklärte im Washington Exeminer: „Energiespeicher der nächsten Generation werden dazu beitragen, die Effizienz und Zuverlässigkeit unseres Stromnetzes zu verbessern, die Energiekosten zu senken und die Übernahme erneuerbarer Ressourcen zu fördern.“

[Washington Exeminer

… Collins und die anderen Republikaner, die die Gesetzesvorlage unterstützen, Sens. Cory Gardner aus Colorado und Martha McSally aus Arizona, stehen 2020 vor harten Wiederwahlkämpfen in lila Staaten, wobei Umweltprobleme, als Thema mit dem „Green New Deal“ durch die Demokraten ins Spiel gebracht, eine herausragende Rolle spielen dürften.]

Arizona, Kalifornien, Hawaii, Massachusetts, New Jersey, New York und Oregon verabschiedeten Statuten oder Ziele zur Entwicklung von Speichersystemen für die Netzstromversorgung, wobei sich New York zum ehrgeizigsten Ziel des Landes bekennt. Im Januar kündigte der Gouverneur von New York, Andrew Cuomo, im Rahmen seines Mandats „100 Prozent sauberen Strom bis 2040“ an, bis 2030 Speicher mit einer Leistung von 3.000 Megawatt (MW) bereitzustellen.

Heute haben 29 Staaten Gesetze für die Mengen an zu nutzender „Erneuerbarer Energien“, was bedeutet, weiter steigende Mengen an erneuerbaren Energien zu erwerben. Die Stromerzeugung aus Wind- und Solarsystemen ist jedoch intermittierend [und selten gerade dann erhältlich, wenn gebraucht]. Im Durchschnitt liegt die Windleistung zwischen 25% und 35% der Nennleistung der Windstromanlagen. Die Solarleistung ist sogar noch geringer und macht durchschnittlich etwa 15% bis 20% der Nennleistung aus.

Zum Vergleich bedeutet der erzwungene Einkauf von Strom aus Wind und Sonne, dass eine Familie gezwungen wird, ein zweites Auto zu kaufen, welches aber im Durchschnitt nur in 30% der Zeit fahren kann [und dass noch unplanbar]. Die Familie kann das ursprüngliche Auto nicht durch das neue intermittierende Auto ersetzen, sondern muss dann zwei Autos betreiben.

Befürworter erneuerbarer Energien schlagen jetzt die Speicherung von Elektrizität vor, um das Problem der Zufälligkeit zu lösen und die traditionellen Kohle-, Erdgas- und Kernkraftwerke durch erneuerbare Energien zu ersetzen. Bei hoher Wind- und Solarleistung wird überschüssiger Strom in Batterien gespeichert um in schwachwind und sonnenarmen Zeiten traditionelle Kraftwerke zu ersetzen, welche standardmäßig rund um die Uhr Strom erzeugen können.

In den Schlagzeilen einschlägiger Medien wird das Wachstum von Batterieanlagen für die Netzspeicherung hervorgehoben, die im vergangenen Jahr um 80% und gegenüber 2014 um 400% gestiegen sind. Die Menge an US-amerikanischem Strom, der heutzutage gespeichert wird, ist jedoch zum Ganzen verglichen gering.

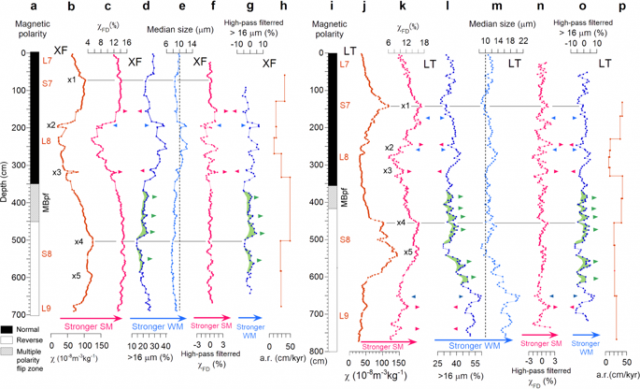

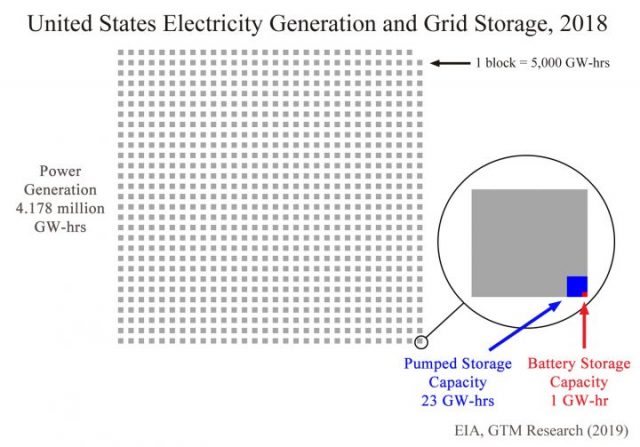

US Energy Information Administration, Vergleich Kapazität Pumpspeicher zu Batteriespeicher

Pumpspeicher, nicht Batterien, speichern in den USA etwa 97% des gespeicherten Stromes. Pumpspeicher verwenden überschüssigen Strom, um Wasser in ein höher gelegenes Reservoir zu pumpen, und wenn es abgelassen wird, treibt es eine Turbine mit Generator an, um wieder Strom zu erzeugen, wenn dieser [kurzfristig] benötigt wird. Aber weniger als ein Watt in 100.000 Watt US-Strom stammt aus Pumpspeichern.

Im Jahr 2018 erzeugten US-Kraftwerke 4,2 Millionen GWh an elektrischen Strom. Die Kapazität der Pumpspeicher belief sich auf 23 GWh. Die Batteriespeicher bieten nur etwa 1 GWh Kapazität. Damit ist ersichtlich, dass nur weniger als ein Millionstel des verbrauchten Stroms in Batterien gespeichert werden kann.

Stromspeicher sind teuer. Pumpspeicher sind mit etwa 2.000 USD pro Kilowatt die kostengünstigste Form des Netzspeichers, erfordern jedoch Landschaften, in denen ein tiefgelegener See mit genügend Wasser-Kapazität und ein dazugehöriges, hochgelegenes Gegenstück gebaut werden kann, bzw. zur Verfügung steht. Dagegen kosten Batteriespeicher etwa 2.500 USD pro Kilowatt für eine Entladungsdauer von zwei Stunden oder mehr. Batterien sind teurer als Windenergie an Land, deren Marktpreis unter 1.000 USD pro Kilowatt liegt. Ein Schlüsselfaktor für die Nützlichkeit des Speichers ist jedoch die Zeitspanne, in der das System den gespeicherten Strom liefern kann.

Im Fall des Staates New York, sind geplant:

In Part 4. Launching the Green New Deal, ab Seite 312

Die Installation von 9.000 MW Offshore – Windkapazität bis 2.035 und 3.000 MW Batteriespeicherung bis 2030 [Es ist unklar, ob damit 3.000 MWh gemeint sind oder „MW = Anschlussleistung“]. Das Windsystem kostet wahrscheinlich über 9 Milliarden USD und das Batteriesystem wird wahrscheinlich etwa 7,5 Milliarden USD kosten. Diese geplante Batteriekapazität ist jedoch völlig unzureichend, um die Unterbrechungen des Windstroms auszugleichen.

Wenn das Windsystem eine durchschnittliche Abgabeleistung von 33% seiner Nennleistung hat, können die geplanten 3.000 MW-Batteriespeicher nur etwa zwei Stunden lang die durchschnittliche Windleistung liefern

[Annahme: dann hätten die geplanten Batteriespeicher eine Kapazität von 6.000 MWh –das muss aber in Überschusszeiten erstmal wieder geladen werden können.

Die „größte Batterie der Welt“ von Elon Musk in Südaustralien kann gerade mal 30MW anbieten (s. Nachsatz unten) und hat eine Kapazität von etwa 100 MWh, der Übersetzer]

Um die Leistung für einen ganzen Tag zu ersetzen, an dem der Wind nicht weht, wären 36.000 MW Speicher erforderlich, und zwar zu einem Preis von 90 Milliarden US-Dollar, was etwa dem Zehnfachen des Windsystems selbst entspricht. Da an den meisten Standorten mehrere Tage Windstille üblich sind, reicht selbst ein Tag Batteriesicherung nicht aus.

Darüber hinaus ist die Lebensdauer von Batterien im Netzabsicherungs-Maßstab von 10-15 Jahren nicht lang zu nennen. Wind- und Solaranlagen sind für eine Lebensdauer von 20-25 Jahren ausgelegt. Traditionelle Kohle-, Erdgas- und Nuklearsysteme haben eine Lebensdauer von 35 Jahren und mehr.

Die Speicherung von Elektrizität war bislang von jedem verarbeitenden Gewerbe als unklug angesehen. Jahrzehntelang setzten große Unternehmen auf Just-in-Time-Produktion, „Losgröße eins“, Kanban, Lean Manufacturing und andere Mitarbeiterprogramme, die darauf abzielen, den Bestand an Fertigwaren zu reduzieren, um die Kosten zu senken.

Strom muss bei Bedarf sofort erzeugt und geliefert werden, das ultimative Null-Fertigwaren-Inventar-Produkt. Aber viele Organisationen fordern jetzt Stromspeicher, um die Unterbrechungsschwäche der erneuerbaren Energien zu beheben.

Heute beträgt die Speicherkapazität der Batterien am Netz weniger als ein Millionstel der nationalen Stromproduktion. Batteriespeicherung erhöht die Kosten des Partnersystems für erneuerbare Energien um einen Faktor von mindestens zehn. Es wird Jahrzehnte dauern, bis die Batteriespeicherung in großen Stromversorgungssystemen eine bedeutende Rolle spielt, wenn überhaupt [genügend Rohstoffe und Geld zur Herstellung vorhanden sind].

Veröffentlicht auf Wattsupwiththat vom 29.06.2019

Übersetzt durch Andreas Demmig

https://wattsupwiththat.com/2019/06/29/battery-storage-an-infinitesimally-small-part-of-electrical-power/

Ursprünglich in Energy Central veröffentlicht . Auf Wunsch des Autors hier neu veröffentlich

Nachschub vom Übersetzer:

Dieser Artikel ist offenbar durch die Pläne der Politiker in USA beeinflusst, und kann unseren Lesern einen anderen Blickwinkel auf die Problematik der volatilen Erneuerbaren und die Stromspeicher geben. Gleichwohl, sind die Eigenschaften der angesprochenen Stromgeneratoren und Stromspeicher unklar beschrieben. Kommt sicherlich auch durch die Agenda 2019 von Gouverneur Andrew M. Cuomo., Part 4. Launching the Green New Deal, ab Seite 312

***

Eigenschaften

Ein Kraftwerk wird mit MW spezifiziert, thermische Kraftwerke (Kohle, Gas Nuklear) können z.B. eine Leistung von 1.300 MW haben, Windkraft inzwischen meist um 3.000 kWatt (= 3 MW), die Haliade-X 12 des US-amerikanischen Herstellers General Electric soll 12MW haben.

Diese Leistung kann das Kraftwerk maximal zur Verfügung stellen, anders ausgedrückt, Verbraucher mit diesem Bedarf können daran angeschlossen werden. Das ist aber erstmal nichts anderes, als z.B. von einem PKW Motor zu sagen: der hat 100PS (74 KW) – solange der Motor steht, wird auch keine Energie erzeugt (aus dem Brennstoff in Bewegung / Strom umgewandelt). Wie lange und ob überhaupt (Windstärke -> Windstrom) Strom geliefert werden kann, ist eine ganz andere Frage.

Was gebraucht wird, ist die tatsächlich gelieferte Energie, in der Elektrotechnik im Privathaushalt mit kWh abgerechnet, größere Verbrauchsmengen werden in MWH oder GWh gemessen.

Ein konventionelles Kraftwerk kann beispielsweise aufs Jahr gesehen, den Strom an durchschnittlich mehr als 90% aller Stunden mit seiner Nennleistung liefern. (Stillstands Zeiten für Störung und Wartung eingerechnet), also 8760 h x 0,9 x 1.300 MW = 10.249.200 MWh = ~ 10.249 GWh – und dieses kontinuierlich, planbar

Windkraftanlagen, 3 MW Nennleistung, liefern aufs Jahr durchschnittlich z.B. 40% ihrer Kapazität, 8760h x 0,4 x 3 MW = 10.512 MWh, das ist im Durchschnitt aufs Jahr. Das kann – wie der Wind weht – auch mal mehr oder weniger sein, aber nicht planbar wie lange und wann,

Batterien werden mit drei Kennwerten beschrieben, mit der Anschluss Spannung (in Volt), der Kapazität (in Ah) und dem maximalen Entladestrom (in Ampere) (zum Laden auch den maximalen Ladestrom).

Weil das viele unserer Leser sicherlich schon mal gesehen haben, zur Erläuterung als Beispiel eine typische, gute Autobatterie: 12 V, 44 Ah, 440 A

Die Anschlussspannung ist 12 Volt,

ein Strom von 44 Ampere kann eine Stunde lang geliefert werden , dann ist sie leer (das sind 12 V x 44A x 1h = 0,528 KWh

( – wobei die Zellenspannung nicht auf 12 V bis zur vollständigen Entladung bleibt, damit sinkt der Strom, d.h. real weniger nutzbare Kapazität, In der Praxis der Autobatterien wird ein Entladestrom über 5 Stunden gemessen und dann auf Stundenwert umgerechnet)

Der maximale Strom, der zum Starten für 30sec gezogen werden kann, sind 440A, realerweise dann nicht mit 12V. Nehmen wir mal 10V an: 10 V x 440 A= 4.400 Wh = 4,4 kW Startleistung, mit obigen Kapazitätswerten, hält die Batterie das dann theoretisch rd. 9 min durch, bis sie leer ist.

Daher ist die im Artikel angegebene Leistung von 3.000 MW für das große Netzspeicher-Batteriesystem wahrscheinlich die von Politikern phantasierte Kurzzeitleistung – noch ist so ein Batteriespeicher nicht gebaut worden.