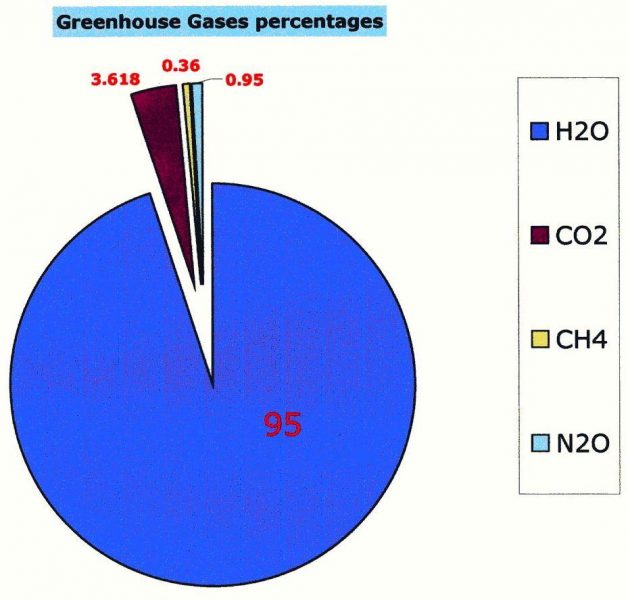

● Der natürliche Anteil von CO2 in der Atmosphäre liegt bei 0,04%, das ist alles andere als das wichtigste Treibhausgas, geschweige denn das einzige, anders als es der größte Teil der Öffentlichkeit sieht.

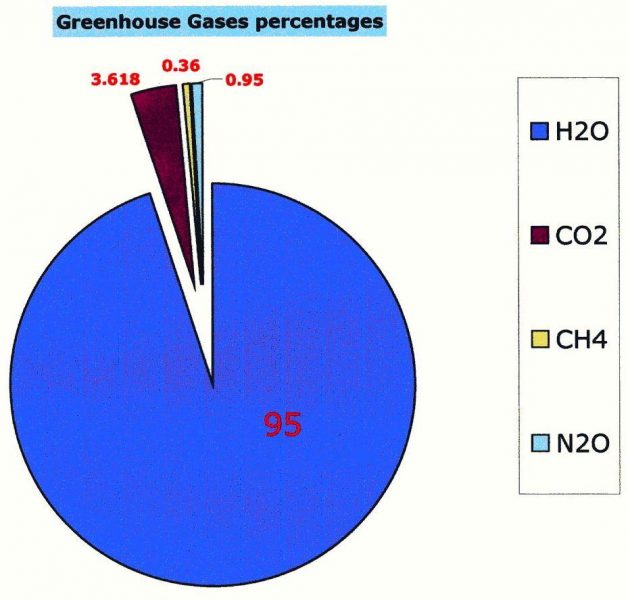

● Wasserdampf, dem Volumen nach mit einem Anteil von 95% an Treibhausgasen, ist bei weitem das häufigste und bedeutendste Treibhausgas.

● Das andere relevante Treibhausgas ist Methan (CH4), aber es macht nur zu 0,000175% aller atmosphärischen Gase aus und 0,036% aller Treibhausgase.

● Um die Bedeutung von CO2 aufzublähen, erzeugte man eine Maßzahl, genannt „Klimasensitivität“. Damit ist gemeint, dass CO2 als Treibhausgas „effektiver“ ist als Wasserdampf.

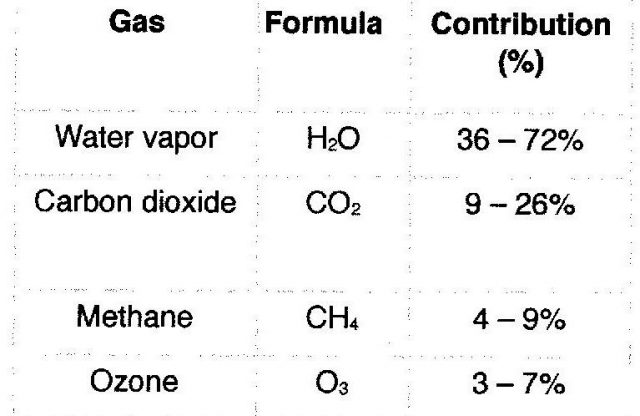

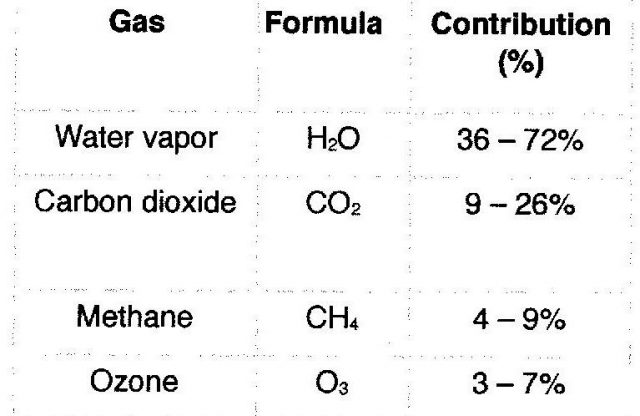

● Hier folgt eine Tabelle von Wikipedia, welche Schätzungen der Effektivität der verschiedenen Treibhausgase zeigt. Man beachte die Bandbreite der Schätzungen, welche die Maßzahlen effektiv bedeutungslos macht – es sei denn, man hat eine politische Agenda. Wikipedia räumt ein: „Es ist nicht möglich festzustellen, dass ein bestimmtes Gas einen bestimmten Prozentanteil des Treibhausgas-Effektes auslöst“:

● Das Ergebnis der Bestimmung der „Effektivität“ war die Erzeugung einer Karte des Global Warming Potential (GWP). Sie war ähnlich der Karte der Ozone Depleting Substances (ODS) [Ozon zerstörende Substanzen], welche nach der falschen Behauptung konstruiert worden war, dass CFCs das Ozon in der oberen Atmosphäre angreifen.

● Schätzungen der Größe der der Atmosphäre hinzugefügten menschlichen CO2-Erzeugung werden vom IPCC erzeugt. Es behauptet, dass es 3% der Gesamtmenge des hinzugefügten CO2 ausmacht.

● In den frühen IPCC-Berichten wurde kolportiert, dass die Verweildauer von CO2 in der Atmosphäre mindestens 100 Jahre beträgt. Obwohl die 100 Jahre nicht erwähnt werden, ist diese Angabe nach wie vor auf vielen Websites der Regierung implizit präsent. Zum Beispiel heißt es bei Environment Canada: „Da Kohlendioxid lange Zeit in der Atmosphäre verbleibt, wird sich dessen Niveau durch fortgesetzte menschliche Emissionen immer weiter erhöhen“. Die tatsächliche Verweildauer von CO2 beträgt aber nur 5 bis 7 Jahre. Danach wird es von natürlichen Senken absorbiert wie Pflanzen, Ozeane und Erdboden.

● Der Ozean ist der Haupt-Kontrolleur des atmosphärischen CO2, aber dessen Fähigkeit variiert mit der Wassertemperatur. Ein kalter Ozean absorbiert mehr als ein warmer Ozean.

● Menschen erzeugen CO2, aber sie entfernen es auch aus der Atmosphäre. Land- und Forstwirtschaft sind die Haupt-Absorber, welche geschätzt 50% der Gesamtproduktion aus der Atmosphäre entfernen.

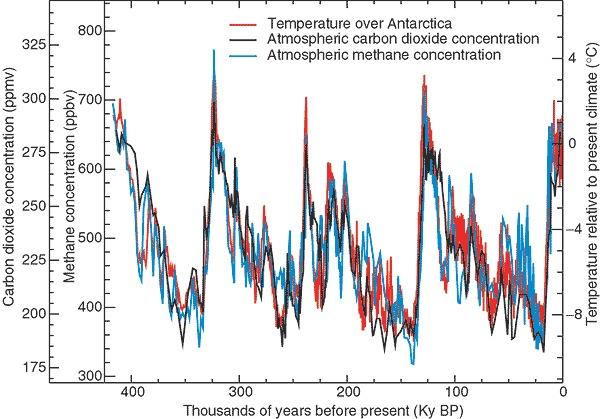

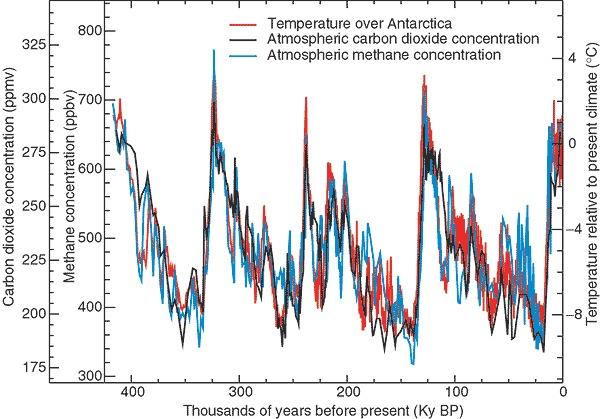

● Antarktische Eisbohrkerne zeigen, dass die Temperatur vor einer Zunahme des CO2-Gehaltes gestiegen war. Eine ähnliche Relation findet sich in jeder Aufzeichnung welcher Dauer auch immer und für alle Zeiträume. Trotzdem sind alle Computer-Modelle so programmiert, dass eine CO2-Zunahme auch eine Temperaturzunahme verursacht.

● Kohlendioxid ist für das gesamte Leben auf der Erde unabdingbar. Forschungen belegen, dass der gegenwärtige Anteil von etwa 392 ppm etwa ein Drittel des Optimums für die meisten Pflanzen ausmacht. Empirische Beweise, ermittelt durch Einleitung von CO2 in kommerzielle Gewächshäuser, zeigen das optimale Niveau zwischen 1000 und 1200 ppm. Interessanterweise entspricht dies dem mittleren Niveau der letzten 300 Millionen Jahre.

Die zweite große Datenmanipulation involvierte CO2, die Zielscheibe des gesamten UNEP und des IPCC. Wie kann man „industrialisierte Nationen loswerden“, wie es Maurice Strong fordert. Die Quelle für deren Energie und Erfolg sind fossile Treibstoffe. Man vergleiche die Nation mit einem Auto. Das ist eine gute Analogie, weil viele das Auto dämonisieren als das Symbol der Industrialisierung, besonders in den USA. Man kann das Auto anhalten, indem man die Benzinzufuhr kappt. Das Gleiche kann man mit einer Nation machen, aber es würde augenblicklich eine negative Reaktion nach sich ziehen. Man denke einfach nur an die Reaktion, wenn die Treibstoffpreise explodieren. Man kann das Auto auch anhalten mittels Blockierung der Abgase, und das hat Potential für die Anwendung auf eine Nation. Man zeige, dass das Nebenprodukt des Autos – oder der Nation – das Klima zerstört, und man hat ein mächtiges Zugpferd, um eine Agenda voranzutreiben, das Auto oder die Industrie zu verbannen. Das ist effektiver, wenn man dem Nebenprodukt das Stigma eines Verschmutzers aufdrückt.

Die Isolation begann, als das IPCC den Klimawandel als ausschließlich auf menschliche Ursachen beruhend apostrophierte. Die Definition für Klimawandel stammt aus dem United Nations Environment Programme (Artikel 1) des United Nations Framework Convention on Climate Change (UNFCCC):

„…eine Änderung des Klimas, welche direkt oder indirekt menschlichen Aktivitäten zugeordnet werden kann, wodurch die Zusammensetzung der globalen Atmosphäre verändert wird und welche zusätzlich zur natürlichen Klimavariabilität auftritt, die über längere Zeiträume beobachtet wird“.

In einer weiteren seiner betrügerischen Machenschaften verwarf das IPCC die ursprüngliche Definition von Klimawandel, wie sie von der UNFCCC festgelegt worden war und die in die ersten drei IPCC-Berichte Eingang gefunden hatte, bevor sie im Bericht 2007 ersetzt worden ist. Beschrieben wird dies in einer Fußnote in der Summary for Policymakers: „Klimawandel im Sinne des IPCC meint jedwede Änderung des Klimas mit der Zeit, sei diese nun der natürlichen Variabilität oder menschlichen Aktivitäten geschuldet. Diese Definition unterscheidet sich von derjenigen im UNFCCC, wo Klimawandel sich ausschließlich auf eine Änderung bezieht, die direkt oder indirekt menschlichen Aktivitäten zugeordnet werden kann, wodurch die Zusammensetzung der globalen Atmosphäre verändert wird und welche zusätzlich zur natürlichen Klimavariabilität auftritt, die über längere Zeiträume beobachtet wird“. Das Problem dabei: Man hat den Vierten Zustandsbericht nicht verändert, weil die Berichte kumulativ sind und es daher keine Grundlage für die Einbeziehung der natürlichen Variabilität existiert.

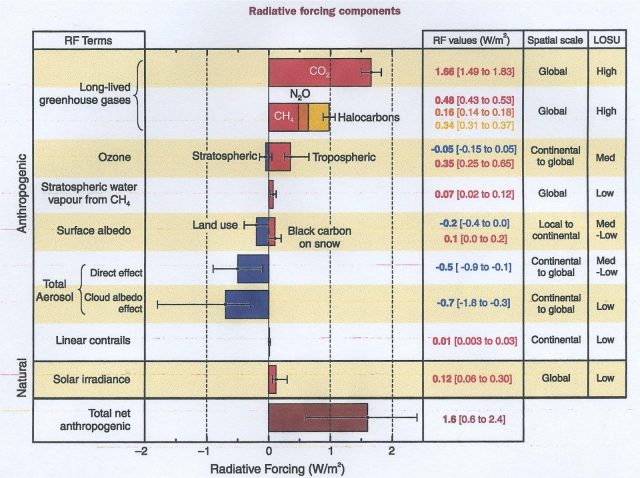

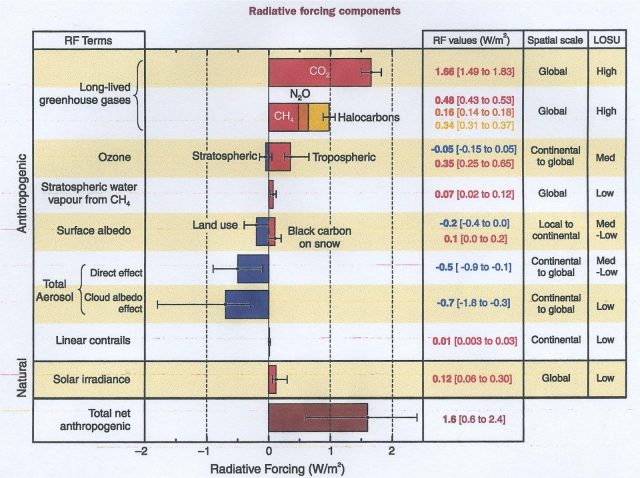

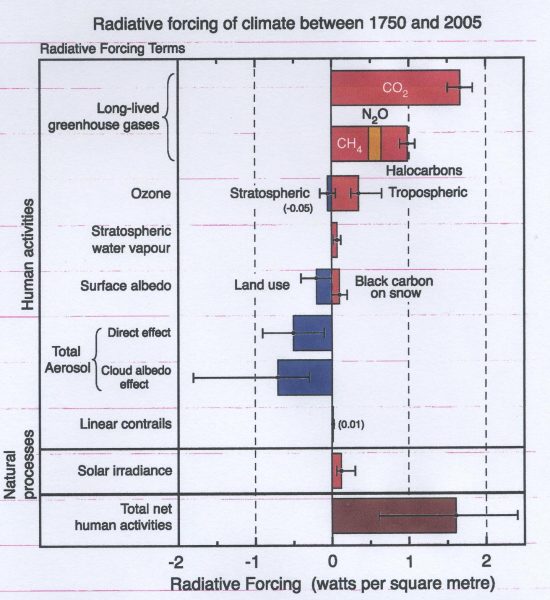

Tabellen mit den vom IPCC herangezogenen Faktoren belegen, dass sich nichts geändert hat. Hier folgt die Tabelle aus dem IPCC-Bericht 2001:

Was darin auffällt:

1. Wasserdampf, das bedeutendste Treibhausgas, ist gar nicht erst aufgeführt.

2. Nur die Sonneneinstrahlung ist gelistet – dabei ist das nicht der einzige Faktor, mit welchem die Sonne das Klima beeinflusst. Falls man ausschließlich menschliche Gründe listet, wie beeinflussen wir dann die Sonneneinstrahlung?

3. Die Spalte rechts zeigt das Level of Scientific Understanding (LOSU).

4. Behauptungen eines „großen“ Verständnisses sind wissenschaftlich nicht gerechtfertigt.

5. Neun Faktoren sind gelistet – davon sind nur zwei hoch, aber vier niedrig und 2 Med-niedrig.

6. Die vom Menschen verursachte Gesamtänderung wird gemittelt mit 1,6 W/m² angegeben (Bandbreite 0,6 bis 2,4)

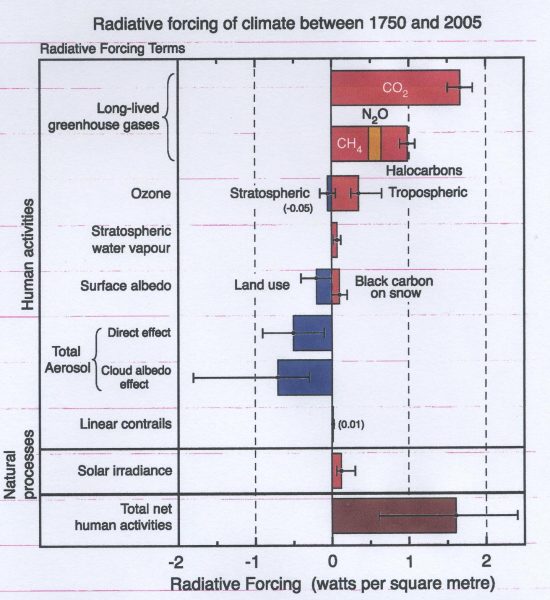

Im Report 2007 wurde keine neuen Variablen hinzugefügt – trotz der neuen angeblichen Definition. Wie es mit Allem, was das IPCC macht, so geht: das, was fehlt oder verändert wurde, erzählt die Story:

1. Die LOSU-Spalte ist verschwunden.

2. Die Spalte mit der Bandbreite der Schätzungen des Strahlungsantriebs (RF) ist verschwunden.

3. Wasserdampf fehlt immer noch

4. Zahlen für die Bandbreite des menschlichen Antriebs fehlen, aber dem Augenschein nach blieben sie unverändert.

5. Der menschliche Gesamt-Effekt scheint weiterhin bei 1,6 W/m² zu liegen.

6. Dies zeigt, dass die behauptete Zunahme von menschlichem CO2 nicht enthalten ist.

Es verbleibt das Problem: Da man nicht weiß, wie viel CO2 es gibt oder wie stark es sich auf natürliche Weise verändert, kann man nicht bestimmen, welcher Anteil menschlichen Aktivitäten geschuldet ist. Jede einzelne Angabe ist im besten Falle eine grobe Schätzung.

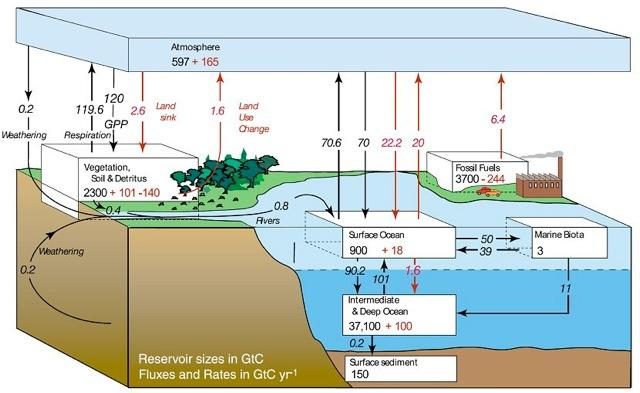

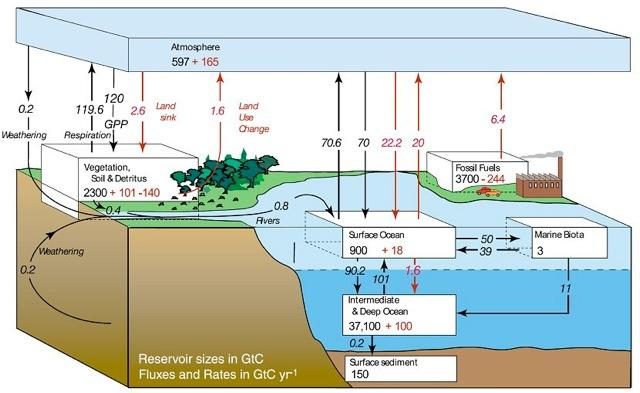

Mittels des Designs unterstreichen alle vom IPCC genannten Zahlen bzgl. CO2 den menschlichen Einfluss. Das sind bedeutungslose Zahlen des gesamten Volumens der jährlichen Flüsse und des menschlichen Eintrags, wie es im Diagramm des Kohlenstoff-Zyklus‘ des IPCC eingezeichnet ist. Im Jahre 2010 erstellte Dr. Dietrich Koelle eine Tabelle der geschätzten Emissionen und CO2-Aufnahmen aus natürlichen Quellen und menschlichen Emissionen:

Emissionen:

Menschen und Tiere 45 bis 52

Ausgasen aus Ozeanen (tropische Gebiete) 90 bis 100

Vulkanische und andere Geo-Quellen 0,5 bis 2

Boden-Bakterien, Verrottung und Verfall 50 bis 60*

Waldrodungen und -brände 1 bis 3

Anthropogene Emissionen (2010) 9,5

Gesamt: 196 bis 226,5

*Andere veröffentlichte Werte: 26 Gt bzw. 86 bis 110 Gt

Aufnahme

Vegetation auf dem Festland 55 bis 62

Ozeane 87 bis 95*

Algen, Phytoplankton, Seetang 48 bis 57

Verwitterung (Silizium-Mineralien) 3 bis 6

Gesamt 193 bis 220

Andere veröffentlichte Werte: 68 bis 110 bzw. 30 bis 50 Gt

Die Differenz beträgt +1,5 bis 3 Gt pro Jahr, was übereinstimmt mit der jährlichen Zunahme (abhängig von der ENSO-Aktivität)

Man beachte, dass Fehlerbandbreite für Schätzungen der Ausgasungen aus Ozeanen und Bodenbakterien die Gesamt-Emissionen der Menschen übersteigt.

Die menschliche CO2-Erzeugung steht im Mittelpunkt des IPCC, so dass es die Verbreitung von Informationen kontrolliert. Wie fast alles, was das IPCC macht, findet das hinter verschlossenen Türen statt, aber es weiß, dass einige Menschen um die Bedeutung wissen. Man erklärt das Verfahren so:

Welche Rolle spielt das IPCC bei den Treibhausgas-Untersuchungen und berichtet dem UNFCCC?

Das IPCC hat eine Reihe von Verfahrensberichten bzgl. nationaler Treibhausgas-Untersuchungen erzeugt mit dem Ziel, international akzeptable Untersuchungs-Verfahren zu beschreiben. Das IPCC akzeptiert die Verantwortung, wissenschaftliche und technische Ratschläge zu geben bzgl. spezifischer Fragen mit Bezug zu jenen Untersuchungsverfahren, welche in diesen Berichten enthalten sind. Das IPCC hat eine Task Force eingerichtet, welches das National Greenhouse Gas Inventory Programme (NGGIP) betreiben soll, um diese Beratung bzgl. der Verfahren zu erstellen. Mitglieder des UNFCCC haben beschlossen, den IPCC-Leitlinien bei Berichten an die Konvention zu folgen.

Wie erzeugt das IPCC diese Leitlinien? Zur Nutzung der IPCC-Verfahren entwerfen nominierte Experten aus der ganzen Welt die Berichte, welche dann exzessiv zweimal begutachtet werden, bevor sie vom IPCC angenommen werden. Dieses Verfahren stellt sicher, dass die breitest mögliche Bandbreite von Standpunkten in die Dokumente einfließt.

Mit anderen Worten: das IPCC kontrolliert die gesamte Prozedur, von der Verfahrensweise über die Art der technischen Beratung, die Einrichtung von Task Forces, Leitlinien der Berichterstellung, Nominierung von Experten zur Erstellung der Berichte bis zur endlichen Annahme dessen, was die Berichte enthalten. Man stützt sich auf Daten von individuellen UN-Mitgliedsstaaten, aber jedwede Untersuchung der UN-Daten enthüllt sehr schnell deren Unzulänglichkeiten. Beispiel: Man betrachte die Länder welche eine Alphabetisierungs-Rate von 99% oder höher für sich in Anspruch nehmen.

Die IPCC-Zahlen der jährlichen CO2-Erzeugung pro Nation sind genauso verzerrt und falsch. Schlimmer noch, sie haben keinen wissenschaftlichen Zweck, sondern dienen ausschließlich der politischen Agenda. Prof. Murray Salby zeigt in diesem Video, dass der menschliche Anteil keinerlei Auswirkungen hat. Er zeigt, dass Variationen der natürlichen (nicht menschlichen) CO2-Quellen fast alle jährlichen Änderungen erklären. Er zeigt, wie eine Variation um lediglich 5% dieser Quellen mehr ausmacht als die gesamte menschliche Erzeugung.

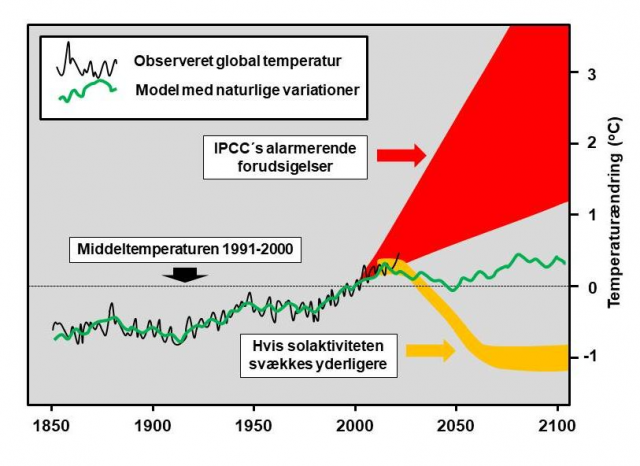

Teilweise erklärt sich der IPCC-Fehler dadurch, dass die Klimawissenschaft davon ausgeht, dass Änderung und Variabilität ungewöhnlich seien, wie das Diagramm illustriert. Sie zeigen nicht den Fehler in den Schätzungen der Volumina, welche in mindestens drei Bereichen, Atmosphäre, Ozeane und Vegetation/Erdboden, weit über Schätzungen der gesamten menschlichen Erzeugung hinausgehen. Das gilt selbst dann, wenn man die vom IPCC behauptete jährliche Zunahme heranzieht.

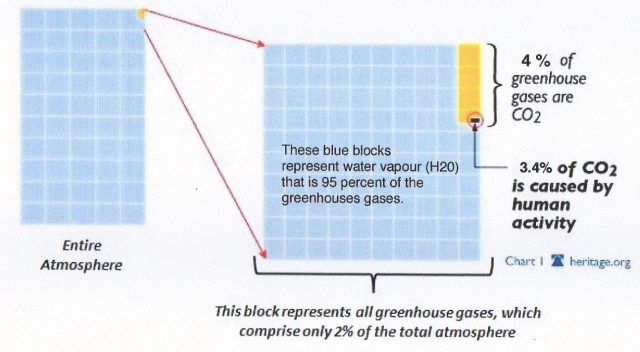

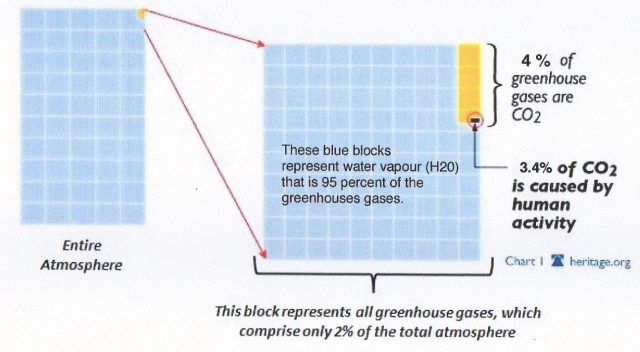

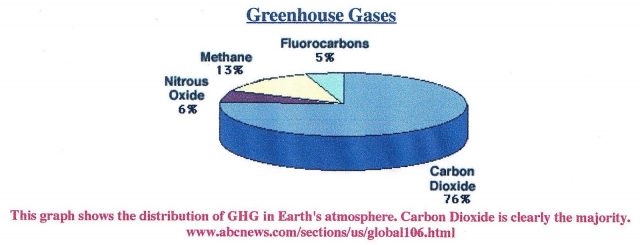

Die folgende Abbildung zeigt die Prozentanteile von Treibhausgase in der Atmosphäre:

Ein anderes Diagramm zeigt diese Anteile in anderer Form:

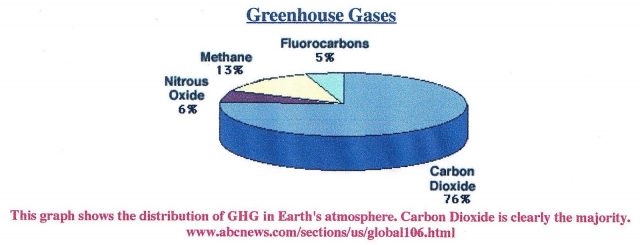

Man vergleiche dieses Diagramm mit dem Folgenden von der Website des ABC News Network. Sie zeigt die Verzerrungen durch den Betrug des IPCC. Wasserdampf, das bei Weitem bedeutendste Treibhausgas, taucht nicht einmal auf. Dies ist ein Beweis für den Erfolg, die gesamte Aufmerksamkeit auf das CO2 zu lenken.

Es gibt viele Missverständnisse über CO2, alle erzeugt, um die Hypothese zu stützen und das Bedrohungsniveau auf verschiedene Weise zu erhöhen. Zum Beispiel lautet eine frühe IPCC-Behauptung, dass die Verweildauer von CO2 in der Atmosphäre mindestens 100 Jahre lang ist. Das war ostentativ dazu gedacht, uns glauben zu machen, dass selbst bei sofortiger Beendigung der CO2-Erzeugung der angerichtete Schaden noch lange Zeit währen wird. Heute wissen wir, dass die Verweildauer etwa 5 bis 6 Jahre beträgt.

Die grundlegende Annahme der Hypothese sagt, dass ein CO2-Anstieg einen Temperaturanstieg verursacht. Nach der Veröffentlichung von Petit et al. (1999) schienen antarktische Eisbohrkerne diesen Befund zu belegen, wie der IPCC-Bericht 2001 meint:

Abbildung: antarktischer Eisbohrkern

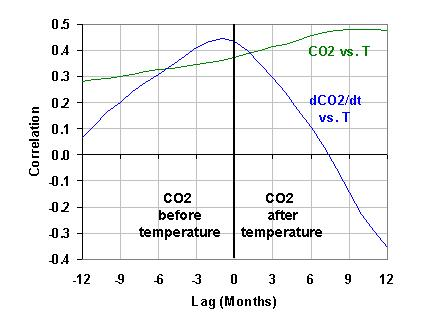

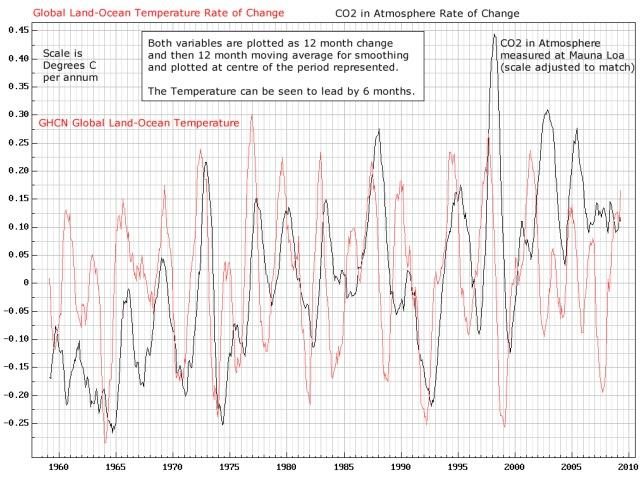

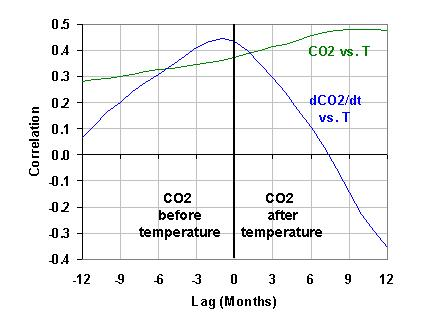

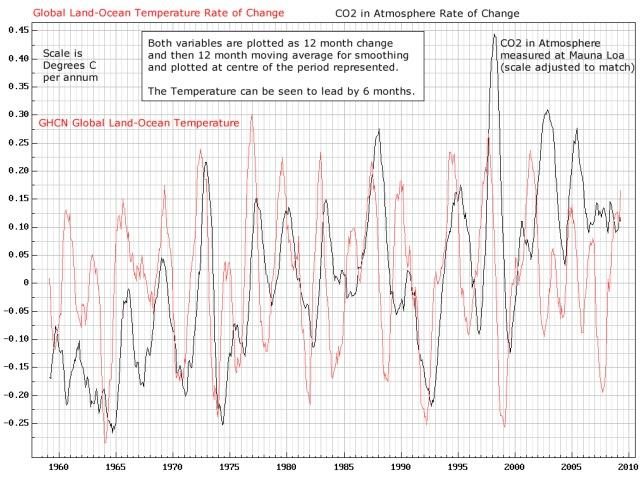

Aber nur vier Jahre später erschien der Beweis, dass die grundlegende Annahme der Hypothese falsch war. Ein detaillierterer Blick darauf zeigte nämlich, dass die Temperatur vor einer Zunahme des CO2-Gehaltes gestiegen war, was ein kompletter Widerspruch zur Hypothese war. Irgendwie wurde das aber beiseite gefegt, vermutlich wegen der ablenkenden Behauptung, dass die Verzögerung zwischen 80 und 800 Jahren beträgt. Das spielt jedoch keine Rolle, weil es immer noch der zugrunde liegenden Hypothese widerspricht. Noch überzeugender ist die Tatsache, dass sich die einer CO2-Änderung vorausgehende Temperaturänderung in fast allen Aufzeichnungen für jedwede Periode oder Dauer zeigt. Sehr merkwürdig ist, dass dieser Widerspruch von allen Befürwortern und zu vielen Skeptikern ignoriert wird. Die folgende Abbildung zeigt einen kürzeren Zeitraum der Aufzeichnung bzgl. dieser Relation:

Abbildung: zeitliche Verzögerung über einen kurzen Zeitraum, 1958 bis 2009

Es ist logisch anzunehmen, dass falls eine CO2-Änderung wirklich einer Temperaturänderung in jeder Aufzeichnung hinterher läuft, CO2 kein Treibhausgas sein kann. Und trotzdem ist die Hypothese, dass eine CO2-Zunahme eine Temperaturzunahme bewirkt, in allen globalen Klima-Computermodellen enthalten einschließlich jener, die das IPCC heranzieht.

Das IPCC stand bald vor einer weiteren ernsten Herausforderung aufgrund der Notwendigkeit, die Hypothese zu beweisen anstatt sie zu widerlegen, wie es in der normalen Wissenschaft selbstverständlich ist. Man musste nämlich die Mittelalterliche Warmzeit MWP irgendwie loswerden, weil sie zeigte, dass es auf der Welt schon vor der industriellen Revolution wärmer war als heute. Das war notwendig, um zu belegen oder zu behaupten, dass das vorindustrielle CO2-Niveau niedriger war als heute. Diese Kampagne lief bereits, als die Informationen aus den Eisbohrkernen veröffentlicht worden sind.

Die meisten Menschen denken, dass Eisbohrkerne die einzige Quelle für vorindustrielles CO2 seien. Was die meisten Menschen aber nicht wissen ist, dass Tausende Messungen des atmosphärischen CO2 bereits im 19. Jahrhundert durchgeführt worden waren. Joseph Black studierte die Eigenschaften von CO2 bereits im Jahre 1750, und Joseph Priestly veröffentlichte Untersuchungen über Sauerstoff im Jahre 1775. Versuche, die verschiedenen Volumina atmosphärischer Gase zu messen einschließlich Messungen des CO2-Gehaltes folgten ab dem Jahr 1812. Wissenschaftler nahmen präzise Messungen mit kalibrierten Instrumenten vor, wie Ernst Georg Beck gründlich dokumentiert hat.

In einem Papier, welches anlässlich einer Anhörung vor dem US-Senatskomitee für Kommerz, Wissenschaft und Transportwesen eingereicht worden ist, schreibt Prof. Zbigniew Jaworowski:

Die Grundlage der meisten IPCC-Schlussfolgerungen bzgl. anthropogener Ursachen und Projektionen klimatischer Änderungen ist die Annahme eines niedrigen CO2-Niveaus der Atmosphäre in vorindustrieller Zeit. Diese Annahme ist falsch, wie glaziologische Studien belegen“.

Genauso bedeutend ist diese Feststellung Jaworowskis:

Die Vorstellung eines niedrigen vorindustriellen CO2-Niveaus wurde zu einem weithin akzeptierten heiligen Gral der Klima-Erwärmungs-Modelle, obwohl diese auf so einem ärmlichen Wissen beruhen. Die Modellierer ignorierten die Beweise durch direkte Messungen des CO2-Gehaltes der Luft, welche belegen, dass die mittlere Konzentration im 19. Jahrhundert bei 335 ppmv lag. Es wurden Daten selektiv herausgepickt, um zu zeigen, dass das atmosphärische CO2-Nveau im 19. Jahrhundert 292 ppmv betragen hatte. Eine Studie mittels der Anzahl von Stomata in fossilem Laub bei einem See in Dänemark zeigt, dass das CO2-Niveau vor 9400 Jahren 333 ppmv und vor 9600 Jahren 348 ppmv betragen hatte. Dies falsifiziert das Konzept einer stabilen und geringen CO2-Konzentration in der Luft bis zum Eintreten der industriellen Revolution.

Die Behauptung Jaworowskis, dass die Modellierer die Messungen aus dem 19. Jahrhundert ignoriert hätten, stimmt nicht. Sie wussten sehr wohl um diese Messungen, hat doch T. R. Wigley der klimawissenschaftlichen Gemeinschaft Informationen hinsichtlich der Messungen im 19. Jahrhundert zukommen lassen (Wigley, T.M.L. 1983 The pre-industrial carbon dioxide level.” Climatic Change 5, 315-320). Dann wurde das gemacht, was sehr oft gemacht wurde: man hat die Messungen mit höheren Werten eliminiert und aus den übrigen einen Wert von etwa 270 ppm abgeleitet. Ich denke, dass dies die Modellierer beeinflusst hat, weil Wigley mit ihnen an der CRU bei East Anglia zusammen gearbeitet hat. Er war die Schlüsselperson, welcher alles lenkte, wie aus den durchgesickerten E-Mails der CRU hervorgeht.

Wigley war nicht der Erste, der die Daten des 19. Jahrhunderts missbraucht hatte, aber er hat diese Daten in die Klima-Gemeinde gebracht. Dann wurden nur jene Messungen berücksichtigt, welche zur Hypothese passten.

Die ganze Story steht hier.

Link: https://wattsupwiththat.com/2019/05/01/a-story-of-co2-data-manipulation/

Übersetzt von Chris Frey EIKE