Der missverstandene Klimawandel

Obwohl die exakte Terminologie und Ausdrucksweise variieren kann, erzählt man uns immer wieder die offiziellen ,Fakten‘ zum Klimawandel, als da wären:

a) Globale Erwärmung ist im Gange, und zwar mit einer beispiellosen und sich beschleunigenden Rate

b) Sie wird verursacht durch unsere Kohlendioxid-Emissionen aus der Verbrennung fossiler Treibstoffe

c) Das hat bereits zu einem alarmierenden und sich beschleunigenden Anstieg des Meeresspiegels geführt.

d) Das hat bereits zu einer alarmierenden und sich beschleunigenden Zunahme an Häufigkeit und Stärke von Extremwetter-Ereignissen geführt.

e) Es hat bereits alarmierend und beschleunigend das Aussterben von Spezies verursacht.

f) Wir befinden uns in einer Klimakrise, die schon bald katastrophale Ausmaße annehmen wird (potentiell einher gehend mit einem Massen-Aussterben), falls wir den Klimawandel nicht stoppen.

g) Wir können den Klimawandel stoppen mittels des dringenden Übergangs zu erneuerbaren Energiequellen wie Wind und Solar und damit unsere Emissionen eliminieren.

h) Die Wissenschaft hinter diesen Punkten ist settled und jenseits aller Zweifel.

Meine These lautet nicht, dass diese ,Fakten‘ einfach nur ,Fake News‘ sind (also absichtlich in die Welt gesetzte Falschheiten) oder ,Mythen‘ (andeutend, dass in ihnen keine Wahrheit irgendeiner Art steckt), sondern dass es sich um fundamentale Missverständnisse handelt auf der Grundlage der Art und Weise, mit der uns Wissenschaft und Belege informieren. Diese Missverständnisse scheinen sich das Mäntelchen eines ,kollektiven Glaubens‘ umgehängt zu haben, welcher durch gebetsmühlenartige Wiederholungen in den Medien irrtümlich als unbestreitbare Tatsachen aufgefasst wird – obwohl man jederzeit die Wissenschaft dahinter selbst überprüfen und Beweise widerlegen kann (oder sie zumindest ernsthaft hinterfragen). Nur wenige Menschen werden die Ansichten von Wissenschaftlern vernommen haben (darunter die von vielen der führendsten Wissenschaftler in der Welt), welche diese ,vom Menschen verursachte Klimawandel-Krise‘ in Frage stellen – einfach deswegen, weil diese Stimmen weitgehend ruhig gestellt worden sind (typischerweise, indem diese Personen als ,Klimawandel-Leugner‘ oder ,Wissenschafts-Leugner‘ gebrandmarkt werden). Im gegenwärtigen Klima der Feindschaft auch nur gegen die Einbeziehung alternativer Standpunkte gibt es offenbar nur eine einzige politisch korrekte Position, nämlich zu akzeptieren, dass das alarmistische Narrativ über alle Zweifel erhaben ist.

Es kommt kaum überraschend, dass es zu diesen Missverständnissen gekommen ist, weil für die meisten Menschen (seien das nun die allgemeine Öffentlichkeit, Politiker oder insbesondere auch Journalisten) ihre Informationen zum Thema Klimawandel vorherrschend aus den Medien beziehen. Wenn die Medien außerdem auch dem Mainstream zuzuordnen sind (wie etwa die BBC) und man ihnen ,vertraut‘, glauben die Menschen aus guten Gründen, dass ihnen die ,ganze Wahrheit‘ vermittelt wird durch neutral berichtende Journalisten, welche die Wissenschaft und die Beweise verstanden und kritisch unter die Lupe genommen haben. Traurigerweise gibt es jedoch kaum ein solches Verständnis und kritische Analysen – Journalisten neigen stark dazu, einfach zu übernehmen, was ihnen die ,wissenschaftlichen Autoritäten‘ vorgeben (in Gestalt von Presseerklärungen und Dokumenten mit einer executive summary, aus welchen alle Komplexitäten und ausgeprägte Unsicherheiten und Mehrdeutigkeiten entfernt worden sind). Dieses oftmals oberflächliche Verstehen wird dann dem Zielpublikum vermittelt in einer unwissenschaftlichen, emotionalen und hyperbolischen Sprache (wie etwa die Termini ,Klima-Notstand‘ oder ,Klimawandel-Krise‘), wobei Ausreißer-Prophezeiungen angeführt werden, die praktisch unmöglich eintreten können, um den Eindruck von Dringlichkeit und Gefahr zu erwecken; rhetorische Appelle an Emotionen gekoppelt mit alarmierenden Bildern (wie kalbenden Gletschern, Hurrikanen und Waldbrände oder auch vom Computer animierte ertrinkende Städte). All dies gräbt sich in die öffentliche Meinung viel stärker ein als rhetorische Appelle an die Logik, gekoppelt mit einer komplizierten Wissenschaft, mit Graphiken und Daten. Auf diese Weise werden höchst unwahrscheinliche Risiken in ferner Zukunft als existenzielle Krise heutzutage wahrgenommen. Falls man also die allgemeine Öffentlichkeit (und Journalisten und Politiker) davon überzeugen will, dass wir uns ,in einer vom Menschen verursachten Klimawandel-Krise‘ befinden, dann muss man sie normalerweise nur davon überzeugen, dass ,globale Erwärmung‘ im Gange ist (was niemand bestreitet) – einfach weil nur Wenige die fundamentalen Unterschiede verstehen werden zwischen einem vom Menschen verursachten Klimawandel einerseits und der natürlichen Klimavariation andererseits. Es reicht also schon eine einzige Temperaturgraphik (von denen man bei Google Tausende findet), um den offensichtlichen ,Beweis‘ des Narrativs zu führen. Dabei ist ein Beweis dafür, dass die globale Erwärmung stattfindet, kein Beweis dafür, dass es sich um eine vom Menschen verursachte Erwärmung handelt. Es ist kein Beweis dafür, dass Klimawandel stattfindet (geschweige denn ein vom Menschen verursachter Klimawandel), weil es sich bei der Erwärmung einfach um die natürliche Klimavariabilität handelt. Diese natürliche Klimavariabilität ist die Variabilität des mittleren Zustandes des Klimas in allen Zeitmaßstäben (jenseits der Zeitmaßstäbe normaler Wetterereignisse) aufgrund rein natürlicher Prozesse.

Diese Konfusion wurde versinnbildlicht in der Dokumentation ,Climate Change – The Facts‚ von Sir David Attenborough (von BBC TV gesendet am 18. April 2019). Diese Dokumentation war ein einziger Katalog wissenschaftlicher Missverständnisse und umfassender Behauptungen bzgl. eines vom Menschen verursachten Klimawandels, der zu eskalierenden Hitzewellen, Dürren, Stürmen, Überschwemmungen, Eisschmelze in der Antarktis, Anstieg des Meeresspiegels, Aussterben von Spezies und verbreitetem Korallensterben führen soll. Eine Zusammenstellung von Kritiken an dieser Sendung findet man hier und hier und hier. Enthalten darin ist auch die Behauptung (wie sie auch von so extremistischen Gruppen wie Extinction Rebellion aufgestellt werden), dass wir global bis zum Jahre 2050 Null-CO2-Emissionen erreichen müssen und nicht über ein halbes Grad Celsius globale Erwärmung hinausgehen dürfen, falls wir eine Klimakatastrophe vermeiden wollen. Diese Behauptung wird – um es so freundlich wie möglich auszudrücken – in keiner Weise von der Wissenschaft gestützt, wie jedem mit zumindest einem minimalen Verständnis der Klimawissenschaft oder jemandem, der den SR15-Report des IPCC gelesen hat, klar ist, obwohl dieser Report angeblich die Grundlage dieser Behauptung sein soll. Dem IPCC zufolge würde das Erreichen dieses Zieles außerdem beispiellose Änderungen unserer Lebensweise, unseres Energieverbrauchs und unseres Transportwesens erfordern – also nichts weniger als eine globale soziale und ökonomische Revolution.

Das grundlegende Problem für all jene, die bereit sind, alternative Gesichtspunkte ernsthaft in Erwägung zu ziehen besteht darin, dass um die Falschheiten in dem simplistischen Narrativ der Alarmisten zu verstehen es eines ziemlich tiefen Eintauchens in die Wissenschaft bedarf, in Statistiken, Politik und Ökonomie des Klimawandels – und das ist zeitraubend. Es ist harte Arbeit, welche ein ziemlich hohes Niveau wissenschaftlicher Bildung voraussetzt. Falls man sich jedoch dieser Mühe unterzieht, ergibt sich ein sehr unterschiedliches (und weitaus weniger alarmierendes) Bild:

1) Globale Erwärmung und Klimawandel sind beide eindeutig im Gange (wobei Letzterer reflektiert wird beispielsweise durch sich zurückziehende Gletscher und Meeresspiegelanstieg) – jedoch bislang in beiden Fällen mit einer Rate, die klar innerhalb der natürlichen Klima-Variabilität liegt (und die nicht beispiellos ist).

2) Es gibt grundlegende Unsicherheiten bzgl. der Frage, inwieweit menschliche Aktivitäten zur postindustriellen globalen Erwärmung und Klimawandel beigetragen haben, nicht zuletzt wegen des extrem schwierigen Unterfangens, den vom Menschen verursachten Klimawandel vom ,Hintergrund-Rauschen‘ der natürlichen Klima-Variabilität zu trennen.

3) Der Meeresspiegel steigt mit einer Rate von 18 bis 20 cm pro Jahrhundert, also mit einer Rate, die trotz unserer eskalierenden Kohlendioxid-Emissionen stabil geblieben ist, d. h. die Ursachen sind vorherrschend natürlichen Ursprungs. Wir können sämtliche derartigen Emissionen über Nacht einstellen, und der Meeresspiegel wird genauso weiter steigen – eine Unvermeidlichkeit, an die wir uns anpassen müssen.

4) Es gibt nicht einmal ansatzweise irgendwelche überzeugenden wissenschaftlichen Beweise, dass Extremwetter-Ereignisse an Häufigkeit oder Stärke in postindustrieller Zeit zugenommen haben (obwohl die Berichterstattung darüber sehr wohl zugenommen hat).

5) Es gibt nicht einmal ansatzweise irgendwelche überzeugenden wissenschaftlichen Beweise, dass Klimawandel (sei er nun vom Menschen verursacht oder nicht) zu einem verbreiteten Aussterben von Spezies geführt hat (die meisten Aussterbe-Ereignisse sind dem Verlust von Habitaten, Raubbau, Verschmutzung oder invasiven Spezies geschuldet).

6) Falls man die (vollständig natürliche) El Nino-Erwärmung von 2015/16 entfernt, gab es in diesem Jahrhundert keine statistisch signifikante globale Erwärmung.

7) Jüngst (vor allem in diesem Jahrhundert) hat sich die globale Erwärmung verlangsamt (während unsere Kohlendioxid-Emissionen weiter gestiegen sind). Dies illustriert die Tatsache, dass es keine direkte (oder lineare) Korrelation gibt zwischen der globalen Temperatur und Kohlendioxid-Emissionen.

8) Es ist unmöglich, die mittlere Temperatur der Erde zu kontrollieren (schon gar nicht in Zeitmaßstäben von Jahrzehnten bis zu Jahrhunderten), indem man einfach die Kohlendioxid-Emissionen kontrolliert.

9) Es ist unmöglich, den Klimawandel zu stoppen – ist dieser doch inhärent komplex, unvorhersagbar und unkontrollierbar.

10) Es ist unmöglich, eine Größenordnung des Klimawandels zu spezifizieren, jenseits der die Auswirkungen desselben insgesamt schädlich werden (das 2°C-Ziel des Paris-Abkommens ist politisch willkürlich).

11) Kohlendioxid ist ein nicht brennbares, farb-, geruch- und geschmackloses Gas, welches ein sehr effektiver Grundstoff für das Pflanzenwachstum ist. Dank der von unseren Emissionen verursachten Zunahme der Konzentration in der Atmosphäre ist die Erde auf eine Art und Weise ergrünt, die schon jetzt äquivalent zur doppelten Größe der USA ist. Der Kohlenstoff-Zyklus der Erde kann durch das Hinzufügen einer solch großen Kohlenstoff-Senke fundamental verändert werden. Außerdem ist das Gas der ,Treibstoff‘ der Photosynthese und für die Erzeugung von Sauerstoff; es ist absolut essentiell für die Existenz des komplexen Lebens auf der Erde (uns selbst eingeschlossen). Dr. Richard Lindzen, Professor der atmosphärischen Wissenschaften am MIT, hat es so ausgedrückt: „An den Gedanken, dass Kohlendioxid ein gefährliches, den Planeten zerstörendes Gift ist, wird man sich später als ,die größte Massen-Irreführung aller Zeiten‘ erinnern“.

12) Die Kohlendioxid-Konzentrationen in unserer Atmosphäre sind heute um etwa 46% höher als die Konzentrationen in vorindustrieller Zeit (280 ppm), aber sie liegen etwa viermal niedriger als dessen mittleres Niveau und mindestens zehnmal niedriger als zur Zeit der höchsten Konzentration in der Erdgeschichte (auf der Grundlage paläoklimatischer Schätzungen).

13) Die globale mittlere Temperatur der Erde liegt heute um etwa 1°C über dem vorindustriellen Niveau, aber um etwa 6°C unter dem mittleren Niveau und mindestens um 13°C unter dem höchsten Niveau in der Erdgeschichte (auf der Grundlage paläoklimatischer Schätzungen).

14) Computermodelle bzgl. Klimawandel erweisen sich als sehr unzuverlässige Hilfsmittel zur Vorhersage des Klimawandels in der Zukunft (besonders hinsichtlich deren grober Übertreibung der Erwärmung) – und doch sind es die extremsten ,Prophezeiungen‘ dieser Modelle, welche die globale Klima- und Energiepolitik bestimmen.

15) Die zukünftigen Kosten und Auswirkungen von Dekarbonisierung können sehr gut über zukünftige Kosten und Auswirkungen einer vom Menschen verursachten globalen Erwärmung hinausgehen, d. h. selbst wenn eine solche Erwärmung schädlich sein sollte, dürfte es kaum kosteneffektiv sein, dem mit Dekarbonisierung zu begegnen.

16) Auf der Grundlage von aus Beobachtungen abgeleiteter Schätzungen der Klima-Sensitivität dürfte die weitere, vom Menschen verursachte globale Erwärmung in diesem Jahrhundert kaum über 1,5°C hinausgehen, und die Auswirkungen derselben sind wohl insgesamt vorteilhafter für Mensch und Umwelt. …

17) Klima-Störungen (z. B. mit einem Zusammenbruch des Golfstromes) vor Ende dieses Jahrhunderts aufgrund einer vom Menschen verursachten globalen Erwärmung sind nicht absolut unmöglich, aber extrem unwahrscheinlich.

18) Ein ,Massen-Aussterbe-Ereignis‘ vor Ende dieses Jahrhunderts aufgrund der menschengemachten Erwärmung ist praktisch unmöglich. Hingegen ist eine globale ökonomische Rezession/Depression als Folge der Klimapolitik praktisch sicher – eine Politik, die vermeintlich darauf abzielt, die zukünftige Erwärmung auf ein halbes Grad Celsius zu begrenzen, um gerade ein solches Ereignis zu vermeiden.

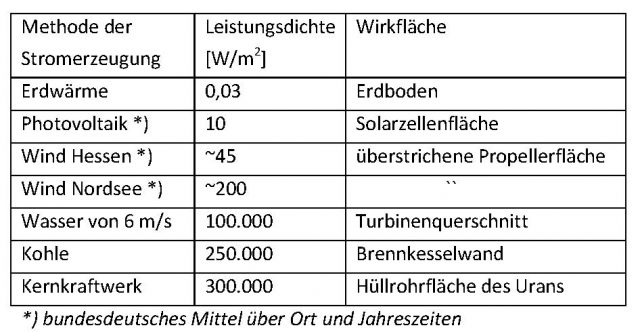

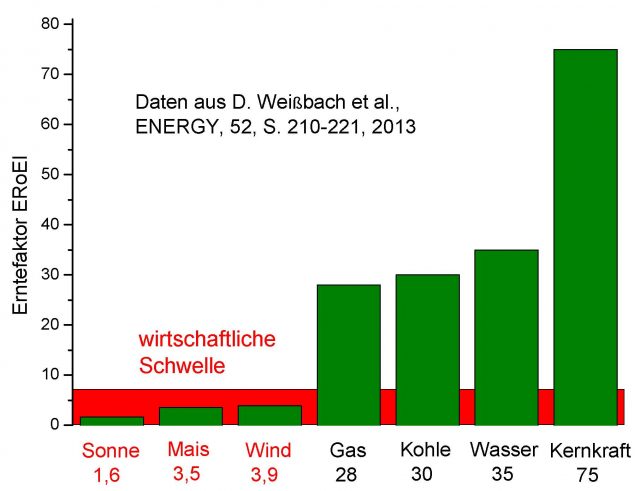

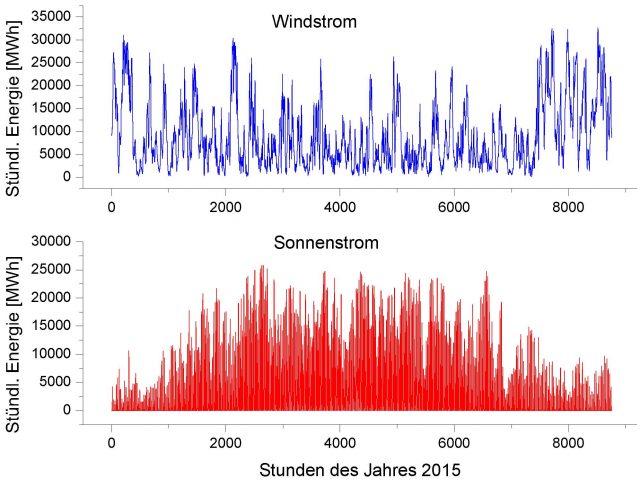

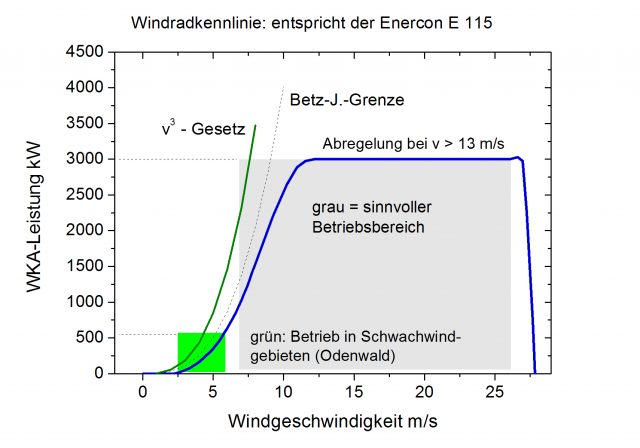

19) Unberechenbare [intermittent] Wind- und Solarenergie ist keine Lösung bzgl. irgendeines zukünftigen Klimawandel-Problems.

20) Die Wissenschaft vom Klimawandel ist gegenwärtig unausgegoren, höchst fragwürdig und nicht einmal ansatzweise settled. Genau das ist der Grund, warum so viele so verschiedene Interpretationen dieser Wissenschaft durch die Welt geistern.

Auf der Grundlage all dieser Punkte ist der politisch korrekte Modetrend für Gremien/Landkreise/Länder, einen ,Klimawandel-Notstand‘ auszurufen, eindeutig einem ausgeprägten wissenschaftlichen Missverständnis geschuldet (tatsächlich ist es schwierig, nicht den Terminus ,wahnhaft‘ {delusional} in den Mund zu nehmen), wenn man irgendeine vernünftige Definition des Terminus‘ ,Notfall‘ [emergency] zugrunde legt. Es könnte wohl politisch sinnvoll sein (um das ,grüne Votum‘ zu erlangen), aber es ist wissenschaftlich und ökonomisch kompletter Unsinn. Beispiel: die einzige signifikante Änderung des Klimas in UK seit hunderten von Jahren war eine geringe Erwärmung – und dennoch hat das UK-Parlament jetzt einen ,Klimawandel-Notfall‘ ausgerufen. Es ist schwierig, einen Sinn in dieser Maßnahme zu erkennen, denn der Klimawandel bisher war insgesamt vorteilhaft für Mensch und Umwelt, hat er uns doch aus dem Elend der Kleinen Eiszeit herausgebracht, welche der geringen Erwärmung vorausgegangen war, mit ihren Dürren, Missernten, Hungersnöten und Epidemien – und er ist einher gegangen mit dem zunehmenden Wohlstand und der längeren Lebenserwartung aufgrund der Industriellen Revolution. All das deutet viel eher auf das genaue Gegenteil eines Notfalls.

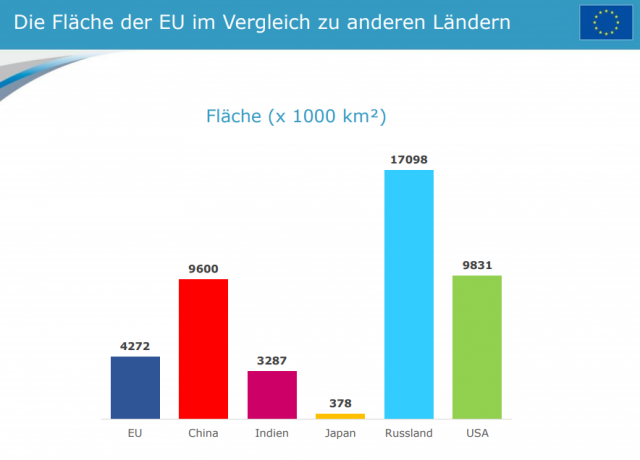

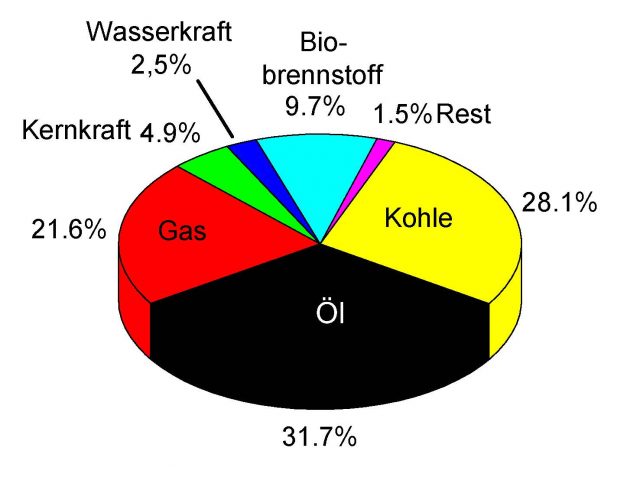

Trotz allem oben Gesagten – falls man trotzdem der Linie der radikalen globalen Dekarbonisierung folgt, kann diese nicht ohne konzertierte Maßnahmen erfolgreich sein, besonders seitens großer Emittenten wie China (30% der weltweiten Kohlendioxid-Emissionen, Tendenz steigend – und der IEEFA zufolge einer Finanzspritze von etwa 36 Milliarden Dollar von Kohle-Projekten). Falls nur schwache Emittenten der Dekarbonisierung folgen, ist das noch schlimmer als sinnlos. Selbst wenn beispielsweise UK (1,1% der globalen Emissionen) ihre Ökonomie irgendwann vollständig dekarbonisiert (mit noch gar nicht verfügbaren Verfahren wie CCS), wie es vom UNFCCC gefordert wird, wäre die zukünftige Reduktion der globalen Erwärmung immer noch unmessbar klein. Damit ergeben sich grundsätzlich extreme ökonomische, soziale und umweltliche Schäden. Die einzige Grundlage, auf der so etwas erreicht oder verantwortet werden kann ist, wenn große Emittenten wie China dem Beispiel von UK folgen – und, gelinde gesagt, die Chance dafür ist vernachlässigbar.

Natürlich steht es um diese 20 Punkte erheblich komplizierter, qualifizierter und unsicherer als die 8 einfachen, absoluten und ,sicheren‘ Fakten zu Beginn dieses Beitrags. Hätte man die Wahl zwischen den komplexen Unsicherheiten der 20 Punkte und der einfachen Sicherheit der ,Fakten‘, würden wohl Viele letzteres vorziehen. Können wir also all diese Komplexität auf ein relativ einfaches ,alternatives Klimawandel-Narrativ‘ reduzieren – mit dem sehr realen Risiko, dass dieses Narrativ genauso banal ist wie der ursprüngliche Faktensatz? Falls man zu einer so großen Vereinfachung gezwungen ist, möchte ich Folgende Punkte vorschlagen:

a) Globale Erwärmung ist im Gange, wenngleich mit einer Rate, die durchschnittlich ist und sich nicht beschleunigt.

b) Sie wurde verursacht sowohl durch menschliche Aktivitäten als auch natürliche Kräfte (das heißt sie ist nicht einfach nur unseren Kohlendioxid-Emissionen geschuldet)

c) Dadurch steigt der Meeresspiegel, wenngleich in einer Rate, die durchschnittlich ist und sich nicht beschleunigt

d) Es ist nicht zu einer Zunahme von Häufigkeit und Intensität von Extremwetter-Ereignissen gekommen.

e) Sie hat nicht zu einer Beschleunigung des Aussterbens von Spezies geführt.

f) Wir stehen nicht vor einer ,Klimawandel-Krise‘ oder gar einem ,Klimawandel-Notfall‘ (tatsächlich ist genau das Gegenteil der Fall), aber Klima-Störungen in ferner Zukunft sind nicht unmöglich, wenngleich auch extrem unwahrscheinlich.

g) Wir können den Klimawandel nicht aufhalten, aber wir können die Klimawandel-Risiken reduzieren (wenngleich zu sozial und umweltlich unerschwinglichen Kosten), indem wir graduell zu weniger Kohlenstoff-intensiven Energiequellen wechseln (wie Erdgas).

h) Die Wissenschaft hinter diesen Punkten ist unausgereift und Gegenstand von Diskussionen. Es gibt einen fast totalen wissenschaftlichen Konsens, dass globale Erwärmung stattfindet und dass wir dazu beitragen [?, der Übersetzer] – aber ausgeprägte Meinungsunterschiede über das Ausmaß unseres Beitrags, ob dieser zu einem ,gefährlichen‘ Klimawandel führt und ob globale Dekarbonisierung wirklich die richtige politische Antwort ist.

Nun ist all dies höchst kontrovers, weil es die politisch korrekte Orthodoxie bzgl. Klimawandel unterläuft, jene alarmierenden ,Fakten‘, die in Frage zu stellen uns verboten ist. Viele würden zweifellos gegen dieses alternative, besonnene und weit weniger alarmistische Narrativ opponieren, vielleicht mit der Aussage, dass dies ,nicht dem entspricht, was das IPCC sagt‘. Das IPCC wird typischerweise beschrieben als ,das international anerkannte Gremium bzgl. Klimawandel‘. Es wird von den meisten Akademikern, Politikern, Umweltaktivisten und Journalisten mit Achtung, wenn nicht sogar Ehrfurcht betrachtet, sehen diese doch das IPCC als praktisch unfehlbar und allwissend an, wenn es um Klimawandel geht. Tatsächlich sind viele meiner 20 Punkte direkt aus den IPCC-Berichten abgeleitet. Insgeheim habe ich den Verdacht, dass das IPCC im Privaten den meisten dieser 20 Punkte zustimmt (was es aber aus Furcht vor einer Reduktion der Furcht nie öffentlich einräumen würde). Außerdem konzentriert sich das IPCC fast ausschließlich auf einen vom Menschen verursachten Klimawandel (um der Vorgabe des UNFCCC zu folgen) auf Kosten bedeutender Aspekte des natürlichen Klimawandels, und die Brandmarkung des Schuldigen, also Kohlendioxid, ist vorbestimmt. Die Ansichten des IPCC zu ignorieren wäre genauso närrisch wie zu glauben, dass es über alle Zweifel erhaben ist.

Um das Thema Klimawandel wirklich zu verstehen müssen wir akzeptieren, dass es weitaus komplizierter, facettenreicher und unsicherer ist als die vereinfachte Berichterstattung in den Medien. Wir müssen unseren Geist der breiten Vielfalt von Experten-Meinungen öffnen, über diese sehr ernsthaft nachdenken, den gesunden Menschenverstand walten lassen und vorsichtige Beurteilungen abgeben. Über allem muss aber stehen, dass wir uns vor irgendwelchen simplen Lösungen hüten müssen – wie etwa eine globale Dekarbonisierung. Unglücklicherweise haben nur sehr wenige Menschen dafür Zeit, Neigung und Ausdauer. Dr. Richard Lindzen drückte es so aus: „die offensichtlich überwältigende Botschaft der da oben lautet, dass wir vor einer vom Menschen verursachten Klimawandel-Krise stehen und dass dieser nur durch dringende und radikale globale Dekarbonisierung zu begegnen ist“. Dabei ist es nur zu verständlich (wenngleich auch bedauerlich), dass die breite Mehrheit der allgemeinen Öffentlichkeit ebenso wie Journalisten und Politiker sich einfach dafür entschieden haben, das zu glauben. Die simplen Sicherheiten des alarmistischen Narrativs in den Medien mag auf ausgeprägten wissenschaftlichen Missverständnissen beruhen (wessen sich die da oben auch wohl bewusst sind). Aber die Haltung der Oberen scheint es zu sein, dass weil eine ,Klimawandel-Krise‘ in ferner Zukunft nicht unmöglich ist, die dubiosen Mittel durch das implizite möglich gerechtfertigt sind. Aber selbst dieses alarmistische Narrativ hat es nicht vermocht, die Nationen der Welt zu gemeinsamem Handeln zu bewegen. Würden die Behörden ehrlich über das Thema Klimawandel reden mit all seiner Komplexität und Unsicherheit, würde dies den Regierungen sogar noch weitere Gründe geben, Dekarbonisierungen zu verzögern oder zu vermeiden. Das Verhalten aller wissenschaftlichen Autoritäten ist perfekt verständlich, wenngleich auch bedauerlich, weil dadurch das Risiko radikaler Klimawandel-Maßnahmen zu implementieren steigt, welche man in Zukunft noch sehr bedauern würde. Und natürlich ist auch das Verhalten der Medien völlig verständlich (wenngleich ebenfalls bedauerlich), weil sich schlechte Nachrichten nun einmal gut verkaufen. Hingegen ist es sehr schwierig, aus ,keine Klimawandel-Krise‘ eine Story zu machen.

Wenn die Leute sagen, dass sie an die Klimawandel-Krise glauben, weil sie an ,die Wissenschaft glauben‘, sagen sie in Wirklichkeit, dass sie es deswegen sagen, weil sie die Wissenschaft gar nicht verstehen, an die zu glauben sie sich entschieden haben. Und das, weil dieses Narrativ von Behörden und in den Medien vorangetrieben wird. Nur wenige Menschen entscheiden sich dafür, den ,wenig begangenen Weg‘ einzuschlagen, ihren Geist zu öffnen für die Argumente der anderen Seite der Klimawandel-Debatte, einschließlich Komplexität, Unsicherheit, Zweifel und sozialer Schande. Einerseits hat man es mit einem offensichtlich wissenschaftlich Geradeaus zu tun, das leicht verständlich, sehr sicher und sehr alarmierend ist („unsere Kohlendioxid-Emissionen verursachen eine Klimawandel-Krise“), und das auch eine einfache Lösung hat („Dekarbonisierung“). Andererseits gibt es ein wissenschaftlich herausforderndes, sehr schwierig zu verstehendes, komplexes und unsicheres Problem, welches alarmierend sein kann oder nicht und welches keine einfache Lösung hat. Anders gesagt, einerseits gibt es eine imminente existentielle planetare Krise, der nur durch eine radikale und dringliche Transformation der globalen Gesellschaft begegnet werden kann, während man andererseits ein mögliches Problem in ferner Zukunft hat ohne eine offensichtlich ,korrekte‘ politische Lösung heute. Es ist nicht schwierig zu erkennen, warum manche Leute, besonders junge, idealistische und leicht zu beeindruckende Leute, eher zu Ersterem neigen, die Banner ausrollen und ,den Planeten retten‘ wollen mittels einer Welt-Revolution unter dem Motto Save The Planet‚.

Innerhalb der klimawissenschaftlichen Gemeinschaft läuft die Trennlinie im Wesentlichen zwischen jenen (verkörpert durch das IPCC), welche vorherrschend an Klimamodelle glauben (d. h. virtuelle Welt-Projektionen dessen, was in der Zukunft passieren könnte) und jenen, die vorherrschend an empirische wissenschaftliche Beweise glauben (d. h. Beobachtungen in der realen Welt, die tatsächlich vor sich gegangen sind). Erstere Gruppe neigt dazu, sich auf die möglichen hohen Risiken eines zukünftigen Klimawandels konzentrieren und einer rapiden globalen Dekarbonisierung das Wort reden nur für den Fall. Die zweite Gruppe hingegen neigt dazu sich auf die möglichen geringen Risiken zu konzentrieren (sowie auf die hohen Kosten und die Auswirkungen von Dekarbonisierung). Man könnte sagen, dass die zweite Gruppe das Ganze wie ein Geschäftsmann betrachtet, welcher das Gleichgewicht von Möglichkeiten, Kosten, Vorteile und Risiken austariert, während die erste Gruppe einfach sagt, dass es ein gewaltiges potentielles Risiko gibt und daher etwas (radikale globale Dekarbonisierung) getan werden muss, fast ungeachtet aller Wahrscheinlichkeiten, Kosten und negativer Auswirkungen. Jemand hat es so ausgedrückt: „die ungelöste Schlüsselfrage lautet, ob globale Dekarbonisierung ,unsere allgemeine Zukunft im globalen Maßstab zu unserem Vorteil fundamental umgestalten wird oder rasch zu Schäden führt, welche die Menschheit in den ökonomischen, sozialen und umweltlichen Bankrott führen kann’“. Klimawissenschaftler, die das dominante Narrativ einer vom Menschen verursachten Klimawandel-Krise hinterfragen, sagen nicht, dass es ein eindeutiges wissenschaftliches Urteil ,Unschuldig‘ gibt, sondern sie sagen einfach dass unsere Schuld noch nicht über alle Zweifel erhaben bewiesen ist.

Das fundamentale Problem mit dem Klimawandel-Problem ist, dass es ein ,hinterhältiges‘ Problem ist: es ist unmöglich, unser zukünftiges Klima vorherzusagen oder zu bestimmen, ob es nun harmlos oder alarmierend ist, und zu sagen, wie man darauf reagieren sollte, weil einfach zu viele Variable, zu viele Unbekannte und zu viele Unsicherheiten im Spiel sind. Was wir jedoch als Reaktion wählen ist ein gigantisches Hasardspiel mit der Zukunft der Menschheit. Wie auch immer wir uns entscheiden – es könnte dazu führen, dass wir unsere Entscheidungen eines Tages zutiefst bedauern.

Link: https://wattsupwiththat.com/2019/05/06/climate-change-misconceived/

Übersetzt von Chris Frey EIKE