Sven Plöger und das 5-fache Motiv ein Grad Celsius aus dem #Treibhauseffekt verschwinden zu lassen !!

Die fünf stichhaltigen Argumente, die den Vorsatz von Sven Plöger belegen, in Kurzform:

1. E-Mail von KLIMAMANIFEST an Bettina Böttinger vom 29.03.2019

2. Treibhauseffekt-Zitate in Büchern von Sven Plöger (2009 bis 2013)

3. Maildiskussion in 2014 mit Frank Böttcher (Co-Autor von Sven Plöger)

4. Diverse Beschwerdeverfahren beim WDR seit 2013 bis 2016

5. Telefonat vom 09.06.2017 mit WDR-Journalistin Charlotte Gnändiger

Deshalb: Es war nachweislich VORSATZ als Sven Plöger am 11.04.2019 in der WDR-LIVE-Sendung „Ihre Meinung“ 1 °C aus dem natürlichen Treibhauseffekt einfach hat verschwinden lassen, als er den globalen Absoluttemperaturwert einfach von 15 °C auf 14 °C bzw. den Wert aus dem Treibhauseffekt von 33 °C auf 32 °C heruntergesetzt hat. Wir haben den Sachverhalt bereits seit 12.04.2019 in einem kurzen, 5-minütigen Video erklärt, hier:

Der Video-Blogger von FMDsTVChannel hat den wichtigen Sachverhalt in seinem durch uns inspirierten Video ergänzend in einer animierten Sequenz ab Minute 2:38 noch etwas deutlicher rübergebracht, auch ein wichtiger O-Ton von „Klimapapst“ Hans Joachim Schellnhuber ist dort ebenfalls zusätzlich zu hören. Wir haben diese wichtige Video-Passage mit dem folgenden 3-minütigen-Video noch weiter ergänzt und optimiert:

Wenn Sie die obigen beiden Videos gesehen und verstanden haben, werden Sie nun auch womöglich noch besser verstehen, warum wir seit Jahren auf die Beantwortung der Fragestellung pochen, auf welchen Absoluttemperaturwert sich das 2-Grad bzw. 1,5-Grad bezieht:

Hinzukommt: Wir haben bis dato mindestens 27(!) verschiedene 2-Grad-Ziele recherchiert und die Klima(folgen)forschung teilt bis heute nicht mit, welches „2-Grad-Ziel“ denn das RICHTIGE/KORREKTE ist.

Hinzukommt: Wir haben bis dato mindestens 27(!) verschiedene 2-Grad-Ziele recherchiert und die Klima(folgen)forschung teilt bis heute nicht mit, welches „2-Grad-Ziel“ denn das RICHTIGE/KORREKTE ist.

Sehr passend dazu auch diese Print-Artikel-Überschrift im Schweizer „TAGESANZEIGER“ vom 25.04.2019 auf Seite 3:

Fragen Sie sich: Wo liegt denn die Normaltemperatur der Fichte, wenn die Fichte kein Fieber hat? Fragen Sie diesen „tollen“ Revier-Förster Heinz Studer mal, ob er Ihnen den Normal-Temperaturwert der Fichte nennen kann, wenn er behauptet, die Fichte hätte (angeblich) Fieber.

Fragen Sie sich: Wo liegt denn die Normaltemperatur der Fichte, wenn die Fichte kein Fieber hat? Fragen Sie diesen „tollen“ Revier-Förster Heinz Studer mal, ob er Ihnen den Normal-Temperaturwert der Fichte nennen kann, wenn er behauptet, die Fichte hätte (angeblich) Fieber.

Denn wenn Ihnen die NORMAL-Temperatur als absoluter Wert nicht mindestens ein-einziges Mal definitiv glaubwürdig ermittelt und mitgeteilt wird, sind Sie der Willkür ausgeliefert und es kann Ihnen mit x-beliebigen steigenden Temperaturkurven vorgegaukelt werden, Sie hätten (angeblich) Fieber oder es würde eine gefährliche Erderwärmung existieren, eine Täuschung, wie sie im Dezember 2016 durch den ARD-Meteorologen Karsten Schwanke mit der Öffentlichkeit versucht wurde, über die wir aber u.a. mit folgender .gif-Datei aufgeklärt haben:

Aber warum GENAU können wir behaupten, dass es VORSATZ war, dass Sven Plöger die 1 °C aus dem natürlichen Treibhauseffekt hat verschwinden lassen?

Das hat mehrere Gründe, die wir nachfolgend nennen und dokumentieren werden:

Der Hauptgrund allen voran ist die Tatsache, dass die Moderatorin Bettina Böttinger und damit die zuständige WDR-Redaktion von „Ihre Meinung“ seit dem 29.03.2019 per Mail über die wichtige 15°C-Argumentation informiert war und zwar durch unser Mail, hier:

Aber – wie so häufig bei den öffentlich-rechtlichen TV-Sendern – bekommt man dann eine unpersönliche, automatische Antwort, die aber trotzdem beweist, dass unsere Mail vom 29.03.2019 beim WDR angekommen ist:

Aber – wie so häufig bei den öffentlich-rechtlichen TV-Sendern – bekommt man dann eine unpersönliche, automatische Antwort, die aber trotzdem beweist, dass unsere Mail vom 29.03.2019 beim WDR angekommen ist:

Der WDR war also nachweislich informiert. Setzen Sie diesen Nachweis auch in Beziehung zu der Video-Aufforderung von Bettina Böttinger vom 29.03.2019:

Der WDR war also nachweislich informiert. Setzen Sie diesen Nachweis auch in Beziehung zu der Video-Aufforderung von Bettina Böttinger vom 29.03.2019:

Wenn es diesem öffentlich-rechtlichen Sender wirklich um Aufklärung und die Repräsentanz aller und insbesondere sehr relevanter Recherchen und Auffassungen gehen würde, hätte dieser grösste deutsche gebühren-finanzierte TV-Sender den Widerspruch, der in endlosen Schulbücher nachzulesen ist, zum Thema in der Sendung gemacht.

Stattdessen passierte u.a. DAS:

In der Sendung „Ihre Meinung“ am 11.04.2019 kam es dann zu diesem peinlichen Fehler: Es wurde die „2“ bei CO2 fälschlich hochgestellt:

Obwohl es sich oberflächlich nur um eine vermeintliche Kleinigkeit handelt, sagt dieser Fehler doch sehr viel über die zweifelhafte „Kompetenz“ der im Hintergrund tätigen WDR-Journalisten (hier: Jens Eberl) aus. Abgesehen davon, dass sich bis heute niemand vom WDR für den Fehler entschuldigt hat, auch nicht der über Twitter informierte und verantwortliche WDR-Journalist Jens Eberl. Die WDR „Ihre Meinung“-Sendung vom 11.04.2019 war somit leider die übliche Klimawandel-Propaganda der öffentlich-rechtlichen TV-Medien, denn die paar kritischen Stimmen waren in der Sendung unbedeutend und hatten keine wirklich stichhaltigen Argumente zur Entlarvung des Erderwärmungs-Schwindel.

Übrigens: Dem ach-so-renommierten Grimme-Institut in Marl ist dieser gleiche CO2-Fehler bereits im Jahr 2011 passiert.

Und so lobt der WDR seine Moderatorin und Vorzeige-Journalistin Bettina Böttinger auf der Webseite zur Sendung „Ihre Meinung“ (rot-Markierungen durch Klimamanfest.ch):

Aber nun zurück zu unserer Mail an den WDR vom 29.03.2019:

Als Anlage war unserer Mail vom 29.03.2019 eine Schulbuchseite 194 aus einem aktuellen KLETT-Geographie-Schulbuch aus dem Jahr 2017 incl. Titel-Cover als 2-seitige .pdf-Datei beigefügt:

Im oberen Teil der Schulbuchseite 194 findet sich eine drei geteilte Grafik, die in der dritten Grafik „c“ – ganz rechts – den Schülern zeigt und erklärt, woran man (angeblich) einen – so wörtlich – „durch den Menschen verstärkten Treibhauseffekt“ erkennt:

Im oberen Teil der Schulbuchseite 194 findet sich eine drei geteilte Grafik, die in der dritten Grafik „c“ – ganz rechts – den Schülern zeigt und erklärt, woran man (angeblich) einen – so wörtlich – „durch den Menschen verstärkten Treibhauseffekt“ erkennt:

…nämlich an einem globalen Temperaturwert oberhalb von 15°C. Das Schulbuch spricht – so wörtlich – von „+15°C + X„:

…nämlich an einem globalen Temperaturwert oberhalb von 15°C. Das Schulbuch spricht – so wörtlich – von „+15°C + X„:

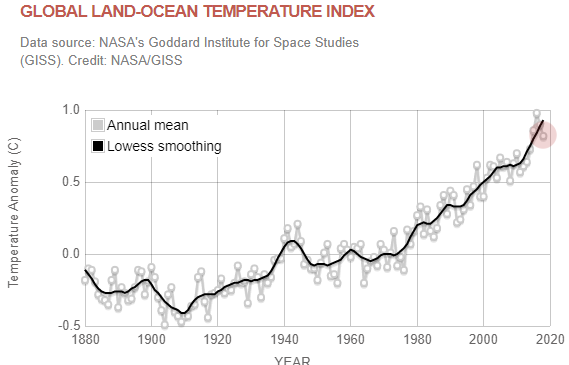

Aber die Grafik auf der Schulbuchseite 194 unten, die die globalen Temperaturen ausweist, zeigt aber keine globalen Absoluttemperaturwerte, die seit 1880 die 15°C aus dem natürlichen Treibhauseffekt überschritten haben, was lernende Schulkinder aber womöglich auf den ersten Blick nicht sehen und nicht erkennen:

Aber die Grafik auf der Schulbuchseite 194 unten, die die globalen Temperaturen ausweist, zeigt aber keine globalen Absoluttemperaturwerte, die seit 1880 die 15°C aus dem natürlichen Treibhauseffekt überschritten haben, was lernende Schulkinder aber womöglich auf den ersten Blick nicht sehen und nicht erkennen:

Erst wenn man die Absoluttemperaturen zusätzlich ergänzt, erkennt jeder Schüler, dass der Höchstwert der globalen Durchschnittstemperatur seit 1880 nur zwischen 14,5°C und 14,6°C, also unterhalb von 15°C liegt:

Erst wenn man die Absoluttemperaturen zusätzlich ergänzt, erkennt jeder Schüler, dass der Höchstwert der globalen Durchschnittstemperatur seit 1880 nur zwischen 14,5°C und 14,6°C, also unterhalb von 15°C liegt:

Die Temperaturlinien mit den globalen Absoluttemperaturen wurden von www.klimamanifest.ch zur besseren Sichtung zusätzlich hinzugefügt.

Diese Recherche über die wichtige Klett-Geographie Schulbuch-Seite 194 ist auch als 18-minütiges Video verfügbar. In dem Video werden am Ende auch noch weitere Schulbuch-Seiten aus anderen Schulbüchern gezeigt:

Diese Argumentation aus dem obigen 18-minütigen Video lässt sich auch auf einer A4-Seite anschaulich für jeden klimastreikenden #Fridays-for-Future – Klimaaktivisten darstellen, um ihm in aller Kürze zu zeigen, dass die Gefährlichkeit der Erderwärmung definitiv ein Schwindel und eine Täuschung ist:

In den offiziellen globalen Klima-Langberichten, die die Weltwetterorganisation (WMO) in Genf seit 1993 einmal jährlich veröffentlicht, lagen die Globaltemperaturen in den letzten 5 Jahren auch nur zwischen 14,57°C [2014] und 14,83°C [2016]; das Jahr 2018 wurde von der WMO bei 14,68°C ausgewiesen:

Also allesamt unterhalb von 15°C. Besonders eindrucksvoll erwähnte der ZDF-Wetterfrosch Benjamin Stöwe im ZDF-Morgenmagazin am 19.01.2017 den globalen Temperaturwert für das Jahr 2016:

In der „Summary für Policy Makers“ (SPM) des 4. IPCC-Bericht 2007 und auch im wissenschaftlichen IPCC-Langbericht aus dem Jahr 2007 sind die globalen Absoluttemperaturwerte seit 1850 auch abzulesen. Der globale Absoluttemperatur für das Jahr 1850 lag demnach bei ziemlich genau 13,69°C:

Ausschnitt aus: https://www.de-ipcc.de/media/content/IPCC2007-WG1.pdf#page=6 (rote Linien und roter Text von www.klimamanifest.ch nachträglich ergänzt)

Interessant auch: Stefan Rahmstorf bestätigte am 17.03.2019 auf Twitter, dass er einer der Autoren der betreffenden IPCC-Dokumente aus 2007 gewesen sei und er redete sich dann in der Twitter-Diskussion um Kopf-und-Kragen.

Dieser absolute globale Temperatur-Wert von 13,69°C für das Jahr 1850 bzw. als globale Mitteltemperatur für den Zeitraum 1850 – 1990 lässt sich auch über die Seite 6 und die Seite 8 des aktuellen Klimawandel-Langbericht der WMO in Genf für das Jahr 2018 belegen. Recherchieren und rechnen Sie dort mal selbst. Die Zahlen passen, die Zahlen sind konsistent.

Besonders peinlich ist deshalb die Behauptung des Klimafolgenforschers vom PIK in Potsdam, Anders Levermann, der auf die Frage, welcher globale Absoluttemperaturwert denn für das Jahr 1850 bzw. beim Beginn der Industrialisierung ausgewiesen wird, bei der Anhörung am 28.11.2018 im Deutschen Bundestag, anstatt den eigentlich korrekten Wert 13,69°C hätte nennen müssen, aber stattdessen den Wert „15 °C“ nannte, kein Witz, hören Sie selbst:

Soviel zur Kompetenz der Klimafolgenforscher aus Potsdam. Wir hatten schon des Öfteren den Eindruck, dass diese „Experten“ Ihre eigene Wissenschaft nicht kennen, geschweige denn verstanden haben.

Aber vielleicht hat ja Anders Levermann nur genauso „gedacht“, wie dieser Schüler hier, der dieses Bild gemalt hat?:

Erkennen Sie die Parallelen zur Schulbuch-Seite 194?

Erkennen Sie die Parallelen zur Schulbuch-Seite 194?

Bis hierhin ist festzuhalten, dass sowohl in relevanten IPCC-Berichten, als auch in Veröffentlichungen der Weltwetterorganisation (WMO) in Genf die globalen Absoluttemperaturwerte zu finden sind, die dort immer unterhalb von 15°C aus dem natürlichen Treibhauseffekt ausgewiesen worden sind. Unsere Recherchen ergaben bis heute, dass weder der IPCC, noch die WMO seit 1988 bzw. seit 1993 eine absolute globale Mitteltemperatur oberhalb von 15°C ausgewiesen hatten.

Es ist ja auch nicht sehr verwunderlich, weil die Erde seit dem Ende der „Kleinen Zeit“ (ca. um 1850) das damals niedrige globale Temperaturniveau bis heute „versucht“, wieder aufzuholen, aber dabei immer unterhalb von global 15°C geblieben ist. Die TAGESSCHAU.DE-Grafik vom 27.12.2013 weist zeitlich nach der „Kleinen Eiszeit“ eine Globale Mitteltemperatur oberhalb von 15°C aus, was aber bekanntlich – gemäss WMO in Genf – nicht korrekt ist. Die folgende, von uns selbst erstellte Animation korrigiert den „Fehler“ in der Grafik, denn die Grafik ist ansonsten korrekt:

Ergänzende und richtigstellende und von klimamanifest.ch-erstellte Animation über eine Grafik von TAGESSCHAU.DE vom 27.12.2013 über die Globale Mitteltemperatur nach der „Kleinen Eiszeit“.

Schauen Sie auch unser ergänzendes Aufklärungsvideo in dem #SagsMirInsGesicht-Gespräch mit Kai Gniffke, wie der für die obige TAGESSCHAU.DE-Grafik verantwortliche ARD-Meteorologe Tim Staeger die Grafik in Zukunft „geändert“ hatte, damit die Temperatur-Diskrepanz nicht mehr auffällt, im Video wird es erklärt ab Minute 1:03:25:

Auch in TV-Berichten der öffentlich-rechtlichen Sender sind in den letzten Jahren vereinzelt in Grafiken diese korrekten globalen Absoluttemperaturwerte unterhalb von 15°C ausgewiesen worden, z.B. in der 20-Uhr-TAGESSCHAU am 07.12.2009:

Screenshot aus TAGESSCHAU (DAS ERSTE) vom 07.12.2009 (gelbe Linie ergänzt durch www.klimamanifest.ch)

SRF „TAGESSCHAU“ am 07.12.2009:

Screenshot aus SF1 „TAGESSCHAU“ am 07.12.2009 (Hinweis: Der Schreibfehler „IPPC“ ist so in der Original SF1-Sendung enthalten gewesen)

ZDF „HEUTE-JOURNAL“ vom 06.12.2009:

Und auch noch im RBB am 11.10.2017 in einem Filmbericht über „25 Jahre PIK POTSDAM„, kein Witz:

So, nun setzen Sie diese obigen Screenshots mit der Behauptung in Beziehung, die am 08.12.2009 in der WDR-Sendung „QUARKS & Co“ bei Erklärung des angeblich „natürlichen Treibhauseffektes und im Beisein von Stefan Rahmstorf (PIK POTSDAM) gefallen ist:

Screenshot aus WDR „QUARKS & Co“ vom 08.12.2009. Der Text „15°C, jetzt ist die Erde perfekt“ als Schriftzug nachträgllich ergänzt, denn der Text wurde am 08.12.2009 in der WDR-Sendung nur von der Offstimme gesprochen.

Und es gibt ja neben diesem noch mehr einschlägige Zitate in dem obigen Plöger-Video, z.B. dieser folgende O-Ton von Harald Lesch vom 17.04.2016, den wir im obigen Nachtrags-Video ebenfalls eingebunden haben:

…und auch sogar die NASA (!) weist auf ihren Webseiten die 15°C als Wert aus dem natürlichen Treibhauseffekt (=greenhouse-effect) aus:

Quelle: https://climate.nasa.gov/faq/19/what-is-the-greenhouse-effect/ (Abruf: 22.04.2019, 22:00 MESZ) (rot-Markierung durch www.klimamanifest.ch ergänzt)

und hier:

Quelle: https://climate.nasa.gov/causes/ Abruf: 22.04.2019, 22:15 MESZ (rot-Markierung durch www.klimamanifest.ch ergänzt)

…und auch sogar die WMO (!) in Genf weist auf ihrer Webseite rechnerisch die 15°C als Wert aus dem natürlichen Treibhauseffekt (=greenhouse-effect) aus, denn :

Quelle: https://public.wmo.int/en/our-mandate/focus-areas/environment/greenhouse%20gases (Abruf: 22.04.2019, 22:22) (rot-Markierung durch www.klimamanifest.ch ergänzt)

und sogar auch bei Svante Arrhenius werden die „15°C“ als „mittlere absolute Temperatur der Erdoberfläche“ ausgewiesen:

…und es gibt noch viel, viel mehr O-Töne, Grafiken und Zitate, die eindeutig die 15°C als „Normal-Temperatur“ ausweisen, auch wenn es nur sehr selten so deutlich mit den „15°C“ formuliert wird, wie im Buch von Mojib Latif aus dem Jahr 2003:

…und es gibt noch viel, viel mehr O-Töne, Grafiken und Zitate, die eindeutig die 15°C als „Normal-Temperatur“ ausweisen, auch wenn es nur sehr selten so deutlich mit den „15°C“ formuliert wird, wie im Buch von Mojib Latif aus dem Jahr 2003:

Oder auch in dem Buch „Eiskeller oder Treibhaus“ von dem Ende der 1980er-Jahren sehr bekannten Wissenschafts-Journalisten Heinz Haber werden die „15°C“ als „Normaler Mittelwert“ bezeichnet:

Oder auch in dem Buch „Eiskeller oder Treibhaus“ von dem Ende der 1980er-Jahren sehr bekannten Wissenschafts-Journalisten Heinz Haber werden die „15°C“ als „Normaler Mittelwert“ bezeichnet:

Insofern steht auf der Klett-Geographie-Schulbuchseite 194 und auch vielen anderen deutschen Schulbüchern nix Falsches, sondern nur genau DAS, womit die offizielle Klima(folgen)forschung seit über 30 Jahren die Gefährlichkeit der globalen Erderwärmung begründet. Insofern weicht auch der bekannte Schweizer Klimaforscher Thomas Stocker dieser argumentativen Tatsache aus und sagte am 02.09.2018 gegenüber dem Schweizer Fernsehen (SRF) ausweichend:

Insofern steht auf der Klett-Geographie-Schulbuchseite 194 und auch vielen anderen deutschen Schulbüchern nix Falsches, sondern nur genau DAS, womit die offizielle Klima(folgen)forschung seit über 30 Jahren die Gefährlichkeit der globalen Erderwärmung begründet. Insofern weicht auch der bekannte Schweizer Klimaforscher Thomas Stocker dieser argumentativen Tatsache aus und sagte am 02.09.2018 gegenüber dem Schweizer Fernsehen (SRF) ausweichend:

Schulbücher sind nicht geeignet, um eine wissenschaftliche Debatte zu führen.

Merkwürdig, Herr Stocker, denn – wie gesagt – in Schulbücher steht nur genau die gleiche relevante Argumentation der offiziellen Klima(folgen)forschung, mit der auch seit Jahren die Gefährlichkeit der Erderwärmung begründet wurde und bis heute wird. Und ein Thomas Stocker ist bis heute nicht in der Lage, den angeblichen Treibhauseffekt logisch-konsistent zu erklären, was wir bereits vor Jahren in einem Video als „Unbequeme Wahrheit #3“ thematisiert haben. In dem Video werden Sie auch darüber informiert, dass auch der IPCC ab dem 3. IPCC-Bericht 2001 bei den Temperaturwerten beim angeblichen Treibhauseffekt (greenhouse-effect“) ebenfalls „getrickst“ hatte:

Wichtiger Recherche-Tipp zu Thomas Stocker: „Der Schweizer Klimaforscher Thomas Stocker beantwortet Fragen seiner Kritiker !!„

Obwohl im aktuell 5. wissenschaftlichen IPCC-Bericht 2013/2014 der Ausweis von Absoluttemperaturwerten aus dem sog. „Greenhouse-effect“ (=Treibhauseffekt) komplett verschwunden ist, findet sich doch im Glossar des IPCC-Berichts 2013/2014 beim Thema „Energy budget of the Earth“ auf Seite 1453 – also ganz weit hinten – ein interessanter Satz, der die „15°C“ als argumentativ-wichtig weiterhin belegt:

Screenshot von Seite 1453 vom 5. IPCC-Bericht 2013/2014 (https://www.ipcc.ch/site/assets/uploads/2018/02/WG1AR5_all_final.pdf#page=1469) gelb-rot-Markierung durch www.klimamanifest.ch

Denn mit dieser wichtigen 15°C-Argumentation zum Beleg eines natürlichen Treibhauseffektes argumentiert auch der Deutsche Wetterdienst (DWD) z.B. auf Twitter:

— DWD Klima und Umwelt (@DWD_klima) 2. April 2019

Und in dem dort verlinkten Blogtext von „Welt der Physik“ der deutschen physikalischen Gesellschaft (DPG) findet sich diese anschauliche Grafik:

Und Sie kennen dort in der Grafik erkennen, dass die „15°C“ (siehe Temperaturwertanzeige rechts auf der Erdoberfläche) als Erdbodenabstrahlung an den „390 W/m²“ (aus dem Stefan-Boltzmann-Gesetz) gekoppelt sind und diese Grafiken mit den argumentativ „390 W/m²“ Erdbodenabstrahlung finden sich auch in den IPCC-Berichten von 1995 bis 2007. Deshalb kann/darf man den Wert aus dem Treibhauseffekt von 15°C nicht einfach auf 14°C heruntersetzen – wie das Sven Plöger am 11.04.2019 in der WDR-Live-Sendung aber gemacht hatte. Denn dann ist die gesamte Treibhauseffekt-Argumentation nicht mehr stimmig und nicht mehr konsistent.

Logisch nachvollziehbar wird unsere Argumentation auf Basis der 15°C, um die Temperaturbasis für die Gefährlichkeit einer Erderwärmung zu definieren, ja auch noch zusätzlich, wenn Sie sich die 23-Seitige Recherche-Dokumentation über Publikationen anschauen, wo seit Jahren ein globaler Absoluttemperaturwert oberhalb von 15°C ausgewiesen worden ist:

Und sehr wichtig:

Und sehr wichtig:

Und kein „Geringerer“ als Stefan Rahmstorf vom PIK in Potsdam hat im Februar 2018 unsere drei wichtigen Prämissen mit unserer logischen Schlussfolgerung unwidersprochen bestätigen müssen (.pdf):

Stefan Rahmstorf hat in seinem Blogtext im Februar 2018 versucht unsere Recherche zur globalen Absoluttemperatur als angebliches „Verwirrspiel“ zu diskreditieren, was ihm aber nicht gelungen ist, weil wir all seine Argumente in unserem Blogtext entkräftet und widerlegt haben. Nicht zuletzt die bereits erwähnte 23-seitige Recherche über globale Absoluttemperaturen belegt, dass Rahmstorf und die gesamte Klima(folgen)forschung selbst die Urheber und die Verantwortlichen für das angebliche „Verwirrspiel“ sind, denn mindestens diese Klima(folgen)forscher mit Namen Schönwiese, Graßl, Latif, Crutzen, Hennicke, Hansen, Schellnhuber, Kromp-Kolb haben selbst in den letzten 30 Jahren bei der globalen Absoluttemperatur nachweislich „Verwirrung“ gestiftet, in dem sie nachweislich in ihren Publikationen globale Absoluttemperaturen oberhalb von 15°C ausgewiesen haben.

Stefan Rahmstorf hat in seinem Blogtext im Februar 2018 versucht unsere Recherche zur globalen Absoluttemperatur als angebliches „Verwirrspiel“ zu diskreditieren, was ihm aber nicht gelungen ist, weil wir all seine Argumente in unserem Blogtext entkräftet und widerlegt haben. Nicht zuletzt die bereits erwähnte 23-seitige Recherche über globale Absoluttemperaturen belegt, dass Rahmstorf und die gesamte Klima(folgen)forschung selbst die Urheber und die Verantwortlichen für das angebliche „Verwirrspiel“ sind, denn mindestens diese Klima(folgen)forscher mit Namen Schönwiese, Graßl, Latif, Crutzen, Hennicke, Hansen, Schellnhuber, Kromp-Kolb haben selbst in den letzten 30 Jahren bei der globalen Absoluttemperatur nachweislich „Verwirrung“ gestiftet, in dem sie nachweislich in ihren Publikationen globale Absoluttemperaturen oberhalb von 15°C ausgewiesen haben.

Denn auch ein Stefan Rahmstorf hat ein „Problem“:

Unsere Argumentation steht de facto auch auf drei Seiten in seinem Buch „DER KLIMAWANDEL“, was das folgende 5-minütige Video dokumentiert:

Und auch im aktuellen Referenten-Entwurf aus Februar 2019 für das geplante Bundes-Klimaschutzgesetz (KSG) steht unter § 1 Zweck des Gesetzes ein Hinweis auf die „globale Durchschnittstemperatur„:

Auszug aus Referentenentwurf zum Bundesklimaschutzgesetz (Februar 2019) (Rot-Markierungen durch www.klimamanifest.ch)

Und nun zurück zur WDR-Sendung „Ihre Meinung“ vom 11.04.2019 mit Sven Plöger:

Bettina Böttinger wurde in unserer Mail vom 28.03.2019 bekanntlich gebeten, sie möge sich bitte – als intelligente Journalistin – mit dem Inhalt auf dieser Schulbuchseite 194 logisch auseinandersetzen und womöglich – so hatten wir erhofft und vielleicht auch erwartet – wird sie sich dann bei uns melden. Aber es kam kein Anruf, stattdessen setzte Sven Plöger in der Sendung „Ihre Meinung“ am 11.04.2019 den globalen Temperaturwert aus dem natürlichen Treibhauseffekt von 15°C auf 14°C herunter:

Das kann man dann schon als kriminell bezeichnen, was Sven Plöger am 11.04.2019 gemacht hat. Auf Sven Plöger passen deshalb auch die drei Bezeichnungen: Gauner, Schwindler, Scharlatan !! (wie auch für Harald Lesch)

Das kann man dann schon als kriminell bezeichnen, was Sven Plöger am 11.04.2019 gemacht hat. Auf Sven Plöger passen deshalb auch die drei Bezeichnungen: Gauner, Schwindler, Scharlatan !! (wie auch für Harald Lesch)

…und mit dem folgenden Flyer täuschen auch die #Scientists4Future, zu denen auch Sven Plöger mit Listeneintrag gehört, also die 23.000 (angeblichen) Wissenschaftler, auf die wir in diesem Blogtext auch später noch zu sprechen kommen:

Diese #Scientists4Future verschweigen

Diese #Scientists4Future verschweigen

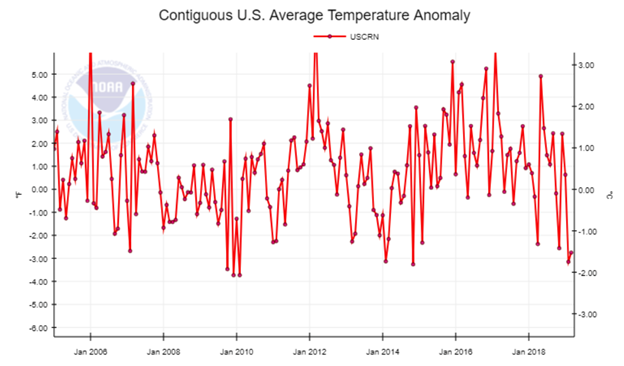

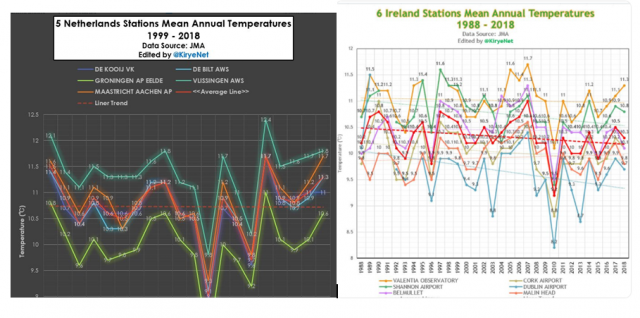

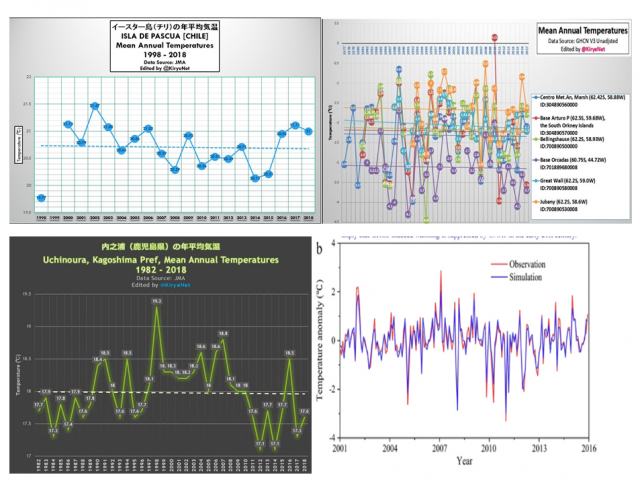

1., dass sich die Globaltemperatur in den letzten 2 Jahren (2017 und 2018) wieder gesenkt hatte

und

2., der Wert aus dem „natürlichen Treibhauseffekt“ von 15°C gar nicht überschritten worden ist

und

3., die NASA mit James Hansen Ende der 1980er-Jahren nachweislich höhere globale Absoluttemperaturwerte (+15,4°C) ausgewiesen hatte, über die u.a. auch der SPIEGEL damals berichtet hatte.

Die weiteren vier stichhaltigen Argumente, die den Vorsatz von Sven Plöger belegen,

2. Treibhauseffekt-Zitate in Büchern von Sven Plöger (2009 bis 2013)

3. Maildiskussion in 2014 mit Frank Böttcher (Co-Autor von Sven Plöger)

4. Diverse Beschwerdeverfahren beim WDR seit 2013 bis 2016

5. Telefonat vom 09.06.2017 mit WDR-Journalistin Charlotte Gnändiger

können Sie per Klick auf www.klimamanifest.ch recherchieren.