Klimawandel : Wissenschaftliches Mobbing

Es ist das klassische Schema eines Westerns. Auf der einen Seite steht der Held. Er ist jung und aufrecht, ein Mann der Zukunft. Er heisst Reto Knutti, ist 45 Jahre alt, lehrt an der ETH Zürich Klimawissenschaften und wirkt seit 2001 als «bedeutendes Mitglied» (Wikipedia) beim Uno-Weltklimarat (IPCC) mit. Doch Knutti ist immer wieder Ziel perfider Attacken obskurer Mächte. Den Part des Bösewichts spielt Markus Häring. Er ist alt (67), arbeitete einst im Dienst der Erdölfirma Shell, ist Kolumnist bei der Basler Zeitung – und er zweifelt am menschengemachten Klimawandel.

Ein richtiger Western endet mit einem Showdown, bei dem der Gute natürlich obsiegt. So weit liess es die NZZ am Sonntag allerdings nicht kommen, die den Kampf des edlen Knutti und des düsteren Häring in der Ausgabe vom 10. März auf der Titelseite ankündigte («Klimaleugner diffamieren Wissenschaftler») und danach auf drei Seiten («Im Netz der Klimaleugner») breitwalzte. Denn mit den Skeptikern, so das Fazit des Blattes, sollte man eigentlich nicht einmal streiten. Sie wissen bestenfalls nicht, was sie sagen. Der menschengemachte Klimawandel ist eine wissenschaftlich erhärtete Tatsache, ein Faktum. Wer daran zweifelt, ist entweder ein Ignorant, oder er verfolgt unlautere Ziele.

Rat der Wissenden

Mit der Realität haben der NZZ-Western und seine zur Karikatur überzeichneten Antagonisten Reto Knutti und Markus Häring herzlich wenig zu tun. Doch das Muster, welches das Zürcher Intelligenzblatt hemmungslos bespielt, scheint sich in den akademischen Sphären global durchzusetzen: Die Klimaforschung ist nicht ein Ringen um das bessere Argument, sondern ein Kampf zwischen Wissenden und Dumpfbacken, Fortschrittlichen und Ewiggestrigen, Menschenfreunden und Menschenfeinden (siehe «Top Five der Klimaleugner», Seite 18). Denn beim Klima, das predigt auch das Bundesamt für Energie (BfE) in Bern seit Jahren, gibt es keine Meinungen, nur Fakten und Lügen. Es herrsche ein «97-Prozent-Konsens» (s. Seite 23), der vom Uno-Weltklimarat periodisch neu justiert wird. Und wer die vom Rat der Wissenden amtlich angeordneten Wahrheiten in Frage stellt oder gar ablehnt, ist ein Leugner, ein Feind der Wissenschaft.

Tatsächlich wurde der Treibhauseffekt, der unter anderem dem CO2 zu verdanken ist und ohne den die Welt eine unbewohnbare Eiswüste wäre, vor über hundert Jahren entdeckt. Es ist auch nicht neu, dass die Gletscher seit der Mitte des 19. Jahrhunderts, dem Ende der sogenannten Kleinen Eiszeit, am Schrumpfen sind. Margaret Thatcher warnte bereits in den 1980er Jahren – unter anderem in einer Rede vor den Vereinten Nationen – eindringlich vor dem CO2-Problem. Für die britische Premierministerin war es ein willkommenes Argument im Kampf gegen die Kohlegewerkschaften und für die Kernenergie.

Umweltaktivisten setzten damals allerdings auf das Waldsterben. Erst als das prognostizierte Ende des Baumes Anfang der 1990er Jahre stillschweigend abgesagt wurde, holte man das Klima wieder aufs Tapet. Im Rampenlicht der Weltöffentlichkeit stand nun plötzlich eine wissenschaftliche Randgruppe, die bis dahin ein stiefmütterliches Dasein gefristet hatte. Atmosphärenphysiker, Historiker, Ozeanologen und Glaziologen wurden über Nacht zu Medienstars.

Besonders gefragt waren nach dem journalistischen Grundgesetz natürlich jene, die möglichst düstere Weissagungen machten. Sie erhielten auch die meisten Forschungsgelder. Nur sind Prognosen bei einem derart komplexen Thema eine vertrackte Angelegenheit.

Erde wird immer grüner

Das Klima war immer Wandlungen unterworfen. Man weiss, dass es schon viel kälter war als heute, etwa während der Eiszeiten, oder auch wärmer, etwa im frühen Mittelalter. Über die Gründe – Sonnenaktivität, kosmische Strahlung, Verschiebung der Erdachse, Vulkane, Meteoriten – gibt es viele Thesen, aber nichts Gesichertes. Das ist bis heute so. Doch wie will man das Kommende voraussagen, wenn man nicht einmal das Geschehene richtig versteht?

Dass Treibhausgase wie das CO2 eine Rolle spielen, ist schon lange bekannt. Viel wichtiger für den Treibhauseffekt ist allerdings unbestrittenermassen der Wasserdampf. Hier wird es aber richtig kompliziert. Je nach Höhenlage, Konzentration und Aggregatzustand kann Wasser in der Atmosphäre die Temperatur auf der Erde erhöhen oder auch senken. Meere reagieren anders als Landflächen. Es gibt natürliche Puffer. CO2 wirkt wie ein Dünger auf Pflanzen und fördert das Wachstum; unser Planet wird immer grüner, wie die jüngsten Satellitenkarten der Nasa zeigen. CO2-Fresser sind auch die Abermilliarden von Einzellern in den Ozeanen, die das Kohlendioxid in Kalkablagerungen umwandeln und effizient aus dem Kreislauf entfernen.

Die Klimafrage löste seit der Jahrtausendwende einen veritablen Hype in den Wissenschaften aus. Wer die «Verbreitung der Pharaonenameise in Hinterindien» erforschen will, erhält kaum Geld; setzt man jedoch den Titel «Verbreitung der Pharaonenameise in Hinterindien unter dem Einfluss des Klimawandels», sieht das schon viel besser aus. Der Klimawandel durchdrang nun plötzlich alle möglichen Forschungsbereiche. Und natürlich durfte kein Forscher zum Schluss kommen, dass ein Grad mehr oder weniger Durchschnittstemperatur in seinem Fall keine Rolle spielt. Er würde damit ja seine eigenen Forschungsgelder kappen.

Wirklich neu sind die computergestützten Klimamodelle, auf die sich der IPCC bei seinen Prognosen beruft. Die Universität Bern spielte in dieser Disziplin eine Pionierrolle. Der Berner Professor Hans Oeschger (1927–1998) war ein international anerkannter Vorreiter der Klimaforschung. Das 2007 gegründete und nach ihm benannte Oeschger Centre for Climate Change Research (OCCR) gilt als Mekka der Klimaprognostiker. Eine Leitfigur auf diesem Gebiet ist der Berner Klimaforscher Thomas Stocker, der seit 1998 auch eine zentrale Rolle beim IPCC spielt. Das Gleiche gilt für seinen akademischen Ziehsohn Reto Knutti. Er wirkt an der ETH Zürich und arbeitet dort an Klimamodellen.

Klima-Code geknackt?

Nun haben Wissenschaftler seit den mittelalterlichen Alchemisten immer wieder versucht, den Code des Universums zu knacken. Karl Marx glaubte, die Gesetzmässigkeiten des menschlichen Lebens durchschaut zu haben und rational steuern zu können. Millionen von Menschen bezahlten seine wissenschaftlichen Visionen mit dem Leben; der Umbau der Gesellschaft nach Marx’ Rezepten mündete regelmässig in humanitäre Katastrophen (was viele seiner Anhänger allerdings bis heute nicht beeindruckt). Legionen von grandios gescheiterten Börsengurus, Planern und Politologen glaubten schon, die Zukunft wissenschaftlich vorauszusehen. Misst man die Weissagungen am Resultat, bleibt bestenfalls erheiternde Ernüchterung.

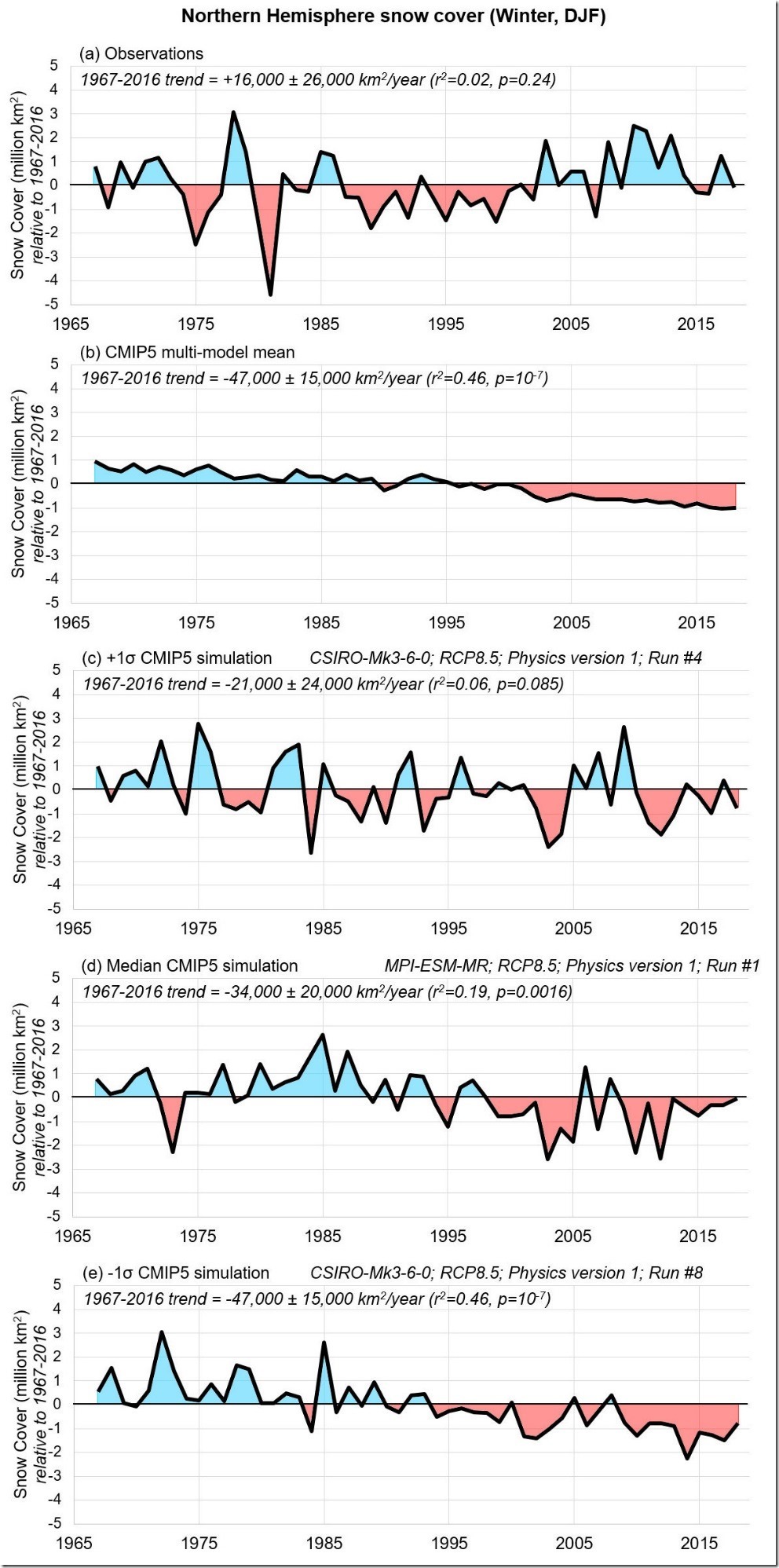

Ist beim Klima etwa alles anders? Hat der IPCC den geheimen Code geknackt? Damit die Modellrechnungen überhaupt möglich sind, beschränkt man sich im Wesentlichen auf das CO2. Die meisten anderen möglichen Faktoren werden ausgeblendet. Das führt zwar zu alarmierenden Resultaten. Ob diese auch mit der Realität übereinstimmen, hängt aber von den Prämissen ab, auf die man die Modelle stützt. Und diese sind mit zahllosen Unwägbarkeiten behaftet.

So funktioniert halt die Wissenschaft, mag man einwenden, nach dem Prinzip von Versuch und Irrtum. Und das wäre auch nicht weiter tragisch, wenn Fehler zugelassen und akzeptiert würden. Doch die Klimamodelle von Stocker und Knutti schliessen jeden Irrtum aus. Aus ihrer Sicht sind die Modelle keine Hypothesen, wie sie bei jeder Gelegenheit betonen, sondern Fakten, «gesicherte wissenschaftliche Erkenntnisse».

Die Klimaforschung ist ein ungemein facettenreiches und faszinierendes Feld. Fatalerweise ist die Wissenschaft unter dem Schirm der Uno mit der Politik zu einem amalgamartigen Komplex verschmolzen. Welchen Anteil an der Klima-Erwärmung man dem Menschen zuordnet, ob man die Folgen mehr oder weniger dramatisch einstuft, ist nicht eine Frage des Abwägens von Wahrscheinlichkeiten, von Thesen und Antithesen, Rede und Gegenrede, sondern primär eine Frage politischer, wirtschaftlicher und ideologischer Interessen.

Erbsenzähler und Modellbauer

Die Weltwoche konnte mit einem Studenten reden, der sowohl in Bern wie auch an der ETH Zürich im Bereich der Klimawissenschaften studiert hat. An beiden Hochschulen gebe es, so sagt er, unter den Dozenten «Erbsenzähler» und «Modellbauer». Als «Erbsenzähler» bezeichnet er jene, die anhand von konkreten Daten – etwa Jahrringen in Bäumen, Eiskernen, historischen Quellen und Messungen aller Art – Entwicklungen des Klimas zu rekonstruieren versuchten. Die Resultate stünden bisweilen in einem eklatanten Widerspruch zu den Modellen des IPCC. Doch das werde kaum offen thematisiert. Denn die Deutungshoheit liege bei den «Modellbauern», die kaum Feldforschung betreiben und im Wesentlichen über ihren Computern brüten.

Widerrede sei bei den «Modellbauern» verpönt. Wer grundsätzliche Zweifel anmelde, werde isoliert. Beim OCCR in Bern trage die «unité de doctrine» geradezu sektenhafte Züge. Eigenständiges Denken sei nicht gefragt, die wissenschaftliche Arbeit erschöpfe sich in der Regel im Zitieren bestimmter Autoren. Bei der ETH in Zürich, wo offener diskutiert werde, sei es eher eine Frage des Lifestyles. Vegan, bio oder solar gelten als coole Attribute, die CO2-Steuer als Mittel des sozialen Ausgleichs, die Klimawissenschaften als Mittel für den guten Zweck.

Das eingangs erwähnte, von der NZZ am Sonntag herbei fabulierte Westerndrama zwischen Reto Knutti und Markus Häring passt perfekt in dieses Schema. Nur ist der Basler Geologe nicht der gelangweilte Pensionär, als der er karikiert wird, «einer von Unzähligen, die Meinungsartikel und Bücher schreiben». Er gehört vielmehr zu den Pionieren der Umweltforschung in der Schweiz.

Nach seinem Studium der Geologie (Physik im Nebenfach) und seinem Doktorat (über Sedimente im Meer) war Markus Häring ein Jahrzehnt lang für den Erdölriesen Shell im Amazonas, in Australien, auf der Nordsee und in Nigeria als Feldforscher tätig. 1991 kam er – auch aus umweltschützerischen Überlegungen – in die Schweiz zurück, um sein Wissen über Tiefenbohrungen im Bereich der Erdsonden zu nutzen. Er zog mehrere Projekte erfolgreich durch und wurde deshalb zu einem gefragten Fachexperten beim Bundesamt für Energie in Sachen Geothermie.

Preis für die ernüchternde Erkenntnis

1999 wurde Häring mit der Planung und der Leitung eines 60 Millionen Franken teuren Geothermie-Versuchsprojektes bei Basel betraut. Es gelang, in eine Rekordtiefe von 5009 Metern zu bohren. Das Einpumpen von Wasser unter hohem Druck zur grossräumigen Auflockerung des Untergrundes – anders ist die nur langsam nachfliessende Wärme aus der Tiefe nicht zu gewinnen – löste ein leichtes Erdbeben (3,4 Grad auf der Richterskala) aus. Das Projekt wurde abgebrochen. Doch die 60 Millionen waren nicht verloren. Es war der Preis für die Erkenntnis, dass in der Schweiz die Stromproduktion aus Geothermie auf absehbare Zeit keine Option ist, auch weil die Energiedichte schlicht und einfach zu gering ist.

Häring arbeitete denn auch weiter für das BfE. Während Jahren erforschte er im Auftrag des Bundes die unterirdische Einlagerung der CO2-Emissionen von Gaskraftwerken, die man als Ersatz der Kernenergie in Erwägung zieht. Häring gelangte 2015 zum Schluss, dass die unterirdische Einlagerung von CO2 in der Schweiz nicht nur an der Wirtschaftlichkeit scheitert, sondern auch mit Risiken behaftet ist, die in keinem Verhältnis zum Ertrag stehen. Das Resultat widersprach natürlich den politischen Vorgaben. Seither bekam Häring keine Aufträge mehr vom BfE.

Markus Häring mag kein Klimaforscher im engeren Sinne sein. Doch mit der Erdgeschichte, den physikalischen und chemischen Vorgängen und insbesondere mit dem CO2 hat er sich ein Leben lang wissenschaftlich befasst. Er verfügt aber auch über eine praktische Erfahrung im Energiebereich. Anders als jene, die ihn verspotten, ist er nicht nur auf ein Spezialgebiet fokussiert.

Genau das ist es, was Härings faktenreich und nüchtern verfasste Bücher über den «2000-Watt-Irrtum» und den «Sündenbock CO2» von den futuristischen Theorien und Modellen abhebt: Der Autor deckt Schwachstellen bei den Mainstream-Theorien auf und plädiert für eine pragmatische Gesamtschau, die soziale, ökonomische und physikalische Aspekte miteinbezieht. Er ist Mitglied des Carnot-Cournot-Netzwerks, eines Zusammenschlusses von kritischen Wirtschaftsführern, Ökonomen, Ingenieuren und Naturwissenschaftlern, die nach alternativen Ansätzen im Umweltbereich suchen.

Angriff auf die Wissenschaft

Markus Häring hat nie behauptet, im Besitze der allein seligmachenden Wahrheit zu sein. Er verzichtet auch auf persönliche Angriffe gegen die «Modellbauer» der Klimatheorie – was ihm die NZZ am Sonntag implizit unterstellt (ohne dafür einen Beleg zu liefern). Sehr wohl kritisiert und hinterfragt er aber die Klimamodelle des IPCC. Doch Professoren wie Reto Knutti und Thomas Stocker betrachten jeden Einspruch als Angriff auf die Wissenschaft.

Tatsächlich liegt die grösste Bedrohung in genau dieser Geisteshaltung. Denn eine Wissenschaft, die sich selber nicht mehr permanent in Frage stellt und stellen lässt, sondern Hypothesen als ultimative Wahrheiten definiert, Zweifler mit den Mitteln des Mobs lächerlich macht, als Leugner ausgrenzt und kaltstellt, die sich politischen Zielen und Ideologien unterordnet, hat ihre wichtigste Tugend verloren – und damit auch jede Glaubwürdigkeit.

=================================================================

)* Anmerkung der EIKE-Redaktion: Dieser Artikel ist zuerst erschienen in der WELTWOCHE Zürich : Wissenschaftliches Mobbing | Die Weltwoche, Nr. 12 (2019)| 21. März 2019 ; http://www.weltwoche.ch/

EIKE dankt der Redaktion der WELTWOCHE und dem Autor ALEX BAUR für die Gestattung der ungekürzten Übernahme des Beitrages.

=================================================================