Fangen wir mit den Prophezeiungen bzgl. der globalen Erwärmung seitens des IPCC an. Im Jahre 2013 wurden vier Szenarien definiert, von denen eines, nämlich RCP 8.5, von dessen Autoren (Riahi et al, 2007; Rao & Riahi, 2006) selbst als absichtlich extrem gehaltenes Szenario eingestuft worden ist. Es basiert auf so absurden Kriterien der Bevölkerungsentwicklung und des Energieverbrauchs, dass es getrost ignoriert werden kann.

Für das weniger unvernünftige, am oberen Ende der plausiblen Szenarien liegende RCP 6.0 soll der gesamt-anthropogene Antrieb im 21. Jahrhundert 3,8 Watt pro Quadratmeter betragen (2000 bis 2100):

Die CO2-Konzentration von 370 ppmv im Jahre 2000 sollte den Prophezeiungen zufolge beim RCP 6.0-Szenario bis zum Jahr 2100 auf 700 ppmv steigen (AR 5, Abb. 8.5). Folglich wäre der hundertjährige prophezeite CO2-Antrieb 4,83 ln(700/370) oder 3,1 W/m², also fast fünf Sechstel des Gesamtantriebs. Die prophezeite hundertjährige Referenz-Sensitivität (d. h. Erwärmung vor Rückkopplungen) ist das Produkt von 3,8 W/m² und des Planck-Parameters von 0,3 K/Wm², also 1,15 K.

Die CMIP5-Modelle prophezeien eine mittelfristige Gleichgewichts-Sensitivität bei einer CO2-Verdoppelung von 3,37 K (Andrews+ 2012) im Vergleich zu einer Referenz-Sensitivität von 1 K vor Berücksichtigung von Rückkopplungen, was eine mittelbreite Transfer-Funktion [a midrange transfer function] von 3,37/1 = 3,37 impliziert. Die Transfer-Funktion, also das Verhältnis von Gleichgewichts- und Referenz-Temperatur, umfasst definitionsgemäß die gesamte Auswirkung von Rückkopplungen auf das Klima.

Daher beträgt die Erwärmung im 21. Jahrhundert, welche das IPCC prophezeien sollte, beim RCP 6.0-Szenario und auf der Grundlage der eigenen Schätzung der CO2-Konzentration sowie der Modell-Schätzungen des CO2-Antriebs und der Charney-Sensitivität 3,37 x 1,15 oder 3,9 K.

Tatsächlich aber prophezeit das IPCC nur eine Erwärmung von 1,4 bis 3,1 K im 21.Jahrhundert unter dem RCP 6.0-Szenario. Das ergibt eine mittelfristige Schätzung von gerade mal 2,2 K und impliziert eine Transfer-Funktion von 2,2/1,15 = 1,9. Das ist etwas höher als die Hälfte der mittelbreiten Transfer-Funktion von 3,37, welche implizit in den Projektionen der Gleichgewichts-Sensitivität im CMIP5-Ensemble enthalten ist.

Man beachte, dass in Abb. 2 jeder Hinweis darauf fehlt, dass die globale Erwärmung „settled science“ ist. Das IPCC prophezeit mit allen Szenarien und der Absicherung seiner Angaben eine Temperaturänderung zwischen -0,2 K und +4,5 K bis zum Jahr 2100. Dessen Best Estimate ist die mittelbreite Schätzung von 2,2 K.

Im Endeffekt impliziert also bei einer gegebenen Referenz-Sensitivität von 1 K bei einer CO2-Verdoppelung die dem IPCC zufolge zu erwartende Erwärmung im 21. Jahrhundert eine Charney-Sensitivität von 1,9 K. Das ist das Standardmaß für Studien zur Klimasensitivität, welche die Gleichgewichts-Sensitivität bei CO2-Verdoppelung ist, nach Einwirkung aller kurzfristig agierenden Rückkopplungen. Es sind nicht die 3,4 (2,1; 4,7) K der CMIP5-Modelle.

Da die offiziellen Prognosen also folglich untereinander erheblich inkonsistent sind, ist es schwierig, aus ihnen einen Eckwert abzuleiten für die offiziell prophezeite Erwärmung für das 21. Jahrhundert. Er liegt irgendwo zwischen den 2,2 K, die das IPCC aufgrund seiner RCP 6.0-Schätzung gibt, und den 3,9 K, abgeleitet aus dem anthropogenen Antrieb im 21. Jahrhundert mittels der mittelbreiten CMIP5-Transfer-Funktion.

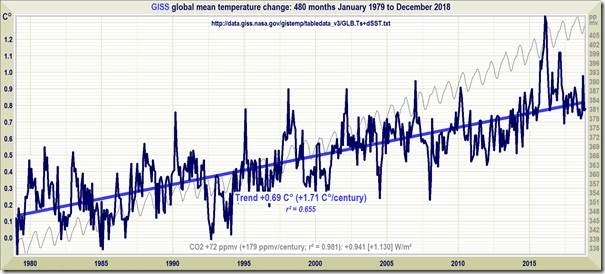

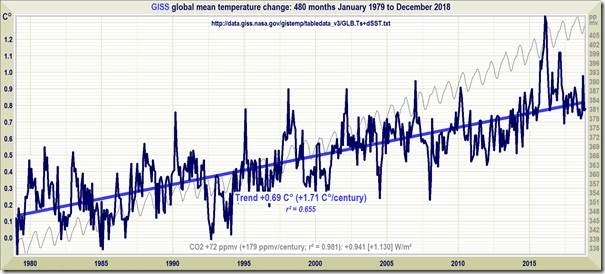

So viel zu den Prophezeiungen. Aber was geht in Wirklichkeit vor sich, und passt die beobachtete Erwärmung zur Prophezeiung? Hier folgen die gemessenen Erwärmungsraten während der 40 Jahre von 1979 bis 2018. Fangen wir mit GISS an. Dort zeigt sich, dass sich die Welt während der 40 Jahre mit einer Rate erwärmt hat äquivalent nicht zu 3,9°C/Jahrhundert, nicht einmal zu 2,2°C/Jahrhundert, sondern lediglich zu 1,7°C/Jahrhundert:

Als nächstes zum NCEI: Dieser Datensatz – vielleicht aus politischen Gründen – ist plötzlich nicht mehr verfügbar:

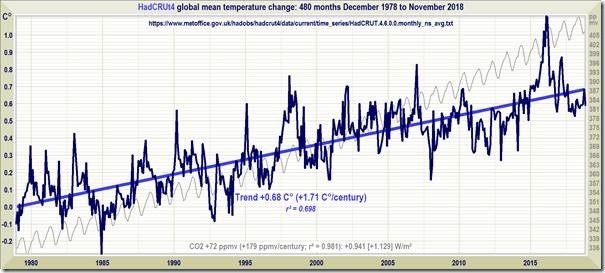

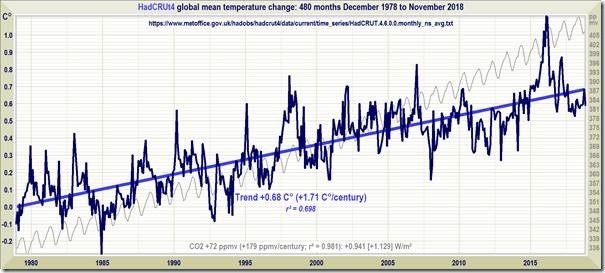

Als nächstes der vom IPCC bevorzugte Datensatz vom HadCRUT4. Die University of East Anglia ist ziemlich betulich hinsichtlich der Aktualisierung seiner Informationen, läuft doch der 40-Jahre-Zeitraum dort von Dezember 1978 bis November 2018. Die Erwärmung ist aber mit derjenigen vom GISS identisch mit 1,7°C/Jahrhundert:

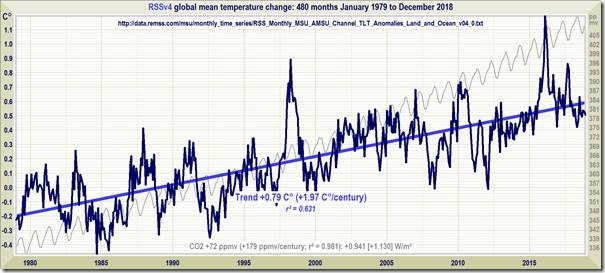

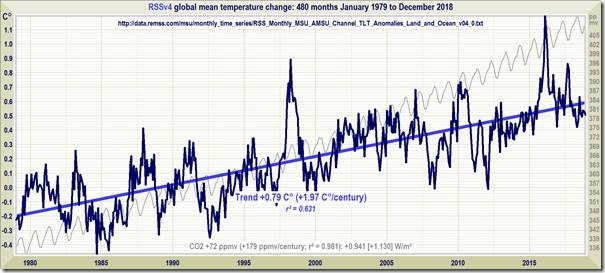

Als nächstes die von Satelliten gemessenen Trends, zuerst RSS. Es ist bemerkenswert, dass seit der Überarbeitung des RSS-Datensatzes zur Eliminierung des Stillstands dieser Datensatz dazu tendiert, die höchste Rate der globalen Erwärmung zu zeigen, nämlich 2°C/Jahrhundert. Der Chef-Wissenschaftler dort nennt alle, die nicht mit ihm bzgl. Klima übereinstimmen, „Leugner“:

Und schließlich noch UAH. Diesen sieht Prof. Ole Humlum (climate4you.com) als den Goldenen Standard für globale Temperaturaufzeichnungen an. Bevor UAH seinen Datensatz änderte, zeigte dieser gewöhnlich mehr Erwärmung als die anderen. Jetzt zeigt er die geringste Erwärmungsrate, nämlich 1,3°C/Jahrhundert:

Wie viel globale Erwärmung hätte es geben müssen während der 40 Jahre seit Beginn der Satellitenmessungen? Die CO2-Konzentration ist um 72 ppmv gestiegen. Der CO2-Antrieb während dieses Zeitraumes beträgt folglich 0,94 W/m². Dies impliziert einen Gesamt-Antrieb von 0,94 x 6/5 = 1,13 W/m² von allen Quellen. Entsprechend liegt die Referenz-Sensitivität dieses Zeitraumes bei 1,13 x 0,3 oder 0,34 K, und die Gleichgewichts-Sensitivität laut der CMIP5-Transfer-Funktion 3,37 sollte 1,14 K ergeben. Und doch betrug die Erwärmung über diesen Zeitraum 0,8 K (RSS), 0,7 K (GISS & HadCRUT4) oder 0,5 K (UAH) – gibt im Mittel eine Erwärmung von etwa 0,7 K.

Ein realistischeres Bild könnte man zeichnen, wenn man den Beginn der Berechnungen in das Jahr 1950 verlegt, als unser Einfluss erstmals bemerkbar war. Die HadCRUT4-Aufzeichnung sieht so aus:

Der CO2-Antrieb seit 1950 beträgt 4,83 ln(410/310) oder 1,5 W/m². Dies wird zu 1,8 W/m², nachdem man nicht-anthropogene CO2-Antriebe zugelassen hat. Dieser Wert ist konsistent mit dem IPCC (2013, Abb. SPM.5.). Daher beträgt die Referenz-Sensitivität über den Zeitraum 1950 bis 2018 1,8 x 0,3 oder 0,54 K, ist 0,54 x 3,37 = 1,8 K, von denen lediglich 0,8 K eingetreten sind. Zieht man die überarbeitete Transfer-Funktion 1,9, abgeleitet aus der prophezeiten Erwärmung nach dem RCP 6.0 heran, sollte die Erwärmung nach 1950 0,54 x 1,9 = 1,0 K betragen haben.

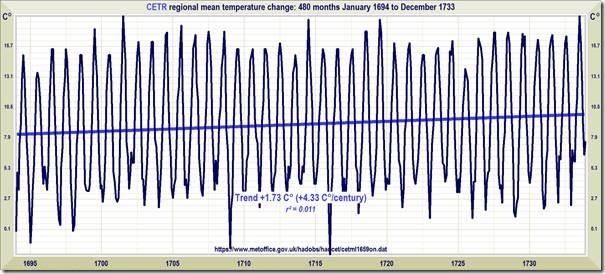

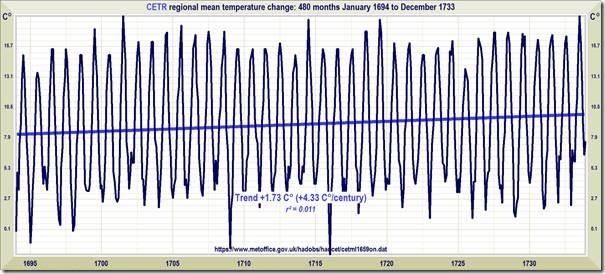

Man sollte hier auch die Temperaturaufzeichnung aus Mittelengland im Zeitraum der 40 Jahre von 1694 bis 1733 betrachten. Während dieses Zeitraumes war die Temperatur in den meisten Gebieten von England mit einer Rate äquivalent zu 4,33°C/Jahrhundert gestiegen im Vergleich zu den lediglich 1,7°C/Jahrhundert während der 40 Jahre von 1979 bis 2018. Daher ist die gegenwärtige Erwärmungsrate keineswegs beispiellos.

Aus dieser Aufzeichnung geht klar hervor, dass selbst die große Temperaturänderung aufgrund natürlicher Ursachen nicht nur in England, sondern weltweit gering ist im Vergleich zu den großen jährlichen Temperaturschwankungen der globalen Temperatur.

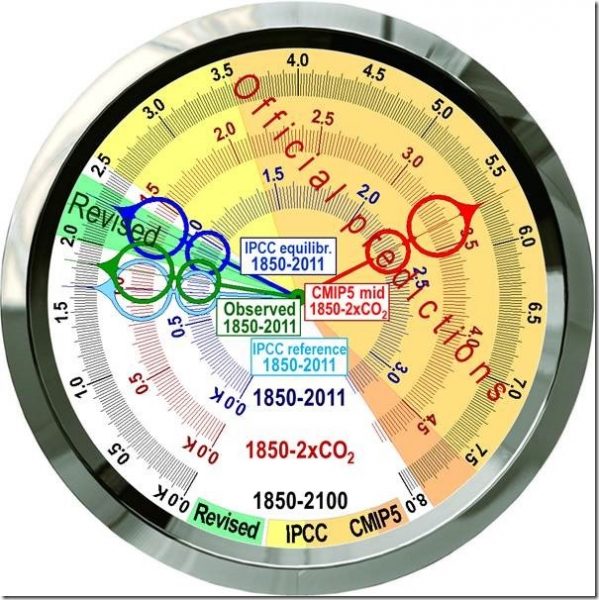

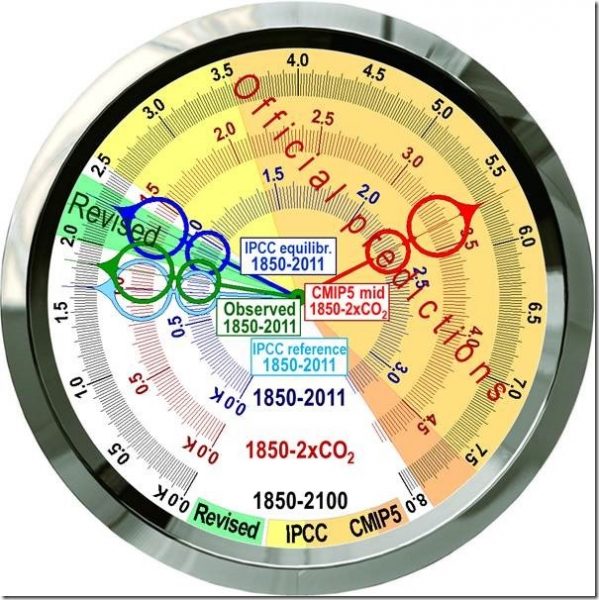

Der einfachste Weg, die sehr große Diskrepanz zwischen prophezeiter und gemessener Erwärmung während der letzten 40 Jahre darzustellen ist es, die Ergebnisse auf einer Scheibe zu zeigen:

Sich überlappende Projektionen des IPCC (gelbe & gelbbraune Zonen) und der CMIP5-Modelle (gelbbraune & orange Bereiche) der globalen Erwärmung von 1850 bis 2011 (dunkelblaue Skala), 1850 bis 2 x CO2 (dunkelrote Skala) und 1850 bis 2100 (schwarze Skala) gehen über die gemessene Erwärmung von 0,75 K im Zeitraum 1850 bis 2011 (HadCRUT4) hinaus. Sie liegt zwischen der Referenz-Sensitivität von 0,7 K bis zum anthropogenen Antrieb in IPCC (2013, Abb. SPM.5) (blaugrüner Zeiger) und der zu erwartenden Gleichgewichts-Sensitivität in diesem Zeitraum von 0,9 K nach Adjustierung des Strahlungs-Ungleichgewichtes (Smith et al. 2015) (blauer Zeiger). Die Projektion der CMIP5-Modelle einer Charney-Sensitivität von 3,4 K (roter Zeiger) liegt etwa drei mal so hoch wie der Wert aus den Beobachtungen. Das überarbeitete Intervall der Prophezeiungen globaler Erwärmung (grüner Bereich) korrigiert um einen physikalischen Fehler in den Modellen, deren Rückkopplungen nicht auf die Emissions-Temperatur reagieren, liegt nahe der beobachteten Erwärmung.

Anmerkungen: Ich verpflichtete mich, über den Fortschritt der Studie meines Teams zu berichten, in welcher der physikalische Fehler der offiziellen Klimatologie betrachtet wird, der darin bestand, die schlichte Tatsache, dass die Sonne scheint, in den Berechnungen der Rückkopplungen nicht zu berücksichtigen. Ursprünglich ist die Studie Anfang vorigen Jahres abgelehnt worden mit der Begründung, dass der Herausgeber des führenden Journals, bei dem sie eingereicht worden war, offenbar niemanden finden konnte, der kompetent genug war, die Studie zu begutachten. Wir vereinfachten die Studie und reichten sie erneut ein, und nach einer Verzögerung von vielen Monaten kamen nur zwei Begutachtungen zurück. Bei der ersten handelte es sich um die Begutachtung eines Begleit-Dokuments, in welchem die Ergebnisse der Experimente beschrieben worden waren, die in einem Labor der Regierung durchgeführt wurden. Es war jedoch klar, dass der Begutachter den Laborbericht nie gelesen hat, worin sich auch die Antwort auf die Frage befand, die der Begutachter gestellt hatte. Die zweite war angeblich eine Begutachtung der Studie, aber der Begutachter gab an, dass er sich nicht die Mühe gemacht habe, die Gleichungen zu lesen, welche jene Schlussfolgerungen gerechtfertigt haben, weil er diese Schlussfolgerungen unlogisch fand.

Wir protestierten. Der Herausgeber holte dann eine dritte Begutachtung ein. Aber das war wie die beiden ersten keine Begutachtung der vorliegenden Studie. Es handelte sich um die Begutachtung einer anderen Studie, welche im Jahr zuvor bei einem anderen Journal eingereicht worden war. Alle in dieser Begutachtung aufgeworfenen Fragen sind schon seit Langem umfassend beantwortet. Keiner dieser drei Begutachter kann also die Studie gelesen haben, die sie angeblich begutachtet hatten.

Nichtsdestotrotz meinte der Herausgeber die Studie ablehnen zu müssen. Als Nächstes kontaktierte uns das Management des Journals des Inhalts, dass man hoffe, wir wären einverstanden mit der Ablehnung, und man lud uns ein, künftig weitere Studien einzureichen. Ich erwiderte, dass wir keineswegs mit der Ablehnung einverstanden waren wegen der offensichtlichen Tatsache, dass keiner der Begutachter die Studie überhaupt gelesen hatte, welche der Herausgeber ablehnte. Wir bestanden daher auf das Recht, die Studie zu veröffentlichen.

Der Herausgeber stimmte zu, die Studie noch einmal zur Begutachtung zu stellen, und wählte diesmal die Begutachter mit größerer Sorgfalt aus. Wir schlugen vor – und der Herausgeber stimmte dem zu – dass wir angesichts der Schwierigkeiten, welche die Begutachter mit dem Verständnis des Punktes hatten, um den es geht und welcher sie eindeutig überraschte, der Studie eine umfassende mathematische Beweisführung hinzufügen, dass die Transfer-Funktion, welche die gesamte Wirkung der Rückkopplungen auf das Klima umfasst, sich nicht nur als das Verhältnis der Gleichgewichts-Sensitivität nach Rückkopplungen und der Referenz-Sensitivität ausdrücken lässt, sondern auch als das Verhältnis der gesamten absoluten Gleichgewichts-Temperatur zur gesamten absoluten Referenz-Temperatur.

Wir sagten, dass wir detaillierter erklären sollten, dass die Gleichung der Klimatologie nicht brauchbar ist – obwohl beide Gleichungen der Transfer-Funktion der offiziellen Klimatologie und unsere eigenen valide sind – weil selbst geringe Unsicherheiten in den Sensitivitäten, die um zwei Größenordnungen geringer sind als die absoluten Temperaturen, zu einer großen Unsicherheit der Werte der Transfer-Funktion führen, während sogar große Unsicherheiten bei den absoluten Temperaturen zu geringer Unsicherheit in der Transfer-Funktion führen. Diese kann folglich sehr einfach und sehr zuverlässig abgeleitet werden ohne den Gebrauch der allgemeinen Zirkulationsmodelle.

Ich habe den Eindruck, dass der Herausgeber erkannt hat, dass wir recht haben. Wir warten jetzt auf einen neuen Abschnitt unseres Professors der Kontroll-Theorie zur Ableitung der Transfer-Funktion aus der Energiebilanz-Gleichung mittels einer Ausdehnung einer Taylor-Reihe von führender Größenordnung. Das wird uns Ende des Monats vorliegen, und der Herausgeber wird die Studie dann noch einmal einer Begutachtung zuführen. Falls wir recht haben und die Charney-Sensitivität (Gleichgewichts-Sensitivität im Verhältnis zu verdoppeltem CO2) 1,2 (1,1; 1,3)°C beträgt, was viel zu gering ist, um von Bedeutung zu sein und nicht wie die Modelle zeigen 3,4 (2,1; 4,7)°C, dann wird dies, wissenschaftlich gesprochen, das Ende des Klima-Betrugs sein.

Link: https://wattsupwiththat.com/2019/01/10/the-credibility-gap-between-predicted-and-observed-global-warming/

Übersetzt von Chris Frey EIKE