Ein fingierter Hockeystick

Der besagte “NoTricksZone Artikel”:

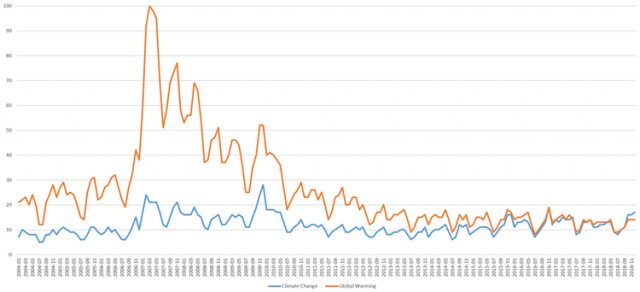

NoTricksZone 13. December 2018: [1] A Fabricated ‘Uptick’? Marcott’s 2013 Hockey Stick Graph Debunked By Marcott’s Own 2011 Ph.D Thesis referiert, wie Studienautoren aus Proxidaten zu Ergebnissen – hier eine Bestätigung der Hockeystick-Temperaturkurve – gelangten, obwohl die angegebenen Daten dieser Aussage (und weiteren in der Studie) eklatant widersprechen.

Trotzdem wurde diese Studie bisher nicht zurückgezogen. Im Gegenteil, sie wird von Klimaforschern und dem IPCC – zum Beispiel im aktuellen SR1.5 Sonderbericht – weiterhin zitiert.

Anmerkung: Der Autor hat in der folgenden Darstellung im Wesentlichen (orientierend übersetzte) Ausschnitte des Originalartikels von NoTricksZone verwendet und nur ab und zu erklärende Ergänzungen zugefügt. Die (fast durchgängigen) Zitate sind nicht extra kursiv ausgewiesen. Man möge dies aus Gründen der besseren Lesbarkeit entschuldigen.

NoTricksZone, Artikel: [1] Unmasking Marcott’s “Uptick”

Die besagte Studie listet in ihrer Zusammenfassung (Summary):

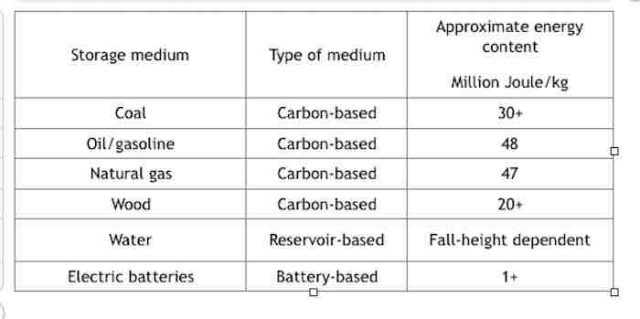

Marcott et al., 2013 [2] (in grober Übersetzung): Eine Rekonstruktion der regionalen und globalen Temperatur der letzten 11.300 Jahre

… Temperaturrekonstruktionen der letzten 1500 Jahre deuten darauf hin, dass die jüngste Erwärmung in dieser Zeit beispiellos ist. Hier bieten wir eine breitere Perspektive, indem wir regionale und globale Temperaturanomalien der letzten 11.300 Jahre aus 73 global verteilten Datensätzen rekonstruieren. Auf die frühe Holozän (vor 10.000 bis 5000 Jahren) Wärme folgt eine Abkühlung von ~0,7°C durch das mittlere bis späte Holozän (vor <5000 Jahren), die in den kühlsten Temperaturen des Holozäns während der Kleinen Eiszeit vor etwa 200 Jahren gipfelt. Diese Abkühlung ist weitgehend mit einer Veränderung von ~2°C im Nordatlantik verbunden. Die aktuellen, globalen Temperaturen des letzten Jahrzehnts haben die interglazialen Spitzenwerte noch nicht überschritten, sind aber wärmer als während ~75% der holozänen Temperaturgeschichte. Die Modellprognosen des Zwischenstaatlichen Ausschusses für Klimaänderungen für 2100 übersteigen die volle Verteilung der Holozäntemperatur unter allen plausiblen Szenarien für Treibhausgasemissionen.

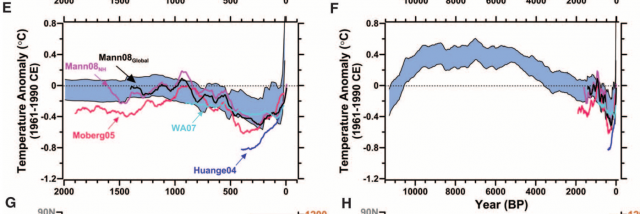

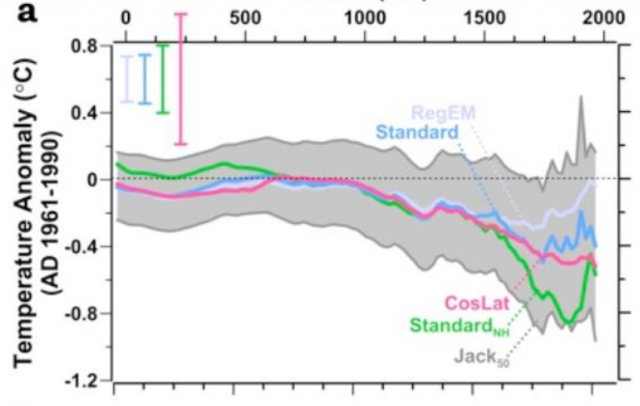

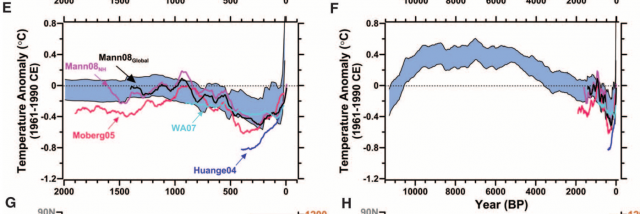

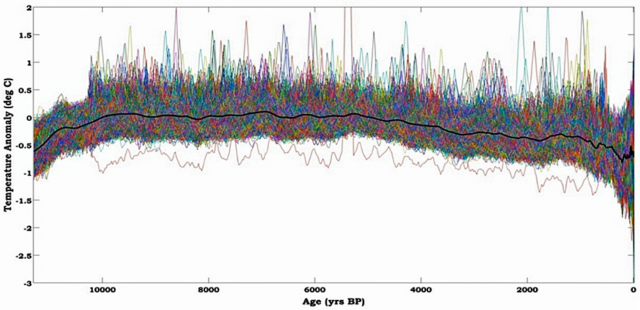

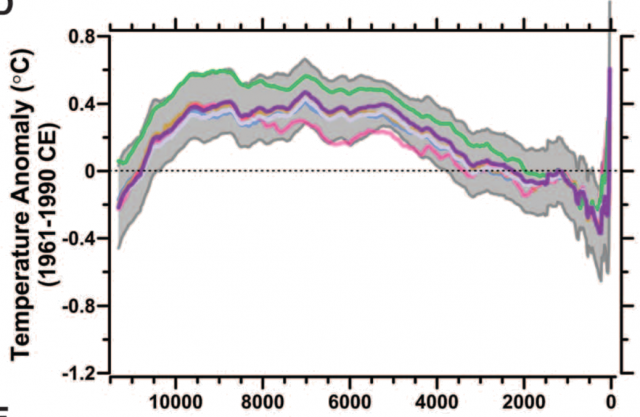

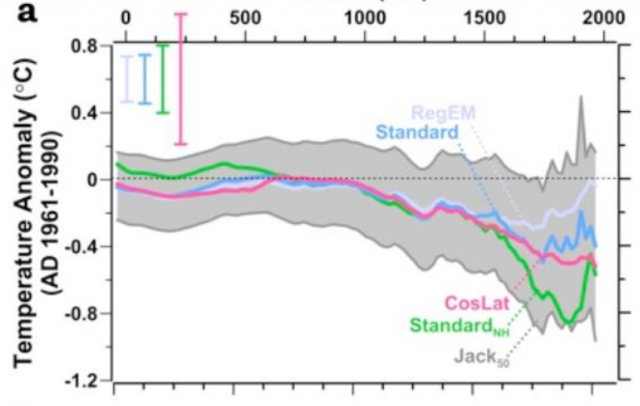

Bild 1 Hockeysticks aus [2] Marcott et al., 2013. Auszug aus Fig. 1. Comparison of different methods and reconstructions of global and hemispheric temperature anomalies. (E and F) Published temperature anomaly reconstructions that have been smoothed with a 100-yearcenteredrunning mean, Mann08Global (2), Mann08NH (2), Moberg05 (3), WA07 (8), Huange04 (36), and plotted with our global temperature stacks [blue band as in (A)].

Anmerkung: Es wurde im Ansatz ein ähnliches Verfahren wie beim „Original“-Hockestick angewendet. Nachdem die Weiterführung der Proxidaten das (gewünschte?) Ergebnis nicht lieferte, wurde das „notwendige“ Ende – ein steiler Temperaturanstieg“ – durch Selektion der Daten und statistische Kunstgriffe „erzeugt“.

[1]: Trotz dieses eingeräumten Mangels an Belegen für den „Aufwärtstrend“ des 20. Jahrhunderts wude die Marcott et al (2013) „Hockeyschläger“ -förmige Kurve von anderen Autoren fast 700-mal zitiert.

Die gleichen 73 global verteilten Proxy-Temperaturaufzeichnungen, welche zur Herstellung von Marcott et al. (2013) verwendet wurden, wurden zwei Jahre zuvor in Shaun Marcotts Doktorarbeit an der Oregon State University vorgestellt.

Anmerkung: Der Haupt-Studienautor, Shaun Marcott, führte die grundlegenden Arbeiten der Studie von 2013 bereits zuvor in seiner Dissertation durch (Marcott 2011). Darin ist die Ausarbeitung natürlich wesentlich detaillierter dargestellt und auch die Daten hinterlegt. Allerdings ist das Ergebnis in der Dissertation trotz der gleichen Daten vollkommen anders, als zwei Jahre später in der Studie (2013) dargestellt.

Anmerkung: Nun bezieht sich die Beschreibung auf die Dissertation.

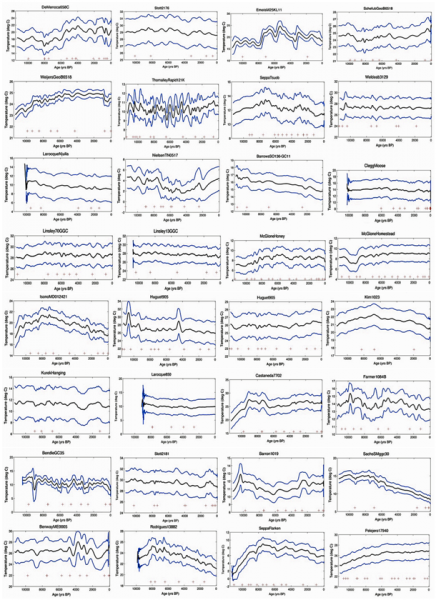

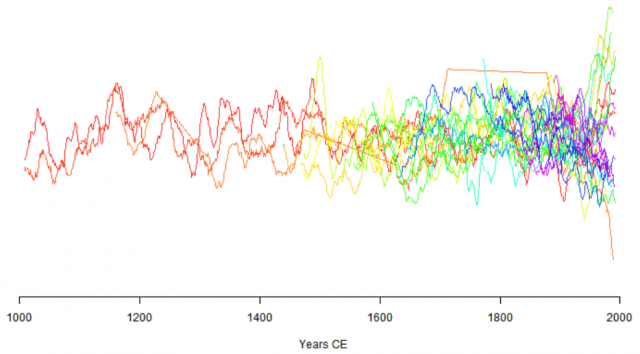

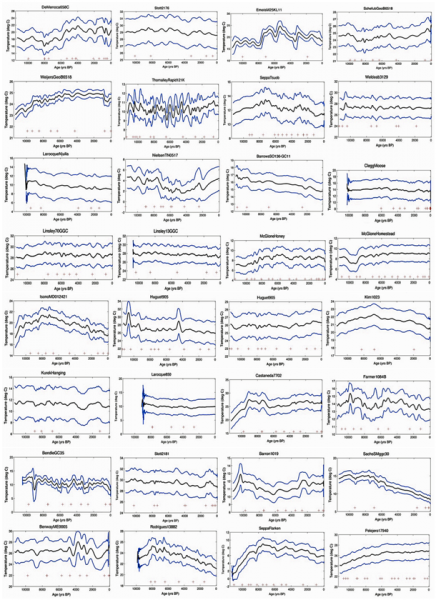

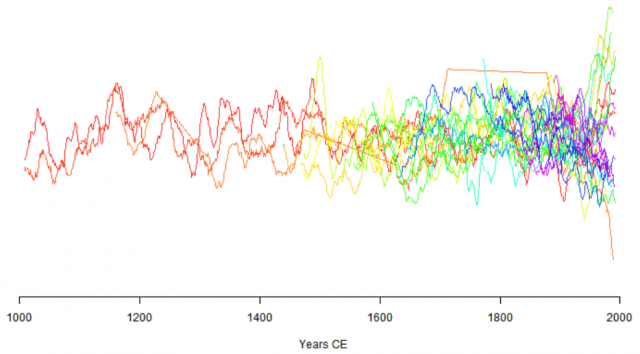

[1]: Interessanterweise weisen die meisten Diagramme keine Temperaturen auf, die sich bis zur rechten Y-Achse erstrecken, was darauf hindeutet, dass die meisten der 73 Proxy-Datensätze nicht das moderne Zeitalter umfassen und eine Analyse der relativen Temperaturunterschiede zwischen Vergangenheit und Gegenwart ausschließen.

Tatsächlich haben nur 32 der 73 Diagramme allgemeine Trendlinien, die sich im Marcott-Dissertationspapier auf „0 Jahre BP“ (Anmerkung: Before Present, also vor der aktuellen Zeit) erstrecken. Der Rest endet irgendwo im späten Holozän (oder früher). Die 32 Rekonstruktionen, die sich bis zur rechten Y-Achse erstrecken, sind unten dargestellt.

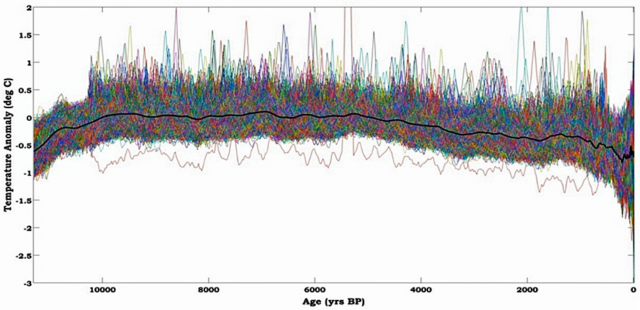

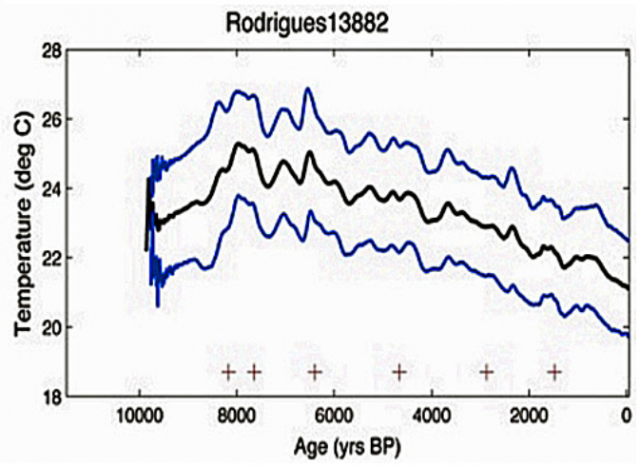

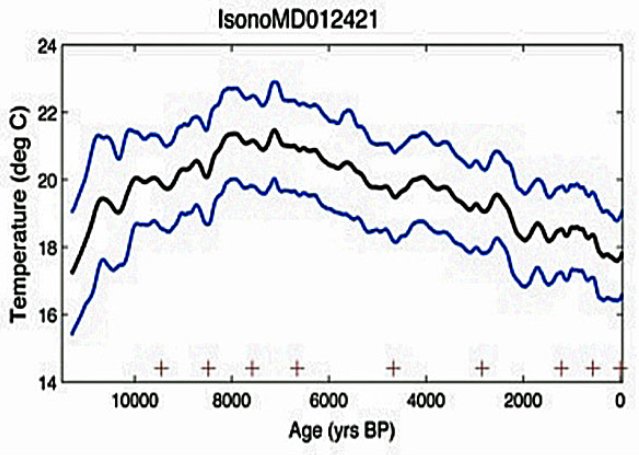

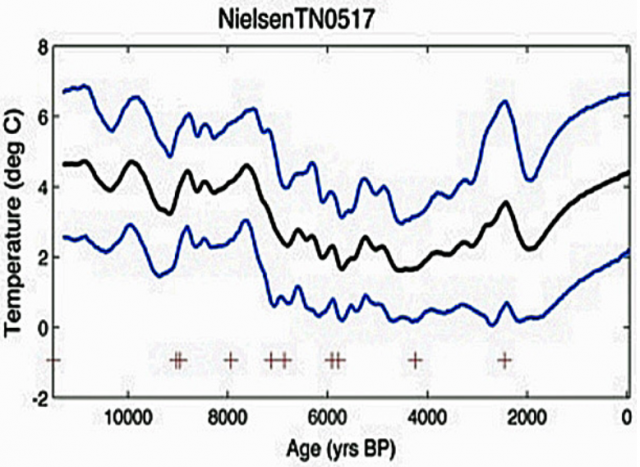

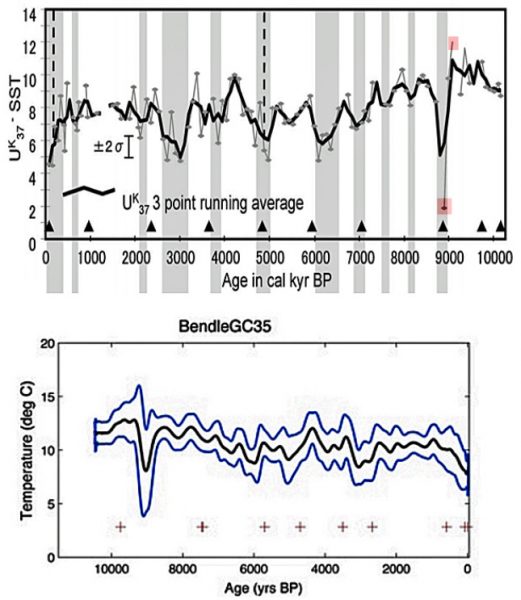

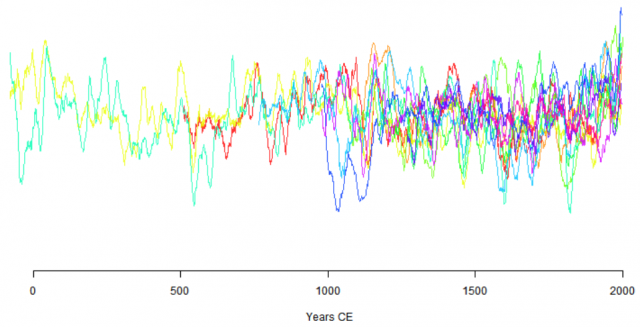

Bild 3 [1] Die Temperaturproxis, welche in Marcott, 2011 [3] bis zur aktuellen Zeit reichen

Gleiche Daten, widersprüchliche Ergebnisse

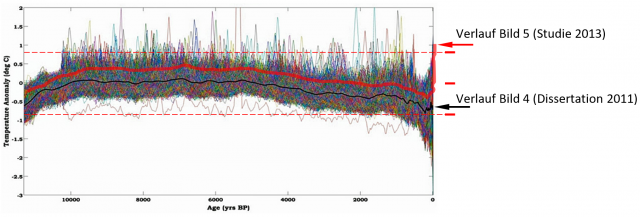

[1]: Wie schon ein flüchtiger Blick auf die 32 Rekonstruktionen verdeutlicht, zeigte Marcott’s Dissertation aus dem Jahr 2011 nach einem bescheidenen Holozän-Abkühlungstrend keinen Temperaturanstieg im 20. Jahrhundert.

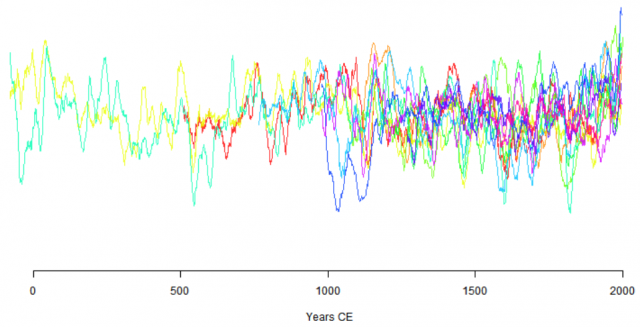

Eine Zusammenstellung aller 73 Holozän-Temperaturtrends der letzten 11.300 Jahre ist in einem komprimierten Diagramm auf Seite 204 (Anmerkung: hier Bild 4) dargestellt. Beachten Sie, dass die große Amplitude von Änderungen, die Temperaturänderungen von mehreren Grad Celsius in den Proxy-Rekonstruktionen enthalten, durch viel kleinere, variable Bereiche ersetzt wurden (Zehntel Grad).

Bild 4 [1] Temperaturrekonstruktion in Marcott, 2011 (Dissertation) [3]

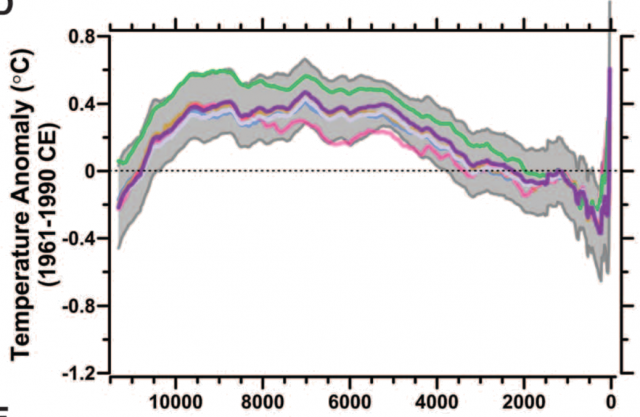

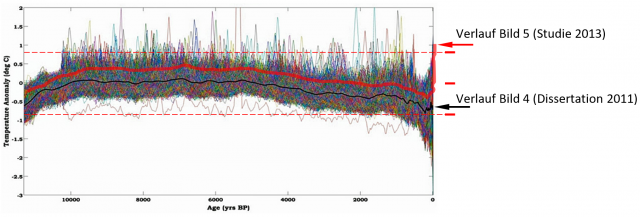

Bild 5 Hockeystick aus [2] Marcott et al., 2013 (andere Darstellung in der Studie von Bild 1)

Bild 6 Die Verläufe von Bild 4 und von Bild 5 vom Autor übereinander kopiert. Anm.: Der Verlauf Bild 5 (Rot) wurde vom Autor aus der violetten Linie von Bild 5 nachgezeichnet

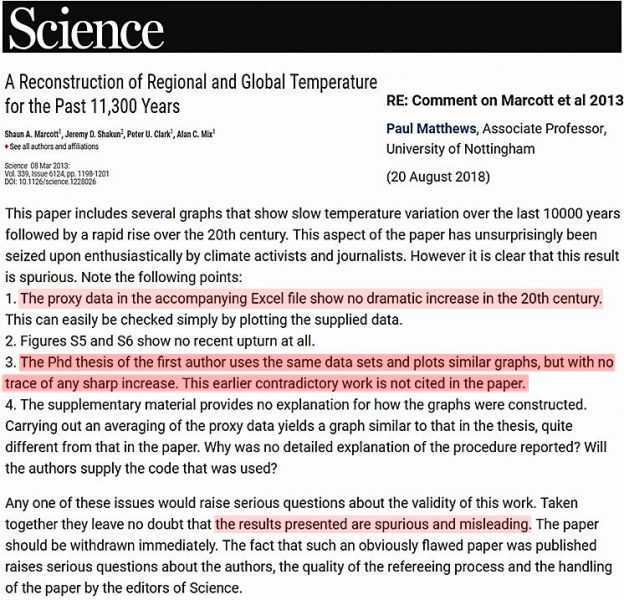

[1]: Auf diesen krassen Widerspruch zwischen Marcotts Veröffentlichungen von 2011 und 2013 wies Professor Paul Matthews in einem von der Zeitschrift Science veröffentlichten Kommentar hin:

Grobe Übersetzung (Text, Bild 7)

Kurzkommentar zu „Rekonstruktion der regionalen und globalen Temperatur in den letzten 11.300 Jahren“

Paul Matthews, School of Mathematical Sciences, Universität Nottingham, Großbritannien, 16. März 2013

… Dieses Papier enthält mehrere Grafiken, die langsame Temperaturschwankungen in den letzten 10000 Jahren zeigen, gefolgt von einem rapiden Anstieg im 20. Jahrhundert. Dieser Aspekt des Papiers wurde überraschenderweise von Klimaaktivisten und Journalisten begeistert aufgenommen. Es ist jedoch klar, dass dieses Ergebnis falsch ist. Beachten Sie die folgenden Punkte:

1. Die Proxy-Daten in der beiliegenden Excel-Datei zeigen im 20. Jahrhundert keinen dramatischen Anstieg. Dies kann einfach durch Zeichnen der gelieferten Daten überprüft werden.

2. Die Abbildungen S5 und S6 zeigen überhaupt keinen Aufschwung.

3. Die Doktorarbeit des Erstautors verwendet die gleichen Datensätze und stellt ähnliche Diagramme dar, ohne jedoch einen starken Anstieg zu erkennen. Diese frühere, widersprüchliche Arbeit wird im Papier nicht zitiert.

4. In dem ergänzenden Material wird nicht erläutert, wie die Grafiken erstellt wurden. Die Mittelwertbildung der Proxy-Daten führt zu einem Diagramm, das dem in der Dissertation ähnelt, und unterscheidet sich stark von dem in der Arbeit. Warum wurde keine detaillierte Erklärung des Verfahrens gemeldet? Liefern die Autoren den verwendeten Code?

Jede dieser Aussagen würde ernsthafte Fragen über den Wahrheitsgehalt dieser Arbeit aufwerfen. Zusammengenommen lassen sie keinen Zweifel daran, dass die vorgelegten Ergebnisse falsch und irreführend sind. Das Papier sollte sofort zurückgezogen werden. Die Tatsache, dass ein so offensichtlich fehlerhaftes Papier veröffentlicht wurde, wirft ernsthafte Fragen über die Autoren, die Qualität des Reviewprozesses und die Handhabung des Papiers durch die Redakteure von “science” auf.

[1]: Marcott’s ausgewählte Rekonstruktionen zeigen wärmeren Temperaturen um 2 ° C während des frühen bis mittleren Holozäns

Interessanterweise zeigen die Rekonstruktionen bei der Temperatur, die Marcott 2011 sowohl für seine Doktorarbeit als auch für seine wissenschaftliche Arbeit von 2013 verwendet hat, dass:

(a) die Temperaturen im frühen bis mittleren Holozän im Durchschnitt um mehr als 2 ° C wärmer waren als heute und

(b ) Sie variierten im gesamten Holozän um mehrere Grad Celsius statt nur um den Zehntelgrad, der sowohl in den Papieren von 2011 als auch von 2013 gezeigt wurde.

Von den 32 Rekonstruktionen, die sich in Marcotts Papieren auf die Y-Achse erstrecken, definieren 25 eindeutig die moderne oder gegenwärtige Temperatur relativ zur Vergangenheit. Die anderen 7 hatten keine modernen oder aktuellen Temperaturwerte, die im paper eindeutig definiert waren. Bei den 25 Rekonstruktionen, die einen Vergleich ermöglichten, wurden die ermittelten Spitzentemperaturen des Holozäns mit durchschnittlich 2,3 ° C wärmer als heute ermittelt. Dieses Ergebnis widerspricht völlig den Behauptungen von Marcotts Papier von 2013.

Beispiele der wärmeren, als heutigen Aufzeichnungen

[1]: Vielleicht hat Marcott den Inhalt der von ihm referierten Papiere nicht genau genug untersucht. Hätte er dies getan, hätte er vielleicht bemerkt, dass bei Rodrigues et al., 2009 die derzeitige Temperatur in der iberischen Region bei 15 ° C liegt, was etwa 1 ° C kälter ist als während der Kleinen Eiszeit (16 ° C) C) und 4 ° C kälter als die Spitzentemperatur des Holozäns .

Isono et al. (2009) berichten, dass die „gegenwärtige“ Temperatur 16,7 ° C beträgt, aber die Spitzentemperatur des Holozäns 21,4 ° C betrug, was bedeutet, dass die Temperaturen im Nordpazifik vor etwa 7000 oder 8000 Jahren etwa 5 ° C wärmer waren.

Sogar eine Grafik, die anfänglich einen deutlichen Temperaturanstieg in der Neuzeit zu unterstützen scheint (ein „Aufwärtstrend“) wie Nielsen et al. (2010) sagt tatsächlich, dass der Holozän-Peak 4 ° C wärmer war als der heutige Mittelwert in der Studie.

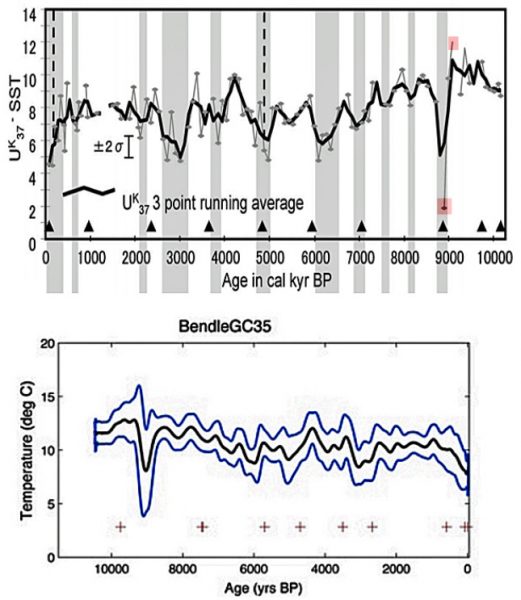

Wie Bendle und Rosell-Mele, 2007 (Bild 11), hervorheben , könnte die Amplitude früherer Temperaturänderungen innerhalb von Jahrhunderten bis zu 10 ° C betragen. Dies scheint der Behauptung zu widersprechen, dass die Holozän-Temperaturvariabilität viel weniger ausgeprägt war (einige Zehntel Grad über Jahrtausende).

Bild 11 [1]

Bemerkenswert ist, dass keine der untersuchten Rekonstruktionen die Behauptung stützt, dass moderne Temperaturen ungewöhnlich hoch oder beispiellos sind.

Wenn die Beweise aus dem Paläoklima keinen kürzlich ausgesprochenen „Aufwärtstrend“ unterstützen, woher kommt er?

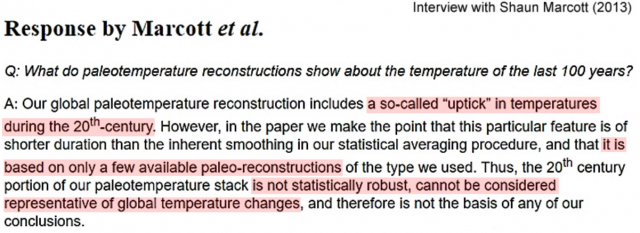

[1]: Marcott selbst hat eingeräumt, dass der „Aufwärtstrend“ des 20. Jahrhunderts nur auf „wenigen“ Rekonstruktionen beruht, die weder global repräsentativ, noch statistisch robust sind. Das wirft die Fragen auf:

1. Welcher Datensatz wird verwendet, um die Darstellung eines ausgeprägten Temperaturanstiegs zu rechtfertigen?

2. Wurde das „Uptick“ hergestellt?

3. Auf welcher Grundlage veröffentlichte die Zeitschrift Science die Ausgabe 2013 eines Papiers, dem ein früheres Werk desselben Autors widerspricht?

Anmerkung: Im Originalartikel kommt nun eine Listung der Studien mit den (interessanten) Proxigrafiken, welche alle zeigen, dass der (re-)konstruierte Hockeystick daraus nicht abgeleitet werden kann.

Wie geht es mit den Daten weiter?

[1]: Allein in den letzten Jahren wurden hunderte (neue Studien) von Menschen veröffentlicht, die zeigen, dass der Großteil des Holozäns um 2-5 ° C wärmer war als heute.

Beginnen Sie mit diesen Links unten. Wir aktualisieren regelmäßig. Die Links sind auch dauerhaft auf unserer rechten Seitenleiste zu finden („450 Diagramme ohne Erwärmung“ 1 und 2).

~ 300 Grafiken von 2017 und 2018

~ 300 Grafiken aus den 2000er Jahren bis 2016

Damit ist die Zitierung aus dem „NoTricksZone”-Artikel zu Ende.

Ergänzende Zitate aus einer vergleichbaren Rezension zur Marcott-Studie (2013) von „kaltesonne“

kaltesonne 17. April 2013: [5] Nach drei Wochen erneutem Hockeyschläger-Alarm war der Spuk wieder vorbei und der Skandal perfekt: Wie Jungforscher Shaun Marcott die Medienwelt hinters Licht führte

Bild 12 Bild 4 in anderer Darstellung in der Dissertation (2011). “kaltesonne”: [5] Abbildung 5: Globale Temperaturentwicklung der letzten 2000 Jahre laut Marcotts Doktorarbeit 2011. Es fehlt die ominöse moderne Wärmespitze, das Herzstück des späteren Science Artikels.

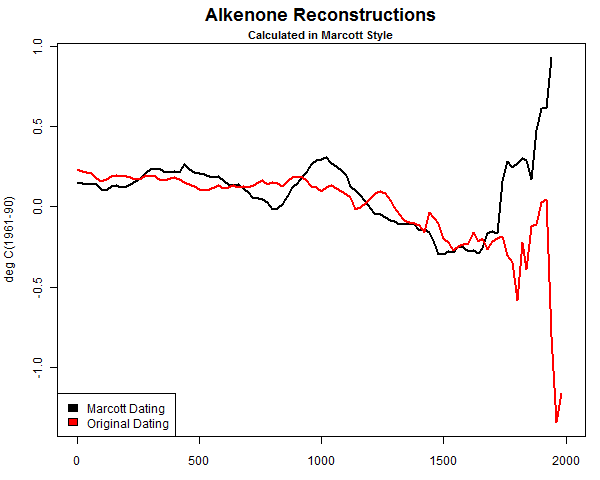

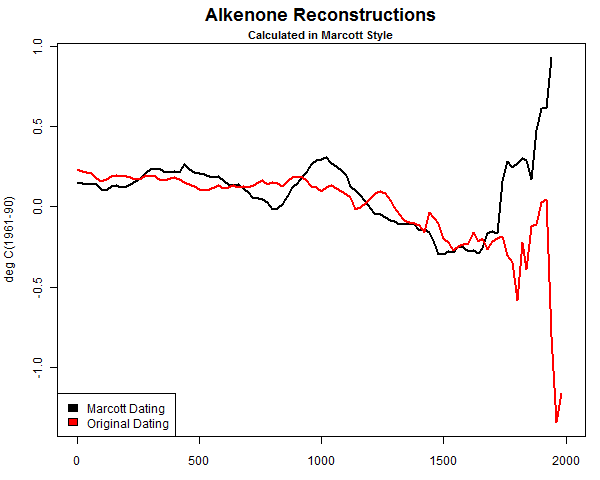

Bild 13 [5] Abbildung 7: Originaltemperaturdaten (rot) und was daraus nach phantasievoller Modifikation durch Marcott et al. wurde. Quelle: Climate Audit.

Niemand von den etablierten Fachpersonen und Medien bemerkte die Manipulationen

kaltesonne: [5] Ein Skandal und keine Folgen?

Der Skandal ist aufgeflogen und trotzdem scheint es keinen der ehemaligen Berichterstatter der Studie zu interessieren. Tagesspiegel, Stuttgarter Zeitung und Klimaretter haben noch immer ihren Originalartikel im Netz (Anmerkung: Auch heute, nach 15 Jahren noch), ohne Hinweis oder Addendum auf den sinnentstellenden Fehler. Die klimaalarmistische Gemeinde verstummte plötzlich und ging auf Tauchstation. Klimarealisten wie Ross McKittrick mussten die Lücke füllen und die Öffentlichkeit über die veränderte Sachlage in der Presse informieren.

Und heute nach ca. 15 Jahren, tut der IPCC im SR1.5 so, als gäbe es diese Kritik an der Studie nicht

In dem noch rechtzeitig vor dem gerade erst vergangenen Klimagipfel herausgekommenem – alarmistischen – Klima-Zwischenbericht SR1.5 des IPCC haben die vielen Autoren und beteiligten Wissenschaftler scheinbar immer noch nichts von den beschriebenen Ungereimtheiten (eher gravierenden Fehlern) festgestellt, beziehungsweise ignorieren sie einfach, weil deren Ergebnis zum Beleg der Alarmierung „erforderlich“ ist.

Gleich im Kapitel 1 am Anfang wird sie als Beleg angezogen:

SR1.5, Chapter 1: Framing and Context

Box 1.1: The Anthropocene: Strengthening the global response to 1.5°C global warming

Introduction

… Since 1970 the global average temperaturehas been rising at a rate of 1.7°C per century, compared to a long-term decline over the past 7,000 years at a baseline rate of 0.01°C per century (NOAA 2016, Marcott et al. 2013). These global-level rates of human-driven change far exceed the rates of change driven by geophysical or biosphere forces that have altered the Earth System trajectory in the past …

Ein schöner Beleg, dass es dem IPCC in seinen Berichten nicht um die Darstellung von Wahrheiten geht.

Wie sehen es Klima(Folgen)Forscher vom PIK

Herr Rahmstorf konnte sich damals gar nicht genug über die in seinen Augen hohe Qualität dieser Studie auslassen. Das Ergebnis entsprach schließlich genau seiner “Vorstellung”. Zudem bestätigt es ja (in seinen Augen) auch die damals gerade abgeschlossene, große Proxyanalysesammlung Pages2k (die für den Autor nur bestätig, dass die Proxiqualitäten so schlecht sind, dass sie für historische Aussagen nicht angewendet werden können – siehe Anlage). Auch kann man auf seinem Blog nachlesen, wie Herr Rahmstorf die Ergenisse von Studien ignoriert, welche zeigen, dass in der Klimavergangenheit wesentlich höhere Temperaturschwankungen vorkamen (Bild 11).

Anbei Auszüge aus der damaligen Bewertung von Professor Rahmstorf in seinem Klimablog:

Stefan Rahmstorf, 17. Juni 2013: [4] BLOG KlimaLounge – Nah dran am Wandel

Paläoklima: Das ganze Holozän

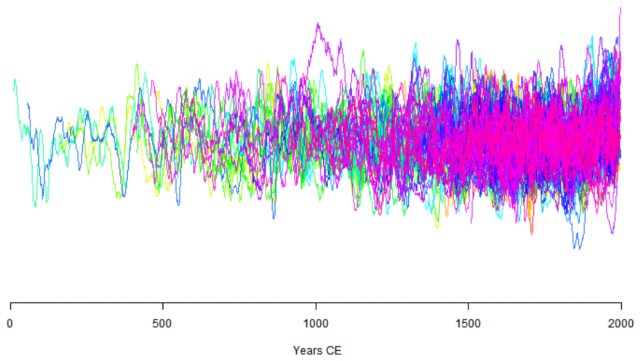

Über die letzten Jahrzehnte haben zahlreiche Forscher in mühsamer Kleinarbeit viele Datenreihen z.B. aus Sedimentbohrungen in der Tiefsee gewonnen, analysiert, datiert, kalibriert usw. Nun haben Shaun Marcott und Kollegen erstmals 73 solcher Datenreihen aus aller Welt zu einer globalen Temperaturrekonstruktion für das Holozän zusammengefügt. Oder genau genommen zu vielen: sie haben rund zwanzig verschiedene Mittelungsmethoden ausprobiert und außerdem 1000 Monte-Carlo-Simulationen mit zufälligen Datierungsfehlern der einzelnen Datenreihen durchgeführt, um die Robustheit ihrer Ergebnisse zu belegen.

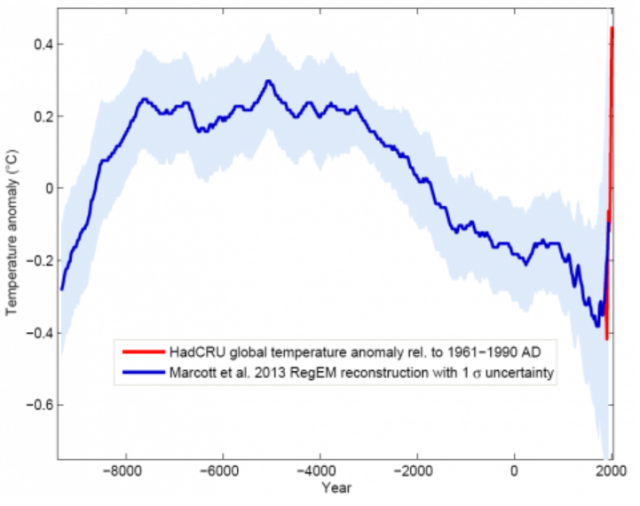

Um das Hauptergebnis gleich vorweg zu nehmen, es sieht so aus:

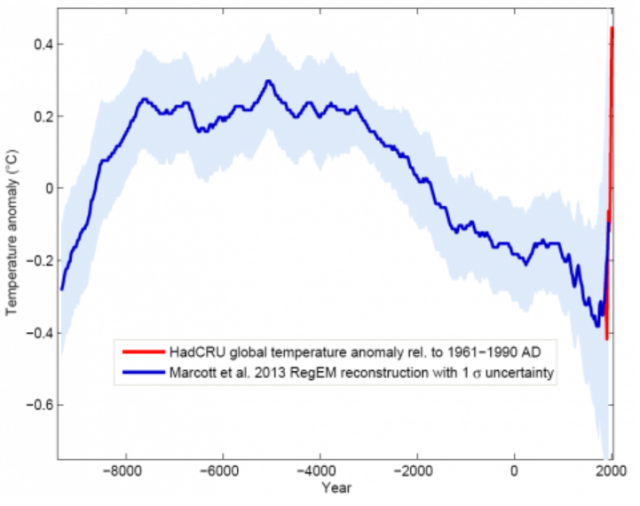

Bild 14 [4] Abb. 1. Blaue Kurve: Globale Temperaturrekonstruktion aus Proxydaten von Marcott et al., Science 2013. Gezeigt ist die RegEM-Version – nennenswerte Unterschiede zwischen den Varianten mit verschiedenen Mittelungsmethoden gibt es allerdings ohnehin nur gegen Ende, wo die Zahl der Proxyreihen abnimmt, wo der Verlauf aber aus instrumentellen Messungen gut bekannt ist. Rote Kurve: Globale Temperatur aus Messdaten (HadCRU). Grafik: Klaus Bittermann.

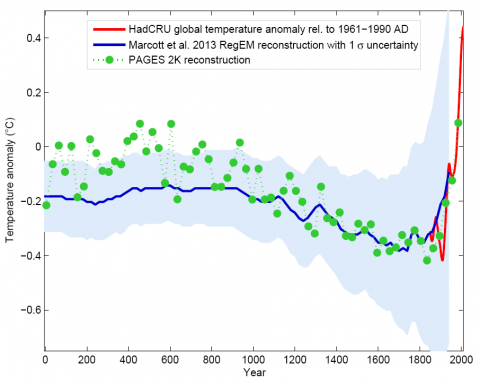

Vergleich mit PAGES 2k

Die verwendeten Daten unterscheiden sich von denen des PAGES 2k Projekts (nur Land-Daten) hauptsächlich darin, dass sie zu 80% aus Tiefseesedimenten stammen …

… Insgesamt ist die neue Marcott-Rekonstruktion weitestgehend unabhängig von und schön komplementär zu der PAGES 2k Rekonstruktion: Ozean statt Land, ganz andere Methodik. Daher ist ein Vergleich zwischen beiden interessant:

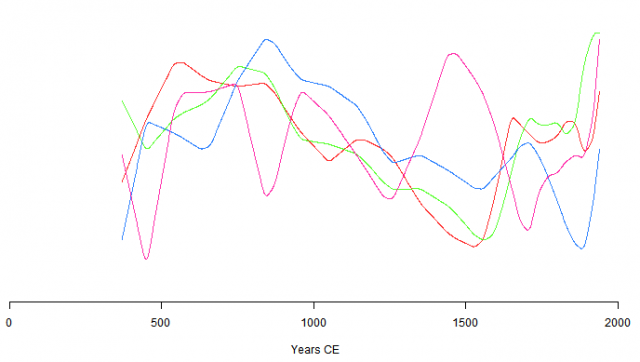

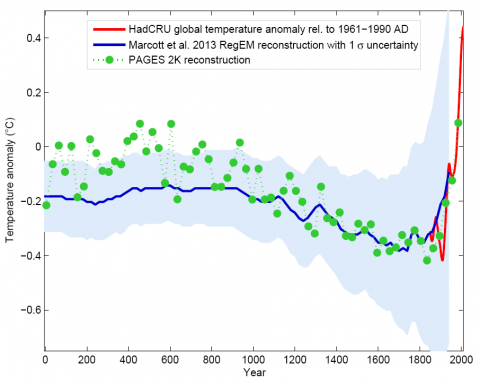

Bild 15 [4] Abb. 3. Die letzten zweitausend Jahre von Abb. 1 im Vergleich mit der PAGES-Rekonstruktion (grün), die in Teil 1 von uns näher erläutert wird. Grafik: Klaus Bittermann.

… Entscheidend ist vielmehr, dass der rasche Anstieg im 20. Jahrhundert im ganzen Holozän einmalig ist. Ob das wirklich so ist, darüber wurde nach Erscheinen des Papers in den Blogs intensiv diskutiert. Denn die Proxydaten haben nur eine grobe zeitliche Auflösung – hätten sie es überhaupt erfasst, wenn es im Holozän schon einmal eine ähnlich rasche Erwärmung gegeben hat?

Ich halte es aus drei Gründen für praktisch sicher, dass es eine so rasche Erwärmung noch nicht gab:

Es gibt auch eine Reihe von hochaufgelösten Proxydaten über das Holozän, z.B. die Eiskerne aus Grönland und der Antarktis. Sie zeigen einen glatten Verlauf ohne eine frühere starke Erwärmung wie im 20. Jahrhundert. Hätte es eine solche globale Erwärmung schon einmal gegeben, müsste man sie zumindest in einigen Datenreihen deutlich sehen, selbst wenn sie in der gemittelten Marcott-Kurve untergeht.

… Es gibt keinerlei Hinweise in den Forcing-Daten, dass ein solcher Klimaantrieb plötzlich aufgetaucht und wieder verschwunden sein könnte, und ich kann mir auch nicht vorstellen, was der Mechanismus gewesen sein sollte …

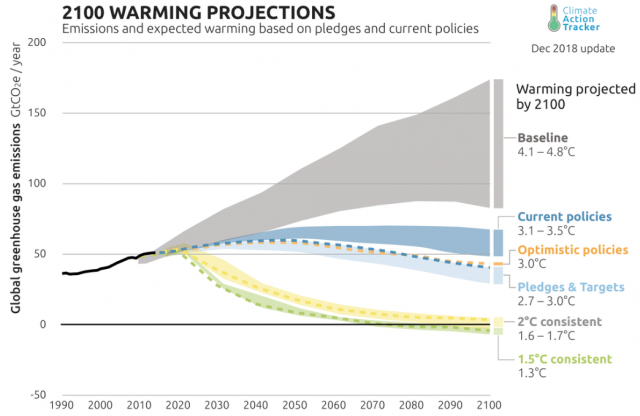

Schlimmer geht`s nimmer

Ein NGO, Climate Analytics, führt im WEB einen sogannten „ClimateActioTracker“, welcher Temperaturprojektionen anzeigt. Man ahnt, welche Institution die Daten „speist“, es ist das PIC, welches auf deren Homepage als „Collaborateur“ gelistet ist.

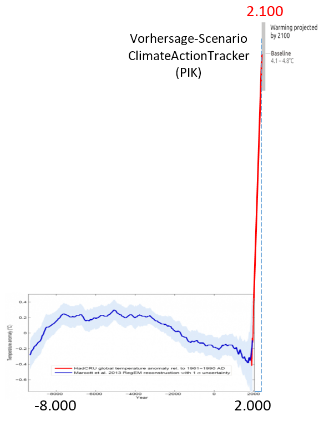

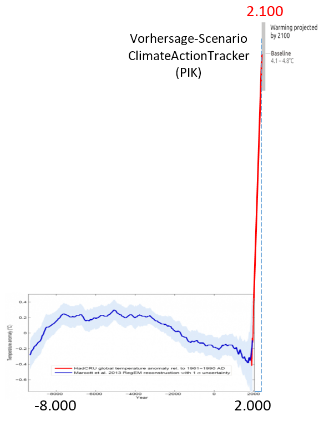

Fügt man die Temperatur-Verlaufsdaten von Marcott at al. (2013) und die des ClimateActionTrackers zusammen, dann „verbrennt“ die Welt demnächst wohl tatsächlich.

Bild 17 Verlauf Marcott at al (2013) und ClimateActionTracker Projektion Baseline. Vom Autor zusammengestellt

Nun stellt sich die Frage: Wer glaubt solchen Darstellungen, gegenüber denen die Vorhersagen von Zukunfts-Grausamkeiten im Alten Testament fast als „Kinderkram“ erscheinen?

Zum Beispiel die Redaktion der Tageszeitung des Autors: Auf eine Anfrage zu den Datenquellen ihrer während des Klimagipfels (ausschließlich) höchst alarmistischen Kommentare kam die Antwort der Redaktion, dass Angaben von diesem ClimateActionTracker übernommen wurden.

Wenn es das PIK simuliert und der IPCC nicht widersprochen hat, kann es ja niemals falsch sein? Gott verweigerte den Menschen damals den Apfel vom „Baum der Erkenntnis“, damit sie nicht gescheiter würden. Der Ökogot muss nichts verweigern, seine Anhänger machen es freiwillig.

Klimapropaganda in den „Öffentlich-Rechtlichen“

Etwas abweichend, aber zum Thema Propagand passend, ein Trailer des BR. Ein Wissenschaftserzähler wechselt sich dort bei der Klimapropaganda inzwischen mit Harald Lesch ab.

Im Trailer geht es um den wieder einmal „immer schneller“ steigenden Meeresspiegel.

BR, Sendung: Gut zu wissen

Land unter – Meeresspiegel steigen immer schneller. Dass die Meeresspiegel weltweit ansteigen, ist nichts Neues. Eine aktuelle Studie zeigt nun, dass das offenbar viel schneller passiert als bislang angenommen. „Gut zu wissen“ erklärt warum.

Bild 18 Screenshot von der BR Mediathek. Link zum Trailer: BR Mediathek

Erklär-Stichworte in der Sendung:

BR, Sendung: … Die Malediven gehen unter … weil es so warm ist, taut das Grönlandeis seit ein paar Jahren fast auf der gesamten Fläche an … und es wird noch schlimmer werden, wenn irgendwann das Festlandeis am Südpol, also in der Antarktis schmilzt … das Festlandeis könnte dann schneller nachrutschen und im Meer schmelzen … CO2 muss reduziert werden … denn irgendwann ist es soweit und dann schmilzt das Grönlandeis komplett und dann steigt der Meeresspiegel um 7 m …

Damit endet die „Information“. Außer alarmistischen Statements und Schlagwörtern ist keinerlei wirkliche Detaillierung zum Thema, schon gar nicht eine kritische, oder zur eigenen Meinungsbildung anregende, enthalten.

Diese deshalb kurz nachgeholt:

„Immer schnellerer Pegelanstieg“: Bezug genommen wird wohl auf die in den folgenden Rezensionen analysierte Pegelalarm-Studie:

EIKE 7. März 2018: Flashcrash Klimaalarm. Wer Klimaalarm posaunt, bekommt immer recht (Teil 2 und Abschluss)

EIKE 06.03.2018: Flashcrash Klimaalarm. Wer Klimaalarm posaunt, bekommt immer recht (Teil 1)

EIKE 01.06.2017: Der Meerespegel steigt drei Mal so stark an – ohne dass sich an dessen Verlauf etwas verändert hat

Judit Curry: Sea level rise acceleration (or not): Part IV – Satellite era record

„Malediven gehen unter“: Sie denken in Wirklichkeit gar nicht daran „unterzugehen“. So ist es inzwischen von vielen Wissenschaftlern – und vor allem auch mit dem aktuellen Seepegelverlauf – belegt. „Unter“ gehen sie ausschließlich in entsprechend parametrierten Computersimulationen:

EIKE 03.11.2017: Das Wochenende, an dem die Welt (wieder) begann unterzugehen

EIKE 18.10.2016: Wie steht es um den Untergang der Marshall-Inseln?

EIKE 17.09.2015: Gehen die Südseeinseln wirklich wegen des Klimawandels unter, Teil 1 Die Malediven

Dass das Grönlandeis – und das der Antarktis- komplett schmilzt, kann natürlich passieren. Falls es dazu käme, dauert es allerdings mehrere Tausend Jahre. Aktuell nimmt das Eis in der Antarktis jedoch eher zu:

kaltesonne: Neuer Kälterekord in der Antarktis: fast minus 100 Grad (4.7.2018)

EIKE 14.03.2017: Auch das Antarktiseis schrumpft – aber nur partiell – und nur im Sommer!

kaltesonne: Alfred-Wegener-Institut: Ostantarktischer Eisschild ist stabil und wächst sogar leicht an (5.5.2015)

Um den „erforderlichen“ Untergang trotzdem zu erreichen, propagiert das PIK die „Gletscher Rutsch-Hypothese“. Nur mittels dieser Hypothese lässt sich eine Verringerung des Anatarktischen Festlandeises überhaupt simulieren:

ntv, 22. Mai 2017: Kettenreaktion teilweise im Gang Düstere Prognosen fürs Antarktis-Schelfeis

Selbst wenn Schelfeis zum Teil auf dem Wasser schwimmt, hat es fatale Folgen, wenn es schmilzt: Inlandseis fließt dann schneller ab. In der Antarktis hat dieser Vorgang bereits begonnen – und könnte sich dramatisch beschleunigen …

Forscher des Potsdamer Institutes für Klimafolgenforschung haben berechnet, wie es bei einem unverminderten Klimawandel um das Filchner-Ronne-Schelfeis und die dahinterliegenden Eisströme steht. Das Ergebnis: Innerhalb von 200 Jahren könnte der weltweite Meeresspiegel um bis zu 40 Zentimeter steigen.

Was man sogar anhand des ntv-Alarmartikels herauslesen kann: Selbst das über-alarmistische PIK simuliert hier einen Pegelanstieg, der weit unter allen alarmistischen Szenarien liegt (20 cm in 200 Jahren ist fast in der Größenordnung des natürlichen Anstiegs [7]).

Ob dann allerdings die (simulierte) Erwärung wirklich kommt, steht in den Sternen. Viel wahrscheinlicher beginnt bald die nächste – bereits überfällige – Eiszeit. In den Klimasimulationen ist diese nur nicht einprogrammiert, im Erdklima jedoch seit einer Million Jahren:

EIKE 25.12.2016: Man sollte schon langsam an die nächste Eiszeit denken, denn wenn die neuesten Hypothesen sich als falsch erweisen, kann sie schnell da sein

Was zeigt das Video allerdings wieder? Es ist leider nicht so, dass eine Ausbildung in MINT-Fächern wirklich gegen Alarmismus hilft, wie es viele EIKE-Blogeinträge meinen.

Der Redakteur des Videos ist studierter Physiker. Er weiß also bestimmt zwischen Simulation und Messergebnissen zu unterscheiden. Er weiß aber auch, mit welcher Darstellung man in Deutschland im öffentlichen Bereich am sichersten aufsteigt und viel Geld (und Ehre) verdient. Wie Herr Lesch und Herr Schellnhuber hat auch er sich deshalb ausschließlich dafür entschieden. Alle zeigen, dass man dann (und nur dann) fast schon „automatisch“ mit Arbeiten, Ehrungen, Posten und Geld regelrecht „beworfen“ wird.

Wie perfekt das funktioniert, wurde gerade erst an einer anderen Stelle präsentiert:

Achgut: Claas Relotius oder: Der Spiegel lässt die Hosen runter

Die Diskussion der möglichen Wirklichkeit

Auf eines weisen alle Medien und „offiziellen“, bedeutet, von öffentlichen Geldern abhängigen, Klima(Folgen)Forscher mit Bedacht nicht hin: Dass an dem, das ganze Schreckensszenario alleine bestimmendem Forcingwert aktuell massiv „gerüttelt“ wird.

Sowieso gibt es in Deutschland seit vielen Jahren eine konsequente Unterdrückung kritischer Meinungen (nicht nur) zum AGW-Klimawandel. Eine GRÜNE „Vorzeigedame“ sagte es ganz deutlich, was sie davon hält, wenn jemand es wagt, Klimadogmen in Frage zu stellen:

EIKE 11. Dezember 2017: Bärbel Höhn beschwert sich, dass Herr Kachelmann Fakten über den Klimawandel erzählt

Eine Regierungsberaterin vermittelte es über ihre Homepage:

EIKE 09.04.2017: Klima-Lügendetektor: Wer der Bildzeitung sagt, Eisbären würden nicht durch den Klimawandel sterben, ist ein schlimmer Demagoge

Und eine Umweltministerin (Frau Hedricks) wusste sogar, dass es in Deutschland gar keine (von ihrer) abweichendeMeinung geben kann:

EIKE 27.03.2017: Nee, bei uns gibt´s keine Klimaleugner

Dabei fällt mit der aktuellen Diskussion zum wirklichen Forcing das ganze Alarmgebäude in sich zusammen:

kaltesonne, 24.12.2018: Die Sonne im November 2018 und die Sache mit der „Pause“

EIKE 17. Dezember 2018: Klimasensitivität – Wer rechnet hier falsch ?

[x] EIKE 21.02.2018: Und plötzlich wird die Zukunft glücklicher

Bei einem wahrscheinlichen Forcingwert in der Gegend von 1,5 … 1 Grad besteht keinerlei alarmistischer Anlass mehr. Sollten die dazu noch Recht behalten, welche eine Größenordnung von ca. 0,6 Grad vermuten, dann bleibt es nicht mehr als ein Rauschen im Mülleimer der Erdgeschichte.

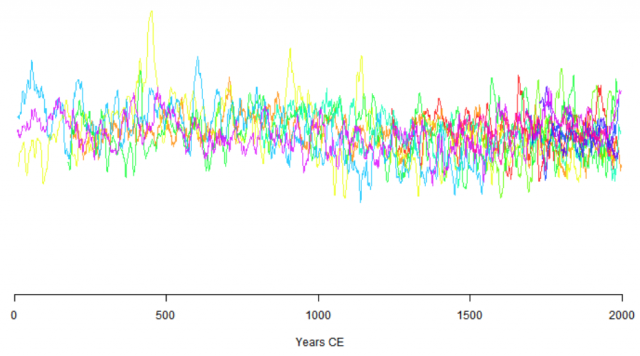

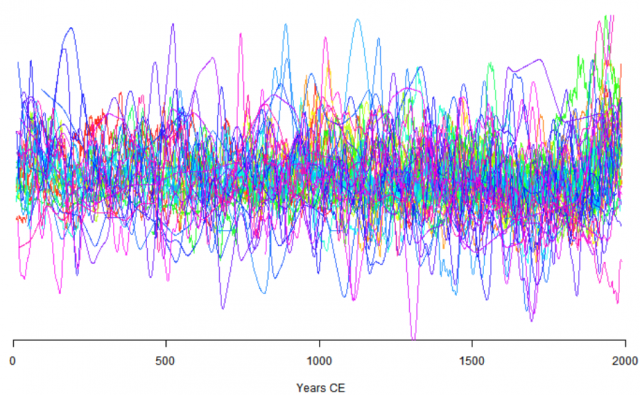

Proxibilder Kontinente/Großregionen

Wer immer noch (wie beispielsweise Professor Rahmstorf vom PIK) glaubt, mit Proxis ließen sich (ausreichend genaue) Aussagen zur Klimahistorie ableiten, der sollte sich solche einfach ansehen, wie es der Autor gemacht hat:

Zum Beispiel in einer exemplarischen Sichtung von Temperaturproxis des größten, von Herrn Rahmstor gelobten, internationalen Proxi-Rekonstruktions- und Sammlungsprojektes, Pages2k:

EIKE 11.05.2016: [6] Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES2k

Das gilt nicht nur für Temperatur-, sondern auch für Pegelproxis. Dort allerdings weniger wegen fehlender Genauigkeit, sondern der Erkenntnis, dass das aktuell gemessene – und als AGW-alarmistisch publizierte – “Pegelwackeln” im historischen Pegelrauschen verschwindet:

EIKE 07.04.2016: Der Verlauf des Meeresspiegels im Holozän und seit 2.000 Jahren

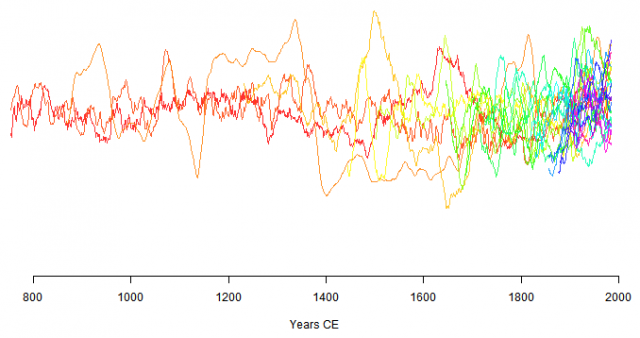

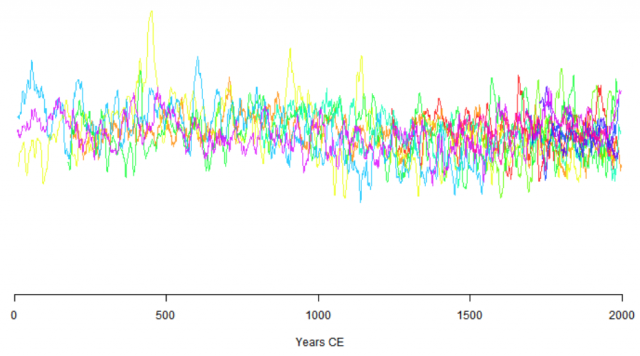

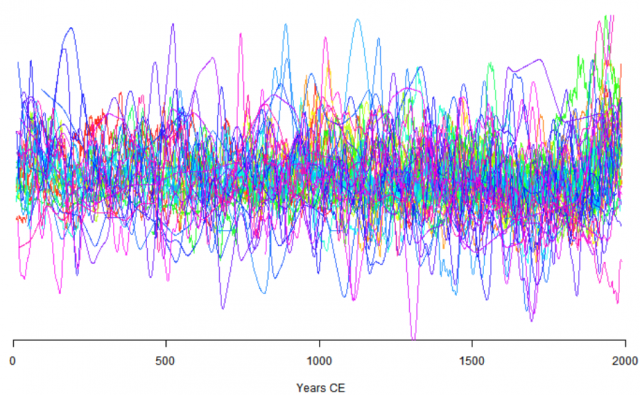

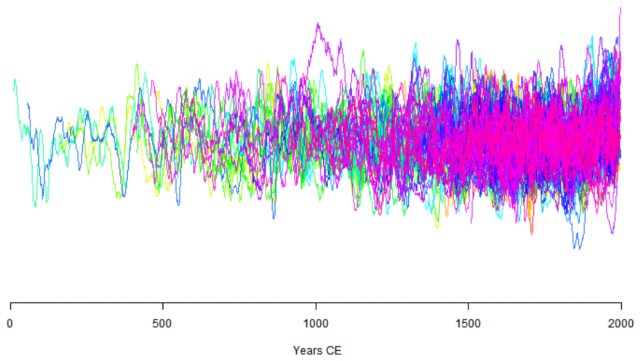

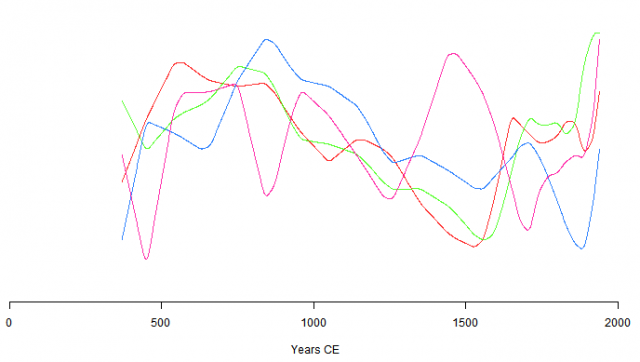

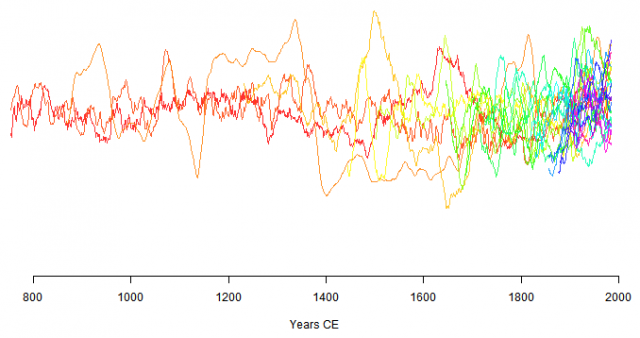

Beispielhaft nun die TemperaturProxi-Globaldiagramme für die letzten 2.000 Jahre aus dem Pages2k-Projekt für einzelne Kontinente. Die “Farbspaghettis” sind die übereinander gelegten Temperatur-Proxikurven der gleichen Region. Dabei soll es sich um die besten Proxis handeln (Kritik dazu siehe [6]).

Daraus bitte ableiten, dasss:

ein so schneller und großer Temperaturanstieg wie aktuell noch nie in der Vergangenheit vorgekommen ist,

es noch nie (in den letzten 2000 Jahren) so warm war wie heute,

die Erde unaufhaltsam der “Selbstverbrennung” entgegengeht, da Temperatur-Kipppunkte bereits überschritten sind.

Bild 19 Antarctic. Quelle: Pages2k-Viewer

Bild 20 Arctic. Quelle: Pages2k-Viewer

Bild 21 Australien. Quelle: Pages2k-Viewer

Bild 22 Europe. Quelle: Pages2k-Viewer

Bild 23 Asia. Quelle: Pages2k-Viewer

Bild 24 NAmerica. Quelle: Pages2k-Viewer

Bild 25 SAmerica. Quelle: Pages2k-Viewer

Quellen

[1] NoTricksZone 13. December 2018: A Fabricated ‘Uptick’? Marcott’s 2013 Hockey Stick Graph Debunked By Marcott’s Own 2011 Ph.D Thesis

[2] Marcott et al., 2013: A Reconstruction of Regional and Global Temperature for the Past 11,300 Years

[3] Marcott, 2011: Late Pleistocene and Holocene Glacier and Climate Change

[4] Stefan Rahmstorf, 17. Juni 2013: BLOG KlimaLounge – Nah dran am Wandel Paläoklima: Das ganze Holozän

[5] kaltesonne 17. April 2013: Nach drei Wochen erneutem Hockeyschläger-Alarm war der Spuk wieder vorbei und der Skandal perfekt: Wie Jungforscher Shaun Marcott die Medienwelt hinters Licht führte

[6] EIKE 11.05.2016: Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES2k

[7] EIKE 29.09.2016: Aus dem Lehrbuch zur Erzeugung von Klimaalarm Teil 1