Das Picasso-Problem

Was ist üblicherweise mit Klima-Sensitivität gemeint? Um das zu erklären, muss ich einen kleinen Umweg machen. Erstens, einfallende Strahlung [Downwelling].

„Downwelling“ in der Klimawissenschaft bedeutet die auf die Oberfläche des Planeten treffende Strahlung. Einfallende Strahlung ist die Gesamtstrahlung in Richtung Erdoberfläche. Sie setzt sich zusammen aus Sonnenlicht (kurzwellig) plus thermischer Strahlung aus der Atmosphäre (langwellig). In der Klimawissenschaft nennt man diesen Parameter, also die gesamte einfallende Strahlung „Antrieb“ [Forcing F].

Das zentrale Paradigma der modernen Klimawissenschaft lautet, dass wenn sich die Stärke der einfallenden Strahlung (Forcing) ändert, sich auch die Temperatur an der Oberfläche notgedrungen ändert. Es wird behauptet, dass sich alles andere heraus mittelt, und falls das Forcing sich verstärkt, muss sich auch die Oberflächentemperatur ändern, um das globale Energie-Gleichgewicht zu erhalten. Sie muss sich ändern! Sie muss!

Kurz gesagt lautet das zentrale Paradigma der modernen Klimawissenschaft:

Langfristig ist die globale Temperaturänderung proportional zur Änderung der globalen Forcings.

Die vermeintlich konstanten Proportion zwischen beiden Größen, also Temperatur-Änderung dividiert durch Forcing-Änderung, nennt man „Klima-Sensitivität“.

Klima-Sensitivität wird oftmals ausgedrückt als die mutmaßliche Temperaturänderung bei einer Änderung der einfallenden Strahlung von 3,7 Watt pro Quadratmeter (W/m²). Die Berechnung dieser so genannten „Klima-Sensitivität“ ist eine zentrale Frage, die sich rund um das Paradigma erhebt, dass Temperaturänderung proportional zu Temperaturänderung ist.

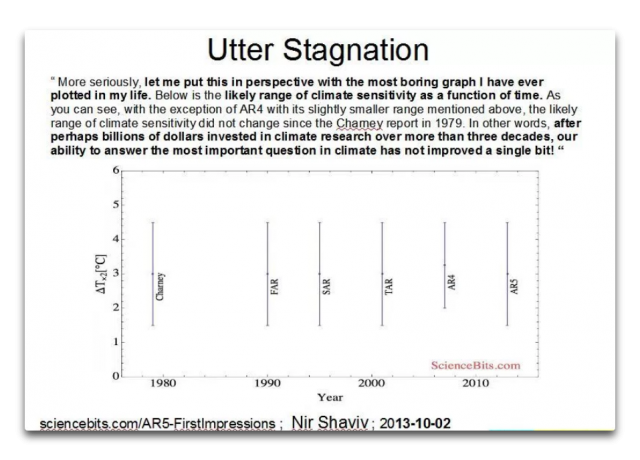

Und das bringt mich zu der höchst langweiligen Graphik unten. Sie zeigt die Änderungen der Schätzung des Wertes der Klima-Sensitivität über die Zeit:

Abbildung 1: Änderungen über die Zeit der Schätzung des Klima-Sensitivitäts-Parameters „lambda“. „∆T2x(°C)” ist die erwartete Temperaturänderung in Grad Celsius bei einer Verdoppelung des atmosphärischen CO2-Gehaltes, von welcher man annimmt, dass sie das Forcing um 3,7 W/m² verstärken wird. Mit den Abkürzungen FAR, SAR, TAR, AR4, AR5 sind die fünf Zustandsberichte des IPCC gemeint, welche eine Zustandsbeschreibung des Status‘ der Klimawissenschaft zum jeweiligen Zeitpunkt der Berichte sind.

[Bildinschrift oben in der Graphik: UTTER STAGNATION – Dr. Shaviv schreibt: „Lassen Sie mich das in eine Perspektive bringen mit der langweiligsten Graphik, die ich je in meinem Leben geplottet habe. Die Graphik zeigt die wahrscheinliche Bandbreite der Klima-Sensitivität als Funktion der Zeit. Wie man sieht, hat sich die wahrscheinliche Bandbreite der Klima-Sensitivität seit dem Charney-Report aus dem Jahr 1979 nicht verändert, wenn man vom AR 4 mit einer etwas geringeren Bandbreite absieht. Mit anderen Worten: Nach vermutlich Milliarden Dollar, welche über mehr als drei Jahrzehnte in die Klimaforschung gepumpt worden waren, hat sich unsere Fähigkeit, die wichtigste Frage bzgl. Klima zu beantworten, nicht einmal ansatzweise verbessert!“]

Es ist der Erwähnung wert, dass seit dem Jahr 1979 gesamte neue Wissenschaftsbereiche wie die DNA-Analyse erstmals aufkamen und inzwischen erstaunliche Niveaus der Entwicklung erreicht haben … und das über die gleiche Zeit, in der die von Dr. Shaviv als die „bedeutendste Frage bzgl. Klima“ bezeichnet keinerlei Entwicklung aufweist. Überhaupt keine.

Seit 1979 ist die Rechenleistung der uns zur Verfügung stehenden Computer explodiert, sowohl individuell als auch bei großen Organisationen. Mein zuverlässiger PowerMac hat mehr Rechenleistung als den meisten Universitäten im Jahre 1979 zur Verfügung stand. Die Kosten sind ebenfalls gesunken, von 100.000 Dollar pro MIPS (Millionen Befehle pro Sekunde) auf weniger als 1 Dollar pro MIPS heute. Und die Geschwindigkeit der Rechenleistung hat alle Grenzen gesprengt, laufen doch über die Super-Computer Klimamodelle mit über einer Billion Rechen-Operationen in jeder Sekunde. Auch die Anzahl der sich mit der Erforschung des Wertes der Klima-Sensitivität befassenden Personen hat mit der Zeit zugenommen. Und Milliarden über Milliarden Dollar wurden aufgebracht, um die Frage zu beantworten.

Fazit: Seit dem Charney-Report im Jahre 1979 bzgl. Klima-Sensitivität gab es eine ebenso horrende wie unsinnige Zunahme bei:

● Computerleistung bzgl. der Frage

● Stunden intensiver Forschung bzgl. der Frage

● Diskussionen, Debatten und Interesse bzgl. der Frage

● Aufgebrachtes Geld bzgl. der Frage

Und trotz dieser ungeheuren Steigerung von Zeit, Arbeit, Diskussionen und Computerleistung hat sich die Untersuchung der Frage nach dem Wert der Klima-Sensitivität genau Null Millimeter bewegt. Keinerlei Fortschritt.

Wie können wir diese wissenschaftliche Eigenartigkeit einordnen? Was steckt dahinter, dass all die aufgebrachte wertvolle Zeit, Geld und Mühen genau nichts erreicht hat? Ich meine Null. Gar nichts. Keinerlei Bewegung. Die langweiligste Graphik.

Ich schlage mal als Grund vor, dass die Klimawissenschaft das Opfer von etwas ist, das ich das „Picasso-Problem“ nenne. Pablo Picasso sagte nämlich einmal etwas, das mir noch sehr lange im Kopf herumging:

„Welchen Nutzen haben Computer? Sie können doch nur Antworten geben“.

Ich selbst habe mein erstes Computerprogramm im Jahre 1963 geschrieben, also vor mehr als einem halben Jahrhundert. Damals war ich sechzehn Jahre alt. Ich ließ es auf einem Computer von der Größe eines kleinen Raumes laufen. Seitdem programmiere ich Computer. Ich habe Programme für alles geschrieben, von Stoffdesign für große Zelte [catenary tents ?] über die Berechnung der Gezeiten des nächsten Jahres aus den Gezeiten-Tabellen dieses Jahres bis hin zur Erstellung der Graphiken in diesem Beitrag. Und mit den Jahren habe ich auch ziemlich Kohle gemacht mit meiner Erfahrung bzgl. Computer.

Wenn ich also lese, dass Picasso Computer mit jener Feststellung abschreibt, lautete meine spontane Antwort „Was?! Computer sind großartig! Worauf will dieser verrückte Künstler hinaus? Ich habe viel Geld verdient mit meinen Computern. Wie können sie unnütz sein?“

Aber nach gründlicherem Nachdenken erkannte ich, dass Picasso recht hatte. Er meinte Folgendes:

„Selbst der allerbeste Computer kann keine richtige Antwort geben, wenn man ihm zuvor nicht die richtige Frage stellt“.

Das war für mich eine grundlegende Erkenntnis, eine, die mich über viele meiner wissenschaftlichen Unternehmungen geleitet hat – man konzentriere sich nicht zu sehr auf die Antworten. Man muss auch die Fragen in den Mittelpunkt rücken.

Betrachtet man nun also die Klimawissenschaft – welches ist die falsche Frage, welche die richtige? Auch hier möchte ich wieder ein wenig abschweifen.

Mein Interesse an der Klimawissenschaft wurde um die Jahrtausendwende geweckt, und zwar wegen der inflationären Zunahme von Untergangsprophezeiungen eines drohenden ThermageddonTM. Also begann ich, mich mit den Grundlagen zu befassen und zu lernen, wie der schlecht bezeichnete „Treibhauseffekt“ die Erde weit wärmer hält als es auf dem Mond ist, der etwa die gleiche Entfernung von der Sonne hat.

Allerdings habe ich im Zuge dieses Interesses gelesen, dass das Best Estimate der Erwärmung über das gesamte 20. Jahrhundert in der Größenordnung von 0,6°C aufgetreten war. Da kam mir spontan der Gedanke „Was – weniger als ein Grad?! All dieses Brimborium, und die Temperatur hat sich um weniger als 1 Grad geändert?“

Ich war überrascht wegen meiner Erfahrung mit der Reparatur von Maschinen mit einem Regler und aufgrund meiner Erfahrung mit Sonnenenergie. Ich betrachtete das Klima als eine gigantische, von der Sonne angetriebene Wärmemaschine, wobei die Sonnenenergie konvertiert wird zu der unablässigen Bewegung der Atmosphäre und der Ozeane gegen die bremsende Wirkung der Reibung und vielem mehr.

Wenn man die Effizienz oder andere Charakteristika einer Wärmemaschine analysiert, oder wenn man Dinge wie die Stefan-Boltzmann-Gleichung verwendet, um Temperatur in das Äquivalent thermischer Strahlung zu konvertieren, muss man die Kelvin-Temperaturskala (K) heranziehen. Diese Skala beginnt am absoluten Nullpunkt. Temperatur ist eine Funktion der Bewegung von Molekülen oder Atomen, und am absoluten Nullpunkt hören diese Bewegungen vollständig auf.

Man kann für derartige Berechnungen nicht die Celsius- oder die Fahrenheit-Skala heranziehen, weil beide willkürlich gewählte Nullpunkte haben. Nur mit der Kelvin-Skala funktionieren diese Berechnungen. Kelvin hat die gleichen Abstände der Einheiten wie Celsius und lediglich einen anderen Nullpunkt, nämlich minus 273,15°C.

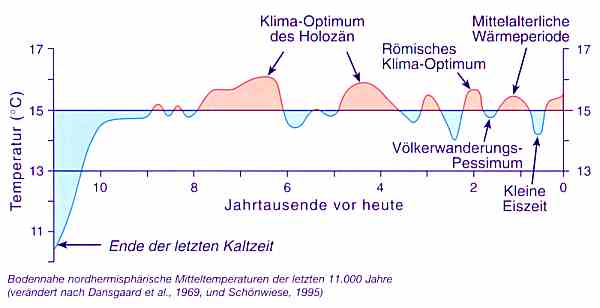

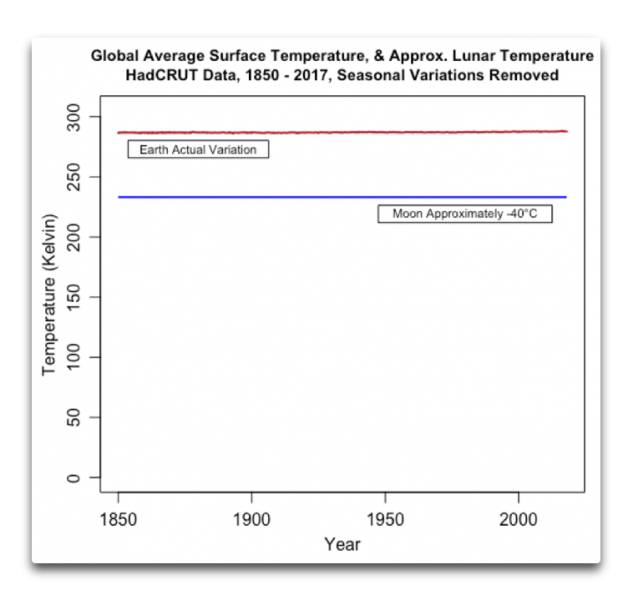

Nun beträgt die mittlere Temperatur an der Erdoberfläche größenordnungsmäßig 14°C – oder 287 Kelvin. Und mit dieser mittleren globalen Temperatur von 287 Kelvin macht die globale Temperatur-Variation von 0,6 K über das 20. Jahrhundert gerade mal ein Fünftel von einem Prozent aus.

Dies war die Seltsamkeit, die mich bei meinen Untersuchungen bzgl. Klima begleitete … über einen Zeitraum von 100 Jahren hat die Temperatur nur mit etwa einem Fünftel eines Prozentes variiert. Das war für mich umwerfend. Ich hatte viel Erfahrung mit geregelten Systemen wegen meiner Arbeit mit elektrischen Generatoren. Diese müssen genau geregelt werden, damit ihre Geschwindigkeit konstant bleibt trotz der sich ändernden Last des Systems. Und bei dieser meiner Arbeit habe ich herausgefunden, dass es ziemlich schwierig ist, innerhalb eines Prozents regelnd in ein mechanisches System einzugreifen.

Und jetzt: Trotz Dürren und Überschwemmungen, trotz großer Vulkanausbrüche, trotz sich konstant ändernder globaler Wolkenbedeckung, trotz aller Arten von Änderungen des Antriebs, trotz hemisphärischer Temperaturänderungen um ~13°C zweimal pro Jahr in jedem Jahr, trotz des Ausgleichs des Globus‘ bzgl. eines Treibhauseffektes, der den Planeten um rund ~50°C wärmer hält als den Mond … trotz all dieser Änderungen und Variationen variierte die mittlere Temperatur der Erde nicht stärker als ein Viertel Prozent im Laufe eines ganzen Jahrhunderts.

Das ist eine erstaunlich enge Regelung. Hier folgt ein Beispiel aus der realen Welt, warum mich diese Stabilität überrascht hat.

In meinem Auto gibt es einen Geschwindigkeits-Regler. Den kann man auf eine bestimmte Geschwindigkeit einstellen, die dann stur gehalten wird, egal ob das Auto beladen ist oder nicht. Bei starkem Gefälle ändert sich die Geschwindigkeit geringfügig um plus/minus 1 km/h. Das heißt, diese vom Computer gesteuerte Regelung hält die Bandbreite der Geschwindigkeit innerhalb 2% … aber die Temperatur der Erde ist sogar noch viel besser reguliert. Sie schwankt innerhalb von plus/minus einem Zehntel Prozent.

Zu jener Zeit war diese thermische Stabilität für mich ein untrügliches Anzeichen für die Existenz irgendeines unbekannten natürlichen thermostatischen Prozesses, der auf sehr effiziente Art und Weise die Temperatur innerhalb dieser geringen Bandbreite hält. Also sah ich es als meine Aufgabe im Bereich Klimawissenschaft, das Phänomen zu finden, welches diese enge Bündelung der planetarischen Temperatur über Jahrhunderte hinweg bewirkt.

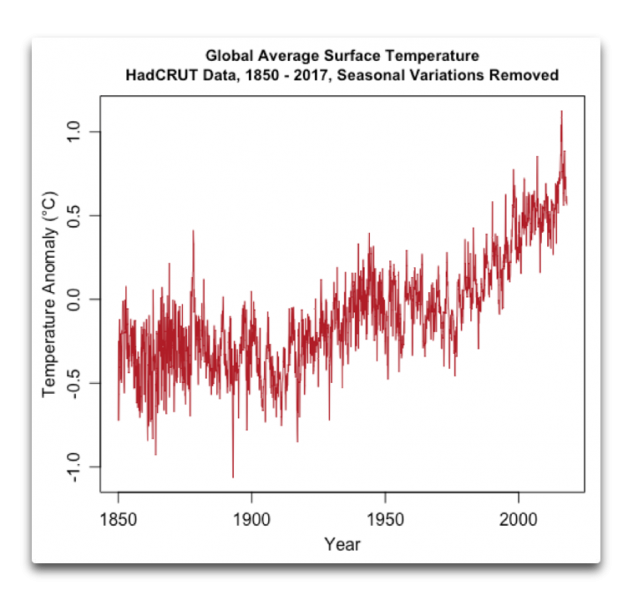

Was ich in eine eigentümliche Lage brachte. Alle etablierten Klimawissenschaftler versuchten und versuchen immer noch herauszufinden, warum sich die Temperatur so stark ändert. Sie verbrachten Zeit damit, auf Graphiken wie die Folgende zu starren, welche die Variationen der Temperatur auf der Erde zeigt:

Andererseits wollte ich als jemand mit Interesse für Wärmemaschinen und Regler versuchen herauszufinden, warum sich die Temperatur so wenig geändert hat. Dabei zog ich genau die gleichen Daten heran wie in Abbildung 2, habe sie aber anders dargestellt:

Abbildung 3: tatsächliche globale Mitteltemperatur (nach den gleichen Daten wie in Abbildung 2) sowie die angenäherte mittlere Mondtemperatur in Kelvin.

Und das bringt mich nach dem Beackern dieses entfernt liegenden Bereiches zurück zu der Frage nach der Klima-Sensitivität und der weitsichtigen Frage von Picasso: „Wozu sind Computer nütze? Sie können doch nur Antworten geben!“

Meine Aussage: Der Grund dafür, warum wir Jahrzehnte lang überhaupt keine Fortschritte gemacht haben, die Klima-Sensitivität zu berechnen oder zu messen ist, dass wir unsere unermessliche Computerleistung bemühen, um die Antwort auf die Frage zu finden, warum sich die globale Temperatur so stark ändert.

Für mich ist das die völlig falsche Frage. Stattdessen sollten wir viel eher die folgende Frage stellen:

Warum ändert sich die globale Temperatur nur so geringfügig?

Nach vielem Nachdenken und noch mehr Forschung erkenne ich, dass der Grund für die nur so geringe Änderung der globalen mittleren Temperatur NICHT die Proportionalität derselben zu irgendwelchen Antrieben ist, wie allgemein angenommen wird. Als Ergebnis ist die so genannte „Klima-Sensitivität“ keine Konstante, wie vermutet wird … und weil das so ist, ist der Versuch, den exakten Wert zu berechnen, vergebliche Mühe, weil es keinen festen Wert gibt. Darum auch können wir auch nicht den geringsten Fortschritt erzielen, sie zu messen … weil es eine Chimäre ist auf der Grundlage eines falschen Verständnisses dessen, was vor sich geht.

Stattdessen lautet meine Hypothese, dass die Temperatur durch eine Vielfalt von Phänomenen innerhalb dieser geringen Bandbreite gehalten wird. Sie kühlen die Erde, wenn es zu warm wird, und erwärmen sie, falls es zu kalt wird. Ich habe eine große Vielfalt von beobachteten Beweisen gefunden, dass dies tatsächlich der Fall ist. Siehe dazu auch die Links zu vielen Beiträgen, die ich zu diesem Thema bereits geschrieben habe*.

[*Siehe unten]

Aber das ist jetzt nur meine Antwort. Und ich bekenne sofort, dass diese durchaus falsch sein kann … aber zumindest ist es eine Antwort auf die richtige Frage. Das wirkliche Mysterium des Klimas ist dessen erstaunliche thermische Stabilität.

Und schließlich, wie kommt es, dass ein ganzer Wissenschaftsbereich sich abmüht zu versuchen, die falsche Frage zu beantworten? Ich sage, dass dies die Folge der Erschaffung des IPCC seitens der UN ist.

Im Jahre 1988 war der Bereich Klimawissenschaft ein ganz neuer Bereich. Trotzdem jedoch waren die UN bereits davon überzeugt, dass man genau wusste, um welches Problem es sich handelt. Typische bürokratische Arroganz. Als Folge davon heißt es in der Resolution 43/53 der Vollversammlung aus dem Jahre 1988 (die das IPCC hervorbrachte):

Die Vollversammlung ist besorgt hinsichtlich menschlicher Aktivitäten, welche das globale Klima verändern können, wodurch gegenwärtige und zukünftige Generationen von ernsten ökonomischen und sozialen Konsequenzen bedroht sind.

Man nimmt besorgt zur Kenntnis, dass Beweise zunehmend darauf hindeuten, dass die fortgesetzte Zunahme der Konzentration von „Treibhaus“-Gasen eine globale Erwärmung hervorrufen könnte mit einem eventuellen Anstieg des Meeresspiegels, deren Auswirkungen katastrophal für die Menschheit sein können, wenn nicht rechtzeitig in allen Bereichen Gegenmaßnahmen getroffen werden.

Und als Erwiderung sprang man sofort zu der Frage, ob sie wissenschaftlich korrekt war oder nicht; und man ging direkt dazu über, Maßnahmen gegen etwas zu ergreifen, von dem die Vollversammlung nicht die geringste Ahnung hatte. Die Resolution sagte, dass …

…die Vollversammlung rechtzeitig notwendige Maßnahmen ergreifen sollte, um das Problem Klimawandel innerhalb eines globalen Rahmens anzugehen.

Rufe nach Maßnahmen machen Bürokraten immer glücklich. Also wurde das IPCC, eine ausgesprochen politische „zwischenstaatliche“ Organisation, de facto zur Führungskraft einer gesamten Wissenschaftsdisziplin … was sich als ein gewaltiger Fehler herausstellte.

Bis zu jener Zeit und auch danach bis jetzt gab es in allen anderen Bereichen der Wissenschaft erstaunliche Fortschritte hinsichtlich des Verständnisses ohne irgendein globales „zwischenstaatliches“ Gremium zur Anleitung ihrer Bemühungen. Es gab begeisternde Erfolge mit der gewöhnlichen wissenschaftlichen Methodik, wobei viele Wissenschaftler involviert sind, die ziemlich unabhängig auf der ganzen Welt irgendwelchen wissenschaftlichen Fragen nachgehen, manchmal in Kooperation, manchmal im Wettbewerb, ohne dass sie irgendjemanden brauchen oder haben wollen, der „die Wissenschaft zusammenfasst“, wie es das IPCC zu tun behauptet.

Und angesichts des Fehlens jedweden Fortschrittes, wie in der „langweiligsten Graphik jemals“ oben in diesem Beitrag sage ich, dass die Welt niemals wieder eine Haufen von UN-Bürokraten [pluted bloatocrats] einsetzen sollte für irgendetwas, das mit Wissenschaft zu tun hat. Hätten wir ein „zwischenstaatliches Gremium zur DNA-Analyse“ [Intergovernmental Panel on DNA-Analysis] eingerichtet, als der Bereich noch neu war, dann kann man sicher sein, dass dieser Bereich unweigerlich blind und taub unsinnigen Behauptungen hinterhergelaufen wäre wie „97% aller DNA-Wissenschaftler stimmen darin überein…“

Auf dem exzellenten Blog von Judith Curry fragte mich einmal jemand, was genau ich gegen das IPCC hätte. Ich erwiderte:

Hier sind einige Hauptgründe. Ich habe weitere.

1) Es wird ein Grad wissenschaftlicher Übereinstimmung vorausgesetzt, der einfach nicht vorhanden ist. Die meisten Menschen in dem Bereich einschließlich der Skeptiker glauben, dass sich die Welt erwärmt und dass Menschen sehr gut dazu beitragen könnten. Aber hier endet die Übereinstimmung schon. Wie groß der menschliche Beitrag ist, wie er aussieht und wie lange – zu diesen und ähnlichen Fragen gibt es keinerlei Übereinstimmung.

2) Das Gremium ist korrupt, wie unter Anderem das Jesus Paper zeigt.

3) Es ignoriert generell alles, was von der festgelegten Weisheit der Klimawissenschaft abweichen könnte.

4) Es wird von der Politik gesteuert, nicht von Wissenschaft. Bestimmte Paragraphen und Schlussfolgerungen sind verändert oder entfernt worden aufgrund politischer Einsprüche.

5) Bei dem Versuch, Entwicklungsländer mit ins Boot zu holen, wurde eine Anzahl sehr schlechter Wissenschaftler eingestellt.

6) Jedwede Organisation, die einen Leiter wie Rajendra Pachauri bekommt, ist sehr, sehr schlecht.

7) Man hat wirkliche Unsicherheiten ignoriert und diese ersetzt durch vollkommen subjektive Schätzungen der Unsicherheit.

8) Man hat Dinge wie die Hockeyschläger-Studie und die zahlreichen „Stick-alikes” veröffentlicht, obwohl es sich dabei um eklatant schlechte Wissenschaft handelt [laughably bad science]

9) Man erstellt „Projektionen“, die wenig oder gar nichts zu tun haben mit der realen Welt, wie etwa den Representative Concentration Pathway 8.5 (RCP 8.5).

10) Skeptiker aller Arten werden generell ausgeschlossen, entweder direkt oder weil die Skeptiker Besseres zu tun haben als sich einer solchen Organisation anzudienen.

11) Jeder, der „Projektionen“ erstellt, die über das Jahr 2010 hinausgehen, bläst Schall und Rauch in die Luft [der Autor drückt es drastischer aus. Anm. d. Übers.]

12) Man macht sich viel, viel zu stark abhängig von ungeprüften, nicht verifizierten und nicht validierten Klimamodellen.

13) Das IPCC denkt generell ohne nachzudenken, dass Erwärmung schlecht, schlecht, schlecht ist … was das Gegenteil der wirklichen Auswirkungen der Erwärmung seit der Kleinen Eiszeit ist.

14) Dem IPCC wurde die falsche Aufgabe bei seiner Gründung übertragen. Anstatt es zu beauftragen herauszufinden, was nun wirklich das Klima kontrolliert, übertrug man ihm die Aufgabe herauszufinden, wie viel CO2 wir emittieren dürfen, bevor es gefährlich wird. Diese Aufgabenstellung setzte eine Vielfalt von Dingen voraus, die niemals begründet worden waren.

15) … ach was, das reicht jetzt! Wen es interessiert – ich kann noch viele weitere Gründe benennen.

Das also ist das Klima-Picasso-Problem. Der Bereich Klimawissenschaft versucht, mittels Computern Antworten auf die falsche Frage zu finden, und als Folge davon führt der Bereich ins Nirgendwo.

Link: https://wattsupwiththat.com/2018/11/17/the-picasso-problem/

Übersetzt von Chris Frey EIKE

[Im Original folgen jetzt die o. g. Angesprochenen Links zu den Beiträgen von Willis Eschenbach zu diesem Thema. Aus Zeitgründen und weil sie nicht direkt zum Thema dieses Beitrags passen, werden diese hier aber nicht mit übersetzt. Anm. d. Übers.]