Über die Illusion der Minderung des CO2-Ausstoßes durch Ausstieg aus der Kohle ohne existierende Stromspeicher

Das bedeutet dann weiterhin, dass

a) die Umstellung von Verbrennungsmotoren auf Elektromotore keinen Sinn macht

b) die geforderte Verminderung des CO2-Aussoßes bei Verbrennungsmotoren auf Mittelwerte für die jeweilige Autoflotte in 2021 auf 95 g CO2/km (etwa 3-4 l/100 km) und die jüngst in der Diskussion stehende weitere Verminderung um 35% bis 2030 für Deutschland völlig obsolet geworden ist, da diesen Extremforderungen nur durch einen erheblichen Anteil an Elektroautos nachgekommen werden könnte.

Um weiteren nicht mehr rückängig zu machenden Schaden von Deutschland abzuwenden, muß Abschied genommen werden von dieser „Klimaromantik“ (CO2 hat keinen Einfluß auf das Klima) und die komplette Energiewende eingestampft und neu überdacht werden.

_______________________________________________________________

Die Kohlekommission zum Ausstieg aus der Braunkohle zur Absenkung des CO2-Ausstieges hat ihre Arbeit aufgenommen, spätestens am Ende des Jahres soll sie liefern.

Erste Aussagen dringen bereits durch: kurzfristige Abschaltung von Braunkohlekraftwerkskapazität von 5 Gigawatt (GW), Verzicht auf den Anschluß des modernen Uniper-Steinkohlekraftwerkes in Datteln (1,1 GW-Block) mit einem Wirkungsgrad von 58%, das Klima-freundlichste Kohlekraftwerk Deutschlands.

Deutschland ist ein hoch technologiesiertes Industrieland, dessen Entscheidungen früher auf der Basis von Fakten getroffen wurden. Mit dem Beginn der zahlreichen Energiewenden hat Deutschland den Pfad der Faktenlage verlassen, das Wort des Jahres 2016 war „postfaktisch“.

Eine gründliche Diskussion einer Fehleranalyse zur Durchführung der Energiewende hat es nie gegeben, man schlittert von einer Energiewende in die andere.

So wurde nie die Frage diskutiert, ob die Energiewende bei einer von der Abnahme der Stromverbraucher stark abhängige und schwankende Leistungsanforderung mit der flatternden Stromerzeugung über Wind+Sonne überhaupt möglich ist und ob bei den technisch möglichen Gegebenheiten (Stromspeicher) über eine Herausnahme der Kohle im Strommix eine Absenkung des CO2-Ausstoßes überhaupt funktionieren kann.

- Nach dem Atomausstieg nun der Ausstieg aus der Kohle analog zur Anhebung der erneuerbaren Energien auf 65% bis 2030 und darüber hinaus (Koalitionsvertrag 2018)

In einer früheren Arbeit (1) war die Anhebung der erneuerbaren Energien auf 65% bis 2030 auf Kosten des Kohleanteiles auf der Basis der Zahlen des Jahres 2017 quantifiziert worden einschließlich einer Betrachtung der Verhältnisse bis zum 100%igen Anteil an erneuerbaren Energien, so dass im Folgenden die Berechnungsschritte im Einzelnen nicht mehr aufgeführt werden müssen. Als Ergebnis soll hier nur noch einmal festgehalten werden:

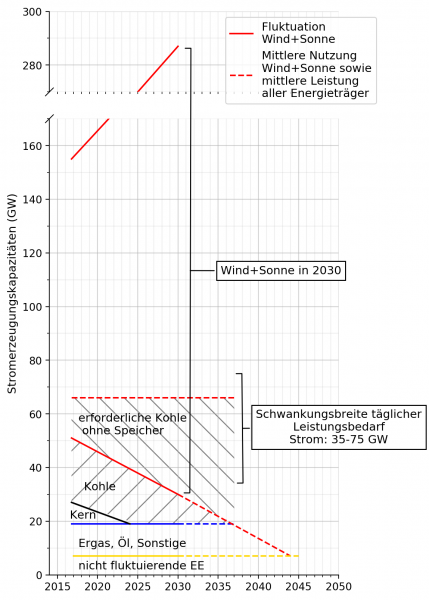

a) Bei einer Anhebung der Erneuerbaren auf 65% bis 2030 kann über Braun- und Steinkohle nur noch eine Leistung von 1,4 bzw. 9,6 GW beigestellt werden. Dazu muß eine Leistung über Wind+Sonne von 250 GW installiert werden (vgl.später auch Bild 3).

Zur Aufrechterhaltung der Stromerzeugung müssen jedoch in 2030 im Jahresmittel Stromspeicher mit einer Kapazität von 435 GWh/Tag bzw. einer Leistung von 18 GW zur Verfügung stehen.

Das schließt nicht aus, dass an einzelnen Tagen die klomplette über Wind+Sonne beizustellende Leistung gegen null gehen kann, d.h. dass die Stromspeicher in der Lage sein müssen, eine Tagesleistung von 1610 GWh abzudecken oder gar eine 14-tägige Windflaute (vgl. später).

Um eine tägliche Spitzenanforderung von 80 GW abzudecken, müssen Wind- und Solaranlagen mit einer Kapazität von 310 GW installiert werden bei einer gleichzeitigen Erfordernis einer mittleren Stromspeicherleistung von 22,4 GW – eine Illusion. (vgl.später)

b) Bei Fortführung der Geschwindigkeit der Anhebung der Erneuerbaren über 2030 hinaus könnte in 2037 auf Kohle komplett verzichtet werden, wenn 327 GW über Wind- und Solaranlagen installiert werden. Zur Abdeckung einer täglichen Leistungsanforderung von 80 GW wären dann bereits 420 GW erforderlich, ohne noch einmal die müßige Frage der Stromspeicherung strapazieren zu wollen.

c) Soll auch noch auf die restlichen Kohlenstoffträger wie Erdgas, Öl, Sonstige im Strommix zugunsten der Erneuerbaren verzichtet werden (das wäre 2044 möglich) – schließlich soll nach den jüngsten Vorstellungen des IPCC in 2050 der CO2-Ausstoß weltweit bei null liegen -, erhöht sich die zu installierende Leistung für Wind+Sonne auf 412 GW, bei einer täglichen Leistungsanforderung von 80 GW auf 505 GW.

d) Auf das Problem des Ausbaues der Netzkapazität soll hier nicht eingegangen werden.

- Sichtbarmachung des Problems der Stromversorgungssicherheit

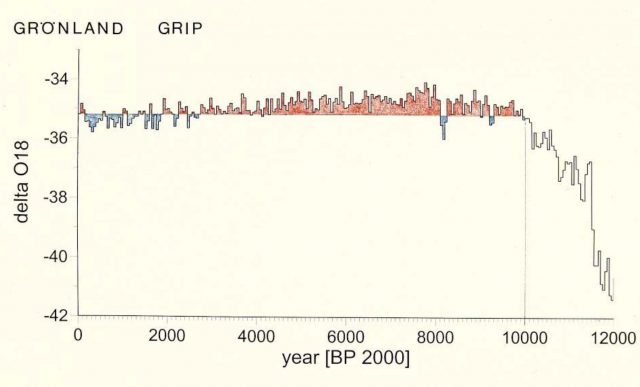

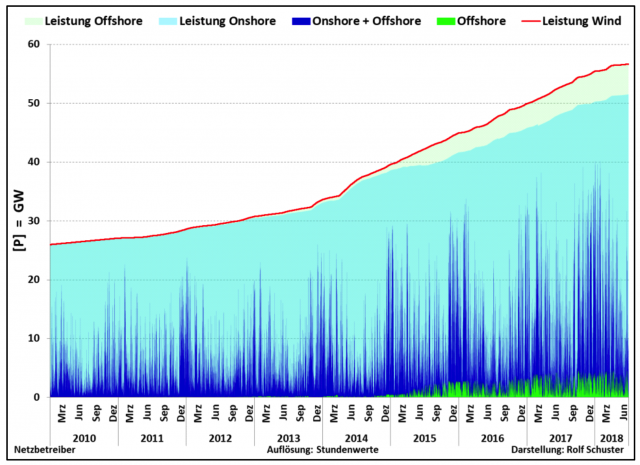

In Bild 1 ist die Entwicklung des Ausbaues der Windleistung onshore und offshore von 2010 bis Juni 2018 auf der Basis von Stundenwerten dargestellt. (2) Lag in 2010 die installierte Leistung (rote Linie) noch bei etwa 27 GW, so stieg sie in 2018 auf über 55 GW an.

Bild 1: Entwicklung der installierten und erzielten Windleistungen

Erkennbar ist eine permanente starke Streuung der Stromleistungen zwischen praktisch null GW und nahe an die Installationsleistung heranreichende Werte, die bei einer Auflösung der Stundenwerte in kleinere Zeiteinheiten anzunehmen sind.

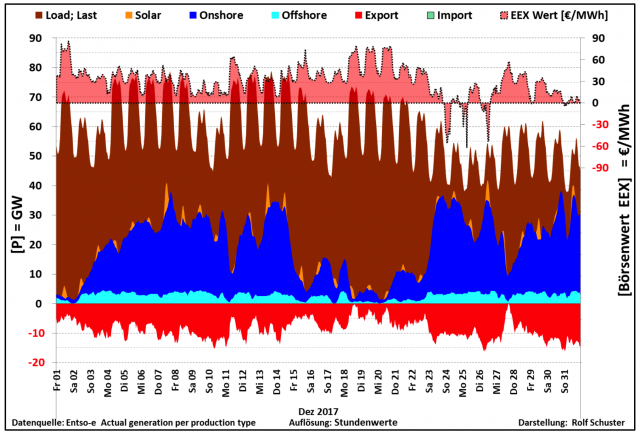

Bild 2: Schwankungsbreite der vom Verbraucher geforderten und von den alternativen Energien gelieferten Leistungen im Dez. 2017

Wird mit der Windstromleistung gleichzeitig die Solarleistung wie in Bild 2(Beispiel Dez. 2017) (3) im Verbund mit der vom Verbraucher gefordenden Leistung („Load; Last“) dargestellt, so bedarf es nur geringer intellektueller Fähigkeiten um zu begreifen, dass eine gesicherte Stromerzeugung bei ausschließlich erneuerbare Energien ohne einen Ausgleich der Streubreite der gegebenen Leistungen über Wind+Sonne ohne eine ausreichende Kapazität an Stromspeichern oder konventionellen Stromerzeugern als Illusion anzusehen ist.

Es ist deulich zu erkennen, dass bei einem Anteil an erneuerbaren Energien von etwa 30% die erzeugte Leistung teilweise gegen null geht und teilweise bereits an die von den Verbrauchern geforderte Leistung heranreicht. Wenn nun die Erneuerbaren im ersten Schritt auf 65% in 2030 angehoben werden sollen oder gar auf 100%, so wird die unabdingbare und sofortige Forderung nach funktionierenden Stromspeicher deutlich.

Bild 2zeigt zudem den Stromimport wie -export sowie die an der Strombörse gehandelten Strompreise. Die teilweise negativen Strompreise machen bereits jetzt die Notwendigkeit der Stromspeicher deutlich.

Aber das einzige z.Z. diskutierte Speicherverfahren Power-to-Gas ist von einer technischen Reife und Bezahlbarkeit bei solchen zu speichernden Strommengen in 2030 meilenweit entfernt. In 2030 sollen gerade einmal 7,5 GW installiert sein. (4)

Es ist schon verwunderlich, wenn dann der Leiter der deutschen Sektion des Weltklimarates, C. Stolle, erst jetzt zur Kenntnis gibt: „Ambitionierte Klimaziele können nur erreicht werden, wenn erneuerbare Energien nicht nur direkt als Strom genutzt werden, sondern auch als Gas oder flüssiger Brennstoff speicherbar sind“. (FAZ, 18.10 2018)

Der Generalsekretär des europäischen Energieverbandes Eurelectric, K.Ruby, klagte, es müsse dringend diskutiert werden, wie es in ganz Europa bei den ständig weiter abgebauten Atom- oder Kohlekraftwerken eine ausreichende Menge an gesicherter Leistung geben könne.

Auch der Chef des deutschen Branchenverbandes BDEW, Kapferer, verwies auf eine Stellungnahme von 10 Verbänden: es fehle ein Konzept, wie die Versorgung in Deutschland nach der Abschaltung der Kernkraftwerke und der bis 2030 erwarteten Halbierung des Kohlestromangebotes gesichert werden könne. Dabei gehe es immerhin um etwa 30 GW. (FAZ, 11.10.2018)

- Ausschließliche Stromerzeugung aus alternativen Energien ohne ausreichende Stromspeicherkapazität und ihre Bedeutung für den CO2-Ausstoß

In der in Kapitel 1 zitierten Arbeit (1) war die Auswirkung der Erhöhung der Alternativen auf 65% bis 2030 und darüber hinaus auf Kosten des Kohleanteiles berechnet worden.

Dieses in (1) dargestellte Bild ist im Sinne der o.g. Aufgabenstellung hier leicht modifiziert worden (Bild 3).

Bild 3: Notwendiger Kohleanteil im Strommix ohne funktionierende Stromspeicher

Bild 3zeigt über den „Nicht fluktuierenden erneuerbaren Energien EE“ den Anteil „Erdgas, Öl, Sonstige“, schließlich die über Kernenergie und Kohle beizustellende Leistung von 2017 bis 2030, dann die Daten bis zum Ausstieg aus der Kohle (2037) bis hin zum gänzlichen Verzicht der Kohlenstoff-enthaltenen Energieträger wie Erdgas, Öl, Sonstige in 2044.

Über dem Anteil der mit zunehmenden Erneuerbaren abnehmende Kern- und Kohleanteil im Strommix ist die stark zunehmende zu installierende Kapazität über Wind+Sonne aufgetragen mit einer mittleren Gesamtleistung von 66,6 GW über den gesamten Zeitraum (rot gestrichelt im Bild dargestellt).

Der Wert 66,6 GW aus dem Jahre 2017 wurde im Sinne einer gleichbleibenden Stromerzeugung gleich gelassen, auch wenn der vorgesehenen Sektorkopplung („Klimaschutzplan 2050“) folgend der Wert demnächst angehoben werden müßte, so das Ganze denn funktionieren kann.

Die über Wind+Sonne eingestellte mittlere Stromerzeugungskapazität von 66,6 GW besagt bei den in den Bildern 1 und 2aufgezeigten Streubreiten der Leistungsträger Wind+Sonne , dass der oberhalb dieses Mittelwertes anfallende Strom aus Wind+Sonne gespeichert werden muß, um ihn dann bei Wind- und Solarleistungen unterhalb des Mittelwertes wieder einspeisen zu können.

Wenn diese Stromspeicher nicht vorhanden sind – wovon auszugehen ist -, muß diese fehlende Leistung über Kohle gedeckt werden ((Atomkraft wird in 2022 abgestellt) (Bild 3). Das wären in 2030 36 GW, in 2037 47,1 GW Stromleistung zusätzlich über Kohle.

Ohne Stromspeicher müßte dann die oberhalb des Mittelwertes 66,6 GW anfallende Stromerzeugung ins Ausland abgeschoben werden – was bei dieser Leistung illusorisch wäre -, oder die Anlagen müssen still gesetzt werden.

Schließlich bedeuten diese Aussagen, dass ohne eine ausreichende und funktionierende Stromspeicherkapazität eine Absenkung des CO2-Ausstoßes nicht möglich ist, d.h. das Ende der Energiewende ist längstens erreicht.

Nach Aussagen des Bundesrechnungshofes kostete diese Energiewende zu allem Überfluß in den letzten 5 Jahren 150 Mrd.€ (der Hälfte des Bundeshaushaltes), alleine in 2017 34,36 Mrd. €.

Da die Stromerzeugung für etwa 50% des CO2-Ausstoßes verantwortlich zeichnet, ist ohne Stromspeicher auch der „Klimaschutzplan 2050“ gescheitert, da auch

a) eine Umstellung vom Verbrennungsmotor auf den Elektromotor nun keinen Sinn mehr macht

b) die erforderliche Verminderung des CO2-Ausstoßes des Verbrennungsmotors für die Autoflotte in 2021 auf 95 g CO2/km (entsprechend etwa 3-4 l/100 km) und die jüngst in der Diskussion stehende weitere Verminderung von 35% bis 2030 völlig obsolet geworden ist, da diese Extremforderungen nur durch einen erheblichen Anteil an Elektrofahrzeugen zustande kommen kann.

Um weiteren nicht mehr rückgängig zu machenden Schaden von Deutschland abzuwenden, muß die komplette Energiewende eingestampft werden mit einem Neuanfang ohne postfaktisches Geplänkel.

Die beste Lösung dabei wäre, die gesamten Maßnahmen zum CO2-Abbau für alle Sektoren („Klimaschutzplan 2050“) einzustellen, da CO2 ohnehin keinen Einfluß auf das Klima ausüben kann.

Die Ausarbeitungen des IPCC und ihre Modelle zum Einfluß des CO2 auf das Klima fußen auf Fake News. (1) So können die Modelle die Vergangenheit nicht nachvollziehen, wohl aber werden sie dazu mißbraucht, die Zukunft in Form von Untergangsszenarien zu beschreiben (Weltuntergang durch Verglühen durch hohe CO2-Gehalte, obwohl die Erdgeschichte schon um Potenzen höhere Zeiträume prächtig überstanden hat).

Wenn es nicht gelingt, die Deutschen von dieser „Klimaromantik“ (Einfluß von CO2 auf das Klima) und der daraus resultierenden Energiewende abzubringen, besteht die Gefahr eines irreparablen Schadens – es wäre nicht das erste Mal, dass sich Deutschland verrennt.

Quellen

- Beppler, E.: „Über eine auf Fake News des IPCC basierende Vorstellung zum Ausstieg aus der Kohle“, EIKE, 24.09.2018

2. Schuster, R.: Mitteilung 03.07.2018

3. Schuster, R.: Mitteilung 02.01.2018

4. Beppler, E.: „Energiebranche jetzt für Kohleausstieg bis 2030 – aber wo bleiben die Speicher?“; EIKE, 02.07.2018