Die Sonne im August 2018 und atmosphärische Konflikte

Die Sonne war also im letzten Monat weniger als 1/3 so aktiv wie im Mittel. An 13 Tagen des Monats war überhaupt kein Fleck zu beobachten, an den übrigen Tagen sah man diesmal die Südhemisphäre zu 74% zu den wenigen kleinen Flecken beitragen.

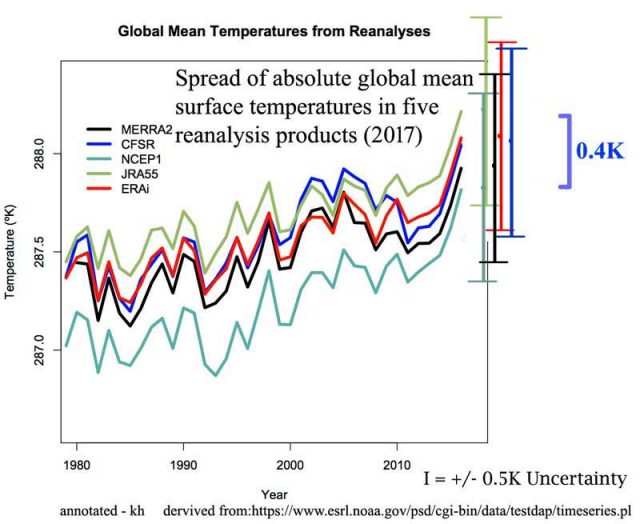

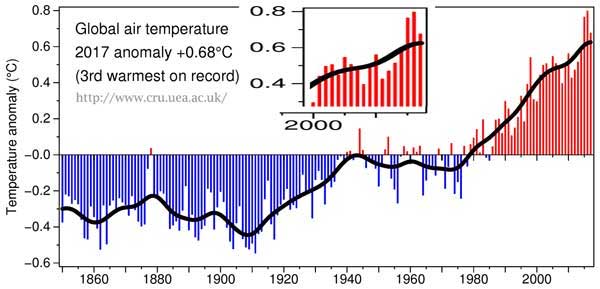

Abb.1: Die Fleckenaktivität des aktuellen SC (für SolarCycle) 24 im Vergleich zu einem mittleren Zyklus (blau) und dem im letzten Zyklusdrittel sehr ähnlichen SC5 ( schwarz).

Vieles spricht dafür, dass der Zyklus seine letzten rechnerischen 14 Monate sehr ruhig beendet. Das ist einigermaßen beruhigend wenn man weiß, dass die Sonne auch anders könnte und wohl auch schon konnte. Super-Explosionen auf der Sonne kamen schon vor: der berühmte „Carrington Event“ am 1.September 1859 ist ein Beispiel. Damals gab es einen Flare (eine Sonneruption), der erdgerichtet war und um ein Vielfaches stärker als alles, was wir in dieser Beziehung im Satellitenzeitalter beobachten konnten. Vor wenigen Wochen erschienen Arbeiten, die Ereignisse im Jahre 774 und 993 ( wir wissen von Ihnen durch globale Nachweise in Proxies) unzweifelhaft der Sonne zuordneten, und die noch etwa 20 mal so stark waren wie der „Carrington Event“.

Auch im Jahre 2012 ereignete sich ein potentiell gefährlicher Flare, der jedoch nicht erdgerichtet war. Für die heutige Infrastruktur mit ihren langen Leitungen für Energieversorgung und Kommunikation wäre ein Treffer schon sehr gefährlich, vermutlich würde auch jede Satellitennavigation ausfallen. Eine Vorhersage ist noch relativ unsicher. Mehr als 1…2 Wochen vor einem möglichen Event hätten wir vielleicht nur die Gelegenheit, uns zu wappnen, wie diese aktuelle Arbeit zeigt. Und wann ein großer energiereicher Sonnenfleck wohin genau explodiert- für solche Vorhersagen gibt es noch keine ausreichenden Modelle. Also ist bei allen Fortschritten im Wissen um die Eigenschaften unserer Sonne immer noch ein wenig Glück dabei, dass wir noch keine fundamentalen Schäden durch Sonnenstürme erleben mussten: Großflächige Blackouts, Netzwerkausfälle auf lange Zeiten, kaum noch funktionierende Navigation.

Zurück zur aktuell sehr ruhigen Sonne. Der Vergleich der Zyklen untereinander bestätigt das:

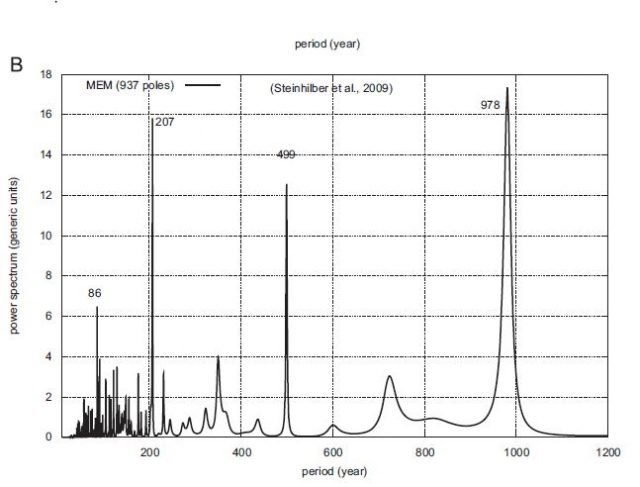

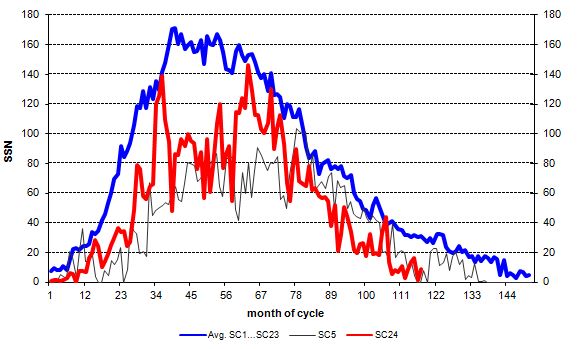

Abb.2: Die aufsummierten Abweichungen der einzelnen Zyklen vom mittleren Zyklus (blau in Abb.1). Sehr gut sichtbar: die Clusterbildung. Seit dem Zyklus 5 tauchen immer mindestens 3 Zyklen in Reihe auf, die entweder unter- oder übernormal stark waren. Einzelne Ausreißer sind nicht zu verzeichnen.

Die Vorausschau auf den Zyklus 25 wird nun immer verlässlicher: die maximale Stärke der polaren solaren Felder ist mit hoher Sicherheit erreicht. Recht wahrscheinlich ist ein nächster Zyklus, der etwa so stark ist wie der SC14, der zwischen 1902 und 1913 beobachtet wurde. Also weiterhin eine (magnetfeldtechnisch) schwache Sonne bis in die 30er Jahre der 2000er.

Atmosphärische Konflikte

Gemeint ist hier nicht das bekannte und vergnügliche Gedicht von Erich Kästner, mit dem er die interne Variabilität des Überganges Winter/ Frühjahr in Deutschland vor genau 90 Jahren mit Humor und Tiefgang beschrieb, als noch keiner verfrühte/verspätete Wärme dem Klimawandel zuschreiben wollte. Die einzigen, die blass wurden, waren die Oberkellner!

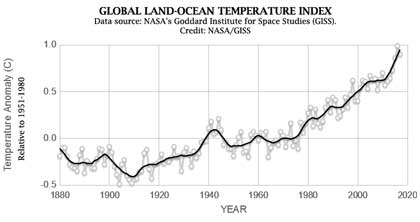

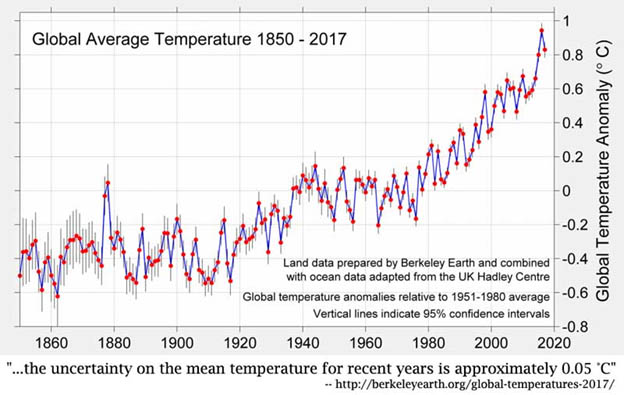

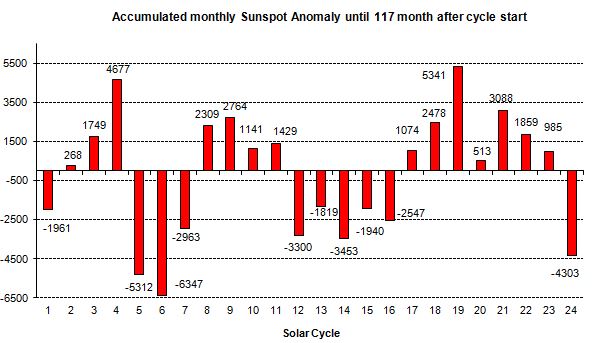

Vielmehr geht es uns um eine aktuelle Arbeit von McKitrick/Christy, in der die Autoren mit den bestmöglichen Beobachtungen seit 1958 aus Ballonaufstiegen die Erwärmung der tropischen oberen Atmosphäre auswerten. Die Temperaturen in einer Höhe von 10-13km ( 300mb-200mb), so sagen es die Modelle, erwärmen sich deutlich schneller bei jedem Temperaturanstieg als die am Boden, also auch den durch die Wirkung von Treibhausgasen. Es ist die Region in unserer Atmosphäre, die am heftigsten auf diesen Antrieb reagiert. Daher nennt man es auch den „tropischen Hotspot“.

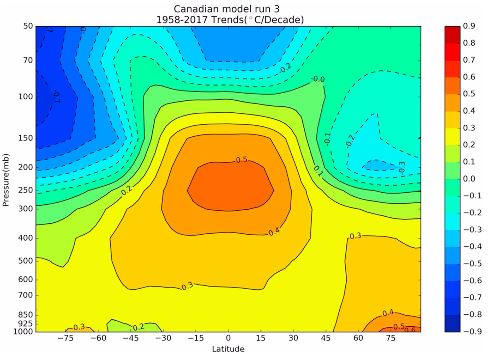

Abb.3: Der „tropische Hotspot“ in einem Klimamodell. Über den Tropen (Latitude -25°…25°) in der Höhe von 200-300mb soll sich die Troposphäre mit ca. 0,5°C/ Dekade erwärmt haben zwischen 1958 und 2017. Quelle: Fig.1 aus McKitrick et al. (2018).

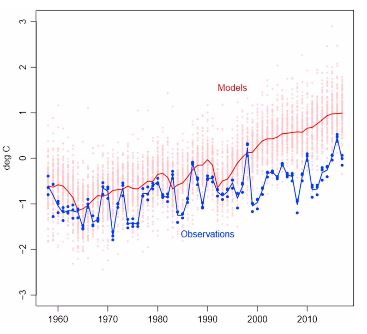

Das ist doch super, sollte man meinen. Wir haben damit eine „Vorwarnung“, die Erwärmung ist dort noch heftiger als am Boden und wir können sehr gut ablesen, wie stark es sich aufheizt, noch bevor es am Boden so manifest wird. Ganz so einfach ist es nicht! Die Luft ist recht dünn auf Reiseflughöhe der modernen Jets und daher auch sehr empfindlich auf interne Schwankungen des Klimasystems. So haben da ElNinos viel größere Ausschläge, ebenso wie Vulkanereignisse. Sie erkennen die starken Einflüsse von ENSO in Abb.4: sowohl 1997/98 als auch 2015/16/17 sieht man Ausbrüche nach oben. Bleibt ein solch starker Ausreißer aus, wird der Trend wieder auf das Niveau der letzten 40 Jahre zurückkehren. Diese Empfindlichkeit auf natürliche Schwankungen macht die Trends unsicherer.

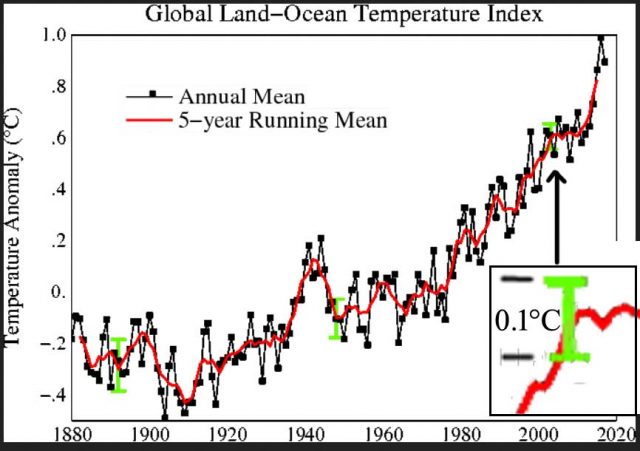

Mit Satellitenmessungen ist es auch schwierig: Um nur die fragliche troposphärische Schicht zu treffen ist eine Trennschärfe zu der darüber liegenden Stratosphäre -sie kühlt sich ab, (vgl. Abb. 3 über 100mb) bei Erwärmung der Troposphäre, u.a. weil sie durch ihre Ausdehnung in größere Höhen gerät- zu realisieren, die nicht durchgängig gegeben ist. Ballons steigen nicht überall auf und daher braucht es mit ihnen viel länger, um zu gesicherten Aussagen zu kommen. Nun haben sich also die Autoren von McKitrick et al. (2018) die recht langen Messreihen von verschiedenen Anbietern vorgenommen und die letzten 60 Jahre ausgewertet. Das Ergebnis: Die Erwärmung der oberen tropischen Troposphäre ist nicht im Entferntesten so stark, wie es alle Modelle, die für den 5. Sachstandbericht (AR5) des IPCC in 2013 entwickelt (CMIP5) wurden, antizipierten. Sehr gut erkennt man das in dieser Abbildung der Arbeit:

Abb.4: Die Entwicklung der Temperaturen im Bereich aus Abb.3 über die Zeit. Seit etwa 1995 laufen die Modellwerte den Beobachtungen zunehmend nach oben weg. Quelle: Fig. 3 aus McKitrick et al. (2018)

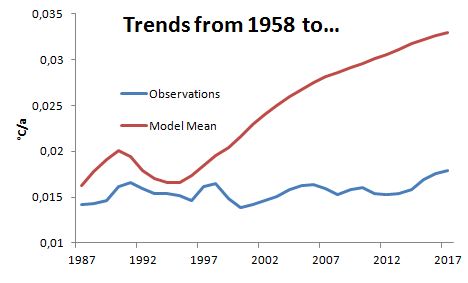

Die Autoren stellen denn auch mit großer statistischer Sicherheit fest, dass die Modelle inkonsistent zu den Beobachtungen sind. Um die Entwicklung der Diskrepanzen noch etwas genauer zu untersuchen, haben wir die Abb.4 digitalisiert und mit den gewonnen Daten Trendberechnungen angestellt:

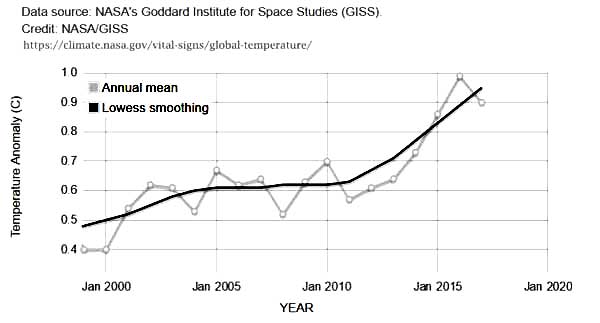

Abb.5: Die linearen Trends ( in °C/ Jahr) der Beobachtungen (blau) und des Modellmittels (rot).

Die kürzeste Trendlänge ab 1958 beträgt 30 Jahre, daher beginnt das Diagramm mit dem Jahr 1987. Der längste Trend geht von 1958 bis 2017. Mit jedem neuen Jahr ergibt sich ab Ende der 90er Jahre eine größere Abweichung der Modellberechnungen vom beobachteten realen Klimasystem. Während diese einen recht konstanten Anstieg von ca. 0,15°C/ Dekade seit 1958 aufweisen, erwärmt sich die Modellwelt immer schneller.

Über die Ursachen der Abweichungen lässt sich nur vermuten. Die Autoren der Arbeit jedenfalls spielen den Ball den Schöpfern der Modelle ins Feld. Ein möglicher Grund für die um ca. 100% zu hohe Erwärmung bis 2017, die ab etwa 2000 ihren Lauf nimmt, könnte eine zu hoch gerechnete Abkühlung durch Aerosole sein. Die nämlich flacht global ab Mitte der 90er in der realen Welt ab und geht sogar zurück seit Ende der 90er Jahre bis in die jüngste Vergangenheit. Auch eine fehlerhafte Berücksichtigung von tropischen Wolken in den Modellen ist zu vermuten, wie diese aktuelle Arbeit von Allison Kolly et al. zeigt. Eine Arbeit von John Christy (der Co-Autor der hier ausgewerteten Studie von McKitrick) und Kollegen aus dem Frühjahr nutzte Satelliten-und Ballondaten ab 1979 und kommt zu nahezu identischen Ergebnissen: Modelle zeigen zu viel Erwärmung in der tropischen Troposphäre. Die Autoren vermuten weitere Modellfehler beim modellierten Wasserkreislauf und in der Physik von Niederschlägen.

Wie auch immer: die Empfindlichkeit der Modelle gegenüber der weitgehend CO2-bedingten Erwärmung ist auch beim „Hotspot“, also in der Region mit dem modellierten stärksten Anstieg der Temperaturen weltweit, um bis zum Faktor 2 zu hoch. Und die Diskrepanz wird weiter wachsen, das legt Abb. 5 nahe. Alle Prognosen, die mit viel zu heiß laufenden Klimamodellen begründet werden, müssen immer mehr hinterfragt werden. Die empirische Wissenschaft zeigt die Grenzen der Modell-Apokalyptiker auf. Wir freuen uns auf jeden Fortschritt in der Wetter-u. Klimabeobachtung!

Der Beitrag erschien zuerst bei „Die kalte Sonne“ hier