Das Climate Forecast Application Network CFAN* hat seine Prognose-Bemühungen auf die Überbrückung dieser Lücke konzentriert, indem es Prognosen extremer Ziel-Abschätzungen des Vertrauens in die Vorhersage abgibt.

[*Man könnte das etwa übersetzen zu Netzwerk der Anwendung von Klima-Prognosen. Anm. d. Übers.]

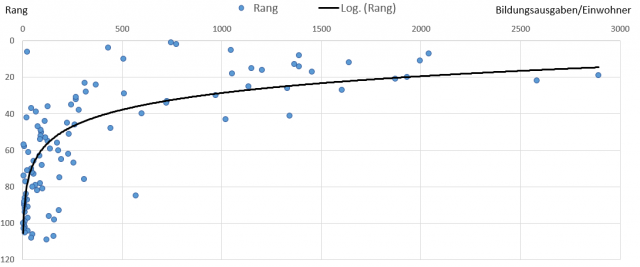

Abbildung 1: Brauchbarkeit von Vorhersagen für das Risiko-Management

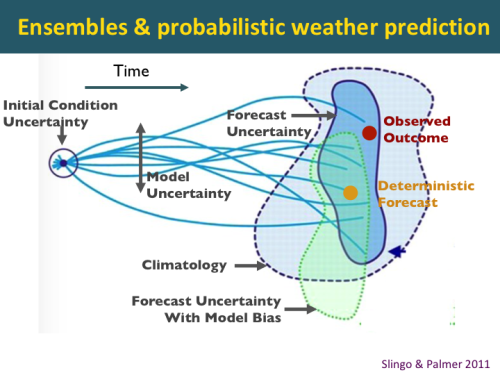

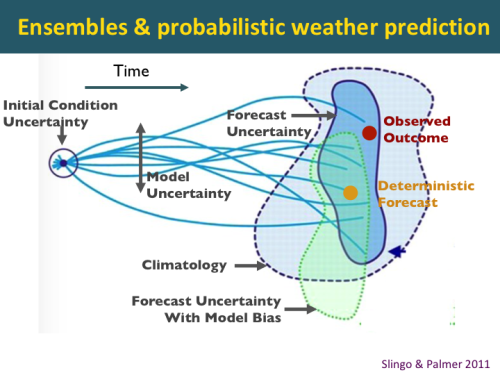

Diese Abbildung illustriert das Konzept der probabilistischen Wettervorhersage mittels eines globalen Prognose-Systems von Ensemble-Modellen.

Für jede Vorhersage errechnet das globale Modell ein Ensemble multipler Vorhersagen, initialisiert mit leicht unterschiedlichen Anfangszuständen. Das Modell der europäischen Wetterzentrale ECMWF hat eine Ensemble-Größe von 51 Vorhersagen. Eine Einzelvorhersage (sagen wir mal der goldene Punkt in Abbildung 2) kann ziemlich weit entfernt liegen vom tatsächlich beobachteten Ergebnis (der rote Punkt). Falls das Ensemble groß genug ist, kann eine bedeutsame probabilistische Vorhersage gegeben werden. Ziel der probabilistischen Vorhersage ist es, das beobachtete Ergebnis (der rote Punkt) in einen Probabilitäts-Raum zu bringen (reflektiert durch die dunkelblaue Fläche), welcher deutlich kleiner ist als der der Klimatologie (hellblaue Fläche).

Die tatsächliche Modellprognose wird durch die grüne Fläche charakterisiert. Die potentielle Vorhersagbarkeit des Modells wird charakterisiert durch die dunkelblaue Fläche. Diese potentielle Vorhersagbarkeit kann sich in einer Vorhersage niederschlagen mittels Kalibrierung der Vorhersage und Verfahren der Interpretation der Ensembles.

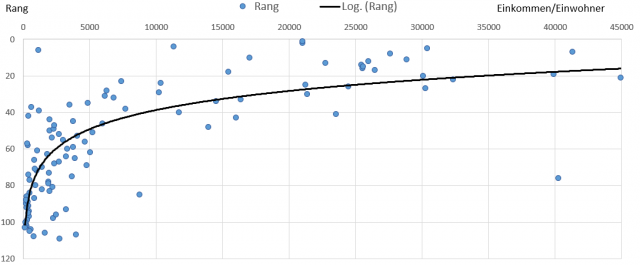

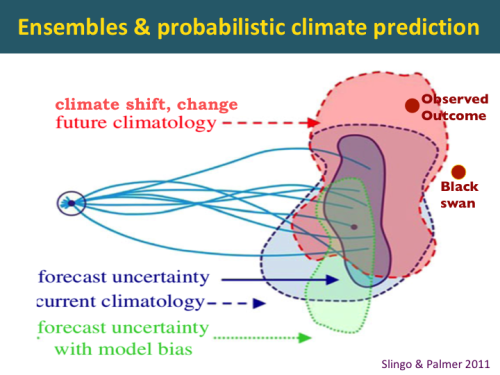

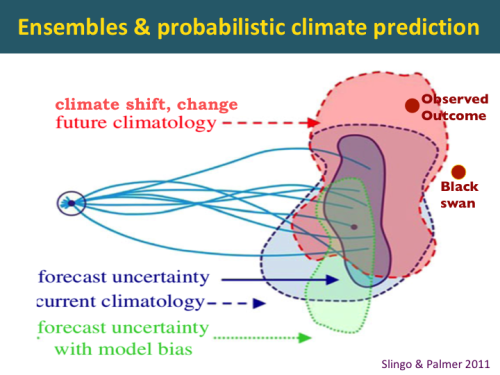

Abbildung 2: Ensembles und probabilistische Wettervorhersage

Die Herausforderung der probabilistischen Klimavorhersage ist: um das beobachtete Ergebnis zu erfassen, muss die Ensemble-Größe sehr groß sein und so groß werden wie die Klimatologie. Die Herausforderung wird noch stärker, wenn sich das Klima ändert, etwa in Gestalt einer allmählichem globalen Erwärmung oder einer abrupten Verschiebung in einem Klimaregime wie etwa der Atlantischen Multidekadischen Oszillation AMO.

Abbildung 3: Ensembles und probabilistische Klimavorhersage

Für Wettervorhersagen in einer zeitlichen Größenordnung von 2 Wochen oder weniger können Ensemble-Vorhersagemodelle bedeutsame Probabilitäten liefern. Dieser Zeitrahmen wird zu einem Zeitrahmen kürzer als Jahreszeiten erweitert, potentiell bis zu 6 Wochen. Allerdings zeigen Vorhersagen, die über 2 Monate hinaus gehen, oftmals wenig Bezug zur Wirklichkeit, und derartige probabilistische Vorhersagen können tatsächlich Entscheidungsträger in die Irre führen. Im Zeitrahmen von Jahreszeiten werden typischerweise prognostische Einsichten vermittelt, während ein Prognostiker die Modellprognosen in eine Analyse von Analogien und vielleicht ein paar statistischen Vorhersageverfahren integriert.

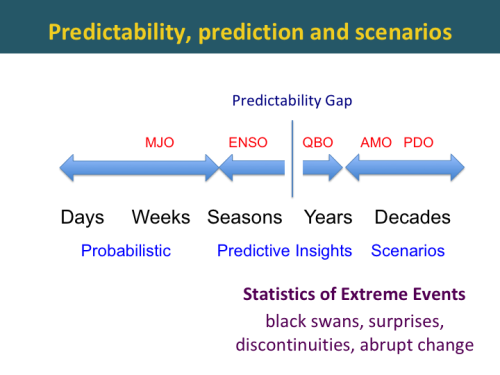

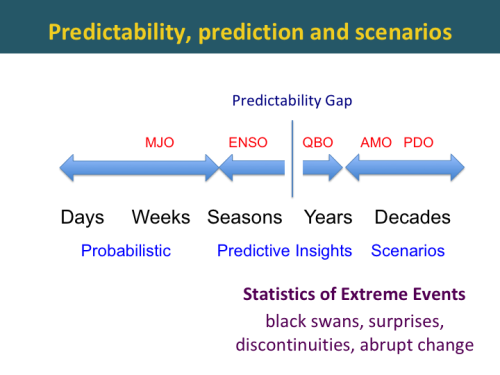

Abbildung 4: Vorhersagbarkeit, Vorhersage und Szenarien

Eine Lücke in der Vorhersagbarkeit ist um 1 Jahr erkennbar, sie ist dort nur sehr gering. Vergrößert man den Zeitrahmen, steigt die Vorhersagbarkeit wieder, und zwar assoziiert mit längerfristigen Klima-Regimes. Allerdings werden die Vorhersagen zunehmend unsicher, wenn man den Zeitrahmen immer mehr verlängert.

Mögliche Zukunfts-Szenarien können nummeriert, aber nicht eingeordnet werden, z. B. wegen Unsicherheit.

Eine brauchbare Langfristvorhersage lässt die Möglichkeit offen, falsch oder auch überraschend zu sein in Verbindung mit abrupten Änderungen oder Schwarzer-Schwan-Ereignissen. Es ist höchst sinnvoll, derartige Ereignisse von vornherein als Möglichkeit zuzulassen.

Die entscheidende Herausforderung der Vorhersage ist es, den Zeitrahmen für bedeutsame Probabilitäts-Vorhersagen und für die prognostischen Abschätzungen der Wahrscheinlichkeit zukünftiger Ereignisse auszuweiten.

Wie können wir diese Prognose-Horizonte erweitern?

ECMWF ENSO Prognosegüte

Verbesserungen der globalen Klimamodelle helfen, den Zeitrahmen für bedeutsame probabilistische Vorhersagen auszudehnen.

Die folgende Abbildung vergleicht Vorhersagen der El Nino Southern Oscillation ENSO mittels der jüngsten Version des europäischen Modells ECMWF im Vergleich mit der vorherigen Version dieses Modells. Die Y-Achse ist der Monat der Initiierung, und die X-Achse repräsentiert den Vorhersage-Zeithorizont in Monaten. Die Farben repräsentiert die Stärke der Korrelation zwischen historischen Vorhersagen und Beobachtungen.

Abbildung 5: ECMWF ENSO Prognosegüte

Das bemerkenswerteste Phänomen in diesem Diagramm ist der Einbruch der Vorhersagbarkeit im Frühjahr [ein unter Synoptikern von Anfang an bekanntes Phänomen]. Initialisiert man eine Vorhersage im April, wird die Prognosegüte bis Juli rapide abnehmen, und der Korrelationskoeffizient sinkt unter 0,7 (weiße Fläche). Wird jedoch eine Prognose im Juli initiiert, bleibt die Vorhersagegüte für die folgenden 7 Monate und auch darüber hinaus sehr hoch.

Die Güte der neuen ECMWF-Version findet sich rechts, und man erkennt eine substantielle Verbesserung. Zwar unterscheidet sich das Farbschema etwas, doch kann man erkennen dass die weiße Fläche mit einem Korrelationskoeffizienten unter 0,7 viel kleiner ist. Dies ist ein Anzeichen, dass das Modell hinsichtlich des Einbruchs im Frühjahr viel besser agiert.

Die verbesserte Güte in Version 5 wird Verbesserungen des Ozean-Modells zugeordnet, ebenso wie Parametrisierungen der tropischen Konvektion.

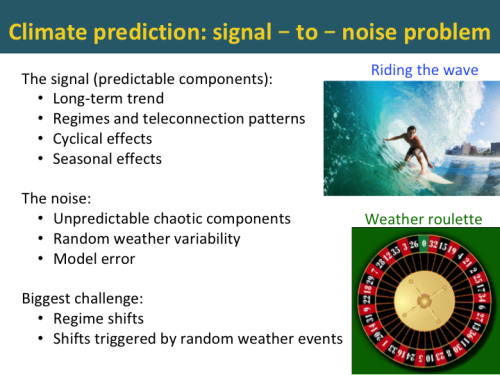

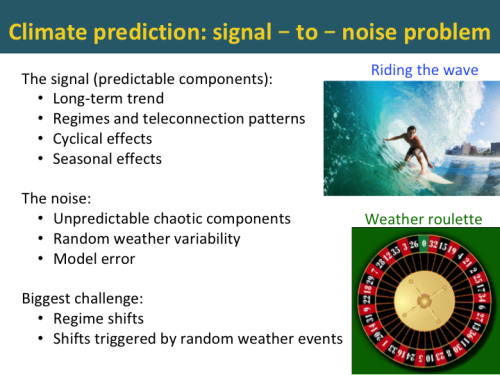

Abbildung 6: Klima-Vorhersage: Signale des Problems des Rauschens

In Zeitrahmen über ein paar Wochen hinaus besteht die Herausforderung darin, die vorhersagbaren Komponenten zu identifizieren. Unter diesen Komponenten sind:

● jedweder langfristige Trend

● Regimes und Fern-Wechselwirkungen

● sowie jedwede zyklische oder jahreszeitliche Effekte.

Hat man vorhersagbare Komponenten erst einmal identifiziert und isoliert, kann man loslegen.

Die Herausforderung besteht darin, die vorhersagbaren Komponenten vom ,Rauschen‘ zu trennen. Darunter sind:

● unvorhersagbare chaotische Komponenten

● Zufallsvariabilität des Wetters

● Modellfehler

Die größte Herausforderung sind Verschiebungen der Regimes, vor allem, wenn diese Verschiebungen durch Zufallsereignisse ausgelöst wurden. Man erinnere sich, im Jahre 2015 sah es wirklich so aus, als würde sich ein El Nino entwickeln. Dessen Entwicklung wurde jedoch vereitelt durch zufällige starke Ostwinde im tropischen Pazifik. Diese fehlgeschlagene Entwicklung des Jahres 2015 bahnte den Weg für den Super El Nino des Jahres 2016.

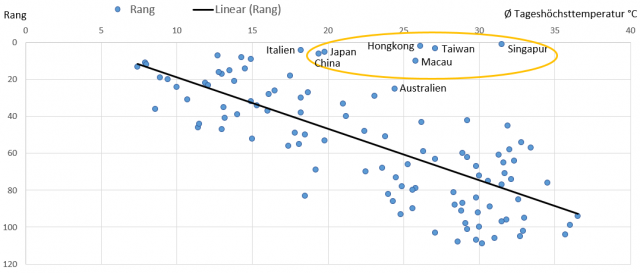

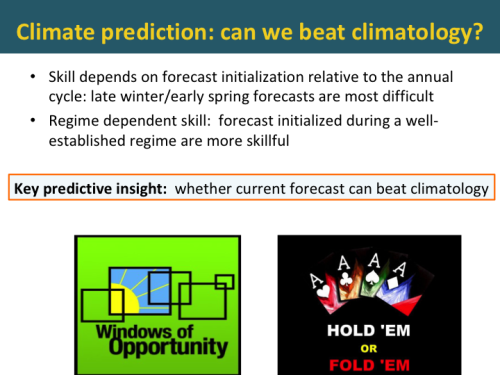

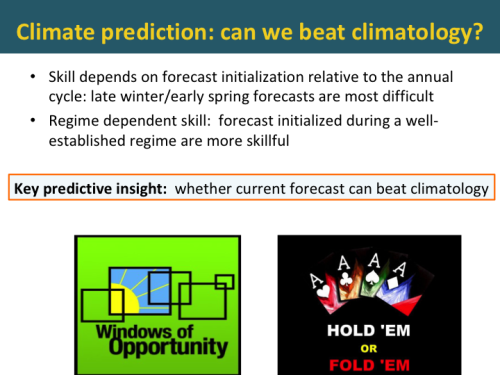

Abbildung 7: Klimavorhersage: können wir die Klimatologie schlagen?

Die große Frage bei einer Klimavorhersage ist, ob man die Klimatologie schlagen kann. Die Vorhersagegüte ist von vielen Dingen abhängig.

Die Initialisierung einer Vorhersage relativ zum jahreszeitlichen Zyklus ist eine bedeutende Determinante der Güte. Auch ist eine Vorhersage, die während eines fest bestehenden Regimes initialisiert wird wie etwa einem El Nino, besser.

Eine der bedeutendsten prognostischen Erkenntnisse, den ein Prognostiker liefern kann ist, ob die aktuelle Vorhersage die Klimatologie schlagen kann.

Das Vorhersagefenster der Gelegenheit, Fenster bzgl. Raum und Zeit zu identifizieren ist größer, wenn die erwartete Vorhersagegüte größer als gewöhnlich ist, weil dann bestimmte Phasen großräumiger Zirkulationen vorherrschen.

Ich verwende oft eine ,Poker‘-Analogie, wenn ich dies Energiehändlern erkläre – man muss wissen, wie man weitermachen soll [im Original steht hier das unübersetzbare Wortspiel ,hold‘ or ,fold‘. Anm. d. Übers.]. Hinsichtlich einer Vorhersage ist dies der Unterschied zwischen Vorhersagen mit geringem oder hohem Vertrauen.

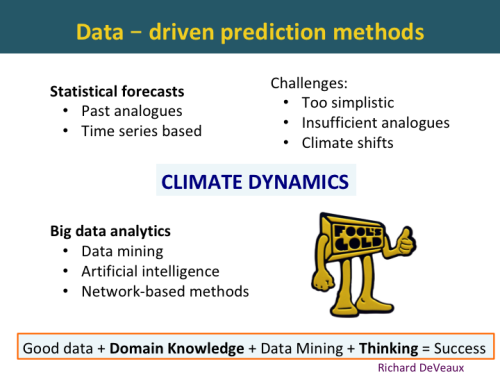

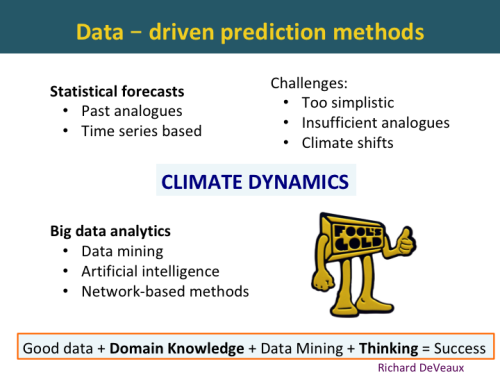

Abbildung 8: von Daten bestimmte Prognoseverfahren

Statistische Vorhersagen wurden viele Jahrzehnte lang verwendet, bevor globale Klimamodelle entwickelt worden sind, besonders für die Monsunregen in Asien. Traditionelle statistische Vorhersagen waren Zeitreihen auf der Grundlage von Analogien während der Vergangenheit. Während in diese Verfahren Erkenntnisse der Klimadynamik einfließen, haben sie sich als zu simplizistisch erwiesen, und außerdem gibt es nur eine unzureichende Anzahl von Analogien während der Vergangenheit.

Die größte Herausforderung für statistische Vorhersagen ist, dass sie bei einer Verschiebung von Regimes keinerlei Aussagekraft mehr haben. Man erinnere sich an das Jahr 1995, als das statistische Hurrikan-Vorhersagemodell von Bill Gray nicht mehr funktionierte, nachdem sich die atlantische Zirkulation verändert hatte. Ein Beispiel aus jüngerer Zeit ist die Bewertung der Schneebedeckung im Oktober in Sibirien. Diese heranzuziehen funktionierte auch nicht mehr, nachdem sich das Klimaregime verändert hatte.

Gegenwärtig ist die Analytik von Big Data der letzte Schrei bzgl. der Vorhersage von Wetter und Klima. IBM-Watson ist ein Beispiel. Mathematiker und Statistiker bringen Verfahren der Datengewinnung und künstlicher Intelligenz ins Spiel für die Wetter- und Klimavorhersage.

Der Guru künstlicher Intelligenz Richard DeVeaux nennt das folgende Rezept dafür, erfolgreich zu sein:

Gute Daten + Fachkenntnisse + Datengewinnung + Nachdenken = Erfolg

Die eingrenzenden Zutaten sind Fachkenntnis und Nachdenken. Ohne gute Kenntnisse der Klimadynamik wird Katzengold das Ergebnis jedweder Klimavorhersage auf der Grundlage von Datengewinnung sein.

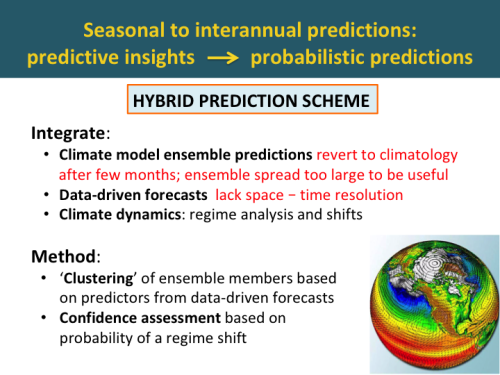

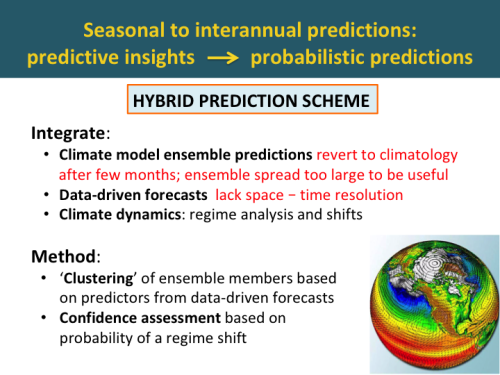

Abbildung 9: Jahreszeitliche bis jährliche Vorhersagen: Prognostische Erkenntnisse → probabilistische Vorhersagen.

Der Weg zu einer Ausdehnung des Zeithorizonts für bedeutsame probabilistische Vorhersagen ist es, globale Klimamodelle mit Erkenntnissen von Vorhersageverfahren auf der Grundlage von Daten zu integrieren.

Das Problem der Klimamodell-Vorhersagen ist, dass sie nach ein paar Monaten unvermeidlich in die Klimatologie abgleiten. Das Problem von Vorhersagen auf der Grundlage von Daten ist deren schlechte räumlich-zeitliche Auflösung.

Diese können integriert werden, indem die Klimamodell-Ensemble-Mitglieder anordnet um Prädiktoren aus auf Daten basierenden Vorhersagen zu Gruppen zusammengefasst werden.

Vertrauensabschätzungen können vorgenommen werden auf der Grundlage der Wahrscheinlichkeit einer Regime-Verschiebung.

Vorhersagen auf Daten-Grundlage: Analyse der Klimadynamik

Bei Verfahren zur Klimavorhersage auf der Grundlage von Daten ist es unabdingbar, die Bandbreite der Klimaregimes zu kennen, welche unsere Vorhersage beeinflussen können. Diese Regimes zeigen die Erhaltensneigung im Klimasystem. Die Herausforderung besteht darin, die geeigneten Regimes zu identifizieren, deren Auswirkung auf die gewünschten Vorhersage-Variablen zu verstehen und die Vorhersage zukünftiger Verschiebungen dieser Regimes.

Die CFAN-Analyse der Klimadynamik enthält die Betrachtung dieser 5 Zeitrahmen und deren damit assoziierten Regimes. Sie reichen vom jährlichen Zyklus bis zu multidekadischen Zeitrahmen.

Zustände der Zirkulation: Quellen der Vorhersagbarkeit

Unsere Bemühungen zur Datengewinnung haben eine Anzahl neuer Zirkulations-Regimes identifiziert, die als Prädiktoren brauchbar sind über eine Bandbreite von Zeitmaßstäben. Darunter sind:

● Nordatlantische ARC-Zirkulation

● Indo-Pazifik-Atlantik-Zirkulation

● Anomalien hemisphärischer stratosphärischer Zirkulation auf beiden Hemisphären

● Bipolare Zirkulation in der Stratosphäre

● NAOX: Nordatlantische SLP/Windzirkulation

● Globale Zirkulationen von Nord-Süd-Winden in der oberen Troposphäre/unteren Stratosphäre

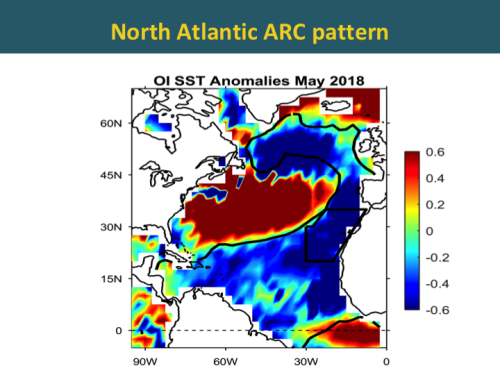

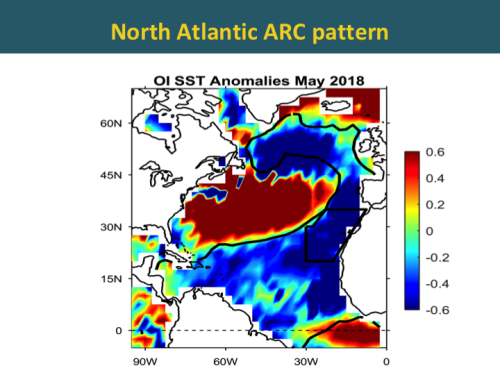

Nordatlantische ARC-Zirkulation

Abbildung 10: Nordatlantische ARC-Zirkulation

Im Atlantik ist aktuell eine faszinierende Entwicklung zu beobachten. Abbildung 10 zeigt Anomalien der Wassertemperatur im Atlantik für den Monat Mai. Man erkennt einen Bogen kalter blauer Temperaturanomalien, welcher sich vom äquatorialen Atlantik entlang der Küste von Afrika erstreckt und dann in ein von Ost nach West verlaufendes Band südlich von Grönland und Island mündet. Diese Verteilung bezeichnet man als die atlantische ARC-Zirkulation.

Abbildung 11: ARC-Wassertemperatur-Anomalien im Nordatlantik

Eine Zeitreihe von Wassertemperatur-Anomalien im ARC-Gebiet seit 1880 zeigt, dass sich Änderungen mit scharfen Verschiebungen manifestieren. Man erkennt derartige Verschiebungen in den Jahren 1902, 1926, 1971 und 1995.

In der unteren Graphik erkennt man, dass die ARC-Temperaturen während der letzten paar Monate einen schroffen Rückgang zeigen. Ist dies jetzt lediglich eine Kalt-Anomalie wie im Jahre 2002? Oder wird hier eine Verschiebung in die Kaltphase eingeläutet?

Die CFAN-Forschungen haben Präzedenzen der Verschiebungen identifiziert. Gegenwärtig arbeiten wir aktiv daran, die jetzige Lage richtig einzuordnen.

Kaltphase der atlantischen AMO: Auswirkungen

Es wird erwartet, dass eine Verschiebung hin zur Kaltphase der AMO ausgeprägte Auswirkungen haben wird. Diese Erwartung speist sich aus Verschiebungen während der Vergangenheit:

● verringerte Hurrikan-Aktivität im Atlantik

● verstärkte Regenfälle in den USA

● verringerte Regenfälle in Indien und der Sahel-Zone

● Verschiebung der Fischbestände im Nordatlantik

● Beschleunigung des Meeresspiegel-Anstiegs an der nordöstlichen US-Küste

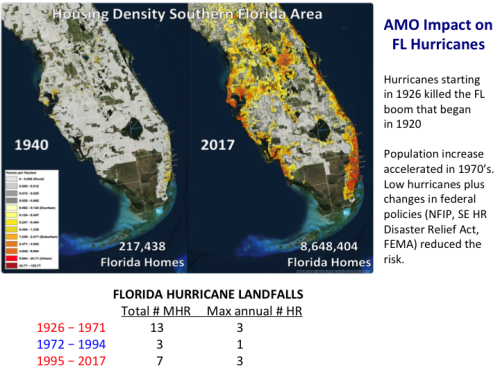

Abbildung 12: Auswirkungen der AMO auf atlantische Hurrikane

Die Atlantische Multidekadische Oszillation übt auf atlantische Hurrikane einen substantiellen Einfluss aus. Die obere Graphik zeigt die Zeitreihe der Anzahl starker Hurrikane seit dem Jahr 1920. Die Warmphasen der AMO sind gelb schattiert. Man erkennt eine substantiell höhere Anzahl starker Hurrikane während der gelb schattierten Zeiträume.

Einen ganz ähnlichen Effekt zeigt die Accumulated Cyclone Energy:

Abbildung 13: Auswirkungen der AMO auf auf das US-Festland übergreifende Hurrikane

Im Gegensatz dazu erkennt man, dass die Warmphasen im Vergleich zu den Kaltphasen der AMO kaum Auswirkungen auf die Häufigkeit von auf das US-Festland übergreifende Hurrikane hat.

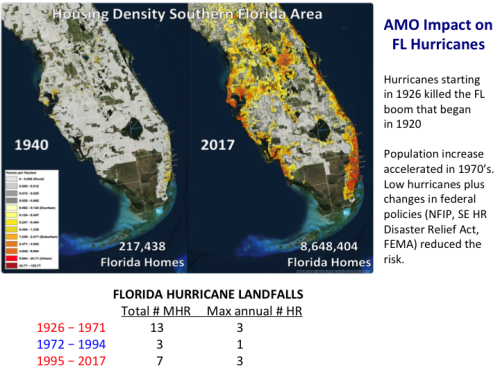

Abbildung 14: Auswirkungen der AMO auf Hurrikane in Florida

Allerdings hat die Phase der AMO einen gewaltigen Einfluss auf Florida. Während der vorangegangenen Kaltphase gab es zu keiner Jahreszeit mehr als einen Übertritt auf Florida, während es während der Warmphase mehrere Jahre gab mit drei derartigen Ereignissen oder mehr. Dass ein starker Hurrikan auf Florida übergreift ist mehr als doppelt so wahrscheinlich in einer Warmphase als in der Kaltphase.

Diese Variationen der Übertritte auf das Festland in Verbindung mit Änderungen der AMO haben einen substantiellen Einfluss auf die Entwicklung in Florida. Die Reihe von Hurrikanen des Jahres 1926 tötete den ökonomischen 1920 angefangenen Boom. Bevölkerung und Entwicklung beschleunigten sich während der siebziger Jahre, unterstützt durch eine Periode schwacher Hurrikan-Aktivität.

Die jahreszeitlichen Vorhersagen atlantischer Hurrikane von CFAN

Das CFAN-Verfahren untersucht globale und regionale Wechselwirkungen zwischen Ozean-, Troposphären- und Stratosphären-Zirkulationen. Vorlaufende Prozesse werden identifiziert durch Datenerfassung, interpretiert im Zusammenhang der Klimadynamik-Analyse. Damit werden dann statistische Tests mit Nachhersagen durchgeführt.

Wir betrachten in unserer Analyse drei Perioden, definiert durch gegenwärtige Regimes der Zirkulation:

●Die Periode seit 1995, welche mit der Warmphase der AMO korrespondiert

●Die Periode seit 2002, definiert durch eine Verschiebung der Nordpazifischen Oszillation im Jahre 2001

●Die Periode seit 2008, charakterisiert durch eine Vorherrschaft von El Nino-Ereignissen alle drei Jahre.

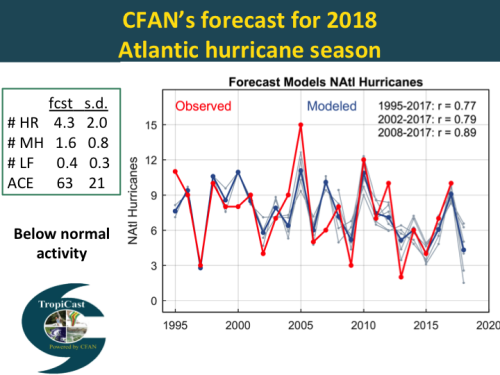

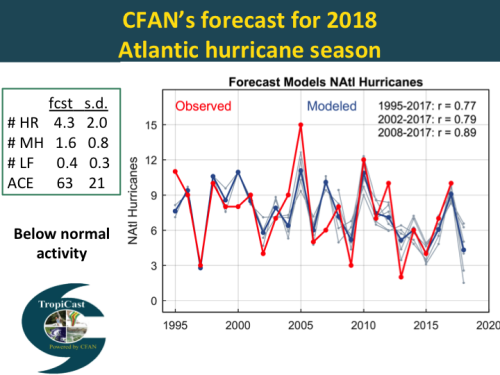

Abbildung 15: CFAN-Vorhersage der atlantischen Hurrikan-Saison 2018

Vorige Woche haben wir unsere dritte Vorhersage für die atlantiche Hurrikan-Saison 2018 herausgegeben. Wir prognostizieren eine unternormale Aktivität mit einem ACE-Wert von 63 und 4 Hurrikanen.

Die Graphik rechts zeigt die Nachhersage-Verifikation unserer Juni-Vorhersage bzgl. der Anzahl von Hurrikanen. Die Prognose wird erstellt mittels historischer Daten aus drei verschiedenen Perioden, die jeweils mit den drei oben beschriebenen Regimes korrespondieren.

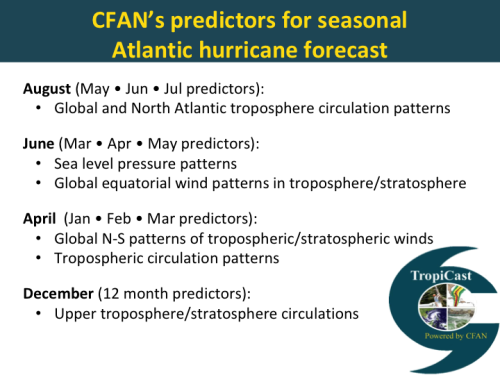

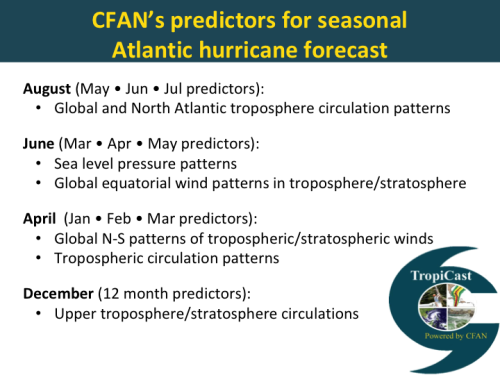

Abbildung 16: Prädiktoren von CFAN für die jahreszeitliche atlantische Hurrikan-Vorhersage

Die jahreszeitlichen Prädiktoren von CFAN werden für jede Vorhersage ermittelt durch ein Datengewinnungs-Verfahren mit unterschiedlichen Prädiktoren für jeden Zeitraum. Die ausgewählten Prädiktoren werden dann einer Klimadynamik-Analyse unterzogen, um zu verifizieren, dass die Prädiktoren aus verfahrenstechnischer Sicht sinnvoll sind.

Die von uns herangezogenen Prädiktoren sind bezogen auf atmosphärische Zirkulationsmuster. Unsere Prädiktoren unterscheiden sich substantiell von denen, die von anderen Gruppen für statistische Vorhersagen herangezogenen werden, welche sich vorherrschend auf die Wassertemperatur und den Luftdruck über dem Wasser stützen.

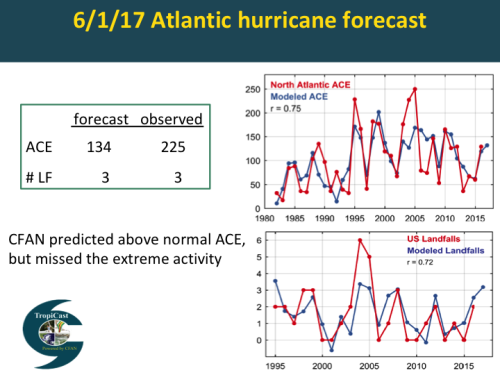

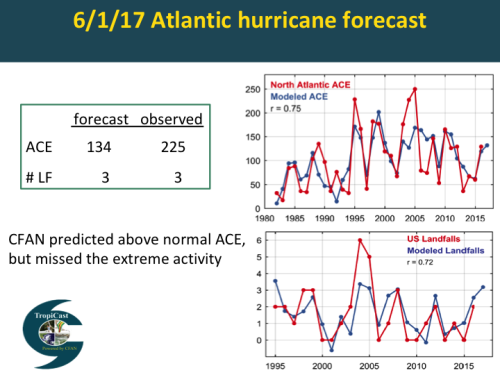

Jahreszeitliche Vorhersage 2017

Abbildung 17: Vorhersage atlantischer Hurrikane: worst case-Szenario

Hier folgt die von uns ausgegebene Vorhersage von vor einem Jahr zur Hurrikan-Saison 2017. Wir prognostizierten eine aktive Saison mit 3 Übertritten auf das US-Festland. Diese Anzahl war korrekt, aber wir haben substantiell die ACE unterschätzt.

Aus der Perspektive des Finanzsektors ist es entscheidend, ob wir eine weitere extrem aktive Hurrikan-Saison erleben und wie viele Hurrikane auf das US-Festland übergreifen.

Wir führten ein Datensammel-Verfahren durch, um Verteilungen zu identifizieren, welche die extrem aktiven Saisons der Jahre 1995, 2004, 2005 und 2017 erklären. Unser gegenwärtiges Vorhersagemodell ist zwar hinsichtlich der Extreme in den Jahren 1995 und 2017 korrekt, nicht jedoch für die Jahre 2004 und 2005.

Der einzige Prädiktor, der 2004/2005 auftauchte, war ein Vorgang in der Stratosphäre nahe der Antarktis. Zu diesem Zeitpunkt haben wir keine Ahnung, ob dieser Vorgang ein plausibler Prädiktor auf physikalischer Grundlage für die atlantische Hurrikan-Aktivität ist. Verstörend ist, dass Prädiktoren der polaren Stratosphäre eine extrem aktive Saison 2018 vorhersagen. Dies steht im Gegensatz zu den anderen von uns herangezogenen Prädiktoren.

Fazit: Zu diesem Zeitpunkt wissen wir nicht, ob wir echtes Gold oder Katzengold ausgegraben haben. In jedem Falle ist dies ein gutes Beispiel des Nutzens und der Gefahren bei der Datensammlung.

Link: https://judithcurry.com/2018/06/07/beyond-enso-new-signals-of-seasonal-to-interannual-predictability/

Übersetzt von Chris Frey EIKE