Forscher: Ozon-Zerstörung, nicht Treibhausgase, ist die Ursache für globale Erwärmung

[*Im Original steht die Abkürzung CFC = Chlorofluorocarbon. Ich habe dafür in dieser Übersetzung die bei uns allgemein bekannte Abkürzung FCKW verwendet, in der Hoffnung, dass sie mit CFC identisch ist. Anm. d. Übers.]

Innerhalb von drei bis fünf Jahren, also der Zeit, von der wir wissen, dass FCKW die Stratosphäre erreicht, begannen die jährlichen mittleren globalen Temperaturen zu steigen. James Lovelock fand mittels seines neuen Elektronen-Detektors [electron capture detector] bedeutende Mengen von FCKW-11 in allen 50 Luftproben, die er von Pol zu Pol genommen hatte. Angeregt durch Lovelocks Arbeiten entdeckten Mario Molina und Sherwood Rowland im Jahre 1974, dass wenn die FCKW die Stratosphäre erreichen, sie durch die ultraviolette Strahlung der Sonne aufgebrochen werden, wobei ultimativ Chloratome freigesetzt werden. Ein Chloratom kann 100.000 Ozonmoleküle zerstören, und zwar mittels katalytischer Prozesse, die besonders effektiv sind in polaren Stratosphären-Wolken.

Ozon bildet sich, wenn die ultraviolette C-Strahlung ein Sauerstoff-Molekül in zwei Sauerstoff-Atome aufspaltet, welche dann mit anderen Sauerstoff-Molekülen das Ozon (O3) bilden. Ultraviolette B-Solarstrahlung verwandelt das Ozon wieder zurück in ein Sauerstoff-Atom und ein Sauerstoff-Molekül. Dieser Ozon-Sauerstoff-Zyklus, bekannt unter der Bezeichnung Chapman-Zyklus, ist kontinuierlich, so dass ein Ozon-Molekül normalerweise nur eine Lebensdauer von 8,3 Tagen hat. Die Ozonschicht, ca. 20 bis 30 km über der Erdoberfläche, ist der Bereich der Atmosphäre, in denen die günstigsten Bedingungen für den Ozon-Sauerstoff-Zyklus herrschen.

Wenn ein Molekül wie Sauerstoff oder Ozon zerfällt, fliegen die molekularen Bruchstücke mit hoher Geschwindigkeit auseinander, wobei sie die gesamte Bindungsenergie in kinetische Energie umwandeln. Die mittlere kinetische Energie aller Atome und Moleküle in einem Gas ist der kinetischen Theorie der Gase zufolge direkt proportional zur Temperatur eines Gases. Folglich zeigen hohe Ozon-Konzentrationen Regionen einer lokalen Erwärmung an. Dass diese Wetter und Klima beeinflussen, wurde erstmals von Gordon Dobson während der zwanziger Jahre des vorigen Jahrhunderts beobachtet.

Wenn Ozon zerfällt, wird in der Ozonschicht weniger Ultraviolett-B absorbiert, wodurch die Ozonschicht abkühlt. So wurde es von 1970 bis 1998 beobachtet. Mehr Ultraviolett-B erreicht dann die Erdoberfläche, wo es Dutzende Meter tief in die Ozeane eindringt und folglich sehr effizient absorbiert wird. Zunehmendes Ultraviolett-B sorgt auch in den bodennahen Luftschichten für Ozon-Verschmutzung, was die Luft in Industriegebieten erwärmt. Dies erklärt, warum die globale Erwärmung von 1970 bis 1998 auf der Nordhemisphäre doppelt so stark war wie auf der Südhemisphäre, enthält erstere doch 90% der Weltbevölkerung. Der Ozonzerfall ist in den Polargebieten im Winter am stärksten. Dies erklärt, warum die stärkste, von 1970 bis 1998 beobachtete Erwärmung in den Polargebieten erfolgte. Dieses Phänomen ist bekannt unter der Bezeichnung polar amplification.

Im Jahre 1985 entdeckten Joe Farman, Brian Gardiner und Jon Shanklin, dass die Zerstörung der Ozonschicht über der Antarktis bis zu 70% im Frühjahr der Südhalbkugel ausmacht. Wissenschaftler erkannten auf einmal, dass der Ozonzerfall ein viel größeres Problem war als ursprünglich gedacht. Innerhalb von zwei Jahren entwickelten Politiker und Wissenschaftler das Montreal-Protokoll, in welchem der Stopp der FCKW-Produktion ab Januar 1989 gefordert wurde.

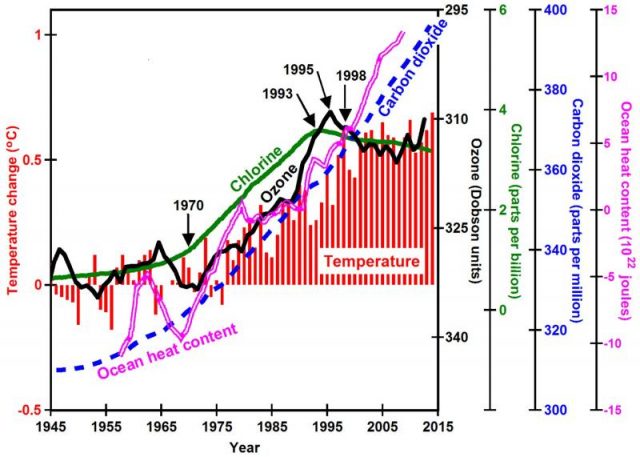

Im Jahre 1993 endete die FCKW-Zunahme in der Atmosphäre. Bis 1995 war die Zunahme des Ozon-Zerfalls beendet. Ab dem Jahr 1998 hörte der globale Temperaturanstieg auf. Die Ozonschicht bleibt zerfallen, die Ozeane erwärmen sich weiter, Eis schmilzt weiterhin [?], der Meeresspiegel steigt weiter – aber die globalen Temperaturen änderten sich von 1998 bis 2013 kaum. Das war auch von 1945 bis 1970 der Fall. Folglich scheinen die Menschen aus Versehen die Erwärmung ab 1970 in Gang gesetzt zu haben mittels Herstellung großer Mengen von FCKW und diese Erwärmung im Zuge der Versuche, den Ozonzerfall aufzuhalten, genauso aus Versehen wieder zum Stehen gebracht zu haben.

Abbildung: Die Zunahme von Chlor in der Troposphäre (grüne Linie), verursacht durch die Herstellung von FCKW, führte zu einem zunehmenden Zerfall der Ozonschicht (schwarze Linie), was wiederum zu steigenden Temperaturen führte (rote Balken).

Gleichzeitig stieg die atmosphärische Konzentration von Kohlendioxid linear, jedoch mit stetig zunehmender Rate. Sie zeigt keine direkte Relation zu den Details der beobachteten globalen Erwärmung. Dutzende begutachteter Studien von führenden Atmosphären-Wissenschaftlern haben auf der Grundlage der Treibhausgas-Theorie versucht zu erklären, warum sich die globale Temperatur von 1998 bis 2013 kaum geändert hat. Bekannt ist dieses Phänomen unter der Bezeichnung Stillstand der globalen Erwärmung. In diesen Studien stecken viele interessante Gedanken, aber keiner davon fand allgemeine Akzeptanz.

Im Jahre 2014 schleuderte der isländische Vulkan Bárðarbunga basaltische Lava aus, welche innerhalb von sechs Monaten eine Fläche von ca. 85 km² überzog, das war der stärkste Ausbruch basaltischer Lava seit 1783. Ausbrüche dieser Art von Lava, welche Millionen Quadratkilometer überdeckten, gingen zeitgleich einher mit Perioden der stärksten globalen Erwärmung, Ozean-Versauerung und Massenaussterben von Spezies zu allen geologischen Zeiten. Zum Beispiel überdeckten vor 251 Millionen Jahren sibirische Basalte eine Fläche von ca. 7 Millionen Quadratkilometer, das ist so groß wie das US-Festland ohne Texas und Montana. Man stelle sich eine Fläche von New York bis San Francisco, von Seattle bis Miami vor, die von basaltischer Lava bedeckt ist. Die Eruption dieser Basalte erwärmte die Ozeane bis auf Sauna-Temperaturen [?] und löschte 95% aller damals existierenden Spezies aus. Basalte emittieren ungeheure Mengen Chlor und Brom, welche die Ursache für den Ozonzerfall zu sein scheinen. Jedoch sind die genauen chemischen Zusammenhänge noch unklar. Der Ausbruch des Bárðarbunga scheint eine sehr rapide globale Erwärmung von 2014 bis 2016 ausgelöst zu haben, welche sich 2017 abzuschwächen begann, so dass sich innerhalb eines Jahrzehnts die Werte des Jahres 2013 wieder einstellen dürften.

Während der achtziger Jahre des vorigen Jahrhunderts waren viele führende Wissenschaftler davon überzeugt, dass Treibhausgase die Ursache der globalen Erwärmung waren, dass die Erde Gefahr lief, sich im 21. Jahrhundert mit steigenden Treibhausgas-Emissionen zu überhitzen, und dass Wissenschaftler einen Konsens an den Tag legen müssen, um politische Führer davon zu überzeugen, teure Maßnahmen auf den Weg zu bringen. Diese seien erforderlich, um die Treibhausgas-Emissionen zu reduzieren. Mittels der WMO und der UNEP halfen sie, das IPCC im Jahre 1988 ins Leben zu rufen. Das IPCC hat Tausende Wissenschaftler beschäftigt, welche zehntausende Seiten Papier vollschrieben mit nachdenklicher Wissenschaft zur Stützung der Treibhausgas-Erwärmungs-Theorie. Das IPCC stellte nie die weit verbreitete Hypothese in Frage, dass Treibhausgase wirklich der primäre Grund für globale Erwärmung sind. Im Dezember 2015 trug diese Bemühung Früchte in Gestalt des Paris-Abkommens, in welchem Politiker fast aller Länder zustimmten, zusammen zu arbeiten, um Treibhausgas-Emissionen zu reduzieren.

Wissenschaft wird jedoch niemals mittels Abstimmungen durchgeführt. Wissenschaft wird nicht durch Konsens durchgeführt. Konsens ist politisches Zeug; Debatte ist das Werkzeug der Wissenschaft. Die Wissenschaft ist niemals settled. Michael Crichton drückte es im Jahre 2003 so aus: „In der Wissenschaft ist Konsens irrelevant. Relevant sind ausschließlich reproduzierbare Ergebnisse. Die größten Wissenschaftler der Geschichte sind genau deswegen groß, weil sie mit dem Konsens gebrochen haben. Es gibt so etwas wie Konsens in der Wissenschaft nicht. Falls es Konsens ist, ist es keine Wissenschaft. Falls es Wissenschaft ist, ist es kein Konsens. Punkt!“

IPCC-Wissenschaftler sind so besessen von ihrem Konsens und so unwillig, sich mit Klimaskeptikern zu streiten, dass sie sich weigern, allein schon den Gedanken bzgl. Ozonzerfall in Betracht zu ziehen. Ihre Modelle berechnen, dass Treibhausgase viel mehr terrestrische Infrarotstrahlung absorbieren als die geringe Menge ultravioletter B-Strahlung, welche die Erde beim Zerfall von Ozon erreicht. Was sie aber nicht erkennen ist, dass die Energie in thermischer Strahlung keine Funktion der Stärke dieser Strahlung ist, sondern eine Funktion der Frequenz. Ultraviolette B-Strahlung weist eine um 48 mal höhere Frequenz auf als die Frequenz infraroter Strahlung, welche am stärksten durch Kohlendioxid absorbiert wird [?]. 48 mal höher – das hat das Potential, die Temperatur des absorbierenden Körpers 48 mal wärmer zu machen. Ultraviolette B-Strahlung enthält genug Energie, um Sonnenbrand, Hautkrebs und Grauen Star auszulösen – was keine Menge infraroter Strahlung je vermag. Schließlich wird einem viel wärmer, wenn man im Sonnenlicht steht als nachts im Freien mit all der infraroten Strahlung ringsum. Ich kann jetzt zeigen, dass Treibhausgase einfach nicht genug Wärme absorbieren können, um als primäre Ursache für globale Erwärmung zu dienen.

Klimamodelle auf der Grundlage von Treibhausgas-Erwärmung haben seit 1998 die Temperaturen nicht mehr richtig prophezeit. Die große Erwärmung, zu welcher es den Ergebnissen dieser Modelle zufolge später in diesem Jahrhundert kommen soll, wird aller Voraussicht nach nicht eintreten. Wenn politische Führer nach Wegen suchen, die Treibhausgas-Konzentration zu reduzieren mit zu erwartenden Kosten in Billionenhöhe, müssen sie verstehen, dass dies keinerlei Auswirkung auf die Reduktion der globalen Erwärmung haben könnte.

Inzwischen wird sich der Ozean weiter erwärmen, solange das Ozon relativ zum Niveau des Jahres 1970 zerfallen bleibt. Die Erholung der Ozonschicht wird verzögert durch einen deutlichen schwarzen Mark von FCKW, weil es sich die Menschen in ärmeren Ländern nicht leisten können, ihre von FCKW abhängigen Kühlschränke und andere Einrichtungen zu ersetzen. Hinzu kommt: kurzlebigere Substanzen wie dichloromethanes haben eine stärkere negative Auswirkung auf das Ozon-Niveau als zuvor gedacht. Falls wir wirklich unseren negativen Einfluss auf das Klima [?] reduzieren wollen, müssen wir uns darauf konzentrieren, den Ozonzerfall zu stoppen. Wir müssen auch anfangen, über unsere Optionen im Falle großer Ausbrüche basaltischer Lava nachzudenken.

Dr. Peter L. Ward worked 27 years with the United States Geological Survey as research geophysicist, branch chief, and program manager. He helped develop and manage a major national research program, chaired a committee at the White House, testified before Congress, worked on a committee for Vice President Gore, published dozens of scientific papers, and won two national awards for explaining science to the general public. He retired in 1998, working intensely for the past twelve years, trying to resolve several enigmatic observations related to climate change.

Ward’s analysis and theory are explained in detail on his website, WhyClimateChanges.com, and in his new book: „What Really Causes Global Warming? Greenhouse Gases or Ozone Depletion?“

Link: https://www.rdmag.com/article/2018/04/ozone-depletion-not-greenhouse-gases-cause-global-warming-says-researcher

Übersetzt von Chris Frey EIKE

Kommentar des Übersetzers zu diesem Beitrag:

Mit diesem Beitrag wird nun eine weitere und meines Wissens nach völlig neue Ursache der globalen Erwärmung geliefert – so diese wirklich ein messbares Ausmaß erreicht hat. Die von mir im Artikel gesetzten Fragezeichen [?] sollen schon auf Ungereimtheiten hinweisen.

Es ist immer wieder interessant, mit welch immer neuen Ansätzen versucht wird, Klimaänderungen zu begründen. Die hier vorgestellte FCKW-Theorie scheint mir die gleiche zufällige Koinzidenz zu sein wie steigender CO2-Anteil in der Atmosphäre und steigende Temperatur. Oder wie die steigende Storchenpopulation und zunehmende Geburten in Deutschland. Oder wie… Mit einiger Phantasie lassen sich viele dieser Koinzidenzen finden, die aber alle eines gemeinsam haben: Sie können den immerwährenden Klimawandel seit vielen Millionen Jahren auf der Erde vor dem Auftritt des Menschen nicht erklären.Man muss sich doch nur fragen: Seit wann gibt es das FCKW-„Problem“ – und seit wann gibt es Klimawandel?

Hier wird nun der aktuelle Klimawandel mit einem Einzelereignis in Verbindung gebracht, nämlich einem Vulkanausbruch 2013. Die nachfolgende Wärmespitze soll diesem Ereignis geschuldet sein – und nicht dem Super-El Nino, der nicht einmal erwähnt wird. Damit schließt sich der Kreis unter dem Motto: Immer mal wieder etwas Neues. Das wird wohl unendlich so weitergehen – bis vielleicht das aktuelle Sonnenaktivitäts-Minimum Wirkung zeigt…