Promotoren von Wind und Sonne, die auf die Hunderte von Milliarden Dollar fixiert sind, die beim zum Aufbau neuer Kapazitäten ausgeworfen werden, diskutieren selten den tatsächlichen Wert all dieser Industrieanlagen, in Bezug auf das, was die Stromverbraucher am meisten wollen und brauchen: Strom, Strom und noch mehr Strom, nicht irgendwann, wenn der Wind weht oder die Sonne aufgeht, sondern wenn sie es wirklich brauchen.

Versprechen und Reden liefern keine zuverlässige Energie. Fragen Sie einen Südaustralier.

In diesem Beitrag führt Anthony Cox den Herrscher über die Behauptungen vor, dass SA (Süd Australien) auf dem besten Weg zu einer Zukunft im Bereich der erneuerbaren Energien ist.

Er (dieser Beitrag) konzentriert sich auf Sonnenkollektoren, die SA’s verblendeter Premier, Jay Weatherill als Rettung seiner selbst verschuldeten Strompreis und Versorgungs-Katastrophe ansieht.

Aber, das gleiche gilt auch für die Windkraft: nämlich die Hoffnungen auf Energie an das Wetter zu knüpfen und zu erwarten, dass die Ergebnisse gut werden.

Südaustralischer Wahnsinn

The Australian Climate Sceptics Blog, Anthony Cox, 23 February 2018

Wir wissen alle, der Premier von SA, Jay Weatherill ist ein Schwarzseher, der die verrückt machende Pille des Alarmismus und seiner ebenso verrückten Nachkommen – die erneuerbaren Energien, mit Begeisterung geschluckt hat. Er hat billige, zuverlässige Kohlekraftwerke in die Luft gesprengt, unbekannte Geldbeträge in Musks Batterien investiert, Dieselgeneratoren installiert, die die meisten (realen) Verschmutzungen aller Energiequellen verursachen, mit Ausnahme von Holz, was die einzige Brennstoffquelle ist, die er nicht ausprobiert hat. Und das alles in SA mit dem größten Uranvorkommen der Welt und jetzt dem teuersten Strom der Welt.

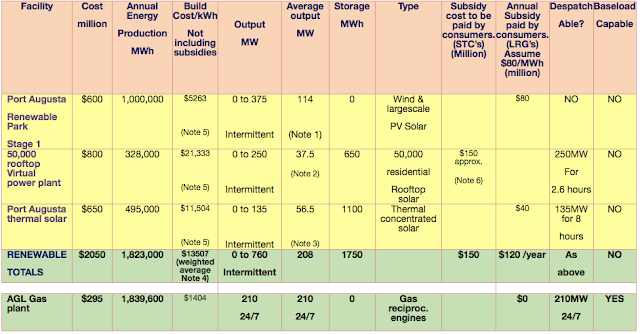

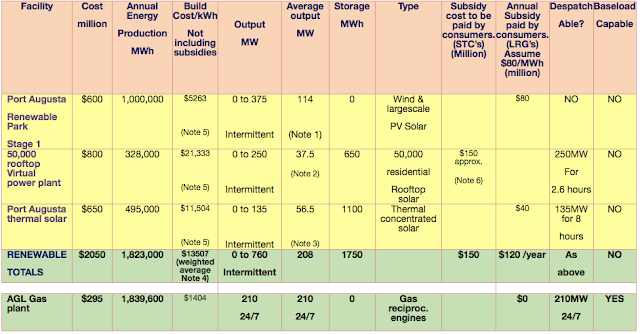

Peter Rees hat bereits einige gute Arbeit geleistet, indem er den SA-Wahnsinn hervorhob, wobei Weatherill über 2 Milliarden Dollar Steuergelder für wenig Wind- und Sonnenenergie ausgab, während AGL (australisches Energieunternehmen), ebenfalls bis zum Hals in Panikmache und erneuerbare Modetorheiten steckt, gerade 295 Millionen Dollar ausgibt, mit einigen Subventionen, für ein Gaskraftwerk, das viel mehr Strom auf zuverlässige Weise produzieren wird, als die 2 Milliarden Dollar an erneuerbaren Energien.

Quelle Peter Rees, auf the climate sceptics party. Es genügt, auf die grünen unterlegten Zeilen zu schauen: Kosten und output, Grundlastfähig

Peter hat einige weitere Berechnungen durchgeführt, die zur Diagnose von Wahnsinn in SA beitragen. Diesmal geht es um den Kapazitätsfaktor der Erneuerbaren Energien, der in den offiziellen Wahlinformationen der SA ohne Scham aufgeführt ist. Der Kapazitätsfaktor ist die tatsächliche Energie, die eine Elektrizitätsanlage produziert. Der Kapazitätsfaktor wird in % der Leistung der installierten Nennleistung ausgedrückt. Die Nennleistung ist die installierte Leistung [hier: der Generatoren, oder die Peak- (Spitzen-) Leistung von Solarpanels [neu und nur] bei maximalem Sonnenschein]. Hat z.B. ein neuer Windpark eine installierte Nennleistung von 100 MW, beträgt der Kapazitätsfaktor einen prozentualen Anteil davon und wird in MWh angegeben.

Aus langjähriger Erfahrung wissen wir, dass der Kapazitätsfaktor von Wind und Sonne weitaus geringer ist als die installierte Leistung, weshalb die großmäuligen Befürworter immer nur von der installierten Leistung sprechen. Aber jetzt, nachdem so viele Erfahrungen vorliegen, man kann auch sagen „Ausfälle“, kommen sie nicht umhin zuzugeben, dass die tatsächliche Ausbeute (Kapazitätsfaktor), die der blöde Wind und die Solarproduktion produzieren, viel geringer ist als die installierte Leistung.

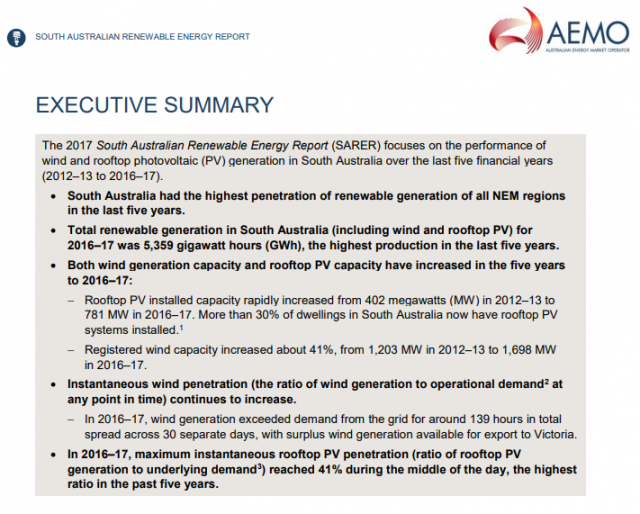

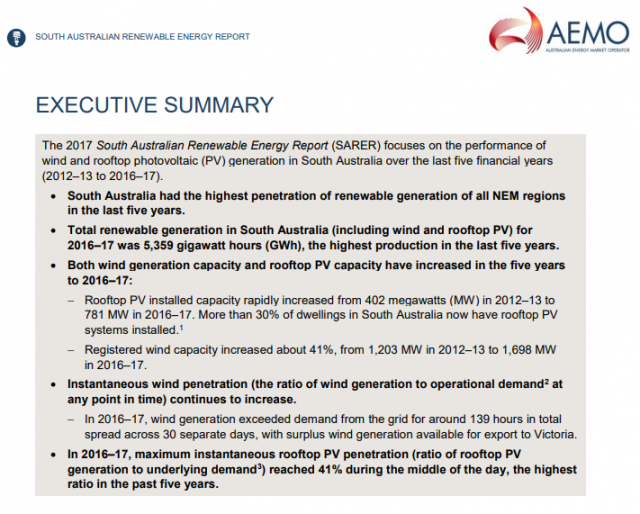

Der Bericht der SA über erneuerbare Energien für 2017 sagt auf Seite 1 der Zusammenfassung:

Die gesamte installierte PV-Kapazität auf den Dächern hat sich in den Jahren 2016-17 um 95 MW auf 781 MW erhöht. Die gesamte PV-Erzeugung auf den Dächern in Südaustralien betrug im Berichtsjahr 1.016 GWh, 12% mehr als in den Jahren 2015-16.

Peter analysiert die Verschleierung der tatsächlichen Verhältnisse:

Die installierte Leistung der SA Dach-Solaranlagen (2016-17) beträgt 781 MW, die 1016 GWh im ganzen Jahr produzierten.

Die Einheit für die elektrische (Nenn-) Leistung wird Watt genannt.

1000W = 10^3 W = 1kW (Kilowatt)

1000kW = 10^6 W = 1MW (Megawatt)

1000MW = 10^9 W =1 GW (Gigawatt)

1000GW = 10^12 W = 1 TW (Terawatt)

[[Einschub für nicht-Elektriker: Erst mit der Multiplikation der Zeit (meist in Stunden = h), in der obige Leistung tatsächlich angefordert wird, entstehen die „verbrauchten“ kWh, die am Stromzähler angezeigt und bezahlt werden müssen]]

Eine Haushaltsklimaanlage hat typischerweise eine Anschlussleistung von ca. 3-5kW

Das Kohlekraftwerk Hazelwood Powerplant konnte in seiner Blütezeit 1600MW bereitstellen.

Die durchschnittliche Nachfrage in Südaustralien liegt bei 1420 MW [konnte also allein durch ein Kohlekraftwerk erfüllt werden (im Durchschnitt)]

Haben wir eine 5kW-Solaranlage auf einem Dach installiert und die Sonneneinstrahlung ist und bleibt optimal, kann sie theoretisch 5kWh Strom in einer Stunde produzieren.

Hat man also insgesamt Solaranlagen mit der Nennleistung von 781 MW auf dem Dach, könnten diese theoretisch 781 MWh in einer Stunde produzieren. Aber die Sonne scheint nicht rund um die Uhr, Wolken blockieren den Sonnenschein, Schmutz reduziert die Absorption durch die Paneele ebenso wie der Sonnenwinkel, so dass die tatsächlich nutzbare oder besser: „verfügbare“ Leistung geringer ist.

Aber wie viel ist nun real nutzbar? Schauen Sie zurück auf die Aussage oben aus dem Bericht. Es besagt, dass 781 MW Solarzellen 1016 GWh im Jahr produzieren. Um herauszufinden, wie viel durchschnittlich in einer Stunde produziert werden würde, teilen wir das durch 365 und dann durch 24.

1016 / 365 / 24 = 0.115GWh = 115MWh

So liefern unsere 781 MW Solaranlagen durchschnittlich 115 MW je Stunde. Damit betrug die durchschnittlich nutzbare Leistung, [der Kapazitätsfaktor] 115/781 * 100 = 14,7%! und das bei einem enormen Aufwand.

Ohne das auch für Windkraftanlagen ausführlich zu berechnen (der Rechengang ist wie bei den Solaranlagen) liefert / produziert eine Windkraftanlage in den südlichen Bundesländern mit einem Kapazitätsfaktor von rund 30 % und ein Kraftwerk für fossile Brennstoffe mit einen Kapazitätsfaktor von über 90 %.

Damit kann man – zum Vergleich, nun berechnen, welchem „kleinem Kraftwerk“ die gelieferte Energie der Solaranlagen entspricht.

Die durchschnittlich nutzbare Nennleistung der Solaranlagen entspricht damit .781 x (14,7/100) = 114MW! [aufs ganze Jahr gerechnet].

Was hat die 781 MW Solaranlage, die nur 114 MW produzierte, gekostet?

Nehmen wir an, alle Solaranlagen hätten 5kW, also 781MW/5kW, dann wären das = 156,000 Anlagen.

5kW-Solarpanels auf dem Dach kosten derzeit etwa $8000, so dass die Gesamtkosten für diese Systeme dann bei etwa $1250 Millionen Dollar (156.000 x 8000) lagen!

Die Besitzer der Solaranlagen erhielten alle eine staatliche Subvention von 3000 Dollar pro System (ca.) = 468 Millionen Dollar. So zahlten die Australier 782 Millionen Dollar mit der Stromrechnung und als Steuerzahler weitere 468 Millionen Dollar.

Unter dem Strich kosteten die Solaranlagen $1250 Millionen Dollar, die dann eine durchschnittliche Leistung von 114 MW brachten, je nach aktuellem Sonnenschein mal mehr oder gar nicht, außer in der „Nacht“ [ = NULL] ist die verfügbare Energie nicht definitiv vorausplanbar. Die wahrscheinliche Lebensdauer dieses Systems beträgt 15-20 Jahre, wobei die Leistung jedes Jahr abnimmt, da die Fähigkeit der Paneele, Sonnenschein zu absorbieren, mit zunehmendem Alter abnimmt.

Aber es gibt bei den Erneuerbaren noch mehr zu bedenken: Die 14,7% Leistung der Solarpanels stehen nicht gleichmäßig zur Verfügung, es kommt – bei viel Sonnenschein und / oder wenn der Bedarf nicht so groß ist, zu viel Energie, verschlimmert durch die Kapriolen der Windkraft, was zu schädlichen Überspannungen im Netz führt. Das bedeutet, nur um die Solarpanel und die Windkraft einzubinden, enorme zusätzliche Kosten für das Stromnetz entstehen, um Transformatoren und Infrastruktur hinzuzufügen, um die unplanbare Spitzenenergie aus Wind und Solar „in den Griff“ zu bekommen. Dabei haben wir noch nicht darüber gesprochen, was der Stromlieferant macht, wenn kein oder nicht genügend Wind und Sonne da sind. [Ergebnis wie schon oft: Black-out wegen Überspannung oder Strommangel] Auch wirken die großen rotierenden Massen konventioneller Kraftwerke als „Schrittmacher“ für eine zwingend notwendige gleichmäßige Frequenz im Versorgungsnetz. Fertigungsunternehmen, öffentliche Einrichtungen aber auch Haushalte brauchen „elektrisch sauberen Strom“ und den zuverlässig und sofort, wenn der Bedarf da ist.

Bleiben wir bei dem o.g. umweltfreundlichem Gaskraftwerk mit 210 MW Nennleistung, dann hätten man für $1250 Millionen dreieinhalb Gasanlagen kaufen können, die eine Lebensdauer von 40-50 Jahren haben und rund um die Uhr zuverlässig, planbar und qualitativ hochwertig Strom liefern können

Die verantwortlichen Politiker, die dafür verantwortlich sind, zerstören Australien. Wähler, die für Leute wie Weatherill, Andrews und jeden grünen Politiker stimmen, verdienen alles, was sie bekommen, nämlich einzufrieren und im Dunkeln zu verhungern. Es ist schade, dass der Rest von uns mit ihnen untergehen muss.

The Australian Climate Sceptics Blog

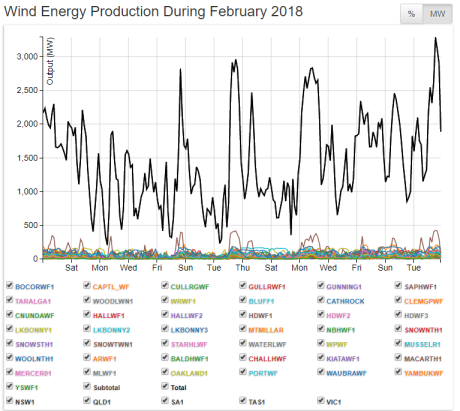

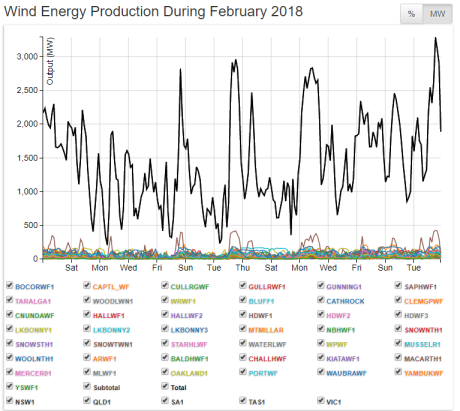

Die Grafik der Leitungsabgabe der Windanlagen in SA. Die Nennleistung liegt bei 4.675 MW. Der durchschnittliche Kapazitätsfaktor für das Los liegt bei 28%: Der beste Wert wurde von Snowtown in SA mit rund 40% erreicht, die schlechtesten kämpfen um 22%, wie etwa Infigenes Lake Bonney im Südosten.

Erschienen auf Stop These Things am 05.03.2018

Übersetzt und elektrotechnische Beschreibung angepasst durch Andreas Demmig

https://stopthesethings.com/2018/03/05/renewables-hoax-australias-biggest-retailer-agl-gets-out-of-coal-by-spending-200m-fixing-coal-fired-power-plant/

Ergänzung, auf Science Alert gefunden

Die südaustralische Batterie von Elon Musk reagierte in nur 140 Millisekunden, nachdem ein Kohlekraftwerk ausgefallen war

„Das ist ein Rekord.“

In diesem Beitrag wird euphorisch gemeldet, dass bei einem Stromausfall eines Kraftwerkes, die Batterien innerhalb von sehr kurzer Zeit Strom geliefert hätten. – ja, äöh, das ist Physik!

Wenn ein Batteriesystem parallel zum Netz angeschlossen ist, dann ist das wie beim Auto: die Batterie liefert sofort, wenn die „äußere“ Spannung zurück geht (beim Auto die Lichtmaschine, korrekter: der Generator) .

Wie lange, d.h. wie viel Energie, die Batterie ins Netz liefern konnte, davon steht nichts im Text.

PS:

in den Tagen, wo ich diesen Beitrag in der Mache hatte, sagte ein Windkraft Befürworter im Gespräch: „Die Windkraftanlagen müssen kleiner werden, dann drehen die sich auch mit weniger Wind besser“.

Meine Rückfrage: : „Wovon hängt die Energie ab, die produziert wird?„