Nach der Kältewelle steigen endlich die Temperaturen. Doch ein massiver Wetterumschwung erhöht auch das Risiko für einen Infarkt

Inzwischen kommen die Bürger auch mit dem Wetter nicht mehr alleine zurecht. Ist es Winter, muss die WHO bereits Kleidungstipps geben und auf die Kälte hinweisen [3], wohl weil zu Viele fest davon überzeugt sind, dass seit dem ominösen Klimawandel keine Winter mit Kälte vorkommen können und nicht mehr gelernt haben, wie Kleidung wärmt. Bald wird auch in Vergessenheit geraten, wofür Heizungen da sind. In Zukunft stellt diese eine App ein und das Wissen darüber, was diese App eigentlich macht, geht unwiederbringlich verloren.

Kommt zusätzlich ein Wetterumschwung, ist der Bürger inzwischen jedoch ganz neuen Gefahren ausgesetzt. Denn solche sind schnell tödlich und nehmen, wie es jeder lernt, durch den Klimawandel immer mehr zu.

Kein Wunder, dass unsere Ärzte die Gefahr erkannt haben und immer tiefschürfender zum Klimawandel-Krankheits-Zunahmerisiko forschen.

Inzwischen sind aus diesem Forschungszweig bereits Erfolge sichtbar: Auf einem Herzkongress in Orlando (USA) wurden erste, harte Fakten präsentiert. Und diese sind geradezu erschütternd:

Jeder Temperatursprung von einem Tag zum nächsten mit 5 Grad Differenz erhöht die Herzinfarktrate um satte 5 % [3]. 30.000 Herzpatienten wurden dazu untersucht. Und weil es so viele waren – und die Anzahl der Daten in der Klimawandelforschung nach einhelliger Expertenmeinung die Qualität ausmacht [5] -, kann das Ergebnis nicht falsch sein.

Wie schlimm wird es besonders gefährdete Gebiete Deutschlands, wie zum Beispiel Franken, treffen?

Wie zufällig kam gleich zur SZ-Meldung am folgenden Montag in einer Lokalzeitung die Zusatzinformation, dass Franken besonders vom Klimawandel getroffen ist

nordbayern: [4] In Franken und der Oberpfalz ist der Klimawandel längst da.

In Bayern ist es damit bereits so schlimm, dass ihn die bayerische Umweltministerin mit den Händen greifen kann, wie sie einmal berichtete.

Wer nun in einer solch gefährdeten Gegend von Deutschland lebt, wo jeden Tag das Infarktrisiko dramatisch ansteigen kann und diese Gefahr auch noch deutlich zunehmen wird, möchte natürlich wissen, wie hoch diese einzuschätzen wäre. Leider hat diese ganz praktische Frage die SZ-Journalisten nicht mehr interessiert und so blieben ihre Leser damit vollkommen alleine gelassen.

Zum Glück ist der Autor ebenfalls von dieser Fragestellung betroffen, weshalb er sich die von der SZ versäumte Mühe gemacht hat, die Auswirkungen auf im besonders gefährdeten Franken wohnende Bayernbürger abzuschätzen.

Gefährdungsanalyse Franken

In Franken liegt Nürnberg mit einer DWD Wetterstation, ID: 3668. Deren Wetterdaten sind anbei mit den Infarkt-Risikodaten ausgewertet.

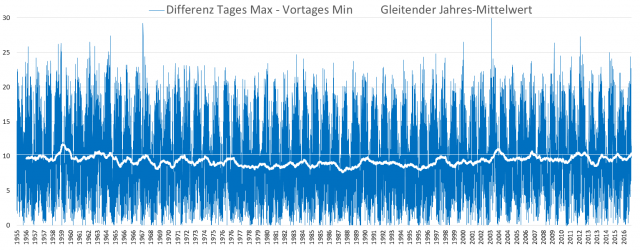

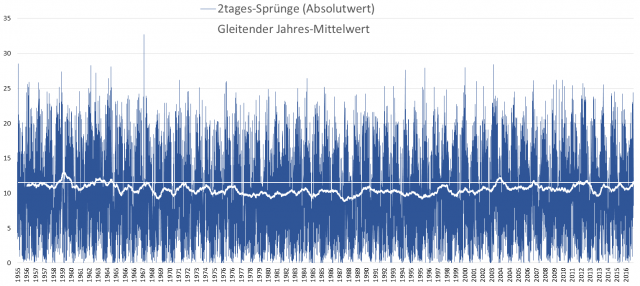

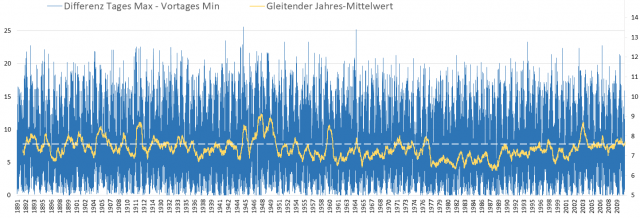

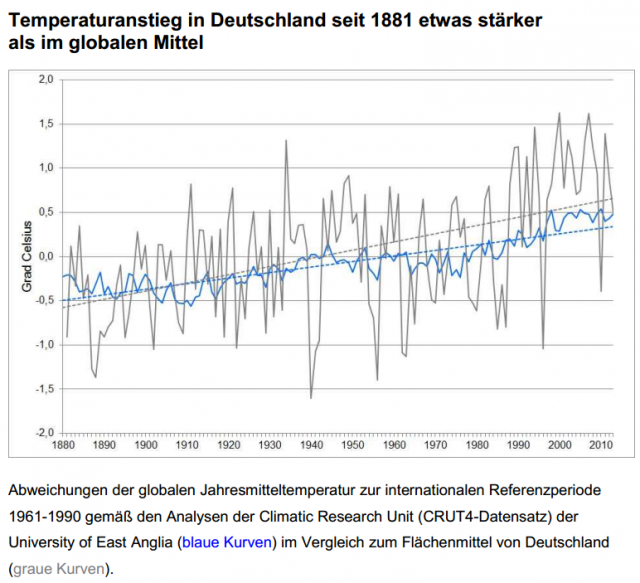

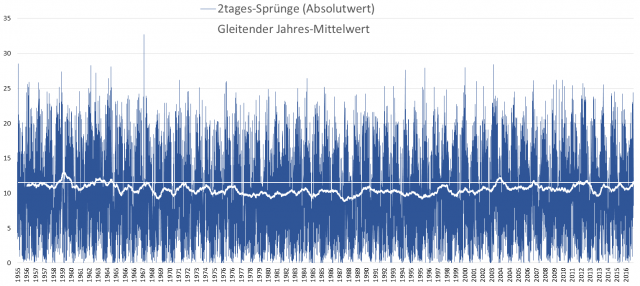

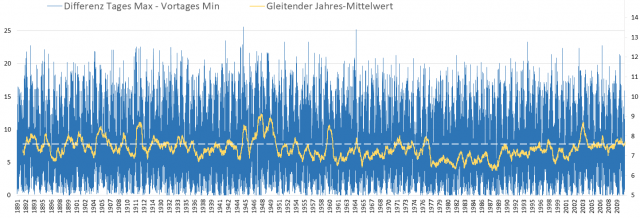

Laut den amerikanischen Ärzten ist die Temperaturdifferenz von einem Tag zum anderen die kritische Belastung. Bild 1 zeigt dazu den Absolutwert des Tages-Maximum zum Vortags-Minimalwert. Die Differenzen sind schon gewaltig und die relevanten 5 Grad Temperaturdifferenz häufig überschritten, was bedeutet: Es ist fast ständig eine deutliche Erhöhung der Infarktgefahr vorhanden.

Bild 1 Temperaturdifferenz Absolutwert des Tages-Maximum zum Vortags-Minimum mit gleitendem Jahresmittel (weiß) von 1950 – 2017 der DWD-Station Nürnberg (blau).

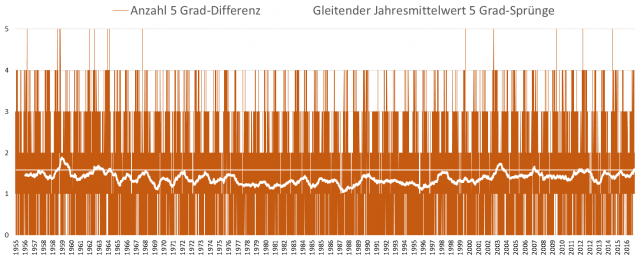

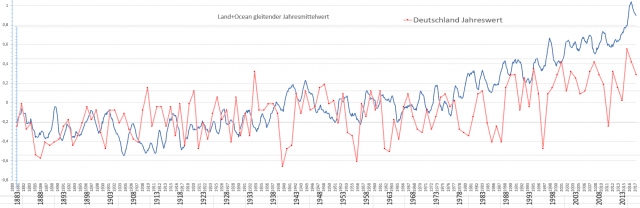

Im Folgebild sind die Werte in die „ereignisrelevanten“ 5 Grad-Sprünge geclustert, von denen jeder +5 % Infarktrisiko darstellt.

Bild 2 Die Daten von Bild 1 als Anzahl von 5 Grad Sprüngen (braun). Gleitendes Jahresmittel (weiß)

Daraus bleibt nur ein Fazit übrig: Die Temperaturwechsel haben einen hohen Anteil an der Infarktrate.

Beim Ansehen dieser Auswertebilder (-Mittelwerte) kommt man vom Thema „Temperatur-Differenz-bedingte Infarktraten-Eintrittswahrscheinlichkeits-Erhöhung“, jedoch sofort zu einer anderen Fragestellung.

Wo ist die gemeldete, Klimawandel-bedingte Verstärkung?

Im SZ-Artikel wird darauf hingewiesen, warum die „Infarkt-Erkenntnis“ so wichtig ist: Früher waren abrupte Temperaturwechsel scheinbar eine Ausnahme, während sie aufgrund des Klimawandels inzwischen normal sind und sogar weiter zunehmen:

SZ: [3] … Diese Forschung wird wichtiger, denn mit dem Klimawandel häufen sich Wetterextreme. Abrupte Temperaturwechsel von Tag zu Tag sind dann keine Ausnahme mehr …

Leider widersprechen bereits die Bilder 1 und 2 dieser Aussage der Süddeutschen Zeitung. Weder absolut, noch geclustert haben sich die relevanten Temperaturdifferenzen seit Beginn der Messreihe (und das ist genau der Beginn des starken Klimawandels) signifikant verändert. Und dass sie heutzutage gegenüber früher zugenommen hätten, oder würden, zeigen die bisherigen, beiden Auswertebilder ebenfalls nicht.

Die SZ-Aussage einer Erhöhung der Temperatur-Differenzen ist falsch

Wenn die Bilder 1 und 2 stimmen, muss sich die angegebene Häufung der Temperatur-Differnezextreme wo anders verstecken.

Deutschland ist beim Wetter nicht so extrem, wie die USA. Es könnte also sein, dass bei uns erst die Temperaturdifferenz von zwei Tagen das relevante Ergebnis liefert.

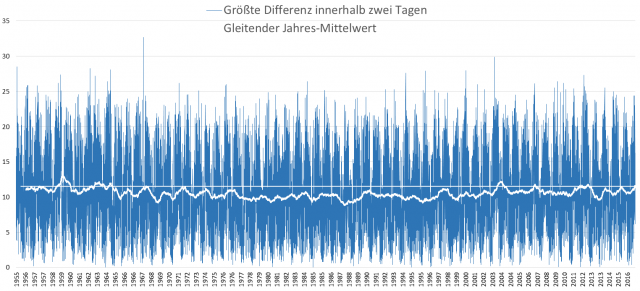

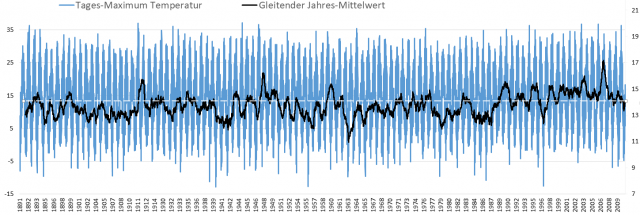

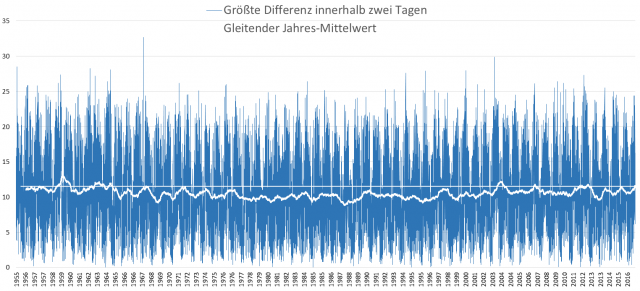

In den folgenden Grafiken sind nun dazu die Differenzen nach Absolut- und Maximalwerten dargestellt. Doch unabhängig, wie man auswertet, das Ergebnis lautet: Es gibt keine Erhöhung der Temperaturdifferenzen.

Somit bleibt nur eine Schlussfolgerung übrig:

Die Aussage in der SZ: [3] … denn mit dem Klimawandel häufen sich Wetterextreme. Abrupte Temperaturwechsel von Tag zu Tag sind dann keine Ausnahme mehr …, ist ganz einfach falsch!

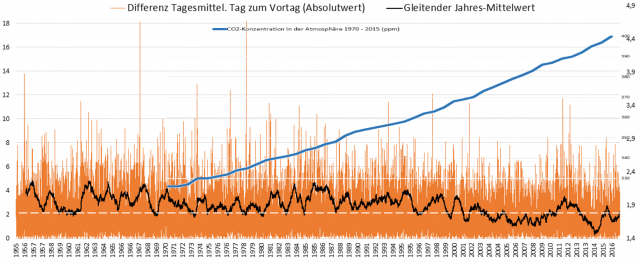

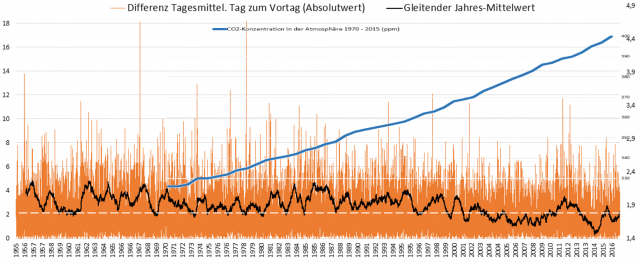

Es ist nicht erkennbar, dass die gestiegenen Temperaturen zu mehr Extremen führen. Und das bestätigen auch die weiteren Temperaturdifferenz-Auswertungen. Bild 5 zeigt sogar eindeutig eine erhebliche, negative Korrelation zwischen CO2-Eintrag und Vortages-Temperaturdifferenz.

Bild 3 Absolute Temperaturdifferenz zweier Folgetage Min. zum Maximumwert mit gleitendem Jahresmittel von 1950 – 2017 der DWD-Station Nürnberg

Bild 4 Maximale, absolute Temperaturdifferenz während ein- bis zweie Folgetagen, Min. zum Maximumwert mit gleitendem Jahresmittel von 1950 – 2017 der DWD-Station Nürnberg

Nun könnte es sein, dass nicht die Maximalwerte, sondern nur das Tagesmittel vom Klimawandel betroffen ist. Anbei deshalb die absolute Differenz des Tagesmittels zum Vortagesmittel. Deren Differenzen haben durch den „Klimawandel“ eindeutig abgenommen. Gut erkennbar darin die (negative) Korrelation zwischen CO2-Konzentratio und Abnahme der Tagesmittel-Differenzen.

Bild 5 Differenz Tagesmittel zum Vortag von 1950 – 2017 der DWD-Station Nürnberg (braun). Gleitendes Jahresmittel (schwarz, Maßstab rechts). Darüber kopiert der CO2-Konzenrationsverlauf von 1970 – 2015 (blau)

Findet sich der Klimawandel-Einfluss, wenn man noch weiter zurückschaut?

Nun könnte es sein, dass die Auswertung falsch ist, weil der Zeitraum der Nürnberger Datenreihe zu kurz ist. Im Artikel der nordbayerischen Nachrichten findet sich dazu nämlich eine Hinweis:

nordbayern: [4] … Extreme Wetterereignisse wie der Starkregen vor zwei Jahren waren in den letzten 15 Jahren in Deutschland wesentlich häufiger als im Jahrhundert davor ...

Man muss wohl das ganze, vorherige Jahrhundert auswerten, um mit den letzten 15 Jahren vergleichen zu können. Leider findet sich dazu keine Station in Franken (mit Tagesauflösung), doch die Datenreihe von Aachen reicht zum Beispiel so weit zurück.

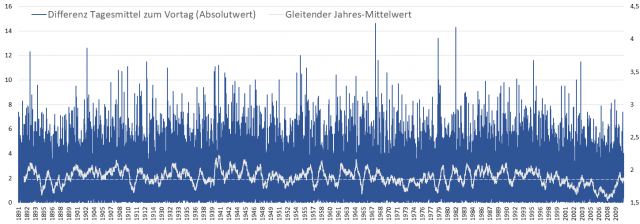

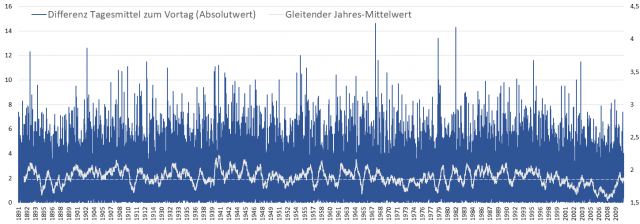

Also das Analysespiel anhand der Tagesdaten von Aachen nochmals durchgeführt. Das Ergebnis:

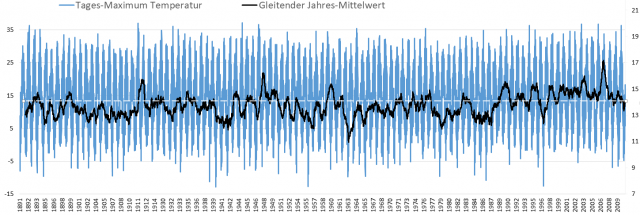

Es zeigt sich nun noch deutlicher, dass der ominöse Klimawandel die Temperaturdifferenzen nicht erhöht.

Leider endet die Messreihe von Aachen mit dem Jahr 2011, so dass von den wichtigen, letzten 15 Jahren einige fehlen. Der Autor wagt jedoch die Behauptung, dass diese letzten, fehlenden Jahre am Auswerte-Ergebnis wenig ändern würden.

Bild 6 Temperaturdifferenz Tagesmittel zum Vortag und gleitendes Jahresmittel (Maßstab rechts)von 1891 – 2014 der DWD-Station Aachen (ID: 3)

Bild 7 Temperaturdifferenz des Vortages-Min. zum Maximumwert des Folgetages und gleitendes Jahresmittel (Maßstab rechts) von 1891 – 2014 der DWD-Station Aachen (ID: 3)

Bild 8 Tagesmaximum und gleitendes Jahresmittel (Maßstab rechts) von 1891 – 2014 der DWD-Station Aachen (ID: 3)

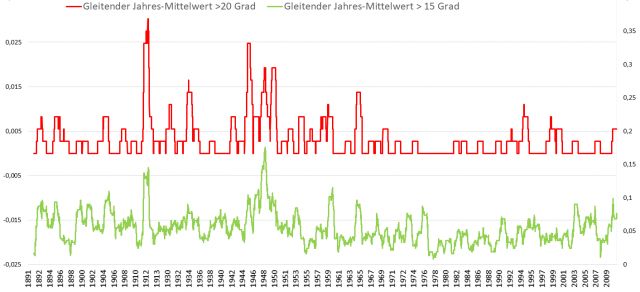

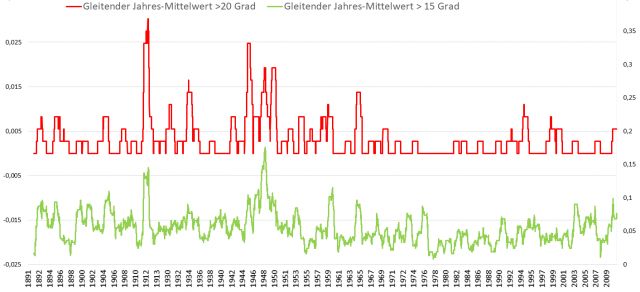

Als Abschluss noch eine Prüfung, ob wenigstens die großen Temperaturdifferenzen durch den Klimawandel zugenommen haben. Doch auch dazu ergibt die Langzeitreihe eine vollständige Entwarnung.

Bild 9 Gleitende Jahresmittel der Folgetage mit Temperaturdifferenzen >15 Grad (grün) und >20 Grad (rot) von 1891 – 2014 der DWD-Station Aachen (ID: 3)

Zu Extremereignissen gehören auch Starkniederschläge. Dass es sich bei Starkregenereignissen ebenfalls nicht anders verhält, wurde bereits in früheren Artikeln gezeigt:

EIKE 22.08.2017:

Verschiebt der Klimawandel Europas Hochwässer dramatisch

EIKE 12.08.2017:

Die Starkregen vom Juli 2017 in Deutschland sind (keine) Menetekel eines Klimawandels

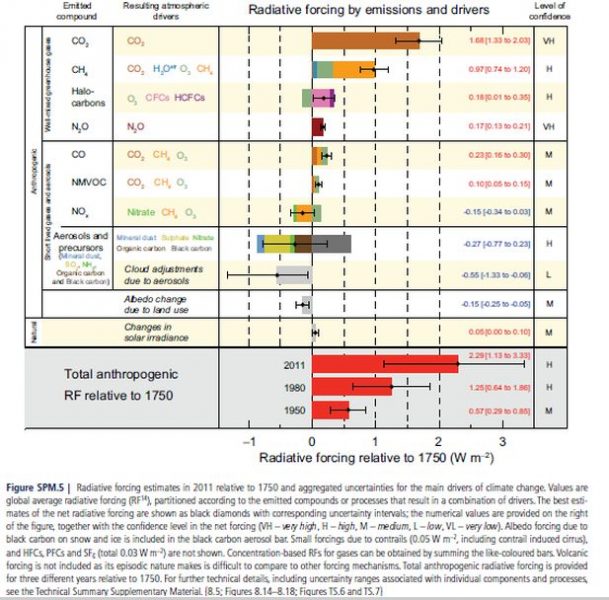

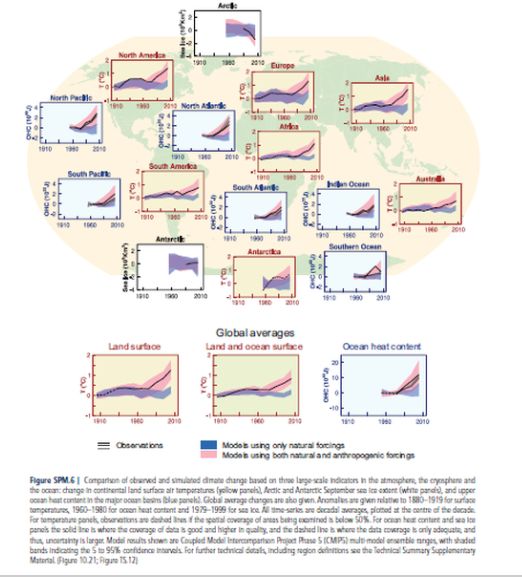

Einflüsse des Klimawandels auf die Infarkt-Mortalität

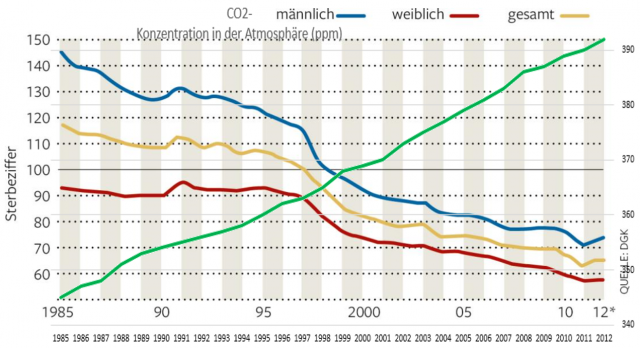

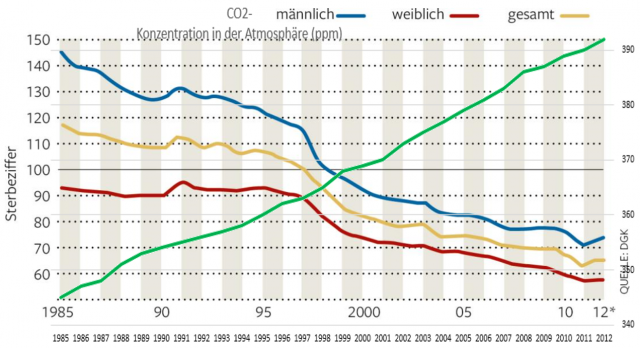

Korrelationen sind so herrlich statistisch und klingen toll nach Wissenschaft. Deshalb zeig das Bild 10 eine solche zwischen der Infarktmortalität und CO2-Konzentration in der Atmosphäre: Die Verläufe sind eindeutig hoch signifikant negativ korreliert und belegen, dass die sich erhöhende CO2-Konzentration dem menschlichen Herzen genau so gut tut, wie den nach CO2 dürstenden Grünpflanzen.

Bild 10 Sterbeziffern Herzinfarkt Deutschland von 1985 – 2012. Quelle: Die Welt. Vom Autor darüber gelegt der Verlauf der CO2-Konzentration in diesem Zeitraum (grün)

Jeder weiß, dass gerade die Mittelmeerländer besonders vom Klimawandel gebeutelt werden.

Frankfurter Allgemeine, 27.10.2005:

Klima: Mittelmeerländer leiden besonders unter Klimawandel

Dazu der erkennbar, sehr positive Einfluss des Klimawandels auf die Infarkt-Sterberate in verschiedenen EU-Ländern, welche nahe am Mittelmeer oder im Süden liegen.

Bild 11 Infarkt-Sterberaten verschiedener EU-Länder. Quelle: Ärzte-Zeitung

Abschlussergebnis der kleinen Recherche

Wenn es einen Bereich der Wissenschaft gibt, der seine Reputation ständig neu verliert, und einen Bereich der Leserinformation, mit dem unsere Medien immer neu belegen, wie ideologisch hinterlegt „berichtet“ wird, dann gehört das Thema (AGW-)Klimawandel dazu.

Der hier rezensierte Artikel der SZ zeigt zudem, warum gerade die Süddeutsche Zeitung oft als „Alpenprawda“ betitelt wird.

Verlegt sich (wie bereits zu erkennen ist) die forschende Ärzteschaft in Zukunft zum „Abzapfen“ von Fördermitteln nun verstärkt auf den Klimawandel als Mortalitäts- und Krankheitsfaktor, dürften in kurzer Taktung immer neue „Erkenntnisse“ ans Licht kommen. Ob diese den Patienten helfen, wird man nicht fragen dürfen.

Ergänzender Hinweis: Mehr Details zur Studie, als in den deutschen Medien (und hier) berichtet wurden, lassen sich nachlesen bei: [6] WUWT: The latest medical malpractice: blaming “climate change” for heart attacks

Behörden als Propagandainstitute

Die SZ ist natürlich nicht alleine. Unsere Behörden gehen mit „gutem Beispiel“ voran. Eine ganz aktuelle Pressekonferenz des DWD zeigte es wieder exemplarisch:

Pressemitteilung: [7] Klima-Pressekonferenz 2018 des DWD

… In seinem Rückblick auf das Wetter und Klima im vergangenen Jahr hob der DWD hervor, dass das Jahr 2017 weltweit erneut eines der drei wärmsten Jahre seit Aufzeichnungsbeginn 1881 war. Der Trend zur globalen Erwärmung ist also, so Dr. Thomas Deutschländer, Klimaexperte des DWD, nach wie vor ungebrochen …

Das Jahr 2017 brachte in Deutschland viele Wetterextreme

„Das Jahr 2017 stand hierzulande aber auch ohne neuen Rekord ganz im Zeichen des Klimawandels“ so Deutschländer. Dies zeigte nicht nur die Verteilung statistisch betrachtet zu warmer und zu kalter Monate. So waren nur der Januar und September im Vergleich zum vieljährigen Mittel zu kühl. Auffällig seien auch die vielen Extremereignisse gewesen. Wiederholt kam es zu Sturm und Starkregen. Als Beispiele nannte der DWD-Experte die Stürme Axel im Januar 2017 sowie Xavier und Herwart im Oktober 2017. Tief Rasmund brachte der Stadt Berlin und dem Umland am 29. Juni an nur einem Tag Niederschlagsmengen von rund 150 Litern pro Quadratmeter (l/m2). An der Wetterstation Tegel wurde sogar ein Spitzenwert von 196,9 l/m2 gemessen. Hinzu kamen extreme Witterungsabschnitte, wie eine andauernde Trockenheit im Frühjahr oder das anhaltend trübe Wetter zwischen September 2017 und Januar 2018. So summierte sich das Sonnenscheindefizit in diesem grundsätzlich eher sonnenscheinarmen Zeitraum deutschlandweit auf über 74 Stunden. Außergewöhnlich war auch der neue Temperaturrekord für den März 2017. Mit einer Mitteltemperatur von 7,2 °C und einer Abweichung von +3,7 Grad wurde der bisherige Rekord von 1938 und 1989 um 0,2 Grad übertroffen.

Ob solche meteorologischen Extremereignisse zugenommen haben, sei allerdings statistisch nach wie vor schwierig nachzuweisen. Als Gründe nannte Deutschländer häufig noch zu kurze Beobachtungsreihen, die hohe natürliche Klimavariabilität sowie Probleme bei der flächendeckenden Erfassung von kleinräumigen Ereignissen. Dennoch sei die beobachtete Häufung solcher Ereignisse auch 2017 ein Indiz für die Annahme vieler Klimaforscher, dass extreme Wettersituationen mit weiter steigenden Temperaturen zunehmen dürften.

Selbstverständlich kommen nur harte Fakten vor. Doch werden extreme Ereignisse ganz bewusst so gelistet, als ob es Klimawandel-bedingt, zunehmende wären. Obwohl der Fachmann des DWD genau weiss, dass es nicht „statistisch nach wie vor schwierig nachzuweisen“ sei, sondern bewiesen ist, dass es diese Extremereignisse schon immer gab und sie deshalb mit einem (AGW-)Klimawandel nichts zu tun haben. Es gibt – und das sollte gerade mit diesem Artikel (wieder) gezeigt werden, keine „ … beobachtete Häufung solcher Ereignisse … „. Die „ … Probleme bei der flächendeckenden Erfassung von kleinräumigen Ereignissen … „ können das Problem schon gar nicht lösen, denn die damit gewonnenen Daten lassen sich nicht mit den historischen vergleichen (was man natürlich trotzdem macht, indem man in die Vergangenheitsdaten simuliert).

Wer die wohl wissentlich falschen Darstellungen nicht glaubt, sollte sich bei kaltesonne die gerade erschienene Listung historischer Extremereignisse ansehen. Heute auftretend, würden viele wohl zu sofortigen Massenpaniken führen.

kaltesonne 6. März 2018: Extremwetter in den letzten tausend Jahren

… Extremwetter Fazit

Selbst wenn man den Chronisten einige Übertreibungen unterstellt, dürfte feststehen, dass Extremwetter in der Vergangenheit nicht seltener, sondern öfter eintraten und diese Ereignisse nicht harmloser, sondern schlimmer waren, als das was wir heute erleben. Verglichen mit den vergangenen 1000 Jahren, leben wir heute in einer ruhigen Zeit. Am ähnlichsten scheint mir noch das 13. Jahrhundert mit dem 20. Jahrhundert zu sein. Zwar scheinen Hunger in einer globalisierten Wirtschaft nicht mehr vorstellbar, zumindest in den s. g. entwickelten Ländern. Auf die Marktpreise hat das Wetter auch heute noch Einfluss, wie man selbst bei kleinen Wetterabweichungen wie ein Spätfrost im April in 2017 beobachten konnte. Da erfroren mal eben die Blüten an den Obstbäumen und schon waren Kirschen und Äpfel knapp und teuer.

Was würde heute geschehen, wenn wie in all den Jahrhunderten der kleinen Eiszeit, die Flüsse in Europa zufrieren würden, oder der Winter von Oktober bis Juni anhält? Wie würden wir reagieren, wenn Niederschläge und Überschwemmungen, oder Hitze und Dürre Ausmaße annehmen wie sie die Chronisten beschrieben haben? Und wer garantiert uns, dass es nicht doch wieder mal so kommt, denn Extremwetter hat es zu allen Zeiten gegeben, egal ob das Klima kälter oder Wärmer war. Es hat den Anschein, dass es in den wärmeren Perioden etwas weniger Wetter-Abweichungen vom „Normalen“ gab. Das mag aber auch daran liegen, dass die Extreme zum Kalten hin für uns Menschen schädlicher sind als die zum Warmen hin. Klar dürfte auch sein, dass wir Menschen Extremwetter nicht verhindern und auch nicht herbei zaubern können, selbst nicht mit Kohlendioxyd.

Wie subtil und konsequent der DWD in seinen alarmistischen Darstellungen vorgeht, zeigt ergänzend ein Beispiel aus der DWD-Publizierung: Klima-Pressekonferenz des Deutschen Wetterdienstes am 25. März 2014 in Berlin: Zahlen und Fakten zum Klimawandel in Deutschland

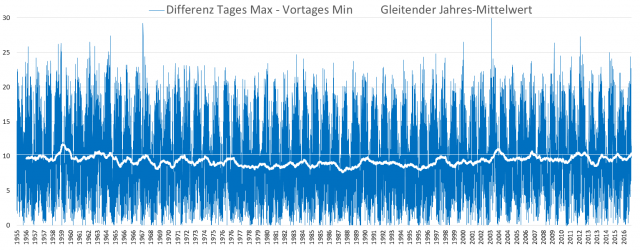

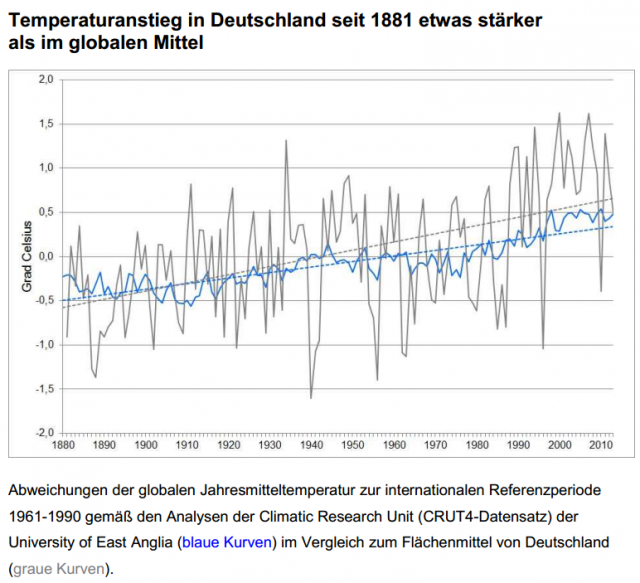

Auf der Seite 34 sieht man dort die folgende Information mit Schaubild:

Bild 12 Quelle [8]

Dazu gibt es eine Rezension des Autors:

EIKE 23.10.2017:

Deutschland erwärmt sich schneller als der Rest der Welt – oder etwa doch nicht?

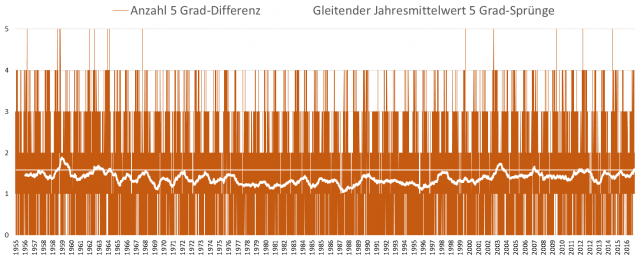

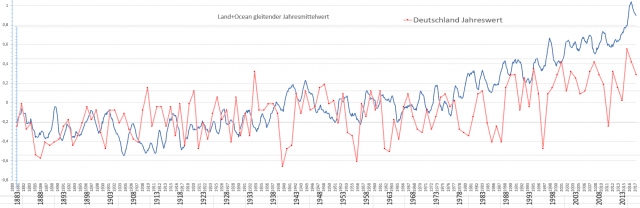

mit dem folgenden Bild 13. Darin sind die Daten von Bild 12 (mit dem alternativen, aber fast identischen Giss-Globaldatensatz), durch Skalierung der Deutschland-Temperaturreihe angepasst worden, um einen Vergleich zu ermöglichen.

Und sofort sieht man, dass die Verläufe aus zwei Zeitsegmenten bestehen und die Temperatur Deutschlands seit den 60er Jahren des letzten Jahrhunderts deutlich langsamer als der globale Durchschnitt steigt. Man könnte sogar so weit gehen, zu behaupten, die linearen Regressionen ergeben falsche Werte und Deutschland „hinkt“ sogar seit 1881 „hinterher“.

Ein exemplarisches Beispiel, wie man Information in die gewünschte Richtung „dreht“.

Bild 13 [9] GISS Globaltemperatur 1880 – 2017 (gleitendes Jahresmittel, blau) und Deutschland DWD Jahreswerte (rot) übereinander gelegt (mit Anpassung an den Anfangs- bis Mittelteil des Zeitraums). Temperaturachse der Deutschlandwerte nicht mit den GISS-Werten übereinstimmend. Grafik vom Autor erstellt

[1] SZ 3./4. März, Printausgabe: „Herzenssache“

[3] SZ 3. März 2018:

Herzschmerz nach dem Frost

[4] nordbayern:

In Franken und der Oberpfalz ist der Klimawandel längst da

[5] Flashcrash Klimaalarm. Wer Klimaalarm posaunt, bekommt immer recht (Teil 2)

[6] WUWT March 4, 2018:

The latest medical malpractice: blaming “climate change” for heart attacks

[7] 06.03.2018

Pressemitteilung zur Klima-Pressekonferenz 2018 des DWD

[8] DWD-Broschüre: Klima-Pressekonferenz des Deutschen Wetterdienstes am 25. März 2014 in Berlin: Zahlen und Fakten zum Klimawandel in Deutschland

[9] EIKE 23.10.2017:

Deutschland erwärmt sich schneller als der Rest der Welt – oder etwa doch nicht ?