Der Januar zeigt keine Klimaerwärmung

Laut Deutschem Wetterdienst – DWD – war der abgelaufene Januar mit einem Schnitt von 3,7 C der sechstwärmste seit den Temperaturaufzeichnungen 1881, wobei wir jedoch anmerken müssen, dass die Wetterstationen damals an ganz anderen und viel kälteren Plätzen standen. Im Folgenden wollen wir nun diesen Januar an verschiedenen Orten über die letzten 30 Jahre betrachten, denn 30 Jahre sind laut Definition die kleinste Klimaeinheit. Und schon über die letzten 30 Jahre zeigt sich für Deutschland Überraschendes:

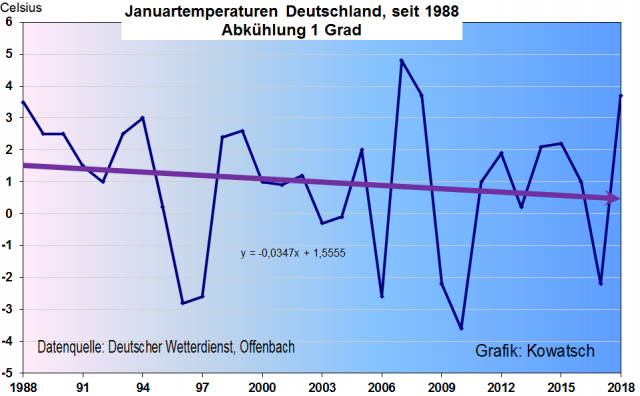

Grafik1: Der Wintermonat Januar wurde überhaupt nicht wärmer in den letzten 30, bzw. 31 Jahren, trotz des sehr milden Januars 2018. Die Trendlinie zeigt eine deutliche Abkühlung. Seit 1988 fallen die Januartemperaturen in Deutschland. Der Januar wird kälter und nicht wärmer.

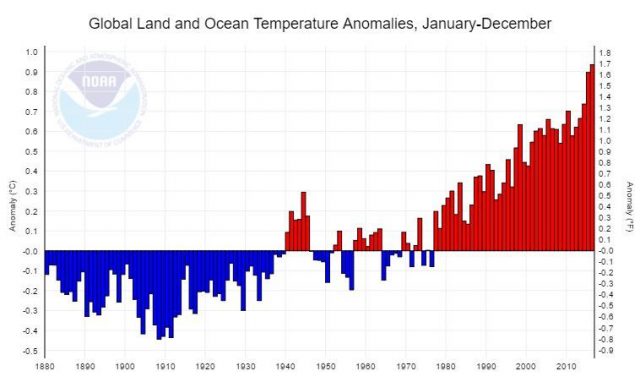

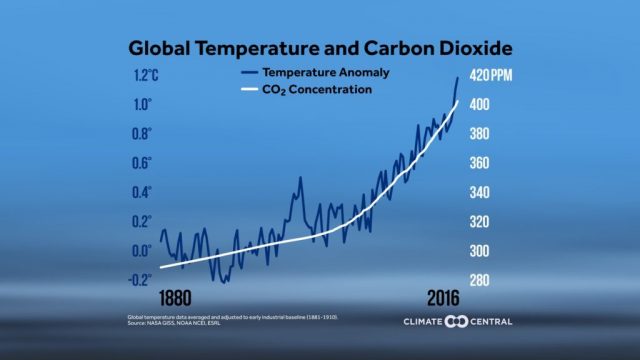

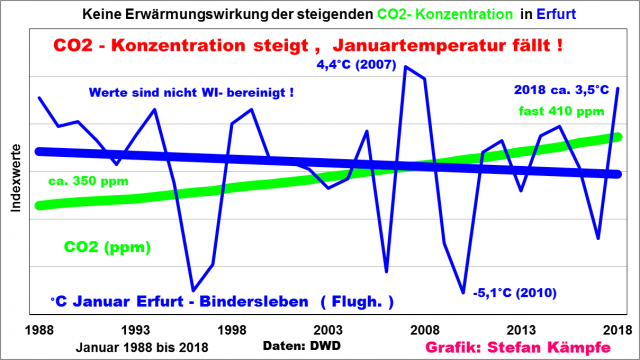

Und wie gegensätzlich sich die Januar- Temperaturen und die CO2- Konzentration entwickelt haben, zeigt die folgende Grafik am Beispiel der DWD- Station Erfurt/Weimar. Die Kohlendioxidkonzentration der Atmosphäre steigt, der Monat Januar wird hingegen leicht kälter.

Grafik 2: Januar- Temperaturentwicklung in Erfurt (316m) seit 31 Jahren. Um sie in einem Diagramm mit der CO2-Konzentration, welche von 350 ppm (1988) auf fast 410 ppm (Anfang 2018) am Mauna-Loa-Observatorium gestiegen ist, darstellen zu können, mussten Indexwerte berechnet werden. Den wärmsten Januar seit 1988 gab es hier 2007 mit +4,4°C, den kältesten 2010 mit minus 5,1°C.

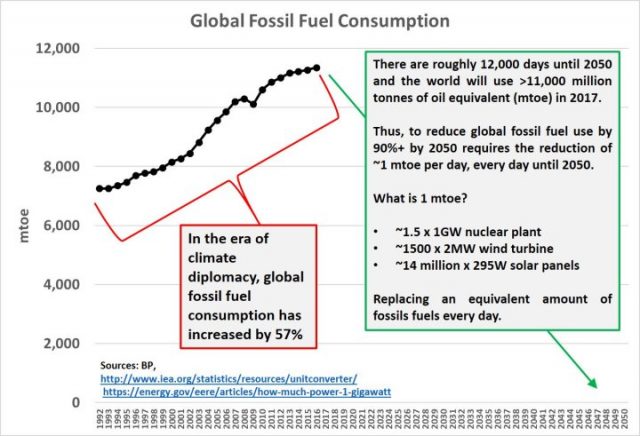

Nun sind diese Messungen des DWD nicht wärmeinselbereinigt. Seit 1988 hat die Bevölkerung Deutschlands leicht zugenommen, vor allem aber wurde überall gebaut, täglich kommen fast 100 ha an Gebäuden und Straßen hinzu, Heizungen und Autos haben zugenommen und die gesamte in den Molekülen gespeicherte Wärme der fossilen Energieträger dient der Aufheizung der Städte und der freien Landschaft. Neuerdings heizen die „Erneuerbaren Energien“ der freien Landschaft kräftig ein, denn die Windräder verhindern, dass sich nachts eine bodennahe Kaltluftschicht bildet; tagsüber bremsen sie den kühlenden Wind in Bodennähe. Und die Solarpaneele der „Solarparks“ wandeln kaum 10% der Solarenergie in Strom um, absorbieren aber durch ihre dunkle Oberfläche fast alle übrige eintreffende Solarenergie, während die ungestörte, im Januar nicht selten schneebedeckte Landschaft fast alle Solarenergie reflektiert. In den Städten und Ansiedlungen bleibt kein Schnee mehr liegen, dafür sorgt auch ein immer besser funktionierender Winterdienst.

Diese schleichende, jährlich wachsende Zusatzwärme ist in den DWD-Messdaten verborgen. Könnte man Sie herausrechnen, also um einen Wärmeinselfaktor –WI- korrigieren, dann wäre die Abkühlung noch stärker. Die menschengemachte Zusatzwärme wirkt der Januarabkühlung entgegen, ohne diese Zusatzwärme würde die Trendlinie noch stärker fallen.

Wir fragen uns: Wie hoch ist diese menschengemachte Zusatzerwärmung im Zeitraum der letzten 30 Jahre? bzw. wie stark wäre die Januarabkühlung in Deutschland, wenn sich unser Land in diesem Zeitraum überhaupt nicht durch Menschenhand verändert hätte.

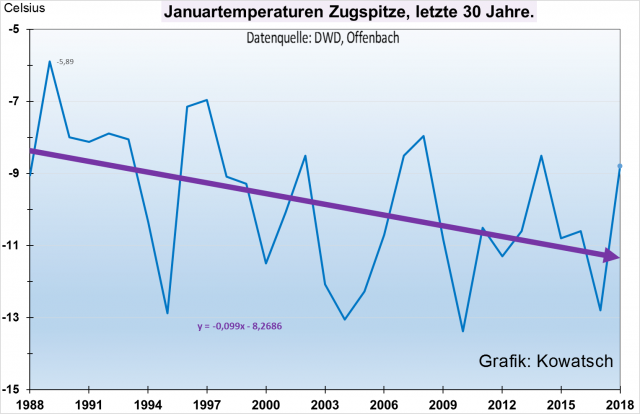

Um diese Frage zu beantworten, betrachten wir 2 Klimastationen. Die Zugspitze und Amtsberg im Erzgebirge. Deutschlands höchster Berg hat im Winter fast keinen WI-effekt, da die Besucher im kalten Januar ausbleiben. Wegen der vor allem in diesem Januar 2018 fast immer geschlossenen Wolkendecke über dem Flachland und dem starken Wind (ruhige, antizyklonale Wetterlagen, welche WI- Effekte begünstigen, gab es kaum), blieb auch die Erwärmung von unten, also über die Siedlungsheizung, weitgehend aus.

Grafik 3a: Und wie erwartet, ist der Januar 2018 auf der Zugspitze überhaupt nicht so mild wie im Flachland. Was aber mehr auffällt: Der Januar 2018 ist etwa gleich wie der Januar 1988. Insgesamt sinken die Temperaturen wie die Trendlinie deutlich zeigt. Innerhalb der letzten 30 Jahre war der Januar 2018 nur der elftwärmste.

Damit lag der Hochwintermonat nur um 1,5 Grad über dem Schnitt des Zugspitz-Betrachtungszeitraumes 1981 bis 2010, für das restliche Deutschland gibt der DWD den Monat auf seiner homepage mit 3,4 Grad „zu warm“ an.

Wir stellen fest: Die Januartrendlinie für die Zugspitze ist stark fallend. In der Höhe Deutschlands wurde es deutlich kälter in den letzten 30 Jahren. Die Trendlinie zeigt eine Abkühlung von deutlich über 2 Grad.

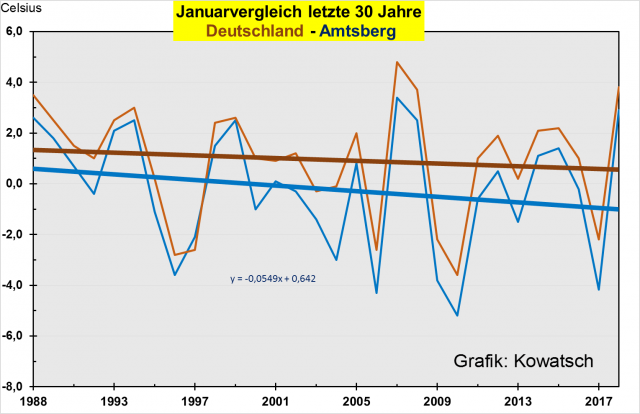

Über einen Leser haben wir den Zugriff auf die Station Amtsberg am Fuße des Erzgebirges erhalten. Glücklicherweise scheint dort die Zeit seit fast 30 Jahren stehen geblieben zu sein, so dass wir die Station als fast WI-frei und in einer größeren Umgebung als fast unbeeinflusst bezeichnen können. In der folgenden Grafik sehen wir den Januarverlauf der DWD-Stationen und Amtsberg im Vergleich zueinander.

Grafik 3b: Bei der fast WI-freien Station Amtsberg (blau gezeichneter Temperaturverlauf) am Fuße des Erzgebirges in der Nähe von Chemnitz sehen die letzten 30 Januarmonate ähnlich aus wie die DWD-Grafik, die Trendlinie ist jedoch stärker fallend als beim DWD-Gesamtschnitt. (negativere Steigungsformel)

Es gibt zu den DWD-Werten für Gesamtdeutschland jedoch zwei Unterschiede:

- Der Monat Januar ist gegenüber dem Deutschlandschnitt etwa um 1 Grad kälter.

- Die Trendlinien gehen auseinander, der Januar kühlt in ländlichen Gebieten stärker ab als in größeren Ansiedlungen oder gar Städten.

Das führt im Endeffekt dazu, dass die Trendlinie von Amtsberg fallender ist als die von Deutschland. Wie aus der Grafik 3b ersichtlich, wurde der Januar in Deutschland kälter, aber in Amtsberg noch kälter. Der Unterschied der beiden Trendlinien ergibt eine Größenabschätzung auf den Januar-Wärmeinseleffekt für Deutschland in den letzten 30 Jahren.

Überschlag: Die DWD-Trendlinie ist um 1 Grad gefallen, die von Amtsberg fast um 2 Grad. Demnach beträgt der WI Deutschlands für den Monat Januar über die letzten 30 Jahre fast ein Grad, wobei anzumerken ist, dass der Vergleich einer einzelnen Station mit dem „Rastermittel“ des DWD nur grobe Hinweise liefern kann.

Dieser Betrag entspricht etwa dem, den Raimund Leistenschneider aus seiner statistischen Erhebung mit 0,6K für die letzten 35 Jahre für die DWD-Jahresmittelwerte errechnet hat.

Fehlerabschätzung: Nun könnte man natürlich einwenden, dass es sich nur um den Januar handelt, und in diesem Monat wird besonders viel geheizt, ebenso verbrauchen die Autos 30% mehr Sprit und der Stromverbrauch liegt im Januar ebenfalls um 50% höher als in den Sommermonaten. Und jedwede Energie wird am Schluss als Wärme in die Landschaft freigesetzt. Haben wir durch die Auswahl des Monates Januar also cherry- picking betrieben?

Auch lassen wir den Einwand zu, dass sich das Erzgebirge in den letzten 30 Jahren mehr abgekühlt haben könnte als das restliche Deutschland. Trotzdem waren wir bei unserer Arbeit selbst überrascht, dass sich der in den deutschen Daten versteckte, schleichend anwachsende WI-effekt auf so einfache Weise zeigen lässt, und dass unsere bislang angegebene Größenordnung des WI stimmt. Der DWD gibt inzwischen längst zu, dass seine erhobenen Daten nicht wärmeinselbereinigt sind.

Und wer von den Lesern zum ersten Male von unserem WI-Korrekturfaktor hört und nur staunt, dem sei lediglich gesagt: Dass man die Temperaturen von heute und von früher nicht direkt vergleichen kann, da sich die Umgebung der Stationen durch die menschliche Bebauung wärmend verändert hat.

- Ab 20 Jahre Zeitdifferenz braucht man einen WI-Korrekturfaktor.

- Der WI-Korrekturfaktor ist umso höher, je größere Zeiträume man betrachtet.

Wir möchten abschließend aber auch betonen, dass die Leiter der Wetterstationen zuverlässig arbeiten, ihre erhobenen Daten sind nicht anzweifelbar. Diese und der DWD in Offenbach können nichts dafür, dass sich Deutschland laufend durch menschliche Eingriffe wärmend verändert. Umso größer dürfte die Überraschung sein, dass der Monat Januar sich trotz dieser WI-Zusatzwärme seit 30 Jahren deutschlandweit sogar abkühlt.

Ein Blick über den Ozean:

Auch an anderen Orten der Nordhalbkugel gibt es die Wärmeinselproblematik; und an wärmeinselarmen Stationen zeigen sich Abkühlungstendenzen. Weil bis Redaktionsschluss nicht alle internationalen Januar- Werte für 2018 vorliegen, endet die folgende Grafik mit 2017.

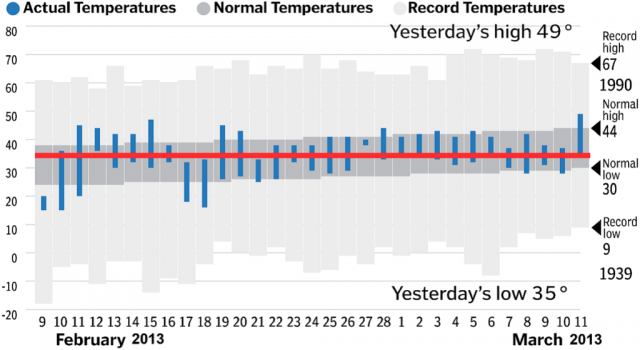

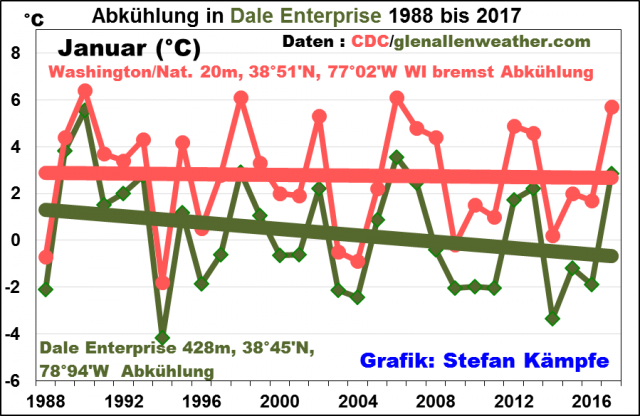

Grafik 4: Die abseits bei einer Farm in Virginia gelegene Enterprise Dale-Weather Station zeigt ebenfalls eine deutliche Januarabkühlung. Im Gegensatz dazu wurde der Januar im gleichen Zeitraum in der Bundeshauptstadt Washington kaum kühler.

Wobei anzumerken ist, dass der Januar 2018 bei Dale Enterprise, also bei der isoliert stehenden Farm in Virginia bitterkalt war und die grüne fallende Trendlinie bestätigen wird. (Grafik endet 2017)

Der Vollständigkeit halber sei erwähnt, dass in Zentralengland, Nordjapan und Mittelschweden ebenfalls eine Januar- Abkühlung seit 30 Jahren zu beobachten ist. In anderen Teilen der Welt kam es in diesem Januar 2018 zu neuen Kälte- oder Schneehöhenrekorden. Darüber wurde sogar kurz in den Medien berichtet; in Deutschland ehr lustlos, denn den hierzulande meist links- grünen Journalisten passen Nachrichten über mehr Kälte und Schnee nicht ins Konzept. Betroffen waren außer Nordamerika auch Sibirien, Zentral-, Süd- und Ostasien. Näheres dazu unter anderem hier

https://www.iceagenow.info/massive-snow-dump-iran/ hier https://www.iceagenow.info/lowest-temperature-ever-recorded-bangladesh-history/ und hier https://www.eike-klima-energie.eu/2018/01/21/sind-ihnen-die-tage-zurzeit-zu-kalt-dann-lesen-sie-hier-etwas-ueber-sibirien/ . Das „Zu wenig Winter“ bei uns heuer in Deutschland bedeutet eben ein „Zu viel Winter“ andernorts. Schuld sind die Zirkulationsverhältnisse, welche Kälte und Wärme ungleich verteilt haben.

Wir fordern unsere Leser auf, anhand unserer Grafiken den Medien vor Ort mitzuteilen, dass der Monat Januar nicht wärmer, sondern seit 30 Jahren kälter wird und dass die Klima-Abkühlung des Monates Januar viel größer wäre, wenn man die schleichend wachsende Zusatzwärme aus den DWD-Daten heraus korrigieren würde. Das zeigen die Januardaten der Zugspitze oder die Daten ländlich geprägter Stationen.

Zusammenfassung:

Die Januartemperaturen sinken seit gut 30 Jahren. Der CO2-gehalt der Atmosphäre steigt. Somit verhalten sich CO2 und Temperaturen gegensätzlich zueinander. Aus der Statistik könnte man allenfalls schlussfolgern, dass ansteigende CO2-Konzentrationen zu Temperaturabkühlungen führen.

Bei ländlichen Stationen und in Höhenlagen ist die Januarabkühlung laut Trendlinie stärker als in den Städten. Das ist ein Beweis des weiter zunehmenden Wärmeinseleffektes. Man könnte vereinfacht sagen: In den Städten werden die kalten Temperaturen heraus geheizt.

Es wird Zeit, dass endlich wieder Natur- und Umweltschutz in den Mittelpunkt der Politik gestellt wird und nicht das Geschäftsmodell Klimaschutz und das Märchen von der globalen Temperaturerwärmung. Der Januarverlauf seit 1988 braucht keinen Erwärmungsstopp, da er von selbst kälter wird.

Josef Kowatsch, Naturbeobachter und unabhängiger Klimaforscher

Stefan Kämpfe, Diplom- Agrar- Ingenieur, unabhängiger Natur- und Klimaforscher