MIT HAKEN UND ÖSEN – Photovoltaik und Vulkane

Das Jahr 1816 gilt als das »Jahr ohne Sommer«. In vielen Ländern schien über ein Jahr lang kaum die Sonne, heftige Regenfälle verwüsteten das Land; in Europa und in den Vereinigten Staaten fuhren die Bauern Missernten ein, Hungersnöte brachen aus; weniger allerdings in Russland, dessen Zar Getreide in die Schweiz liefern ließ.

Ein Jahr zuvor, im April 1815, brach auf der anderen Seite des Erdballes der Vulkan Tambora aus. Eine gewaltige Explosion schleuderte den oberen Teil des Vulkans in die Luft, verkleinerte den Berg von 4.300 Meter Höhe auf nur noch 2.800 Meter. Er spie ungeheure Mengen an giftigen Gasen und Asche in die Luft. Die Explosion vernahm man noch in 1.500 Kilometer Entfernung. Die Asche breitete sich meterdick über riesige Flächen aus, zerstörte alles Leben. 100.000 Menschen sollen gestorben sein.

In der westlichen Hemisphäre gilt dieser Ausbruch als eine Ursache für die katastrophale Wetterverschlechterung. Wie weit der Ausbruch des Vulkans an der dramatischen Verschlechterung des Wetters beteiligt war, ist noch nicht ganz geklärt. Schließlich gab es schon seit 1812 eine Reihe von kalten und regnerischen Jahren verbunden mit Missernten. Aber keine Frage: Der Vulkanausbruch schleuderte gewaltige Mengen an Asche und Feinstaub in die oberen Luftschichten der Atmosphäre. Der Vulkan liegt dicht am Äquator, ausgestoßene Gase und Ascheteilchen geraten in die globalen Windströmungen und werden rund um den Globus verteilt. Das geschieht bei näher an den Polen gelegenen Vulkanen eher nicht.

Eine solche Naturkatastrophe bekommt ganz neue, bisher ungeahnte Folgen für ein Land, das seine Energie aus sogenannten »Erneuerbaren« bezieht. Was geschieht also, wenn wieder ein Vulkan ausbricht? TE-Leser Wolfgang Kohl fragt, welche Auswirkungen auf die alternative Stromversorgung ein Vulkanausbruch mit global weitflächiger und monate- oder gar jahrelanger stark verminderter Sonnenstrahlung haben kann? Denn in der bisherigen Diskussion über alternative Energien hat er noch nie etwas darüber gelesen, wie derartige Naturkatastrophen in ihren Auswirkungen eingeschätzt werden.

Da lohnt ein Blick schon einmal auf den Normalbetrieb von Photovoltaik-Anlagen. Wer in Städten in Wüstengebieten sein Auto nur zwei oder drei Tage stehen lässt, sieht hinterher nichts mehr durch seine Scheiben und muss durch eine Waschstraße fahren. Es sind permanent ungeheure Mengen an feinem Staub in der Luft, die sich auf alle Flächen absetzen. Fensterreinigern jedenfalls geht die Arbeit nie aus.

Das Gleiche passiert auch mit Photozellen. Auf denen setzt sich eine Schicht Staub ab und vermindert den Lichteinfall. Das kann bis zum völligen Blockieren des Lichteinfalls führen, wenn die komplette Fläche der Solarzellen mit Staub, Schmutz oder gar Schnee bedeckt sind. Bis zu 25 Prozent reduziert sich der Ertrag einer Photovoltaik-Anlage bei nur leichter Verschmutzung.

In staubigen und trockenen Regionen bildet sich innerhalb weniger Tage eine geschlossene Decke an Staub und Schmutz auf den Photozellen und reduziert bis verhindert die Stromerzeugung. In trockenen und staubigen Ländern lassen sich die Auftraggeber meist bestätigen, dass die Photovoltaikanlagen sich selbst reinigen. Hier sind die Oberflächen speziell beschichtet; das soll verhindern, dass sie sich zusetzen. Letztlich aber ist ein kräftiger Wüstenstaub stärker.

In Deutschland sind die meisten Module auf Dachschrägen befestigt. Hier sorgt Regen für eine gewisse Reinigung der Oberflächen. Dennoch sammeln sich gerade über längere trockene Zeiten Staub und Laub auf den Flächen an und vermindern die Leistung. Abrieb von Bremsstäuben, Zement und Kalkstäube sind aggressiv und fressen sich in das Glas. Zusätzlich können Moose und Algen wachsen. Es muss also gereinigt werden, wenn der Ertrag nicht zu stark vermindert werden soll.

Problematischer sind Anlagen, die auf flacheren Dächern von Ställen zum Beispiel montiert wurden. Die Landwirte lockten die großen Flächen, doch die warme Luft, die Tiere abgeben, strömt nach oben und zieht über die Lüftungsöffnungen der Dächer ab. Mit im Gepäck haben sie Staub und Ammoniakverbindungen aus dem Stall. Das legt sich über die Glasflächen und reduziert ebenfalls den Lichteinfall. Solarmodule putzen – es ist immer wieder nett anzuschauen, welche neuen Berufsbilder ein solches Gebilde wie die Energiewende produziert.

Bereits im Normalbetrieb also beeinträchtigen Staub und sonstige Stoffe in der Luft den Betrieb von Photovoltaik-Anlagen. Wir wollen uns besser nicht ausmalen, was geschieht, wenn ein Vulkan ausbricht, die Erde verdunkelt und die vollkommen ()oder überwiegend) auf Photovoltaik und Windenergie verlegte Energieerzeugung empfindlich stört. Klar ist, dass eine solche Naturkatastrophe erhebliche Auswirkungen auf die Energieversorgung eines Industrielandes wie Deutschland hätte. Man kann davon ausgehen, dass die meisten Photovoltaik-Anlagen keinen Strom mehr liefern werden, wenn sich eine Ascheschicht auf die Module legte und zudem von der Sonne weniger Licht durch die Luftschichten käme.

Das ist glücklicherweise nur in Deutschland so. Die Nachbarländer verfügen über konventionelle Kohle- und Kernkraftwerke. Wir können den Strom aus Frankreich und Tschechien bekommen. Später werden wir in Russland und China um Energie bitten und betteln.

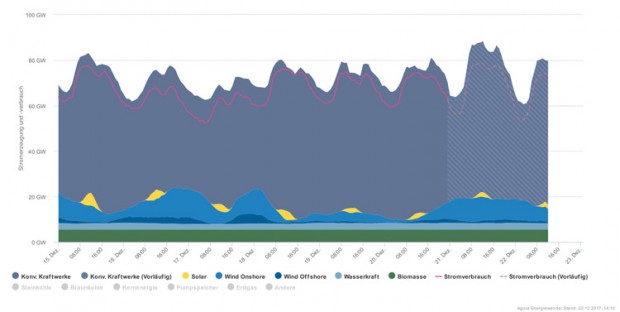

Wie wacklig die sogenannten erneuerbaren Energien sind, erwies sich gerade wieder beim jüngsten Hochwasser. Die ach so natürliche Wasserkraft zeigte, wie weit der Rückschritt ins Mittelalter gediehen ist: Bei den jüngsten heftigen Regenfällen und Schneeschmelzen mit hohem Wasseraufkommen produzierten die Wasserkraftwerke – nein, nicht, wie man angesichts der Wassermassen vermuten könnte, gigantische zusätzliche Mengen an Strom, nein, sie mussten – abgeschaltet werden. Abgeschaltet! Zu viel Wasser!

Denn einmal war die Differenz zwischen Ober- und Unterwasser zu gering, der Druckunterschied vor und nach der Wasserturbine so gering, dass kaum mehr Strom erzeugt werden konnte. Zudem liefen die Wasserkraftwerke Gefahr, dass die mitgeführten Unratmassen die Turbineneinläufe mit ihren Rechenwerken verstopfen. Äste, ganze Baumstämme, tonnenschwer, reißen die Fluten mit, zudem viel Laub – tödlich für jede Turbine. Im Winter droht bei Eis sogar die Zerstörung des Wasserkraftwerkes. Deshalb haben die alten Wassermühlenerbauer früher einen separaten Zulauf zum Mühlrad angelegt, den sie bei Eisgang sperren konnten.

Zu viel Wasser ist also nichts für die Stromerzeugung aus Wasserkraft. Genauso wie zu viel Wind schädlich für die Windräder ist. Bei kräftigem Wind und Sturm knicken sie um wie Streichhölzer. Damit sie nicht in Gefahr geraten, auseinanderzufliegen, müssen sie bei starkem Wind abgeschaltet werden. Die Flügel werden in eine sogenannte Segelstellung gestellt, bieten so dem Wind kaum Widerstand und laufen weniger Gefahr, von Orkanböen zertrümmert zu werden.

»Erneuerbare« Energien also sind sehr anfällig gegenüber Unbilden der Natur. Zu viel Wind, zu viel Wasser oder gar ein Vulkanausbruch mit Ascheregen – kein Strom. Fein, dass die Grünen den großen Fortschritt, eine einigermaßen unabhängige und günstige Energiequelle geschaffen zu haben, jetzt wieder rückgängig machen wollen.

Der Beitrag erschien zuerst bei Tichys Einblick hier