Diesel: Die Lückenmedien im Glashaus (7)

Bild 1. [Aufmacher] Vergangenheit: Primitiver, „schmutziger“ Verbrenner-Dino ohne Platz, Komfort oder Sicherheit (oben), Zukunft: Modernes E-Mobil, das keine Wünsche offen lässt (unten) (Foto: Wikimedia JoachimKohlerBremen)

In den bisherigen Teilen dieses Aufsatzes wurde nachgewiesen, dass die NO2-Belastung der Luft in ganz Deutschland und auch an den sogenannten „Hotspots“ in den Städten auf im Prinzip unbedeutende Werte zurückgegangen ist. Wichtiger Grund hierfür ist die stetige Ablösung älterer durch jüngere Fahrzeuge mit besseren Abgasbehandlungssystemen. Dieser Trend wird sich auch in den nächsten Jahren fortsetzen. Auch wurde aufgedeckt, wie fragwürdig die Messmethoden sind und welche Tricks und Manipulationen zum Einsatz kommen. Im dritten Teil wurden die teils grotesk übertriebenen Behauptungen über die gesundheitlichen Auswirkungen von Stickstoffdioxid sowie die offensichtliche Parteilichkeit sowohl der öffentlich-rechtlichen Medien als auch industriefeindlicher Behörden behandelt. Im vierten Teil wurde festgestellt, dass das Auto auch in der Stadt der Zukunft unverzichtbar bleibt und Elektromobilität zurzeit nicht realisierbar ist. Außerdem wurden Widersprüche in den Aussagen des Umweltbundesamtes beleuchtet und anrüchige Querverbindungen zwischen der Deutschen Umwelthilfe sowie Ministerien und Behörden thematisiert. Im fünften Teil wurde gezeigt, dass an der angeblichen Gesundheitsgefährdung selbst durch geringste NO2-Konzentrationen nichts dran ist und die Horror-Stories über zigtausende Tote durch Dieselabgase nicht wissenschaftlich fundiert sind. Zahlreiche Studien basieren sogar auf gefälschten Zahlenwerten. Im sechsten Teil wurden grobe Mängel bei den Studien der US-Umweltschutzbehörde EPA und der WHO dargelegt, mit denen behauptete Gesundheitsgefahren von Stickoxiden „belegt“ werden sollen. Im jetzigen siebten Teil wird anhand von umfassenden Abgasuntersuchungen in bayrischen Großstädten nachgewiesen, dass selbst an den „Brennpunkten“ des Abgasgeschehens keinerlei Gründe für Fahrverbote für Diesel-PKW vorliegen.

Wie man den Diesel-PKW-Fahrer zum Sündenbock macht

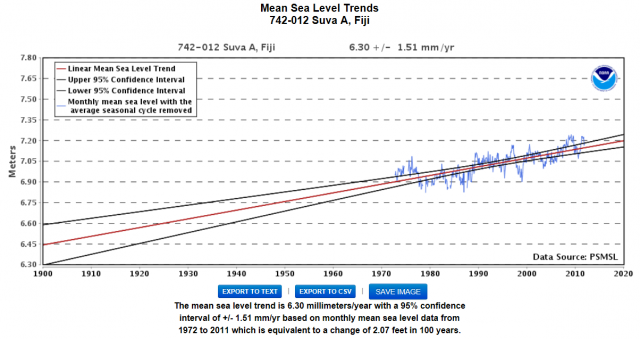

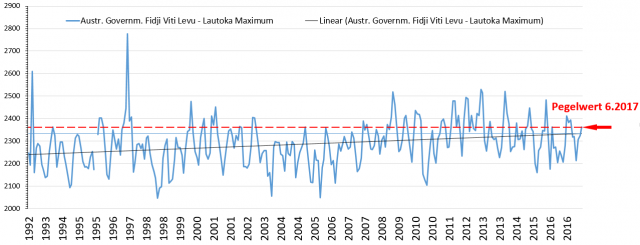

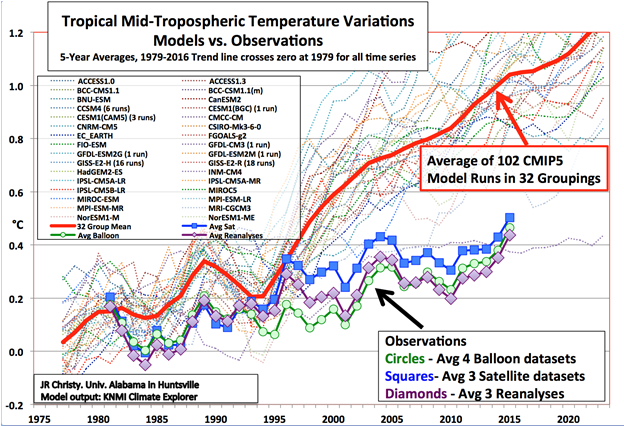

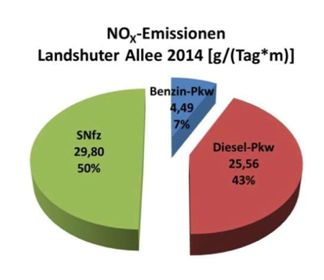

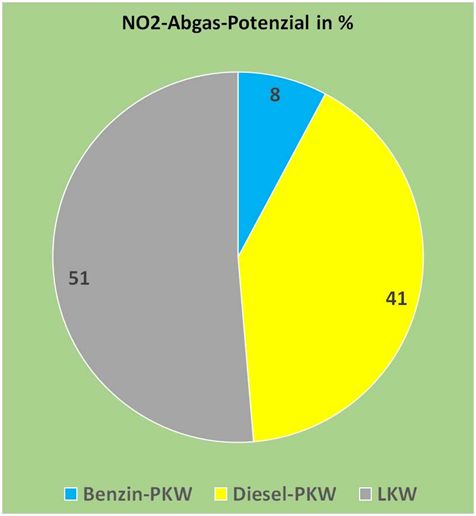

An dieser Stelle kommen nochmals Aspekte zur Sprache, die in früheren Teilen dieses Berichts nur gestreift werden konnten. Zu den perfiden Hinterhältigkeiten der aktuellen, auch und gerade von diversen Behörden geförderten Kampagne gegen die Automobilindustrie gehört der Versuch, dem privaten Fahrer eines Diesel-PKW die Hauptverantwortung für die NO2-Werte in der Luft unserer Städte in die Schuhe zu schieben, um ihm dann mit Verboten auf die Pelle zu rücken. Wie dabei vorgegangen wird, sieht man recht anschaulich bei einer umfassenden Untersuchung des Bayerischen Landesamtes für Umwelt [BLFU]. Dort findet sich zu den Stickoxid-Emissionen von PKW und schweren Nutzfahrzeugen (SNFz) auf Seite 20 die folgende Teilgrafik, Bild 2.

Bild 2. Absolute und prozentuale Werte zu den NO2-Emissionen der verschiedenen Fahrzeugkategorien an der besonders hoch belasteten Messstelle Landshuter Allee in München im Jahr 2014 (Grafik: [BLFU])

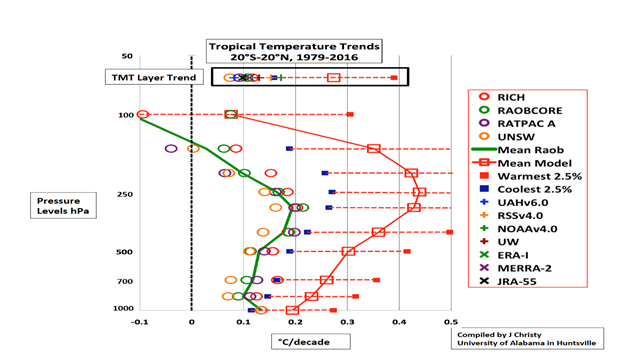

Mit dieser Darstellung scheinen sich die Behauptungen industriefeindlicher Kräfte, dass Diesel-PKW die Hauptsünder bei der Befrachtung der Stadtluft mit dem angeblich schädlichen NO2 sind, zu bestätigen. Allerdings gibt es eine dazugehörende zweite Teilgrafik zu Stickoxidemissionen, die paradoxerweise ganz andere Zahlen enthält, Bild 3.

Bild 3. Absolute und prozentuale Anteile der NOx-Emissionen der verschiedenen Fahrzeugkategorien an der besonders hoch belasteten Messstelle Landshuter Allee in München im Jahr 2014 (Grafik: [BLFU])

Vergleicht man die Absolutwerte von Bild 2 und Bild 3, so fällt auf, dass die SNFz zwar 29,8 g/(Tag*m) an NOx und damit 50 % der Gesamtemissionen an Stickoxiden ausstoßen, ihr Anteil beim NO2 jedoch bei lediglich 2,82 g/(Tag*m) bzw. 23 % liegt. Beim Diesel-PKW liegt der NOx -Anteil dagegen mit 25,56 g/(Tag*m) bei nur 43 %, ihr NO2-Ausstoß erreicht dagegen mit 9 g/(Tag*m) volle 75 %. Grund für diese erheblichen Unterschiede sind die Charakteristiken der jeweiligen Motor- und Abgasnachbehandlungstechnologien. Derartige Diskrepanzen sollten investigative Journalisten eigentlich sofort misstrauisch machen. Sind NO-Emissionen etwa harmlos? Ist der Kfz-Verkehr die einzige Ursache für Stickoxid-Emissionen? Hier erscheint ein Faktencheck dringend geboten.

Tricksereien mit NO, NOx und NO2

Um die hier angewandten Tricks nachvollziehen zu können, müssen wir uns nochmals kurz einige Grundlagen zum Thema Stickoxide vor Augen führen. Dieser Begriff umfasst eine ganze Gruppe von Gasmolekülen, die aus Stickstoff und Sauerstoff in unterschiedlichen Kombinationen bestehen. Für Autoabgase und auch für die Immissionen in Städten sind jedoch nur zwei Moleküle von Bedeutung, und zwar das Stickstoffmonoxid NO und das Stickstoffdioxid NO2. Zusätzlich wird auch noch häufig der Begriff NOx verwendet. Er bezeichnet die Summe aus NO und NO2. Somit kann man aus den Zahlen in den Bildern 2 und 3 die Emissionen der drei Fahrzeugkategorien wie folgt errechnen, Tabelle 1.

| Fahrzeug kategorie | NO- Ausstoß g/(Tag*m) |

%-Anteil | NO2– Ausstoß g/(Tag*m) |

%-Anteil | NOx– Ausstoß g/(Tag*m) |

%-Anteil |

| Benzin-PKW | 4,24 | 9 | 0,25 | 2 | 4,49 | 7 |

| Diesel-PKW | 16,56 | 35 | 9 | 75 | 25,56 | 43 |

| SNFz | 26,98 | 56 | 2,82 | 23 | 29,80 | 50 |

| Gesamt | 47,78 | 12,07 | 59,85 |

Tabelle 1. Mengen und prozentuale Anteile der Stickoxidemissionen der verschiedenen Fahrzeugkategorien (Daten: [BLFU])

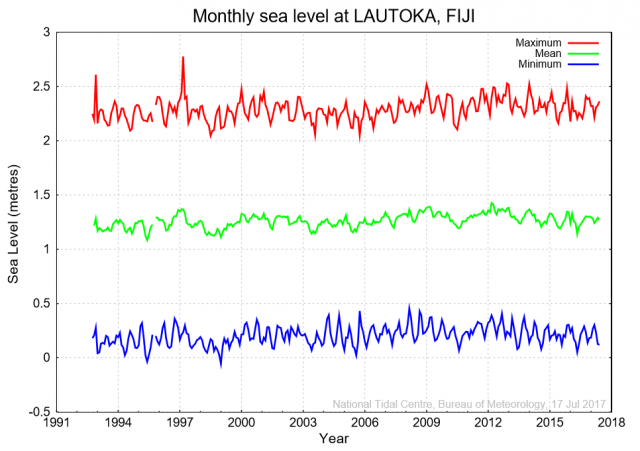

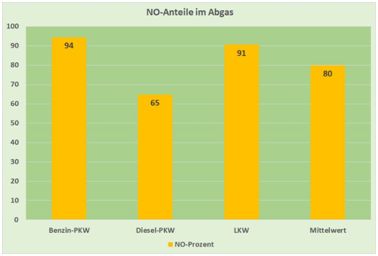

Eine grafische Darstellung der massiv höheren Anteile von NO in den Abgasen von Benzin-PKW und SNFz im Vergleich zum Diesel PKW zeigt Bild 4.

Bild 4. Sowohl beim Benzin-PKW als auch bei SNFz sind die NO-Anteile im Abgas auffallend höher als beim Diesel-PKW (Daten: [BLFU])

Das äußerst schlechte Abschneiden des Diesel-PKW bei den NO2-Emissionswerten (siehe Bild 2) hängt nicht etwa damit zusammen, dass dieser besonders große Mengen an Stickoxiden erzeugt, sondern damit, dass sich hier das Verhältnis von NO2 zu NO besonders ungünstig auswirkt, wenn man zur Beurteilung lediglich den NO2-Ausstoß heranzieht. Letzteres ist in der Diesel-Debatte zur Regel geworden und wird weidlich zur Panikmache ausgenutzt, weil sich die deutschen Immissionsschutzvorschriften ebenso wie die Horrormeldungen zahlreicher epidemiologischer Veröffentlichungen zum Thema Stickoxide nahezu ausschließlich auf das NO2 beziehen. Das als weniger schädlich eingestufte NO wird dagegen weitgehend ausgeklammert. Dies gilt auch für die 39. Verordnung zur Durchführung des Bundes-Immissionsschutzgesetzes [BIMS], wo NO im Zusammenhang mit dem Schutz der menschlichen Gesundheit nicht einmal erwähnt wird. Lediglich im Zusammenhang mit dem Schutz der Vegetation wird ein Grenzwert für NOx – also für den Gesamtgehalt an NO und NO2 – definiert. Nach dem NO – das ebenfalls ein Reizgas ist, für das gesetzliche Obergrenzen gelten – fragt dagegen kein Mensch und vor allem kein Gericht. Dank dieses „Scheuklappeneffekts“ sind sowohl Benzin-PKW als auch SNFz wegen des besonders geringen Anteils an NO2 in ihren Abgasen bei allen Diskussionen fein raus, während der Diesel-PKW als Sündenbock herhalten muss. Diejenigen, die dem deutschen Bürger das private Autofahren vermiesen und im nächsten Schritt dann ganz verbieten wollen, haben natürlich ein Interesse daran, diese Einseitigkeit nach Kräften auch weiterhin aufrechtzuerhalten, damit technische Laien – zu denen auch Richter zählen – möglichst nicht merken, wie sie hinter die Fichte geführt werden.

Emissionen und Immissionen

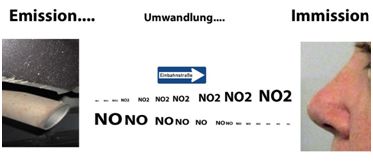

Dieser Betrug am Volk ist erschreckend einfach durchzuführen: Man hält dem Bürger den NO2-Grenzwert aus dem Bundesimmissionsschutzgesetz vor die Nase wie der Torero dem Stier das rote Tuch. Und dann argumentiert man mit der Zusammensetzung der Emissionen. Wer weiß denn schon, dass NO sich auf dem Weg vom Auspuff bis zur Lunge aufgrund von chemischen Gesetzmäßigkeiten in NO2 umwandelt?

Der Trick besteht also darin, den NO-Anteil in den Abgasen von Benzin-PKW sowie SNFz nicht zu erwähnen bzw. davon abzulenken, was hinter dem Auspuff damit geschieht. Man muss nur darauf achten, dass niemand auf die Idee kommt, nach dem Unterschied zwischen Emissionen und Immissionen überhaupt zu fragen. Dabei ist der Unterschied eigentlich leicht zu verstehen. Emissionen sind das, was man direkt am Auspuff eines Fahrzeugs messen kann. Immissionen sind dagegen das, was davon tatsächlich an der Nase der Bürger ankommt. Der Unterschied ist deshalb bedeutsam, weil sich dazwischen ein erheblicher Teil des NO in NO2 umwandelt. Dies liegt an der Temperatur: Je weiter sich die am Auspuffendrohr noch sehr heißen Abgase abkühlen, desto mehr des darin enthaltenen NO wandelt sich unter Aufnahme eines Sauerstoffatoms in NO2 um. An der freien Atmosphäre läuft diese Umwandlung bei Temperaturen unterhalb von 25 °C fast vollständig ab [MARX], Bild 5.

Bild 5. Naturgesetze sorgen dafür, dass der größte Teil der aus dem Auspuff entweichenden NO-Emissionen bis zum Ort und Zeitpunkt der Immissionsbestimmung zu NO2 umgewandelt ist

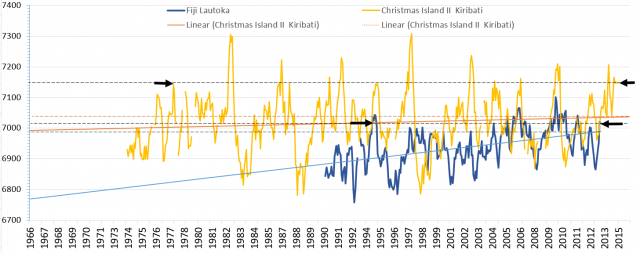

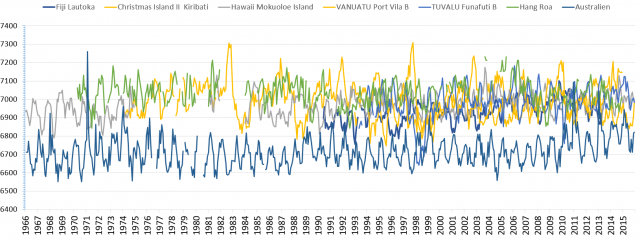

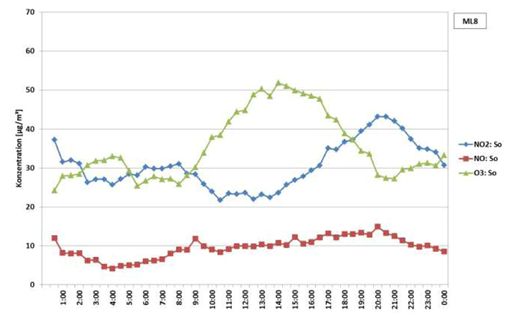

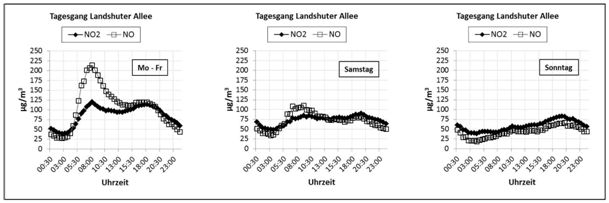

Die Umwandlung beginnt sofort und läuft innerhalb von einigen Stunden ab. Dies kann man auch anhand entsprechender Messwerte leicht nachweisen. Den Angaben in Bild 4 kann man entnehmen, dass das Verhältnis von NO und NO2 bei den Verkehrsemissionen im Mittel bei 4:1 liegt. Würde es nicht zu dieser Umwandlung kommen, so müsste entsprechend Bild 4 das Verhältnis zwischen NO und NO2 bei Immissionsmessungen auch bei rund 4:1 liegen. Misst man jedoch z.B. am frühen Sonntagmorgen in etwas ruhigeren Straßen, d. h. zu einem Zeitpunkt, wo die Umwandlung (auch wegen des Sonntagsfahrverbots für LKW) Zeit hatte, recht weitgehend abzulaufen, so stellt man fest, dass das Verhältnis stattdessen zwischen 1:3 und 1:5 liegt, Bild 6.

Bild 6. In den ruhigeren Stunden am frühen Sonntagmorgen geht das Verhältnis von NO zu NO2 von ursprünglich 4:1 am Auspuff auf Werte zwischen 1:3 und 1:5 zurück (Grafik: [BLFU])

Das Bild 6 veranschaulicht sehr eindrücklich den in Bild 5 dargestellten Zusammenhang. Die Messungen erfolgten in der Münchner Schlörstraße, einer etwas ruhigeren Seitenstraße der berüchtigten Landshuter Allee. Gegen etwa 4 Uhr am Sonntagmorgen, wenn kaum noch Neuemissionen durch Fahrzeuge hinzukommen, sinkt das Verhältnis zwischen NO und NO2 auf bis zu 1:5 ab. Man kann daraus folgern, dass zu diesem Zeitpunkt bereits etwa 80-90 % des ursprünglich vorhandenen NO zu NO2 umgewandelt wurden. Dass das Niveau des NO2 dennoch ebenfalls weiter absinkt, liegt daran, dass die Verdünnung dieser Gase ständig weitergeht. Sie verbreiten sich über ein immer weiteres Gebiet, wodurch die Konzentration abnimmt. Zudem werden beide Gase ständig an Oberflächen absorbiert sowie durch Regen aus der Atmosphäre ausgewaschen.

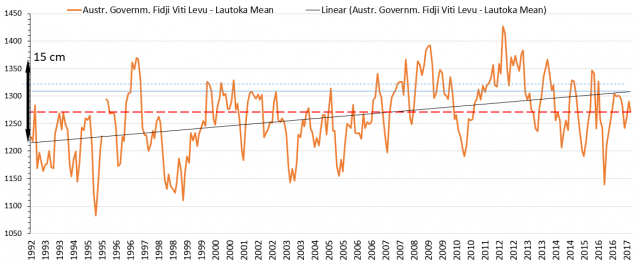

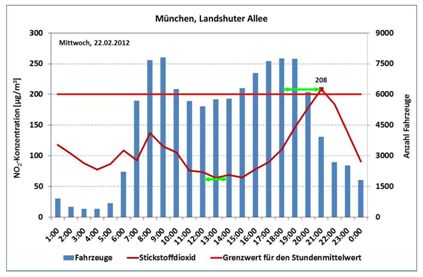

Eine Vorstellung davon, wie schnell die Umwandlung von NO in NO2 anläuft, bekommt man zudem, wenn man sich den Zeitversatz zwischen Maxima des Verkehrsaufkommens sowie den Scheitelpunkten der an gleicher Stelle gemessenen NO2-Konzentrationen ansieht, Bild 7.

Bild 7. Gegenüberstellung von Fahrzeugaufkommen und NO2-Messwertverlauf (Grafik: [BLFU])

In Bild 7 ist zu erkennen, dass die NO2-Maxima bzw. Minima gegenüber dem Verkehrsgeschehen mittags und abends einen Zeitversatz von 2-3 Stunden haben. Die naheliegende Erklärung hierfür dürfte sein, dass dies durch den Zeitaufwand für die Umwandlung des ursprünglich in wesentlich größeren Mengen erzeugten NO in NO2 bedingt ist. Der fehlende Versatz am Morgen könnte auf Messprobleme zurückzuführen sein.

Am Rande sei angemerkt, dass es zu dieser Umwandlung recht unterschiedliche mathematische Ansätze gibt, die z.T. auf Weiterentwicklungen basieren. Auch gibt es noch weitere Reaktionen als die direkte Umwandlung von NO in NO2 gibt. In manchen Publikationen wird den diversen möglichen Reaktionen zwischen Stickoxiden und Ozon viel Aufmerksamkeit gewidmet. Die Hypothese, dass diese Reaktionen, die auch noch die Anwesenheit bestimmter Stäube und Kohlenwasserstoffe sowie UV-Licht erfordern, in der chaotischen Realität der städtischen Atmosphäre tatsächlich in der Weise und in dem Umfang ablaufen, wie es seitens mancher ideologielastiger Quellen wie Wikipedia behauptet wird, wird von Fachleuten der Ozonchemie nicht so ohne weiteres mitgetragen. So findet sich dazu in einer entsprechenden Veröffentlichung des Arbeitskreises Ozon die Aussage: „Ozon…verwandelt sich unter bisher noch nicht genau definierten Reaktionen mit Stickoxiden zu Sauerstoff zurück [OZON].

Generell ist festzuhalten, dass die mathematische Modellierung all dieser möglichen Umwandlungsreaktionen, egal ob direkt oder unter Einbeziehung von Ozon, bei näherer Betrachtung eher empirisch als exakt physikalisch-chemisch begründet zu sein scheint. Da diese unterschiedlichen Modelle bei Simulationen zur Luftbelastung zum Einsatz kommen, die Belastbarkeit der entsprechenden Ergebnisse nicht allzu hoch.

Abgase: Entscheidend ist das reale NO2-Potenzial

Die hier gezeigten Zusammenhänge zeigen, dass die plumpen Unterstellungen, dem Diesel-PKW seien aufgrund seiner höheren NO2-Emissionsanteile 75 % des NO2-Anteils an der Luftbefrachtung in den Städten anzulasten, schlicht falsch sind. Zwangsmaßnahmen zur Luftreinhaltung wie die geplanten Fahrverbote haben ernste und weitreichende Konsequenzen. Man sollte vorher sicherstellen, dass man die Hauptquellen unerwünschter Immissionen zweifelsfrei identifizieren konnte. Sonst hat man keine Rechtfertigung derart schwerwiegende Eingriffe. Ideologisch statt sachlich begründete Argumente sind nicht nur unangebracht, sondern ein recht zweischneidiges Schwert, wenn sich der Bürger hinterher als der Betrogene sieht. Deshalb ist jedem Verantwortlichen anzuraten, sich mit dem Einfluss von NO-Emissionen auf die Luftbefrachtung mit NO2 genauer zu beschäftigen, siehe auch Bild 8.

Bild 8. Mittlere Tagesgänge von NO und NO2 am Münchner Brennpunkt Landshuter Allee an Wochentagen sowie an Samstagen und Sonntagen (Grafik: [BLFU])

Der Unterschied zwischen den Teilbildern zeigt, dass an Werktagen der zeitlich sehr eng gestaffelte Start des Gewerbeverkehrs zwischen 6.00 und 8.00 zu einem drastischen Hochschnellen des NO-Anteils von um die 25 µg/m3 auf bis zu etwa 210 µg/m3 führt. Diese Fahrzeuge dürften zu vermutlich über 95 % Dieselmotoren mit hohem NO-Anteil im Abgas haben. Nach 8.00 Uhr haben offensichtlich die Handwerker ihre Baustellen und die Spediteure entweder die Stadt verlassen oder ihre ersten Lade- bzw. Abladestationen erreicht, so dass der Anstieg mit einem abrupten Knick in einen Abfall übergeht. Die Umwandlung zu NO2 erfolgt anschließend über mehrere Stunden und hält dementsprechend den NO2-Gehalt hoch. Ab etwa 17.00 kommt der gewerbliche Verkehr zum Erliegen, und dementsprechend sinkt der NO-Anteil etwa 2-3 Stunden später unter den NO2 ab. Am Sonntag hingegen, wenn der gewerbliche Diesel-Verkehr weitgehend entfällt und dementsprechend weit weniger NO emittiert wird, verbleibt dessen Gehalt ganztägig unterhalb desjenigen des NO2.

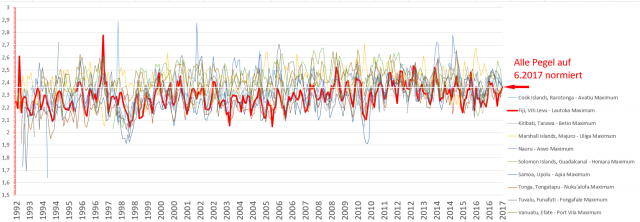

Die Bilder 6 bis 8 belegen anschaulich, warum es unzulässig ist, sich bei der Beurteilung von Immissionsursachen auf die Zusammensetzung von Emissionen zu stützen. Statt das NO weitgehend zu ignorieren, muss vielmehr sein NO2-Potenzial aufgrund der eintretenden Umwandlung ins Kalkül gezogen werden. Es erscheint realistisch, hier von einer effektiven Umwandlungsquote von 90 % auszugehen. Aus ursprünglich 100 Teilen NO werden demnach 10 Teile NO und 90 Teile NO2. Zusätzlich ist noch zu beachten, dass sich bei dieser Umwandlung das Molekülgewicht durch die Aufnahme eines zusätzlichen Sauerstoffatoms um 53 % erhöht. Das Ergebnis einer entsprechenden Neuberechnung der Werte aus Tabelle 1 zur Bestimmung des tatsächlichen NO2-Potenzials zeigt Bild 9.

Bild 9. Das tatsächliche NO2-Immissionspotenzial des Abgases der verschiedenen Fahrzeugkategorien unter Berücksichtigung der Umwandlung von NO in NO2, berechnet auf Basis der Daten der Bilder 2 und 3

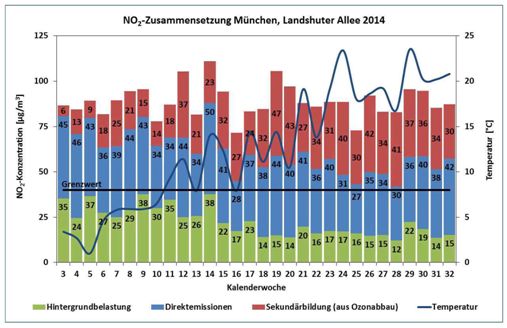

Die Neuberechnung zeigt, dass es nicht die Diesel-PKW, sondern die Nutzfahrzeuge sind, welche den größten Beitrag zur NO2-Immissionsfracht aus den Abgasemissionen des städtischen Verkehrs liefern. Doch auch mit dieser Korrektur ist der tatsächliche Beitrag der diversen Verkehrsteilnehmer noch nicht vollständig erfasst, denn zusätzlich ist auch noch der Beitrag des städtischen Hintergrunds einzubeziehen, der sich aus Quellen wie Heizungen, Kaminen und Industrie etc. speist. Angaben zu diesem Hintergrund liefert Bild 10.

Bild 10. Wochenmittel der NO2-Immissionsfracht an der Landshuter Allee im ersten Halbjahr 2014 mit zusätzlicher Angabe der Temperatur (Grafik: [BLFU])

Zu den Angaben in Bild 10 ist anzumerken, dass für die Betrachtung wegen Zweifeln an der „Ozonhypothese“ der Verfasser der BLFU-Studie lediglich die tatsächlich gemessene Gesamtmenge sowie der Wert für den städtischen Hintergrund zur Auswertung herangezogen wurden. Um die Veränderungen des Hintergrunds zwischen Heizperiode und Sommer zu berücksichtigen, wurden die ersten 26 Werte genommen, da auf diese Weise je zwei Wochen des kältesten und des wärmsten Jahresmonats einbezogen wurden. Als Durchschnittswert für den städtischen Hintergrund ergab sich damit ein Wert von 23 µg/m3. Angesichts des gesetzlichen Grenzwerts von lediglich 40 µg/m3 lässt dies einer heutigen Stadt viel zuwenig Spielraum. In der Heizperiode lag der Hintergrundwert während fünf Wochen sogar zwischen 35 und 38 µg/m3. Im Prinzip bliebe der Stadt München angesichts der von den Quälgeistern der Deutschen Umwelthilfe (DUH) geforderten strengen Auslegung des Grenzwerts keine andere Wahl, als ihren Bürgern über Wochen entweder das Heizen oder das Autofahren zu verbieten: Beides zusammen ist unter den geforderten Voraussetzungen nicht möglich.

Unbegreifliche Versäumnisse der Politik

Bei nüchterner Betrachtung fällt es schwer zu begreifen, wieso ein Rechtsstaat mit über 80 Millionen Einwohnern sich durch eigene Dummheit in eine Lage gebracht hat, die es einem winzigen Verein gestattet, seine Großstädte im Interesse ausländischer Industriekonzerne – die DUH wird massiv u.a. von Toyota unterstützt – derart in die Enge zu treiben. Die Politiker, die einen von US-Interessen diktierten Grenzwert von nur 40 µg/m3 akzeptierten, haben Deutschland massivst geschadet. Die Situation ist unerträglich und darf so nicht weitergehen. Es ist kaum vorstellbar, dass die DUH-Leute keinen Dreck am Stecken haben. Hier sollte man die Gesetze, welche gegen die Bildung krimineller Vereinigungen erlassen wurden, mit voller Konsequenz zur Anwendung bringen, einschließlich der heutzutage möglichen und in anderen Fällen ja extensiv eingesetzten Mittel zur Überwachung. Aber wenn natürlich ein ehemaliger DUH-Verbandschef aktuell als hochgeehrter Staatssekretär in Amt und Würden ist…

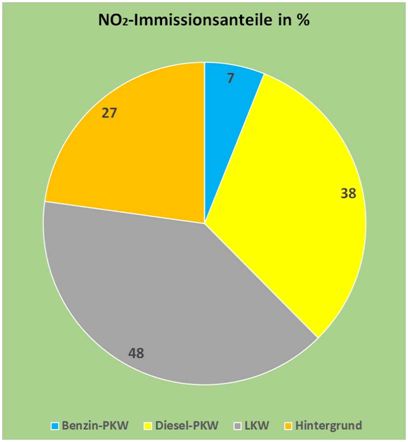

Doch zurück zur Analyse der Beiträge der verschiedenen Verkehrsteilnehmer zu den NO2-Immissionen. Berücksichtigt man bei der Betrachtung des NO2-Potenzials die 23 µg/m3 des städtischen Hintergrunds, so erhält man mit den bisher errechneten Daten aus den Bildern 2 und 3 den tatsächlichen Beitrag der einzelnen Fahrzeugkategorien zum Immissionsgeschehen, Bild 11.

Bild 11. Prozentuale Anteile der verschiedenen Emissionsquellen an den NO2-Immissionswerten der Landshuter Allee in München im Jahr 2014, berechnet auf Basis der Daten der Bilder 2, 3 und 10

Bezieht man zusätzlich zur Berücksichtigung von NO-Emissionen auch noch den städtischen Hintergrundwert in die Analyse der Beiträge zum Immissionsgeschehen an der Landshuter Allee in München ein, so liegt der Beitrag der Diesel-PKW nur noch bei 38 %. Der Unterschied zu den „amtlichen“ Zahlenangaben von Bild 2 ist frappierend. Aussagen wie die der Präsidentin des Deutschen Städtetags, der CDU-Politikerin Eva Lohse, vor laufender Kamera (Bild 12) sollten unterbleiben. Die Städte sägen damit selbst am Ast der Gewerbeeinnahmen, von denen sie leben.

Unsicherheiten

Bei der Beurteilung der hier ermittelten Ergebnisse ist zu beachten, dass es hierbei etliche Unsicherheitsfaktoren gibt. Während die mithilfe der verschiedenen Messsysteme erfassten Immissionswerte als gesichert angesehen werden können, gibt es bei den Angaben zu den Emissionen sowie zum städtischen Hintergrund erhebliche und schwer zu quantifizierende Fehlerquellen. Dies betrifft zunächst die Verkehrsdaten, die als Rohdaten für eine Simulation der Emissionen gedient haben. Die vorgenommene Einteilung nur in die Kategorien PKW und SNFz ist viel zu grob. Durch diese Rasterfestlegung werden die zahlreichen kleineren Transport- und Lieferfahrzeuge sowie Kleinbusse aus den Bereichen Dienstleistungen, Handel, Handwerk und Logistik zu einem erheblichen Teil der Kategorie Diesel-PKW zugeordnet. Dabei sind gerade solche Fahrzeuge wegen ihrer langen Abschreibungszeiträume meist mit älteren und damit weniger effizienten Abgasbehandlungssystemen ausgestattet als private Diesel-PKW. Zudem haben sie höhere Verkehrsanteile.

Weitere Unsicherheiten ergeben sich zwangsläufig aus der Simulationssoftware bzw. den hierfür verwendeten Parametern. So erhebt sich die Frage, ob und falls ja mit welchen Parametern die Umwandlung von NO zu NO2 im Modell berücksichtigt wurde. Prinzipiell sind solche Simulationen zwar nützlich, sie können jedoch auch sehr in die Irre führen. Ein blindes Vertrauen auf Zahlen, weil sie ein Computer errechnet hat, ist heutzutage leider allzu weit verbreitet. Es ist bezeichnend, dass in der Untersuchung des Bayerisches Landesamt für Umwelt keine Angaben zu einer eventuell durchgeführten Kalibrierung aufgeführt sind.

Weiterer Schwachpunkt ist das völlige Fehlen von Angaben zur Herkunft der Hauptbestandteile des städtischen Hintergrunds. Dessen Jahresgang lässt erkennen, dass er zu einem erheblichen Anteil durch den Betrieb von Heizungen verursacht ist. Die schlechte Korrelation mit dem Verlauf der Temperaturkurve in Bild 10 spricht jedoch dafür, dass es hier erhebliche Störgrößen gibt.

Verantwortungslosigkeit der Medien

Den Medienvertretern und Politikern, die uns durch jahrelange Kampagnen gegen das Automobil zu dem aktuellen „Dieselskandal“ verholfen haben, muss man den Vorwurf machen, den Unsinn von „Diesel tötet“ als Dauerschleife in endlosen Variationen wiederholt zu haben. Ohne diese jahrelange Dauerberieselung über angebliche Todesopfer durch Abgase wäre es vermutlich nicht zu dem unsinnig niedrigen, rein ideologisch begründeten Grenzwert von 40 µg/m3 gekommen, den sich die deutsche Politik ohne nennenswerte Gegenwehr durch die EU aufoktroyieren ließ. Dieser ist die Ursache des derzeitigen Wahnsinns. Hier haben die Vertreter der Medien ihrer journalistischen Sorgfaltspflicht gröblich zuwidergehandelt. Man darf als Journalist ruhig etwas nicht wissen: Es gibt aber keine Ausrede dafür, sie sich nicht alle Seiten einer Angelegenheit anzusehen bzw. anzuhören. Es gibt in Deutschland genug Fachleute, die Auskunft darüber geben können, was im Bereich von Kfz-Abgasen realistisch ist und was nicht. Entsprechende Namen sind unter anderem im Bericht des Bundestagsausschusses zur Dieselaffäre zu finden [BUTA]. Journalisten, die ständig nur Meldungen aus dem alarmistischen Lager veröffentlichen und die Positionen der anderen Seite konsequent nicht zur Sprache bringen, machen sich im Endeffekt mitschuldig am Niedergang der Automobilbranche und der Enteignung von Millionen Bürgern.

Fakten und „Faktenfinder“

Die bisherige Analyse der von den „Faktenfindern“ von NDR und Tagesschau präsentierten Aussagen lässt erkennen, dass man sich dort alles andere als kritisch-investigativ mit dem Thema NO2-Immissionen der Stadtluft beschäftigt hat. Stattdessen übernimmt man einfach die Positionen von Hendricks und dem UBA, als seien deren Ansichten der Weisheit letzter Schluss. Eine eigenständige kritische Wertung von Daten und Hintergründen ist nicht einmal in Ansätzen erkennbar. Dies bestätigt die bereits bisher gemachte Erfahrung, dass die Mehrzahl der Medien – allen voran die Fernsehanstalten ARD, ZDF und ihre Landesdependancen – beim sogenannten „Diesel-Skandal“ einseitig, parteiisch und irreführend berichtet. Statt um Ausgewogenheit und Sorgfalt bemüht man sich offenkundig eher darum, das Thema so darzustellen, wie bestimmte Bundesbehörden sowie die etablierten Parteien es gerne haben möchten. Abweichende Meinungen von Fachleuten, Medien, Journalisten oder Bloggern werden als unglaubwürdig hingestellt. So leistet man dem ideologischen Ziel der Deindustrialisierung Deutschlands durch „Dekarbonisierung der Volkswirtschaft“ Vorschub. Der Diesel ist dabei nur das erste Opfer. Die Vernichtung der deutschen Automobilindustrie wird anschließend auch beim Benziner weitergehen, und zwar alternativlos. Die sich jetzt abzeichnende „Jamaika“-Koalition ist dafür ein sehr schlechtes Omen.

Fred F. Mueller

Demnächst folgt Teil 8

Quellen

[BIMS] Neununddreißigste Verordnung zur Durchführung des Bundes-Immissionsschutzgesetzes Verordnung über Luftqualitätsstandards und Emissionshöchstmengen (39. BImSchV) vom 02.08.2010

[BLFU] Bayerisches Landesamt für Umwelt: Untersuchung der räumlichen Verteilung der NOX-Belastung im Umfeld von vorhandenen, hochbelasteten Luftmessstationen. Abschlussbericht. September 2015.

[BUTA] Drucksache 18/12900 – 492 – Deutscher Bundestag – 18. Wahlperiode

[FAKT] http://faktenfinder.tagesschau.de/inland/stickstoffdioxid-111.html

[MARX] https://www.eike-klima-energie.eu/2017/10/02/ueber-stickoxide-und-den-dieselmotor/

[OZON] http://www.ak-ozon.de/ozon.htm

[ZDF] ZDF Heute – Sendung vom 2.9.2017, Sendeminuten 03:55 bis 04:11