1. Die Bauernregeln und die „Milde Oktober- kalte Winterregel“

Der sehr milde Oktober 2017 ruft die Regel „Ist Oktober mild und fein (trocken- sonnig), wird ein harter Winter sein“ auf den Plan. Korrekter formuliert, lautet die Regel folgendermaßen: „Ist der Oktober in Deutschland wesentlich (mehr als 1,5 Kelvin) zu warm und gleichzeitig merklich zu trocken, beides bezogen auf den Langjährigen Mittelwert, so wird der Folgewinter mit etwa 80%iger Wahrscheinlichkeit zu kalt ausfallen.“ Und 2017 scheidet diese Regel sowieso aus, weil der milde Oktober insgesamt deutlich zu niederschlagsreich ausfiel. Die Oktoberkombination „deutlich zu mild (mind. 1 K) und mehr oder weniger deutlich zu nass“ findet sich beim DWD- Mittel seit 1881 nur sechsmal (1923, 1942, 1966, 1989, 2013 und 2014). Von den Folgewintern war nur der von 1923/24 merklich zu kalt, alle übrigen um >1 bis teils um 3 K deutlich zu mild. Bei dieser geringen Zahl der Vergleichsfälle ist aber Vorsicht geboten.

„Wenn im Herbst viel Spinnen kriechen, sie einen harten Winter riechen.“ Im Spätsommer/Herbst 2017 gab es ungewöhnlich viele Spinnen; doch lässt sich daraus nicht auf die Winterstrenge schließen. Aber auf etwas Anderes- soll es nach den rot- grünen Mainstream- Medien nicht immer weniger Insekten in Deutschland geben? (die angeblichen Schuldigen: Eine „böse“ intensive Landwirtschaft und der Klimawandel). Doch alle Spinnenarten ernähren sich räuberisch von Insekten- es muss also sehr viele Insekten gegeben haben! „Ist Martini (10./11.11.) trüb und feucht, wird gewiss der Winter leicht.“ Um den 10.11.2017 herrschte trübes, feuchtes, normal temperiertes Wetter. Wegen der Kalenderreform von 1583 (10 Tage Verschiebung aller Lostage) ist auch die Witterung um den 20.11. beachtenswert. „Elisabeth (19.11., diesmal normal temperiert, windig und wechselhaft) sagt an, was der Winter für ein Mann“. „Wie’s Wetter an Kathrein (25.11., diesmal fast temperaturnormal und verregnet), so wird es auch im Januar sein.“ Solche Regeln treffen keinesfalls immer zu. Insgesamt deutet die Mehrzahl der Bauernregeln auf einen sehr milden bis höchstens normalen Winter hin.

2. La Nina- was bedeutet das?

Momentan herrschen im tropischen Südost- Pazifik einschließlich der Südamerikanischen Küste deutlich zu niedrige Meeresoberflächentemperaturen- ein klassischer „La Nina“. Dieser soll sich im Winter fortsetzen. Direkte Auswirkungen auf die Winterwitterung in Deutschland lassen sich daraus aber kaum ableiten; La- Nina- Winter können hierzulande mild (2013/14, 2007/08,1999/2000,1998/99, 1988/89,1974/75) oder zu kalt (1995/96,1984/85,1962/63) ausfallen. „La Nina“ hat aber eine andere Auswirkung- auf die globalen Durchschnittstemperaturen. Der seit etwa 20 Jahren zu beobachtende Hiatus der „globalen Erwärmung“ dürfte sich dadurch manifestieren.

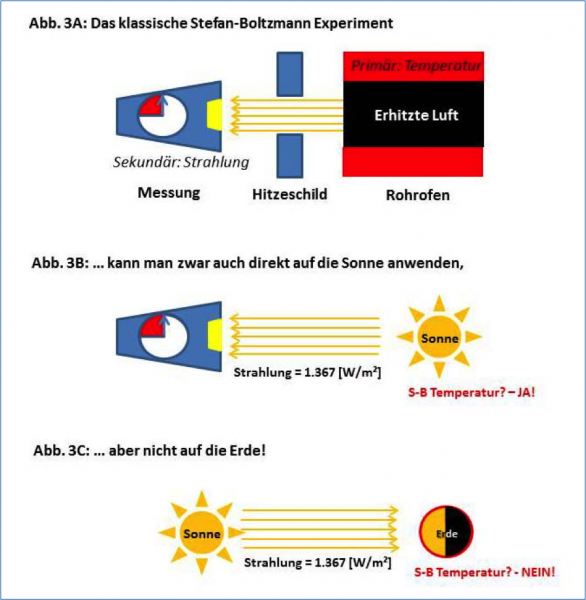

3. Nachlassende Sonnenaktivität- Menetekel der Abkühlung

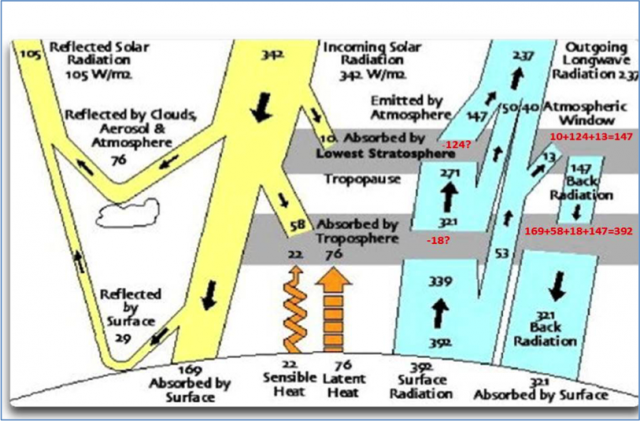

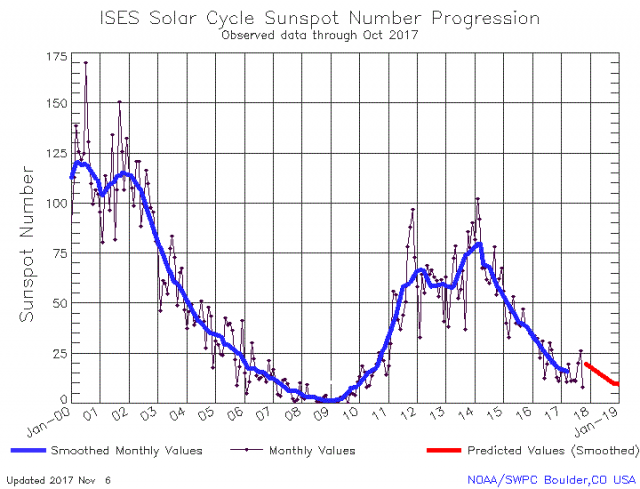

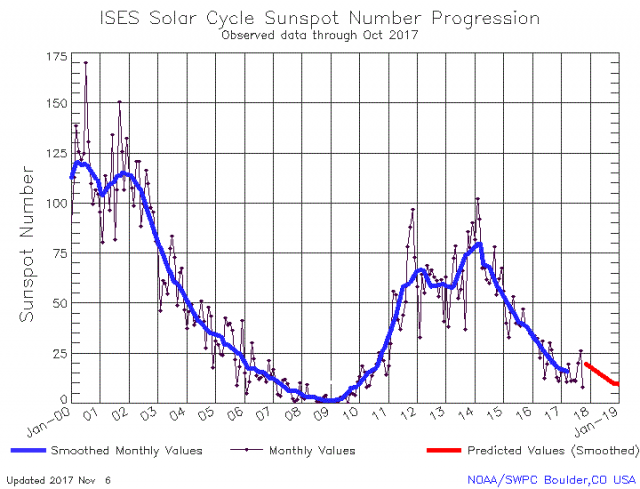

Direkte Sonnen- und Infrarotstrahlung schwanken nur wenig, umso mehr aber das solare Magnetfeld, die Teilchenstrahlung („Solarwind“, verantwortlich u.a. für Polarlichter), die Radiostrahlung und die von der oberen Erdatmosphäre weitgehend absorbierte kurzwellige Strahlung (Röntgen, kurzwelliges UV). Sie beeinflussen Wetter und Klima wesentlich; allerdings besteht noch Forschungsbedarf. Die Sonnenfleckenanzahl bildet die Sonnenaktivität grob ab; je mehr Sonnenflecken, desto höher die Sonnenaktivität. Die Sonnenaktivität wirkt auf verschiedenen Zeitskalen; hierzu wird intensiv geforscht. Im Jahr 2017 nahm die Fleckenzahl tendenziell weiter ab; oftmals war die Sonne schon fleckenlos, was Kältewellen in den kommenden Monaten begünstigen könnte.

Dem noch intensiven 23. folgte der schwache 24. SCHWABE-Zyklus. Dieser ist mit maximal nur gut 100 Flecken einer der schwächsten Sonnenfleckenzyklen seit 200 Jahren:

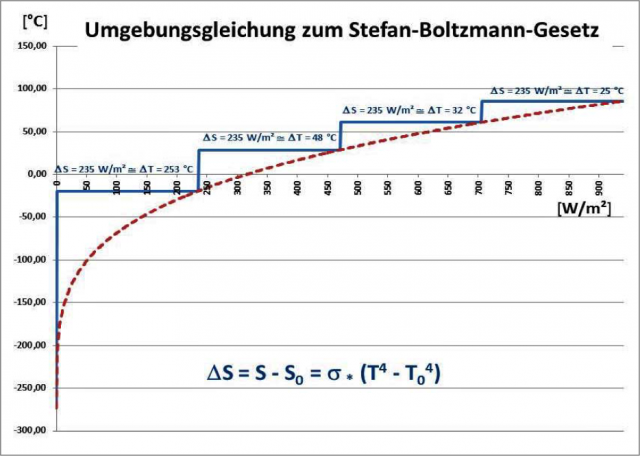

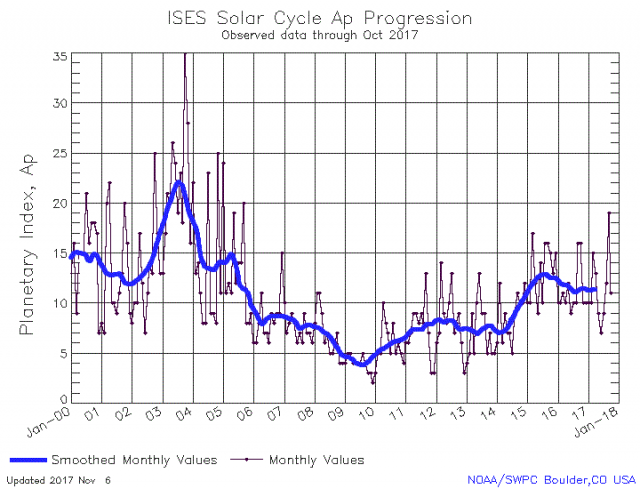

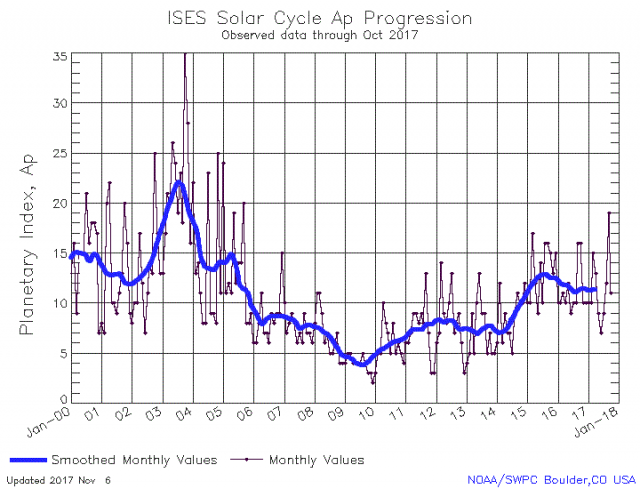

Nach dem absoluten Zyklus-Maximum (Februar 2014) sank die Fleckenzahl. Der Winter 2017/18 ist der vierte nach dem Maximum des SCHWABE-Zyklus. Die 23 Vergleichswinter seit 1760/61 trafen mit -0,2°C genau das langjährige Wintermittel dieses 257ig- jährigen Zeitraumes, wobei aber auffällt, dass die letzten sechs, beginnend mit 1950/51, allesamt zu mild waren. Sehr kalte Winter treten ohnehin bevorzugt zum Minimum des Schwabe-Zyklus oder 1 bis 2 Jahre nach diesem auf; letztmalig 2009/10, davor 1995/96 und 1996/97 sowie 1986/87. Hier zeigt sich schon eine gewisse Verzögerung, mit der die Wintertemperaturen der solaren Aktivität folgen. Eine bessere Aussagefähigkeit hat der solare Ap- Index, welcher die magnetische Wirkung der solaren Teilchenstrahlung beschreibt. Er hatte sein Minimum zwischen 2008 und 2010, was die damaligen Kälte- Winter mit erklären könnte. Gegenwärtig ist aber der Ap- Index, im Gegensatz zur Anzahl der Sonnenflecken, noch mäßig hoch, was für einen eher normalen Winter spricht:

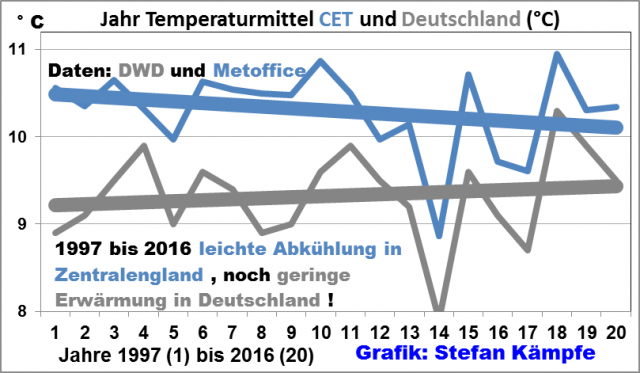

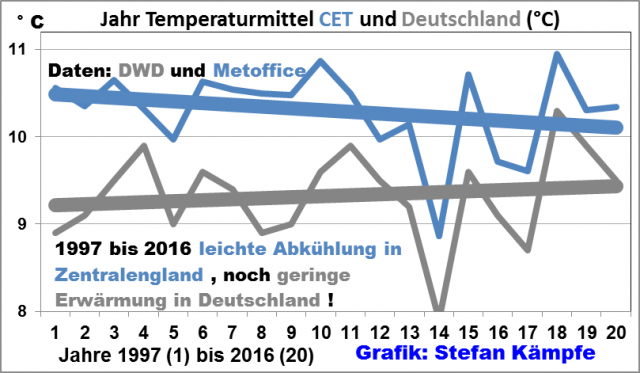

In den kommenden Jahrzehnten sinkt die Sonnenaktivität aber vermutlich weiter (neues Dalton- oder Maunder-Minimum), was weltweit abkühlend wirkt und in Mitteleuropa Meridionallagen (im Winter oft kalt) begünstigt. Das träge Klimasystem reagiert nur mit Verzögerungen von etwa 10 bis 30 Jahren auf die schon nach 1990 beginnende tendenzielle Abschwächung der Sonnenaktivität, so dass sich negative Auswirkungen erst weit nach 2015 deutlicher zeigen werden. Vermutlich gab es deswegen bereits in den letzten 20 Jahren kaum noch Erwärmung in Deutschland; in Zentralengland kühlte es sich gar leicht ab:

Bei globaler Betrachtungsweise (die „Erdmitteltemperatur“ ist strenggenommen ein wertloses Kunstgebilde) fehlt, trotz des starken El Ninos 2015/16, nun schon seit gut 20 Jahren eine signifikante „globale“ Erwärmung. Insgesamt lässt die geringe Sonnenaktivität 2017 einen eher normalen bis zu kalten Winter erwarten.

4. Die Zirkulationsverhältnisse

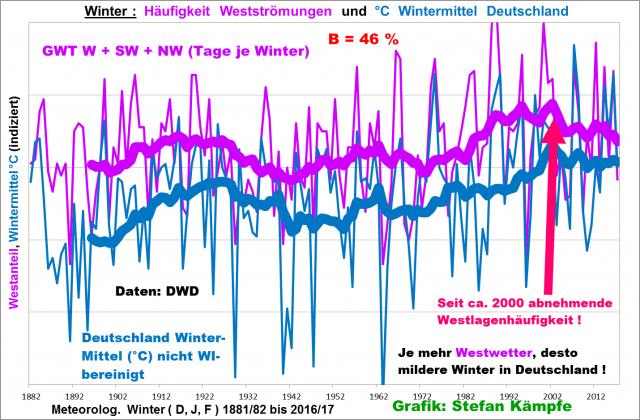

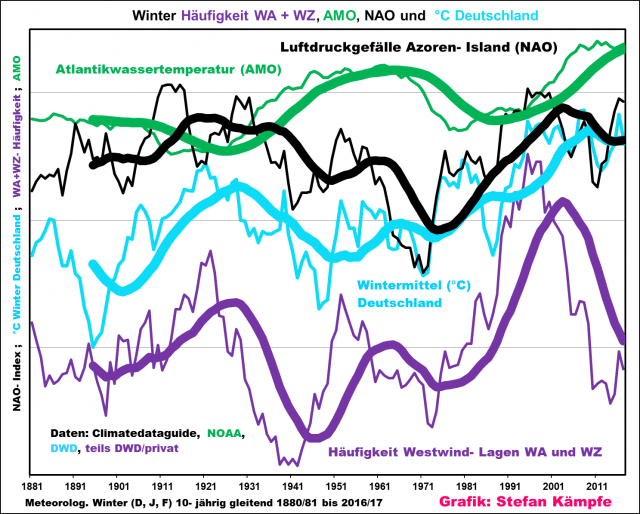

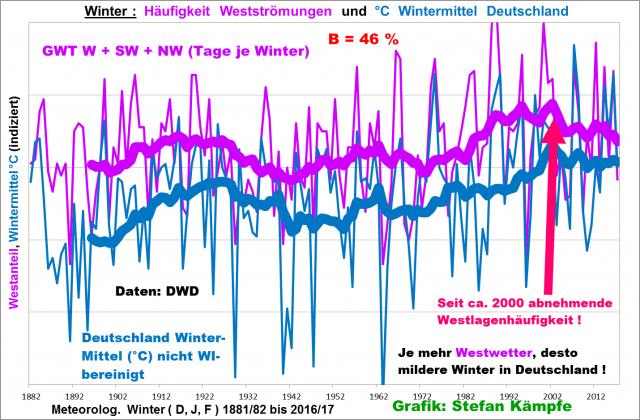

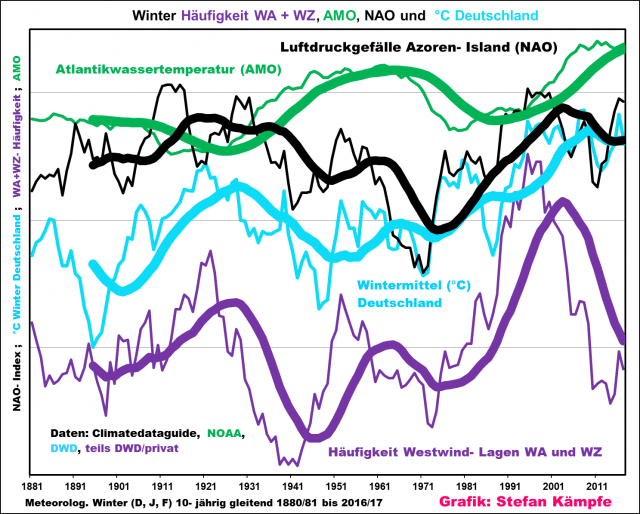

Westliche Luftströmungen (Zonale Großwetterlagen) bringen milde Atlantikluft nach Deutschland, nördliche und vor allem östliche Kaltluft. Bei Süd- und Zentralhochlagen muss ein starker Wind die bodennah aus Ost einsickernde oder vor Ort immer wieder neu entstehende Kaltluftschicht vertreiben, ansonsten können auch sie im Tiefland bitterkalt sein, während es auf den Berggipfeln sehr mild ist. Der Zusammenhang zwischen der Häufigkeit der Luftströmungen mit Westanteil (Großwettertypen W, SW und NW) sowie den Wintertemperaturen in Deutschland ist sehr eng (folgende Grafik):

Für längerfristige Vorhersagen muss man die Zirkulationsverhältnisse vorhersehen können, was kaum möglich ist. Im Herbst 2017 war die Zonalzirkulation zeitweise kräftig entwickelt; so Mitte September und in der ersten sowie letzten Oktoberdekade, was auf einen eher milden Winter hindeutet; ähnlich wie 2013/14, 1988/89 oder 1989/90. Ob die seit der Jahrtausendwende zu beobachtende leichte Abnahme der Westlagenhäufigkeit in diesem Jahr eine Rolle spielt, ist mehr als fraglich. Wegen der sich aktuell vermutlich verstärkenden Ostwind-Phase der QBO (Erklärung siehe Punkt 7) liegt eine verstärkte Meridionalisierung mit Kälte im Laufe des Hochwinters aber noch im Bereich des Möglichen. Einhergehend mit der lebhaften Zonalzirkulation gab es schwere Herbststürme („XAVIER“ Anfang und „HERWART“ Ende Oktober). Die Zirkulationsverhältnisse weisen überwiegend auf einen eher milden Winter hin.

5. Die mittelfristigen Modelle

Die verbesserte Kurzfrist-Vorhersagegüte (etwa 1 bis 4 Tage im Voraus) resultierte aus der Entwicklung und Verfeinerung numerischer Modelle, basierend auf Gleichungen der Thermodynamik, in Verbindung mit immer schnelleren Computern sowie mehr und besseren Mess- oder Beobachtungsdaten per Satelliten und Automaten. Für längerfristige Vorhersagen dienen sogenannte Ensemble- Modelle, bei denen man die Ergebnisse mehrerer Modell- Läufe (gerechnet mit leicht variierten Anfangsparametern) mittelt. Sie liefern keine detaillierten Vorhersagen, doch gute Abschätzungen des Temperaturniveaus für etwa eine Woche im Voraus und vage für bis zu 15 Tagen.

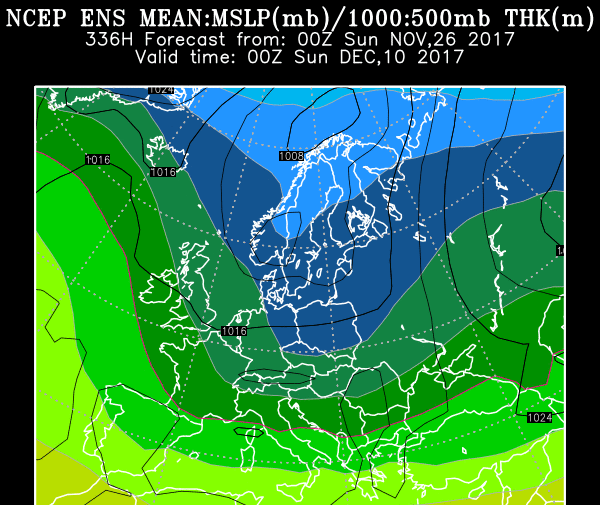

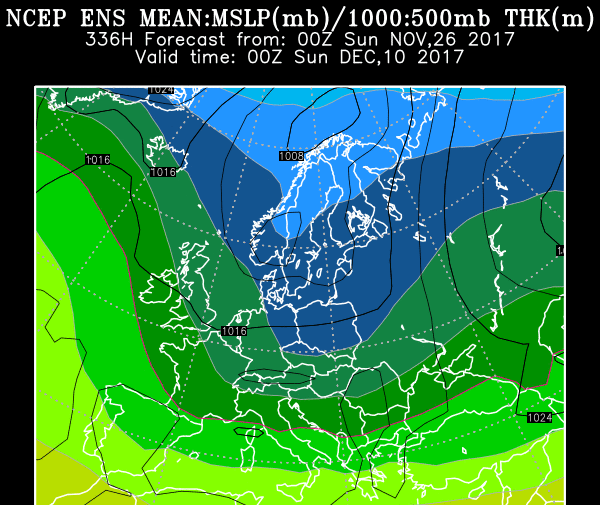

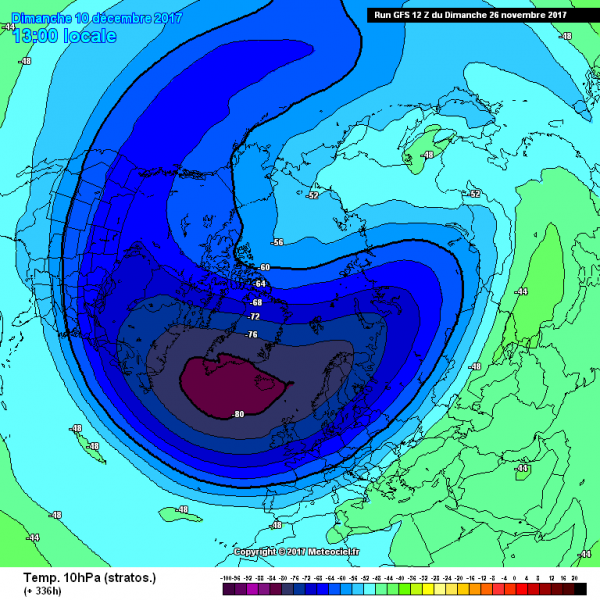

Die Ensemble-Vorhersagekarte des NOAA (USA- Wetterdienst) vom 26.11. für den 10.12.2017 zeigt ein Tief über Skandinavien, flankiert von hohem Luftdruck über dem Atlantik und Osteuropa (Quelle NOAA). Sollte das so eintreten (noch sehr unsicher), so wäre es zumindest im Bergland oberhalb 600 bis 800 Meter winterlich; im Tiefland wäre nasser Schnee oder Regen bei leichten Plusgraden möglich:

Es deutet sich, auch nach den hier nicht gezeigten Einzel- Modell- Läufen, für die erste Dezemberdekade normal temperiertes, nasskaltes Wetter an; im Bergland oberhalb etwa 600 bis 800m könnte gar Dauerfrost mit guten Wintersportbedingungen herrschen; im Tiefland zumindest zeit- und gebietsweise nasser Schnee liegen; zumindest gelegentliche Nachtfröste mit Glättegefahr sind hier zu erwarten; tagsüber aber meist mehr oder weniger deutliche Plusgrade; vielleicht kurzzeitig im Nordosten auch mal schwacher Dauerfrost.

6. Die aktuelle Tendenz der Wintertemperaturen in Deutschland

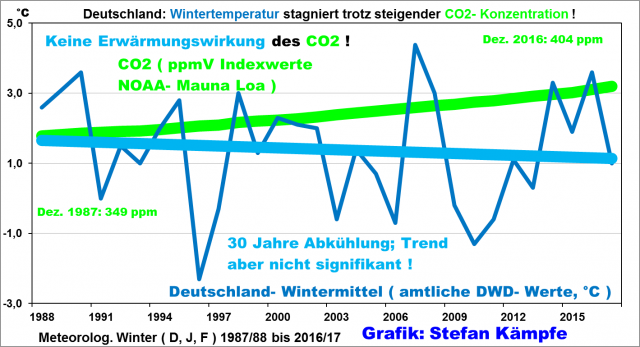

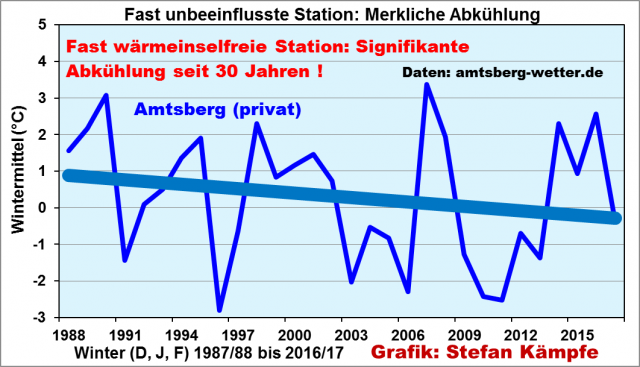

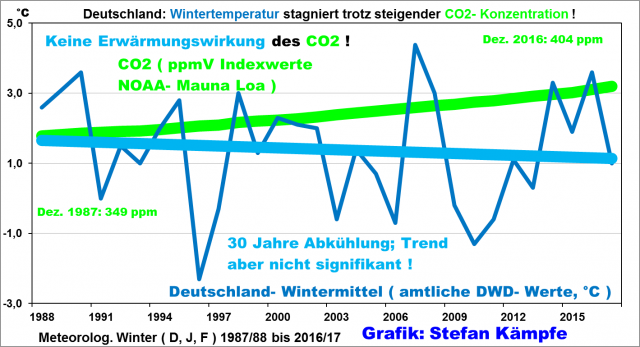

Trends erlauben nie Rückschlüsse auf den Einzelfall und keine Extrapolation in die Zukunft. Die Wintertemperaturen entwickelten sich in den letzten 30 Jahren folgendermaßen:

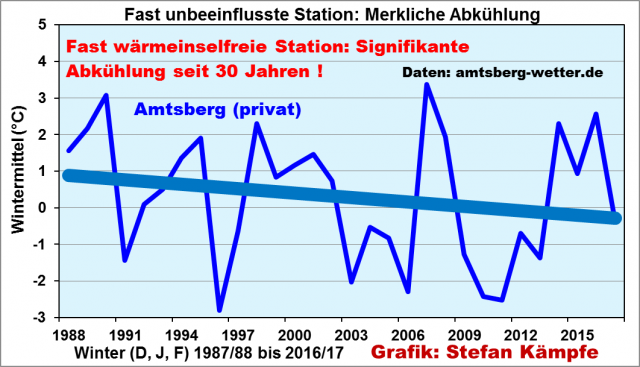

Trotz der sehr milden Winter 2013/14 und 2015/16 und kontinuierlich steigender CO2- Konzentration (obere, grüne Linie) fiel das Wintermittel seit 30 Jahren, wenngleich nicht signifikant, weil die schon erwähnte nachlassende Sonnenaktivität und schwächere Zonalzirkulation bereits Wirkung zeigen. Doch die DWD-Daten sind nicht wärmeinselbereinigt. Einen deutlicher fallenden Trend zeigt die wärmeinselarme Station Amtsberg/Erzgebirge:

Aber die „richtige“ Kälte dürfte indes wegen der Trägheit des Klimasystems erst in wenigen Jahren bis Jahrzehnten zuschlagen („Kleine Eiszeit“). Die seit einigen Jahren wieder leicht steigende Zahl von Nebeltagen weist gleichfalls auf eine langsam beginnende Abkühlung hin.

7. Die Nordatlantische Oszillation (NAO), die AMO, die QBO und der Polarwirbel

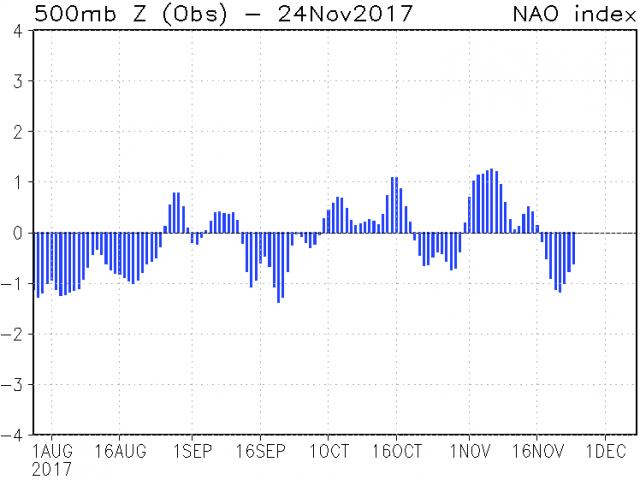

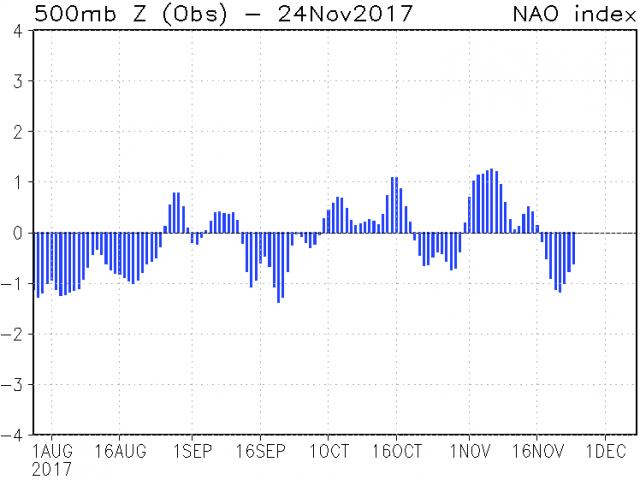

Der NAO- Index ist ein Maß für die Intensität der Westströmung über dem Ostatlantik im Vergleich zum Langjährigen Mittel. Positive NAO- Werte bedeuten häufigere und intensivere, im Winter eher milde Westwetterlagen. Bei negativen NAO- Werten schwächt sich die Intensität der Zonalströmung ab, bei stark negativen Werten kann sie gar in eine Ostströmung umschlagen oder meridional verlaufen. Die NAO schwankte seit Sommer 2017 häufig zwischen positiven und negativen Werten; zum Schluss war der Index negativ (Quelle http://www.cpc.ncep.noaa.gov/products/precip/CWlink/pna/nao.mrf.obs.gif ):

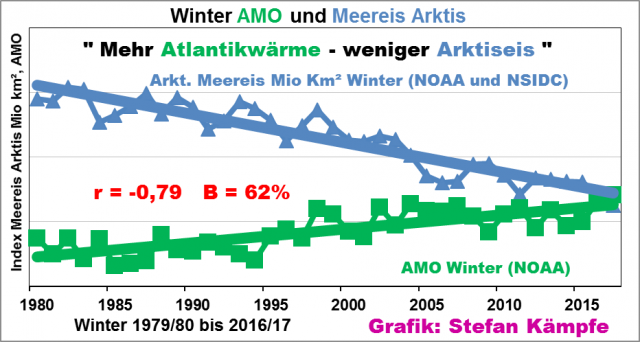

Mitunter verändert sich die NAO sprunghaft (schwere Vorhersagbarkeit). Die AMO (ein Maß für die Wassertemperaturschwankungen im zentralen Nordatlantik) beendet gegenwärtig ihre Warmphase. Ein kompletter AMO- Zyklus dauerte seit Beginn regelmäßiger Messungen immer etwa 50 bis 80 Jahre, somit ist in naher Zukunft ein Wechsel in die Kaltphase wahrscheinlich. Mehr zum Zusammenhang von AMO, NAO und den Temperaturverhältnissen in Deutschland unter anderem hier http://www.eike-klima-energie.eu/news-cache/im-takt-der-amo-und-der-nao-3-das-haeufigkeitsverhalten-der-grosswetterlagen-und-dessen-auswirkungen-auf-die-deutschland-temperaturen/ . Die folgende Abbildung beginnt mit dem 10-jährigen Gleitmittel ab 1880/81 unter Einbeziehung der Werte ab 1871/72. Die AMO (grün) verhält sich fast spiegelbildlich zu NAO (obere schwarze Kurve), der Westwetterlagenhäufigkeit (unterste, violette Kurve) und den Wintertemperaturen in Deutschland. Die Gleitmittel wurden dann nochmals 15- jährig geglättet (fette Linien).

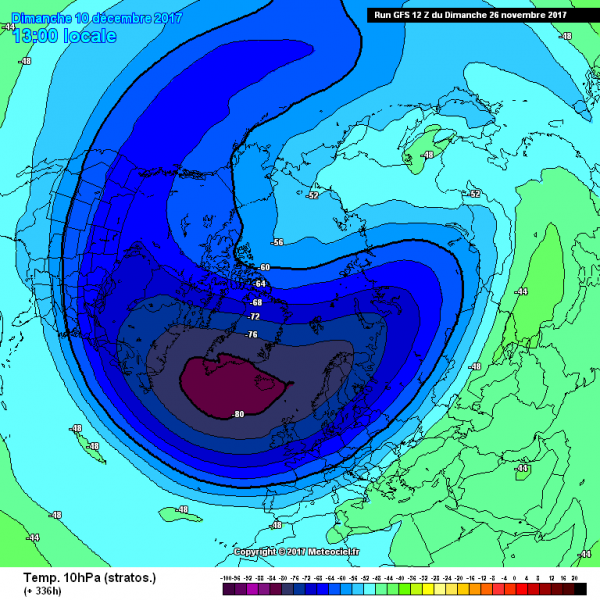

AMO- Warmphasen erhöhen die Wahrscheinlichkeit für einen kalten Winter leicht, weil diese Konstellation kalte, nordöstliche Strömungen („Wintermonsun“) begünstigen könnte. Und die sogenannte QBO (Windverhältnisse in der unteren Stratosphäre der Tropen, die etwa alle 2,2 Jahre zwischen West und Ost wechseln) verhält sich momentan ungewöhnlich uneinheitlich (Westwindphase in der unteren Stratosphäre und Ostwindphase in der oberen Stratosphäre). Nur wenn die Westwind- Phase in der unteren Stratosphäre enden sollte, könnte das Meridionale Lagen und damit einen Kaltwinter begünstigen. In diesem Zusammenhang lohnt noch ein Blick auf die mögliche Entwicklung des Polarwirbels. Ein ungestörter, sehr kalter Polarwirbel im 10- hPa- Niveau (gut 25 Km Höhe, Stratosphäre) ist kreisrund und in der Arktis extrem kalt, was Westwetterlagen begünstigt, welche in Deutschland mild sind. Für den 10. Dezember wird ein Polarwirbel vorhergesagt, der merklich gestört und über Grönland/Island am kältesten ist, was alle Möglichkeiten für milde oder kalte Witterungsabschnitte noch offen lässt:

NAO, QBO, AMO und das Verhalten des Polarwirbels deuten auf einen eher normalen bis milden Winter hin.

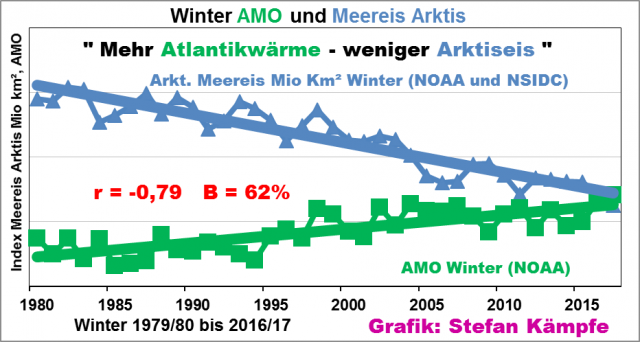

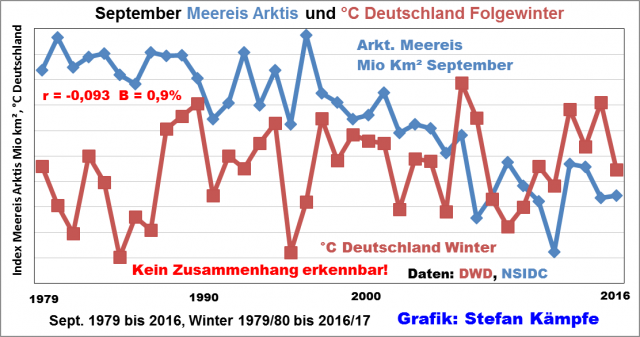

8. Verursacht das angeblich verschwindende Arktische Meereis kältere Winter? Für die relativ kalten Winter 2009/10 und 2012/13 wurde das schwindende arktische Meereis, speziell im September, verantwortlich gemacht. Mit etwa 4,8 Millionen Km² gab es im Septembermittel 2017 eine etwas größere Eisfläche, als in den beiden Vorjahren, und deutlich mehr zum bisherigen Negativ- Rekordmittel von 3,57 Millionen Km² (Sept. 2012) (Daten: NSIDC, National Snow and Ice Data Center der USA). Bei AMO- Warmphasen wird mehr Wärme in die Arktis eingetragen. Die minimale Eisausdehnung und die geringere Westlagenhäufigkeit der 2000er Jahre „passen“ gut zum AMO- Maximum. Genaueres Zahlenmaterial zur Eisausdehnung liegt leider erst seit 1979 vor (Einführung der flächendeckenden, satellitengestützten Überwachung). Zumindest in diesem relativ kurzen Zeitraum von mehr als 35 Jahren bestand ein signifikanter Zusammenhang zwischen der AMO und der Fläche des winterlichen Arktis- Meereises:

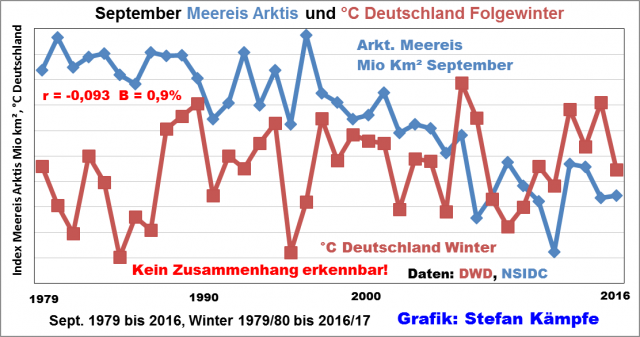

Ähnlich wie in den 1930er Jahren, als während der damaligen AMO- Warmphase ebenfalls ein Meereisrückgang sowie vor allem ein starkes Abschmelzen der Grönland- Gletscher herrschte. Näheres dazu unter http://www.eike-klima-energie.eu/climategate-anzeige/fotos-aus-den-dreissiger-jahren-groenland-gletscher-haben-sich-damals-schneller-zurueck-gezogen-als-heute/ . Die These „weniger Arktiseis – mehr Winterkälte in Deutschland“ ist unhaltbar; tatsächlich fehlt jeglicher Zusammenhang:

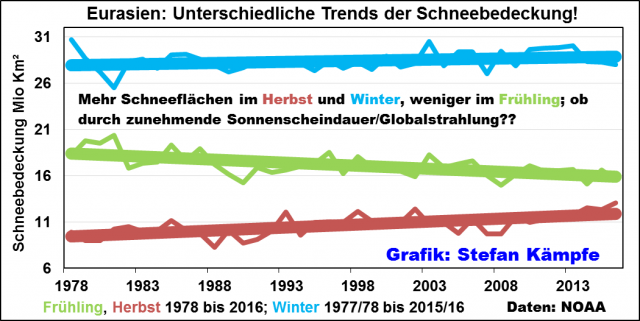

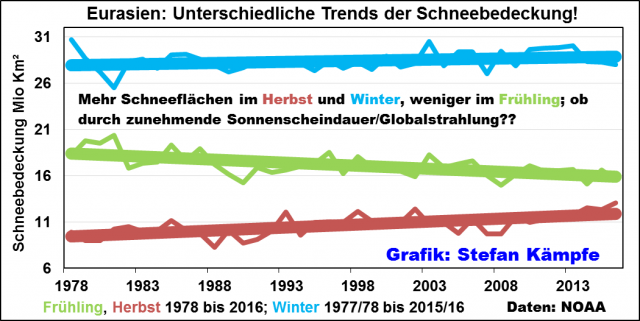

Auch bei Betrachtung anderer Bezugszeiträume besteht keine Korrelation. Die aktuelle Meereisbedeckung im Vergleich zu den Vorjahren auf der Nordhalbkugel kann man hier abrufen: http://ocean.dmi.dk/arctic/icecover.uk.php . Laut einer Fehlprognose von Al Gore sollte der Nordpol schon im Spätsommer 2013 eisfrei sein. Näheres bei http://info.kopp-verlag.de/hintergruende/enthuellungen/alex-newman/al-gore-sagte-voraus-2-13-sei-die-arktis-voellig-eisfrei-stattdessen-ist-die-eisschicht-um-die-ha.html . Im Herbst 2017 war ein stärkeres Eiswachstum als in den Vorjahren zu beobachten, was den Polarwirbel stärken und milde Westlagen begünstigen könnte. Insgesamt hat das komplizierte, wenig erforschte Zusammenspiel zwischen Meeresströmungen, AMO, Meereis und Großwetterlagen wahrscheinlich großen Einfluss auf die Witterungsverhältnisse. Die Ausdehnung der Schneebedeckung im Spätherbst (Okt/Nov) in Eurasien hat ebenfalls keine eindeutigen Auswirkungen auf die deutsche Winterwitterung. So bedeckte der Schnee in den Spätherbsten 1968, 70, 72, 76, 93, 2002, 09, 14,15 und 16 auf der größten zusammenhängenden Landmasse der Erde eine deutlich überdurchschnittliche Fläche, doch nur die 3 Winter 1968/69, 2002/03 und 2009/10 waren danach zu kalt, während die anderen 7 zu mild ausfielen; letztmalig der von 2016/17, trotz des kalten Januars. Eine große Überraschung bot dieser Analyseteil trotzdem. Im Herbst und Winter wächst nämlich die mit Schnee bedeckte Fläche Eurasiens; nur im Frühling und Sommer nimmt sie ab. Sollte es Dank des „Klimawandels“ nicht immer weniger Schneeflächen in allen Jahreszeiten geben?? Und die wahre Ursache für die Abnahme im Frühjahr/Sommer ist nicht das CO2, sondern vermutlich mehr Sonnenschein (siehe folgende Abbildung):

9. Analogfälle (ähnliche Witterung wie 2017)

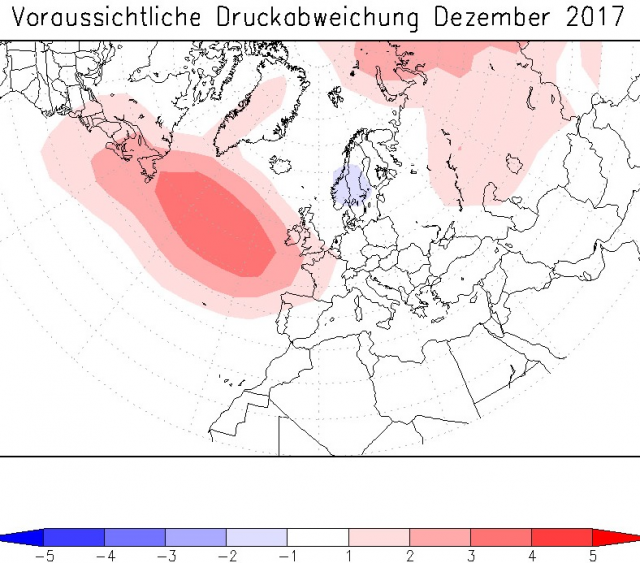

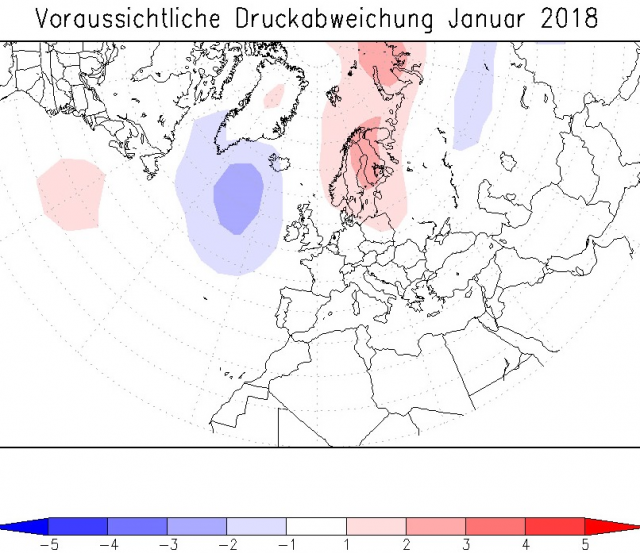

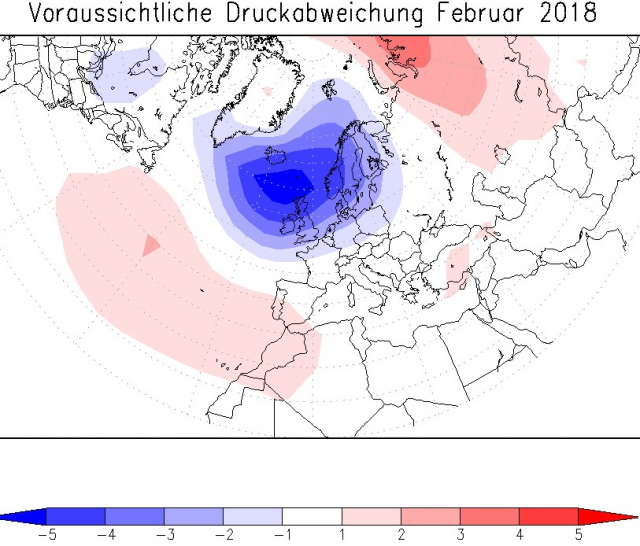

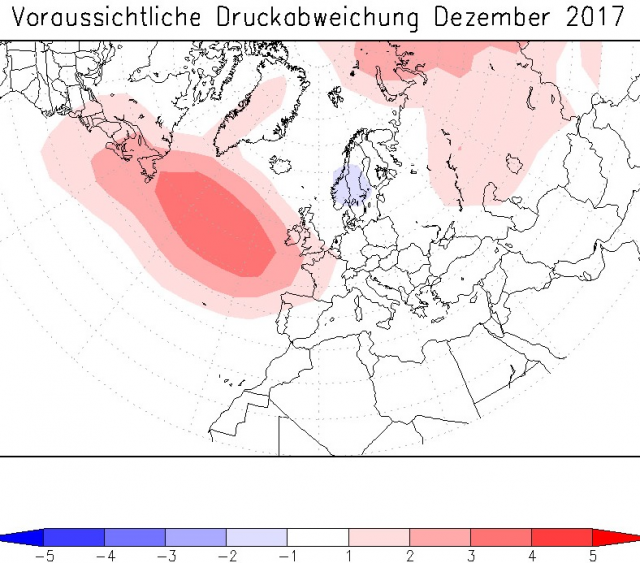

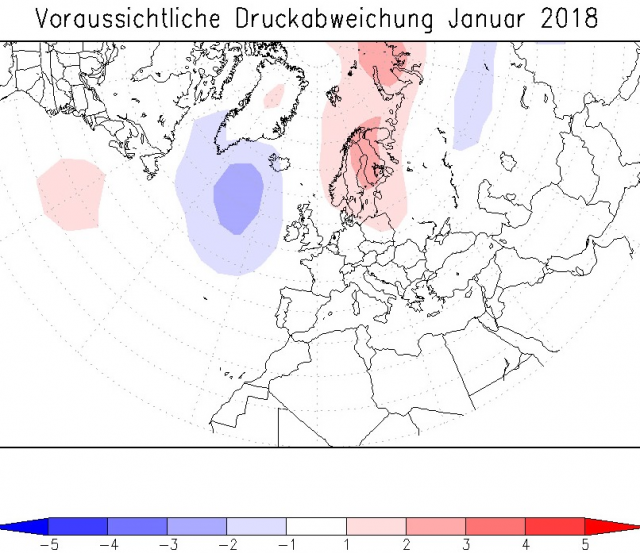

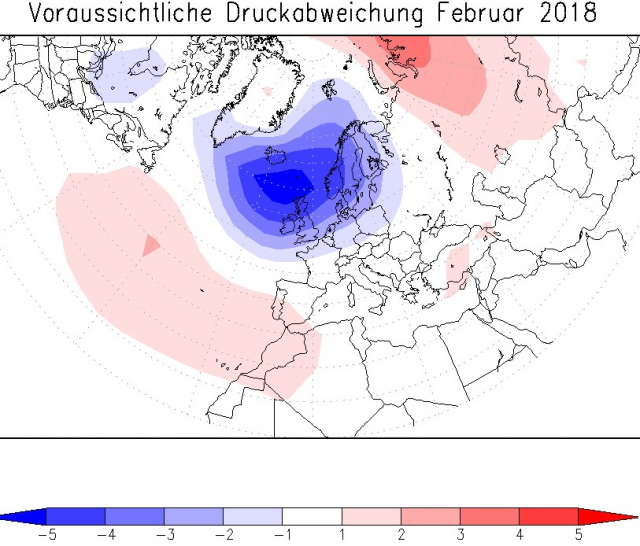

Bei dieser Methode werden die dem Winter vorangehenden Monate hinsichtlich ihres Witterungsverlaufs untersucht. Betrachtet man alle mehr oder weniger zu kalten Winter der vergangenen 4 Jahrzehnte inklusive solcher, die bei milder Gesamtwitterung mindestens eine mehrwöchige Kälteperiode aufwiesen, so gingen diesen Wintern bis auf die Ausnahme von 2011 Herbste voraus, die schon mindestens einen auffälligen Kälteeinbruch hatten. Dabei war nur selten der Herbst insgesamt zu kalt, aber er wies dann mindestens einen zu kalten Monat oder wenigstens eine markante Kaltphase auf (November 1978, 1980, 1981, 1984, 1985, September 1986, September 1990, November 1993, November 1995, September 1996, September/Oktober 2002, November 2005, September 2008, Oktober 2009, November 2010, Oktober 2012, 2015, Oktober/November 2016). Schneite es bereits im Oktober stellenweise bis ins Flachland (2002, 2009, 2012 und 2015), so war in den ersten 3 Fällen der gesamte Winter zu kalt; 2015/16 kam es nur im Januar besonders in Nordostdeutschland zu längeren, winterlichen Phasen. Vor den meisten fast durchgängig milden Wintern (1973/74,1974/75,1987/88,1988/89,1989/90, 2006/07, 2007/08, 2013/14, 2014/15) waren die Herbste entweder rau, gemäßigt oder extrem mild; markante Kälteeinbrüche fehlten jedoch so wie auch 2017 oder waren nur ganz kurz (November 1988 und 1989). Das Witterungsverhalten im September/Oktober 2017 (September etwas zu kalt, Oktober zu feucht und viel zu mild) ähnelte, freilich nur sehr grob, dem der Jahre 1923, 66 und 2013, wonach der Winter 1923/24 zu kalt und die beiden letzten zu mild waren. Die wahrscheinliche (trotzdem sehr unsichere) Luftdruckabweichung vom Langjährigen Mittel über Europa (Quelle: langfristwetter.com) sieht für die kommenden Wintermonate so aus:

Im Dezember 2017 (oberes Bild) positive Luftdruck-Anomalie in hpa auf Meeresspiegelniveau über dem Nordatlantik und etwas zu tiefer Luftdruck über Skandinavien. Das hätte normale Dezembertemperaturen in Mitteleuropa zur Folge; mit Schneefällen besonders in den Mittelgebirgen. Im Januar 2018 (Mitte) leicht erhöhter Luftdruck über Nordosteuropa- zumindest einzelne Kältewellen aus Nordost wären bei insgesamt etwas zu kaltem Januar denkbar. Im Februar deutlich zu tiefer Luftdruck bei Island mit sehr mildem Westwetter bei uns. Die Vergleichsjahre mit ähnlicher Vorwitterung, aus der sich die berechnete Druckverteilung ergab, waren 1949, 1967, 1970, 1973, 1983, 1984, 1990, 1994, 1996, 1999, 2001, 2005 und 2013. Es finden sich danach 6 zu milde (am deutlichsten 2013/14), 4 fast temperaturnormale und 3 zu kalte Winter; am markantesten 1984/85. Damit deutet sich bei Mittelung eine Tendenz zu einem eher normalen Winter an. Auch hier ist die geringe Zahl der Vergleichsfälle problematisch; Näheres zu der Methode unter http://www.langfristwetter.com/langfristprognose-europa.html . Zu warmen Sommern (auch der Sommer 2017 war trotz seiner sehr wechselhaften, nassen Witterung deutlich zu warm!) folgen meist milde statt kalten Wintern (positiver Zusammenhang). Für seriöse Vorhersagen ist diese Beziehung freilich auch viel zu schwach. Zwischen den Herbst- und Wintertemperaturen findet sich sogar ein etwas deutlicherer positiver Zusammenhang. Schon der August liefert aber manchmal erste Hinweise. Er wies 2017 nach der Objektiven Wetterlagen- Klassifikation des DWD (seit 1979 verfügbar) mit 30 Tagen auffallend viele mit Westanteil und nach der HESS/BREZOWSKY- Klassifizierung mit 15 Tagen auffallend viele mit Südanteil auf. Ähnlichen Augusten folgten in der Vergangenheit zu 50 bis 60% milde und nur zu 10 bis 25% kalte Winter; die restlichen waren normal. Und sogar der dem Winter vorausgehende März (2017 extrem mild) lässt einen sehr kalten Winter unwahrscheinlich werden. In den 36 Fällen seit 1881, bei denen der Vor- März im Deutschlandmittel mindestens 5°C erreichte, also merklich zu mild war, verlief der folgende Winter in 17 Fällen zu mild, in 13 normal und nur in 6 Fällen etwas zu kalt. Ähnliches gilt für den Vor- Mai. Insgesamt deutet sich nach den Analogfällen also eine erhöhte Wahrscheinlichkeit für einen normalen bis zu milden Winter an.

10. Die Hurrikan- Aktivität (Nordatlantik) und Zyklonen- Aktivität (nördlicher Indik)

Mit gewissen Abstrichen (mangelnde Beobachtungsmöglichkeiten vor Einführung der Satellitentechnik) ist die jährliche Anzahl der Tropischen Wirbelstürme im Nordatlantik (Hurrikane) und der Zyklone (nördlicher Indischer Ozean) etwa bis zur Mitte des 19. Jahrhunderts bekannt. Die verheerenden, meist wenige Tage bis selten länger als zwei Wochen existierenden Hurrikane gelangen nie nach Mitteleuropa. Aber sie beeinflussen unsere Witterung. Sie schwächen bei bestimmten Zugbahnen das Azorenhoch oder kommen bei Einbeziehung in die Westdrift als normale Tiefs nach Europa, wo sie im Spätsommer/Frühherbst mitunter einen Witterungsumschwung einleiten. Auch die Anzahl der im nördlichen Indischen Ozean jährlich vorkommenden Wirbelstürme (Zyklone) könnte einen gewissen Einfluss auf unsere Winterwitterung haben; es gibt von 1890 bis 2014 eine leicht negative Korrelation (tendenziell kältere Winter, wenn dort viele Zyklone auftraten). Im Mittel von 1851 bis 2014 sind gut 5 Hurrikane pro Jahr (die Saison beginnt meist erst zwischen Mai und Juli, doch 2016 gab es schon im Januar einen Hurrikan, und endet spätestens Anfang Dezember) aufgetreten. Erreichte ihre Zahl mindestens 10 (1870, 1878, 1886, 1887, 1893, 1916, 1933, 1950, 1969, 1995, 1998, 2005, 2012), so waren von den 13 Folgewintern 11 zu kalt, nur 2 (1998/99 und 1950/51) zu mild. Bei fast all diesen Fällen brachte allerdings schon der Spätherbst markante Kältewellen; selbst vor den beiden dann milden Wintern waren sie zu beobachten; besonders markant 1998. In diesem Jahr gab es bislang 10 Hurrikane und damit deutlich zu viele, was eher für einen kalten Winter spricht. Im Indischen Ozean blieb die Zyklonen- Aktivität 2017 jedoch unterdurchschnittlich, was auf einen eher milden Winter hindeutet. Die Wirbelsturm- Aktivität liefert diesmal also keine eindeutigen Hinweise auf den Charakter des Winters in Deutschland.

11. Die Langfrist- Vorhersagen einiger Institute, Wetterdienste und Privatpersonen:

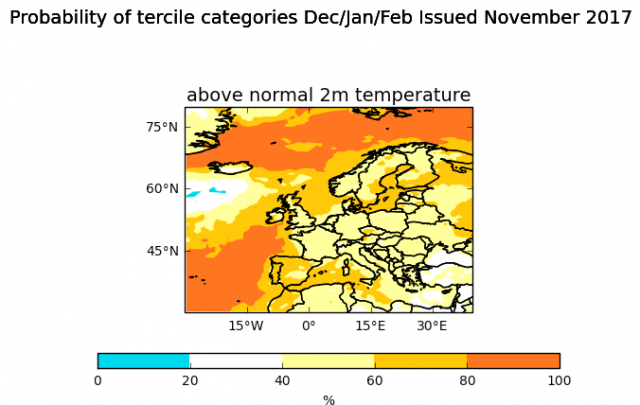

UKMO (Großbritannien): Stand 11.11.2017 Winter (D, J, F) mit leicht erhöhter Wahrscheinlichkeit in Deutschland zu mild (folgende Karte):

Anmerkung: Hier wird nur die erste UKMO- Karte gezeigt. Es gibt zwei weitere, eine mit der Probability (Wahrscheinlichkeit) für einen normalen Winter und eine für einen zu kalten; erstere weist ebenfalls eine leicht erhöhte Wahrscheinlichkeiten auf; während ein zu kalter Winter höchstens zu 20% wahrscheinlich ist . Die aktuellen Karten jederzeit unter http://www.metoffice.gov.uk/research/climate/seasonal-to-decadal/gpc-outlooks/glob-seas-prob

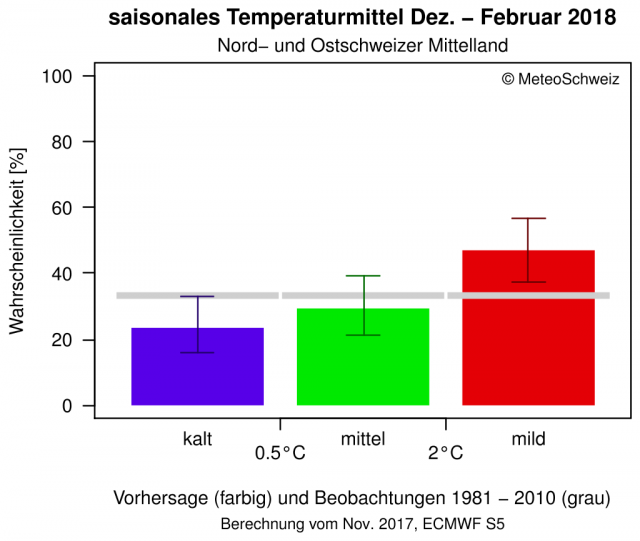

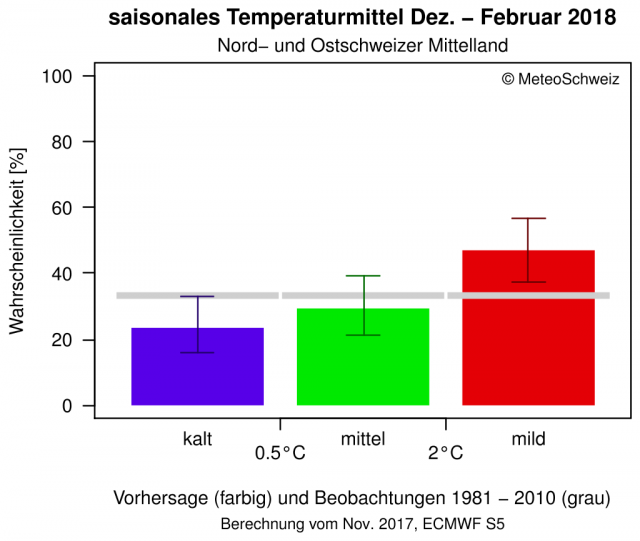

Meteo Schweiz Stand Nov. 2017: Leicht erhöhte Wahrscheinlichkeit für einen zu milden Winter. Zu kalter Winter nur zu etwas mehr als 20% wahrscheinlich); normaler zu knapp 30%. Die „doppelten T“ sind die Fehlerbalken:

LARS THIEME (langfristwetter.com) Vorhersage von Anfang November 2017: Alle drei Wintermonate zu mild.

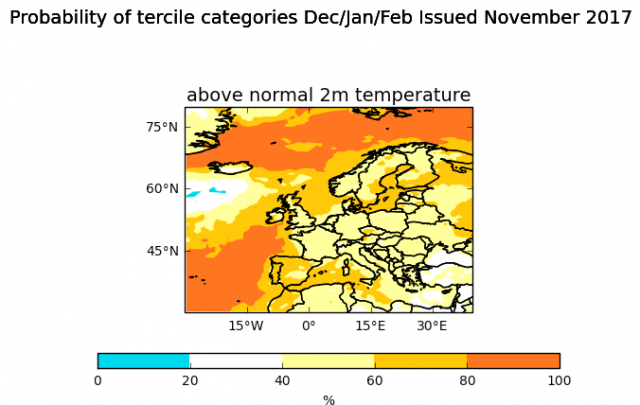

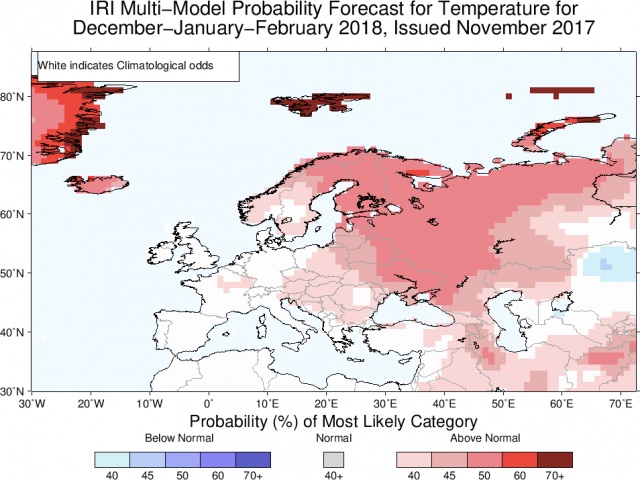

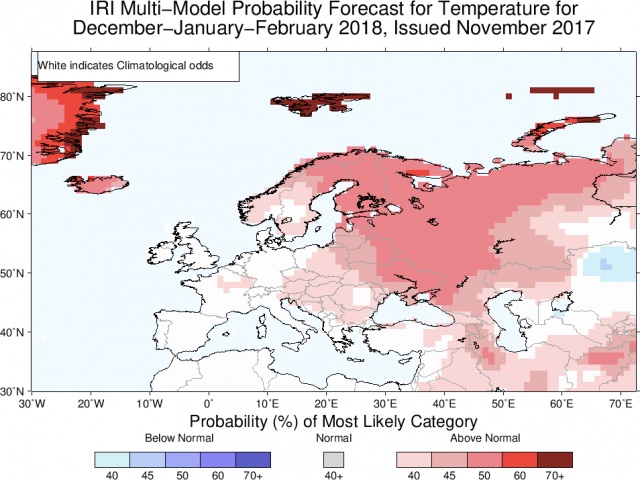

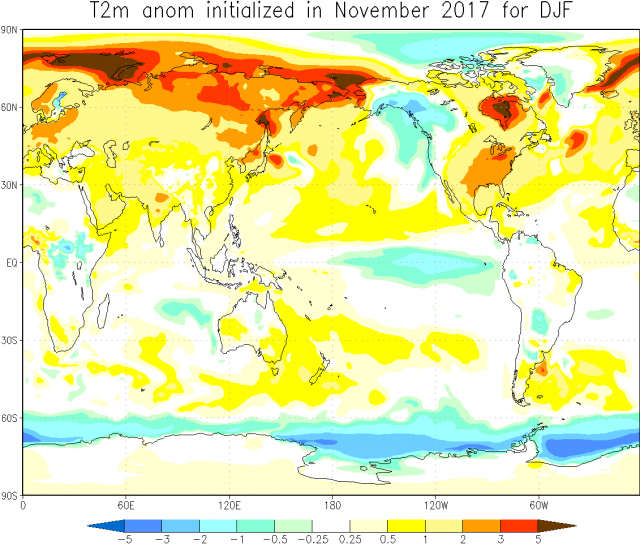

IRI (folgende Abbildung), Vorhersage vom Nov. 2017: Keine Aussagen für Deutschland und weite Teile West- und Mitteleuropas; zu mild in Nord- und Osteuropa.

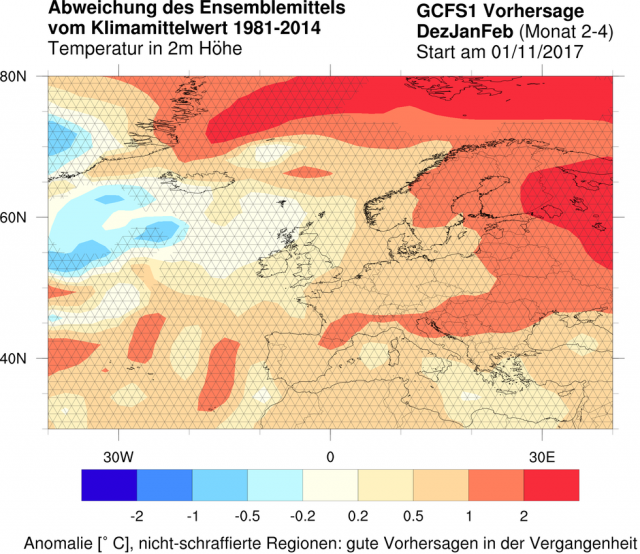

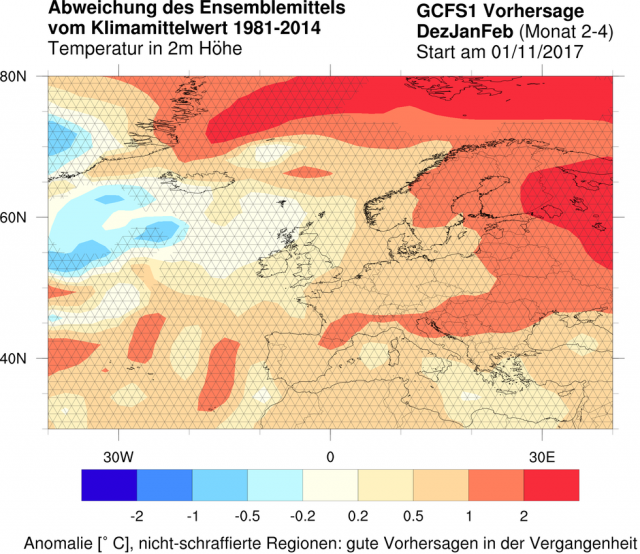

DWD (Offenbach): In Deutschland 0,5 bis 1°C zu mild, bezogen auf den Mittelwert der Jahre 1981 bis 2014 (Stand Nov. 2017):

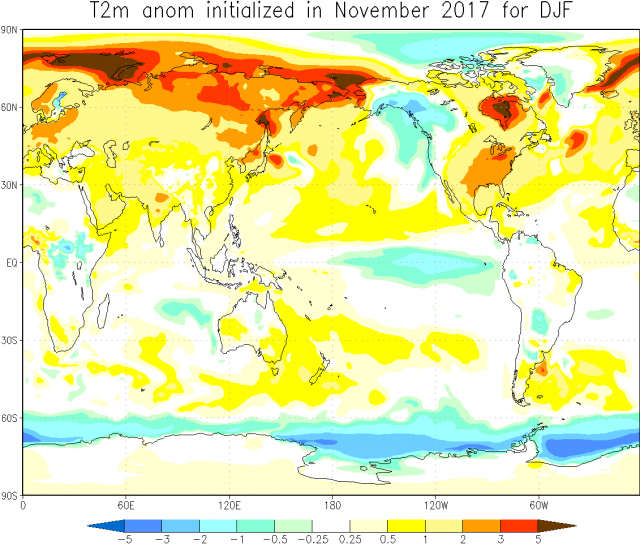

NASA (US- Weltraumbehörde) Karte vom November 2017: Winter in Mitteleuropa etwa 2 bis 3 K zu mild. Bei dieser Karte liegt Mitteleuropa am linken Kartenrand, weit oben:

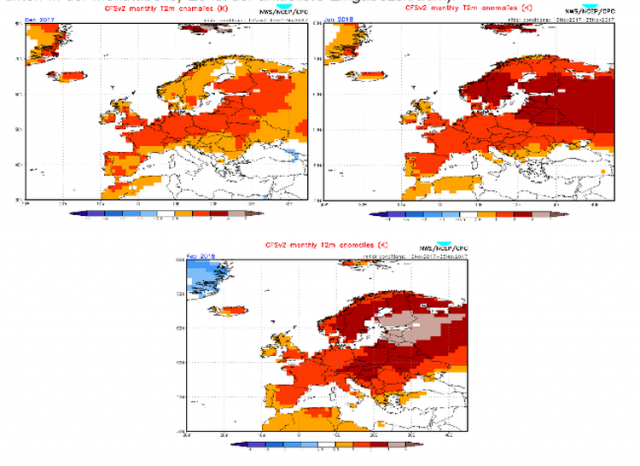

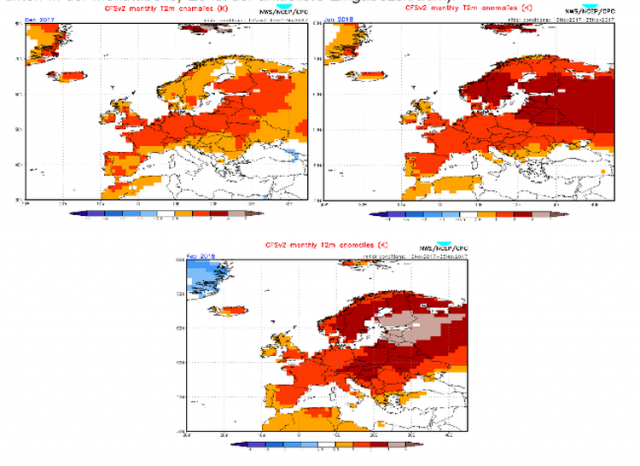

CFSv2- Modell des NOAA (Wetterdienst der USA, folgende 3 Abbildungen, Eingabezeitraum 16. bis 25.11. 2017): Alle 3 Wintermonate um 1 bis 2 K zu mild. Dezember (links) Januar (rechts) Februar (unten); damit Winter insgesamt sehr mild. Die vorhergesagten Temperaturabweichungen beziehen sich auf die Mittelwerte der Periode 1981 bis 2010. Die fast täglich aktualisierten, aber leider oft falschen Prognosen unter http://www.cpc.ncep.noaa.gov/products/people/wwang/cfsv2fcst/ (Europe T2m, ganz unten in der Menütabelle; E3 ist der aktuellste Eingabezeitraum):

Die Mehrzahl dieser experimentellen, nicht verlässlichen Langfristprognosen deutet einen eher zu milden Winter an.

Fazit: Eindeutige, verlässliche Anzeichen für einen durchgehend kalten Winter fehlen. Die Prognosesignale sowie die Vorhersagen der Wetterdienste und Institute tendieren bei großer Unsicherheit in Richtung eines normalen bis extrem zu milden Winters. Momentan kündigen sich keine markanten Kälteeinbrüche im Frühwinter an; aber nasskaltes Wetter; im Bergland oberhalb von etwa 500 Metern könnte im Dezember häufiger, im Tiefland gelegentlich Schnee liegen. Insgesamt fällt der Winter 2017/18 nach momentanem Stand also normal bis extrem zu mild aus und wird im Deutschland- Mittel auf +0,5 bis +3,5°C geschätzt (LJM 1981 bis 2010 +0,9°C); bei den sehr widersprüchlichen Prognosesignalen muss die weitere Entwicklung aber noch abgewartet werden. In den Mittelgebirgen bestehen zumindest zeit- und stellenweise gute Wintersportmöglichkeiten. Geschätzte Dezember- Monatsmitteltemperatur für Erfurt- Bindersleben (Mittel 1981- 2010 +0,5°C) 0,0 bis +2,5°C (normal bis deutlich zu mild). Für Jan/Feb. 2018 lässt sich noch kein Temperaturbereich schätzen! Das Schneeaufkommen ist kaum vorhersehbar (langfristige Niederschlagsprognosen sind besonders unsicher). Zur Winterlänge fehlen bisher ebenfalls noch Hinweise. Die Hochwinterwitterung (Jan/Feb.) kann erst anhand des Witterungstrends zum Jahreswechsel etwas genauer abgeschätzt werden; momentan ist ein zu milder Hochwinter deutlich wahrscheinlicher, als ein zu kalter. Wegen eines möglichen Wechsels zur Ostwindphase in der unteren Stratosphäre (QBO) sind aber winterliche Phasen oder wenigstens ein einzelner, kalter bis sehr kalter Wintermonat noch nicht völlig ausgeschlossen. Sollte allerdings der Dezember tatsächlich zu mild ausfallen, so erhöht das die Wahrscheinlichkeit für einen milden Hochwinter 2018 noch weiter.

Dieses Fazit wurde aus 10% der Tendenz der Bauern- Regeln, 10% Sonnenaktivität, 20% Zirkulationsverhältnisse, 10% Mittelfrist- Modelle, 10% NAO, AMO,QBO, Polarwirbel, 20% Analogfälle und 20% der vorwiegenden Tendenz der Langfristprognosen gewichtet.

Aktualisierung voraussichtlich Ende Dezember.

Zusammengestellt von Stefan Kämpfe, unabhängiger Klimaforscher, am 26.11. 2017