Was die Monopolkommission unterlässt!

Auf Wissenschaftler und Experten mit Scheuklappen sollte man sich lieber nicht verlassen. Nur Scheuklappen für Pferde haben ihre Berechtigung: Die Vierbeiner sollen nur das von Reiter oder Kutscher vorgegebene Ziel antraben, Scheuklappen sie bekanntlich davon nicht ablenken. Aber Wissenschaftler und Experten sind keine Pferde, sondern wichtige Ratgeber. Wenn nämlich Sie ein Ziel ansteuern, sollten sie über den Horizont ihres begrenzten Fachgebietes hinausblicken können, auch andere wissenschaftliche Disziplinen im Blick haben und bedenken, ob das Ziel, das sie als Ratgeber anzusteuern beauftragt sind, auch wirklich sinnvoll ist. So zu verfahren, ist umso wichtiger, je mehr die Spezialisierung auch in den Wissenschaften immer weiter ausufert und Detail-Wissen wichtiges Allgemein-Wissen zurückdrängt. Blicke über den Zaun ihres verengten Fachgebietes zu werfen, wäre auch der deutschen Monopolkommission anzuraten.

Den Kernpunkt der Kritik an der Energiewende lässt die Monopolkommission aus

Neulich hat diese Kommission*) der staatlichen Energiewende-Politik ein schlechtes Zeugnis ausgestellt. Sie tut das in ihrem Sondergutachten zur Energiepolitik, das sie alle zwei Jahre vorlegt.**) Dabei beanstandet sie die Energiewende allerdings nicht grundsätzlich, obwohl diese Politik staatliche Intervention pur ist: Die Energiewende-Politik schaltet in der Stromerzeugung den Wettbewerb zwischen den Energieträgern aus und beglückt die Erzeuger von Wind-, Solar- und Biogasstrom mit hohen Subventionen, diktiert auf diese Weise die Strompreise und treibt sie nach oben. Subventionen und Preisdiktat sind nicht Wettbewerb. Sie fördern den Wettbewerb nicht, sie zerstören ihn. Eben in diese Wunde der Energiewende müsste die Monopolkommission den Finger legen. Das aber tut sie nicht.

Verfangen im interventionistischem Klein-Klein – Funktionsfähiger Wettbewerb sieht anders aus

Stattdessen befasst sie sich damit, wie der Staat mit seiner Intervention die Energiewende effizienter hinbekommt. Sie kritisiert herum an der Ausführung, bemängelt die Ausschreibungen der Kommunen für Gas- und Stromleitungen, kritisiert die Menge an Regulierungen, Zielen und Steuerungswirkungen als nur noch schwer überschaubar, mahnt das konsequente Vermeiden von CO2-Emissionen an, wirft dem Gesetzgeber Stückwerk vor, hantiert an allen möglichen Stellschrauben, gibt überaus zahlreiche Handlungsempfehlungen. Kurzum, so, wie sich der Staat mit seiner unsäglichen Energiewende-Bürokratie im Regelungsdickicht verfangen hat, das immer neuen Höhepunkten zustrebt – wie das bei staatlichen Interventionen üblicherweise der Fall ist und es der Wirtschaftswissenschaftler Ludwig von Mises schon in den 1930er Jahren dargestellt hat – so verliert sich in diesem interventionistischem Klein-Klein auch die Monopolkommission. Funktionsfähiger Wettbewerb, für den sie eintreten soll, sieht anders aus. Von der Monopolkommission muss der Bürger erwarten, dass sie wettbewerbspolitisch verfehlte Gesetzgebung nicht mit Ratschlägen zur besseren Anwendung unterstützt, sondern sagt, dass sie wettbewerbspolitisch verfehlt ist.

Was die Monopolkommission fahrlässig versäumt

Die Klimaschutzpolitik, mit der die Wende zum „Ökostrom“ offiziell politisch begründet wird, stellt die Monopolkommission nicht infrage, nimmt sie (fahrlässig) als gegeben hin. Man mag einwenden, es sei doch auch nicht ihre Aufgabe, darüber zu befinden, ob das anthropogene CO2zu höheren Temperaturen auf der Erde führt und daher das gegenwärtige Klima zu „schützen“ ist. Gewiss, das soll sie nicht und kann sie nicht. Aber andere können das: Naturwissenschaftler. Das Wenigste aber, was auch die Mitglieder der Monopolkommission in den vielen Jahren mitbekommen haben müssen, ist, dass diese CO2-Erwärmungsthese wissenschaftlich alles andere als einhellig geteilt wird, nicht bewiesen und damit zumindest umstritten ist.***) Was bestritten ist, ist nicht unumstößlich belegt. Was nicht belegt ist, darf nicht zu einer Politik werden, die ruinöse Folgen hat.

Worauf die Monopolkommission wenigstens hinweisen müsste

Wenn sie das also wissen und sich zusätzlich kundig machen können, dann müssen sie sich – gerade weil sie Ökonomen und Unternehmensführer sind – klarmachen können, dass man auf unbewiesene, umstrittene Thesen keine so leichtsinnige, folgenschwere und super-teure Politik wie die der Energiewende aufbauen darf. Und würden sie sich zusätzlich kundig machen, dann würden sie sogar darauf stoßen, dass dieses Ökostrom-Trara sehr wahrscheinlich aus ganz anderen Gründen stattfindet, als die Erde vor (vorgeblich) anthropogener Erwärmung zu schützen. Die Monopolkommission hätte also Grund und Verpflichtung genug, auf diesen Leichtsinn und diese Folgenschwere wenigstens hinzuweisen und so die Fragwürdigkeit der Energiewende öffentlich zu machen. Auf gute und unwiderlegliche Gründe gegen den Strom aus „erneuerbaren“ Energien (EE-Strom) kann sie sich dabei berufen, vor allem auf diese:

Die fünf naturgesetzlich bedingten Hauptmängel der Energiewende

1. Wind und Sonnenlicht haben eine viel zu geringe Energiedichte. Das heißt: Um sie zu nutzen, ist zwangsläufig ein riesiger Flächenbedarf nötig mit zigtausenden Windkraft- und Fotovoltaik-Anlagen. Das gilt ebenso für den Energiepflanzenanbau zur Herstellung von „Biogas“. (Näheres zur Energie- oder Leistungsdichte hier).

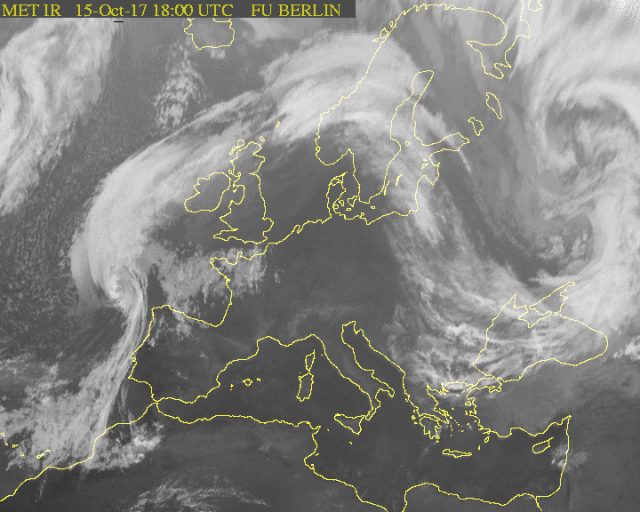

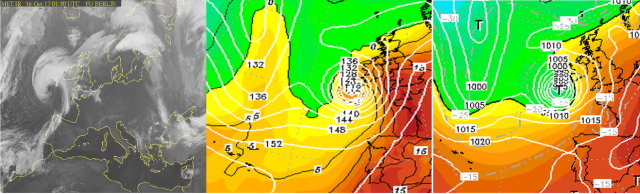

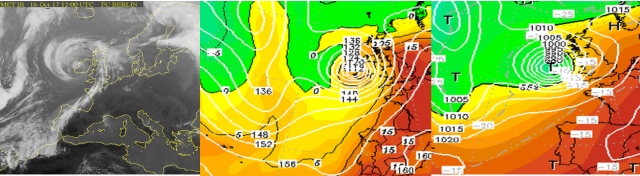

2. EE-Strom ist unzuverlässig. Denn Wind und Sonne scheinen, wann sie wollen, und nicht, wann sie sollen. Sie erzeugen daher nur wetterabhängigen Zufallsstrom, auch Wackelstrom genannt. Daran ändert sich auch dann nichts, wenn immer mehr EE-Anlagen in Betrieb gehen. Sie sind ebenso unsicher sind wie weniger Anlagen Denn es gibt Wetterlagen, in denen alle Anlagen überhaupt keinen Strom erzeugen, unabhängig davon, wieviele es sind. Denn 26 500 Anlagen liefern bei Windstille genauso wenig Strom wie 170 000, nämlich Null. Das Gleiche gilt für Solaranlagen mit ihrem Strom aus Sonnenschein. Wasserkraft lieferte 2016 nur 3,3 Prozent des Bruttostroms, und ein weiterer Ausbau ist in Deutschland nicht möglich.

3. Wetterabhängiger Zufallsstrom bedeutet schlechte Regelbarkeit. Dadurch kann man mit ihm die erforderliche Netzstabilität nicht sicherstellen – im Gegensatz zu Kohle-, Gas- und Kernkraftwerken. Nur diese drei Letztgenannten vermögen es, die Soll-Netzfrequenz von 50 Hertz stabil zu halten. Schon bei einer Abweichung von 0,2 Hertz von der Sollfrequenz besteht die Stromausfall-Gefahr, kann es zappenduster werden. Daher ist Zufallsstrom nicht grundlastfähig, also nicht in der Lage, den jeweiligen Strombedarf jederzeit sicherzustellen.

4. Der Nutzungsgrad von EE-Strom ist zu gering. Bei Windkraftanlagen liegt er bei knapp 20 Prozent ihrer Nennleistung, bei Solaranlagen (Fotovoltaik) um 10 Prozent. Das heißt: Diese „Stromfabriken“ stehen zwischen 80 und 90 Prozent der Zeit eines Jahres still. Das ist Verschwendung pur.

5. Strom ist in der nötigen Größenordnung nicht direkt speicherbar. Was die Verbraucher an Strom gerade abfordern, muss sekundengenau in der gleichen Menge auch erzeugt werden. Oder umgekehrt formuliert: Strom muss, sowie erzeugt, auch sofort verbraucht werden – innerhalb einer Zehntel Sekunde. Wenn Wind und Sonne mehr Strom erzeugen, als gerade benötigt wird und der Überschuss nicht im Ausland unterzubringen ist, müssen die EE-Anlagen abgestellt werden. Technische Tricks, diesen Strom indirekt zu speichern, indem man die elektrische Energie zum Beispiel in gasförmige Energie (Methan) umwandelt (Power-to-Gas-Verfahren), haben einen extrem schlechten Wirkungsgrad, bei dem drei Viertel der Energie verloren gehen. Sie sind daher unglaublich teuer, also sehr unwirtschaftlich. Rein technisch ist zwar vieles möglich, aber nicht alles technisch Mögliche ist auch sinnvoll und bezahlbar.

Für die Stromverbraucher ist das Gutachten letztlich so gut wie wertlos

Diese fünf Mängel sind naturgesetzlich bedingt. Sie hängen dem EE-Strom unausweichlich und unwiderleglich an wie ein schwerer Klotz. Es sind daher inhärente Mängel. Schon sie allein genügen, um von der Stromerzeugung mittels Wind und Sonne die Finger zu lassen. Trotzdem tun Bundesregierung, Politiker aller Altparteien und die Profiteure der Energiewende-Politik so, als gäbe es diese Naturgesetzlichkeit nicht. An dieser Missachtung wird die Energiewende letztlich auch scheitern. Aber erst nach horrenden Kosten für Bürger, Unternehmen und Volkswirtschaft. Da dies die Folge des zerstörten Wettbewerbs in der Stromerzeugung ist, ist das Sondergutachten für Stromverbraucher letztlich so gut wie nichts wert.

____________________________________________________________________________

*) „Die Monopolkommission besteht aus fünf Mitgliedern, die über besondere volkswirtschaftliche, betriebswirtschaftliche, sozialpolitische, technologische oder wirtschaftsrechtliche Kenntnisse und Erfahrungen verfügen müssen.“ (hier). Beraten soll sie Bundesregierung und Gesetzgeber zur Wettbewerbspolitik, zum Wettbewerbsrecht und zur staatlichen Regulierung. Im Wesentlichen geht es darum zu beobachten und zu untersuchen, wie es um den Wettbewerb bestellt ist, und zur Wettbewerbsentwicklung Stellung zu nehmen.

**) Sondergutachten 77: Energie 2017: Gezielt vorgehen, Stückwerk vermeiden (hier). Es ist das sechste zum Energiemarkt und 154 Seiten lang. Der volle Text des Sondergutachtens hier. Die gesetzliche Grundlage ist Paragraph 62 des Energiewirtschaftsgesetzes.

***) Kritisch zur Energiewende und Klimaschutzpolitik Stellung bezogen hat als einzige deutsche Partei die AfD: „Die Untersuchungen einiger Institute zur langfristigen Entwicklung des Klimas aufgrund menschlicher CO2-Emissionen sind sehr unsicherheitsbehaftet, teilweise widerlegt und beruhen nur auf Computer-Modellen. Das Klima hat sich in der Erdgeschichte stets, also auch vor der Industrialisierung und ohne menschlichen Einfluss verändert. Die AfD tritt dafür ein, die Klimaforschung, soweit sie lediglich auf Computer-Modellen basiert und nicht ergebnisoffen betrieben wird, nicht weiter zu fördern und die einseitige Darstellung des anthropogenen CO2 als vermeintliche Ursache von befürchteter Klimaerwärmung aufzugeben.“ (Aus dem Wahlprogramm der AfD Schleswig-Holstein). Ähnlich formuliert ist es im Grundsatz- und Wahlprogramm der AfD-Bundespartei.

Übernommen vom Blog des Autors hier