Deutschland erwärmt sich schneller als der Rest der Welt – oder etwa doch nicht ?

Vorbereitet ist man dort bereits: [5] PIK Pressemitteilung vom 13.10.2017: Hunderte Millionen Menschen werden innerhalb weniger Jahrzehnte von den Auswirkungen des Klimawandels auf Gesundheit und Migration betroffen sein – beide Bereiche wurden bislang zu wenig im Zusammenhang mit der menschgemachten Erwärmung gesehen.

Und vor allem ist die Leitung des PIK auch guten Mutes, wie Herr Schellnhuber anlässlich der Impacts World Conference und dem zur gleichen Zeit stattfindenden, 25-jährigem PIK-Jubiläum sagte: [5] „ … Es gab viele Tage in meinem Leben, an denen ich dachte, dass alles verloren ist“, sagte Schellnhuber „Aber nach dieser Jubiläumsfeier und den wunderbaren Beiträgen von Freunden und Verbündeten weiß ich, dass wir die Welt retten werden …“

Wer die Suche nach Alarmen im Wettergeschehen verfolgen will, braucht nur bei KLIMARETTER.INFO hineinzusehen, wo aktuell gezeigt wird, wie man es macht, „ … ein „Gefühl der Dringlichkeit“ schaffen zu wollen … „, indem wie so oft, zum Beispiel fabulöse Erzählungen „betroffener“ Staaten als Belege präsentiert werden.

Sollte bis zu deren Zusammentreffen beim Klimagipfel in Bonn die Partei mit dem Anspruch von Frau Göring-Eckhardt: … eine Regierung mit Grün sei notwendig für „die Menschheit und den Planeten“,

das Umweltministerium „besetzen“, wird im November in Bonn jeder Staat, dessen Repräsentant*in das Wort „Klimawandel“ oder „vulnerabel“ aussprechen oder zu Protokoll bringen kann, Gehör und Geld von uns finden. Im Grunde nicht weiter schlimm, denn unter Frau Hendricks war es bisher auch nicht anders.

Alarmmeldungen, um abzulenken

Zurück zum eigentlichen Thema. Dieses Jahr 2017 war bisher im Witterungsverhalten bei uns recht unspektakulär. Allerdings – das eine oder andere etwas nicht ganz alltägliche Ereignis wie Sturm XAVIER zeigte, wie verrottet und daher anfällig Deutschlands Infrastruktur bereits ist [4] – weshalb zum Beispiel die Bahn bei diesem Sturm vorsichtshalber sehr weitflächig auch gar nicht davon betroffene Strecken „sperrte“ [3]. Da Kommunikation zum Kunden der Bahn weiterhin ein Gräuel ist, wurde dies den betroffenen Reisenden nicht, beziehungsweise erst lange Zeit danach mitgeteilt [2].

Das Jahr 2016 mit einer relativ hohen Jahresmittel-Temperatur in Deutschland wurde von einem Vertreter des DWD jedoch dreist dazu verwendet einen „Klimawandel-Rekord“ zu erzeugen [6] – weil er sicher sein konnte, in unseren Medien keinen Kritiker fürchten zu müssen und fachliche Reputation in diesem Umfeld nebensächlich geworden ist.

Die Deutschlandtemperatur im Vergleich zum Rest der Welt

Wer erinnert sich zum Beispiel noch an die folgende Schreckensmeldungen vom letzten Jahr?

wetter.de 09. März 2016: Klimawandel: Deutschland erwärmt sich schneller als der Rest der Welt

Deutschland ist von der Erderwärmung voll betroffen. Die Temperaturen steigen bei uns schneller als im globalen Durchschnitt. Das geht aus Daten hervor, die der Deutsche Wetterdienst (DWD) in Berlin vorstellte.

… Seit 1881 hat sich Deutschland demnach um 1,4 Grad erwärmt, International habe der Wert seitdem bei etwas unter einem Grad gelegen, wie DWD-Experte Thomas Deutschländer erklärte … Die Mitteltemperatur der vergangenen 25 Jahre lag demnach hierzulande mit 9,2 Grad genau 1 Grad über dem Wert der internationalen Referenzperiode von 1961 bis 1990. 2015 hatte es mit 40,3 Grad in Kitzingen auch einen neuen Hitzerekord für Deutschland gegeben.

„Das ist erlebter Klimawandel“, so Deutschländer. Dem Meteorologen zufolge waren 23 dieser 25 Jahre zu warm. Dazu beigetragen habe auch das vergangene Jahr – es war zusammen mit 2000 und 2007 das zweitwärmste seit Beginn der Messreihe.

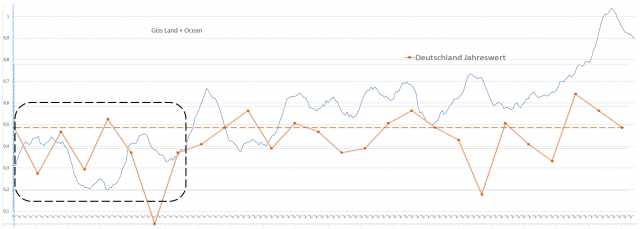

Demgegenüber: Das kommt heraus, wenn man nicht den (bewussten) Fehler des DWD – (Medien-) Experten macht

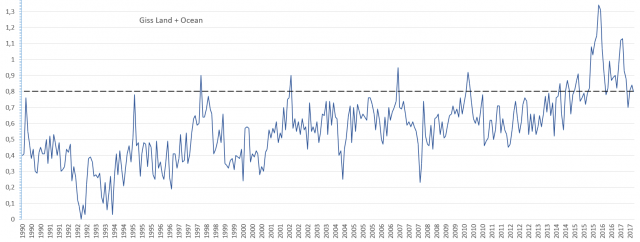

Als „den Rest der Welt“ darf man sicher den ganzen Globus betrachten. Dafür zuständig ist eine der offiziellen Temperaturreihen, zum Beispiel die der Nasa, GISS, Reihe „Land + Ocean“.

Nun ist es für jeden naturwissenschaftlich Interessierten wohl einleuchtend, dass in einem relativ kleinen Klima- und Wetter-Areal wie Deutschland ein Witterungs-Element wie die Temperatur von Jahr zu Jahr eine deutlich größere Variabilität und Streuung um den Mittelwert aufweist als der globale Mittelwert des gesamten Globus. Niemals würde ein seriöser Fachmann deshalb die Spanne der Absoluttemperatur Deutschlands mit der des gesamten Globus direkt vergleichen, sondern er würde zur Trendbetrachtung die Verhältnisse selbstverständlich erst relativieren.

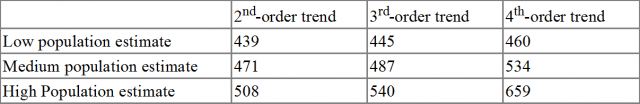

Führt man dies durch, dann zeigen sich seit 1881 (Beginn der GISS Datenreihe und „angeblich anthropogener Klimawandelbeginn“) die in den folgenden Grafiken gezeigten Verläufe. Ein Hinweis: Die Spanne der Deutschlandtemperaturen wurde zur GISS-Datenreihe intuitiv relativiert. Bereits dies reicht aus, um eindeutige, relative Verlaufsbilder zu gewinnen.

Ganz einfach lässt sich so feststellen, dass Deutschland seit ca. 1881 im Vergleich bei Weitem nicht so warm wurde, wie der gesamte Globus. Alleine damit wäre jeder (nur nicht die Redakteure unserer Medien) schon in der Lage, dem Experten des DWD die richtige Rückantwort zu seiner falschen Aussage zu geben.

Bild 1 GISS Globaltemperatur 1880 – 2017 (gleitendes Jahresmittel, blau) und Deutschland DWD Jahreswerte (rot) übereinander gelegt (mit Anpassung an den Anfangs- bis Mittelteil des Zeitraums). Temperaturachse der Deutschlandwerte nicht mit den GISS-Werten übereinstimmend. Grafik vom Autor erstellt

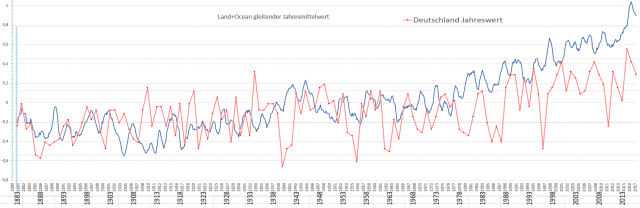

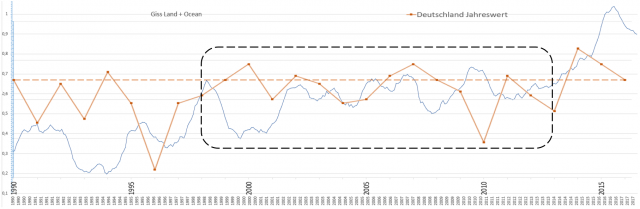

Nimmt man die Werte seit dem Jahr 1990, zeigt es sich ebenfalls (Bild 2 und vor allem Bild 3). Auch die letzten Jahrzehnte „hinkt“ die Temperatur Deutschlands der Welt-Globaltemperatur deutlich hinterher. Da beide Temperaturverläufe in diesem Zeitraum schlecht korrelieren, kann man den Startwert unterschiedlich anlegen (Bereiche gestrichelt eingerahmt), am Ergebnis ändert es nichts.

Bild 2 GISS Globaltemperatur 1990 – 2017 (gleitendes Jahresmittel, blau) und Deutschland DWD Jahreswerte (braun) übereinander gelegt (mit Anpassung an den Mittelteil des Zeitraums). Temperaturachse der Deutschlandwerte nicht mit den GISS-Werten übereinstimmend. Grafik vom Autor erstellt

Bild 3 GISS Globaltemperatur 1990 – 2017 (gleitendes Jahresmittel, blau) und Deutschland DWD Jahreswerte (braun) übereinander gelegt (Anpassung an den Beginn des Zeitraums). Temperaturachse der Deutschlandwerte nicht mit den GISS-Werten übereinstimmend. Grafik vom Autor erstellt

Fazit

Der Autor bezweifelt anhand seiner hier dargestellten Auswertung, dass sich Deutschland schneller als der Rest der Welt erwärmt. Die Aussage des DWD-Meteorologen hält er schlichtweg für falsch.

Das kann passieren, den Meteorologen wissen anscheinend über das Klima nicht bescheid, wie es Herr Kachelmann als Meteorologe kürzlich erst in einer Talkshow freimütig berichtete [8]. Nur: Warum macht dann jemand, der anscheinend wenig Ahnung zum Thema hat, sich um sie zu bekommen aber auch nicht die kleine Mühe macht, die Daten zu vergleichen, Aussagen dazu?

DWD und Harald Lesch, im Klima-Alarmismus vereint

Die GISS Jahreswerte werden von Klimaalarmisten gerne gezeigt, um die „Überhitzung“ der Welt zu demonstrieren. Prof. H. Lesch, welcher gerne über den Klima-Weltuntergang referiert [9][10][11, machte es zum Beispiel in einem seiner vielen Videos, wie dem, worin er (angeblich) die kritischen AfD-Angaben zum AGW-Klimawandel „zerpflückt“ [7].

Man betrachte im Bild 4 den roten Punkt der globalen Maximaltemperatur. Süffisant und in seinem gewohnten, überheblichem Duktus, „beweist“ er damit die bereits erfolgte Überhitzung, welche wohl so weiter gehen soll.

Bild 4 [7] Moderator zerpflückt AfD-Programm und bekommt Hassmails. Videoscreenshot YouTube Harald Lesch Terra X Lesch & Co

Bild 5 NASA GISS Daten von Bild 4 in Monatsauflösung, Stand 9.2017. Grafik vom Autor anhand des Datensatzes erstellt.

Nur in der Hitzespitze liegt Deutschland (auch nur vielleicht) zeitlich vorn

Nachdem es im Artikel von wetter.de mit erwähnt wurde: [6] … 2015 hatte es mit 40,3 Grad in Kitzingen auch einen neuen Hitzerekord für Deutschland gegeben

Auch dazu eine Wiederholung. Dieser „deutsche Rekord“ bedeutet, dass seit der vorherigen Temperaturspitze im Jahr 1983 bis zur aktuellen im Jahr 2015, also nach 32 Jahren, die maximale, an einer DWD-Station gemessene Temperatur um 0,1 °C gestiegen sein könnte. Der Süddeutschen Zeitung war dieser lange Zeitraum für eine derart geringe Temperaturerhöhung damals so peinlich, dass sie in ihrer Meldung anstelle dem Jahr 1983 das Jahr 2003 angab [1].

Dabei handelt es sich bei dieser Differenztemperatur-Messung nicht um die gleiche Station, bei der man eine Mess-Ähnlichkeit vermuten dürfte, sondern um zwei weit voneinander entfernte. Nachdem eine moderne, automatische DWD-Messstelle bei guter Eichung eine Genauigkeit von +-0,2 Grad aufweist, ist zwischen zwei solchen Stationen eine Differenz von 0,1 Grad (richtiger: Kelvin) definitiv nicht messbar. Anzeigbar natürlich schon, aber messtechnisch niemals signifikant zu unterscheiden.

Das weiß sicher auch der DWD. Aber wie beim ersten Beispiel „Deutschlandtemperatur im Vergleich zum Rest der Welt“ bereits gezeigt, achtet dieser Dienst darauf, aus dem Wetter Ergebnisse abzuleiten, welche die Politik „erwartet“.

Dazu ist auch noch die „Genauigkeit“ gerade der Station der letzten Maximalwertmessung unsicher, denn der Standort Kitzingen ist (wie so viele andere Standorte auch) nicht wärmeinselfrei. Ein ausgewiesener Klimaforscher der Uni Würzburg plauderte es einer Lokalzeitung gegenüber aus:

Mainpost 07. September 2016, Prof. Paeth (Klimaforscher), Uni Würzburg: [12] … Schließlich, sagt Paeth, gebe es noch einen Spezialeffekt. „Wir haben in Deutschland häufig Westwindlagen“ – auch in Kitzingen komme die kühlende Frischluft hauptsächlich von Westen. Genau im Westen der Stadt habe aber seinerzeit die Wehrmacht eine große Kaserne errichtet. 61 Jahre lang war das Gelände dann amerikanische Garnison, heute ist es ein Gewerbepark. Ein Hindernis für die Luftzufuhr blieb es. Die Stadt habe sich ihre Frischluftschneise zugebaut, konstatiert Paeth. „Für die Hitze könnte das eine Erklärung sein.“

Doch selbst, falls alles richtig wäre, was der DWD über die deutsche Maximaltemperatur berichtet, hätte sich damit

die Welt bezüglich der (von seit längerer Zeit installierten Wetterstationen) gemeldeten Spitzentemperaturen kaum verändert:

– Seit 103 Jahren ist es global nicht mehr heißer geworden

– Seit 74 Jahren hat sich an der globalen Grenztemperatur überhaupt nichts verändert

– In den letzten 32 Jahren ist es in Deutschland nicht heißer geworden (alternativ um nicht messbare +0,1 °C)

– würde man die „verworfenen“, älteren Messungen mit einbeziehen, wären die Spitzentemperaturen früher weit wärmer gewesen als aktuell.

Mehr Details dazu lassen sich im folgenden Artikel nachlesen:

EIKE 30.07.2016: Weltweiter Temperaturrekord gemessen?

Der „Extremwerte-Wettbewerb“ ist gnadenlos …

So wie man in Religionen regelmäßig neue Wunder benötigt, um „im Geschäft“ zu bleiben und unter der Konkurrenz zu bestehen, benötigt der AGW-Klimawandel immer neue Extreme.

Zu welchen Auswüchsen dies nicht nur in Deutschland führt, macht gerade Australien vor. Um höhere Temperaturspitzen zu messen, wurde (und wird) dort nicht nach internationaler Regel gemittelt, sondern fälschlich Kurzzeitwerte verwendet, nachzulesen unter:

WUWT October 19, 2017: In Australia, faulty BoM temperature sensors contribute to “hottest year ever”

… Die Lösungen ebenfalls

Dazu passt eine weitere Meldung, welche zeigt, wie konsequent dort gehandelt wird, wenn die (falsch gemessene Spitzentemperatur) von der Politik „zugelassene“ Werte überschreitet. Ein Vorbild für Deutschland und Beleg, dass diese Industrie jederzeit dem „Klimaschutz“ weichen kann*, da sie selbst für einen Kontinent nicht wirklich erforderlich ist:

dw.com – Freitag, 20. Oktober 2017: Australiens letztes Autowerk macht dicht

*Klarstellung: Die Schließung des letzten, australischen Autowerkes hat in Wirklichkeit mit dem Klima nichts zu tun.

Quellen

[1] EIKE 24.09.2016: Die heißeste Temperatur Deutschlands war nur ein Wärmeinseleffekt: Ein Klimaprofessor plaudert aus seinem „Nähkästchen für Temperatur“

[2] Achgut, 06.10.2017: Sturmchaos? Nein, Totalversagen bei der Bahn

[3] Wetterkanal 8. Oktober 2017: Sturm Xavier – wie Medien Menschen auf dem Gewissen haben: Nichtstun tötet

[4] EIKE 14.06.2017: Fake News: Diesmal Pfingstunwetter um Hildesheim – neue Einschläge des Klimawandels?

[5] PIK Pressemitteilung 13.10.2017: „Wir brauchen Sie“: UN Klima-Chefin zu Potsdamer Klimaforschern

[6] wetter.de 09. März 2016: Klimawandel: Deutschland erwärmt sich schneller als der Rest der Welt

[7] YouTube Harald Lesch Terra X Lesch & Co Moderator zerpflückt AfD-Programm und bekommt Hassmails.

[8] EIKE 20. Oktober 2017: „Kippt unser Klima ?“ bei Maischberger/ARD am 10. Oktober 2017: Eine kleine Nachlese über großen Unsinn, sachliche Fehler und wenig Richtiges

[9] EIKE 01.01.2017: Harald Lesch trägt vor den GRÜNEN zum Klimawandel vor: Der Klimawandel ist kein Thema, das man ernsthaft bezweifeln kann

[10] EIKE 27.12.2016: Harald Lesch, die Claudia Roth des Klimawandels: Glaubt einfach, was ich erzähle – Nachprüfen schadet nur!

[11] EIKE 24.08.2016: Wenn der Hopfen nicht stirbt, stirbt dann der Klimawandel?

[12] MAINPOST, 07. September 2016: Kitzingen stellt erneut Hitzerekord auf dpa