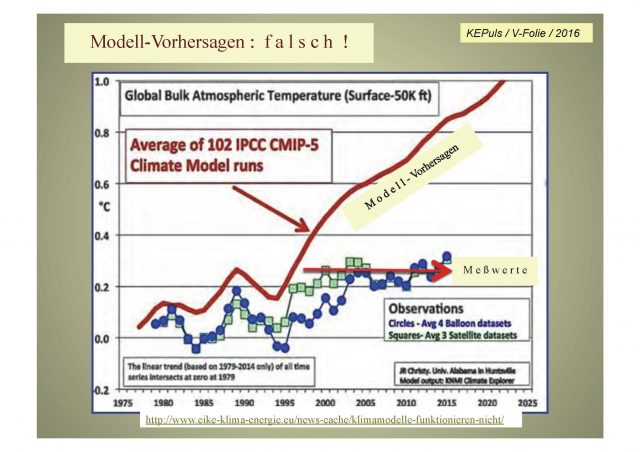

Es ist schlimmer als gedacht: Erwärmung geringer als prophezeit

In der Klimadebatte jedoch ist es immer erhellend, das Kleingedruckte zu lesen. Es ist unüblich, dass die offizielle Klimatologie ihre zahlreichen Fehler und Irrtümer einräumt. Stattdessen wird uns verordnet, dem „Konsens“ zu gehorchen, mit welcher Bezeichnung die Parteilinie heutzutage daherkommt. Nach der Lektüre der Schlagzeilen kam mir sofort der Verdacht, dass das wirkliche Ziel der jüngsten Eingeständnisse die Minimierung und folglich die Verschleierung der wahren Größenordnung der Über-Prophezeiungen der Vergangenheit ist. Die Studie stammt von Millar et al. und ist in der jüngsten Ausgabe von Nature Geo“science” veröffentlicht.

Die Daily Mail berichtete folgendermaßen über die jüngsten Ergebnisse:

„Die Forschungen britischer Wissenschaftler zeigen, dass den alten Projektionen zufolge die Welt derzeit 1,3°C wärmer sein sollte als das Mittel zur Mitte des 19. Jahrhunderts. Die neue Analyse zeigt nun aber, dass es lediglich 0,9°C bis 1,0°C wärmer geworden ist. Michael Grubb, Professor für internationale Energie [?] und Klimawandel am University College London gab zu, dass die alten Projektionen falsch waren“.

Es gab seit 1850 lediglich eine Erwärmung um 0,85°C, ermittelt mit einer linearen Regression kleinster Quadrate des Trends in den monatlichen HadCRUT4-Daten. Diese nicht wirklich aufregende Rate ist äquivalent mit etwa einem halben Grad pro Jahrhundert. Unterzieht man diesen Teil des Statements von Grubb dem Faktencheck, zeigt sich, dass seine beobachtete Erwärmung um 0,9°C bis 1,0°C auf der hohen Seite liegt, aber nicht um sehr viel.

Wie wir sehen werden, hat die Millar-Studie die Erwärmung erheblich unterschätzt, die prophezeit worden wäre, und zwar mit der Aussage darin, dass die offizielle Klimatologie lediglich 1,3°C globale Erwärmung seit 1850 prophezeien würde. Nicht zufällig gibt es in der jüngsten Ausgabe von Nature Geovoodoo [!] auch eine kurze Studie von Gunnar Myhre, welcher mit einem Vergleich von drei Klimamodellen im Jahre 1998 zu dem Ergebnis gekommen war, dass der CO2-Antrieb zuvor um 15% überschätzt worden ist. Aus Myhres jüngster Studie:

„Der kombinierte Strahlungsantrieb aller gut durchmischten Treibhausgase (der non-consensers [?]), besonders CO2, Methan, Stickoxid und Spuren von Kohlenwasserstoffen) betrug 3,1 W/m² Strahlungsantrieb…“, und nahezu alles dieses Antriebs ereignete sich seit 1850.

Um zu bestimmen, eine wie starke globale Erwärmung die offizielle Klimatologie als Reaktion auf einen Strahlungsantrieb von 3,1 W/m² prophezeien würde, sollten wir das offizielle „Null-Dimensions-Modell“ heranziehen [zero-dimension-model]. Die Gleichung dieses Modells ist verblüffend einfach. Darin stehen w, W jeweils als prä- und post-feedback globaler Erwärmung (d. h. „Referenz-Sensitivität“ und „Gleichgewichts-Sensitivität“) und f als Feedback-Faktor:

Und kann man gut und gerne aufgeschreckt – ja tatsächlich schockiert – sein, dass die Gleichung der offiziellen Klimatologie herangezogen wird, um uns zu sagen, wie viel Erwärmung es geben würde, derartig einfach ist. Warum zahlen wir Milliarden pro Jahr an das IPCC, wenn sich alles auf diese sinnfreie Gleichung reduziert? Nichtsdestotrotz möchte ich sie hier betrachten, um zu demonstrieren, dass – so naïv und falsch wie sie ist – sie tatsächlich das ist, was die Klimatologie derzeit heranzieht.

Verwendet man als Input die offiziellen Werte für w, f, spuckt die Gleichung pflichtgemäß die offiziellen Prophezeiungen der Gleichgewichts-Sensitivität W aus. Indem sie sich auf das IPCC (2013) für die offizielle Diagnose der globalen Erwärmung stützen, prophezeit von der jüngsten Generation von Computermodellen, sagen Vial et al. 2013, dass etwa 85% der Unsicherheit in der Gleichgewichts-Sensitivität W aus der Unsicherheit in der Feedback-Summe c resultiert, was der offiziellen Art und Weise nach, mit der alles durchgeführt wird, einfach gleich ist mit c geteilt durch 3,2 K pro Watt pro Quadratmeter.

In Wirklichkeit haben Feedbacks nur einen geringen Einfluss auf Erwärmung, wie wir demnächst demonstrieren zu können hoffen, so dass die einzige Unsicherheit die Größenordnung des Antriebs ist. Aber unsere Studie mit dem Nachweis dieses Tatbestands wartet immer noch die Kommentare der Begutachter, welche seit nunmehr drei Wochen überfällig sind. Daher sollten wir es vorerst einfach noch der offiziellen Weise nach machen, obwohl dies unerhört im Widerspruch zur Mainstream-Wissenschaft steht – und zu Experimenten, die wir einem Regierungs-Laboratorium in Auftrag gegeben haben und die in allen Einzelheiten bestätigt haben, dass wir die Mainstream-Wissenschaft richtig verstanden haben und die offizielle Klimawissenschaft nicht.

Folglich geht die Kalibrierung der Gleichung des Null-Dimensions-Modells weiter. Das IPCC (2013, Abb. 9.43) verweist auf Vial et al. 2013, der offiziell die Feedback-Summe c diagnostiziert hat aus einer simulierten abrupten Vervierfachung der CO2-Konzentration in 11 Modellen der 5. Generation. Der Mittelwert für c der 11 Modelle beträgt 1,57 W/m²K, was eine Schätzung der mittleren Bandbreite von 0,49 für f impliziert. Vial gab auch die 2 σ-Grenzen von f an als mid-range estimate von ± 40%. d.h. 0.49 ± 0.20; und der implizite CO2-Antrieb unter atypischem Einschluss schneller Feedbacks betrug 4,5 W/m².

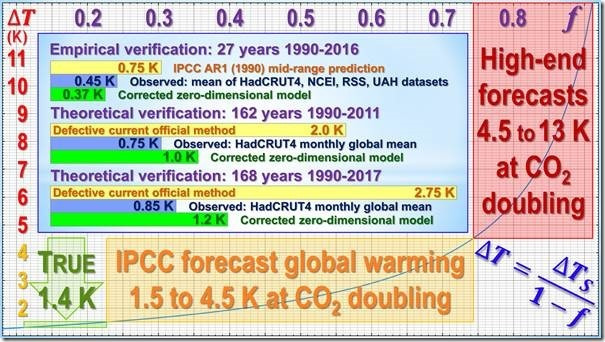

Die direkte Erwärmung w bei einer CO2-Verdoppelung bei Vial beträgt folglich 4,5 / 3,2 = 1,41°C, liegt also etwa um 20% über dem vom IPCC angeführten Wert von 1,16°C. Mit f = 0,49 und w = 1,41°C ergibt die Gleichung des Null-Dimensions-Modells ein Intervall von Gleichgewichts-Sensitivitäten W von 2,0 bis 4,5°C als Reaktion auf eine Verdoppelung des CO2, wie in der folgenden Tabelle fett gedruckt dargestellt. Da die Werte der Gleichung aus offiziellen Inputs stammen und fast perfekt inhaltsgleich mit vielen offiziellen Intervallen sind, ist die Gleichung ordnungsgemäß kalibriert. Ob man es mag oder nicht (man sollte nicht!) – dies ist das, was die Kräfte der Dunkelheit verwenden.

Die einzige Diskrepanz liegt in der zentralen Schätzung der globalen Erwärmung post-feedback, wo das Null-Dimensions-Modell 2,8 K prophezeit und die veröffentlichten offiziellen Schätzungen 3,3 K prophezeien.

Zu der Diskrepanz kommt es, weil die offizielle Klimatologie manchmal vergisst, dass die Kurve der Gleichung des Null-Dimensions-Modells keine gerade Linie, sondern eine rechteckige Hyperbel [rectangular hyperbola] ist (siehe oben). Verwendet man die offizielle Bandbreite des IPCC von 3,0 (1,5;4,5)°C als die prophezeite Gleichgewichts-Sensitivität bei einer CO2-Verdoppelung, impliziert eine mid-range-Schätzung f = 0,49 für den Feedback-Faktor eine mid-range-Schätzung von 2,25°C für die post-feedback globale Erwärmung, nicht die den Vorstellungen des IPCC folgenden 3°C und vor allem weniger als die 3,3°C mid-range-Projektion der CMIP5-Modelle.

Man kann daher die implizite mid-range-Schätzung der post-feedback-Erwärmung in den Modellen der 5. Generation bestimmen mittels Verwendung der Gleichung des Null-Dimensions-Modells. Ist die direkte oder pre-feedback-Erwärmung w als Reaktion auf eine Verdoppelung der CO2-Konzentration 1,16 K und die post-feedback-Erwärmung W wie von den CMIP5-Modellen prophezeit 3,3 K, ist der in dieser Prophezeiung implizit enthaltene Feedack-Faktor 1 – (1.16 / 3.3) = 0.65.

Jetzt haben wir genug Informationen, um die globale Erwärmung zu ermitteln, welche die CMIP5-Modelle prophezeien würden als Reaktion auf einen Strahlungsantrieb von den 3,1 W/m² aus allen anthropogenen Quellen, welche Myhre 2017 zufolge seit etwa 1850 im Gange ist. Die direkte Erwärmung beträgt einfach 3,1/3,2 oder etwa 1°C. Zieht man jetzt die inzwischen kalibrierte, aber verworfene [dump] offizielle Gleichung des Null-Dimensions-Modells heran wie oben beschrieben, beträgt die post-feedback-Erwärmung, welche die CMIP5-Modelle seit 1850 prophezeit hätten, 1 / (1 – 0.65) oder 2.75 C°, wäre also mehr als doppelt so hoch wie die in der Millar-Studie erwähnten 1,3°C und über dreimal so hoch wie die tatsächlich eingetretene Erwärmung von 0,85°C.

Zum Vergleich, unsere korrigierte Version der Gleichung des Null-Dimensions-Modells würde 1,2°C Erwärmung prophezeit haben als Reaktion auf 3,1 W/m² anthropogenen Antriebs seit 1850, was weit näher an den 0,85°C liegt, die tatsächlich gemessen worden sind, als der Wert der offiziellen Klimatologie von 2,75 K.

Man kann eine ähnliche Analyse durchführen auf der Grundlage der Aussage vom IPCC 2013, dass es einen anthropogenen Strahlungsantrieb von 2,3 W/m² seit vorindustrieller Zeit gegeben habe, was eine Erwärmung um 2,05°C bis heute impliziert oder fast dreimal der Wert von 0,75°C von 1850 bis 2011 aus dem HadCRUT4-Datensatz. Unsere Gleichung hätte 1,0°C prophezeit, was erneut weit näher an der beobachteten Realität liegt als die offizielle Gleichung prophezeit hätte.

Oder man könnte die zentrale Prophezeiung des IPCC aus dem Jahr 1990, der zufolge es während der 36 Jahre von 1990 bis 2025 eine Erwärmung um 1°C gegeben habe (äquivalent zu 0,75°C während der 27 Jahre von 1990 bis 2016), vergleichen mit der tatsächlichen Erwärmung von 0,45°C während dieses Zeitraumes, gewonnen aus dem Mittel von zwei terrestrischen und zwei Satelliten-Datensätzen. Erneut zeigt sich, dass die unseriös erstellte offizielle Prophezeiung eine substantielle Übertreibung ist im Vergleich mit dem beobachteten Ergebnis, aber unsere korrigierten Modelle kommen der Wahrheit viel näher, zeigen diese doch eine Erwärmung um 0,37°C, was weit näher an den gemessenen 0,45°C liegt als die vom IPCC prophezeiten 0,75°C.

Professor Myles Allen von der Oxford-University wird von der Daily Mail mit den Worten zitiert, dass falls die Welt den „ambitionierten“ Reduktionen der CO2-Emissionen folgen würde, man nicht einmal ansatzweise der unwissenschaftlichen Festlegung des Paris-Abkommens nahekommen würde, den globalen Temperaturanstieg auf 1,5°C über den vorindustriellen Wert zu begrenzen, was äquivalent ist mit einem Wert, der um 0,65°C über dem derzeit gemessenen Wert liegt.

Allerdings wird die CO2-Konzentration den heutigen Trends folgend bis zum Jahr 2100 von 400 auf 650 ppmv steigen mit der Folge einer direkten Erwärmung von 0,8°C und einem weiteren Beitrag von 0,2°C durch Temperatur-Rückkopplungen. Das 1,5°C-Ziel wird also nicht einmal dann erreicht, wenn wir unsere Mainstream-Gleichung an Stelle der unbrauchbaren Gleichung der offiziellen Klimatologie verwenden.

Es sei denn, die Profs. Harde und Happer haben recht, dass der CO2-Antrieb ebenso wie die Rückkopplungen, auf die sich unsere Studie konzentriert, übertrieben ist. Prof. Harde hat geschätzt, dass er um 30% übertrieben ist; Prof. Happer kommt sogar zu 40% Übertreibung aus anderen Gründen, die sich nicht mit dem Ergebnis von Prof. Harde überlappen. Falls beide recht haben, hätte man den CO2-Antrieb um 82% überbewertet. Falls wir auch recht haben, würde die direkte Erwärmung in diesem Jahrhundert 0,45°C betragen mit einem Zusatzbeitrag von 0,1°C aufgrund der Rückkopplungen. Zwar gibt es noch andere Treibhausgase, doch werden diese durch negative anthropogene Antriebe genau ausgeglichen, so dass selbst ohne jede Bemühung zur Abschwächung [der Emissionen] das Paris-Ziel bis zum Jahr 2100 in Wirklichkeit auf jeden Fall erreicht werden würde. Und falls sich die Welt wirklich um über 0,65°C im Vergleich zu heute erwärmen würde, dies jedoch nicht bis nach dem Jahr 2100, wäre die Erwärmungsrate viel zu gering, um gefährlich zu sein. Es besteht einfach kein Bedarf für das UNFCCC oder das IPCC. Auf den Müll mit beiden!

Die offizielle Klimatologie hat ihre Prophezeiungen drastisch übertrieben. Ihre unqualifizierten Versuche, das wahre Ausmaß der Diskrepanz zwischen übertriebener Prophezeiung und der nicht aufregenden Beobachtungen zu verstecken wird scheitern. Diese Diskrepanz ist hauptsächlich Fehlern bei der Berücksichtigung von Rückkopplungen im Null-Dimensions-Modell und daraus folgend in den dreidimensionalen Modellen geschuldet, deren Outputs die einfache Gleichung gnädig reproduziert, was ihre Wirksamkeit als Blackbox-Diagnose zeigt. Korrektur der Fehler in der offiziellen Gleichung erzeugt Prophezeiungen, die weit weniger extrem und weit näher an der Beobachtung in der realen Welt daherkommen als die wilden Übertreibungen auf der Grundlage, auf der regierungsamtliche und internationale Gebilde bis heute so profitabel Panik erzeugt haben.

Obwohl die Millar-Studie das wahre Ausmaß der offiziellen Übertreibungen verschleiert, worauf Forderungen nach „Klima-Maßnahmen“ beruhen, stellt sie doch auf einer anderen Ebene einen frühen Riss im Damm dar, der zeigt, dass die gesamte Konstruktion des Unsinns drauf und dran ist zusammenzubrechen. Nur Mut! Die Wahrheit, dass die globale Erwärmung gering, harmlos und insgesamt vorteilhaft sein wird [so es sie überhaupt geben wird, Anm. d. Übers.] wird schon bald über die schreienden Extremisten triumphieren. Die Millar-Studie ist nicht der Anfang vom Ende, aber zumindest das Ende des Anfangs.

Link: https://wattsupwiththat.com/2017/09/26/its-worse-than-they-thought-warming-is-slower-than-predicted/

Übersetzt von Chris Frey EIKE