Ich kann mich noch gut daran erinnern, dass Freunde, die Geisteswissenschaften studiert hatten, schon in den 1980er Jahren leuchtende Augen bekamen, wenn die Rede auf erneuerbare Energien kam. Nach einer Elektrolehre und einem naturwissenschaftlichen Studienabschluss stand ich diesem Thema viel nüchterner gegenüber. Das Streben nach erneuerbarer Energie erschien mir, ähnlich wie die allesamt enttäuschenden Versuche, ein Perpetuum mobile zu bauen, als reines Wunschdenken, das an der harten Realität scheitern muss. Der Schöpfer hat uns vermutlich nicht den Gefallen tun wollen, so etwas möglich zu machen. Energie geht zwar nach heutigem Wissen im Universum nicht verloren. Lässt man sie jedoch Arbeit leisten, verwandelt sie sich von einer edlen, das heißt konzentrierten, in eine weniger edle, diffuse Form. Am Ende dieses von den Physikern so genannten dissipativen Prozesses steht Abwärme niedriger Temperatur, die keine Arbeit mehr leisten kann.

Im heutigen Sprachgebrauch bezieht sich der Begriff „erneuerbar“ auf Formen der Energie, die direkt oder indirekt auf die Fusionsenergie der Sonne zurückgehen. Dazu zählt also nicht nur die Photovoltaik, die mithilfe lichtsensibler Halbleiter eine direkte Umwandlung des Sonnenlichts in elektrische Spannung ermöglicht, sondern auch die Kraft des Windes und der Gebirgsflüsse sowie die in pflanzlicher Biomasse wie Holz, Biogas oder Kuhdung gespeicherte Energie. Ginge es nach dem „Klimaschutzplan 2050“ der deutschen Bundesregierung, dann müsste Deutschland bereits im Jahre 2050 nahezu vollständig „dekarbonisiert“ sein, das heißt ohne den Einsatz so genannter fossiler Energieträger auskommen müssen.

Zurück zum Mittelalter?

Hinter diesem Ziel verbirgt sich, wie sich leicht zeigen lässt, die Sehnsucht nach einer Rückkehr zu vorindustriellen, d.h. mittelalterlichen Verhältnissen. Denn vor der Erschließung fossiler Kohlevorräte in der industriellen Revolution mussten sich die Menschen mit den Energieträgern begnügen, die ihnen die Natur darbot. Mehr oder weniger primitive Wasserräder und Windmühlen waren vor der Erfindung der Dampfmaschine die einzig möglichen Maschinenantriebe. Für die Gebäudeheizung und das Salz-Sieden stand nur die Verbrennung von Holz beziehungsweise Holzkohle zur Verfügung. Kein Wunder, dass die Wälder West- und Mitteleuropas vor dem Beginn der industriellen Revolution infolge Jahrhunderte langer Übernutzung soweit heruntergekommen waren, dass sie kaum noch brauchbares Bauholz liefern konnten. Unsere Wälder verdanken ihre Regenration dem Übergang zur massiven Nutzung fossiler Kohle im 19. Jahrhundert. Die ausschließliche Nutzung „erneuerbarer“ Energiequellen (im Folgenden mit EE abgekürzt) war also schon zur Zeit der Renaissance alles andere als nachhaltig.

In etlichen armen Ländern Afrikas und Asiens ist das noch heute nicht viel anders. Weltweit decken EE zurzeit etwa 13,6 Prozent des Primärenergiebedarfs. In den als „Entwicklungsländer“ klassifizierten Ländern liegt dieser Anteil jedoch im Schnitt bei 72,8 Prozent, davon fast 90 Prozent Holz, Holzkohle und Dung. Wind-, Solar- und Gezeitenenergie decken zurzeit nur 0,81 Prozent des Weltenergiebedarfs. Getrocknete Kuhscheiße wiegt in der globalen Energiebilanz also noch immer viel schwerer als die Windenergie. Seit einigen Jahren setzen übrigens Politiker der wohlhabenden Länder des Westens alles daran, in Afrika den Bau von Kohle- und Gaskraftwerken zu hintertreiben, indem sie ihre „Entwicklungshilfe“ auf Wind- und Solarkraftwerke beschränken und arme Länder mit Handelsbeschränkungen bestrafen, sollten sie sich unterstehen, doch in Kohle- oder Gaskraftwerke zu investieren. Darauf hat schon vor Jahren Fiona Kobusingye, die Präsidentin der ugandischen Menschenrechtsorganisation CORE, hingewiesen. Kohle gibt es in Afrika fast überall. Die Vorräte würden nach heutigem Wissen für Jahrtausende reichen und sie ist im Unterschied zu Öl und Gas gefahrlos transportier- und lagerbar.

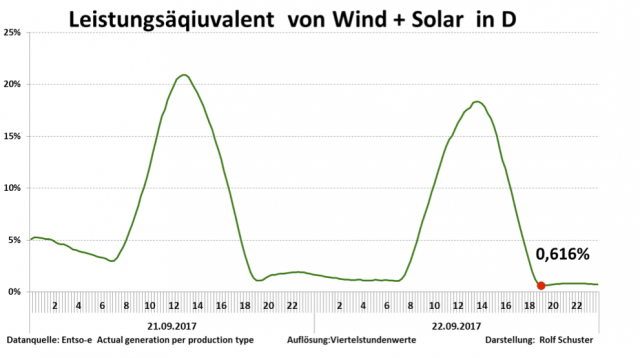

Zwar erreichen die über 27.000 deutschen Windkraftanlagen (WKA) inzwischen eine Leistung von 45 Gigawatt (wenn der Wind weht). Dennoch tragen sie nur mit 2,1 Prozent zur Deckung des gesamten deutschen Primärenergiebedarfs bei. Zusammen mit den installierten 1,6 Millionen Solaranlagen decken sie nur 3,1 Prozent des deutschen Primärenergiebedarfs. Der Anteil aller „Erneuerbaren“ am gesamten Energieverbrauch Deutschlands erreicht immerhin 12,6 Prozent. Der größte Teil davon entfällt allerdings auf Bio-Kraftstoff, der den Kfz-Treibstoffen E5 und E10 aufgrund einer gesetzlichen Vorschrift ungefragt beigemischt wird. Um bis 2050 auf einen EE-Anteil von fast 100 Prozent zu kommen, bedarf es aber wohl viel mehr als eines kleinen Wunders. Zumal dabei bislang nur der Stromsektor betrachtet wurde. Dieser macht aber nur etwa ein Fünftel der Primärenergieproduktion aus. Gebäudeheizung und Verkehr verschlingen viel mehr Energie.

Da Wind- und Solarenergie nur äußerst unregelmäßig verfügbar sind, steht und fällt die von Bundeskanzlerin Angela Merkel 2011 nach der Kernreaktor-Havarie von Fukushima ausgerufene „Energiewende“ mit der Möglichkeit, Energie zu speichern, um sie bei Dunkelheit oder Windstille bedarfsgerecht abrufen zu können. Die effizienteste technische Lösung dafür sind Pumpspeicher-Kraftwerke. Davon gibt es aber in Deutschland bislang nur ein großes in Thüringen und über 30 kleinere mit einem Gesamt-Speichervermögen von 0,038 Terawattstunden /TWh). Der bekannte Ökonom Hans-Werner Sinn hat vorgerechnet, dass man bei einem 50-Prozent-Anteil von Solar- und Windstrom bereits Speicherkapazitäten von über 22 TWh oder mindestens 20.000 Pumpspeicherkraftwerke bräuchte. Dafür fehlen in dem nicht sehr gebirgigen Land schlicht die Standorte. Außerdem leiden die wenigen bereits arbeitenden Speicherkraftwerke inzwischen unter der Konkurrenz des Überangebots von Solarstrom gerade zur Mittagszeit. Bislang gehörte die Deckung dieses Spitzenbedarfs mit einem entsprechend hohen Börsen-Strompreis fest zum Geschäftsmodell der Betreiber der Pumpspeicherkraftwerke. Heute wird deshalb kaum noch jemand bereit sein, weiter in diese Technik zu investieren. Wegen des sommerlichen Strom-Überangebots zur Mittagszeit wird über den europäischen Stromverbund inzwischen selbst die Profitabilität der sauberen Wasserkraftwerke der Alpenländer Schweiz und Österreich beeinträchtigt.

Renaissance der Braunkohle-Kraftwerke

Statt durch Stromspeicher werden Windflauten in Deutschland bislang hauptsächlich durch Braun- und Steinkohle-Kraftwerke überbrückt. Diese Kraftwerke werden auch gebraucht, um die Netzfrequenz von 50 Hertz zu erzeugen. Wind- und Solaranlagen sind dazu alleine nicht in der Lage. In Deutschland kam es deshalb gerade wegen des Erneuerbare Energien Gesetzes (EEG) aus dem Jahre 2000 und der „Energiewende“ zu einer Renaissance der „schmutzigen“ Braunkohlekraftwerke, während die vergleichsweise sauberen Gaskraftwerke durch das zeitweise Überangebot von Öko-Strom aus dem Markt geworfen wurden. Zur Erinnerung: Das EEG schreibt vor, dass die Strom-Endverbraucher über ihre Stromrechnung für die Differenz zwischen dem jeweils entsprechend Angebot und Nachfrage erzielbaren Börsen-Strompreis und der den Produzenten von Ökostrom für 20 Jahre garantierten festen Einspeisevergütung begleichen müssen. Während die Betreiber unregelmäßig produzierender Wind- und Solaranlagen also von Festpreisen profitieren, müssen sich die Betreiber der zuverlässig produzierenden Kraftwerke mit dem jeweils erzielbaren Börsenpreis begnügen. Braunkohlekraftwerke können unter dieser Bedingung noch profitabel arbeiten, nicht aber Gaskraftwerke mit ihrem vergleichsweise teuren Brennstoff.

Die Anhänger des neuen französischen Präsidenten Emmanuel Macron, der aus dem Pariser Klimaabkommen vom Dezember 2015 eine Frage des nationalen Prestiges gemacht hat, ließen sich die Gelegenheit nicht entgehen, den angeblichen „Klimaschutz“-Vorreiter Deutschland als Heuchler vorzuführen. Denn die Struktur der deutschen Elektrizitätserzeugung spricht inzwischen dem Anliegen des „Klimaschutzes“, was immer auch darunter zu verstehen sein mag, Hohn. Über die Hälfte (52 Prozent) des in Deutschland erzeugten Stroms kommt heute aus Kohle-Kraftwerken. Die deutschen Stromkunden haben über die EEG-Umlage bereits über 150 Milliarden Euro für die „Energiewende“ gezahlt und werden in den kommenden zehn Jahren weitere 400 Milliarden Euro zahlen müssen. Zurzeit kostet die deutsche „Energiewende“ jedes Jahr 25 Milliarden Euro, d.h. umgerechnet über 300 Euro je Kopf (Babys und Greise eingeschlossen). Dennoch hat sich die „Klima-Bilanz“ der deutschen Elektrizitätsproduktion, gemessen am Kohlenstoffdioxid-Ausstoß, seit über zwanzig Jahren nicht verbessert.

In Frankreich dagegen kommen 76 Prozent der Elektrizität aus sauberen Kernkraftwerken. Weitere 10 Prozent kommen aus den ebenso sauberen Wasserkraftwerken der Alpen. Nur sechs bis sieben Prozent kommen aus Gas- oder Ölkraftwerken. Dennoch setzt nun auch die Regierung Macron- Philippe (wie schon die sozialistische Vorgänger-Regierung unter François Hollande) zumindest nach außen auf „Erneuerbare“. Der Anteil der Kernenergie an der Stromversorgung soll bis 2025 auf 50 Prozent schrumpfen. Noch im Laufe der gerade begonnenen Legislaturperiode sollen 17 der 58 Kernreaktoren stillgelegt werden, verkündete Nicolas Hulot, der neue Ökowende-Minister und stellvertretende Premierminister Frankreichs (sein genauer Titel: „Minister für die ökologische und solidarische Wende“). Zuvor war Hulot bekanntgeworden als geschäftlich außerordentlich erfolgreicher grüner TV-Produzent. Gleichzeitig setzt er (wie Angela Merkel) auf die Elektromobilität und kündigt an, die Exploration neuer Öl- und Gasvorkommen verbieten und ab 2040 keine neuen Benzin- und Dieselfahrzeuge mehr zulassen zu wollen. Doch um die Batterien der E-Mobile aufzuladen, bräuchte man jedoch zig weitere Kernkraftwerke statt weniger. Wie alle grünen „Konzepte“ bestechen also auch die Pläne Hulots durch ihre Inkohärenz.

„Wir müssen absolut fest an die erneuerbaren Energien glauben“, forderte Hulot kürzlich in einem Interview. In der Tat geht es hier um eine reine Glaubensfrage. In einer Demokratie sollte deren Beantwortung aber der freien Gewissensentscheidung jedes einzelnen anheimgestellt werden. Hulot strebt hingegen, wie er mit dem zitierten Satz selbst offen zugibt, nach einer postindustriellen Gesellschaft, in der es weder Glaubensfreiheit noch Freiheit für ergebnisoffene wissenschaftliche Forschung und Entwicklung gibt. Alles soll sich dem politischen Ziel der „Décroissance“ beziehungsweise „Nachhaltigkeit“ unterordnen. Forschern, die andere Wege gehen wollen, wird wohl einfach der Geldhahn zugedreht werden. In der so genannten Klimaforschung ist das längst gang und gäbe. Eine solche Gesellschaft nennt man zu Recht totalitär.

Pseudowissenschaft „Klimatismus“

Ihre scheinbare wissenschaftliche Begründung erfährt die „Energiewende“ durch den „Klimatismus“, d.h. die Behauptung, das bei der Verbrennung von Kohlenstoff entstehende unsichtbare und geruchlose Abgas Kohlenstoffdioxid (CO2) führe zu einer für das Leben auf der Erde gefährlichen Aufheizung der Atmosphäre. Für diese Behauptung gibt es nicht die geringste vernünftige Begründung, da es in der Erdgeschichte Perioden mit einer im Vergleich mit dem derzeitigen um ein Vielfaches höheren CO2-Gehalt der Atmosphäre gab, die nicht mit einer Erwärmung einhergingen. Statt der heutigen CO2-Konzentration von knapp 400 ppm (0,04 Volumenprozent) wurden zeitweise 6.000 ppm (0,6 Prozent) erreicht, während die Kontinente größtenteils vereist waren. Doch am herrschenden CO2-Dogma konnten solche und andere geowissenschaftlichen Befunde nicht rütteln. Das von zwei UN-Organisationen eingesetzte Intergovernmental Panel on Climate Change (IPCC), gemeinhin auch „Weltklimarat“ genannt, hat die politische Aufgabe, Daten und Simuationsmodelle zur Begründung des CO2-Dogmas zu sammeln und zu bewerten. Begründeten Zweifeln am Dogma nachzugehen, gehört nicht zu seinen Pflichten.

Gemäß diesem Dogma ist das oberste Ziel der Energiepolitik nun nicht mehr die zuverlässige, umweltschonende und preiswerte Versorgung der Bevölkerung mit Elektrizität und anderen Formen von Energie, sondern die Senkung des CO2-Ausstoßes um beinahe jeden Preis. Das Schlagwort dafür lautet „Klimaschutz“. Kaum jemand wagt es, dessen Notwendigkeit in Zweifel zu ziehen. Denn es erweckt den Eindruck, es gehe um das hehre Ziel des Natur- und Umweltschutzes, In der Praxis läuft es freilich, wie die Zerstörung von Wäldern durch den Bau und die Tötung Abertausender von seltenen Fledermäusen und Greifvögeln durch den Betrieb von Windrädern zeigt, nicht selten auf das glatte Gegenteil hinaus. Tatsächlich beruht dieses Schlagwort auf einer Sprachpanscherei sondergleichen. Der Begriff „Klima“ kommt aus dem Altgriechischen und bedeutet schlicht „Neigung“. Aufs Wetter angewandt, bezeichnet „Klima“ die durchschnittliche Wetterneigung einer Region im Vergleich zu einer anderen. Im Rahmen der in Genf ansässigen World Meteorological Organization (WMO) haben sich die Meteorologen darauf geeinigt, diesem Vergleich einen 30-jährigen Beobachtungszeitraum zugrunde zu legen. Einzelne Wetterereignisse sagen also noch nichts über das Klima. Dieses ist vielmehr gleichbedeutend mit der Statistik des Wetters. „Klimaschutz“ hieße also auf gut Deutsch „Wetterstatistikschutz“ beziehungsweise „Temperaturmittelwertschutz“. Denn das ist ja der Inhalt des Ende 2015 in Paris erzielten Klima-Abkommens: Der Anstieg der Durchschnitts-Temperatur über den Landmassen der Erde soll bis zum Ende dieses Jahrhunderts auf anderthalb bis zwei Grad Celsius begrenzt werden. Kann man aber ein statistisches Konstrukt wie einen zum Normalwert erklärten Temperatur-Mittelwert überhaupt schützen? Wir schützen doch nicht das Wetter, sondern schützen uns, wenn nötig, vor dem Wetter.

Solche Sprachschludereien sind vermutlich kein Zufall. Sie leben von der Konfusion zwischen Gedanken-Konstrukt (Modell) und Realität. Für die Pflanzendecke der Erde und damit auch für die davon abhängigen Tiere und Menschen haben Durchschnittstemperaturen nur in Extremfällen eine reale Bedeutung. Worauf es ankommt, ist vielmehr der durchschnittliche Jahresgang der Temperatur und der Niederschläge. Es macht einen großen Unterschied, ob das Niederschlagsmaximum in die wärmsten oder die kältesten Monate des Jahres fällt. Das in Deutschland vorherrschende gemäßigt ozeanische Klima ist gekennzeichnet durch ein Niederschlagsmaximum im mäßig warmen Sommer und kühle, selten kalte Winter. Weiter im Osten finden wir das Kontinentalklima, gekennzeichnet durch heiße Sommer und kalte Winter. Rund ums Mittelmeer herrscht das mediterrane Klima, gekennzeichnet durch eine lange Sommertrockenheit und ein Regenmaximum im milden Winter. Von einem „Weltklima“ zu sprechen, ergibt aus diesem Blickwinkel keinen Sinn. Allenfalls beim Vergleich der Erde mit ihrem Trabanten, dem Mond, oder mit ihren Nachbarplaneten Mars oder Venus, könnte man vom „Weltklima“ sprechen.

Dass die Erde im Unterschied zum Mond und zu ihren Nachbarplaneten bewohnbar ist, hängt offenbar mit der Zusammensetzung ihrer Lufthülle zusammen. Diesen Satz würden auch die Grünen sofort unterschreiben. Allerdings sehen die Grünen die Ursache des lebensfreundlichen Klimas der Erde im so genannten Treibhauseffekt. In der Hauptsache verantwortlich dafür seien dreiatomige, das heißt aus asymmetrischen Molekülen bestehende Spurengase in der Atmosphäre wie vor allem Wasserdampf und Kohlenstoffdioxid. Im Unterschied zu den zweiatomigen Hauptbestandteilen der Luft (Stickstoff und Sauerstoff) können die dreiatomigen Spurengase Infrarotstrahlen (Wärme) einfangen und auch wieder aussenden. Dadurch werde die vom Erdboden reflektierte Sonnenwärme in der Atmosphäre wie in einem Treibhaus aufgestaut. Steige der CO2-Gehalt der Luft infolge der Verbrennung von Kohle und Öl beträchtlich über das vorindustrielle Niveau von 0,028 Prozent, drohe eine Überhitzung der Erde.

Dabei verweisen die Verfechter dieser Hypothese gerne auf den Nachbarplaneten Venus, dessen Atmosphäre zu 96,5 Prozent aus CO2 besteht. Die Bodentemperatur der Venus liegt nach Angaben der US-Weltraumbehörde NASA bei 462 Grad Celsius. Das zeige, so die Klimaschützer, dass so viel CO2 einen „galoppierenden Treibhauseffekt“ verursache. Dem ist aber beileibe nicht so. Wegen ihrer größeren Nähe zur Sonne erhält die Venus im Vergleich zur Erde eine fast doppelt so starke Sonneneinstrahlung. Obendrein ist die Atmosphäre der Venus wegen ihres hohen CO2-Anteils 90mal schwerer als die Erdatmosphäre. Am Boden ergibt sich dadurch ein 50mal höherer Druck als auf der Erde. Zusammen mit der stärkeren Sonneneinstrahlung erklärt dieser nach den Gesetzen der Schulphysik hinreichend die hohe Temperatur auf der Venus. Es ist völlig überflüssig, wenn nicht gar abwegig, dafür einen „Treibhauseffekt“ zu bemühen.

Die Atmosphäre ist kein Glashaus

Die Vorstellung, die Erdatmosphäre wirke wie ein Glashaus, geht auf den schwedischen Physikochemiker Svante Arrhenius (1859 bis 1927) zurück. Dieser berechnete im Jahre 1896, die Durchschnittstemperatur der Erde müsse theoretisch bei minus 18 Grad Celsius liegen. Die tatsächliche Durchschnittstemperatur der Erde lag aber nach damaligem Wissen bei plus 15 Grad Celsius. In der Differenz von 33 Grad zwischen beiden Werten sah Arrhenius den „natürlichen Treibhauseffekt“. Doch der bedeutende amerikanische Strahlenphysiker Robert Williams Wood (1968 bis 1955) konnte schon im Jahre 1909 mithilfe eines einfachen Experiments nachweisen, dass es diesen Effekt nicht einmal in einem richtigen Glashaus gibt. Er setzte zwei Glaskästen dem Sonnenlicht aus und maß den Temperaturanstieg im Innern. Der eine Kasten bestand aus Glas, das Infrarotstrahlen reflektiert. Der andere Kasten bestand aus Halit (Salz), das für IR-Strahlen durchlässig ist. Das Ergebnis war in beiden Fällen das gleiche. Die Aufheizung eines Glashauses geht also ausschließlich auf die Unterbindung des Aufstiegs warmer Luft (Konvektion) durch die Glasscheibe zurück. Einer Reflektion von Infrarotstrahlen bedarf es nicht, um die Erwärmung der Innenluft zu erklären. Professor Nasif Nahle von der Universität Monterrey/Mexico hat Woods Experiment in neuerer Zeit in erweiterter Form wiederholt und bestätigt, dass CO2 nicht als „Treibhausgas“ wirkt.

Welche Rolle so genannte Treibhausgase wie CO2 und H2O in der Atmosphäre tatsächlich spielen könnten, zeigt wiederum der Vergleich der Erde mit dem Mond. Beide Himmelskörper erhalten auf ihrer Tagseite ungefähr die gleiche Sonneneinstrahlung. Doch auf dem Mond steigt die Temperatur auf der Sonnenseite auf plus 120 Grad, während sie auf der Erde höchstens auf 50 Grad (in Extremfällen wie im kalifornischen Death Valley auf plus 70 Grad) steigen kann. Offensichtlich sorgt ihre Atmosphäre insgesamt also für Kühlung. Dafür verantwortlich sind vermutlich ausgerechnet die fälschlich zu „Treibhausgasen“ erklärten Spurengase Wasserdampf und Kohlenstoffdioxid, denn die zweiatomigen Gase Stickstoff und Sauerstoff (N2 und O2), die zusammen 99 Volumenprozent der Luft ausmachen, können nicht aktiv Wärme transportieren. Das können nur die die dreiatomigen Gase, deren Flügelatome die IR-Strahlen kurzzeitig in Schwingungen umsetzen. Überflüssig, darauf hinzuweisen, dass ohne Wasser und Kohlenstoffdioxid Leben auf der Erde gar nicht möglich wäre. Fazit: Das Weltbild der Grünen stellt die realen Zusammenhänge auf den Kopf. Die darauf aufbauenden Klima-Modelle haben mit der Realität nichts zu tun. Das sieht man auch daran, dass ein Anstieg des CO2-Gehalts der Luft in der Erdgeschichte immer Warmzeiten folgte und nicht umgekehrt. Das wiederum kommt wohl daher, dass der globale Kohlenstoffkreislauf vom viel mächtigeren Wasserkreislauf angetrieben wird. Wäre es umgekehrt, müsste der Schwanz mit dem Hund wedeln können.

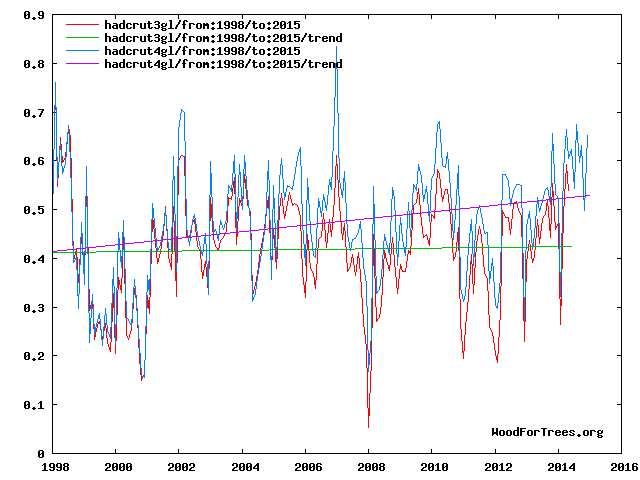

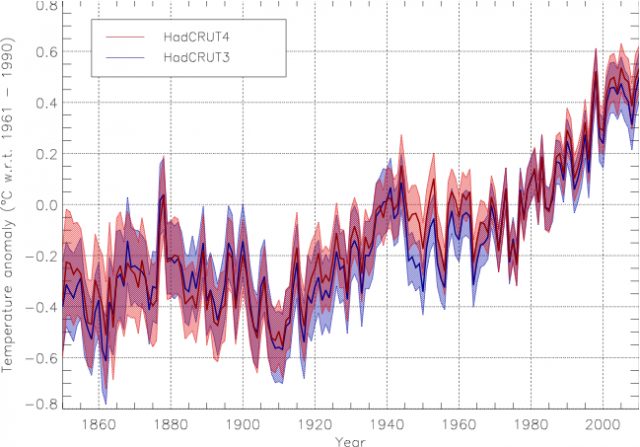

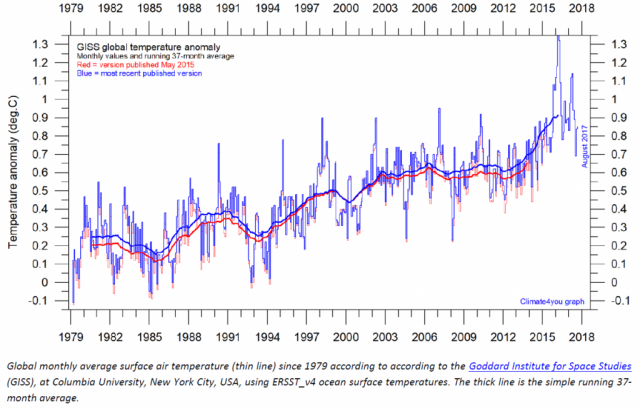

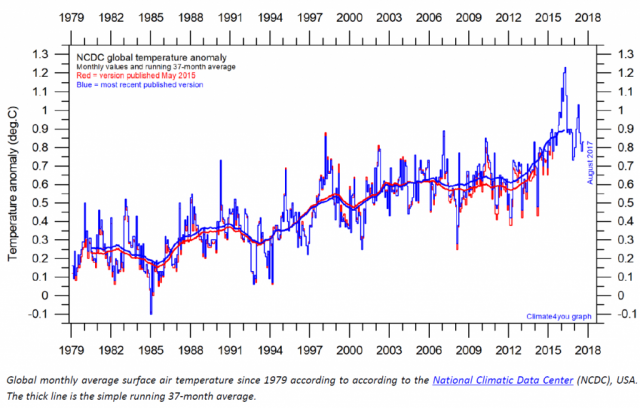

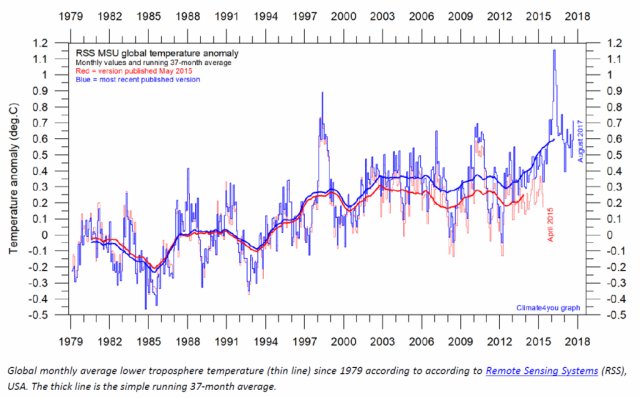

Dennoch hat sich in der Politik die Vorstellung durchgesetzt, wir könnten durch eine Drosselung unserer Verbrennungsabgase die globale Durchschnittstemperatur der Erde senken. Gegen alle Einwände seriöser Forscher (vor allem in den USA), die vor allen darauf hinweisen, dass seit der Jahrtausendwende, trotz einer deutlichen Zunahme des CO2-Ausstoßes vor allem im „Schwellenland“ China und entgegen den Modell-Projektionen des IPCC, von einer globalen Erwärmung keine Rede mehr sein kann. Sogar das IPCC selbst musste diesen „Hiatus“ inzwischen anerkennen. Dennoch einigten sich die im Dezember 2015 in Paris versammelten Unterzeichner-Staaten der UN-Klima-Rahmenkonvention (UNFCCC) in letzter Minute auf ein internationales Abkommen zur Reduktion des Ausstoßes von „Treibhausgasen“. Man sieht den kompromisshaften Formulierungen dieses von der Mainstream-Presse nichtsdestoweniger als „historisch“ klassifizierten Abkommens an, dass ihm viele Unterzeichner-Staaten nur halbherzig zugestimmt haben. Unterschrieben haben wohl die meisten, weil es darin im Grund kaum um das „Klima“, sondern vielmehr um das große Geld geht. Das gilt vor allem für die Völker der so genannten Entwicklungsländer, die in der Regel ganz andere Sorgen haben. Deren Zustimmung zum Pariser Abkommen wurde durch das Versprechen der Überweisung von jährlich 100 Milliarden Dollar für die Erschließung „erneuerbarer“ Energien und Maßnahmen zur Anpassung an den Klimawandel erkauft. Die von den UN noch immer als „Entwicklungsländer“ geführten „Schwellenländer“ China und Indien dürfen bis 2030 mit ihrem CO2-Ausstoß weitermachen, als sei nichts gewesen. Die internationale Finanzindustrie konnte dieses Abkommen als großen Durchbruch feiern, denn dieses macht ihre Geschäfte bis zum Ende des Jahrhunderts berechenbar.

Spielverderber Donald Trump

Doch im November 2016 gewann der als „Populist“ beschimpfte Geschäftsmann Donald Trump gegen Hillary Clinton, die Kandidatin des großen Geldes, mit einem durchaus bescheidenen Wahlkampf-Budget wider Erwarten die US-Präsidentschaftswahlen. Am 1. Juni 2017 kündigte Trump in einer programmatischen Rede im Rosengarten des Weißen Hauses den Ausstieg der USA aus dem Pariser Abkommen an. Anders als in der Gesundheitspolitik weiß Trump in dieser Frage die republikanische Partei geschlossen hinter sich. Bemerkenswert ist die Tatsache, dass Trump mit keinem Wort auf die fragliche wissenschaftliche Begründung der Politik der CO2-Reduktion einging. Vielmehr schloss er sich der vom dänischen Statistiker Björn Lomborg vorgeführten Kosten-Nutzen-Rechnung an: Sollte der behauptete Zusammenhang zwischen CO2– und Temperaturanstieg zutreffen, dann bewirkte die Billionen verschlingende Umsetzung des Pariser Abkommens eine Senkung der Durchschnittstemperatur von gerade einmal 0,05 Grad Celsius! Da hält er es für sinnvoller, die knappen Finanzmittel in die Erschließung neuer Erdgas- und Rohöl-Vorkommen durch die Fracking-Technik zu stecken. Man muss Trump nicht unbedingt lieben, Aber wo er recht hat, hat er recht.

Für die so genannte europäische Macht-Elite ist das aber kein Argument. Führende EU-Politiker, allen voran Angela Merkel und Emmanuel Macron, beeilten sich zu versichern, die „Klimapolitik“ gehe weiter, als sei nichts gewesen. Wenn die USA nicht mitmachten, müsse man eben enger mit China zusammenarbeiten. Ausgerechnet! Zwar könnten die westeuropäischen Regierungen quasi mit einem Federstrich das EEG und ähnliche gesetzliche Regelungen zur großzügigen Subventionierung unwirtschaftlicher Zufallsenergien wieder außer Kraft setzen. Selbst der „Berliner Kreis“, eine konservative Gruppierung in der deutschen Regierungspartei CDU, fordert das inzwischen – ähnlich wie die konkurrierende AfD. Doch über die Jahre haben so viele potenzielle Wähler in Solar- und Windanlagen investiert, dass es keine der großen Parteien mehr wagt, hier das Ruder umzukehren.

So geht in Deutschland vor allem der Ausbau der der WKA-Kapazität munter weiter, zumal sich hier wegen angedrohter Kürzungen der Förderung eine Art Torschlusspanik breitgemacht hat. Schon bald wird die elektrische Höchstleistung der Windturbinen allein den winterlichen Höchstbedarf übersteigen, der in Deutschland derzeit bei etwa 85 Gigawatt liegt. Dr. Udo Niehage wies als Beauftragter des Siemens-Konzerns für die „Energiewende“ darauf hin, dass die Gesamtkapazität der „Erneuerbaren“ beim Fortgang der derzeitigen Geschwindigkeit ihres Ausbaus schon in fünf bis sechs Jahren etwa das Dreifache dieser Höchstlast erreichen wird. Zurzeit werden die gelegentlich auftretenden Stromüberschüsse mit negativen Börsenpreisen ins Ausland verschenkt. Die dortigen Netzbetreiber sind darüber aber keineswegs glücklich. Sie versuchen, sich durch den Bau so genannter Phasenschieber gegen den unplanmäßig ihre Netze überschwemmenden Fremdstrom zu wehren. Phasenschieber sind große Transformatoren, die es erlauben, die Netzfrequenz leicht zu verschieben. Wechselstrom fließt immer in Richtung einer um Bruchteile von Sekunden erniedrigten Frequenz. Wird die Frequenz in einem Netz also leicht erhöht, spiegelt sie dem Nachbarnetz vor, es sei bereits gesättigt und der Strom kann nicht mehr dorthin abfließen.

Deutschland wird also seine Stromüberschüsse bald nicht mehr ins benachbarte Ausland „entsorgen“ können. Den in Deutschland tätigen Netzbetreibern bliebe dann nichts anderes übrig, als Stromüberschüsse in vorsintflutlichen Nachtspeicheröfen mit Schamott-Steinen o.ä. zu verheizen. In der Tat spielen Elektroheizungen in den Zukunfts-Konzepten von Siemens wieder eine wichtige Rolle. Lange Zeit wurden diese von den Grünen jedoch als Energieverschwendung gebrandmarkt. Es wird auch vorgeschlagen, überschüssige Elektrizität in Methan oder Wasserstoff und bei Bedarf wieder in Strom zurück zu verwandeln. Dabei ergäben sich aber Strompreise von deutlich über einem Euro je Kilowattstunde. Diese Vorschläge erinnern übrigens in makabrer Weise an die Autarkie-Pläne für das Nazi-Reich, die die der NS-Turbineningenieur Dr. Franz Lawaszeck in einem 1933 erschienen Buch mit dem Titel „Technik und Wirtschaft im Dritten Reich“ darlegte.

Drohender „Blackout“ in Deutschland

Im letzten Winter kam es bei einer „Dunkelflaute“ (Windstille bei einem Kälte-Hoch mit Nebel) in Deutschland zu einem Beinahe-Zusammenbruch des ganzen Stromnetzes. Wäre es so weit gekommen, hätte es relativ lange gedauert, das Netz wieder hochzufahren. Während dieser Zeit wären Tausende von Menschen in Aufzügen steckengeblieben, die Wasser- und Treibstoff-Versorgung hätten stillgestanden, Patienten in den Intensivstationen der Krankenhäuser wären in Todesnot geraten, in den Städten wäre es wegen des Ausfalls der Verkehrsampeln zu stundenlangen Staus gekommen und die nicht mehr beleuchteten Geschäfte und Supermärkte wären Plünderern anheimgefallen. Als Konsequenz aus dem Beinahe-Blackout hat der Deutsche Bundestag Anfang Februar 2017 heimlich das Energiewirtschaftsgesetz geändert. Um einen großflächigen Blackout zu vermeiden, können lokale Stromversorger verpflichtet werden, innerhalb von nur zwölf Minuten ganze Bezirke von der Stromversorgung zu trennen. „Lastabwurf“ heißt das in der Fachsprache. Auf Krankenhäuser und andere empfindliche Stromkunden darf dabei keine Rücksicht genommen werden. Es besteht auch kein Schadensersatz-Anspruch.

Die Netzbetreiber versuchen, das drohende Chaos durch eine möglichst realistische Simulation der witterungsabhängigen Einspeisung des Öko-Stroms abzuwenden. Schon heute sind fast zu jeder Stunde manuelle Eingriffe in die Stromnetze, genannt Redispatching, nötig, um die Netzstabilität aufrecht zu erhalten. Das wird in den kommenden Jahren immer schwieriger, weil die dezentralen Erzeuger, angeregt durch staatliche Förderprogramme, einen immer größeren Teil des Grünstroms völlig unvorhersehbar für den Eigenverbrauch und die Eigenspeicherung abzweigen. Niehage deutete an, ohne die 800 Kilometer lange Gleichstrom-Verbindung SuedLink zwischen Nord- und Süddeutschland werde der deutsche Strommarkt in einen Nordteil mit Stromüberschuss und einen Südteil mit einer knappen und daher schätzungsweise um sechs Euro je Megawattstunde teureren Stromversorgung im Südteil zerfallen.

SuedLink kommt übrigens wegen des Widerstandes zahlreicher Bürgerinitiativen vor Ort kaum voran. Offiziell soll die neue Trasse dazu dienen, die Windstromüberschüsse der deutschen Bucht und der norddeutschen Tiefebene zu den Industriegebieten Bayerns und Baden-Württembergs zu leiten. Da Windkraftanlagen aber selbst auf der Nordsee nur während maximal 3.000 von den 8.760 Stunden des Jahres Strom liefern, sind die geplanten neuen Stromtrassen von vorneherein so konzipiert, dass sie in windarmen Zeiten auch Braunkohlestrom aus der Kölner Bucht und Brandenburg in den Süden transportieren können. Die neue, von der CDU geführte Landesregierung von Nordrhein-Westfalen setzt übrigens offen auf die Erweiterung der Braunkohle-Tagebaue in dieser Region. Die SuedLink-Trasse würde frühestens drei Jahre nach der für 2022 geplanten Schließung des letzten deutschen Kernkraftwerks Grafenrheinfeld, das sie ersetzen soll, fertig. Da die Gleichstromkabel wegen der Proteste der Anwohner nun unterirdisch verlegt werden sollen, wird der Kilometer Stromtrasse mindestens sieben statt der ursprünglich veranschlagten eine Million Euro je Kilometer kosten.

Tatsache ist: Deutschland ist dabei, sich mit seinen Braunkohle-Plänen heimlich vom Pariser Abkommen zu verabschieden. Dennoch soll der subventionierte Ausbau der „Erneuerbaren“ ebenso planmäßig weitergehen. Selbstverständlich ist den meisten der daran beteiligten Ingenieure bewusst, dass das nicht geht. Aber niemand wagt es, den Mund aufzutun. Erst als Rentner wagen sich manche von ihnen an die Öffentlichkeit. Das ist die Realität in der angeblich freiesten Republik, die das deutsche Volk je erlebt habe. „Die Energiewende ist das teuerste Experiment am lebenden Bürger seit es die Bundesrepublik gibt“, schrieb kürzlich mein Freund und Kollege Dirk Maxeiner. Es geht bei der planwirtschaftlichen Förderung „erneuerbarer“ Energien im Grunde gar nicht um eine umweltschonendere Energieversorgung, sondern um den Machtanspruch der Grünen aller Parteien. Diese glauben offenbar, durch das von ihnen angerichtete Chaos ihren Traum von einer totalitären Öko-Diktatur schneller näherkommen zu können.