Was ist nun wirklich mit der Wissenschaft passiert?

Die Standardantwort auf diese Frage lautet, dass die Unsicherheiten evaluiert worden sind und peripher erscheinen gegenüber dem zentralen Punkt: wir wissen, dass es schlimm werden wird, und wir sind nur unsicher, wie schlimm es wird. Allerdings sind die Unsicherheiten, die ich hier im Sinn habe, zu fundamental für diese Erklärung, als dass man sie akzeptieren kann. Ich habe den Verdacht, das Problem besteht darin, dass Klimatologen Prophezeiungen abgeben, die nicht falsifiziert werden können mittels geeigneter Experimente. Erkenntnisse aus einem Experiment sind ein bedeutendes Mittel, um erkenntnistheoretische Unsicherheiten (das heißt Ignoranz) zu reduzieren, und es sind derartige Reduktionen, die man sich wünschen möchte, um eine Konvergenz der Meinungen zu erreichen. Aber innerhalb der Klimatologie kommt es zu einem Konsens durch Folgerungen und Disput, wobei Logik und Objektivität im Wettbewerb stehen mit Rhetorik, Ideologie, Politik und Berechnung. Die Soziologie der Wissenschaft ist bedeutend dafür, Gewissheit zu etablieren ohne dass man die Ungewissheit reduzieren muss.

Zurück zu den Grundlagen

Niemand wird in Frage stellen, dass Klimatologie eine Wissenschaft ist. Daher profitieren Klimatologen von der Glaubwürdigkeit, die jeder vernünftige Mensch in den Proklamationen der Wissenschaftler sieht. Darum scheint es so einfach zu sein, jeden als ,anti-wissenschaftlich‘ zu brandmarken, der den ,überwältigenden‘ Konsens unter den Klimatologen in Frage stellt. Schließlich – um Präsident Obama zu zitieren – „sind die Wissenschaft über alle Zweifel erhaben und die Fakten eindeutig“. Die gleiche Prämisse unzweifelhafter Integrität liegt hinter den Empfehlungen von Öko-Psychologen an der University of South West England, denen zufolge jeder, der die Wahrheit hinter Catastrophic Anthropogenic Global Warming (CAGW) in Frage stellt, als unter Geistesverwirrung leidend behandelt werden sollte (1). Außerdem, die Zeit, die man mit Diskussionen mit solchen Skeptikern verschwendet (oder ,Flat Earthers‘, wie Al Gore sie nennt), könnte zu entscheidenden Verzögerungen der Einführung notwendiger Maßnahmen führen. Derartiger Skeptizismus ist daher in jeder Einzelheit so irrational und unmoralisch wie die Leugnung des Holocaust, so dass man dagegen wirklich ein Gesetz erlassen sollte, oder? Aber bevor wir völlig darin aufgehen (buchstäblich), sollten wir uns ins Gedächtnis zurückrufen, warum wir den Wissenschaftlern so vertrauen, und wir sollten uns fragen, ob unser Verständnis für die Ursache dieses Vertrauens es rechtfertigt, hinsichtlich des vermeintlichen Konsens‘ unter Klimatologen auf der Hut zu sein.

Es ist allgemein akzeptiert, dass die prinzipielle Stärke hinter der wissenschaftlichen Methode die Objektivität ist, die daraus resultiert, dass man sich selbst strikt daran hält, nur falsifizierbare Statements abzugeben, besonders hinsichtlich praktischer Experimente. Zumindest sollte man nur Statements abgeben, welche Prophezeiungen enthalten, die mit Referenz zur Natur verifiziert werden können. Nur so sollte ein Konsens erreicht werden. Wissenschaft ist keine Demokratie – Fakten entscheiden, nicht eine wissenschaftliche Wählerschaft. Aber selbst in der reinsten aller Wissenschaften kann man gelegentlich Bereiche von Spekulation finden, die nicht offensichtlich einem genauen Experimentieren unterzogen werden können. Wenn dies passiert, ist das Aufblühen eines Disputes fast unvermeidlich. Schließlich sind auch Wissenschaftler nur Menschen. Falls jemand dieser Mischung eine Frage von vitaler Bedeutung hinzufügt, etwa wenn es um das Überleben der menschlichen Rasse geht, kann man fast dafür garantieren, dass Medien und Politik sich des Themas annehmen. Und danach sind dich Chancen einer ruhigen, sachlichen Debatte praktisch gleich Null. Was noch wichtiger ist, das Fehlen der Falsifizierbarkeit bildet den Rahmen für das erreichen eines Konsens‘ mit anderen Mitteln, was zu einer Gewissheit führt, die man nicht als Nennwert betrachten kann. In der Causa Klimatologie kommt der erste Hinweis darauf, dass der Konsens keineswegs das ist, was er zu sein scheint, aus der außerordentlichen Signifikanz. Der Konsens innerhalb der Klimatologie, so sagt man uns, spiegelt das Erreichen eines Niveaus der Gewissheit, welches in der Wissenschaft einmalig ist. Offensichtlich ist Klimatologie die einzige wissenschaftliche Disziplin in der Geschichte, bei der die Wissenschaft ,settled‘ ist!

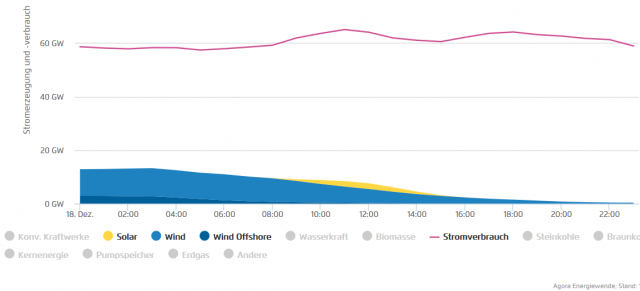

Zugegeben, die Theorie von CO2 als einem Treibhausgas ist im Labor leicht zu bestätigen, und die Tatsache, dass es während der Industrialisierung einen signifikanten Anstieg von CO2 in der Atmosphäre gegeben hat, ist durch Messungen bestätigt. Bis hierhin ist das Narrativ, dass die Menschheit derzeit zum Klimawandel beiträgt, leicht zu akzeptieren. Aber nichtsdestotrotz ist das nicht der Punkt. Die Frage lautet, ob gegenwärtige Trends herangezogen werden können, um zu prophezeien, dass es die realistische Aussicht auf irreversible und katastrophale Umweltschäden in nicht sehr ferner Zukunft gibt [Durch Windräder und Solarpaneele jedenfalls ist diese Zukunft schon Gegenwart! Anm. d. Übers.]

Vergisst man nicht, dass eine wissenschaftliche Aussage falsifizierbar sein muss – gibt es da ein legitimes Experiment, mit dem man die spezifischen Prophezeiungen im Namen der Klimatologie falsifizieren kann? Nun, ich fürchte, die Antwort lautet nein. Das Experiment würde erfordern, einen repräsentativen Planeten zu betrachten (den Planeten Erde zum Beispiel), den man genau der Art CO2-Zunahme aussetzt, der uns Sorgen macht, und dann abzuwarten, was passiert. Ein solches ,Experiment‘ ist im Gange, aber es wurde von den Klimatologen noch nicht in Anspruch genommen. Auf der ,World Conference on the Changing Atmosphere’ im Jahre 1988 wurde es so ausgedrückt: „Die Menschheit führt ein unbeabsichtigtes, unkontrolliertes global allgegenwärtiges Experiment durch, dessen ultimative Konsequenzen nur noch von einem Atomkrieg übertroffen werden können“.

Das wolle wir mit Sicherheit nicht, aber angesichts des Fehlens eines verantwortungsvollen, beabsichtigten und kontrollierten Experiments muss man sich mit Theoretisieren zufrieden geben auf der Grundlage des Verständnisses, wie das Klimasystem der Erde agiert. Dies bedingt Feldstudien zum Erlangen von Informationen hinsichtlich gegenwärtiger und historischer Klimawandel, kombiniert mit mathematischer Modellierung, um die Bandbreite zukünftiger Möglichkeiten zu erkunden. Unglücklicherweise bietet dies unabhängig davon, wie sinnvoll dies ist, breiten Raum für Spekulation.

Erstens, man muss vorsichtig sein bei dem Versuch, die Historie der Temperaturänderungen auf der Erde zu unterscheiden, vor allem, wenn dies Interpretation und Manipulation von Proxies erfordert. Dieser Bereich ist tief in Kontroversen verstrickt, worauf ich später noch einmal zurückkommen werde, wenn wir der infamen Hockeyschläger-Graphik begegnen.

Zweitens, man muss sehr vorsichtig sein hinsichtlich der Natur der mathematischen Modelle, mittels welcher die Evolution des Klimasystems der Erde prophezeit wird – ein System, von dem man weiß, dass es offen, nicht linear, ungeheuer komplex und chaotisch ist. Das Ausmaß der Glaubwürdigkeit,welche man diesen Modellen entgegenbringen kann, hängt davon ab, wie gut sie die relevanten Faktoren erfassen, die hier im Spiel sind, und wie realistisch und akkurat derartige Faktoren parametrisiert worden sind. Außerdem beruht die Vorhersagefähigkeit selbst für ein umfassendes und akkurates Modell auf dem Ausmaß, mit dem Rauschen und die dissipativen Kräfte das Klima langfristig stabilisieren können (2). Unglücklicherweise kann es angesichts der signifikanten strukturellen und parametrischen Ungewissheit innerhalb der Modelle eine Wahnidee sein, ein gewisses Vertrauensniveau in die Hypothesen einer gut definierten Unsicherheit von der Art eines Würfels zu setzen (3):

Nichts von oben Gesagtem scheint jedoch das IPCC zu stören. Für all jene, die sich rückversichern wollen, dass der bestehende Satz von Klimamodelle valide ist, erschien im 4. IPCC-Zustandsbericht die folgende Beteuerung an prominenter Stelle:

„Dieses Vertrauen stammt aus dem Fundament physikalischer Prinzipien der Modelle und aus deren Fähigkeit, beobachtete Phänomene von Klimaänderungen in Gegenwart und Vergangenheit zu reproduzieren“.

Nun ist es beruhigend zu erfahren, dass die Modelle auf allgemeinen physikalischen Prinzipien beruhen, obwohl dies ein wenig so daherkommt, als ob man sagt, dass ein Zeuge zuverlässig ist, weil er eine reale Person und nicht ein Harry-Potter-Charakter ist – das ist kaum etwas, mit dem man prahlen kann. Was die Reproduktion von Klimaänderungen in Gegenwart und Vergangenheit angeht, habe ich zwei Bedenken:

Erstens, die Tatsache, dass ein Modell die Vergangenheit reproduzieren kann, ist nur dann eindrucksvoll, falls es das einzige verfügbare Modell ist welches das kann, und da man eine Vielfalt von Modellen erstellen kann, welche zu den Aufzeichnungen mittels eines vernünftigen ,Tunings‘ passen, ist das eindeutig nicht der Fall (4). Folglich ist das Passen zu Klima-Aufzeichnungen nicht die wahre Metrik für Vertrauen in ein Modell. Stattdessen kommt Vertrauen aus der Plausibilität und der Legitimität der Parameter-Werte, auf welche die Modellierer zurückgegriffen haben, um das Passen zu erreichen. Sogar das IPCC höchstselbst räumt ein: „Falls ein Modell frisiert worden ist, um gut zu einer tatsächlich beobachteten Quantität zu passen, dann kann die Übereinstimmung mit der Beobachtung nicht herangezogen werden, um Vertrauen gegenüber diesem Modell zu haben“. Ist also diese Strategie allgemeine Praxis? Wer weiß das schon? Die Modellierer veröffentliche ihre Tuning-Verfahren nicht.

Zweitens ist es mit Sicherheit ein logischer Trugschluss zu folgern, dass ein Modell, welches gut in der ,Nachhersage‘ ist, notwendigerweise auch zuverlässig ist zum Zwecke des Ausgebens von Prophezeiungen. Zum Beispiel könnte ein Modell, welches unrichtig die Auswirkungen Wasserdampf und Wolken-Rückkopplung abbildet, diese Schwäche nicht zeigen, bis die Auswirkungen signifikant werden.

Das letzte Wort hierzu soll ein Statement sein, welches tief vergraben ist in den Details des 4. IPCC-Zustandsberichtes: „Was sagt die Genauigkeit einer Klimamodell-Simulation des Klimas in Vergangenheit und Gegenwart über die Genauigkeit seiner Projektionen von Klimawandel? Diese Frage anzusprechen steht gerade erst am Anfang…“. Es stellt sich also heraus, dass IPCC schon vertrauensvoll hinsichtlich seiner Modelle war, obwohl die entscheidende Frage ,gerade erst am Anfang steht, angesprochen zu werden‘. Übersehe ich hier etwas?

Aber jenseits aller meiner Bedenken steht der Kernpunkt, den ich deutlich machen möchte, dass nämlich die Verwendung eines mathematischen Modells für eine Prophezeiung ein ärmlicher Ersatz ist für die Durchführung eines Experimentes. Klimatologen mögen jeden Lauf eines Klimamodells als ein ,mathematisches Experiment‘ betrachten, aber wenn sie das tun, scheinen sie sich selbst zu betrügen. In jeder anderen wissenschaftlichen Disziplin wäre ein derartiges Verhalten als ,hypothetisieren‘ bezeichnet werden. Es ist kein Experiment, welches die Fakten der Natur etabliert (wie es bei einem echten Experiment der Fall wäre), sondern es ermöglicht Klimatologen einfach, den Charakter ihrer Spekulationen besser zu verstehen.

Keinen Spielraum für Zweifel

Bislang läuft alles, was ich zur Erklärung der Koexistenz von Ungewissheit und Sicherheit im Bereich Klimatologie gesagt habe, auf einen irgendwie halb fundierten Verdacht hinaus, dass die betroffenen Wissenschaftler der professionellen Fehlbeurteilung schuldig sind; dass sie dem verfügbaren wissenschaftlichen Arsenal zu viel Vertrauen entgegen bringen. Allerdings sollte man nicht die Tatsache aus dem Auge verlieren, dass Klimatologie schwerstens politisiert ist und dass Ideologien ebenso wie wissenschaftliches Verstehen auf dem Spiel stehen. Es sind diese Umstände, welche die Debatte korrumpieren können. Falls also Beweise auftauchen, die belegen, dass die Unsicherheiten absichtlich heruntergespielt worden sind, kann man durchaus argumentieren, dass eine solche Korruption erfolgt ist. Ich stütze dieses Argument auf die folgenden beiden Beispiele:

Das erste Beispiel ist der Vorwurf, dass das IPCC sich einer grob vereinfachenden Darstellung der Wissenschaft schuldig gemacht hat, und dass die in den Executive Summaries vorgebrachte Sicherheit nicht die Unsicherheit reflektiert, auf welche die zu Rate gezogenen Wissenschaftler hingewiesen hatten. Dieser Verdacht erhob sich bereits bei der Veröffentlichung des 1. IPCC-Berichtes im Jahre 1990. Während eine Arbeitsgruppe eingesetzt worden ist, das Gremium bzgl. der Unsicherheiten zu beraten, tauchten diese in der Executive Summary gar nicht erst auf. Beispielsweise erschien das folgende Statement in dem Bericht der Arbeitsgruppe: „Eine globale Erwärmung größeren Ausmaßes gab es mindestens einmal seit dem Ende der letzten Eiszeit ohne jede merkliche Zunahme von Treibhausgasen. Weil wir die Gründe für dieser Erwärmungs-Ereignisse in der Vergangenheit nicht verstehen, ist es noch nicht möglich, einen bestimmten Anteil der jüngsten, geringeren Erwärmung einer Zunahme von Treibhausgasen zuzuordnen“.

Trotz dieser Vorbehalte war die Executive Summary des Berichtes eindeutig hinsichtlich seiner Schlussfolgerungen und riet dazu, dass weil die Beweise für potentielle Schäden durch AGW so stark waren, „sofortige Reduktionen von Emissionen durch menschliche Aktivitäten erforderlich sind, und zwar um über 60%, um die Konzentrationen auf dem gegenwärtigen Niveau zu stabilisieren“. Auch sagte die Executive Summary nichts hinsichtlich der Grobheit der ersten mathematischen Modelle, die als Grundlage für die Klimawandel-Prophezeiungen bemüht worden waren.

Ohne dass ich jetzt darüber theoretisieren will, warum es zu einem solchen Herunterspielen der Unsicherheiten gekommen ist, spricht die Tatsache, dass dies überhaupt möglich war, Bände über das Vertrauen, das man dem Konsens gegenüber haben kann in der Form, wie es das IPCC zu verbreiten trachtete. Das IPCC hat seitdem eine ganze Reihe von Berichten veröffentlicht, aber die Vorwürfe bzgl. falscher Angaben zur Gewissheit wollten nicht verstummen. Zum Beispiel wurden viele Abschnitte im 2. Zustandsbericht des IPCC, in welchen vor den Unsicherheiten gewarnt worden ist, offensichtlich entfernt, nachdem man die Begutachtung für beendet gehalten hatte. Hierzu bemerkte Prof. Frederick Seitz: „Aber dieser Report ist nicht das, was er zu sein scheint – es ist nicht die Version, welche von den auf der Titelseite gelisteten beitragenden Wissenschaftlern geschrieben worden war. Während meiner über 60-jährigen Mitgliedschaft in der amerikanischen wissenschaftlichen Gemeinschaft, einschließlich meiner Funktion als Präsident sowohl der National Academy of Sciences als auch American Physical Society habe ich niemals eine schlimmere Korruption des Begutachtungsprozesses erlebt als bei den Vorkommnissen, welche zu diesem IPCC-Bericht führten“ (5).

Für mein zweites Beispiel der Vortäuschung einer nicht vorhandenen Gewissheit möchte ich die berüchtigte Hockeyschläger-Graphik heranziehen. Sie wurde erzeugt von einem Team unter Leitung von Dr. Michael Mann und im 3. IPCC-Zustandsbericht kolportiert, um die Causa voranzutreiben. Die Graphik zeigt eine unspektakuläre Abkühlung der Temperatur während des vorigen Milleniums, welche mit einem dramatischen Anstieg endete, der zusammenfiel mit dem Beginn der Industrialisierung. Als solche war es eine immens signifikante Graphik vertrieb sie doch die unwillkommenen Erwärmungen in vorindustrieller Zeit, welche im 1. Zustandsbericht angesprochen worden waren. Im besonderen war die Mittelalterliche Warmzeit auf einmal völlig verschwunden. Mit diesem Hockeyschläger zur Hand brauchte das IPCC nicht mehr die Unsicherheit im Inneren seiner Berichte zu vergraben, bewies doch die Graphik, dass die Unsicherheit einfach nicht existierte. Sie zeigt, dass die gegenwärtigen Temperaturen beispiellos sind und dass es keinen Beweis für eine Erwärmung in vorindustrieller Zeit gibt, zumindest nicht im globalen Maßstab. Der Hockeyschläger war der schlagende Beweis, welcher diew AGW-Theorie bestätigte, und damit war die Wissenschaft ,settled‘. Oder doch nicht?

Irgendwie war es überraschend, dass niemand im Bereich Klimatologie sich veranlasst sah zu versuchen, eine Rekonstruktion der Analyse durchzuführen, welche von Mann et al. durchgeführt worden ist, es schien kein Thema zu sein. Stattdessen blieb es einem halb im Ruhestand befindlichen Bergbau-Berater vorbehalten, Steve McIntyre, ein solches Audit durchzuführen – und die Ergebnisse waren verheerend. Ich möchte mich in diesem Beitrag nicht zu Details hierzu verlieren, dazu ist anderswo viel zu lesen. Um meine Bedenken zu rechtfertigen, muss ich mich nicht unbedingt auf eine Seite der Debatte schlagen; es ist ausreichend zu bemerken, dass es diese Debatte gibt. Wenn man aber erst einmal die statistischen Betrügereien erkennt, welche dem Hockeyschläger zugrunde liegen, ist es nichtsdestotrotz schwierig, nicht zu der Schlussfolgerung zu kommen, dass die Daten gnadenlos zur Bestätigung eines Glaubens vergewaltigt worden waren. Aus der Analyse entstand Gewissheit, aber nur auf Kosten der Integrität. Angesichts der gewaltigen Unterstützung und Publicity, welche das IPCC der Studie ursprünglich verliehen hatte, müssten die nachfolgenden Enthüllungen und ultimative Widerlegung eigentlich größte Empörung hervorrufen. Oder zumindest sollte man das annehmen.

Natürlich nehme ich hier die Position der Skeptiker ein. Da gibt es diejenigen, die auf Studien aus jüngerer Zeit verweisen, wie etwa das PAGES 2K-Konsortium, die eine unabhängige Bestätigung des Hockeyschlägers darstellen. Also war am Ende vielleicht Dr. Manns statistische List gar nicht notwendig, um über die korrekte Antwort zu stolpern. Die Schwierigkeit für mich, dieses Argument zu akzeptieren, besteht darin, dass es die Variation eines Themas zu sein scheint: Man nehme viele Proxydaten, drehe sie durch die Mangel mittels Manipulation und statistischer Analysen so lange, bis sie tot sind, aber dennoch die gewünschte Antwort zeigen; und man hoffe, dass niemand die Unsicherheiten und falschen Hypothesen bemerkt, die im Detail stecken. Schon jetzt müssen die PAGES 2K-Ergebnisse aktualisiert werden angesichts der Kritik (6) und der Variabilität niedriger Frequenz in der Temperatur-Rekonstruktion, welche mit jeder Änderung prominenter hervortreten. Je mehr die Paläo-Klimatologen sich bemühen, die Mittelalterliche Warmzeit los zu werden, desto mehr scheinen sie die Unsicherheiten hervorzuheben zu versuchen, eine zuverlässige globale Temperaturreihe zu erstellen aus Zusammenstellungen lokalisierter Proxy-Messungen.

Die echte Ironie hinter all dem ist, dass die politische Bedeutung des Hockeyschlägers immer weit größer war als dessen wissenschaftliche Relevanz. Die AGW-Hypothese wird durch die Existenz der Mittelalterlichen Warmzeit nicht falsifiziert. In der politisierten Arena, in welchem Klimatologie durchgeführt wird, war jedoch die Versuchung groß für das IPCC zu behaupten, dass die Wissenschaft ,settled‘ sei und als Konsequenz ein Pferd aufzuzäumen, welches den Drogentest nicht bestanden hat. Das wäre schon schlimm genug, aber die Intensität und zeitliche Dauer, mit der der Hockeyschläger verteidigt wurde und wird, enthüllt eine sogar noch besorglichere Eigenschaft. Selbst in Bereichen, wo eine Falsifizierung besonders leicht möglich ist, scheint es innerhalb der Klimatologie eine Kultur zu geben, die darauf abzielt, in dieser Hinsicht frustriert zu werden. An jeden, der bezweifelt, dass all dies es erforderlich macht, den Enthüllungen von Klimagate mehr Aufmerksamkeit zu schenken: Die illegale Löschung von E-Mails, welche Gegenstand einer Anforderung im Rahmen des Informationsfreiheits-Gesetzes sind, bildet eine Konspiration, die Herausgeber wissenschaftlicher Veröffentlichungen einschüchtert, die den IPCC-Begutachtungsprozess korrumpiert, die Daten zensiert, welche nicht die zentralen Botschaft stützen. Es gibt permanente Bemühungen zu verhindern, dass Daten der öffentlichen Überprüfung zugänglich gemacht werden sowie eklatante Falschinterpretationen der Daten, um eine gewünschte politische Auswirkung zu erhalten. Und doch ist all dies danach als nichts weiter vom Tisch gewischt worden als der ,robuste‘ Dialog, den man zwischen ehrlichen und fähigen Wissenschaftlern erwarten kann, die ihrer täglichen Routine nachgehen!

Jedoch bedurfte es Klimagate nicht für die Enthüllung, dass die Klimatologie von einer hässlichen Kultur von Einschüchterung, Verzerrung und Zensur umgeben ist, gibt es doch Viele in dem Bereich, die Folgendes aussagen können: Entzug der IPCC-Mitgliedschaft für all jene, die Kontrarians zu sein scheinen; Zurückweisung von Einzelbeiträgen aus fadenscheinigen Gründen; Entzug von Forschungsförderung oder die Androhung desselben; Vorwürfe, dass eine bestimmte Finanzierungsquelle die wissenschaftliche und persönliche Integrität eines Einzelnen unterminiert; Vorwürfe von Inkompetenz und Dummheit; und Verunglimpfung mittels abfälliger Bezeichnungen wie ;Leugner‘ oder ,Wissenschafts-Söldner‘. Viele Beobachter können behaupten, dass derartige Taktiken notwendig sind, um einen legitimen wissenschaftlichen Konsens zu verteidigen, welcher Angriffen ausgesetzt ist seitens einer Armee von Zweiflern mit üblen Absichten, obwohl ich es vorziehe zu sagen, dass ein solches Verhalten wenig dazu beiträgt, die gegenwärtige Krise der Wissenschaft zu mildern (7).

Es ist vielleicht nur fair zu erwähnen, dass einige der Gewissheits-Apostel wie Dr. Mann gleichermaßen gekränkt sind durch den Tonfall der Debatte, und dass sie sich gerne selbst als die wirklichen Helden präsentieren, als Wächter der Wahrheit, umgeben von rasenden und fanatischen Neinsagern. Ich wage zu sagen, dass Dr. Mann Missbrauch erlitten hat, aber der Gedanke, dass er ein Licht ist in einer Wildnis aggressiver Ignoranz ist etwas schwierig zu akzeptieren, wenn er auch behauptet, dass alle richtig denkenden Wissenschaftler ihm zustimmen. Alles, was ich sagen kann ist, dass es eine Menge falsch denkender Wissenschaftler da draußen geben muss.

Aber genug der Schlammschlacht. Wenn es darum geht, könnte das wirkliche Problem der Klimatologie nichts zu tun haben mit Möchtegern-Verschwörungen. Das Problem kann das Ausmaß sein, mit dem der Konsens einem direkten Auswahleffekt geschuldet ist. Es ist eine unbestrittene Tatsache, dass Regierungen auf der ganzen Welt von Anfang an stark in Forschungen der AGW-Hypothese investiert haben, oftmals unter Ausschluss potentieller Alternativen. Ich stelle hier nicht deren Motivation in Frage; die ist unwichtig. Alles was zählt ist, dass falls Forschungsförderung strikt begrenzt ist auf das Voranbringen eines Interesses an einer Vermutung in einem bestimmten Gebiet, man nicht überrascht sein darf, wenn die wissenschaftliche Gemeinschaft, die jemand als Berater installiert hat, mit Einstimmigkeit zu sprechen anfängt.

Es gibt keinen Grund, hier eine Verschwörung zu vermuten. Ich kann ziemlich gut akzeptieren, dass Wissenschaftler ernste und ehrliche Sorgen bekommen angesichts der extremen Möglichkeiten von AGW, und es gibt die Chance, dass sie recht haben. Allerdings kann es genauso gut sein, dass sie nur deswegen so im Vordergrund stehen, weil sie jene Klimatologen, die alternative Standpunkte vertreten, entweder zum Mitmachen bei ihnen nötigen oder sie aus dem Spiel drängen – die Tage des selbstlos forschenden Gentleman-Wissenschaftlers, der an seiner Studie schuftet, sind längst vorbei. Es ist daher denkbar, dass der Konsens, anstatt das Ergebnis von Umdenken im Verlauf der Debatte zu sein, stattdessen aus einer Form soziologischer natürlicher Selektion resultiert.

Man könnte versucht sein, diesen Gedanken als abstrus zurückweisen. Sicher ist es höchst unwahrscheinlich, dass eine ganze Gemeinschaft von Wissenschaftlern unbekümmert signifikante Untersuchungslinien ignorieren. Nun, es mag unwahrscheinlich aussehen, wäre da nicht die Tatsache, dass genau das die ganze Zeit im Gange ist. Alles, was man braucht, ist die richtige Mischung aus Überzeugung, sozialer Druck und die Unfähigkeit, mittels Experimenten etwas zu falsifizieren. Man nehme beispielsweise eine wissenschaftliche Disziplin, von der jedermann glaubt, dass sie ein Ausbund wissenschaftlicher Integrität ist – die Physik hoch energetischer Partikel.

String Wars

Ende der siebziger und Anfang der achtziger Jahre begannen theoretische Physiker, sich Gedanken zu machen, welche nicht nur in unmittelbarer, sondern auch weitester Zukunft nicht falsifizierbar sind. Diese Gedanken wurden unter dem Begriff String-Theorie zusammengefasst, um bald darauf von einem supersymmetrischen Äquivalent ersetzt zu werden, nämlich der Superstring-Theorie. Der Grundgedanke ist, dass Elementarteilchen, einschließlich der Ladung tragenden [force-carrying] Partikel der Quantenfeld-Theorie, keine Punktobjekte sind , sondern stattdessen Manifestationen der Vibration offener Strings oder Energie-Loops [?]. Jeder Vibrations-Zustand ist messbar als ein Partikel einer gegebenen fundamentalen Art. Das Problem bei der String-Theorie ist jedoch, dass die Strings so klein sind (in der Größenordnung der so genannten Planck-Länge von 10-35 m), dass die Energie zur Erkundung derartig kleiner Details in der Natur buchstäblich astronomisch ist – man bräuchte einen Teilchen-Beschleuniger, der so stark ist, dass er die Größe einer mittleren Galaxie haben müsste. Daher wurde vermutet, dass die Theorie bislang dabei versagt hat, auch nur eine einzige Vorhersage zu machen, die in einem Labor überprüfbar ist.

Dieses Problem hat eine Anzahl Beobachter dazu gebracht, in Frage zu stellen, ob die String-Theorie tatsächlich überhaupt eine Wissenschaft ist. Zum Beispiel hat Peter Woit in seinem Buch mit dem Titel ,Not Even Wrong‘ [etwa: Nicht einmal falsch] das Fehlen der Falsifizierbarkeit der String-Theorie beklagt: „Es ist eine niederschmetternde Tatsache, dass es absolut keinen Beweis irgendeiner Art gibt für diese komplexe und unattraktive Theorie“. Nichtsdestotrotz hat dies nicht verhindert, dass die Theorie von Anfang an in den Ruhmeshallen dominierte, zum Verdruss all jener, welche alternative Gedanken zur grundlegenden Struktur der Natur einbringen wollten. Das Problem: wenn eine Lehrmeinung erst einmal von denen übernommen wird, welche in der Lage sind, die zukünftige Richtung der Forschung zu diktieren, ist es sehr schwierig, diese Lehrmeinung zu überwinden. Zu Beginn war der Enthusiasmus für die String-Theorie verständlich, weil sie offenbar sehr vielversprechend war (8). Hat sich jedoch eine Theorie erst einmal eingenistet, kann der Enthusiasmus für sie genauso gut erklärt werden mit dem Wunsch, den Ruf und die Lebensweise derjenigen Individuen und Organisationen zu schützen, die so viel in die Entwicklung dieser Theorie investiert haben. Ein weniger zynisches Gefühl beschreibt der mathematische Physiker Roger Penrose in seinem Buch ,The Road to Reality‘ mit den Worten: „Der oftmals wilde Wettbewerb … führt zu Mitläufereffekten, wobei die Forscher fürchten zurückzubleiben, falls sie nicht mitmachen“.

Es ist heutzutage in Mode zu schreien „Verschwörungs-Theoretiker!“, wenn jemand die Legitimität der herrschenden Glaubensrichtung in Frage stellt. Allerdings braucht man nicht Zuflucht zu Täuschung zu nehmen, um die Dominanz der String-Theorie zu erklären. Eine solche Dominanz ist ein sich entwickelndes Phänomen, welches man erwarten sollte unter der Voraussetzung, dass die Dekane der Fakultäten natürlich all jene um sie herum fördern, welche ihre eigenen theoretischen Neigungen teilen. Und angesichts des involvierten Drucks ist es unwahrscheinlich, dass angehende Wissenschaftler das Fehlen irgendwelcher Integrität hinter ihrem gewählten Studienfach sehen. Nichtsdestotrotz bleibt die Tatsache bestehen, dass viele Universitäten an einem Punkt angekommen sind, an dem es extrem schwierig ist, Forschungsgelder zu bekommen für die Erforschung irgendeiner anderen Theorie außer der String-Theorie. (9).

Als Nicht-Experten in einer bestimmten wissenschaftlichen Disziplin kann der Rest von uns sich nur auf einen wissenschaftlichen Konsens verlassen, um zu bestimmen, wo möglicherweise die Wahrheit liegt. In unserem Beispiel, falls jemand eine Umfrage unter unter theoretischen Teilchen-Physikern durchführen und sie fragen würde, welche der miteinander konkurrierenden Theorien der vielversprechendste Kandidat als Theorie für Alles ist, würde das Ergebnis der Umfrage unweigerlich zugunsten der String-Theorie ausfallen. Allerdings reflektiert dies lediglich die Vorherrschaft von String-Theoretikern innerhalb dieses Bereiches.

Natürlich können wir auch den Praktikern beim Diskutieren zuhören und entscheiden, wer das schlagende Argument vorbringt. Unglücklicherweise jedoch kann man Argumente nur mit anderen Mitteln zusammentragen als mit der Referenz zu unwiderlegbaren Fakten. Angesichts des Fehlens überzeugender experimenteller Beweise beginnen derartige Diskussionen oftmals mit besten Absichten hinsichtlich von Werten wie mathematischer Eleganz, bevor das Ganze in die Art von miesem Spiel degeneriert, das Akademiker anscheinend auszeichnet. Und wehe denjenigen, welche es wagen, die Integrität des betreffenden Forschungsbereiches in Frage zu stellen. In seinem Buch ,The Trouble With Physics: The Rise of String Theory, the Fall of Science and What Comes Next’ beschreibt der theoretische Physiker Lee Smolin einen leidenschaftlichen Aufruf zu einer frischen und ehrlichen Bewertung des State of Affaires innerhalb der theoretischen Teilchen-Physik. Dafür erhielt er die folgende Beurteilung von Luboš Motl (10):

„…Die Konzentrierung irrationaler Statements und anti-wissenschaftlicher Gefühle hat meine Erwartungen übertroffen…“

Antiwissenschaftlich? Wo habe ich das schon einmal gehört? Es scheint eine seltsame, einer Erklärung bedürfende Tatsache zu sein, dass jedem, der sich für die Rückbesinnung auf wissenschaftliche Prinzipien einsetzt, schließlich der Vorwurf gemacht wird, er sei antiwissenschaftlich. Zumindest, soweit ich das sehe, ist noch niemandem der Vorwurf gemacht worden, ein ,String-Leugner‘ zu sein. Aber selbst ohne das ist die Debatte hitzig genug, um den Terminus ,String Wars‘ aufzuwerfen.

Ich sollte darauf hinweisen, dass selbst jene, die hinsichtlich des Zustandes der theoretischen Physik am meisten besorgt sind, nicht fordern, die String-Theorie zu verwerfen. Vielmehr lenken sie einfach Aufmerksamkeit auf die Probleme der experimentellen Verifikation und warnen, dass diese Ergebnisse in einem Freiraum der Spekulation führen, der nicht ganz gesund ist. Hinsichtlich des Überlebens von Theorien, wenn es keine natürliche Selektion mittels Experimente gibt, wird oftmals die Selektion mit soziologischen Mitteln an die Stelle treten. Die Folge davon ist, dass Konsens nicht länger erreicht wird durch Reduktion epistemischer Unsicherheit, sondern durch eine Verengung des Blickwinkels.

Vorsicht vor dem Bias

Klimatologen, die hinsichtlich düsterer AGW-Prophezeiungen übereinstimmen, sind also nicht mehr (oder weniger) fehlgeleitet oder unaufrichtig als die Horden theoretischer Teilchen-Physiker, welche die String-Theorie vorantreiben und erforschen. Auch hier wollen wir ehrlich sein, wenn man es isoliert betrachtet, ist etwas dran an dem AGW-Argument, trotz der zentralen Rolle von Prophezeiungen, welche nicht innerhalb des erforderlichen Zeitrahmens falsifiziert werden können. Allerdings würde man sich sehr viel wohler fühlen, wenn man das als Nominalwert [face value] akzeptiert, falls man nicht den Verdacht hegt, dass die Gelegenheit zur Entwicklung von Gegenargumenten durch nicht wissenschaftliche Mittel vereitelt worden wäre. Es ist sehr beunruhigend, dass das AGW-Argument künstlich gestärkt worden sein könnte durch Bestätigungs-Verzerrung [confirmation bias]. Können wir unter diesen Umständen sicher sein, dass wir nicht unsere eigene Ignoranz ignorieren?

Außerdem gab es keine andere wissenschaftliche Kontroverse, die so viel politische Einmischung über sich ergehen lassen musste oder der auch nur annähernd so viel Medienaufmerksamkeit zuteil wurde als es bei der Klimatologie der Fall ist. Ich sage ,über sich ergehen lassen musste‘, weil trotz eines erbärmlichen Fehlens von Qualifikationen dafür es niemanden in der Politik oder im Medienbereich zu geben scheint, der einem nicht mit Sicherheit sagen kann, welche Seite der Debatte recht hat: Alle düsteren Warnungen vor AGW sind die Wahrheit, und jedermann der dies bezweifelt, ist ein Lümmel. Da man von allen Bürgern fordert, die Wissenschaftler zu unterstützen (die wirklichen Wissenschaftler), sind wir doch alle glücklich, dass wir die Medien und Politiker haben, welche uns durch die Feinheiten der Debatte führen. Wir können nicht hoffen, zwei zuverlässigere und vertrauenswürdige Sektoren der Gesellschaft zu haben, die uns über die Stärke des Konsens‘ aufklären und genau beschreiben, wer die Spinner, Amateure oder verlogenen Skeptiker sind.

Und natürlich sei Gott Dank für das Internet. Der kleine Teil davon, der sich nicht der Pornographie verschrieben hat, scheint dominiert zu sein durch vermeintlich unwiderlegbare Argumente für die eine oder andere Seite der ,CAGW-wird-uns-töten‘-Debatte. Für jemanden mit einem offenen Geist, der die Wahrheit zu finden versucht, ist es zu naheliegend, verzweifelt aufzugeben. Und für den Rest von uns, wir bilden unsere Ansichten auf der Grundlage emotionaler Impulse und bringen den Rest unserer Leben damit zu, uns in Post-Hoc-Rationalisierung zu üben und nach den Informationen zu schauen, welche den von uns gewählten Bias bestätigen. Im Falle globale Erwärmung ist es unglücklicherweise so, dass Individuen aller Glaubensrichtungen immer in der Lage sein werden, die Ermutigung zu finden, nach der sie suchen.

Wenn die Einsätze steigen

Ich habe hier argumentiert, dass es in der CAGW-Kontroverse kaum etwas gibt, das man nicht auch anderswo innerhalb der Wissenschaft findet, wenn erst einmal der feste experimentelle Griff gelockert ist. Sowie dies der Fall ist, brechen bittere Debatten aus zwischen den beiden Seiten der gegensätzlichen Positionen. Trotzdem entwickelt sich ein Konsens, aber der Konsens ist von fragwürdigem Wert, weil es gute Gründe gibt für den Verdacht, dass Auswahleffekte signifikant sind. Individuen, welche den Konsens in Frage stellen, werden als antiwissenschaftlich gebrandmarkt, selbst wenn deren wissenschaftliche Leistungen über alle Zweifel erhaben sind. Wissenschaftler fühlen sich angegriffen, obwohl sie sich selbst deutlich helfen würden, sorgfältiger zu sein bei der Vermeidung unfalsifizierbarer Spekulationen.

Es gibt natürlich Unterschiede zwischen Physik und Klimatologie. Zum Beispiel wird die Lage in der Klimatologie verschlimmert durch ein politisch motiviertes Leugnen der Unsicherheiten und einem Fehlen von Überzeugung gegenüber Offenheit und Reproduzierbarkeit von Ergebnissen. Auch die Einsätze sind viel höher, und da liegt es in der Natur der Sache, dass wir alle eingeladen werden, an der Teegesellschaft teilzunehmen. Allerdings fühle ich mich genau wie bei der Super-Symmetrie-String-Theorie nicht qualifiziert, als Schiedsrichter zu fungieren. Alles, was ich sagen kann ist, dass es so zu sein scheint, als ob Argumente bestehen bleiben, weil alle Seiten so hoch motiviert und keine Experimente zur Beilegung verfügbar sind. Unter diesen Umständen hätte ich gedacht, ein offener Geist sei eine vernünftige Haltung, die ein Laie einnehmen kann. Unglücklicherweise steht die Toleranz von Skeptizismus nicht mehr auf der Tagesordnung, und jeder, der wissenschaftliche Autorität in Frage stellt, wird als unvernünftig angesehen. Die wirkliche Verletzung wissenschaftlicher Prinzipien ist jedoch, dass Wissenschaft ,settled‘ sein kann, ohne dass man darauf warten muss, dass Prophezeiungen eintreffen.

Ursprünglich umgingen Politiker das Problem der fehlenden Falsifizierungs-Möglichkeit, indem sie das Vorsorgeprinzip auf den Schild hoben, wobei die Plausibilität eines Gedankens ausreicht, ihn so zu behandeln, als ob es sich um eine bestätigte Tatsache handelt. In der Klimatologie war also nicht nur die Falsifizierung von Gedanken technisch schwierig, es wurde nicht einmal für notwendig erachtet. Aber dies war eine offenkundige politische Haltung: Eine Entscheidung zu verschieben, bis alle Unsicherheiten beseitigt sind, enthält ein existentielles Risiko, und darum ist es politisch weise, die Entscheidung jetzt zu fällen. Nichtsdestotrotz ist das Vorsorgeprinzip für seine sich selbst zerstörende Logik berüchtigt. Wenn der Preis für eine Maßnahme potentiell katastrophal ist (was durchaus sein kann, wenn man sich die von den CAGW-Befürwortern geforderten drastischen Aktionen vor Augen führt), dann kann das Vorsorgeprinzip auch herangezogen werden, um gegen derartige Maßnahmen vorzugehen. Unsicherheit schneidet beide Wege, und vielleicht ist dies der Grund, warum die Leugnung von Unsicherheit das Vorsorgeprinzip in den Köpfen vieler Menschen usurpiert zu haben scheint als bevorzugte Politik.

Mark Twain hat besser als die meisten Anderen verstanden, wie einfach es ist, von Vermutungen hinweg getragen zu werden, wenn Beweise selten sind, aber ich bezweifle, dass selbst er voll erkannt hatte, wie einfach derartige Vermutungen auf mysteriöse Weise zu Wahrheiten werden können, falls die Einsätze steigen. Man braucht keine Tricks, um dies zu erreichen, obwohl es überraschend ist, zu was sich einige Befürworter hinreißen lassen um sicherzustellen, dass die ,rechtschaffene‘ Seite der Argumentation gewinnt. Falls man mich fragt, ich würde die Unsicherheiten jedoch akzeptieren und das gefürchtete Vorsorgeprinzip aktivieren. Obwohl alles andere als ideal ist dies eine bessere Option als das Herunterspielen von Unsicherheiten bis zu einem Ausmaß, dass ein offener Geist hinsichtlich eines fragwürdigen Konsens‘ als ein Zeichen krimineller Dummheit angesehen wird. Schließlich ist Skeptizismus der Kompass für wissenschaftliche Geister. Also frage ich noch einmal: Was ist mit der Wissenschaft passiert?

Der Autor John Ridgway ist Absolvent der Physik, der bis vor Kurzem in UK als Software-Experte und als Analyst für das Transportwesen gearbeitet hat. Er ist kein Klimawissenschaftler und nicht Mitglied des IPCC, fühlt sich aber als Repräsentant der vielen gebildeten und rationalen Zuschauer, die glauben, dass das hysterische Geschrei gegen Laien-Skeptizismus sowohl unberechtigt als auch kontraproduktiv ist.

Anmerkungen:

1.Siehe http://www.spiked-online.com/newsite/article/6320#.WWu5mGeWzZ4

2. Für weitere Informationen siehe Storch, Hans von; Zwiers, Francis (1999). Statistical Analysis in Climate Research. Cambridge University Press. ISBN 0 521 45071 3.

3. Ich sollte erklären, dass Unsicherheit nach Art eines Würfels aus Zufalls-Fluktuation resultiert. Sie reflektiert die Variabilität der realen Welt und kontrastiert als solche mit der epistemischen Unsicherheit (unsere Wissenslücken) und ontologischer Unsicherheit (Unsere Wissenslücken hinsichtlich unserer Wissenslücken).

4. Diejenigen, die in Frage stellen, dass das Frisieren von Klimamodellen im Nachhinein allgemeine Praxis ist, sollten schauen bei Hourdin Frédéric, et al (2017). The Art and Science of Climate Model Tuning. American Meteorological Society, Journals Online.

5. Viel wurde aus der Tatsache gemacht, dass das IPCC erfolgreich gegen den Artikel in der Wasington Post geklagt hat, in welcher dieses Zitat erschienen war. Die Grundlage der Klage war, dass im Artikel nicht erwähnt worden war, dass Seitz kein Klimatologe war, kein Mitglied des IPCC, auf der Lohnliste einer Ölgesellschaft stand und dass zuvor ihm jemand Senilität vorgeworfen hatte. Weil sie keinen Ad-Hominem-Angriff auf ihren Interviewpartner geführt hatte, hat die Washington Post die journalistische Ausgeglichenheit fehlen lassen, welche vom IPCC verlangt wird! Noch relevanter ist, dass das IPCC auch erfolgreich geltend gemacht hat, dass die Änderungen keine Korruption ihres Begutachtungsprozesses darstellen. Damit wird natürlich stillschweigend zugegeben, dass solche Änderungen vorgenommen worden waren.

6. Siehe Steve McIntyre auf seiner Website Climate Audit.

7. Anders als die Fähigkeit zur Falsifizierung steht die Reproduzierbarkeit von Ergebnissen als prinzipielle Erfordernis des wissenschaftlichen Verfahrens. In dieser Hinsicht scheitern viele wissenschaftliche Disziplinen derzeit grandios; darum die Krise. Die meisten, wenn nicht alle Erklärungen hierfür sind auf Klimatologie anwendbar. Bei dieser Gelegenheit habe ich als mein Hauptthema Falsifizierbarkeit gewählt anstatt Reproduzierbarkeit der Ergebnisse. Vielleicht beim nächsten Mal…

8. In particular, superstring theory equations predict the existence of a spin-2 boson that has all of the properties expected of the force-carrying particle posited by a quantum field theoretic description of gravity (namely, the graviton). This prediction paves the way for an understanding of gravity that is unified with the so called Standard Model of particle physics. [Man sehe mir nach, dass ich das nicht übersetze! Anm. d. Übers.]

9. Weitere Informationen: Woit, Peter (2006). Not Even Wrong: The Failure of String Theory and the Search for Unity in Physical Law. Basic Books. Ch. 16. ISBN 0-465-09275-6.

10. Motl, Luboš (2004). “Lee Smolin: The Trouble with Physics”: a review on The Reference Frame.

Link: https://wattsupwiththat.com/2017/08/10/so-what-happened-to-the-science/

Übersetzt von Chris Frey EIKE