„Der Welt geht das Öl nicht aus“

Und dann passierte das Unerwartete.

Unkonventionelle Ressourcen erlebten ihre Blühte in den USA. Mit steigender Rohölproduktion hörte die U.S. auf, überschüssige Ölmengen der Welt zu benötigen.

Anstatt die Rohölproduktion zu reduzieren, um den Markt auszugleichen, hat Saudi-Arabien die Produktion erhöht, um seinen Marktanteil zu schützen.

Und ta-da! – Wir haben eine globale Flut von Rohöl und Flüssigkeiten, zusammen mit einem wirklich großen Preiskollaps. Heute werden Sie eher hören, dass die Leute über einen möglichen weltweiten Höhepunkt der Ölnachfrage sprechen, anstatt über einen Höhepunkt der Ölproduktion.

Aber die Hauptargumente für Peak Oil haben sich kaum verändert.

Roosevelt 1908

U.S. Präsident Theodore Roosevelt, 13. Mai 1908:

Vergessen wir für den Augenblick moralische Ziele, so ist es sicher zu sagen, dass der Wohlstand unseres Volkes direkt von der Energie und Intelligenz abhängt, mit der unsere natürlichen Ressourcen verwendet werden. Ebenso ist klar, dass diese Ressourcen die Grundlage nationaler Macht und unveräußerlicher Besitz sind. Letztendlich ist es jedoch offensichtlich, dass diese Ressourcen in Richtung einer schnellen Erschöpfung laufen.

Der Jüngste Tag ist abgewandt

Das Konzept des Peak Oil entwickelte sich aus einer Theorie des amerikanischen Geowissenschaftlers M. King Hubbert. Basierend auf den Schätzungen der Gesamtreserve – und dem Muster und der Geschichte der Ölfeld Entdeckungen in den Vereinigten Staaten, kreierte Hubbert eine zusammengesetzte Mega-Rückgangs-Kurve, die der U.S.-Rohölproduktion voraussagte, sie würde in der Zeit von 1965-70 ihre Spitze erreichen.

Und die U.S. Ölproduktion erreichte einen Höhepunkt, ein wenig später als es die ursprüngliche Hubbert-Kurve vorhergesagt hatte. Aber mit der Entdeckung von North Slope Oil in Alaska, begann sie die Produktion wieder zu erhöhen. Die inländische Peak Oil Schätzung wurde als die Unteren 48 [Bundesstaaten] Vorhersage neu gekennzeichnet.

Nun scheint es, dass der Ansatz von Hubbert, ein Profil für die konventionelle Ölförderung in einem definierten geografischen Gebiet prognostiziert, wenn die technologische Entwicklung und der Ölpreis innerhalb begrenzter Limits bleiben.

„Wenn die Leute fragen, „wie viel Öl gibt es noch „, lautet die Antwort: „Zu welchem Preis?“, bemerkt Sternbach. „Dinge wie Ölsand [tar sands] können riesige Mengen Öl zum richtigen Preis freigeben.“

Durchbrüche in der Technik, vor allem bei horizontalen Bohrungen und hydraulischen Frakturen – nennen wir sie „hydrozontale Entwicklung“ – kombiniert mit den heutigen verbesserten Explorations- und Produktionswerkzeugen, haben den Rückgang der US-Ölproduktion umgekehrt.

In ihrer Juni Energievorhersage prognostiziert die US-Energiebehörde, dass die US-Rohölproduktion im Jahr 2018 ein Allzeithoch von mehr als 10 Millionen Barrel pro Tag (b/d – barrel per day) erreichen wird, zusammen mit 4,19 Millionen b/d Erdgasflüssigkeiten und 1,02 Millionen b/d Ethanol.

Anstatt Peak Oil, hat die Welt den Blick auf eine neue Energie-Zukunft bekommen.

Innovation ist „Erhöhung des Wertes der Ressourcen und es ist die Verringerung der Kosten um sie zu fördern. Wenn diese beiden Dinge sich vereinen, kommen Sie zu einem optimalen wirtschaftlichen Antrieb“, sagte Sternbach. „Das ist ein Paradigmenwechsel, der Aufschwung von erhöhtem Wert schafft.“

Siehe Aufmacherbild: Die originale Hubbert Kurve mit moderner Graphik dargestellt (AAPG Explorer)

Hubberts Original 1956er Studie finden Sie hier.

Hubbert bringt Wachstum und Verfall der Ölförderung in eine Formel (Hubbert Math).

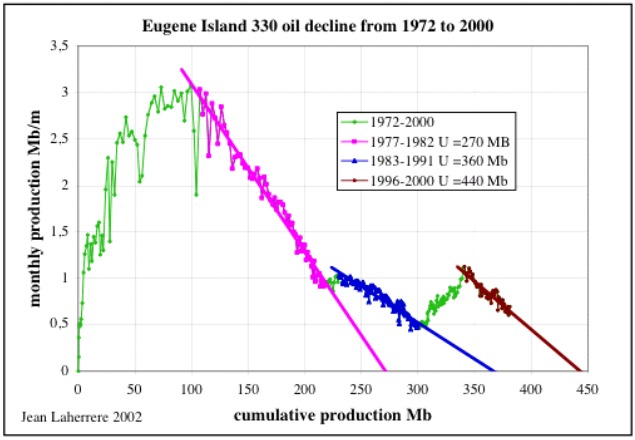

„Peak Oil“ ist eine Grundfunktion der Ressourcenextraktion. Die maximale Produktion erfolgt in der Regel, wenn etwa die Hälfte der nutzbaren Ressource extrahiert wurde. Das Eugene Island 330 Ölfeld im Golf von Mexiko ist ein gutes Beispiel:

Grafik 2. Eugene Island 330 Ölfeld, Förderrate vs kumulative Produktion (Quelle: The Oil Drum) … (Bevor jemand zu schwätzen anfängt, The Oil Drum wäre eine Peak Oil Propaganda Website, die EI 330 Grafik ist korrekt. Ich kann es aus Produktionsdaten reproduzieren, für jeden, der eine Lizenz für die OLL-Datenbank von Lexco besitzt.)

EI 330’s erster Peak tritt bei etwa der Hälfte der Extraktion der ersten 250 Millionen Barrel Öl auf. Alte Ölfelder, besonders große alte Ölfelder, werden oft mehrere sekundäre Produktionsspitzen aufweisen. Im Fall von Eugene Island 330 waren die sekundären Gipfel eine Kombination von guten Wiederholungen, Nebenbohrungen und begrenzter [Wieder-] Aufladung von einigen der Reservoirs (Nein, dies ist kein Beweis für abiotisches Öl).

Die Hubbert-Gleichung ist eine gültige Methode zur Vorhersage der Spitzenrate der Ressourcenextraktion. Denn, die Tatsache, dass „der Welt das Öl nicht ausgeht“, lässt die Gleichung oder das Konzept von „Peak Oil“ nicht ungültig werden.

08. SEP., 2016

Robert Rapier, Mitwirkender

Was Hubbert über Öl wirklich falsch gemacht hat

[…]

Hubberts Ruhm in Spitzenöl-Kreisen kommt in erster Linie aus der Behauptung, dass er genau den 1970 U.S. Peak vorhergesagt hat. Wegen dieser Vorhersage ist Hubbert bei den Peak Oil Anhängern weithin als Visionär angesehen. Er ist ein Orakel und ein Prophet genannt worden. Ein kürzlich veröffentlichter Artikel – What Hubbert And Pickens Got Right About Oil, And What’s Next [Wo Hubbert und Pickens über Öl richtig lagen und Was kommt nun] – erzählt die unheimliche Genauigkeit seiner Vorhersage.

Die Wahrheit ist jedoch viel nuancierter. Hubbert lag bei eine Menge von Dingen ungeheuerlich falsch, und seine oft verkündete 1970 Vorhersage enthält eine große Einschränkung, die den meisten Menschen nicht bewusst ist. Hier ist, was seine 1956 Studie tatsächlich angab:

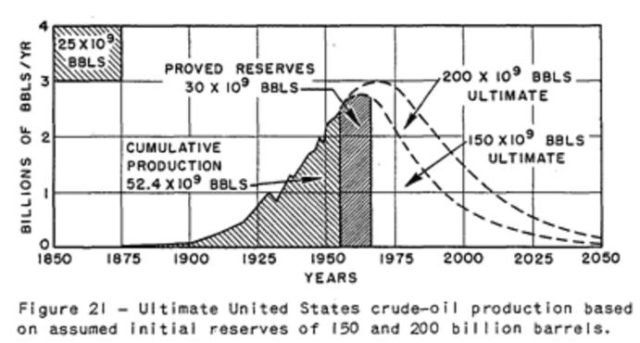

Hubbert schätzte, dass die endgültige potenzielle Reserve der unteren 48 U.S. Staaten und Offshore-Gebiete bei 150 Milliarden Barrel Öl läge. Basierend auf dieser Reserve-Schätzung, und den 6,6 Millionen Barrel pro Tag (bpd) Extraktionsrate im Jahr 1955 und die Tatsache, dass 52,5 Milliarden Barrel Öl kumulativ bereits produziert worden waren, schätzte Hubbert, dass die Ölproduktion in den USA ihre maximale Produktion im Jahr 1965erreichen würde. Das war seine Grundvorhersage. Er schrieb: „Die Kurve muss in etwa 1965 gipfeln und muss dann mit einer Rate abnehmen, die mit ihrer früheren Wachstumsrate vergleichbar ist.“ Hubbert veranschaulichte diesen 1965-Gipfel in seinem Paper:

Quelle: Nuclear Energy and the Fossil Fuels by M. King Hubbert

Wie in der Abbildung gezeigt, projizierte Hubbert im Jahre 1965 eine US-Ölproduktionsspitze mit einer jährlichen Produktionsrate von etwa 2,8 Milliarden Barrel oder 7,7 Millionen Barrel pro Tag (bpd). Beachten Sie jedoch, dass es eine weitere Kurve gibt, die oberhalb und weiterführend über die Spitze von 1965 hinausgeht. Dies war Hubberts „Kontingenzfall“. Er berechnete, dass, wenn die US-Ölreserve 200 Milliarden Barrel wäre, der Höhepunkt im Jahr 1970 stattfinden würde, eine Verzögerung von fünf Jahren gegenüber seinem Basisfall. Allerdings zeigte er Skepsis gegenüber einer so hohen Reserve und bemerkte, dass dies „einen Betrag in Höhe von acht Ost-Texas-Ölfeldern“ implizieren würde – weit mehr als die Schätzung von 150 Milliarden Barrel. Dennoch, falls die US-Reserve so hoch wie 200 Milliarden Barrel wäre, schätzte Hubbert eine Spitze der U.S. Ölproduktion in 1970 von 3 Milliarden Barrel oder 8,2 Millionen bpd. Die Ölproduktion in den USA erreichte im Jahr 1970 tatsächlich eine Spitze, wenn auch bei 9,6 Millionen bpd.

Während Hubberts Vorhersage in der Größenordnung korrekt war, scheint denjenigen, die ihn zitieren, nicht bewusst zu sein, dass seine „perfekte“ 1970-Vorhersage auf einem sekundären Fall beruhte, über den er Skepsis ausdrückte und die angenommene Fördermenge um etwa 15% zu niedrig war. Hubbert’s base case — a prediction made in 1956 of a 1965 peak — was off by 5 years and was 20% too low [Hubbert’s Basismodelle – eine Vorhersage im Jahr 1956 über einen 1965er Peak gemacht – lag um 5 Jahre daneben und war 20% zu niedrig – der letzte Satz ist mit Twitter verlinkt, funktioniert jedoch nur mit Anmeldung.]. Oder anders ausgedrückt, seine Kernaussage zu dieser Zeit war, dass die Ölproduktion der U.S. noch 9 Jahre lang ansteigen würde, aber sie erreichte ihr Maximum nach 14 Jahren und bei 15% höherer Produktion als projiziert.

Mein Punkt hier ist, seine Vorhersagen der Ölproduktion basiertem auf dem, was er eigentlich geschrieben hat. Mehr noch, als jemand, der häufig Vorhersagen macht, würde ich sagen, dass seine Vorhersagen über die Ölproduktion von U.S. ziemlich gut waren. Sie waren nicht prophetisch oder fast genauso genau wie viele Peak-Oil-Anhänger annehmen. Aber sie lagen in der Größenordnung.

Doch wenn wir uns anschauen, was er über die weltweite Ölproduktion und die Erdgasproduktion zu sagen hatte, dann waren seine Vorhersagen weit daneben. Er kam zu einer Schätzung der endgültigen konventionellen Ölproduktion der Welt durch Vergleich einer Reihe von Schätzungen. Er setzte eine Schätzung von 1,25 Billionen Barrel für die ultimative potentielle konventionelle Ölproduktion ein. Wir wissen jetzt, dass diese Schätzung viel zu niedrig war. Aber auf dieser Schätzung projizierte Hubbert, dass die globale Spitze in der Rohölproduktion um das Jahr 2000 mit 34 Millionen bpd auftreten würde [der letzte Satz ist mit Twitter verlinkt, funktioniert jedoch nur mit Anmeldung.] In Wirklichkeit war die Rohölproduktion im Jahr 2000 mehr als doppelt so hoch bei etwa 75 Millionen bpd. Während die konventionelle Rohölproduktion sich im Jahr 2005 abflachte, gibt es nach mehr als einem Jahrzehnt später keine Anhaltspunkte dafür, dass die Ölausbeute damit begonnen hat, weniger zu werden. (Die globale Produktion hat sich weiter erhöht, vor allem wegen des Anstiegs der Schieferölproduktion). Das hatte Hubbert nicht voraus gesehen.

Hubbert-Verteidiger werden argumentieren, dass er nur das Datum des konventionellen Rohölpeaks um 5 Jahre verpasst hat. Aber seine Methodik legt einen Höhepunkt und Niedergang fest. Das ist nicht das, was tatsächlich eingetreten ist. Solange die konventionelle Rohölproduktion nicht ernsthaft abnimmt, wissen wir wirklich nicht, wie weit daneben seine Vorhersage vom Peak 2000 sein wird.

[…]

Forbes [Link zur Homepage – in deren Suchfeld (rechts oben) Hubbert eingeben]

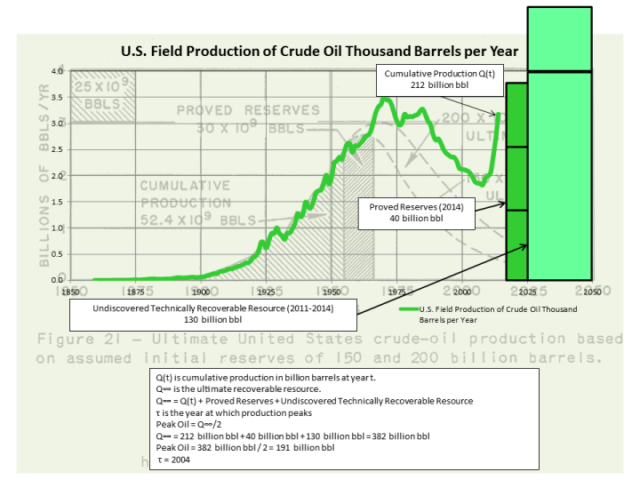

Hubbert unterschätzte schlicht das Gesamtvolumen des abbaubaren Öls (vergangene Produktion + bestätigte Reserven + zukünftige Entdeckungen).

.

.

Figure 3. Hubbert Curve, US. mit 2014er Produktion, Reserven and geschätzten unendeckten Reserven

Wenn wir davon ausgehen, dass die bestätigten U.S. Ölreserven und die [damals] noch nicht entdeckten, abbaubaren Ressourcen abgenommen hätten, wäre der Hubbert „Peak“ für die USA im Jahr 2004 aufgetreten. Denken Sie daran, dass die Hubbert-Kurve nicht als exakt an die Daten angepasst verstanden werden sollte. „Hubbert math“ passt zu den Daten der Kurve. Der „Hubbert-Peak“ wäre zwischen den beiden tatsächlichen Spitzen aufgetreten. Ein alternativer Ansatz wäre, die Produktion in zwei Phasen zu betrachten, mit zwei getrennten logistischen Funktionen. In jedem Fall, wenn die bestätigten Reserven und die geschätzten unentdeckten, abbaubaren Ressourcen nicht mehr angestiegen wären, wären wir derzeit in der Nähe von Peak Oil.

Die Welt erwartet die „schnelle Erschöpfung“ der Rohöllieferungen seit mindestens 100 Jahren.

Wird es für die nächsten 100 so weiter gehen, immer kurz vor dem versiegen der Ölquellen?

Da die bestätigten Reserven im Laufe der Zeit voraussichtlich weiter wachsen und die gesamten, noch nicht entdeckten Ressource wahrscheinlich abnehmen, wird Peak Oil für die absehbare Zukunft voraussichtlich erhalten bleiben. Die Antwort ist ein qualifiziertes „Ja“ – Menschen, die das Konzept des Peak Oil nicht erfassen, werden die „schnelle Erschöpfung“ des Rohöls für viele weitere Jahre erleben.

* * *

Im Interesse der vollständigen Offenlegung: Ich bin seit 1981 in der U.S. Ölindustrie als Geophysiker / Geologe beschäftigt, mit einem sechsjährigen Exil im Management. Ich habe immer für „kleines Öl“ gearbeitet (im Gegensatz zu BIG OIL). Ich bin Mitglied der American Association of Petroleum Geologen (AAPG), Society of Exploration Geophysicists (SEG) und Houston Geological Society (HGS). Ungeachtet meiner Vorliebe für lächerliche Greenschisten, ist grün eigentlich meine Lieblingsfarbe … Öl wird grün auf Landkarten und Bohrloch-Protokolle dargestellt. Peak Oil ist echt, aber nicht wirklich relevant, abiotisches Öl ist möglich (trotz aller fehlenden Beweise dafür [dieses wird von anderen Forschern anders gesehen, der Übersetzer]) und ist auch irrelevant. Weder die Realität von Peak Oil noch der Mangel an Beweisen für abiotisches Öl ist Teil einer Verschwörung, um den Ölpreis hoch zu halten. Wenn es so wäre, wäre es eine ziemlich schlechte Verschwörung, weil die Ölpreise in der meisten Zeit meiner Karriere niedrig waren. Und nein, ExxonMobil versteckt nicht die geheime Formel für das Umwandeln von (setzen Sie an diese Stelle ein, was Sie meinen) in Öl … Aber sie wussten alles über Gorebal Warming laaange bevor Al Gore es erfand … Sie wussten, dass es falsch war.

Wie üblich ist jeder Sarkasmus rein vorsätzlich … Außer dem bisschen über Gorebal Warming.

Erschienen auf WUWT vom 10.07.2017

Übersetzt durch Andreas Demmig

https://wattsupwiththat.com/2017/07/10/the-world-keeps-not-running-out-of-oil/

Ergänzung durch den Übersetzer:

Am Anfang dieses Beitrages wurde das damalige Original Dokument von Mr. Hubbert .pdf verlinkt.

Der Titel der Ausarbeitung lautet: Kernenergie und fossile Brennstoffe

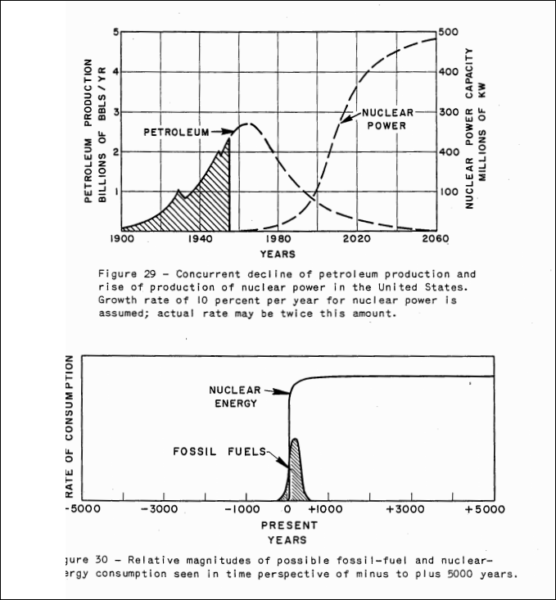

Ich habe es im Groben überflogen und auf Seite 52 / 53 das hier gefunden:

Unter der Überschrift: Zukunftsperspektive, wagt Herr Hubbert einen Ausblick um 5.000 Jahre in die Zukunft. Fossile Brennstoffe werden erschöpft sein, nur ein Wimpernschlag in der Geschichte. Aber es besteht Hoffnung, das die Menschheit das Energieproblem gelöst haben wird (und sich nicht selbst ausgelöscht) und auch die Geburtenkontrolle im Griff haben wird. Dann wird es die Kernkraft als Energiequelle der Zukunft erschlossen haben. Dass er den Anstieg der Kernkraft ab etwa dem Jahr 1980 sieht – zu mindestens für die Welt – (und nicht für Deutschland,) zeigt den damaligen noch unverkrampften Blick auf die Innovationsfähigkeit der Ingenieure und Wissenschaftler.

Quelle wie oben beschrieben.