Das Geschäft mit der Angst basiert beim Feinstaub auf folgender WHO-Aussage:

„Im Jahr 2012 (Anmerkung: Das Jahr ist beliebig austauschbar) sind laut einer Schätzung rund sieben Millionen Menschen weltweit an Erkrankungen gestorben, die mit verschmutzter Luft in Zusammenhang stehen.“

Diese Aussage ist aus zweierlei Gründen nicht zu beanstanden:

- Und da ist von „In Zusammenhang stehen“ die Rede. Wieder so eine Konjunktiv-Aussage, die nichts wert ist: Unser Leben steht auch mit unserem Tod im Zusammenhang…

Solche Konjunktiv-Aussagen sind ähnlich zutreffend, wie, die Erde kann von einem übergroßen Meteoriten getroffen werden, wobei letzteres indes wahrscheinlicher ist, als durch Feinstaub zu sterben.

Der Spiegel macht denn aus solch einer Nullmeldung (Dass sie eine Lachnummer ist, wird der Autor gleich zeigen):

„WHO Luftverschmutzung offiziell als Krebsursache eingestuft“

Was ist aus diesem Magazin geworden, welches der Autor seit 1973 regelmäßig, über 30 Jahre lang, las? Der dortige Redakteur hat in seiner Aussage den Satzfüller „offiziell“ benutzt. Solche Attribute werden üblicherweise dann verwendet, will man eine Nullnummer, der nichts zu entnehmen ist, aufwerten und ihr dadurch einen fundierten Charakter verleihen möchte!

Aus „Luftverschmutzung“ wurde dann die Ableitung erstellt, das „Feinstaub“ Krebs verursacht, was nun völliger Unsinn ist, wie der Autor gleich zeigen wird. Wogegen man „Luftverschmutzung“ in Verbindung mit dem Konjunktiv, also “kann“, gerade so durchgehen lassen kann – immerhin ist die stärkste bekannte Luftverschmutzung, das Rauchen, als entsprechend schädlich bekannt, obwohl auch dieses kein Garant für Krebs ist, wie das Beispiel unseres Altbundeskanzlers Helmut Schmidt zeigt – so einfach ist Krebs nun auch wieder nicht zu verstehen, sonst wäre er längstens heilbar. So ist die Feinstaubbelastung für eine mögliche Krebserkrankung schlichtweg auszuschließen. Doch begeben wir uns nun in die molekularen Ebenen, in denen die o.g. Krankheiten ihren Ursprung und damit ihre Ursache haben.

Oben wurde das Beispiel unseres Altbundeskanzlers genannt, der trotz intensivem Rauchen, weit über 90 Jahre alt wurde und damit fast 20 Jahre länger, als die mittlere Lebenserwartung lebte, trotz Rauchen. Demnach sollte es Faktoren geben, die langes Leben unterstützen und den Ausbruch der Krankheit verhindern. Die gibt es auch und dies sind:

- Unsere genetische Ausstattung (wobei die durch die entsprechenden Gene produzierten Proteine und der mit ihnen verbundenen Steuerungssequenzen das entscheidende Kriterium darstellen). Die Wissenschaft spricht vom individuellen Phänotyp.

- Unser menschliches Immunsystem, wobei es ein Immunsystem gar nicht gibt, sondern den Verbund zwischen dem angeborenen Immunsystem, dem adaptiven Immunsystem, dem zelleigenen Immunsystem, dem Zellkernimmunsystem, dem „Wächterrat“ (z.B.: Peyersche Plaques), den „Verbindungsgliedern“, sowie dem genetischen Immunsystem. Wobei beim letzteren nicht von einen Immunsystem gesprochen wird, weil keine Antigene im Fokus stehen, sondern komplexe Reparaturprozesse vorgenommen werden.

Krebs ist eine Gen-/Chromosomenkrankheit, die ausschließlich in dieser molekularen Ebene ausgelöst werden kann. Sog.Krebsgene können durch äußere Einflüsse entstehen, wie z.B. hochenergetische Strahlung, Giftstoffe (einige chemische Stoffe, man spricht von karzinogenen Stoffen) oder durch Viren. In den meisten Fällen entstehen Krebsgene jedoch durch innere Einflüsse (Eigenmutationen durch den Austausch von Basenpaaren im jeweiligen Gen oder falsch ablaufende Reparaturprozesse in der Doppelhelix des Genoms, z.B. Brustkrebs bei Frauen) der Zelle selbst, die keine(!) Beeinflussung von außen benötigen. Hierzu muss hinzukommen, dass unser adaptives Immunsystem, solche Zellen nicht erkennt und ausschaltet.

Diese Mutationen sind jedoch nicht selbst die Ursache von Krebszellen, sondern größtenteils ist Krebs das Ergebnis der dadurch veränderten Aktivität vieler andere Gene, die für wichtige zelluläre Regelmechanismen verantwortlich sind. So schalten einige Mutationen, Regel- und Überwachungsgene aus, andere erhöhen die Aktivität von Genen, die wiederum die Aktivität der Zelle erhöhen. Da meist (eine Ausnahme z.B. vererbte Krebsdisposition) mehrere Mutationen notwendig sind, um die vorgenannten Regelkreise anzustoßen, ist Krebs denn auch meist eine „Alterskrankheit“. Je früher sie im Alter auftritt, umso weniger ist unser Immunsystem in der Lage, sie in Schach zu halten. Von gut erforschten Krebsarten, wie dem Mammakarzinom, weiß man, dass etwa 1.000 Gene an der Entstehung eines Krebstumors beteiligt sind. Folgende sieben Grundeigenschaften muss eine Zelle aufweisen, damit aus ihr eine Krebszelle werden kann:

- Autonomie der Zellteilungssignale (Krebszellen erzeugen ihre eigenen Wachstumssubstanzen oder verstärken externe Wachstumssubstanzen)

- Unempfindlichkeit gegen wachstumshemmende Signale (das umliegende gesunde Gewebe sendet wachstumshemmende Signale aus, gegen die die Krebszellen unempfindlich sind)

- Deaktivierung des programmierten Zelltods = Apoptose (Mechanismen in der Zelle, gesteuert von zelleigenen Proteinen, werden unterdrückt)

- Unbegrenzte Teilungsfähigkeit (Krebszellen können die normalerweise – läuft über „mathematische“ Logik – begrenzte Anzahl von Zellteilungen umgehen)

- Neubildung von Blutgefäßen (Krebszellen senden Signale für die Bildung neuer Gefäße aus, mit denen sie mit Sauerstoff und Nährstoffen versorgt werden)

- Invasivität und Beweglichkeit (zellinterne Regelmechanismen hindern Zellen meist daran, zu wandern und in fremdes Gewebe einzudringen, Krebszellen sind unempfänglich für solche Signale, die diese Regelkreise steuern)

- Manipulation des Immunsystems (Krebszellen spannen z.B. Zellen des angeborenenImmunsystems für ihre Zwecke ein – zweckentfremdet). Makrophagen können Krebszellen entweder selbst abtöten oder Signale an die T-Zellen des adaptiven Immunsystems senden, welche dann die Zerstörung einleiten. Krebszellen können die Makrophagen jedoch regelrecht umerziehen, so dass sie sich regelrecht in Fabriken für Cytokine und Wachstumsfaktoren wandeln, die den Krebstumor wachsen lassen.

Zur Steuerung aller vorgenannten Eigenschaften dienen aus Aminosäuren, den chemischen Grundbausteinen des Lebens, bestehende Proteine / Enzyme. Feinstaub, als tote Materie, ist nie in der Lage, solche Signale zu steuern oder gar solche Stoffe herzustellen.

Um eine Krebsentstehung zu initiieren, müssen sich demnach sog. Schlüsselgene einer Zelle zu onkogenen Veränderungen anhäufen. Diese Zellen werden dadurch zu ungehemmtem Wachstum angeregt, wodurch dann eine Krebstumorzelle entstehen kann. Wie bereits gesagt, kann dies z.B. durch Genmutationen (durch die Evolution = springende Gene), durch hochenergetische Strahlung (Brüche in der Helix) entstehen oder durch aggressive chemische Substanzen, die direkt in die Zelle und deren Zellkern gelangen und dort das Erbgut direkt schädigen. Nun, das Feinstaub zu den Genen gelangt und dort sowohl Gene, wie Chromosomen schädigt ist der Wissenschaft bisher wohl entgangen.

Krebs ist weiter eine Krankheit von vielzelligen Lebewesen, worin die Erkenntnis verborgen ist, was Krebs eigentlich ist. Deshalb gibt es in der Krebsforschung Ansätze, ihn mit der Evolution zu erklären. Sozusagen als ein Nebenprodukt der Evolution, dass mit ihr entstanden ist. Nun wird niemand ernsthaft behaupten wollen, tote Materie wie Feinstaub, wäre ein Produkt der Evolution.

Gene und deren Proteine überwachen grundsätzlich jede Zellteilung und passen sozusagen darauf auf, wie sich eine Zelle vermehrt. Tut sie dies außerhalb vorgesetzter Regeln, so lösen diese Suppressorproteine entweder die Zellapoptose aus oder veranlassen das adaptive Immunsystem, die Zelle zu töten. Bei Krebs ist diese Kaskade, deren biologische Signalgebung, gestört.

Krebs kann weiter durch Viren, wie dem HPV-Virus (verursacht bei Frauen Gebärmutterkrebs, nicht zu verwechseln, mit HIV-Virus) verursacht werden. Nun, Viren und deren RNA können als lebende Organismen die Zelle „überlisten“, diese entern und ihre RNA zu den Genen/Chromosomen im Zellkern gelangen und dort aggressive Veränderungen vornehmen, wenn sie z.B. ihre Viren-RNA in das menschliche Genom einbauen oder Reparaturprozesse in den Chromosomen verhindern. Unser Genom besitzt übrigens eine Vielzahl von Virensequenzen, die sich im Laufe der Evolutionsgeschichte dort angehäuft haben. Die meisten davon sind unkritisch.

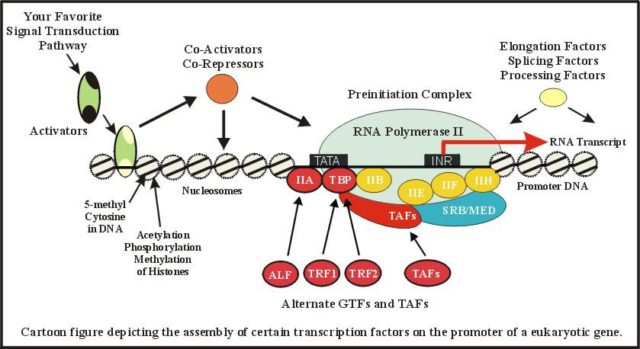

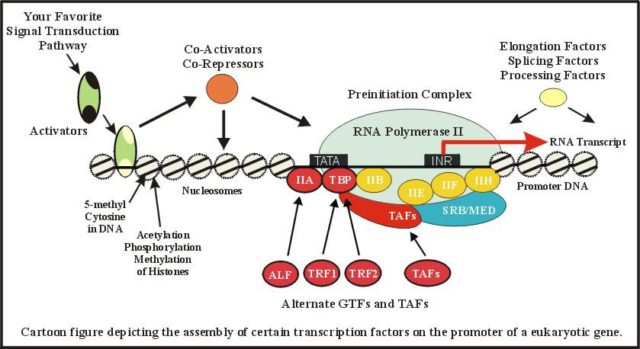

Damit eine Krebszelle überhaupt entstehen kann, müssen zuvor falsche Gene abgelesen werden. Gene, sowohl die zellspezifischen, als auch sog. falsche, bzw. entartete Gene werden durch einen komplizierten Proteinkomplex, die (RNA-)Polymerase II abgelesen. Dieser besteht aus über einem Dutzend verschiedener Funktionseinheiten, die mittels Transkriptionsfaktoren (Proteine, deren geometrische Figur wie ein Schlüssel an die jeweils entsprechende Andockstelle passt und die für die Katalyse notwendig sind) gesteuert werden. So funktioniert z.B. das Gift des Knollenblätterpilzes dahingehend, dass seine biologische Struktur sich an eine solche Andockstelle in der Polymerase II der Leberzellen festsetzt, an die eigentlich ein Transkriptionsfaktor andockt, der die Polymerase II steuert. Da der Platz aber vom biologischen Gift besetzt ist, kann er nicht mehr andocken und die Polymerase II funktioniert nicht mehr und die Zelle wird nicht mehr mit dem notwendigen Nachschub (Proteine) versorgt und stirbt ab. Sie „verhungert“ sozusagen. Nicht gleich, sondern 1 Tag später. Deshalb ist dieses Gift so heimtückisch: Wird es bemerkt, ist es meist zu spät und die Zellen sind bereits abgestorben.

Die Verfechter der Feinstaub-Hype können dem Autor sicherlich sofort sagen, wie Feinstaub die Polymerase II steuert.

Abb.10, Quelle (http://www.biochem.umd.edu/biochem/kahn/molmachines/newpolII/home.html) zeigt vereinfacht den Ablesevorgang an einem Gen durch die RNA-Polymerase II.Dazu wird die Doppelhelix aufgetrennt und der entsprechende Abschnitt mit Hilfe dutzender Hilfs- und Steuerungsproteinen kopiert. Die Boten-RNA wandert dann, wiederum mit Hilfsstoffe aus dem Zellkern zu den Ribosomen, an denen dann das jeweilige Protein entsteht. Feinstaub hat keinerlei Möglichkeit (ist ausgeschlossen) die Polymerase II irgendwie zu beeinflussen.

So tragen Proteine am Anfang ihrer Aminosäurekette einen Code, der ihren Bestimmungsort signalisiert, sozusagen, eine „Postleitzahl“. In den Ribosomen wird anhand der o.g. genetischen Boten RNA (DNA-Kopie = Bauplan), der Genabschrift im Zellkern durch die Polymerase II, mittels Transfer RNAs, die mit Hilfe von Enzymen (ohne deren Hilfe kann die genetische Bauanleitung nicht richtig ausgeführt werden), jeweils an eine „ihrer“ Dreierabfolge der Nukleotide andocken, die Lebensbausteine des Körpers erzeugt. Hier ist ein evolutorisch sehr alter Schutzmechanismus der Zelle vor Vireninfektionen eingefügt und zum Schutz einer korrekten Übersetzung: Nicht die Boten-RNA direkt wird übersetzt, sondern mit Hilfe zelleigener Transfer RNAs, die erkennen sollen, ob es sich um eine falsche Dreierabfolge von Nukleotiden und damit um Fremdgene handelt.

Diese Transfer-RNAs veranlassen das Ribosom, die jeweilige Aminosäure zu erzeugen, mit denen das Protein hergestellt wird. In einer Untereinheit des Ribosoms, dem Signal Recocnition Particle, wird den Proteinen die Zieladressen in der Zelle oder außerhalb der Zelle angefügt. Anschließend verlässt das Protein das Ribosom und beginnt sich in einem komplizierten Prozess zu falten. Falsche Faltungen sind z.B. die Ursache von Krankheiten wie BSE. Bevor jetzt jemand auf die Schnapsidee kommt, Feinstaub würde diese Faltungen behindern und wäre (auch) für BSE verantwortlich: Der Faltungsprozess läuft mittels biologischer Elemente (Cofaktoren wie Chaparone) und nutzt dabei physikalische Grundgesetze. Abgesehen davon, dass Feinstaub gar nicht erst dorthin gelangt, wo diese Prozesse ablaufen.

Die in den Ribosomen hergestellten Proteine dienen der Zelle für ihren „Betrieb“. Wie bereits erwähnt, werden bei Krebszellen falsche Gene abgelesen, die wiederum die Zelle zu abnormen Verhalten veranlassen. Feinstaub kann hier nichts beeinflussen oder eingreifen, da biologische Stoffe aus Aminosäuren notwendig sind.

Bei solchen Genen, die eine hohe Bedeutung für die Entstehung von Krebs haben (Proto-Onkogen), bzw. deren Veränderung Krebs entstehen lässt, spricht die Wissenschaft von Krebsgenen oder Onkogenen. Zu ihnen gehören die z.B. BRCA-Gene (dienen für Reparaturprozesse an der Genom-Helix) oder die FAS-Gene, die für die Fettsäuresynthese verantwortlich sind und somit Schlüsselfunktionen im Gewebe und der Energieversorgung (Energiespeicher) innehaben. Wobei, wie bereits gesagt, mehrere Gene mutiert sein müssen, um eine normale Zelle, in eine Krebszelle zu verwandeln. Ein Grund, warum Krebs meist eine Alterskrankheit ist.

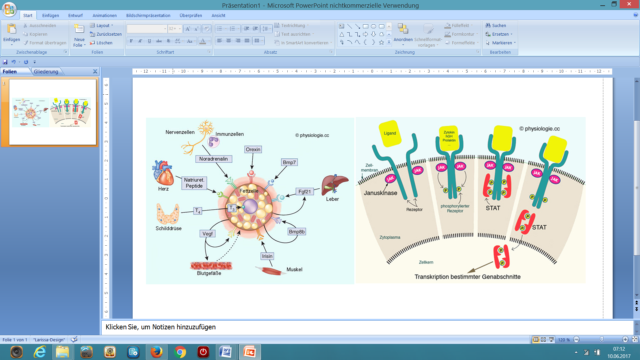

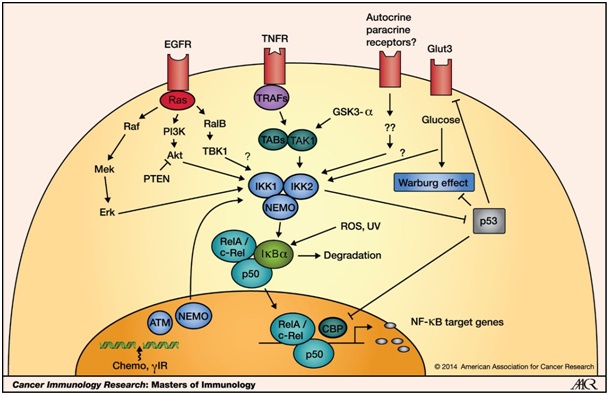

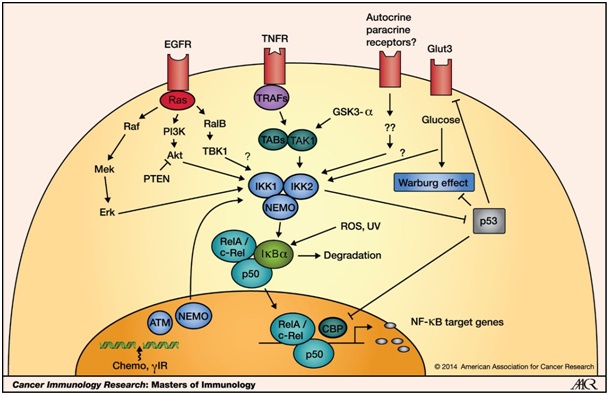

Abb.11, (Quelle Max Planck Gesellschaft) zeigt einen kleinen Ausschnitt der zelleigenen Proteine und ihre komplexen Wechselwirkungen. Insgesamt konnten bei Krebs ca. 10.000 Proteine identifiziert werden, die sich in Verbindung mit der Krankheit wandeln und die Zelle abnorm werden lassen. Alle Proteine und alle ihre Wechselwirkungen laufen über biologische Signalstoffe, die jeweils ihr Rezeptorprotein erkennen müssen, um etwas auslösen zu können.

Um diesen Proteinverbund, wie auch den „normalen“ aufrecht zu halten, benötigt es Kommunikationen. Dazu besitzt eine Zelle Rezeptoren, an die ihr ganz bestimmter Bindungsfaktor andocken muss, damit ein Wirkstoff in eine Zelle gelangt oder in ihr etwas auslöst. Dies kann man sich bildhaft so vorstellen wie eine Fahrberechtigung beim Auto. Nur, wer den richtigen und passenden Schlüssel hat, der kommt in das Fahrzeug, hier, in die Zelle. Der passende Schlüssel ist dabei die räumliche Ausgestaltung der Aminosäuren an einer anderen Zelle, z.B. des Immunsystems oder ein Botenstoff, wie z.B. ein Cytokin. Viren müssen übrigens genau den passenden Rezeptor (Schlüssel) tragen, wollen sie in eine Zelle gelangen. Ohne diesen „Schlüssel“ kommen sie nicht in eine Zelle, um diese zu infizieren und sich anschließend darin zu vermehren. Feinstaub ist aber ein toter Stoff, der keine Bausteine des Lebens (Aminosäuren) hat und damit auch nicht den jeweils passenden Schlüssel, um an einem jeweils ganz bestimmten Oberflächenmolekül an oder in einer Zelle etwas auszurichten. Folglich kann Feinstaub hier grundsätzlich keine Rolle spielen: Weder bei der Entstehung von Krebs, noch bei Erkrankungen wie einer Grippe.

Ein entscheidendes Kriterium bei Krebs ist sein (Zell)Wachstum. Hierfür benutzt er die zelleigenen, sonst „üblichen“ Prozesse, die die Zelle einschlägt zu wachsen, bzw. sich zu vermehren oder zu erneuern. Mit dem Unterschied, dass Regelproteine (wieder biologische Stoffe), die ansonsten ein ungebremstes Zellwachstum verhindern, gehemmt sind und die Proteine, die das Zellwachstum ankurbeln, stark erhöht, also hyperaktiv sind.

Zellwachstum beginnt mit einer Familie von Rezeptoren (EGFR) in der Zellmembran. Werden diese durch externe Wachstumsfaktoren (biologische Proteine wie Sonic hedgehog oder Nough) stimuliert, die die richtige Form in ihren Verbindungsstellen aufweisen, um an diese Rezeptoren anzudocken, wird in den Zellen eine entsprechende Signalkaskade angestoßen, die die Gene in der Zelle adressiert, die für Wachstum und Teilung zuständig sind. Die Aktivierung dieser Rezeptoren bewirkt über eine komplexe Signalkaskade mit dutzenden biologischen Hilfs- und Regelstoffen in der Zelle, an der ausschließlich biologische Stoffe beteiligt sind, weitere Proteine zu erzeugen, die schließlich die notwendigen Gene im Zellkern für die Zellteilung anstoßen. Als totes Material hat Feinstaub hier keinerlei Einflussmöglichkeiten.

Abb.12(http://physiologie.cc/II.1.htm) links zeigt anhand einer Fettzelle anschaulich und vereinfacht die Kommunikation zwischen den Zellen und rechts das Andocken eines jeweils entsprechenden Bindungspartners an Zellrezeptoren und ebenfalls stark vereinfacht, die Zellprozesse, die daraufhin angestoßen werden.

Dockt an die Zelle außen am Rezeptor ein Wachstumsfaktor an, so verbindet sich der Rezeptor mit seinem Nachbarn. Die Paarung zweier Rezeptormoleküle aktiviert ihre sog. Tyrosinkinase (Enzym). Durch anschließende Phosphorylierung (Anhängen einer Phosphatgruppe) an die Innenseite der Rezeptoren, wird eine Signalkaskade in Richtung Zellkern in Gang gesetzt, der entsprechende Wachstumsgene aktiviert. Andere Rezeptorpaare können dagegen direkt in den Zellkern wandern und dort Gene anschalten, die die Zellteilung ankurbeln und die Apoptose verhindern (z.B. Östrogenrezeptor). Solche Rezeptoren lösen, wenn ihr Bindungspartner (immer ein biologischer Stoff = Protein) an ihr andockt, im Zellinnern ein Vermehrungssignal aus, indem sie eine molekulare Kaskade in Gang setzen. In deren Verlauf weitere Gene aktiviert, deren Proteinprodukte wiederum die Aktivität andere Gene regulieren (zur Komplexität siehe Abb.11). Ein Zuviel solcher Wachstumsfaktoren (EGFR), kann denn eine Zelle in eine Krebszelle verwandeln. Mit Feinstaub hat dies alles nichts zu tun.

Um ihr Wachstum zu fördern, senden Krebszellen ihrerseits Wachstumsfaktoren aus (z.B. VEGF = vaskuläre endotheliale Wachstumsfaktur) aus, die Zellen der inneren Blutgefäßwand anlocken. Diese Endothelzellen bilden dann neu aussprossende Blutgefäße, die den Krebstumor versorgen. Der Autor wüsste gern, wie Feinstaub auf diese sog. Angiogenese Einfluss nehmen soll. Die Antwort: Da es sich ausnahmslos um biologisch gesteuerte Prozesse, mit biologischen Stoffen handelt, kann Feinstaub hier als totes Material niemals irgendeinen Einfluss ausüben. Wer nicht den Schlüssel zu einem Fahrzeug hat, der kommt auch niemals hinein. Es sei denn, er schlägt die Fenster ein. Bei Zellen müsste dieser eine zelltoxische Stoff sein. Derartige Stoffe, sog. Karzinogene, sind bekannt. Zu ihnen gehören z.B. Dioxine und in größeren Dosen Aromatische Kohlenwasserstoffe.

Feinstaub, also zu Deutsch feiner Steinist jedoch nicht zelltoxisch (Anmerkung: Es sei denn, man stoßt sich den Kopf an einem größeren Stein – der Autor möchte jetzt niemandem etwas unterstellen) wie z.B. Dioxin und kann daher auch keine „Fenster“ in der Zelle einschlagen und sie dadurch zerstören – biologische Prozesse, die für Krebs notwendig sind, kann er nie anstoßen – er kann seine Wirkung auf äußere Zellen „nur“ mechanisch ausüben. Daher schreibt auch Prof. Dr. Joachim Heyder (über die beobachteten Auswirkungen des ultrafeinen Feinstaubes um 0,1µm): „Aber nach wenigen Tagen sind diese Entzündungen (Anmerkung: In der Lunge) abgeklungen.“ Diese mechanisch verursachten Entzündungen werden durch das angeborene Immunsystem ausgelöst (dazu später mehr), die Fremdstoffe werden identifiziert, gebunden, zerstört und dann abtransportiert. Die Entzündungen klingen wieder ab und bleiben nicht bestehen. Gleiches geschieht auch beim Schnupfen und dort sind die Entzündungserscheinungen weit größer. Kein Mensch würde nun behaupten, das Schnupfen Krebs verursacht.

Weiter benutzen Krebszelle das angeborene Immunsystem, besonders die Makrophagen, um zu wachsen und zu metastieren. Sie programmieren die Makrophagen sozusagen um, so dass diese falsche Signalstoffe an die B-Zellen des adaptiven Immunsystems senden, die dann ihrerseits das angeborene Immunsystem aktivieren, die Krebstumorzellen beim Überleben und beim Wachstum unterstützen, indem sie z.B. den entzündungsfördernden Faktor KappaB produzieren, der Makrophagen anlockt und der sie veranlasst, in den inneren, sauerstoffarmen Bereich den Krebstumors zu wandern, womit sie bewirken, das Blutgefäße hineinwachsen. Ansonsten könnte ein Krebstumor nicht wachsen, da ihm die Sauerstoffversorgung fehlt.

Der Autor wüsste nun gern, wie Feinstaub die biologischen Signale sendet, damit das angeborene Immunsystem umprogrammiert wird? Er wird natürlich keine Antwort erhalten (können), da Feinstaub dieses nicht auszulösen vermag und als tote Materie keine Signale an biologische Proteine, die letztendlich für die obigen Kaskaden verantwortlich sind, abgeben kann.

Abb.13, Quelle: Cancer Immnology Research, „NF-κB, an Active Player in Human Cancers“, zeigt, wie Krebszellen das angeborene Immunsystem für sich ‚einspannen‘. In Abb.13 ist der NF-KappaB dargestellt. Dieses Signalprotein wird vom angeborenen Immunsystem dazu benutzt, um Entzündungsreaktionen (dazu später mehr) hervorzurufen. Chronische Entzündungen können eine wichtige Rolle bei der Entstehung von Krebstumoren, nicht von einzelnen Zellen, spielen. Chronische Entzündungen allein bewirken grundsätzlich keine Mutationen und lösen auch keinen Krebs aus. Sie können ihn indes unterstützen, zu wachsen.

So produzieren Makrophagen entzündungsfördernde Stoffe, wie den Tumornekrosefaktor (TNF), der in der Zelle einen genetischen Schalter, den nuclear factor-kappa B umlegt. In aktivierter Form wandert er in den Zellkern und kurbelt dort die Produktion von Proteinen an, die die Apoptose verhindern, die Entzündung verstärken und die Zellteilung anregen.

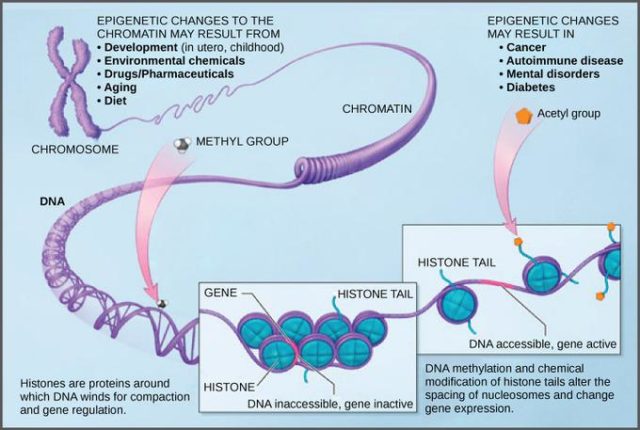

Damit Gene abgelesen werden können, bedarf es nicht nur einer entsprechenden biologischen Signalgebung, um der RNA-Polymerase II zu übermitteln, welches Gen abgelesen werden soll, sondern der entsprechende Abschnitt im Chromosom muss für den vergleichsweise großen Ablesekomplex (RNA-Polymerase II) zugänglich sein. Anmerkung: Der Autor dringt deshalb so tief in die Molekularbiologie und die Zellabläufe ein, um zu zeigen, dass für Feinstaub hier nichts zu beeinflussen ist.

Das menschliche Genom besteht aus ca. 21.000 Genen. Von den drei Milliarden Buchstaben (Nukleotide) sind dies gerade einmal knapp 2%, die für Aminosäuren (das Leben ist aus 20 Standardaminosäuren aufgebaut), den Grundbausteinen der Proteine, codieren. Unser Genom besitzt weiter, 19.000 Pseudogene (an ihren Sequenzveränderungen wird die genetische Uhr abgelesen) und der große Anteil von Introns (etwa 30%, Steuerungssequenzen in den Genen, die nicht codieren) und der ganz große Rest aus Sequenzen außerhalb der Gene und Pseudogene. Die genetischen Buchstaben sind dabei in der DNA-Helix, an einem doppelsträngigen Grundgerüst von Zucker und Phosphateinheiten aufgereiht.

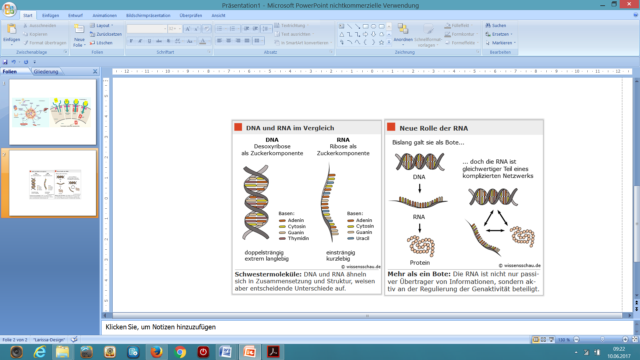

Abb.14, Quelle (http://www.wissensschau.de/genom/rna_genom.php) links zeigt die Doppelhelix unseres Genoms (Ausschnitt), mit den vier Basen, Adenin, Cytosin, Guanin und Tymidin (wobei im Doppelstrang stets A mit T und G mit C gepaart sind und die sog. Leiter bilden) und die entsprechende Boten-RNA, wie sie von der RNA-Polymerase II abgelesen wird und als „Blaupause“ für die Ribosomen in der Zelle dient, anhand derer, das Ribosom die durch Aneinanderreihung von Aminosäuren, das jeweilige Protein bildet. Jeweils drei Buchstaben codieren dabei für eine Aminosäure.

Abb.14 rechts zeigt die zwei Hauptaufgaben der RNA: Blaupause für Proteine und Regulator für Genaktivitäten. Auch hier gibt es für Feinstaub nichts zu beeinflussen – ist für Feinstaub unmöglich.

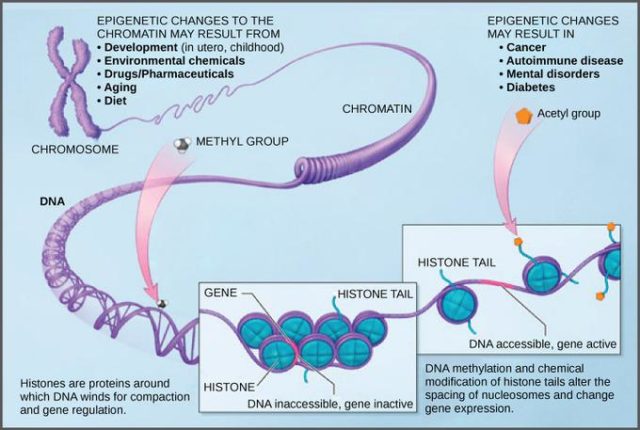

Chromosome sind wiederum um „Verpackungseinheiten“, die Histone, gewickelt. An denen sich Steuerungseinheiten, Acetyl- und/oder Methylgruppen, befinden. Werden diese entfernt (sog. Langlebigkeitsgene* vermögen dies), so ändert sich deren Komplexität / Räumlichkeit und bei der Zellteilung entsteht weniger sog. ribosomale DNA, die eine der Ursachen für die Begrenzung von Zellteilungen ist, weil sich diese Elemente im Zellkern ansammeln und mit jeder Teilung dort häufen. Weil repetitive Sequenzen dazu neigen, zu rekombinieren und dadurch sog. Stottersequenzen in der Abschrift des Chromosoms entstehen, die die Zellteilung letztendlich verhindern oder zu entarteten Funktionen führen, wodurch dann Krankheiten ausgelöst werden, bzw. keine Zellteilungen mehr erfolgen – zu Deutsch: Alterungsprozesse werden eingeleitet, bis hin zur Apoptose, dem zellprogrammierten Zelltod.

* Zu den sog. Langlebigkeitsgenen gehören Sirtuine. Indem Sirtuine in diese komplexe Genregulierungen eingreifen, können sie Alterungsprozesse hinauszögern. Sirtuine greifen weiter in die Prozesse ein, die Diabetes vom Typ 2 auslösen (können ihn hinauszögern) und hemmen Entzündungsreaktionen, indem sie den nekrose Faktor Kappa B bremsen. So regelt das Sirt 1 Enzym die Insulin Produktion und den insolinähnlichen Wachstumsfaktor IGF-1. Kalorienarme Kost (Ernährung) regelt über die dortigen Stoffe den Zellstoffwechsel, der wiederum Stoffe produziert, die die Langlebigkeitsgene ein oder ausschalten, sofern diese vorhanden sind. Darauf beruht übrigens die statistische Erkenntnis, dass gesunde Ernährung der Gesundheit zu Gute kommt. Wogegen die pseudowissenschaftlichen Studien der WHO, Feinstaub würde Millionen Tote verursachen, auf keiner wissenschaftlichen Erkenntnis beruhen, sondern, wieder einmal, auf reinen, subjektiven Modellberechnungen, ohne jegliche wissenschaftliche Grundlage. So etwas wird üblicherweise als Pseudowissenschaft bezeichnet. Prof. Dr. Joachim Heyder vom Forschungszentrum für Umwelt und Gesundheit zu diesen WHO-Studien: „Ich halte das für unseriös.“ Wie anhand der biologischen Abläufe gezeigt, ist dem nichts hinzuzufügen.

Feinstaub hat als totes Material, gar nicht die Möglichkeit, Aminosäuren, die Bausteine des Lebens zu erzeugen und daraus die jeweils entsprechenden Steuerungselemente zu bilden, um in irgendwelche Regelkreisläufe der Zelle einzugreifen um diese entarten zu lassen. Ganz abgesehen davon, dass er gar nicht in den Hochsicherheitstrakt der Zelle, ihren Zellkern, hineinkommt.

Abb.15 (https://www.boundless.com/biology) zeigt anschaulich, wie auf den Chromosomen durch Methylierung durch biologische Steuerungssequenzen, sog. Genregulatoren, sich die Verpackungsdichte der Histone ändert und dadurch das Gen zugänglich wird. Unnötig zu erwähnen, dass auch hier Feinstaub keine Einflussmöglichkeiten hat.

Bei dicht gepackten Genomabschnitten spricht man von Heterochromatin. Wogegen das locker gewickelte und ablesbare Euchromatin heißt. Ribonecleinsäuren aus dem Genom-Bereich IGS (nicht codierende Steuerungssequenz) und ein spezieller Enzymcomplex (NoRC) sind für die Verpackung und Stilllegung auf den Chromosomen zuständig. Durch zu wenig ribosomale RNA (siehe Abb.14) wird die Verpackungsdichte reduziert und somit Bereiche des Genoms abgelesen, die sonst still liegen. Nun weisen Krebszellen eine veränderte DNA-Methylierung an den Histonen auf. Verursacht durch fehlgeleitete zellgenetische Steuerungen. Auch hier würde der Autor gerne wissen, wie Feinstaub in diese biologisch / genetische Regelung, die mit für die Auslösung einer Krebserkrankung verantwortlich sein kann (wenn falsche Stellen angefahren werden), eingreift?

Weiter fehlt Feinstaub die Energie, wie z.B. ionisierende Strahlung, um im Genom Veränderungen vorzunehmen (abgesehen davon, dass Feinstaub gar nicht dorthin kommt), indem z.B. ein Nukleotid (genetischer Buchstabe) verändert wird. Da immer jeweils drei Nukleotide für eine Aminosäure codieren, kann ein Fehler unter Umständen fatale Auswirkungen auf das anschießende Protein haben, sofern dies nicht vorher erkannt wird.

Anmerkung: Der Autor weiß, es ist sehr fachspezifisch, er will aber zeigen, dass Feinstaub da nichts regeln oder beeinflussen kann.

Genmutationen entstehen auch dadurch, dass eine skriptierte RNA (nachdem die Introns entfernt wurden) wieder in DNA zurückgeschrieben und in unser Genom eingebaut wird. Auch hieraus kann theoretisch eine Krebserkrankung werden. Oder ein sonstiger, körpereigener Mangel, der zu einer spezifischen Krankheit führt. So kann z.B. der Mensch, im Gegensatz zu anderen Säugetieren, kein Vitamin C selbst herstellen, weil das notwendige Gen (Gulo) im Chromosom 8 entartet ist (vor mehr als 50 Mio. Jahren) und nur noch als Pseudogen vorliegt. Der Mensch und seine Vorfahren haben dennoch überlebt, weil wir diese Stoffe mit der Nahrung zu uns nehmen. Mangelerscheinungen sind denn auch die Folge solch fehlender Stoffe, die der Körper braucht, aber nicht (mehr) selbst erzeugen kann.

Weiter besitzen wir Menschen bestimmte Gene (deren Proteine), um Beschädigungen der Doppel- oder Einzelstrangbrüche der Helix im Genom zu reparieren. Ohne ein solches funktionsfähiges Gen, haben wir ein viel höheres Risiko, an bestimmten Krebsarten zu erkranken – das Chromosom zerfällt dann in zwei Teile oder reißt an einer Stelle auf, was drastische Folgen haben kann, denn Krebs ist eine Gen-/Chromosomenkrankheit, die auf dieser Ebene entsteht. Gut erforscht ist dabei ihr Einfluss auf Brustkrebserkrankungen bei Frauen, bei der BRCA-Gene mutiert sind, die für solche Reparaturprozesse notwendig sind. Vielleicht können auch hier die Feinstaub-Aktivisten dem Autor sagen, wie Feinstaub in den Hochsicherheitstrakt der Zelle, ihren Zellkern gelangt, dort zu den Chromosomen und dann auch noch, ohne eigene Energie, Chromosomenbrüche verursacht. Der Autor beantwortet die Frage: Schlicht und ergreifend unmöglich.

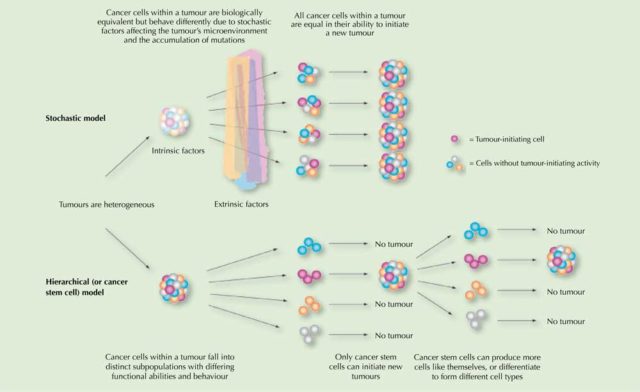

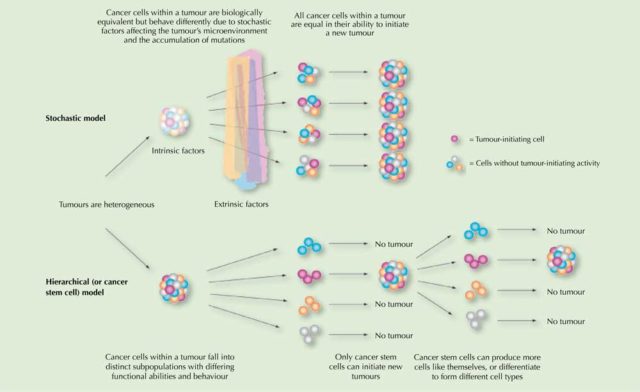

Ein weiteres wichtiges Feld im Verständnis von Krebs sind sog. Krebsstammzellen. Sie sind meist der Grund, wenn sich ein Tumor wieder bildet. Stammzellen sind Zellen, an denen durch eine Kaskade von Aktivitäten (z.B. Sonic hedgehog = Wachstum), die jeweiligen Vorläuferzellen eines Zelltyps entstehen und schließlich, nach zig-Einzelschritten und Differenzierungen, die fertige, funktionale Zelle oder, die entartete Zelle. Ein Versagen der biologischen Stammzellenregulation (deren Kontrolle) liegt vielen Krebsarten zu Grunde. Nun meine lieben „Freunde“ von der Feinstaub-Hype, erklärt doch mal dem Autor, wie Feinstaub dies anstellen soll? Doch da gibt’s jedoch nichts zu erklären, weil zwischen toter und lebender Materie keine Signale und damit Steuerungen ausgetauscht / initiiert werden können. Da Feinstaub auch kein Energieträger ist, können auch auf physikalischer Basis keine Wechselwirkungen in diese Regelkreise erfolgen.

Abb.16, Quelle (http://www.scienceinschool.org/de/2011/issue21/cscs): Zwei Modelle, die zu erklären versuchen, warum innerhalb eines Krebstumors dessen Zellen so unterschiedlich sein können und, dass eine kleine Untergruppe von Zellen (Krebsstammzellen) für die Auslösung und den Bestand des Krebses verantwortlich ist. Die Funktion und das Verhalten von Stammzellen wird von ihrem eigenen, genetischen Programm und einer Vielzahl von (biologischen) Signalen aus dem Gewebe gesteuert (entscheidet auch darüber, ob und wo sich Metastasen bilden). Stammzellen, mit sog. onkogenen Veränderungen in ihrem Programm und die Änderung der vorgenannten Signalketten können dazu führen, dass Krebsstammzellen entstehen. Weder kann Feinstaub als tote Materie die Signalkette manipulieren, noch genetische Veränderungen hervorrufen. Demzufolge, kann Feinstaub auch keinen Krebs auslösen. Immunzellen sind übrigens dazu in der Lage, Krebsstammzellen aufzuspüren und sie zu zerstören.

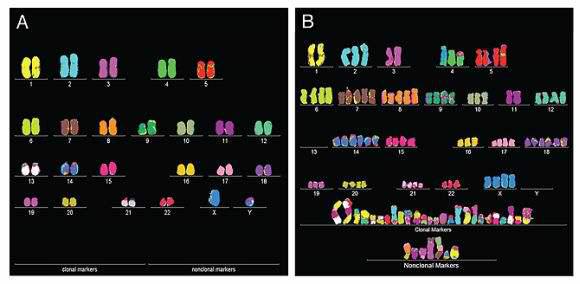

Krebs kann jedoch nicht allein mit dem Gen-Modell erklärt werden, sondern die Betrachtung muss auf die Chromosomen ausgeweitet werden. So ist Krebs eine Gen-/Chromosomenkrankheit. Auffällig ist, dass in Krebszellen gleich ganze Chromosomenbereiche entartet sind und nicht nur einige Gene. So sind in einer Krebszelle zwar einzelne Gene verändert, aber gleichzeitig sind die Chromosome, die tausende Gene tragen, gravierend verändert. Manche sind zerbrochen, tragen Stücke von anderen, andere sind zu viel und andere wiederum fehlen ganz. Dieses direkte Chaos ist nicht die Folge von genetischen Einzelveränderungen, sondern die eigentliche Ursache von Krebs. So sind denn die Abweichungen in der Anzahl und der Struktur der Chromosomen in einer Zelle die Ursache für deren Entartung.

Wir Menschen besitzen zwar weitgehend identische Grundgene. Diese unterscheiden sich jedoch durch Variationen, in denen einzelne Nukleotide verändert sind. Jeder Mensch trägt über sein Genom eine Vielzahl solcher Mutationen und vererbt diese weiter, was die menschliche Vielfalt ausmacht. Man spricht vom Phänotyp.

Der Chromosomensatz in einer Zelle ist hingegen immer gleich und er kommt immer paarweise (diploid) vor. Die Zelle besitzt jeweils ein gleiches Chromosom vom Vater und der Mutter (einzige Ausnahme das männliche Geschlechtschromosom). Diese chromosomale Regel ist eine unverrückbare Stabilitätsregel bei der Zellentwicklung und im Gegensatz zu Genen, gibt es hierzu keine Abweichungen. Bei Krebs jedoch sind die Chromosomen nicht diploid, sondern immer (!) aneuploid.

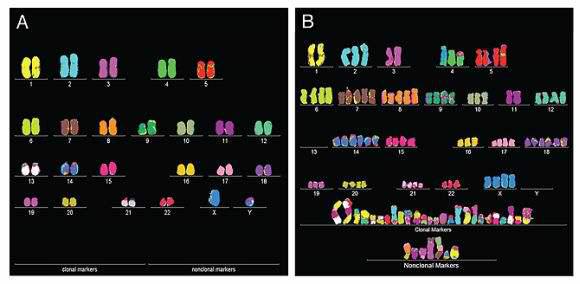

Abb.17, Quelle P. Duesberg / Univ. Berkeley: Der menschliche Chromosomensatz besteht aus 23 Chromosomenpaaren, die immer jeweils gleiche Paarbildung aufweisen. Nur beim Mann ist ein ungleiches Paar zu finden (X und Y-Chromosom, bei der Frau jeweils X zu X-Chromosom). Bei Krebszellen herrscht immer chromosomale Unordnung: Einige Chromosomen liegen in Überzahl vor, einige fehlen, andere haben Bruchstücke ausgetauscht,… Unnötig zu erwähnen, dass Feinstaub ein solches Chromosomenchaos nicht anrichten kann, da es erst gar nicht dorthin gelangt, geschweige in die komplizierten biologischen Steuermechanismen eingreifen kann, die normalerweise für Ordnung sorgen. Der Grund ist vielmehr in der Struktur der Chromosomen selbst zu finden. Neben einigen äußeren Einflüssen, die oben beschrieben wurden (z.B. Viren oder hochenergetische Strahlung), kommt der Anstoß zur Entartung einer Zelle meist (!) aus ihrer inneren Struktur selbst, auf die Feinstaub nun erst recht keinen Einfluss hat.

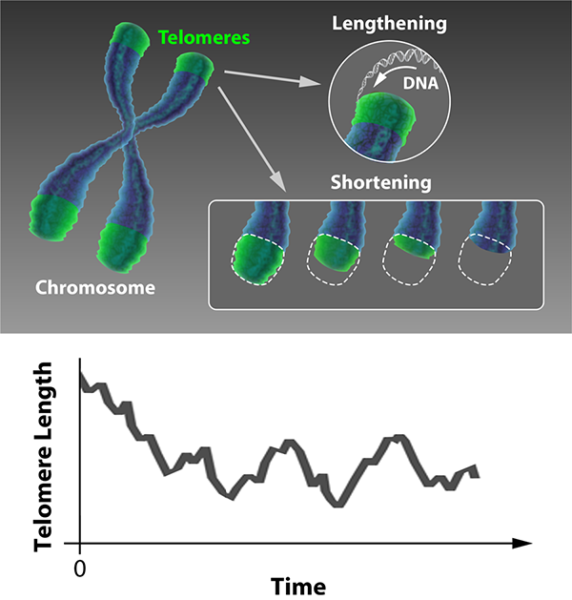

Die chromosomale Betrachtung erklärt denn auch, warum Krebs meist erst im hohen Alter entsteht: Wegen dem sich immer mehr anhäufenden Aneuploidgrad in den Zellen. Ist der Gang der Euploid-Entwicklung erst einmal in Gang gesetzt, erzeugt jede neue Zelle weitere und mehr euploidie, bis diese schließlich entartet. Die Wissenschaft weiß z.B., dass die Chromosomenenden, die Telomere, eine wichtige Rolle bei der Stabilität des Chromosoms spielen. Diese Telomere werden aber mit jeder Zellteilung (mit dem Alter) weniger, was auf die Polymerase I zurückzuführen ist.

Eine wichtige Funktion, dass sich bei der Zellteilung die Chromosomenpaare richtig ausrichten und paaren, hat zu Beginn der Zellteilung der sog. Spindelapparat der Zelle. Ist er gestört, ordnen sich die Chromosomenpaare falsch an, was wiederum Krebszellen entstehen lassen kann, wenn dies nicht vorher vom Immunsystem erkannt wird. So haben die o.g. Aromatische Kohlenwasserstoffe, die unter die Karzinogene fallen, die Eigenschaft, dass sie die Microtubuli („Kraftseile“ der Zelle) depolymerisieren und dadurch zerstören. Diese Proteine braucht jedoch der Spindelapparat, bei der Zellteilung. Dioxine wirken dadurch karzinogen, indem sie durch ihre hohe Toxizität, die Chromosomen direkt angreifen. Der Autor wüsste nun gerne, wie Feinstaub dies fertigbringen soll? Er weiß, dass er keine Antwort erhalten wird.

Die inhärente Instabilität des Krebses ist auch die Ursache, warum Krebs so leicht neue individuelle Merkmale erreicht und dadurch für Medikamente nicht mehr erreichbar ist, die vorher noch halfen. Krebszellen unterscheiden sich damit grundlegend von ihren natürlichen „Vettern“, die alle artspezifische Eigenschaften aufweisen.

Zuweilen fällt bei Feinstaubbelastung und seiner postulierten Wirkung der Begriff Oxidativer Stress und damit verbunden: Freie Sauerstoffradikale. Nun, diese Radikale entstehen grundsätzlich bei unseren Stoffwechselprozessen und sind, da sie sehr reaktionsfreudig sind, kurzlebig. Sie sind deshalb sehr reaktionsfreudig, weil ihnen ein ungepaartes Elektron fehlt und sie versuchen anderen Stoffen, wie den Mitochondrien, dieses Elektron zu entreißen, wodurch sich deren chemische Eigenschaften ändern und sie dadurch instabil, beschädigt werden. Die deutschen Qualitätsjournalisten, die mit diesen Begriffen jonglieren wissen natürlich sofort, warum Freie Radikale so „scharf“ darauf sind, ihr ungepaartes Elektron zu paaren. Daher eigentlich unnötig, dass der Autor den Grund nennt: Ihre Energiegewinn ist dadurch sehr groß. Nach diesem Ausflug in ferne und fremde Welten, nein, die Rede ist nicht vom Raumschiff Enterprise, sondern von der Physik, obwohl der Autor so manchmal den Eindruck hat, dass für unsere deutschen Qualitätsjournalisten das eine dasselbe wie das andere ist, zurück zum oxidativen Stress.

In der Zellen gibt es zum einen biologische Stoffe, die freie Radikale unschädlich machen und zum anderen, Reparaturprozesse, die es ermöglichen, solche Schäden durch freie Radikale zu beheben. Mit dem Alter werden diese weniger, weil, so die gängige Meinung, die Zellen erschlaffen. Jedoch hat die Zelle Möglichkeiten, Alterungsprozesse hinauszuzögern. Dazu gehören die bereits erwähnten Langlebigkeitsgene (z.B. Sirtuine), aber auch Gene, die den Stoffwechsel oder das Wachstum steuern. Sirtuine sind auch bei der Zellabwehr aktiv und unterstützen diese, weiter steuern sie die Apoptose – bei Krebs maßgeblich. Wer eine entsprechende genetische Ausstattung (siehe Helmut Schmidt), vor allem die, die solche Gene aktiviert, hat, der lebt länger, auch wenn er raucht. Durch bestimmte Stoffe, wie Resveratrol (in roten Weitrauben) lassen sich übrigens Zellen dazu anregen, solche Langlebigkeitsgene über chemische Prozesse in der Zelle zu aktivieren. Daher kommt auch die Aussage, wer täglich ein Glas Rotwein trinkt, der lebt länger – die gleiche Substanz ist indes auch im roten (alkoholfreien) Traubensaft.

Besonders vom Rauchen ist bekannt, dass dadurch in unseren Zellen eine mehr als 1.000-fache Erhöhung solcher freien Radikale auftreten können. Ansonsten sind sie normaler Bestandteil unsers Zellstoffwechsels.

Die „Schwadronauten“, inklusive der politischen Organisation WHO, die behaupten, Feinstaub würde Krebs verursachen, können dem Autor sicherlich sofort erklären, wie Feinstaub dies in den vorher beschriebenen, molekularen Zellprozesses, anstellen soll.

Krebs und Virenerkrankungen haben auf molekularer Ebene eine grundlegende Gemeinsamkeit: In beiden Fällen werden in der Zelle falsche Gene abgelesen. Im letzteren durch Manipulation der Viren (indem sie den Enzymapparat der Zelle übernimmt), also der lebenden Fremdkörper und im anderen Fall, durch die (lebenden) Zellprozesse selbst (indem Gene aktiv werden – durch den Krebs aktiv gemacht werden, die eigentlich stumm bleiben müssen, z.B. Gene, die die Zellteilung anregen). In der Wissenschaft besteht hier ein Ansatz (über small interferring RNAs), die über genetisch* erzeugte Antikörper in die Zelle eingeschleust werden. Diese Antikörper fangen die falsch abgelesene RNA in der Zelle auf, indem sie sich auf ihre jeweiligen, konträren RNA-Nucleotide heften. Hierdurch können gezielt Gene stumm geschaltet werden, oder falsche Boten-RNA (z.B. Viren) abgefangen werden. Der Vorgang ist recht komplex und nutzt die zelleigene Interfrenzmachinerie. Der Vorgang gehört übrigens zum zelleigenen Immunsystem. Feinstaub hat als tote Materie, auch nicht im Geringsten die Möglichkeit, in die o.g. Regulation der Zellgene einzugreifen.

*Ohne Genmanipulation ließen sich viele heute verwendete Heilmittel und auch zukünftige, nie herstellen. Sie stellen zudem sicher, dass nur ihr eigentliches Ziel und nicht auch gesundes Gewebe angegriffen wird.

Der Autor hat detailliert beschrieben, dass Feinstaub nicht in der Lage ist, in die biologischen Systeme / Prozesse einzugreifen, die mit Krankheiten wie Krebs in Verbindung stehen, die Feinstaub angeblich auslösen soll. Haben denn „Umwelteinflüsse“ keinen Einfluss auf genetische Prozesse?

Doch, natürlich! Wir sind Kinder der Evolution und wie Charles Darwin so brillant nachwies, passen wir / das Leben sich an seine Umwelt und deren Veränderungen an. So beträgt die Zeitspanne, in der sich ein Gen ändern kann, ca. 10.000 Jahre. Für die Menschheitsgeschichte und noch mehr, die Geschichte des Lebens auf der Erde ist dies nur ein Wimpernschlag. Dennoch wird jetzt hoffentlich niemand um die Ecke kommen und behaupten, seine Gene hätten sich geändert, weil er 10.000 Jahre einer zu hohen Feinstaubbelastung ausgesetzt war. Jeder wüsste sofort, dass dies nur blanker Unsinn sein kann.

Nun können sich Steuerungssequenzen in unserem Genom (Chromosomen) schneller ändern als proteincodierende Gene. Z.B. über Ablesefehler (in die Chromosomen kommt Feinstaub aber gar nicht hin) oder über springende Gene (transposable elements = TEs), die den Ort ihres Erbgutes ändern können und neben der genetischen Vielfalt, zu genetisch bedingten Krankheiten beitragen können. Ausgelöst werden solche Prozesse durch das Genom selbst. Das Genom / Chromosomen ist nämlich keine Datenbank, wie meist behauptet wird, sondern ein komplexes Betriebssystem, in das wie beim Computer auch Viren eindringen können. Als tote Materie kann Feinstaub dieses Betriebssystem nicht beeinflussen. Der Autor hat auch noch nie gehört, dass Feinstaub irgendein Computersystem, dessen Betriebssystem lahmgelegt hätte.

Allerdings können TEs auch epigenetisch kontrolliert werden. Hierbei wird keine DNA verändert, sondern die DNA markiert. Wie weiter oben bereits angerissen, können die Verpackungseinheiten der Chromosome, die Histone, über chemische Stoffe methyliert oder acethyliert werden. Dies entscheidet darüber, ob die Polymerase II den Genabschnitt ablesen kann. Also Stoffe produziert werden oder ob nicht. Über die Zelleigenschaften nehmen Umwelteinflüsse darauf Einfluss, das Grundprinzip der Evolution auf Genomebene.

„Nur“, diese „Umwelteinflüsse“ müssen Tag ein, Tag aus, über Jahre anliegen, sonst verändert sich gar nichts. Beim Rauchen, das bekanntlich Krebs verursachen kann (wenn das Immunsystem, bzw. die genetische Ausstattung – der individuelle Phänotyp – dies nicht unterbindet) liegt dieses Tag ein Tag aus vor. Beim Feinstaub nicht! Selbst in Stuttgart wurde der Grenzwert nur an 63 Tagen in 2016 überschritten. Dies sind nicht einmal 10% eines Jahres und der gemessene Wert basiert hauptsächlich auf der Gewichtsklasse um 10µm und diese Gewichtsklasse beeinflusst rein gar nichts, weil sie nicht in der Lage ist, in den menschlichen Körper einzudringen. Zitat Prof. Ulrich Walter „PM 10 dringt nur bis in den Nasen-Rachenraum vor und ist daher gesundheitlich kaum bedenklich.“

Selbst das grüne Umweltamt in Stuttgart sagt zu dem kleinen Feinstaub von <2,5µm „seit Jahren keine Überschreitungen der Werte registriert“. Erschwerend kommt hinzu, dass der entzündungsauslösende Feinstaub in der Lunge, in Größenordnungen von <0,1µm liegt. Also nochmals der Faktor 25-mal kleiner als der angeblich gefährliche um 2,5µm.

Nein, bei den Feinstaubalarmen und Dieselfahrverboten geht es nicht um unsere Gesundheit, hier geht es um politische Mache zu Lasten eines ganzen Industriezweiges und auf dem Rücken der vielen, dortigen Beschäftigten. Aber dies ist den grünen Männchen und ihren Hilfstruppen gleichgültig. Durch die verbreitete Panik und Angstmache wird denn ausschließlich deren eigener Profit gestärkt. Sei es, um Wähler zu ihren Gunsten zu manipulieren, Macht auszuüben oder Gelder anzuhäufen. Alles zu Lasten unseres Landes und seiner Bürgerinnen und Bürger.

Teil 3: Scharlatane in Zeiten der Feinstaub-Hype, in kürze.

Raimund Leistenschneider – EIKE

Abb.19: Sebastiaen Vrancx, zugeschrieben, Affen mit Quacksalber auf einem Marktplatz. Der Autor vermag nun nicht zu sagen, ob der Affe symbolisch für die deutsche Qualitätspresse steht.