Die Gesetze der Mittelwerte: Teil 1 von 3, Obstsalat – Statistik

von Kip Hansen

Dieses Essay wird länger – und ist am besten solange gespeichert, bis Sie Zeit haben, es in seiner Gesamtheit zu lesen. Das Warten lohnt sich und die eventuelle Anstrengung.

Es kommt in drei Abschnitten: eine Einführung in Durchschnittswerte, eine allgemeine Diskussion über Metriken von Obstsalaten und eine eingehendere Diskussion über ein Beispiel mit einer veröffentlichten Studie.

NB: Während dieser Aufsatz als Beispiel eine ziemlich aktuelle Studie von Catherine M. O’Reilly, Sapna Sharma, Derek K. Grey und Stephanie E. Hampton anführt, mit dem Titel „Schnelle und sehr variable Erwärmung der Oberfläche Wasser in Seen rund um den Globus “

(.pdf hier; Poster hier, AGU Meeting Video-Präsentation hier) [der American Geophysical Union],

ist es nicht meine Absicht, die Studie [das paper] zu kritisieren – ich werde das anderen mit einem direkten Interesse überlassen. Mein Interesse liegt in den logischen und wissenschaftlichen Fehlern, den Informationsfehlern, die aus dem resultieren können, was ich spielerisch geprägt habe „Das erste Gesetz der Mittelwerte“.

Durchschnittswerte: Eine „erste Einführung“

Sowohl das Wort als auch das Konzept „Durchschnitt“ sind in der breiten Öffentlichkeit sehr viel Verwirrung und Missverständnis unterworfen und sowohl als Wort als auch im Kontext ist eine überwältigende Menge an „lockerem Gebrauch“ auch in wissenschaftlichen Kreisen zu finden, ohne die Peer-Reviewed-Artikel in Zeitschriften und wissenschaftlichen Pressemitteilungen auszuschließen. Lassen Sie uns eine kurze Einführung absolvieren oder eine Auffrischung zum Durchschnitt (die cognizanti = die „sich darüber im Klaren sind“, können direkt nach unten zu Obstsalat scrollen).

Substantiv (Hauptwort)

Eine Zahl, die den zentralen oder typischen Wert in einem Satz von Daten ausdrückt, insbesondere den Modus, den Median oder (am häufigsten) den Mittelwert, der berechnet wird, indem man die Summe der Werte in der Menge durch ihre Zahl dividiert.

„Die Immobilienpreise entsprechen zweimal dem nationalen Durchschnitt“

Synonyme: Mittel, Median, Modus

Adjektiv (Eigenschaftswort)

Die das Ergebnis darstellen, indem man mehrere Mengen addiert und dann diese Summe durch die Anzahl der Mengen dividiert.

„die durchschnittliche Temperatur im Mai war 64 °F (< 18°C)

Und natürlich das Verb „bedeuten“, um mathematisch einen Durchschnitt zu berechnen, wie im „Durchschnitt“. Da gibt es drei Haupttypen von „Durchschnittswerten“ gibt – der Modus, der Median und das Mittel – ein kurzer Blick auf diese:

Der Wert, der am häufigsten in einem gegebenen Satz von Daten auftritt.

Adjektiv

Die einen Wert oder eine Menge angeben, die am Mittelpunkt einer Häufigkeitsverteilung von beobachteten Werten oder Mengen liegt, so dass eine gleichmäßige Wahrscheinlichkeit besteht, über oder unter sie zu fallen.

„Die mediane Dauer dieser Behandlung betrug vier Monate“

Substantiv

Der Medianwert eines Wertebereichs.

„Anbauflächen reichten von einem bis zweiundfünfzig mit einem Median von vierundzwanzig“

Substantiv

Der Wert, der durch Dividieren der Summe mehrerer Mengen durch ihre Zahl erhalten wird; ein Durchschnitt.

„die Säurehaltigkeit wurde aus dem der Mittelwert aller drei Proben berechnet“

Adjektiv

(aus einer Menge) als ein Mittelwert berechnet; dem Durchschnitt

„in 1984 war das mittlere Heiratsalter bei Frauen 24,8 Jahre und 26,9 Jahre bei Männern“

„die mittlere Temperatur …“

Mehrere dieser Definitionen beziehen sich auf „einen Satz von Daten“ … In der Mathematik ist ein Satz eine wohldefinierte Sammlung von verschiedenen Objekten, die als ein Objekt in ihrem eigenen „Recht“ betrachtet werden [Zugehörigkeit, Eigenschaft; Lage, Art, … usw.]. (Z. B. sind die Zahlen 2, 4 und 6 verschiedene Objekte wenn sie getrennt betrachtet werden, aber wenn sie zusammen betrachtet werden, bilden sie einen einzigen Satz der Größe drei, geschrieben {2,4,6}.)

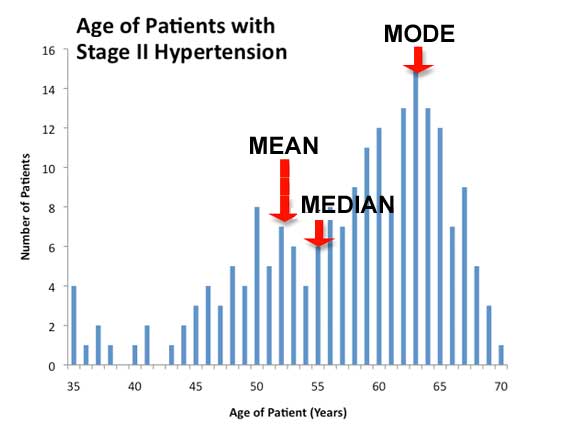

Dieses Bild fasst die drei verschiedenen gemeinsamen Mittelwerte zusammen:

[Alter der Patienten mit Bluthochdruck, Stufe II]

Hier sehen wir das Alter, bei dem die Patienten Stufe II Hypertonie (schwerer HBP – hoher Blutdruck) entwickeln entlang der x-Achse und die Anzahl der Patienten [die daran leiden] entlang der linken vertikalen Achse (y-Achse). Dieses Balkendiagramm oder Histogramm zeigt, dass einige Patienten HBP ziemlich jung entwickeln, in ihren späten 30 und 40ern, nach 45 erhöht sich die Inzidenz mehr oder weniger stetig mit fortschreitendem Alter bis zur Mitte der 60er Jahre, danach fällt die Inzidenz [die Anzahl der Betroffenen] ab. Wir sehen, was eine schiefe Verteilung genannt wird, schief nach rechts. Diese Schande (rechts oder links) ist typisch für viele reale Weltverteilungen. [also nicht gleichmäßig oder Gaußsche Verteilungskurve; Einschub des Übersetzers]

Was wir normalerweise den Durchschnitt nennen würden, der Mittelwert, berechnet durch das Zusammenfügen aller Altersstufen der Patienten, bei denen sich HBP entwickelt hat und die Teilung durch die Gesamtanzahl der Patienten – obwohl mathematisch korrekt, ist das klinisch nicht sehr informativ. Es ist wahr, dass das mittlere Alter für die Entwicklung von HPB bei etwa 52 Jahre liegt, ist es weit häufiger, HPB in den späten 50er bis Mitte der 60er Jahre zu entwickeln. Es gibt medizinische Gründe für diese Verschiebung der Daten – aber für unsere Zwecke ist es genug zu wissen, dass jene Patienten, die HPB im jüngeren Alter entwickeln, den Mittelwert verschieben – ignorieren wir die Ausreißer auf der linken Seite, würde das das Mittel mehr in Einklang mit den tatsächlichen Inzidenz Zahlen bringen.

Medizinisch gesehen, weist dieses Histogramm darauf hin, dass es zwei verschiedene Ursachen oder Krankheitswege für HPB geben kann. Eine, die mit einem frühen Beginn für HPB und eine im Zusammenhang mit fortschreitendem Alter, manchmal auch als später hoher Blutdruck bekannt.

(In diesem Beispiel ist das Median Alter für HPB überhaupt nicht sehr informativ.)

Unser HPB-Beispiel kann gelesen werden als „Im Allgemeinen, beginnt das reale Risiko, HPB zu bekommen, in der Mitte der 40er Jahre und das Risiko steigt weiter bis zur Mitte der 60er Jahre. Wenn Sie HPB nicht um 65 oder so entwickelt haben, verringert sich Ihr Risiko mit zusätzlichen Jahren, obwohl Sie noch wachsam sein müssen. “

Unterschiedliche Datensätze haben unterschiedliche Informationswerte für die verschiedenen Arten von Durchschnittswerten.

Hauspreise [Immobilien] für eine Gegend werden oft als Mediane Hauspreise zitiert. Wenn wir den Mittelwert betrachteten, würde der Durchschnitt von den Häusern, die von den reichsten 1% der Bevölkerung bevorzugt werden, nach oben geschoben werden, d.h. Häuser, die in Millionen Dollar gemessen werden (siehe hier und hier, und hier).

Aktienmärkte werden oft durch Dinge wie dem Dow Jones Industrial Average (DJIA) beurteilt [ein preisgewichteter Durchschnitt von 30 bedeutenden Aktien, die an der New Yorker Börse (NYSE) und der NASDAQ gehandelt wurden und von Charles Dow im Jahre 1896 erfunden wurden]. Ein gewichteter Durchschnitt ist ein Mittelwert, der durch die gegebenen Werte in einem Datensatz mit mehr Einfluss nach einem Attribut der Daten berechnet wird. Es ist ein Durchschnitt, in dem jeder durchschnittlichen Menge ein Gewicht zugewiesen wird, und diese Gewichtungen bestimmen die relative Wichtigkeit jeder Menge im Durchschnitt. Der S & P 500 ist ein Börsenindex, der die 500 am meisten gehaltenen Aktien an der New Yorker Börse oder NASDAQ verfolgt. [Ein Aktienindex … ist ein Maß für den Wert eines Teils der Börse. Es wird aus den Preisen ausgewählter Bestände berechnet, in der Regel ein gewichteter Durchschnitt.]

Familieneinkommen werden von der US Census Bureau [statistisches Amt] jährlich als das „Median Household Income“ für die Vereinigten Staaten gemeldet [$ 55.775 im Jahr 2015].

Lebenserwartung wird von verschiedenen internationalen Organisationen als „durchschnittliche Lebenserwartung bei der Geburt“ gemeldet (weltweit war es 71,0 Jahre über den Zeitraum 2010-2013). „Mathematisch ist die Lebenserwartung die mittlere Anzahl von Lebensjahren, die in einem gegebenen Alter noch verbleiben, vorausgesetzt, dass die altersbedingten Sterblichkeitsraten bei ihren zuletzt gemessenen Werten bleiben. … Darüber hinaus, weil die Lebenserwartung ein Durchschnitt ist, kann eine bestimmte Person viele Jahre vorher oder viele Jahre nach dem „erwarteten“ Überleben sterben. “ (Wiki).

Such man mit einer der großen Internet-Suchmaschinen nach Phrasen, einschließlich des Wortes „Durchschnitt“ wie „durchschnittliche Kosten für ein Brot“, „durchschnittliche Größe von 12-jährigen Kindern“ kann man sich stundenlang unterhalten.

Allerdings ist es zweifelhaft, dass Sie danach als Ergebnis mehr wissen als vorher.

Diese Reihe von Essays ist ein Versuch, diesen letzten Punkt zu beantworten: Warum wissen Sie nach dem Lesen von Durchschnitten nicht mehr als vorher?

Obstsalat

Wir haben alle schon mal Vergleiche von Äpfeln mit Birnen gesehen.

[Amerikaner nehmen andere Früchte für unzulässige Vergleiche: Äpfel mit Orangen, daher geht es nun weiter mit Orangen, der Abwechslung wegen, tippe ich auch mal Fruchtsalat anstatt Obstsalat, der Übersetzer]

Von einem Vergleich von Äpfeln mit Orangen spricht man, wenn zwei Dinge oder Gruppen von Dingen miteinander verglichen werden, die praktischerweise nicht zusammengehören. Die Redewendung, „Äpfel mit Orangen vergleichen“, bezieht sich auf offensichtliche Unterschiede zwischen Dingen, die gewöhnlich als nicht vergleichbar oder unvergleichbar angesehen werden, so wie Äpfel mit Orangen.

Dinge die man vergleicht, müssen homogen genug sein, um vergleichbar zu sein und nicht so heterogen, dass sie so nicht zusammen verglichen werden können.

Adjektive

Von der gleichen Art, ähnlich

„Holzfäller bevorzugen Bäume der gleichen Art“

Bestehend aus der gleichen Sorte

„kulturell gesprochen, stellen die Bauern eine extrem homogene Gruppe dar“

Adjektive (heterogen)

Unterschiedlich in Charakter oder Inhalt

„ein große und heterogene Auswahl“

Adjektive (incommensurable)

Können nicht durch denselben Standard wie etwas anderes vergleichen werden, kein gemeinsamer Standard oder gemeinsame Bewertung.

„diese zwei Arten der Wissenschaft sind inkomparabel“

Probleme treten sowohl physisch als auch logisch auf, wenn Versuche unternommen werden, „Mittelwerte“ von nicht vergleichbaren oder inkommensurablen Objekten zu finden – Objekte und / oder Messungen, die nicht logisch oder physisch (wissenschaftlich) zum selben „Satz“ gehören.

Die Diskussion von Datensätzen für Amerikaner, die in den 40er und 50er Jahren zur Schule gingen, kann für diese verwirrend sein. Später aber, wurden jüngere Amerikaner den Begriffen von Datensätzen frühzeitig ausgesetzt. Für unsere Zwecke können wir eine einfache Definition einer Sammlung von Daten über eine Anzahl ähnlicher, vergleichbarer, gleichartiger, homogener Objekte verwenden und bei einem Datensatz sind die Daten selbst vergleichbar und [liegen] in kompatiblen Messeinheiten vor. (Viele Datensätze enthalten viele Untermengen von verschiedenen Informationen über denselben Satz von Objekten. Ein Datensatz über eine Studie von Eastern Chipmunks [Streifenbackenhörnchen] kann Sub-Sets wie Höhe, Gewicht, geschätztes Alter usw. enthalten. Die Untermengen müssen Intern homogen sein – so wie „alle Gewichte in Gramm“.)

Man kann nicht das Gewicht mit dem Geschmack eines Korbes von Äpfeln vergleichen. Gewicht und Geschmack sind nicht vergleichbare Werte. Auch kann man das Gewicht nicht mit der Farbe der Bananen vergleichen.

Ebenso kann man die Höhe / Länge von Einzelnen in einer Zusammenstellung nicht logisch „mitteln“, wie „alle Tiere, die im zusammenhängenden nordamerikanischen Kontinent leben (als da sind USA, Kanada und Mexiko)“ Warum? Neben der Schwierigkeit beim Sammeln eines solchen Datensatzes, obwohl die Messungen alle in Zentimeter (ganze oder Teile davon) sein können, ist „alle Tiere“ kein logischer Satz von Objekten bei der Betrachtung von Höhe / Länge.

Ein solcher Datensatz, würde alle Tiere von Bison, Elch und Kodiakbären über Rinder, Hirsche, Hunde, Katzen, Waschbären, Nagetiere, Würmer, Insekten aller Arten, multizelluläre, aber mikroskopisch kleine Tiere und einzellige Lebewesen enthalten. In unserem ausgewählten geographischen Gebiet gibt es (sehr sehr grob) geschätzte 1 quintillion fünfhundert quadrillionen (1.500.000.000.000.000.000 [1,5 x10^18]) allein an Insekten.

Es gibt nur 500 Millionen Menschen, 122 Millionen Rinder, 83 Millionen Schweine und 10 Millionen Schafe in der gleichen Gegend. Insekten sind klein und viele in der Anzahl und einige Säugetiere sind vergleichsweise groß aber wenige in der Anzahl. Uni- und multizelluläre mikroskopische Tiere? Jeder der 500 Millionen Menschen hat im Durchschnitt über 100 Billionen (100.000.000.000.000) Mikroben in und an ihrem Körper. Bei jeder Methode – Mittelwert, Median oder Modus – würde die durchschnittliche Höhe / Länge aller nordamerikanischen Tiere buchstäblich etwas verschwinden – so klein, dass man „im Durchschnitt“ nicht erwarten würde, dass man „Tiere“ mit bloßen Augen sehen kann.

Um einen Durchschnitt eines beliebigen Typs zu berechnen, der physisch, wissenschaftlich sinnvoll und logisch und nützlich ist, muss der gemittelte Datensatz selbst eine vergleichbare, ange-messenbare, homogene Sammlung von Objekten sein, mit Daten über diese Objekte, die vergleichbar und angemessen sind.

Wie ich später besprechen werde, gibt es Fälle, in denen die Sammlung (der Datensatz) richtig und vernünftig erscheint, die Daten über die Sammlung scheinen vergleichbare Einheiten zu sein und doch entpuppt sich der daraus resultierende Durchschnitt als nicht-physisch – es macht keinen Sinn in Bezug auf Physik oder Logik.

Diese Arten von Durchschnittswerten, von ungleichartigen, heterogenen Datensätzen, in denen entweder die Messungen oder die Objekte selbst inkommensurabel sind – wie Vergleiche von Äpfeln und mit Orangen und mit Bananen – geben Sie die Ergebnisse, die als Fruchtsalat bezeichnet werden können und haben Anwendbarkeit und Bedeutung, die von sehr verschieden bis nur gering über unsinnig bis überhaupt nicht reicht.

„Der Klimawandel erwärmt die Seen der Welt rapide“

Dies wird als der wesentliche Punkt einer Studie von Catherine M. O’Reilly, Sapna Sharma, Derek K. Grey und Stephanie E. Hampton herausgestellt,

mit dem Titel “Rapid and highly variable warming of lake surface waters around the globe” [ .pdf hier; poster hier, AGU Video Präsentation des Meetings hier ].

[„Schnelle und sehr variable Erwärmung von Seewasserflächen rund um den Globus“, AGU American Geophysical Union]

Es ist bemerkenswert, dass die Studie ein Ergebnis der Global Lake Temperature Collaboration (GLTC) ist, die besagt: „Diese Erkenntnisse, die Notwendigkeit der Synthese von Vor-Ort- und Fernerkundungsdatensätzen und die anhaltende Bestätigung, dass der globale und regionale Klimawandel wichtige Auswirkungen auf Terrestrische und aquatische Ökosysteme hat, ist die Motivation hinter der Global Lake Temperature Collaboration. “

Die AGU-Pressemitteilung zu dieser Studie beginnt mit: „Der Klimawandel erwärmt die Seen der ganzen Welt rapide, bedroht die Süßwasser- und Ökosysteme, nach einer neuen Studie über sechs Kontinente.“

„Diese Studie, die von der NASA und der National Science Foundation gefördert wurde, fand Seen, die durchschnittlich um 0,61 Grad Fahrenheit (0,34 Grad Celsius) jedes Jahrzehnt erwärmt wurden. Das ist mehr als die Erwärmungsrate des Ozeans oder der Atmosphäre und es kann tiefgreifende Effekte haben, sagen die Wissenschaftler. „

Darauf folgen die „beängstigenden“ – wenn dieser Trend fortfährt – Szenarien.

Nirgendwo in der Pressemitteilung wird angegeben, was tatsächlich gemessen, gemittelt und gemeldet wird. (Siehe „Was zählen sie wirklich?„)

Also, was wird gemessen und berichtet? Am Beginn der AGU Video-Präsentation, sagen Simon Hook, von JPL und einer der Co-Autoren, in der Frage & Antwort Runde aus, dass „das sommernächtliche Oberflächentemperaturen sind.“

Lassen Sie mich noch deutlicher sein – das sind sommerliche, nächtliche Temperaturen der Wasser-(Haut-) Oberfläche wie in „Die SST [Sea surface temperature – See Oberflächen …] direkt an der Oberfläche heißt „Haut SST“ und kann sich deutlich von der Masse der SST unterscheiden, vor allem bei schwachen Winden und hohen Mengen an auftreffendem Sonnenlicht …. Satelliten-Instrumente, die im Infrarot-Teil des Spektrums messen, messen im Prinzip die „Haut SST“. „[Quelle]

Bei weiterem nachhaken, erklärt Simon Hook weiter, dass die Temperaturen in der Studie, stark beeinflusst durch Satelliten-Messungen sind, da die Daten zum großen Teil Satelliten-Daten sind , nur sehr wenig Daten sind eigentlich in situ [„an ihrer ursprünglichen Stelle oder in der Position“ – von Hand oder per Boje, zum Beispiel] gemessen worden. Diese Information steht natürlich auch für diejenigen zur Verfügung, die die ganze Studie lesen und sorgfältig durch die ergänzenden Informationen und Datensätze gehen – aber es wird durch die Abhängigkeit von der Aussage verdeckt, die immer wiederholt: „die Seen erwärmen sich durchschnittlich jedes Jahrzehnt um 0,61 Grad Fahrenheit (0,34 Grad) Celsius).“

Welche Art von Durchschnitt? Äpfel und Orangen und Bananen – gibt Fruchtsalat.

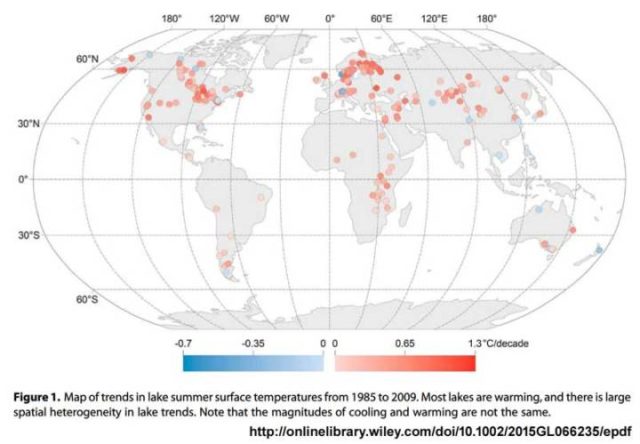

Dies ist die Karte der untersuchten Seen:

Man muss kein See-Experte sein, um zu erkennen, dass diese Seen von den Großen Seen in Nordamerika und bis zum Tanganjika-See in Afrika und zum Lake Tahoe in den Sierra Nevada Mountains an der Grenze von Kalifornien und Nevada reichen. Einige Seen sind kleiner und flach, einige Seen sind riesig und tief, einige Seen sind in der Arktis und manche sind in den Wüsten, einige Seen sind mit Eis bedeckt, und einige Seen sind noch nie zugefroren, einige Seen erhalten Schmelzwasser und einige werden von langsam fließenden Äquatorflüssen gespeist.

Natürlich würden wir davon ausgehen, dass, wie die Land Oberflächentemperatur und die Meeres Oberflächentemperatur, der Durchschnitt der See Wasser Temperatur in dieser Studie durch die See Oberfläche gewichtet wird. Nein ist es nicht. Jeder See in der Studie ist gleichwertig, egal wie klein oder groß, wie tief oder wie flach, Schnee gefüttert oder Fluss gespeist. Da die überwiegende Mehrheit der Studiendaten aus Satellitenbeobachtungen stammt, sind die Seen alle „größer“, kleine Seen, wie der Stausee für meine Wasserversorgung, werden durch den Satellit nicht leicht erkannt.

Also, was haben wir davon, wenn wir die [nächtliche Hautoberfläche in der Sommerzeit] Wassertemperatur von 235 heterogenen Seen „durchschnittlich“ vergleichen“ Wir bekommen einen Obstsalat – eine Metrik, die mathematisch korrekt ist, aber physisch und logisch weit von jeder Nutzung entfernt ist [außer für Propagandazwecke].

Dies wird in der Zusammenfassung der Studie frei eingestanden, die wir uns fragmentarisch anschauen können: [zitierte Zusammenfassung in Kursivschrift]

„Die hohe räumliche Heterogenität der in dieser Studie gefundenen See-Erwärmungs-Raten stehen im Widerspruch zur üblichen Annahme der allgemeinen regionalen Kohärenz.“

Seen reagieren regional nicht auf eine einzige Ursache – wie „globale Erwärmung“. Seen in der Nähe von einander oder in einer definierten Umweltregion sind nicht notwendigerweise in ähnlicher Weise oder aus dem gleichen Grund erwärmt, und einige benachbarte Seen haben entgegengesetzte Zeichen der Temperaturänderung. Die Studie widerlegt die Erwartung des Forschers, dass die regionale Oberflächen-Temperaturerwärmung der regionalen See-Erwärmung entsprechen würde. Nicht so.

„Seen, deren Erwärmungsraten ähnlich waren, in Verbindung mit bestimmten geomorphen oder klimatischen Prädiktoren (dh., Seen innerhalb eines „Blattes“ [der Übersicht; ~ Umgebungsbedingungen]), (siehe die Studie für das Übersichtsdiagramm), zeigten eine nur eine schwache geographische Gruppierung (Abbildung 3b), im Gegensatz zu früheren Schlussfolgerungen der regional – skalierten, räumlichen Kohärenz [~ Zusammenhängen] in den Seen-Erwärmungs-Trends [Palmer et al., 2014; Wagner et al., 2012]. „

Seen erwärmen sich geomorph (nach der Form der Landschaft und anderen natürlichen Eigenschaften der Erdoberfläche) und dem lokalen Klima – nicht regional, sondern individuell. Diese Heterogenität impliziert das Fehlen einer einzigen oder sogar ähnlicher Ursachen innerhalb der Regionen. Mangel an Heterogenität bedeutet, dass diese Seen nicht als ein einziger [zusammenhängender] Datensatz betrachtet werden sollten und es deshalb keinen Sinn macht, diese zu mitteln.

„In der Tat, ähnlich reagierende Seen waren weitgehend auf der ganzen Welt verteilt, was darauf hinweist, dass die Eigenschaften der Seen, Klima-Effekte stark vermitteln können.“

Weltweit gesehen, sind Seen im Zusammenhang mit der Oberflächenwassertemperatur kein physikalisch sinnvoller Datensatz.

„Die Heterogenität in den Erwärmungsraten der Oberflächen unterstreicht die Bedeutung der Berücksichtigung von Wechselwirkungen zwischen Klima und geomorphen Faktoren, die die Seen zu Reaktionen antreiben und einfache Aussagen über Oberflächenwassertrends verhindern; Man kann nicht davon ausgehen, dass jeder einzelne See sich gleichzeitig mit der Lufttemperatur erwärmt hat oder dass alle Seen in einer Region sich gleich erwärmen. „

Auch hier ist ihre Schlussfolgerung, dass die Seen weltweit kein physikalisch sinnvoller Datensatz im Zusammenhang mit der Oberflächenwassertemperatur sind, aber sie bestehen darauf, einen einfachen Durchschnitt zu finden, das heißt, die darauffolgenden Schlussfolgerungen und Warnungen zu diesem Mittelwert.

„Die Vorhersage der zukünftigen Reaktionen der Seeökosysteme auf den Klimawandel beruht darauf, die Natur solcher Wechselwirkungen zu identifizieren und zu verstehen.“

Die überraschende Schlussfolgerung zeigt, dass, wenn sie herausfinden wollen, was die Temperatur eines bestimmten Sees betrifft, müssen sie diesen See und sein lokales Ökosystem für die Ursachen jeder Veränderung studieren.

Ein mutiger Versuch wurde gemacht, diese Studie mit Ad-hoc-Schlussfolgerungen zu retten – aber die meisten geben einfach zu, dass ihre ursprüngliche Hypothese von „Globale Erwärmung verursacht weltweite Erwärmung von Seen“ entkräftet wurde. Seen (zumindest die sommernächtlichen Oberflächentemperaturen der Seen) können sich erwärmen, aber sie erwärmen sich nicht noch nicht mal mit den Lufttemperaturen, und nicht zuverlässig im Gleichklang mit anderen besonderen geomorphen oder klimatischen Faktoren, und nicht unbedingt wärmer werdend, auch wenn die Lufttemperaturen vor Ort steigen Zwangsläufig fallen die Forscher auf die „durchschnittliche“ Metrik der Wärme der Seen zurück.

Diese Studie ist ein gutes Beispiel dafür, was passiert, wenn die Wissenschaftler versuchen, Mittelwerte für Dinge zu finden, die unähnlich sind – so unähnlich, dass sie nicht in das gleiche „Set“ gehören. Man kann es mathematisch machen – alle Zahlen sind zumindest in den gleichen Einheiten von Grad C oder F – aber solche Mittelwerte geben Ergebnisse, die nicht-physisch und unsinnig sind – ein Obstsalat, der aus dem Versuch besteht, diesen als Durchschnitt von Äpfel und Orangen und Bananen zu beschreiben.

Darüber hinaus können die Obstsalat-Mittelwerte nicht nur in die Irre führen, sondern sie verdecken mehr Informationen als sie erhellen, wie sich aus dem Vergleich der vereinfachten Pressemitteilung deutlich ergibt. „Seen erwärmen sich durchschnittlich um 0,61 Grad Fahrenheit (0,34 Grad Celsius) je Jahrzehnt“ zu den tatsächlichen, wissenschaftlich gültigeren Erkenntnissen der Studie, die zeigen, dass sich die Temperatur eines jeden Sees aufgrund lokaler, manchmal sogar individueller, geomorpher und klimatischer Bedingungen für jeden See ändert und damit Zweifel an der Idee globaler oder regionaler Ursachen nährt.

Ein weiteres Beispiel für eine Fruchtsalat-Metrik wurde in meinem schon länger zurückliegenden Baked Alaska? Essay [Kocht Alaska] gezeigt. Der den logischen und wissenschaftlichen Irrtum der Temperatur von Alaska als Einheit, den „Staat Alaska“, als eine politische „Abteilung“ hervorgehoben hat, obwohl Alaska, das sehr groß ist, aus 13 verschiedenen unterschiedlichen Regionen besteht, die sich mit unterschiedlichen Raten erwärmen und kühlen (und offensichtlich mit verschiedenen Anzeichen) über unterschiedliche Zeiträume. Diese wichtigen Details sind alle verloren, verdeckt, durch den staatlichen Durchschnitt.

Das Entscheidende:

- Es reicht nicht aus, den Durchschnitt eines Datensatzes korrekt mathematisch zu berechnen.

- Es reicht nicht aus, die Methoden zu verteidigen, die Ihr Team verwendet, um die [öfter-missbraucht-als-nicht] globalen Mittelwerte von Datensätzen zu berechnen.

- Datensätze müssen homogen, physisch und logisch sein. Sie müssen Datensätze von Gleiches-mit-Gleichem sein, nicht Äpfel-und-Orangen. Datensätze, auch wenn die Mittelwerte mit korrekten Methoden berechnet werden können, müssen sie sowohl physisch als auch logisch plausibel sein.

Sorgfältige kritische Denker werden auf der Hut sein bei Zahlen, die, obwohl sie Ergebnisse einer einfachen Hinzufügung und Teilung sind, in der Tat Obstsalat Metriken sind, mit wenig oder keiner wirklichen Bedeutung oder mit Bedeutungen, weit anders als die, für die sie angeführt werden.

Man sollte mit großer Sorgfalt prüfen, ob die Zahl, die als Durchschnitt dargestellt wird, tatsächlich das Ergebnis darstellt, für das sie beansprucht wird. Durchschnittswerte haben am häufigsten nur eine sehr begrenzte Anwendbarkeit, da sie die Details verdecken, die oft die viel wichtigere Wirklichkeit enthüllen [was das Thema des nächsten Aufsatzes in dieser Serie ist).

# # # # #

Hinweis auf LOTI, HadCRUT4, etc .: Es ist meine persönliche Meinung, dass alle kombinierten Land und See Oberflächen Temperatur Metriken, und wie sie alle genannt werden, einschließlich derer, die als Indizes, Anomalien und „Vorhersagen der kleinsten Fehlerbandbreite“, genau diese Art von durchschnittlichem Obstsalat sind. In der Physik, wenn nicht Klimawissenschaft, ist die Temperaturänderung ein Indikator für die Veränderung der Wärmeenergie eines Objekts (z. B. eines bestimmten Luft- oder Meerwasservolumens). Um einen gültigen Mittelwert von Mischluft- und Wassertemperaturen zu berechnen, muss der Datensatz zunächst gleiche Einheiten für gleichwertige Volumina gleichen Materials enthalten (die automatisch alle Datensätze von Meeres-Oberflächenhaut-Temperaturen, die volumenlos sind) ausschließt.

Die Temperaturen unterschiedlicher Volumina von unterschiedlichen Materialien, auch Luft, mit unterschiedlicher Feuchtigkeit und Dichte, können nicht gültig gemittelt werden, ohne in einen Satz von Temperatur-Äquivalent-Einheiten der Wärmeenergie für dieses Material nach Volumen umgewandelt zu werden. Luft und Wasser (und Stein- und Straßenoberflächen und gepflügte Felder) haben viele unterschiedliche spezifische Wärmekapazitäten, so dass eine 1 ° C Temperaturänderung gleicher Volumina dieser unterschiedlichen Materialien sehr unterschiedliche Änderungen der thermischen Energie darstellt. Meeresoberfläche (Haut oder Masse) Temperaturen können nicht mit Oberflächenlufttemperaturen gemittelt werden, um eine physikalisch korrekte Darstellung zu erzeugen, die als Änderung der thermischen (Wärme-) Energie beansprucht wird – die beiden Datensätze sind inkommensurabel und solche Mittelwerte sind Obstsalat.

Und doch sehen wir jeden Tag, dass diese Oberflächentemperatur-Metriken in genau jener nicht-physikalischen Weise dargestellt sind – als ob sie der quantitative Beweis für eine zunehmende oder abnehmende Energie [-beinhaltung] des Erdklimasystems sind. Dies bedeutet nicht, dass korrekt gemessene Lufttemperaturen bei 2 Metern über der Oberfläche und Oberflächen-Meerwassertemperaturen (Masse – da Argo [Messboje] in bestimmten Tiefen schwimmt) uns nicht etwas sagen kann, aber wir müssen sehr sorgfältig bedenken, was sie uns erzählen. Die getrennten Mittelwerte dieser Datensätze werden dennoch immer noch allen Fallstricken und Qualifikationen unterworfen, die in dieser Reihe von Essays vorgestellt werden.

Unser häufiger Kommentator, Steven Mosher, hat kürzlich kommentiert:

„Die globale Temperatur existiert. Sie hat eine genaue physikalische Bedeutung. Es ist die Bedeutung, die uns sagen kann …

In der „kleinen Eiszeit“ war es kühler als heute … es ist die Mittelung, die es uns erlaubt zu sagen, die Tagesseite des Planeten, ist wärmer als die Nachtseite … Die gleiche Mittelung, die uns erlaubt zu sagen, dass Pluto kühler ist als die Erde und der Merkur ist wärmer. „

Ich muss sagen, dass ich mit seiner Aussage einverstanden bin – und wenn Klimawissenschaftler ihre Ansprüche auf verschiedene Global-Temperatur-Durchschnittswerte auf diese drei Konzepte beschränken würden, würden ihren Behauptungen weitaus wissenschaftlicher sein.

NB: Ich glaube nicht, dass es richtig ist zu sagen: „Es hat eine genaue physikalische Bedeutung.“ Es kann eine genaue Beschreibung sein, aber was es für das Klima der Erde bedeutet, ist bei weitem nicht sicher und wird auch nicht präziser durch irgendwelche Messungen.

Ich erwarte, dass Ihre Meinungen zu diesem Thema variieren können.

# # # # #

Erschienen auf WUWT am 14.06.2017

Übersetzt durch Andreas Demmig

Teil 2 und 3 folgen nach