Das Gute, das Schlechte und die Null-Hypothese

*CAGW = katastrophale anthropogene globale Erwärmung.

**„Strohmann-Trugschluss“: Eine gute Erklärung dazu gibt es hier.

Dies ist gleichbedeutend mit der Argumentation, dass man Konvektion widerlegen muss, um die Plattentektonik zu falsifizieren, oder die Genetik, um die Evolution zu falsifizieren. Plattentektonik und Evolution sind äußerst haltbare wissenschaftliche Theorien, welche auf einer Kombination empirischer und korrelativer Beweise beruhen. Keine der beiden Theorien kann direkt getestet werden mittels eines kontrollierten Experimentes. Allerdings sind beide Theorien mit Jahrzehnte langen Beobachtungen überprüft worden. Nachfolgende Beobachtungen haben diese Theorien voll und ganz bestätigt.

Anmerkung: Ich werde mich hier nicht in Debatten ergehen über die Validität der wissenschaftlichen Theorien der Plattentektonik oder der Evolution!

Die Macht derartiger wissenschaftlicher Theorien wird demonstriert durch ihre Vorhersagbarkeit: Theorien sind Vorhersagen zukünftiger Beobachtungen. Darum ist eine robuste wissenschaftliche Theorie sogar noch stärker als Fakten (lies Messungen/Beobachtungen).

CAGW ist ein ähnlicher Typ theoretischer Hypothese. Sie hängt ab von empirischen („guten“) und korrelativen („schlechten“) Beweisen.

Die Guten

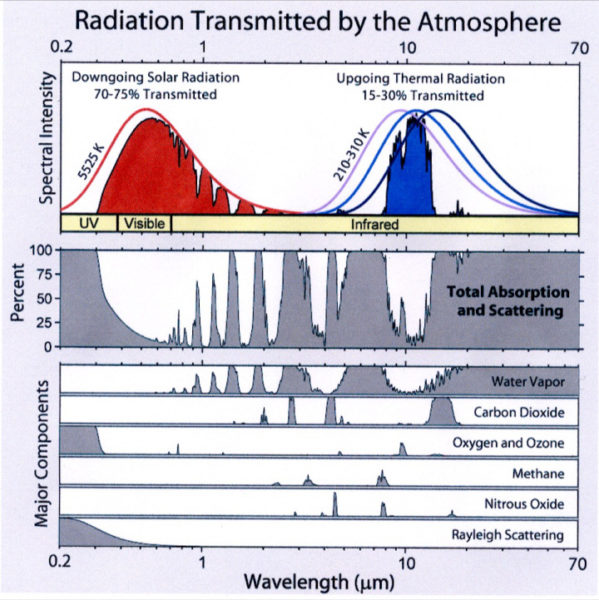

Kohlendioxid ist ein so genanntes „Treibhausgas“. Es verlangsamt Strahlungsabkühlung. Hält man alle anderen Faktoren konstant, wird eine steigende atmosphärische CO2-Konzentration zu irgendwie höheren Temperaturen führen. Allerdings sind alle anderen Dinge in der Erd- und Atmosphären-Wissenschaft niemals konstant… Die Atmosphäre ist nicht Luft in einem Gefäß; Verweise auf Arrhenius haben keine Bedeutung.

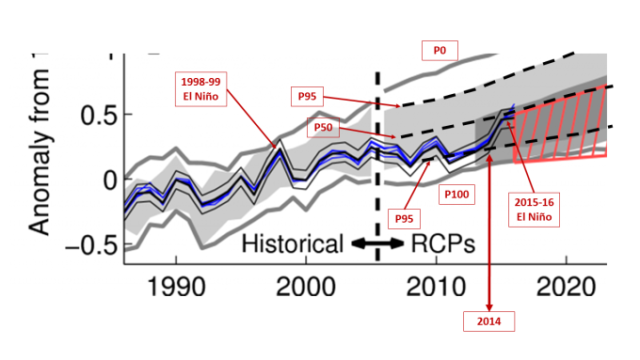

Abbildung 1: Treibhausgas-Spektren. Quelle. Der atmosphärische CO2-Gehalt ist seit dem 19. Jahrhundert gestiegen.

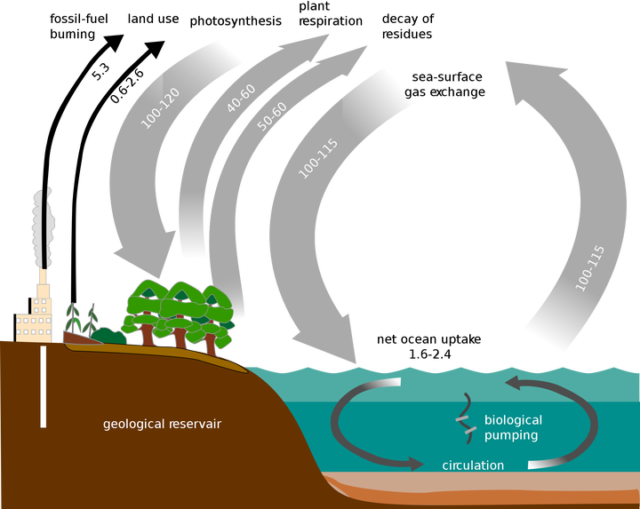

Während anthropogene Quellen nur einen winzigen Bruchteil der Gesamtquellen ausmachen, holen wir Kohlenstoff aus der geologischen Abscheidung wieder hervor und führen ihn zurück in den aktiven Kohlenstoff-Zyklus.

[Anmerkung des Übersetzers: Hier habe ich selbst mir Gedanken gemacht, warum der Mensch die Verpflichtung hat, den Kohlenstoff in den aktuellen Kohlenstoff-Kreislauf zurückzuführen!]

Abbildung 4: Kohlenstoffzyklus. Quelle.

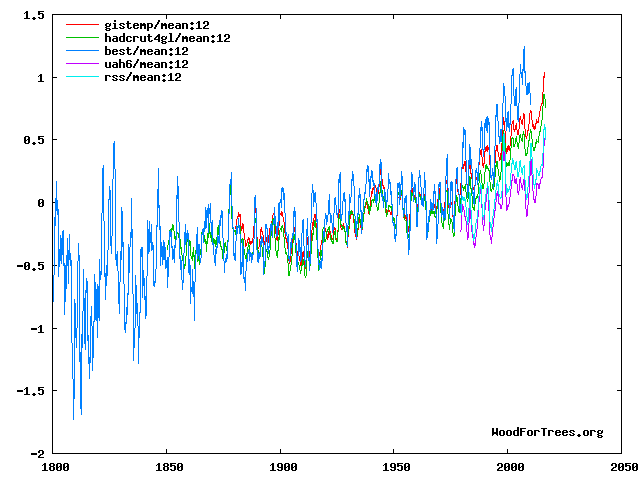

Die mittlere Temperatur an der Oberfläche der Erde und in der Troposphäre ist während der letzten 150 Jahre allgemein gestiegen.

Atmosphärisches CO2 ist gestiegen, und eine Erwärmung fand statt.

Die Schlechten

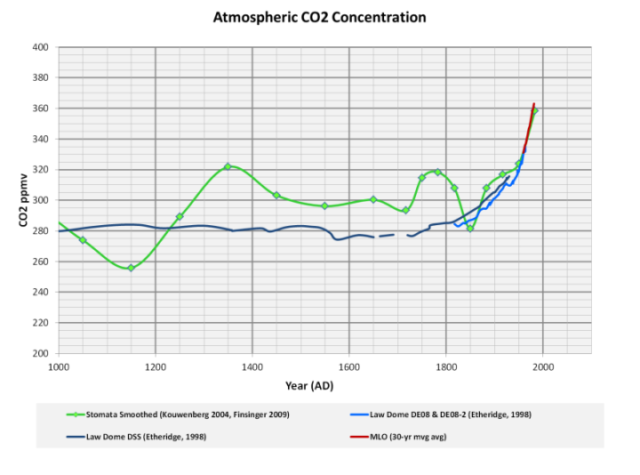

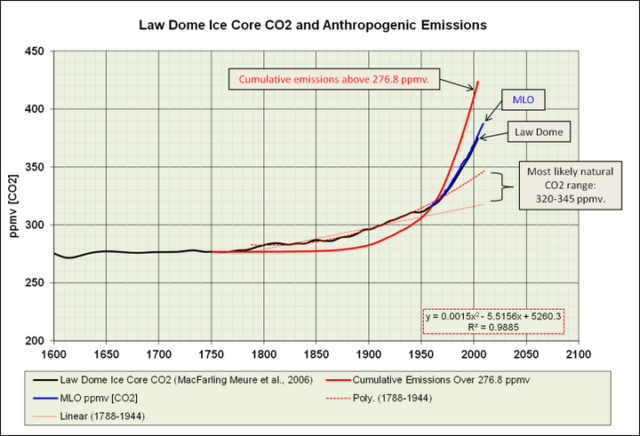

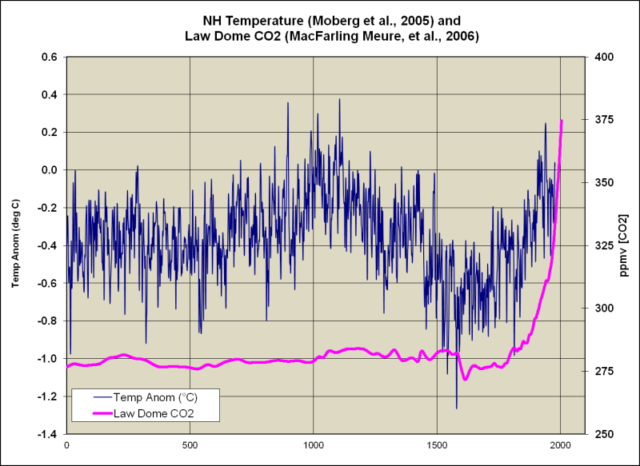

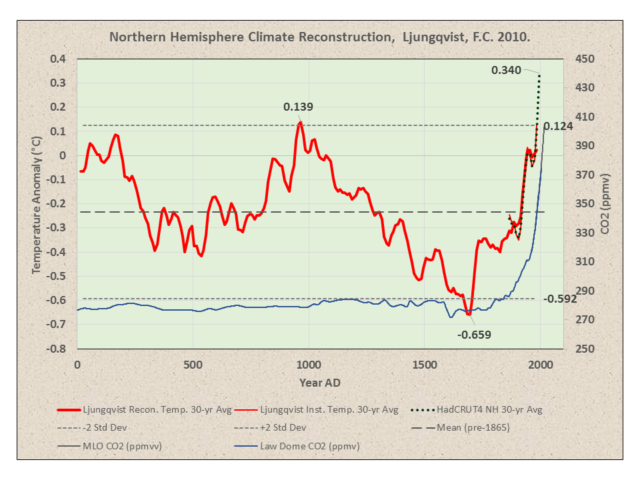

Die moderne Erwärmung begann lange vor dem jüngsten Anstieg der atmosphärischen CO2-Konzentration, und vor dem 19. Jahrhundert waren Temperatur und CO2 entkoppelt:

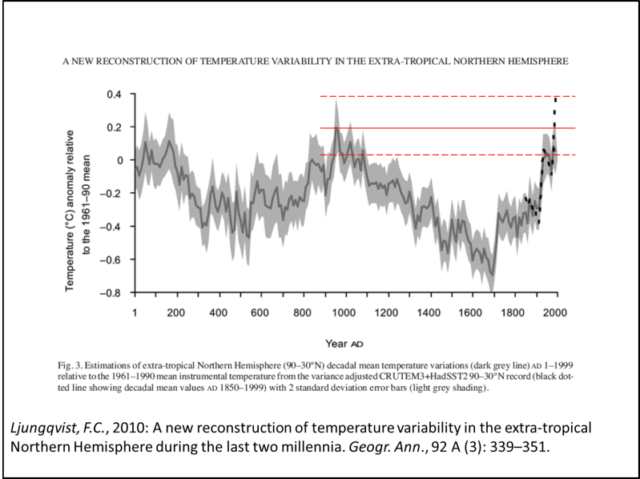

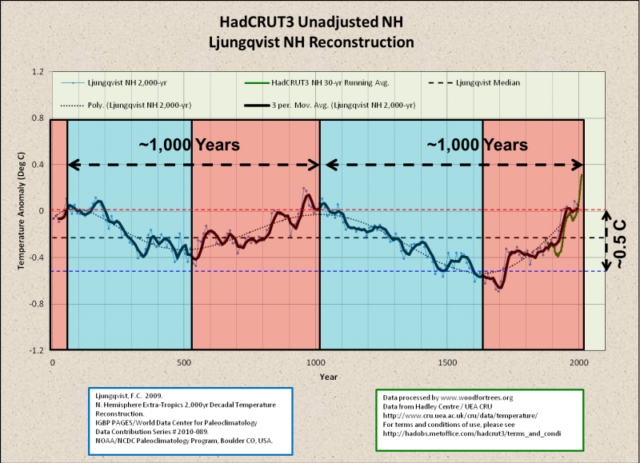

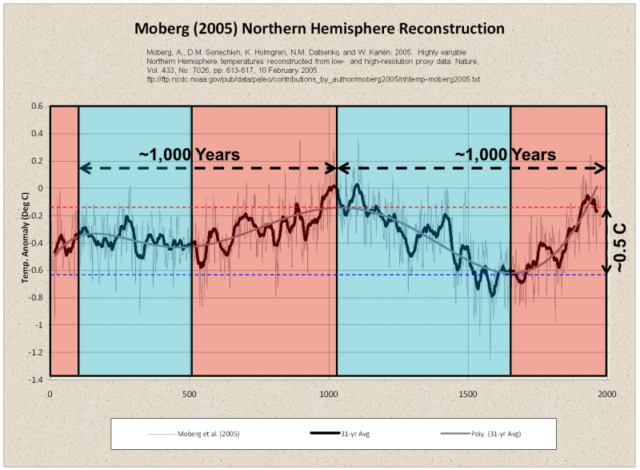

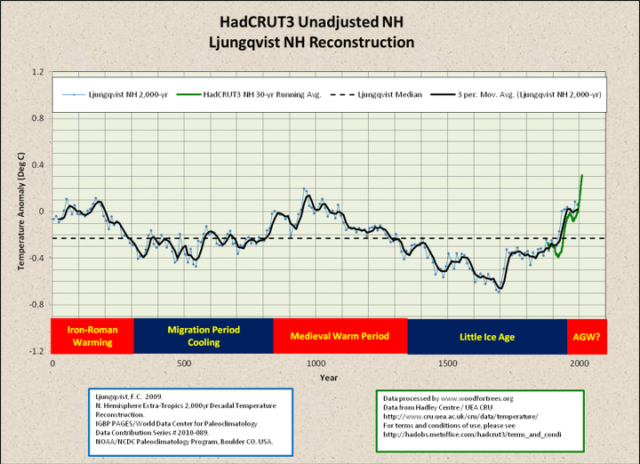

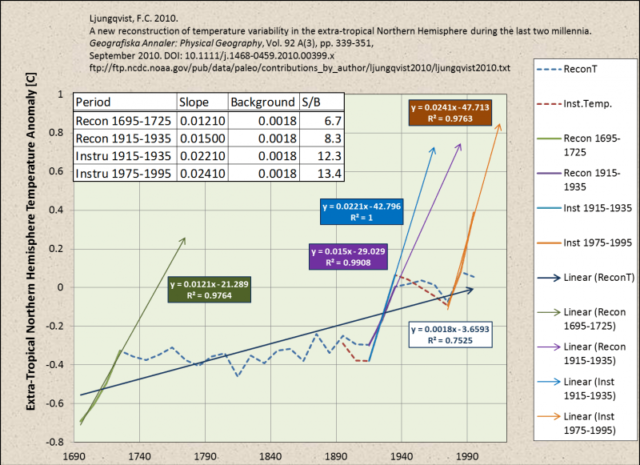

Der jüngste Temperaturanstieg ist nicht anomaler als die Mittelalterliche Warmzeit oder die Kleine Eiszeit:

Während der letzten 2000 Jahre war die Temperatur der Nordhemisphäre drei mal über die natürliche Variabilität hinausgegangen (definiert als zwei Standard-Abweichungen des Mittels vor 1865): 1) der Höhepunkt der Mittelalterlichen Warmzeit, 2) der Tiefpunkt der Kleinen Eiszeit und 3) seit 1998. Menschliche Aktivitäten waren eindeutig nicht der Grund für die ersten beiden Abweichungen. 70% der Erwärmung seit Anfang des 17. Jahrhunderts liegen eindeutig innerhalb der natürlichen Variabilität.

Zwar kann es sein, dass es während der gegenwärtigen Warmphase etwa 0,2°C wärmer ist als zum Höhepunkt der Mittelalterlichen Warmzeit, doch könnte dies auch der unterschiedlichen Auflösung der Proxy-Rekonstruktion und der instrumentellen Daten geschuldet sein:

Abbildung 8: Die instrumentellen Daten zeigen eine höhere Frequenz und eine höhere Amplitude der Temperaturvariationen als die Proxy-Rekonstruktionen:

Die Amplitude der rekonstruierten Temperatur-Variabilität im Zeitmaßstab von Jahrhunderten ist größer als 0,6°C. Diese Rekonstruktion ist die erste, welche eine ausgeprägte Römische Warmzeit der Jahre 1 bis 300 zeigt und die das Temperaturniveau des Zeitraumes 1961 bis 1990 erreicht hatte. Dieser Warmzeit folgte die Kaltzeit des Dark Age der Jahre 300 bis 800. Die Mittelalterliche Warmzeit erkennt man von 800 bis 1300 und die Kleine Eiszeit tritt klar hervor von 1300 bis 1900, gefolgt von einer rapiden Erwärmung im 20. Jahrhundert. Die höchsten Mitteltemperaturen in der Rekonstruktion trifft man von Anfang bis Mitte des 10. Jahrhunderts an, die niedrigsten Mitteltemperaturen Ende des 17. Jahrhunderts. Dekadische Mitteltemperaturen scheinen das mittlere Temperaturniveau der Jahre 1961 bis 1990 erreicht oder überschritten zu haben während längerer Zeiträume der Römischen und der Mittelalterlichen Warmzeit. Die Temperatur der letzten beiden Jahrzehnte jedoch ist möglicherweise höher als zu irgendeiner Zeit der letzten beiden Jahrtausende, obwohl dies nur aus den instrumentellen Temperaturdaten hervorgeht und nicht aus der Multi-Proxy-Rekonstruktion selbst.

(…)

Die Proxy-Rekonstruktion selbst zeigt eine solche beispiellose Erwärmung nicht, aber dabei muss man berücksichtigen, dass nur wenige bei der Rekonstruktion verwendete Aufzeichnungen bis in die neunziger Jahre des vorigen Jahrhunderts reichen. Nichtsdestotrotz muss man das Wärmeniveau seit dem Jahr 1990 im Vergleich zu den Höhepunkten der Römischen bzw. der Mittelalterlichen Warmzeit auf jeden Fall sehr vorsichtig interpretieren.

(…)

Die hier rekonstruierte Amplitude der Temperatur-Variabilität im Zeitmaßstab von Jahrzehnten und Jahrhunderten sollte man als das mutmaßliche Minimum der wahren Variabilität jener Zeitmaßstäbe betrachten.

(…)

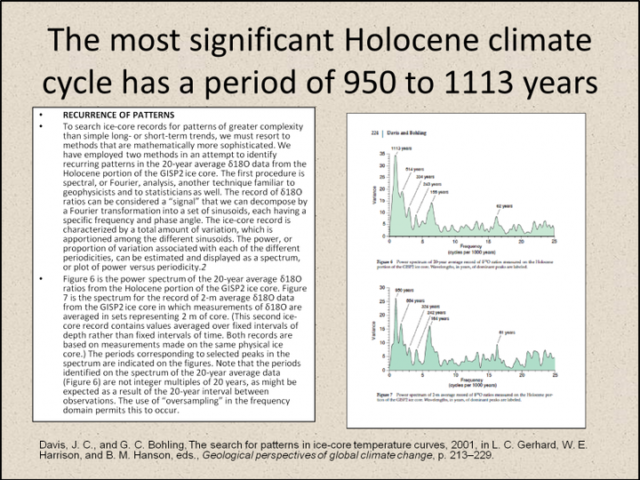

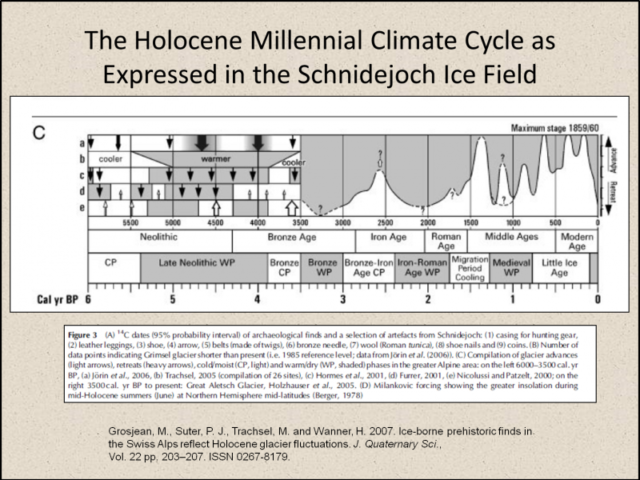

Das Klima im Holozän war gekennzeichnet durch einen grob Jahrtausende langen Zyklus von Erwärmung und Abkühlung (all jenen, die das Wort „Zyklus“ nicht mögen, lesen bitte statt dessen „quasi-periodische Fluktuation“):

Diese Zyklen haben sogar Nahmen:

Schon lange wurden diese Zyklen von Quaternary-Geologen erkannt (Abbildung 13):

Abbildung 13: Eine Fourier-Analyse des Eisbohrkerns GISP2 zeigt klar, dass der Klimazyklus im Jahrtausend-Maßstab das dominante Signal im Holozän ist (Davis &Bohling 2001):

Das Klima der industriellen Ära hat sich in keiner Weise verändert, die nicht zum gut belegten Jahrtausend-Zyklus passt. Unter der Annahme, dass die Erkenntnisse bzgl. CO2 in dem Eisbohrkern zuverlässig sind, hatte der gegenwärtige CO2-Anstieg kaum einen Einfluss auf das Klima, falls überhaupt irgendeinen.

Die Null-Hypothese

Was ist eine ,Null-Hypothese‘?

Eine Null-Hypothese ist ein in der Statistik angewendeter Typ von Hypothese, der davon ausgeht, dass bei einem Satz gegebener Beobachtungen keine statistische Signifikanz vorhanden ist. Die Null-Hypothese versucht zu zeigen, dass es zwischen Variablen keine Variation gibt oder dass eine Einzel-Variable sich nicht von seinem Mittelwert unterscheidet. Sie setzt voraus zu stimmen, bis statistische Beweise auftauchen, die sie ungültig machen zugunsten einer alternativen Hypothese.

Mehr: Null Hypothese http://www.investopedia.com/terms/n/null_hypothesis.asp#ixzz4eWXO8w00

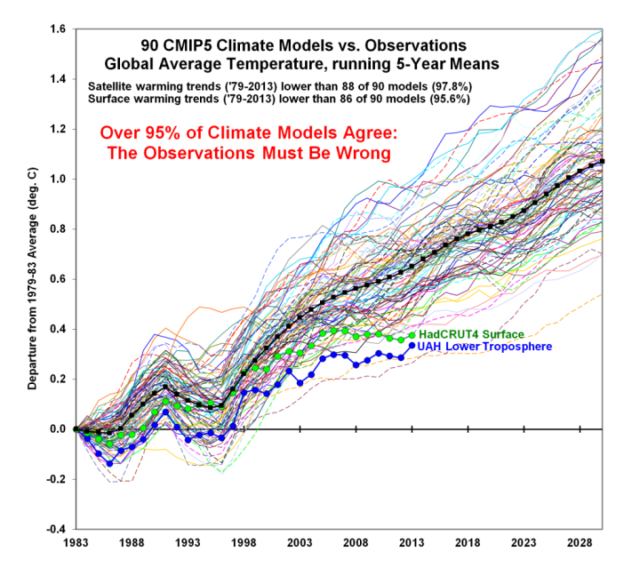

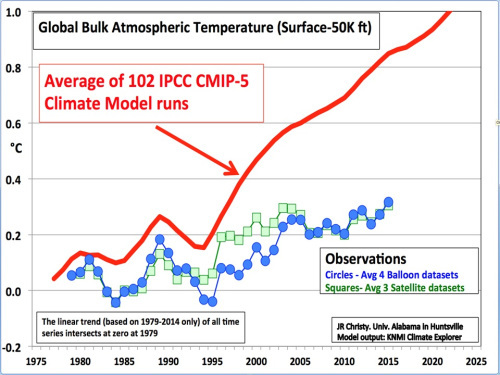

Da es unmöglich ist, mit dem Klima der Erde ein kontrolliertes Experiment durchzuführen (gibt es doch keinen Kontroll-Planeten), ist die einzige Möglichkeit des „Tests“ der CAGW-Hypothese mittels Modellen. Falls die CAGW-Hypothese stimmt, sollten die Modelle Vorhersage-Fähigkeiten zeigen. Daran sind die Modelle grandios gescheitert:

Abbildung 15: „95% aller Modelle stimmen überein: Die Beobachtungen müssen falsch sein!“ Quelle

Abbildung 16: „Klima-Modelle versus Klima-Realität“: Michaels & Knappenberger. Quelle.

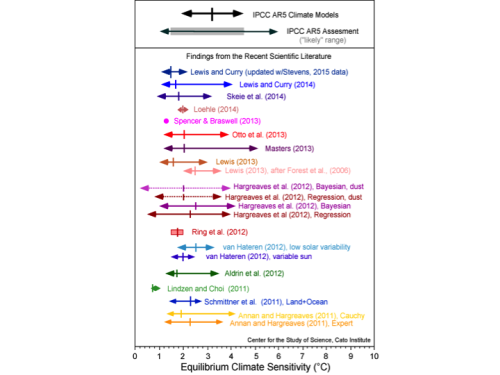

Die Modelle haben versagt, weil sie von einer Klimasensitivität ausgehen, die zwei bis drei mal höher ist als aus Beobachtungen hervorgeht:

Abbildung 17: Gleichgewichts-Klimasensitivität: Realität vs. Modelle. Quelle

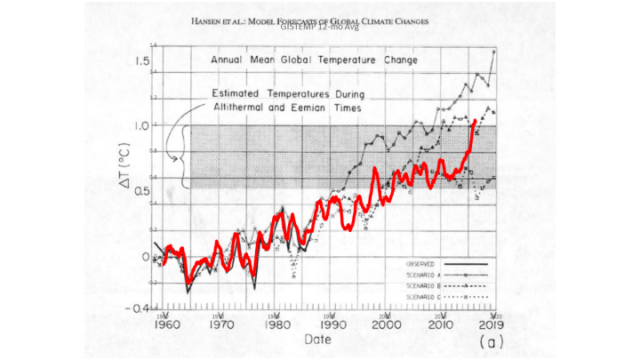

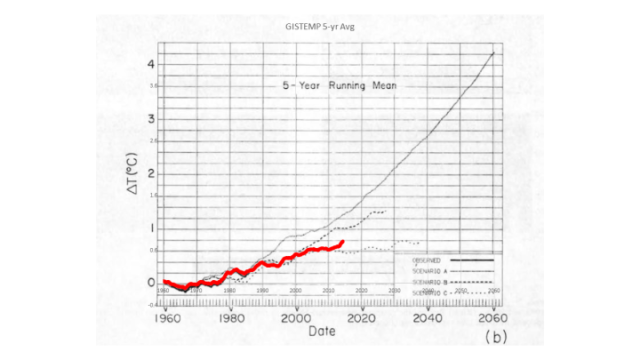

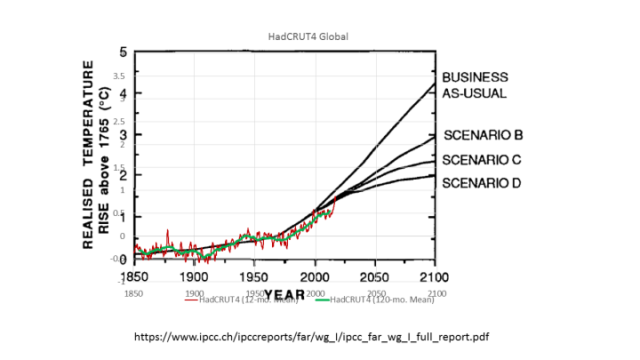

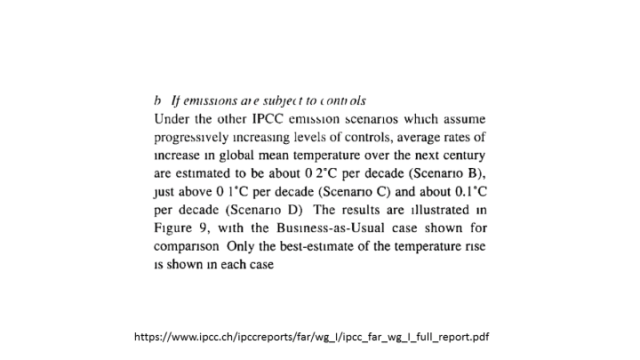

Von Hansen 1988 über jeden IPCC-Zustandsbericht folgten die gemessenen Temperaturen konsistent den starken Abschwächungs-Szenarien, welchen zufolge der atmosphärische CO2-Anstieg verlangsamt und/oder angehalten wurde.

Abseits der starken El Niño-Ereignisse der Jahre 1998 sowie 2015-16 folgte GISTEMP dem Szenario C, nach welchem das CO2-Niveau ab dem Jahr 2000 nicht mehr gestiegen ist und bei 368 ppm verharrt.

Das völlige Scheitern dieses Modells tritt am klarsten hervor aus dem klimarelevanteren gleitenden 5-Jahre-Mittel:

HadCRUt4 lag unter Szenario D.

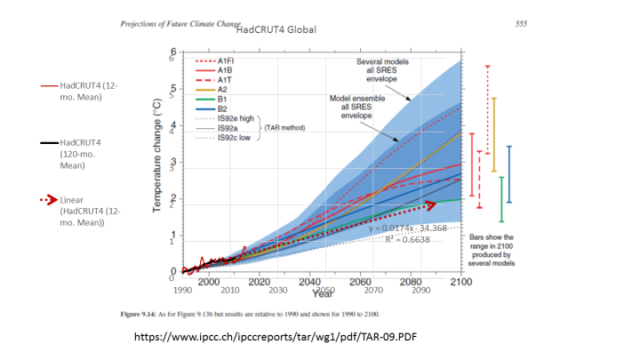

Im Dritten Zustandsbericht (TAR) finden wir:

HadCRUT4 folgte den starken Abschwächungs-Szenarien trotz eines allgemeinen Fehlens von Abschwächung.

Die Klimamodelle haben niemals irgendeine Vorhersage-Fähigkeit an den Tag gelegt.

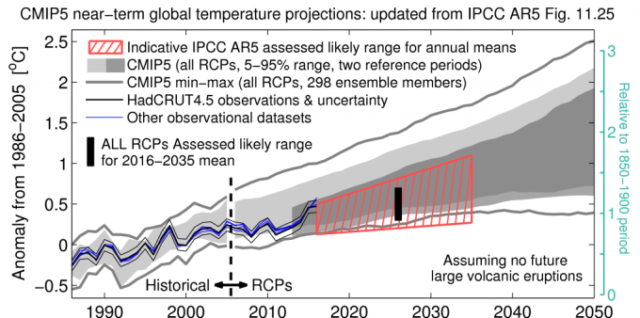

Und die Modelle werden nicht besser. Selbst wenn man den Modelllauf im Jahre 2006 beginnen lässt, liegen die gemessenen Temperaturen permanent beim oder unter dem unteren Ende der Bandbreite 5% bis 95%. Die gemessenen Temperaturen kamen dem Modell-Mittel (P50) nur während der Jahre 2006, 2015 und 2016 nahe.

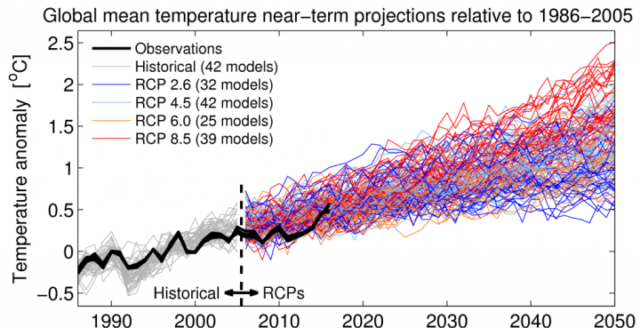

Das Ensemble besteht aus 135 Modellläufen, welche eine Reihe von repräsentativen Konzentrations-Verläufen anwenden (RCP). Sie reichen vom Worst-Case-Scenario RCP5, oftmals als „Business as Usual“ bezeichnet, bis zu variierenden Graden von Abschwächungs-Szenarien (RCP 2.6, 4.5 und 6.0).

Abbildung 24: Abbildung 23 mit individuellen Modelläufen. Quelle.

Wenn wir Löcher bohren, berechnen wir Wahrscheinlichkeiten, um die Öl- und Gasreserven zu schätzen, falls sich die Bohrung als erfolgreich erweist. Der Input für die Modelle besteht aus einer Bandbreite von Schätzungen der Dicke des Reservoirs sowie aus Gebiets- und petrophysikalischen Charakteristiken. Der Modelloutput enthält eine Wahrscheinlichkeits-Verteilung von P10 bis P90.

● P10 = Maximum-Fall. Es gibt eine Wahrscheinlichkeit von 10%, dass das Loch mindestens so viel Öl und/oder Gas ergibt.

● P50 = Mittlerer Fall. Es gibt eine Wahrscheinlichkeit von 50%, dass wir mindestens so viel Öl und/oder Gas erzeugen. Mögliche Reserven sind >P50.

● P90 = Minimum-Fall. Es gibt eine Wahrscheinlichkeit von 90%, dass das Loch mindestens diese Menge Öl und/oder Gas erbringen wird. Nachgewiesene Reserven sind P90.

Mit der Zeit sollte ein Bohrprogramm nahe P50 liegen. Falls die Bohr-Ergebnisse nahe P10 oder P90 liegen, hat das Modell ernsthaft versagt.

Falls das CMIP5-Modellensemble Vorhersagefähigkeiten besäße, sollten die Beobachtungen um P50 liegen, d. h. die Hälfte aller Modelle sollte mehr und die andere Hälfte weniger Erwärmung prophezeien als tatsächlich beobachtet. Während des Vorhersage-Laufes des Modells lag HadCRUT4.5 nicht einmal ansatzweise irgendwo nahe P50…

Ich habe die instrumentellen Messungen „beleuchtet“, um eine Wahrscheinlichkeits-Verteilung der Vorhersagefähigkeit des Modelllaufes zu schätzen.

Prediction Run Approximate Distribution

2006 P60 (60% der Modelle prophezeiten eine höhere Temperatur)

2007 P75

2008 P95

2009 P80

2010 P70

2011-2013 >P95

2014 P90

2015-2016 P55

Man beachte, dass die Messungen während des El Niño von 1998-99 einen Spitzenwert über P05 erreichten (weniger als 5% der Modelle hatten dies prophezeit). Während des El Niño 2015-16 erreichte HadCRUT4 nur einen Spitzenwert bei P55. El Niño-Ereignisse sind keine P50-Bedingungen. Starke El Niño- und La Niña-Ereignisse sollten Spitzenwerte bei den P05 und P95-Grenzen erreichen.

Die Temperaturmessungen folgen eindeutig viel eher den starken Abschwächungs-Szenarien als dem RCP 8.5, dem simulierten „Business as Usual“-Szenario.

Das rot schraffierte Trapez zeigt, dass HadCRUT4.5 weiterhin zwischen weniger als P100 und P50 verlaufen wird. Dies ist ein Hinweis auf ein erhebliches Scheitern der Modelle und ein ziemlich aufschlussreicher Hinweis darauf, dass die Modelle nach unten adjustiert werden müssen.

In jedem anderen Bereich der Wissenschaft wäre CAGW eine schon lange ausgesonderte, falsifizierte Hypothese.

Schlussfolgerungen

Behauptungen, denen zufolge AGW oder CAGW eine Ausnahme vom Prinzip der Null-Hypothese darstellen, sind offenkundig lächerlich:

In der Wissenschaft eine breite natürliche Erklärung einer großen Bandbreite von Phänomenen. Theorien sind prägnant, kohärent, systematisch, vorausschauend und breit anwendbar. Oftmals integrieren und generalisieren sie viele Hypothesen. Theorien, welche von der wissenschaftlichen Gemeinschaft akzeptiert sind, werden generell durch viele unterschiedliche Beweislinien gestützt – aber selbst Theorien können modifiziert oder widerlegt werden durch neue Beweise und Perspektiven. – UC Berkeley

Dies ist keine wissenschaftliche Hypothese: mehr CO2 verursacht Erwärmung. Es ist Schaumschlägerei.

Das hier ist eine wissenschaftliche Hypothese:

Eine Verdoppelung des atmosphärischen CO2-Gehaltes wird die untere Troposphäre sich um ___°C erwärmen lassen.

Über 30 Jahre lang gescheiterte Klimamodelle waren niemals in der Lage, die Lücke zu füllen. Im 5. IPCC-Zustandsbericht wurde essentiell festgestellt, dass das Füllen der Lücke nicht mehr erforderlich war.

Während es recht wahrscheinlich ist, dass menschliche Aktivitäten zumindest teilweise während der letzten 150 Jahre ursächlich für einen Anteil der Erwärmung waren, gibt es dafür keine robuste statistische Korrelation. Das Scheitern der Klimamodelle zeigt eindeutig, dass die Null-Hypothese immer noch auch für atmosphärisches CO2 und Temperatur gilt.

Selected References

Davis, J. C., and G. C. Bohling, The search for patterns in ice-core temperature curves, 2001, in L. C. Gerhard, W. E. Harrison, and B. M. Hanson, eds., Geological perspectives of global climate change, p. 213–229.

Finsinger, W. and F. Wagner-Cremer. Stomatal-based inference models for reconstruction of atmospheric CO2 concentration: a method assessment using a calibration and validation approach. The Holocene 19,5 (2009) pp. 757–764

Grosjean, M., Suter, P. J., Trachsel, M. and Wanner, H. 2007. Ice-borne prehistoric finds in the Swiss Alps reflect Holocene glacier fluctuations. J. Quaternary Sci.,Vol. 22 pp. 203–207. ISSN 0267-8179.

Hansen, J., I. Fung, A. Lacis, D. Rind, Lebedeff, R. Ruedy, G. Russell, and P. Stone, 1988: Global climate changes as forecast by Goddard Institute for Space Studies three-dimensional model. J. Geophys. Res., 93, 9341-9364, doi:10.1029/88JD00231.

Kouwenberg, LLR, Wagner F, Kurschner WM, Visscher H (2005) Atmospheric CO2 fluctuations during the last millennium reconstructed by stomatal frequency analysis of Tsuga heterophylla needles. Geology 33:33–36

Ljungqvist, F.C. 2009. N. Hemisphere Extra-Tropics 2,000yr Decadal Temperature Reconstruction. IGBP PAGES/World Data Center for Paleoclimatology Data Contribution Series # 2010-089. NOAA/NCDC Paleoclimatology Program, Boulder CO, USA.

Ljungqvist, F.C. 2010. A new reconstruction of temperature variability in the extra-tropical Northern Hemisphere during the last two millennia. Geografiska Annaler: Physical Geography, Vol. 92 A(3), pp. 339-351, September 2010. DOI: 10.1111/j.1468-459.2010.00399.x

MacFarling Meure, C., D. Etheridge, C. Trudinger, P. Steele, R. Langenfelds, T. van Ommen, A. Smith, and J. Elkins. 2006. The Law Dome CO2, CH4 and N2O Ice Core Records Extended to 2000 years BP. Geophysical Research Letters, Vol. 33, No. 14, L14810 10.1029/2006GL026152.

Moberg, A., D.M. Sonechkin, K. Holmgren, N.M. Datsenko and W. Karlén. 2005. Highly variable Northern Hemisphere temperatures reconstructed from low-and high-resolution proxy data. Nature, Vol. 433, No. 7026, pp. 613-617, 10 February 2005.

Instrumental Temperature Data from Hadley Centre / UEA CRU, NASA Goddard Institute for Space Studies and Berkeley Earth Surface Temperature Project via Wood for Trees.

Link: https://wattsupwiththat.com/2017/04/17/the-good-the-bad-and-the-null-hypothesis/

Übersetzt von Chris Frey EIKE