Erneuerbare Energie ist kein Allheilmittel

Ein Stopp der Verfügungen und Subventionen für erneuerbare Energie, welche unsere ökonomischen Konkurrenten weiterhin fördern (wenngleich auch weniger als früher) wird unsere weitere globale ökonomischen Führerschaft zementieren. Fossile Treibstoffe, über die Amerika üppig verfügt, sind und werden mindestens noch bis zum Jahr 2050 und wahrscheinlich sogar noch darüber hinaus billiger sein als jedwede Form erneuerbarer Energie. Und fossile Treibstoffe sind auch die zuverlässigste Energiequelle. Falls Energie in den USA relativ billig bleibt und das Land aus dem Pariser Klimaabkommen aussteigt, wie es Präsident Trump versprochen hat, dann erwarte man, dass immer mehr Produzenten ihre Operationen in die USA verlagern.

Europa kürzt bereits seine Unterstützung für erneuerbare Energie. Falls Amerika dem folgt und Subventionen und Anreize für Wind- und Solarenergie kürzt, dann wird der größte Markt für Chinas Erzeugnisse für Erneuerbare austrocknen. Falls China mit seiner Erneuerbaren-Expansion fortfährt, wird es allein die hohen Kosten jener Technologien zahlen müssen, wenn diese im Ausland nicht mehr subventioniert werden. Chinas Wirtschaft schrumpft schon jetzt. Ohne die Märkte in den USA und Europa wird es interessant sein zu sehen, wie lange China noch „führend in der Welt“ bzgl. erneuerbarer Energie sein wird, falls dessen zunehmender Gebrauch sich als Bremsklotz der chinesischen Wirtschaft erweist, wie es bereits in Europa und in geringerem Umfang in den USA der Fall war.

Während China beschlossen hat, die Anzahl neu geplanter Kohlekraftwerke für die kommenden Jahre um über 100 zu reduzieren, sind immer noch über 100 in der Planung. Gebaut werden sie mit einer Rate von etwa einem Werk alle zwei Wochen. Ja doch, Indien errichtet Solarparks im Hinterland, aber es werden gleichzeitig ebenfalls rasch neue Kohlekraftwerke gebaut, ebenso wie in anderen Ländern in Asien und Afrika – wo fast 1000 Kohlekraftwerke sich in verschiedenen Stadien des Baus und der Planung befinden.

Sogar Japan, das Land also, welches in vielfacher Hinsicht den Kampf gegen den vermeintlich gefährlichen, vom Menschen verursachten Klimawandel angeführt hat, indem es entwickelte Länder drängte, deren Treibhausgas-Emissionen zu reduzieren, hat Pläne bekannt gegeben, 45 neue Kohlekraftwerke zu errichten, um den Ausfall der Kernkraftwerke nach dem Unfall in Fukushima zu kompensieren.

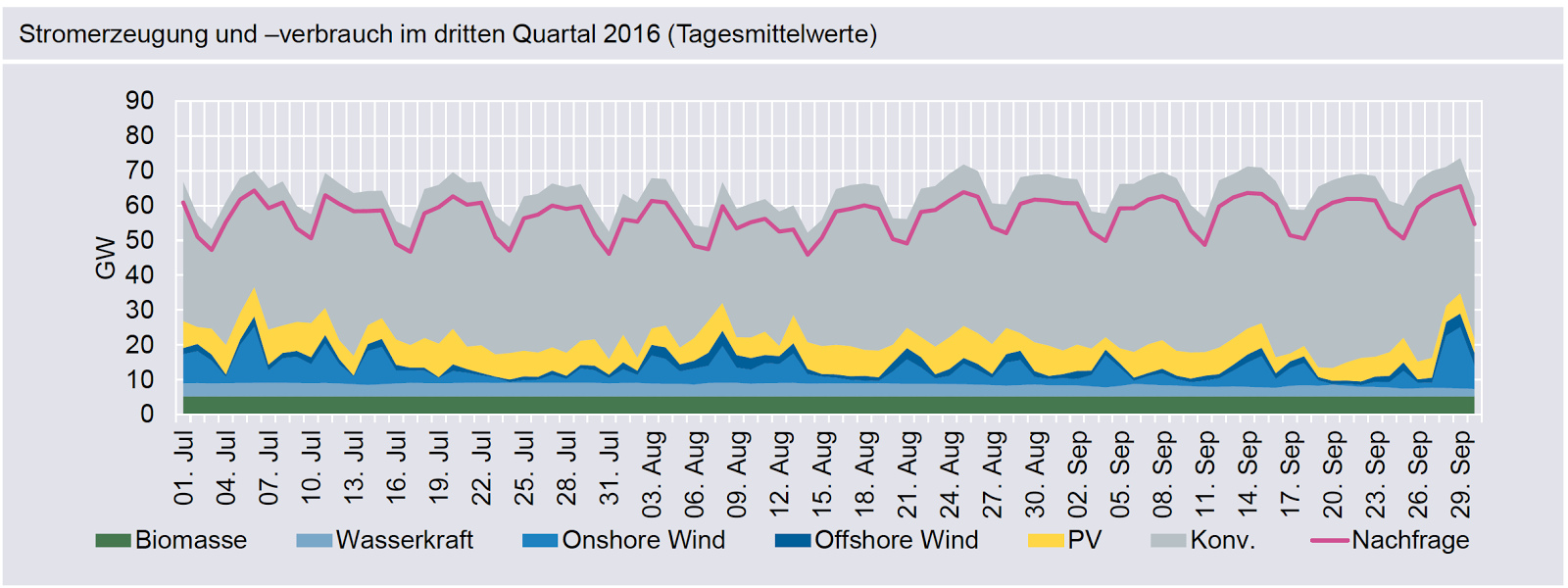

Aber was ist mit Google, Facebook und Amazon? Wollen sie sich nicht von Fossilen befreien? Kaum. Wie meine Freunde Isaac Orr und Paul Driessen erklären und wie es natürlich auch der gesunde Menschenverstand sagt, weht der Wind nicht immer und scheint die Sonne nicht immer. Wenn das der Fall ist, wird Google sich fossiler Treibstoffe bedienen (oder eventuell in einigen Fällen Kern- oder Wasserkraft), genau wie jeder andere auch. Driessen schreibt: „Kein Unternehmen, dass ununterbrochen 365 Tage im Jahr rund um die Uhr aktiv ist, kann zu 100% mit erneuerbarer Energie betrieben werden … 5 bis 25% über das Jahr verteilt sind weit realistischer. Die restliche Zeit muss der Strom von ,Backup‘-Systemen kommen, welche in der Tat die primären Energiequellen sind“. Orr beschreibt die Verkündung von „100% erneuerbar“ seitens Google als ein „Mätzchen“ und erklärt:

Googles eigener Erklärung seines Planes zufolge läuft es darauf hinaus, dass Google Zertifikate erneuerbarer Energie kauft, was es Google erlaubt, erneuerbare Energie zum Großhandelspreis zu kaufen, was bedeutend billiger ist als die Einzelhandelspreise, und jene Energie dann zum Einzelhandelspreis wieder in das Netz zu speisen.

Googles Ausflug in erneuerbare Energie ist kein altruistisches Unterfangen, um die Welt zu retten. Sondern es ist ein billiger Marketing-Trick, um „grün“ auszusehen, was es dem Unternehmen erlaubt, Profite mit politischen Maßnahmen zu machen, welche erneuerbare Energie subventionieren.

Die Zertifikate erneuerbarer Energie von Google sind nur solange wertvoll, wie sie die Politik unterstützt. Falls die Verordnungen und Subventionen verschwinden, wird der Markt und der Wert der Google’schen Zertifikate kollabieren. Falls dies so kommt, wollen wir um der Steuerzahler willen hoffen, dass die Regierung Google nicht als „too big to fail“ einstuft.

Quellen: Wired.com; Isaac Orr; Paul Driessen und Andrew Follett

—————————————————-

Kurzmeldungen der GWPF zu Kohlekraftwerken in Deutschland:

Hier folgen noch zwei Meldungen aus dem Rundbrief der GWPF über neue Kohlekraftwerke in Deutschland. Offenbar ist man hierzulande mit Hochdruck dabei, das unter dem Teppich zu halten. Aber jeder sollte es wissen:

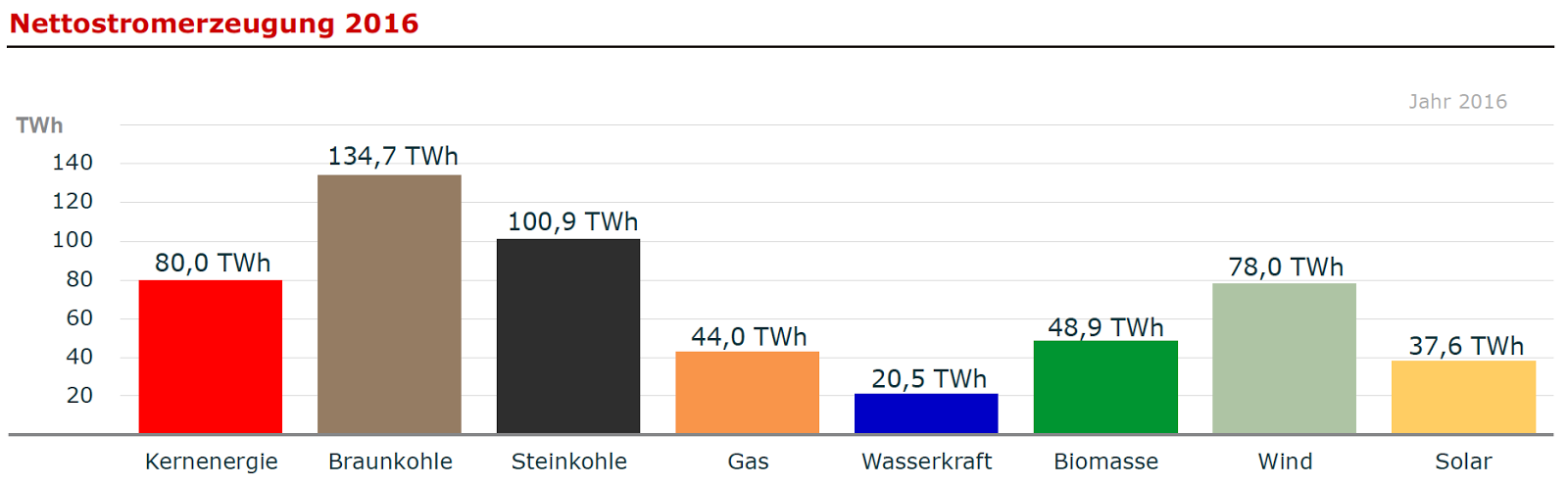

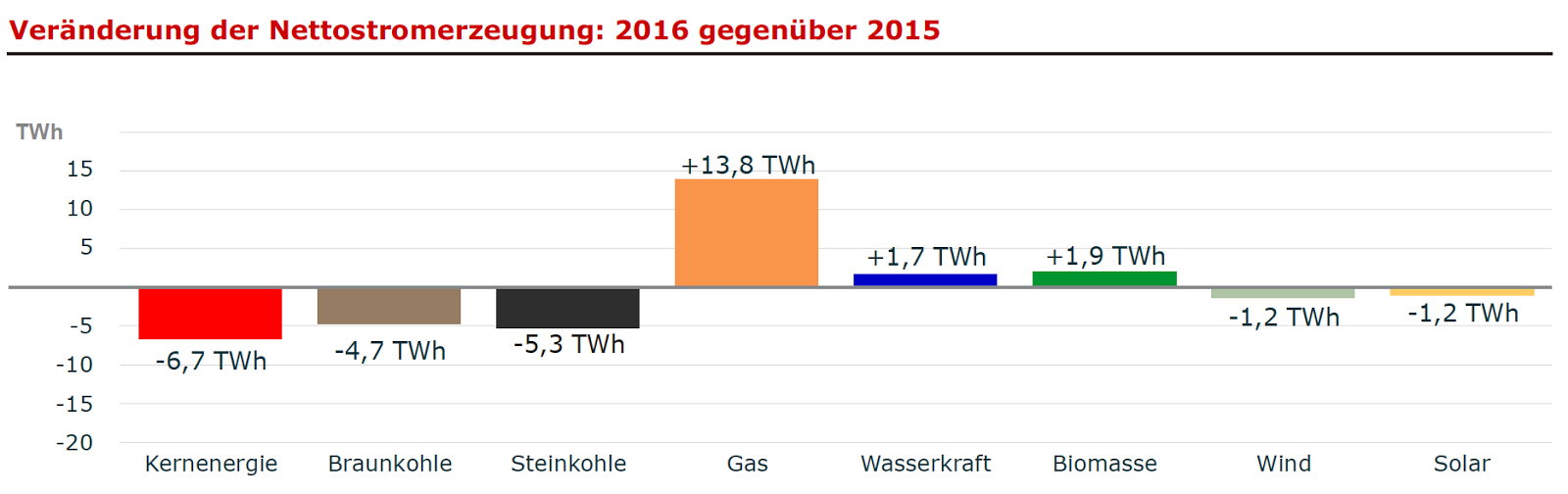

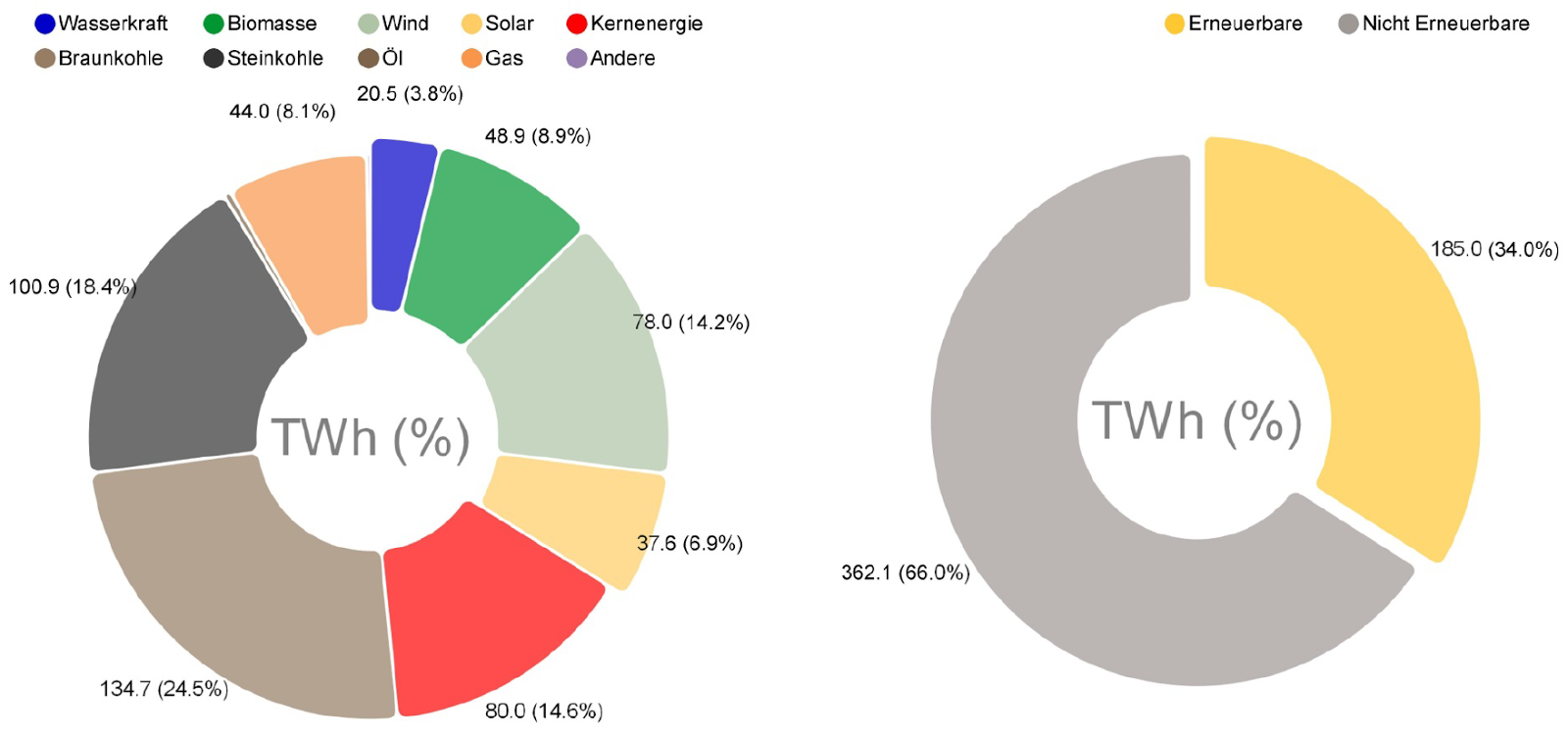

Gut verborgen: Verbrauch von Strom aus Kohle- und Gaskraftwerken in Deutschland auf 5-Jahre-Hoch

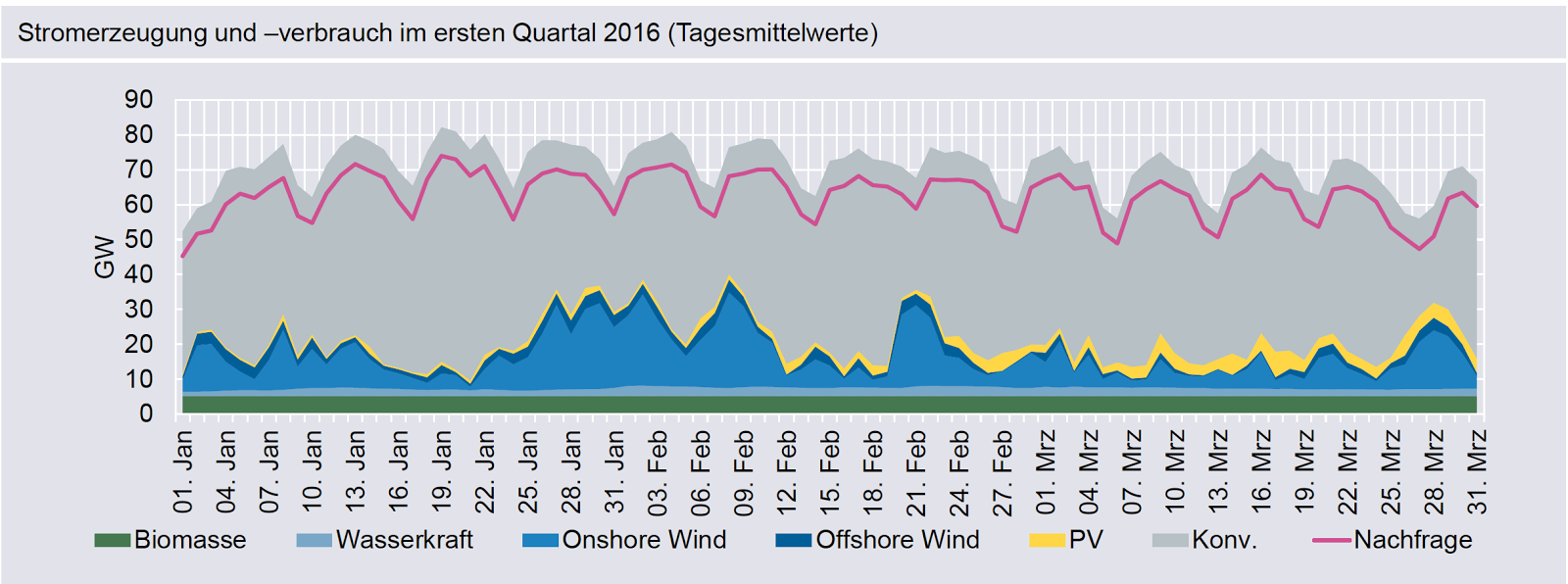

Der Output von Kohle- und Gaskraftwerken in Deutschland hat im Januar den höchsten Stand seit fast fünf Jahren erreicht. Ursachen waren kaltes Wetter, dass der Nachfrage einen kräftigen Schub verlieh, und eine rekord-reduzierte Verfügbarkeit von Kernkraft. Dies geht aus Daten hervor, die das Institut für Solare Energiesysteme der Fraunhofer-Gesellschaft in Freiburg veröffentlicht hat. – Platts, 3 February 2017

—————————————————-

Und zu guter Letzt: Deutschland nimmt demnächst ein weiteres neues Kohlekraftwerk in Betrieb

Das Bezirksgericht Münster genehmigte eine Emissionskontrolle für das Kraftwerk Datteln 4, ein Steinkohlekraftwerk, welches von dem Unternehmen Uniper errichtet wird. Intensive Gerichtsverfahren mit Umweltaktivisten hatten den Bau stark verzögert. Uniper sagte, dass die Strom- und Wärmeerzeugung des 1050-Megawatt-Kraftwerkes in der ersten Hälfte des Jahres 2018 aufgenommen werden soll. – Reuters, 19 January 2017

Alles übersetzt von Chris Frey EIKE