geschrieben von Chris Frey | 12. September 2017

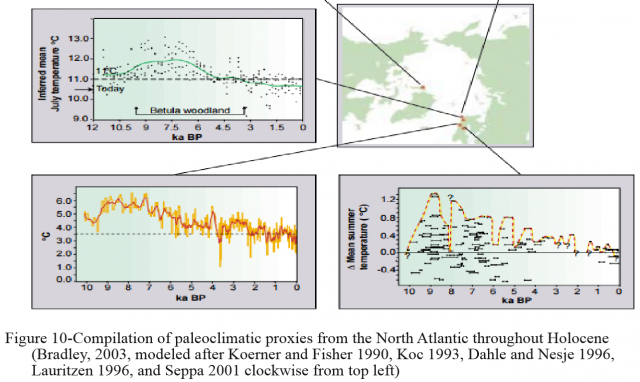

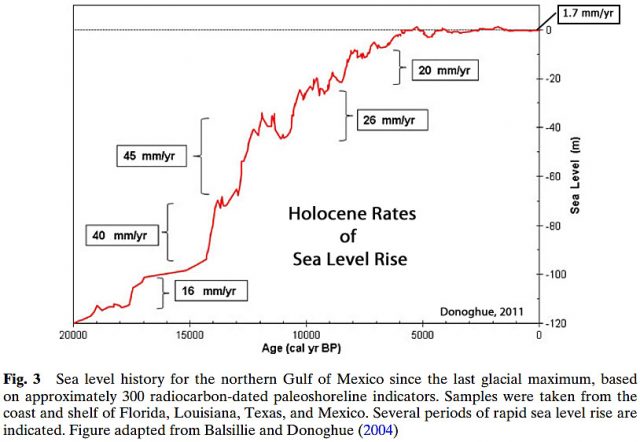

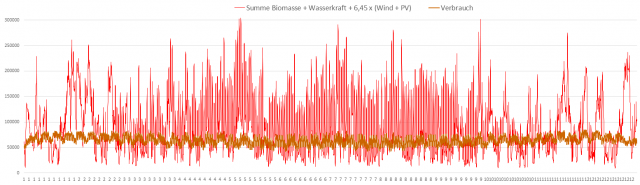

Bildinschrift: Historie des Meeresspiegels für den nördlichen Golf von Mexiko seit dem letzten glazialen Maximum auf der Grundlage von rund 300 Radiokarbon-datierten Indikatoren von historischen Küstenlinien. Die Stichproben stammen von der Küste und dem Schelf vor den US-Staaten Florida, Louisiana, Texas und Mexiko. Es zeigen sich verschiedene Perioden mit einem starken Anstieg des Meeresspiegels. Abbildung nach Balsillie und Donoghue 2004.

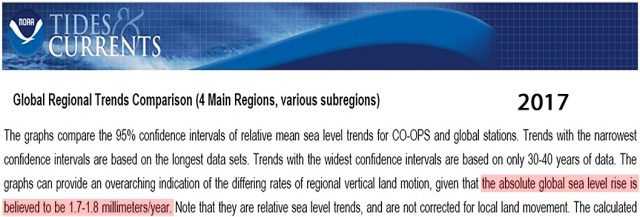

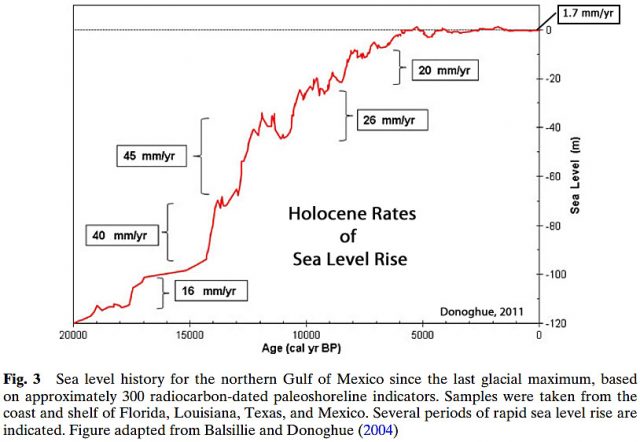

Derzeit „glaubt man“, dass der Meeresspiegel mit einer Rate von 1,7 bis 1,8 mm pro Jahr steigt (hier).

Bildinschrift: Die Graphiken vergleichen die 95%-Vertrauens-Intervalle der relativen Meeresspiegel-Trends für CO-OPS und globale Messpunkte. Trends mit dem engsten Vertrauensintervall basieren auf den längsten Datensätzen. Die Graphiken bieten eine allumfassende Darstellung der differierenden Raten regionaler vertikaler Landbewegungen unter der Annahme, dass der absolute Anstieg des globalen Meeresspiegels 1,7 bis 1,8 mm pro Jahr beträgt. Man beachte, dass es sich um relative Meeresspiegel-Trends handelt, die nicht nach vertikalen Landbewegungen korrigiert sind. …

Diese aktuelle Rate – lediglich 0,17 bis 0,18 eines Meters pro Jahrhundert – ist im Gesamt-Mittel des 20. Jahrhunderts relativ unverändert geblieben, und es gab keine statistisch signifikante Beschleunigung der Anstiegsrate (lediglich 0,0042 mm pro Jahr) seit dem Jahr 1900.

Wenzel und Schröter, 2014: „Die globale mittlere Änderung des Meeresspiegels seit dem Jahr 1900 stellte sich als 1,77 ±0,38 mm pro Jahr heraus. … Die für das globale Mittel gefundene Beschleunigung, +0,0042 ±0,0092 mm pro Jahr, ist nicht signifikant“.

In einer gerade in Climate of the Past veröffentlichten Studie schlüsseln 7 Wissenschaftler detailliert den langzeitlichen Zusammenhang der aktuellen Raten des Anstiegs auf. Von vor 16.500 bis vor 8200 Jahren betrug die mittlere Rate des globalen Anstiegs 1,2 Meter pro Jahrhundert (12 mm pro Jahr), was etwa 700% schneller ist als der während der letzten 115 Jahre erfolgte Anstieg … In dieser mittleren Rate enthalten ist auch die Epoche des „Schmelzwasser-Impulses“ vor rund 14.500 Jahren, als der Meeresspiegel mit Raten um 4 Meter pro Jahrhundert (40 mm pro Jahr) gestiegen war.

Cronin et al., 2017: „Rate und Verteilung des globalen Meeresspiegel-Anstiegs (SLR) nach dem letzten glazialen Maximum (LGM) sind bekannt aus radiometrischen Altersbestimmungen von Korallenriffen vor Barbados, Tahiti, Neuguinea und dem Indischen Ozean sowie aus Sediment-Bohrkernen aus dem Sunda-Schelf und von anderswoher. … Lambeck et al. (2014) schätzen die mittleren globalen Raten während der Haupt-Vereisungsphase von vor 16.500 bis vor 8200 Jahren mit 12 mm pro Jahr (+1,2 Meter pro Jahrhundert) mit einem noch rascheren SLR von etwa 40 mm pro Jahr (+4 Meter pro Jahrhundert) während des Schmelzwasser-Impulses von vor 14.500 bis vor 14.00 Jahren“.

Andere Wissenschaftler haben jüngst gezeigt, dass der Meeresspiegel im hemisphärischen Maßstab vor 14.500 Jahren um 12 bis 22 Meter in nur 340 Jahren gestiegen war. Dieser explosive Anstieg fiel zeitlich zusammen mit einem nordhemisphären-weiten Erwärmungsereignis von 4 bis 5°C innerhalb nur weniger Jahrzehnte, aber es .fiel NICHT zusammen mit einer Änderung des CO2-Niveaus.

die Temperatur auf der Nordhemisphäre um 4 bis 5°C innerhalb nur weniger Jahrzehnte gestiegen war (Lea et al., 2003; Buizert et al., 2014). Dies fiel zeitlich zusammen mit einem Meeresspiegelanstieg um 12 bis 22 Meter während weniger als 340 Jahre (3,5 bis 6,5 Meter pro Jahrhundert) (Meltwater Pulse 1a (MWP1a)) (Deschamps et al., 2012)“.

J. F. Donoghue (2011) stellt die historische Größenordnung von Raten des Anstiegs, die „über 20 mal höher als heute“ waren, in die richtige Perspektive. Küstenlinien müssten sich notwendigerweise um bis zu 40 Meter pro Jahr landeinwärts zurückgezogen haben – 75 cm pro Woche – während jener Jahrhunderte eines erschreckenden [Original: obscene] Anstiegs.

Außerdem spezifiziert Donoghue, dass alles in allem der mittlere Anstieg des Meeresspiegels während der letzten 20.000 Jahre etwa 6 mm pro Jahr betragen hat, was über 3 mal mehr ist als die Rate des vorigen Jahrhunderts. Mit anderen Worten, die aktuellen Anstiegsraten haben sich signifikant verlangsamt im Vergleich zum langfristigen Gesamttrend.

Donoghue, 2011: „Über lange Zeiträume nach dem letzten glazialen Maximum (LGM) vor 2.000 Jahren waren in der Region Anstiegsraten weit über den Raten während der durch langzeitliche Tidenmessungen repräsentierten Perioden aufgetreten. Die regionalen Tidenmessungen zeigen, dass der Meeresspiegel im vorigen Jahrhundert um etwa 2 mm pro Jahr gestiegen war, während die mittlere Anstiegsrate seit dem LGM 6 mm pro Jahr betragen hatte, wobei es auch zu Perioden mit einem abrupten Anstieg über 40 mm pro Jahr (4 Meter pro Jahrhundert) gekommen war.

Der Meeresspiegel ist zeitweise mit Raten gestiegen, die über 20 mal größer waren als heute. Bei derartigen Raten würden sich regionale Küstenlinien um bis zu 40 Meter pro Jahr oder über 75 cm pro Woche landeinwärts zurückgezogen haben“.

Der Geologe Dominic Hodgson aus UK und seine Kollegen haben berechnet, dass der Meeresspiegel vor der Ostantarktis vor etwa 10.000 Jahren mit Raten von 1,2 bis 4,8 Metern pro Jahrhundert gestiegen war, als der Meeresspiegel 8 Meter höher lag als derzeit.

Hodgson et al., 2016: Rapider Anstieg des Meeresspiegels in Prydz Bay, Ostantarktis, zu Beginn des Holozäns … Die Felddaten zeigen rapide zunehmende Raten eines relativen Anstiegs von 12 bis 48 mm pro Jahr von vor 10.473 bis vor 9411 Jahren in den Vestfold Hills und von 8,8 mm pro Jahr von vor 8882 bis vor 8563 Jahren in den Larsemann hills … die geologischen Daten implizieren einen relativen Stand von 8 m über dem heutigen Niveau von vor 9411 bi vor 7564 Jahren. Dem folge eine Periode, in welcher der deglaziale Anstieg fast genau ausgeglichen wurden durch lokalen Rebound.

Und Zecchin et al. 2015 haben gezeigt, dass „episodische“ und „rapide“ Anstiege bis zu 6 Meter pro Jahrhundert erreichen können, und zwar hunderte Jahre lang. Das entspricht etwa dem 35-fachen der derzeitigen Rate.

Zecchin et al., 2015: „Die hier präsentierten Beweise bestätigen abgesunkene Küstenlinien, welche anderswo dokumentiert sind in ähnlichen Wassertiefen. Sie zeigen, dass Schmelzwasser-Einschübe den nacheiszeitlichen relativen Anstieg mit Raten bis zu 60 mm pro Jahr unterstreichen, und zwar einige Jahrhunderte lang“.

Zusammengefasst: Es gab nichts ungewöhnliches hinsichtlich der aktuellen Daten des Meeresspiegel-Anstiegs während des vorigen Jahrhunderts.

Tatsächlich steigt der Meeresspiegel derzeit mit einer Rate, die weniger als ein Drittel der mittleren Rate der letzten 20.000 Jahre ausmacht (Donoghue 2011).

Die Fortsetzung dieser langfristige Verlangsamung während einer Ära mit einem vermeintlichen anthropogenen Einfluss auf das Klima sind ein sehr starker Beweis, dass abrupte Änderungen des Meeresspiegels (Steigen bzw. Fallen) unabhängig von den Variationen der atmosphärischen CO2-Konzentration erfolgen.

Link: http://notrickszone.com/2017/09/07/past-sea-levels-rose-4-6-meters-per-century-shorelines-retreated-40-meters-per-year-without-co2-flux/

Übersetzt von Chris Frey EIKE

geschrieben von Chris Frey | 12. September 2017

Der Anlass für diese Mitteilung der GRÜNEN Expertin war eine Studie.

era, August 2017: [2] Analyse des Exports von Stein- und Braunkohlestrom Erstellt im Auftrag von: Bundestagsfraktion Bündnis 90/Die Grünen, welche die GRÜNEN in Auftrag gaben, um sich belegen zu lassen, dass „GRÜNES“ Wissen zur Energie das neue Wissen ist, und auf physikalischen Gesetzen begründetes nur veraltet sein kann.

Inhaltlich geht es in der Studie um die von einigen EEG-„Fachpersonen“ vertretene Ansicht, dass konventioneller Strom die Leitungen „verstopft“ und nur diese Stromblockaden das EEG am Gedeihen hindern. Erwartungsgemäß hat die Studie die Ansicht ihrer Auftraggeber umfassend bestätigt.

Nachdem die bisher vom Autor gesichteten Studien der Grünen zu EEG und Klima nur eines: Desaströses Unwissen und ideologie-bedingte Falschinformation als Ergebnis vorwiesen [16], stellt sich die Frage, kann es diesmal anders sein? Anbei wird dazu eine Antwort versucht.

Studie: Stromexport verstopft auch Exportleitungen

Es ist bekannt, dass die Professorin C. Kemfert als Ökonomin ähnliche Ansichten vertritt [6]. Auch nach ihren Vorstellungen müssen die Leitungen immer für den ideologisch richtigen Strom freigehalten werden. Fließt darin „dreckiger“, konventionell erzeugter Strom, muss dieser dem „edlen Ökostrom“ selbstverständlich sofort weichen. Ihre Homepage berichtete deshalb nach der Veröffentlichung sofort über die Studie:

KLIMARETTER.INFO: [1] Kohlestrom verstopft auch Exportleitungen

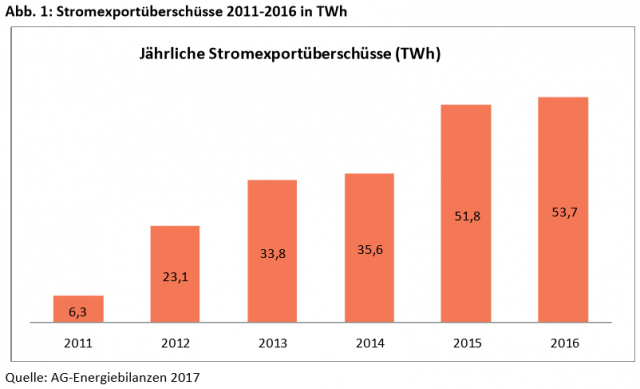

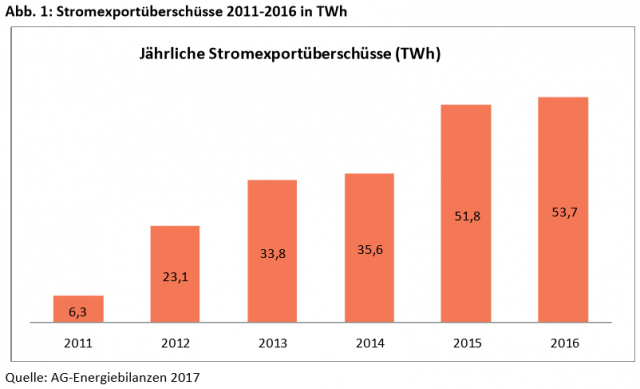

Der Überschuss, den Deutschland beim Stromexport erzielt, hat sich in den letzten fünf Jahren auf mehr als das Achtfache erhöht. Das hat eine Untersuchung des Berliner Energieforschungsinstituts Era im Auftrag der Bundestagsfraktion der Grünen ergeben. Als Hauptgrund für den … steil angestiegenen Exportüberschuss nennt die klimaretter.info vorliegende Analyse die seit 2009 recht konstante Stromerzeugung aus Braun- und Steinkohle. Meist würden die hohen Stromexporte aber der schwankenden Wind- und Solarstromerzeugung angelastet, schreiben die Studienautoren.

Die GRÜNEN meldeten ihren Argumentationserfolg und verknüpften das Ergebnis dazu mit dem Wahlkampf, 25.08.2017: Studie: Stromexporte von Stein- und Braunkohlestrom

Die Bundestagsfraktion BÜNDNIS 90/DIE GRÜNEN hat eine Studie zum Stromexport bei era – energy research in Auftrag gegeben, deren Ergebnisse jetzt vorliegen.

Fazit: Deutschland produziert viel mehr Strom als im Land verbraucht wird. In den letzten fünf Jahren haben sich die deutschen Stromexportüberschüsse fast verzehnfacht. Auch Brandenburg exportiert 60 Prozent des Stroms, weil gerade hier die Braunkohlekraftwerke das Stromnetz verstopfen und kaum wie eigentlich vorgesehen, bei hoher Windeinspeisung runtergefahren werden.

Der denkbar schlechteste Grund dafür: Die deutsche Bundesregierung hält an den unflexiblen Kohlekraftwerken fest. Wenn die Produktion gedrosselt wird, dann nicht bei den klimaschädlichen Kohlekraftwerken, sondern bei den Erneuerbaren-Anlagen. Für diesen Mechanismus ist die Regierung Merkel verantwortlich und deshalb auch für jede einzelne unnötig produzierte Kilowattstunde schmutzigen Kohlestroms. Wir wollen in einer Regierungskoalition die schmutzigsten 20 Kohlekraftwerke als erstes abschalten. Die stabile Stromversorgung in Deutschland ist davon nachweislich nicht berührt.

Der bdew, im Wesentlichen ein Zusammenschluss von Versorgern, sichtete die Studie, fand die Aussagen schlichtweg eine Zumutung an den technischen Sachverstand, darf und will jedoch weder der Kanzlerin, deren energiepolitischen Vorgaben, noch den unsinnigen Vorstellungen sonstiger in Berlin agierender Parteien – und auch nicht den Avancen einiger kommunaler Versorger [8] irgendwie zu nahe treten, geschweige diesen gar den geballten Unsinn vorwerfen.

Entsprechend unterwürfig wurde ein lauer Protest formuliert, um wenigstens ein paar Aussagen der Studie „gerade zu rücken“ und vielleicht auch, um in der Zukunft auf hämische Nachfragen „Widerstand“ belegen zu können:

Was steht in der Studie

Diese Frage lässt sich leichter beantworten, wenn man sich vorher klarmacht, warum es diese Studie überhaupt gibt-Allgemein ist bekannt, dass die EEG-Vorrangeinspeisung zu Netzproblemen führt und immer öfter abgeregelt werden muss. Auch ist bekannt, dass Deutschland Strom – teils sogar zu negativen Preisen – exportiert.

Kein Energiefachmann der alten Schule macht für diese Probleme die Grundlastkraftwerke verantwortlich. Sie weisen stattdessen auf den Unsinn der bedingungslosen Vorrangeinspeisung hin und erklären anhand der Ganglinien, warum die geschilderten Probleme mit immer weiterem EEG-Ausbau immer zwanghafter auftreten (müssen) [5] [7] [9] (und Schlusskapitel).

Den EEG-Befürwortern ist eine solche Argumentation ein Dorn im Auge. Sie behaupten, die Grundlastkraftwerke könne und müsse man sehr wohl jederzeit so schnell und stark regeln, dass der EEG-Vorrangstrom in vollem Umfang eingespeist und verbracht werden könnte. Und damit wären alle EEG-Probleme bereits behoben. Dass dies nicht geschieht, läge nur an der „Geldgier“ der Kraftwerksbetreiber und natürlich an der Politik, die dies zulasse.

Diese Argumentation wird von der Studie übernommen und „belegt“. Anhand ausgesuchter Ganglinienbeispiele „zeigt“ sie, dass bei flexibler Kraftwerks-Einspeiseregelung kein EEG-Strom verloren gehen müsste und Stromexporte unnötig wären.

Die Studienautoren bestätigen dies und sagen: Nicht die unplanbare, mit extremer Spanne schwankende EEG-Vorrangeinspeisung ist das Problem im Netz, sondern die darauf nicht flexibel genug reagierenden Grundlast-Kraftwerke, vor allem Braunkohle und die noch verbliebene Kernkraft. Alleine dies sei die Ursache der Stromexporte und der vorgenommenen Abregelungen. Würde man alle Kraftwerke genau mit der EEG-Einspeisung nachregeln, gäbe es alle Probleme nicht. Ob das technisch überhaupt möglich wäre, hat die Studienautoren nicht interessiert.

Die Grundlastkraftwerke passen sich der fluktuierenden EEG-Einspeisung nicht flexibel genug an

era Analyse: [2] Diese Strommarktanalyse zeigt, dass die zu starre Fahrweise der Braunkohle- und Atomkraftwerke zu hohen Stromexportüberschüssen in Deutschland führt. Die Steinkohlekraftwerke werden zwar variabler betrieben, ihre Leistungsreduzierung reicht aber nicht aus, um bei hoher Windenergie- und PV-Einspeisung eine ausgeglichene Angebot-Nachfrage-Situation im Strommarkt zu erreichen. Dafür müsste auch die Leistung der Braunkohle- und Atomkraftwerke viel stärker an die Stromerzeugung aus erneuerbaren Energien angepasst werden.

Bild 1 Jährliche Exportüberschüsse [2]

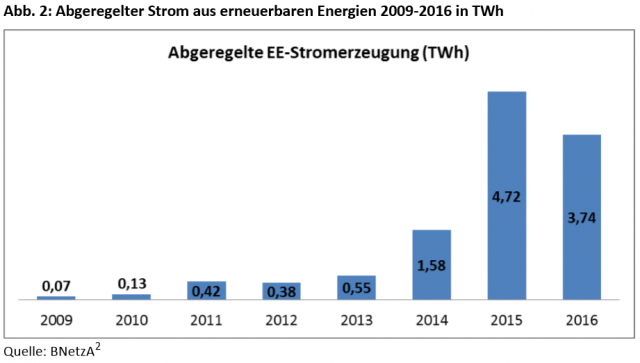

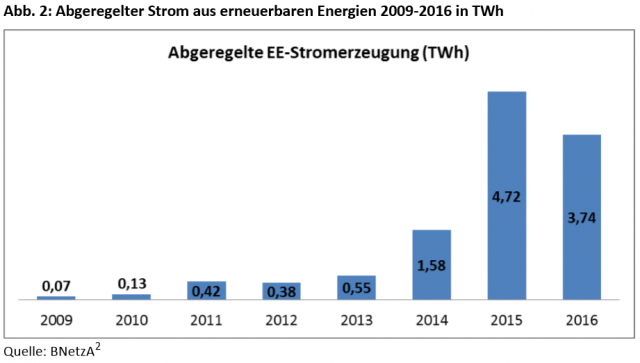

Bild 2 Jährliche Abregelungen [2] (EEG-Strom, der erzeugt wurde, mangels Bedarf nicht eingespeist wird, jedoch bezahlt werden muss)

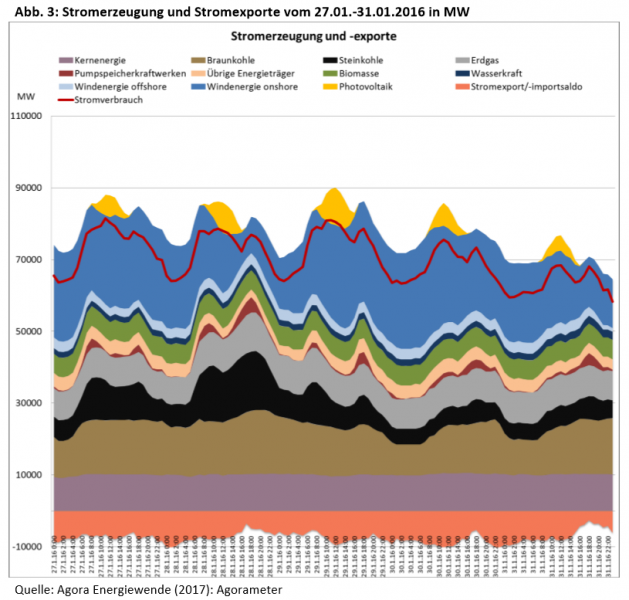

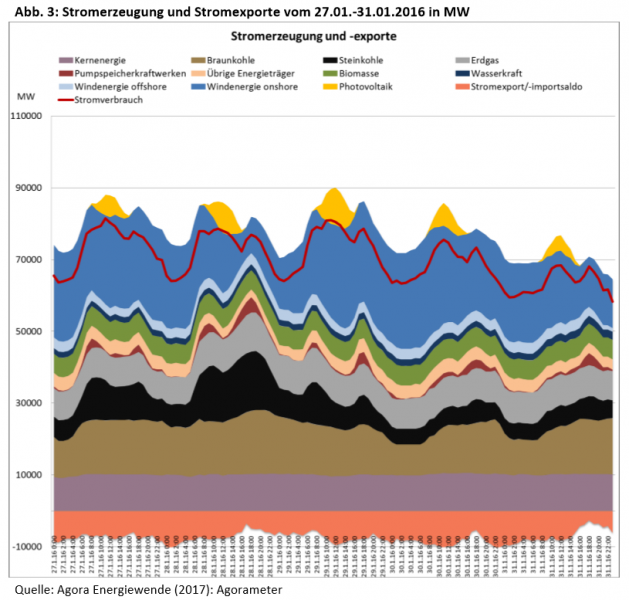

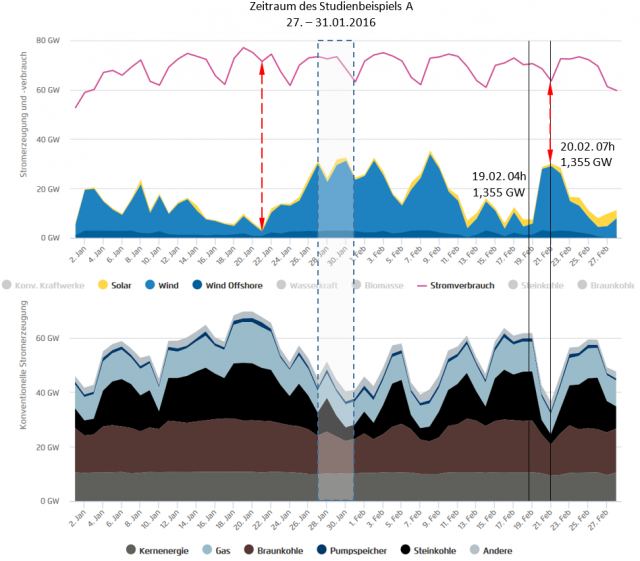

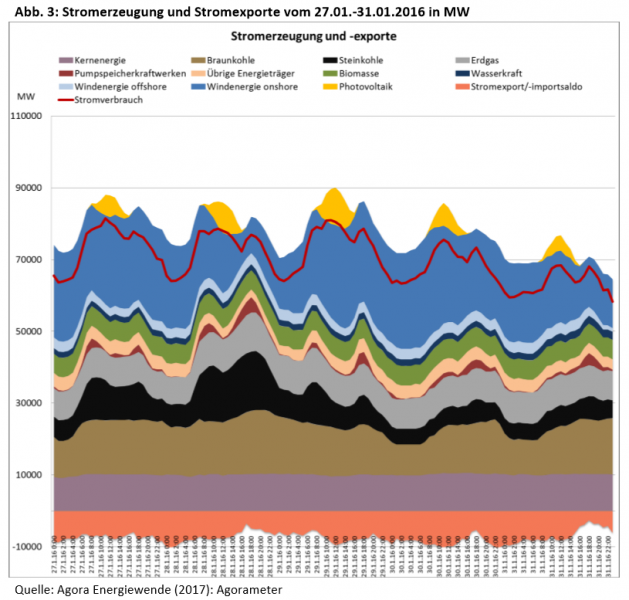

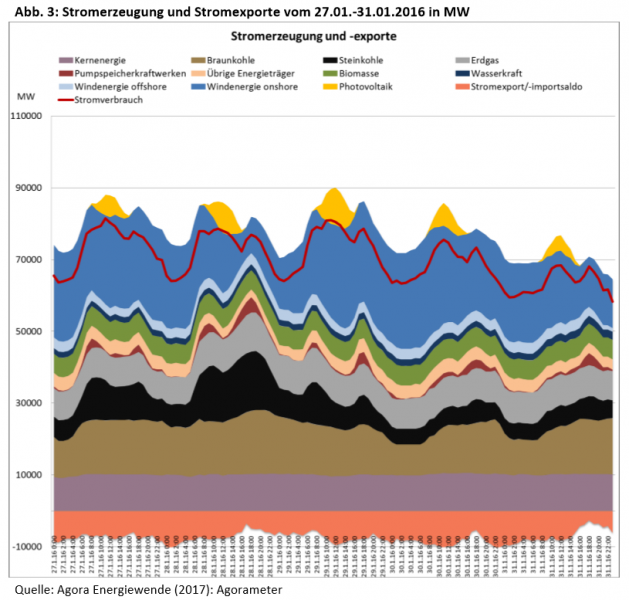

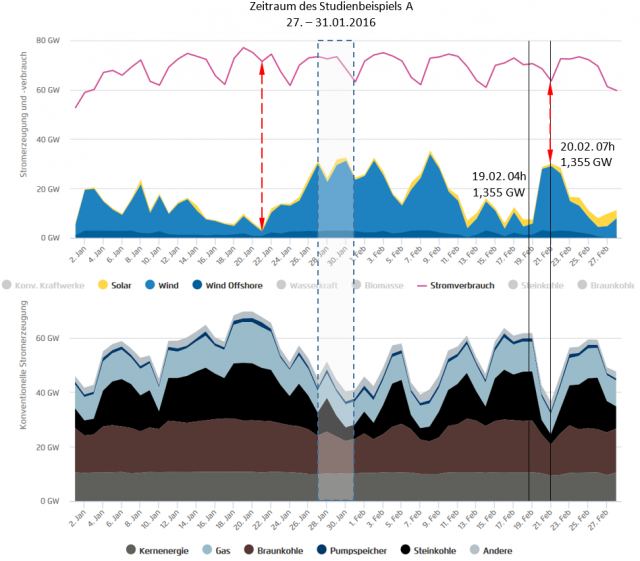

Bild 3 Ganglinienbeispiel Zeitraum 27.01. – 31.01.2016 [2]

Um welches Problem geht es dabei

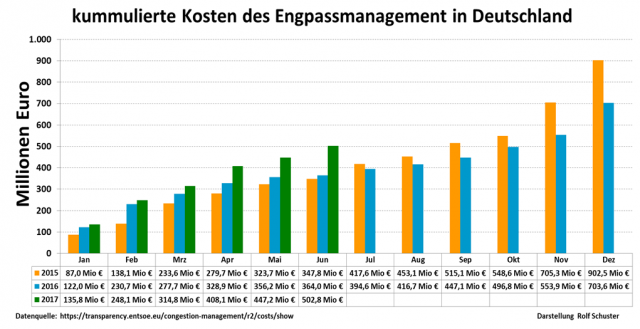

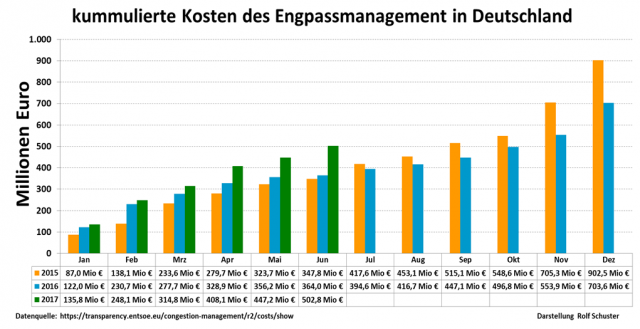

Wie üblich geht es neben anderem um Kosten. Die Netzüberlastungen durch die EEG-Vorrangeinspeisung nehmen mit jedem weiteren Ausbau zu und kosten inzwischen richtig Geld. Zudem führt es auch zu Stromexporten mit negativen Preisen. Mit jedem weiteren EEG-Ausbau explodieren diese Probleme und Kosten.

Bild 4 Kosten der Netzüberlastungen. Quelle: R. Schuster

Als Beleg werden ausgesuchte Ganglinienbeispiele angeführt

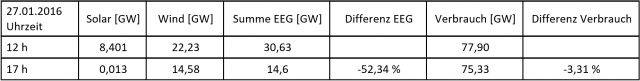

Beispiel A, der Zeitraum vom 27. bis zum 31.01.2016.

Bild 5 Ganglinienbeispiel A, Zeitraum 27.01. – 31.01.2016 [2]

Kritische Betrachtung

Ganz kurz gesagt: Unter der Prämisse, dass EEG-Einspeisung grundsätzlich Vorrang haben muss, dem sich alles andere bedingungslos unterzuordnen hat, wird vollkommen frei von technischen Zwängen erklärt, dass, so lange bei den Grundlastkraftwerken noch „Luft“, also eine Energiedifferenz besteht, alleine diese geregelt werden müssen.

Über die komplexen Zusammenhänge im Versorgungsnetz und über die Probleme eines zukünftig höher werdenden EEG-Anteils wird nicht eingegangen.

Studie: [2] Diese Strommarktanalyse zeigt, dass die zu starre Fahrweise der Braunkohle- und Atomkraftwerke zu hohen Stromexportüberschüssen in Deutschland führt.

Die hohen Exporte werden zumeist der schwankenden Wind- und Solarstromerzeugung angelastet. Die vorliegende Untersuchung zeigt jedoch, dass sie in erster Linie auf die seit 2009 konstant gebliebene Stromerzeugung aus Braun- und Steinkohle zurückzuführen sind.

Die hohe Braunkohle- und Steinkohleerzeugung hat außerdem zusammen mit Netzengpässen dazu beigetragen, dass die abgeregelte Stromerzeugung aus erneuerbaren Energien in den letzten Jahren drastisch gestiegen ist

Da die Betreiber für den nicht eingespeisten Strom aus erneuerbaren Energien entschädigt werden, entstehen durch die Abregelung zusätzliche Kosten, die – zu Unrecht – der Energiewende angerechnet werden.

Bewusst verzichtet die Studie auf jegliche physikalische und kraftwerkstechnische Betrachtung. Für die Studienautoren existieren keine technischen oder kommerziellen Probleme. Sie argumentieren nur nach den Ganglinienkurven.

Was die Studienautoren sicher wissen, aber nicht erwähnen ist, dass dies (auf dem Papier) nur gelingt, weil global immer noch eine Differenz zwischen Verbrauch und EEG-Spitzeneinspeisung besteht. Dass dies in Regionalnetzbereichen schon aktuell nicht mehr der Fall ist [7], wird unterschlagen, beziehungsweise nur nebenbei erwähnt. Auch wird zwar erwähnt, aber nicht darauf eingegangen und ignoriert, warum Braunkohle- und Kernkraftwerke nicht im Stundentakt in der Leistung beliebig hin- und her fahren können. Es wird einfach postuliert, dass es nur an der Geldgier der Betreiber läge.

Die Studie reiht sich damit nahtlos in die Formate ein, wie sie beispielhaft auf Klimaretter.Info regelmäßig zur (Des-)information zu finden sind. Toppt diese jedoch durch eine schon fast auf Kindergarten-Niveau reduzierte „Ganglinienanalyse“. Das ließ sich aber nicht vermeiden: Das Ergebnis war durch den Auftraggeber ja festgelegt.

Die Grundlastkraftwerke haben die sprunghafte EEG-Einspeisung vollständig auszuregeln

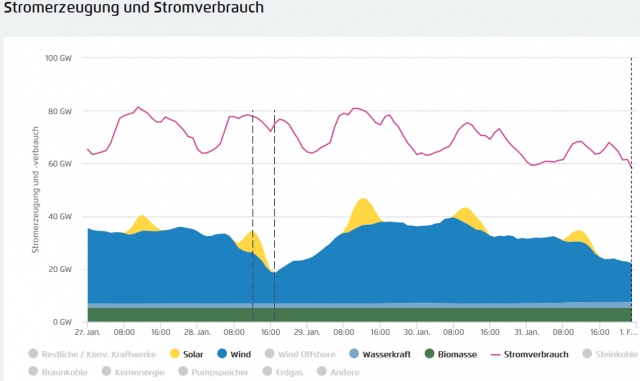

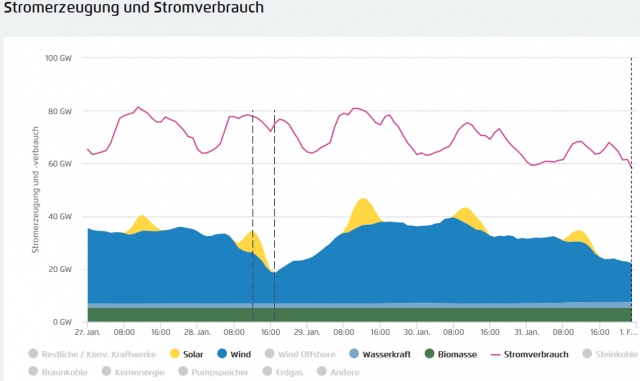

Anhand des ersten in der Studie gebrachten Ganglinienbeispiels (Bild 4) sei die Problematik gezeigt. Dazu ist der 27. Januar 2017 dargestellt und die Eispeiseveränderung zwischen 12 und 17 Uhr.

Bild 6 Ganglinien 27.01. – 31.01.2016. Zeitraum 27.01., 12 – 17 h gekennzeichnet. Quelle Agora Viewer

Innerhalb dieser fünf Stunden speisten die EEG-Generatoren -52 % Energie ins Netz. Während der Verbrauch nur um 3,3 % zurückging. Würde Deutschland (wie geplant) zu 100 % EEG-versorgt, hätten in Deutschland innerhalb der fünf Stunden

50 % der erforderlichen Elektroenergie gefehlt.

Bild 7 Detaildaten der Ganglinien von Bild 6

Die Studie sagt nun folgerichtig, da vom EEG-Gesetz so vorgegeben, dass es nicht Aufgabe der EEG-Stromlieferanten ist, darauf Rücksicht zu nehmen. Diese Einspeise-Verbrauchsdifferenzen müssten die konventionellen Kraftwerke ausregeln. Das machen diese (notgedrungen) auch, ansonsten würde das deutsche Stromnetz bereits aktuell zusammenbrechen.

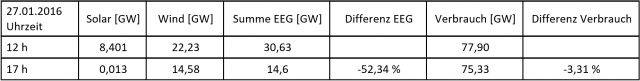

Um es nicht zeigen zu müssen, hat die Studie gezielte Zeitpunkte zur „Analyse“ herausgepickt. Deshalb beispielhaft nochmals das erste Studienbeispiel mit dem Zeitraum über zwei Monate (Bild 7). Sehr schön sieht man nun die Probleme – und nicht die „Erfolge“ der EEG-Einspeisung:

Wenn der Bedarf fast am Maximum liegt, wird ein Minimum an Energie geliefert (rote Pfeillinie). Das ist genau das Gegenteil, was Herr Özdemir behauptet [10].

Obwohl der Bedarf sinkt, wird sprunghaft Maximalenergie eingespeist (um den 21. Februar).

All dies regelt die konventionelle Stromerzeugung aus. Entsprechend der technischen Gegebenheiten der Kraftwerkstechnik in der Reihenfolge: Gas, Steinkohle, dann wenig Braunkohle und noch weniger Kernkraft. Dass sich damit dann kaum noch Geld verdienen lässt, kann mancher vielleicht verstehen. Nicht jedoch die Studienautoren und die GRÜNEN.

Bild 8 Ganglinien vom 01.01. – 28.02.2016. Mit Zufügungen vom Autor. Quelle Agora Viewer

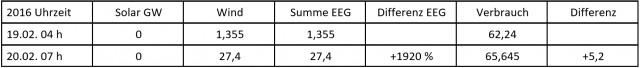

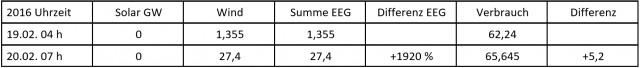

Bild 9 Detaildaten der Ganglinien vom 19. – 20.02.2016 von Bild 8

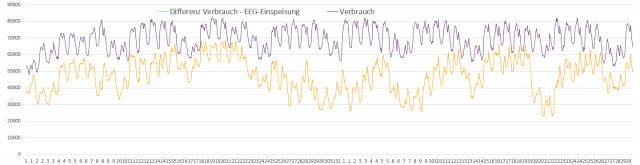

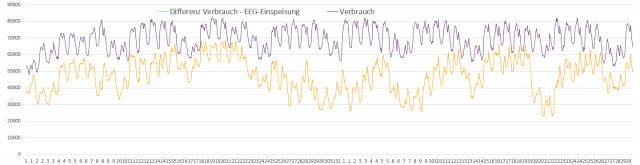

Bild 10 Zeitraum 01.01.2016 – 29.02.2016. Verlauf Verbrauch (violett) und Differenz Verbrauch zur EEG-Einspeisung (braun). Grafik vom Autor erstellt. Quelle: Agora-Daten

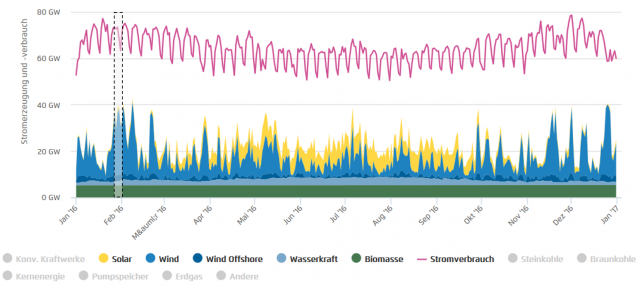

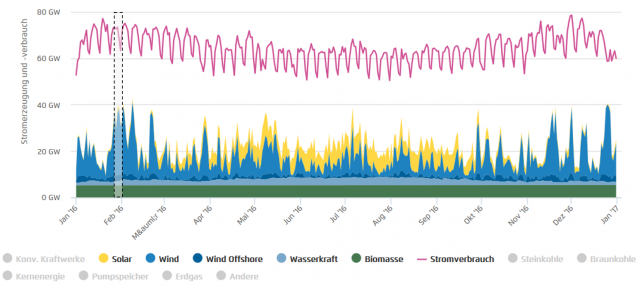

Bild 11 Ganglinie des Gesamtjahres 2016. Zusätzlich gekennzeichnet ist der Zeitraum des Studienbeispiels A. Quelle: Agora-Viewer

Wenn reiner Irrsinn über unsere Energie bestimmt …

Bei jedem Blick in die EEG-Ganglinien ist ersichtlich:

Dass die EEG-Stromversorgung mit ihrer Vorrangeinspeisung bei einem weiteren Ausbau den kommenden Zusammenbruch des Stromnetzes zur Folge haben muss.

Parallel ist ersichtlich, dass die „versprochenen“ Speicher nirgendwo mit ausreichendem Volumen in Sicht sind.

Die konventionellen Kraftwerke sind derzeit noch in der Lage, die Einspeiseproblematik auszuregeln und mit der Strombörse über Export / Import Energiedifferenzen abzufangen.

Trotzdem nehmen die sich verstärkenden Abregelungen (Bild 2) als zusätzliche Notmaßnahme drastisch zu.

Das ist nicht nur die Ansicht des Autors, sondern kann auch an anderen Stellen nachgelesen werden [5] [7] [9].

In dieser immer kritischer werdenden Situation fällt „Fachpersonen“ nichts anderes ein, als unbeirrt ihren ideologischen Weg weiter zu gehen.

Unter diesen sticht die „Fachfrau“ der GRÜNEN (Studium: Politikwissenschaften, öffentliches Recht, Völkerrecht) allerdings hervor. Sie weiss erkennbar nichts über das, was sie sagt, sie weiß aber genau, warum sie es sagt:

„Am Kohleausstieg führt kein Weg vorbei. Nicht nur aufgrund unserer klimapolitischen Verpflichtungen, sondern auch wegen des bevorstehenden Desasters am Strommarkt, wenn wir so weitermachen wie bisher. Es mangelt weder an erneuerbaren Energien noch an der Entwicklung von Speichern und Netzen. Es mangelt an der Bereitschaft, aus der Kohle auszusteigen. Deshalb kommen wir bei der Energiewende nicht richtig voran.“

Zuerst stellt sich die Frage, was diese Darstellung mit den Studienaussagen zu tun hat. Dort steht dazu nämlich praktisch nichts drin.

Information der Studie:

Über Speicher: Nichts,

Dass erneuerbare Energien die Strom-Nachfrage erfüllen könnten: Nichts,

Zum Versorgungsnetz: Es wird nur erklärt, dass derzeit das globale Netz (aktuelle, lokale Überlastungen, wie sie der bdew anspricht, wurden nicht untersucht) auch bei EEG-Einspeisespitzen noch ausreicht, wenn parallel minutengenau alle Grundlastkraftwerke heruntergefahren würden.

Wahrscheinlich hat die Fachfrau die Studie gar nicht gelesen. Man würde sich wünschen, jemand könnte diese „Fachfrau des Wissensgrauens“ zwingen, auch einmal etwas über Energie zu lesen, damit sie wenigstens im Ansatz den Unsinn ihrer Aussagen erkennt:

EIKE, 01. September 2017: [9] SPIELER AM WERK? Die Energiewende und Grünsprech – Die Kaskadierung

TYCHIS EINBLICK, 4. Februar 2017: [5] Anspruch und Wirklichkeit „Energiewende“ trifft frostige Wirklichkeit

Sicher noch hilfreicher wäre, sie müsste einmal dort leben, wo ein solches Energiesystem Realität ist. Allerdings sie alleine (zum Beispiel irgendwo in Afrika) und nicht umgekehrt, wir mit ihr demnächst in Deutschland.

Zur Demo für wenige Tage alle Kraftwerke abzuschalten, um der Fachfrau zu zeigen, an was es bei ihr mangelt, und den Bürgern, was uns durch solche fachfremden Personen alles noch eingebrockt wird, wäre am Hilfreichsten. Da unsere Medien dann aber nicht die Wahrheit berichten, sondern irgend eine Dolchstoßlegende erfinden würden, käme es leider dort, wo es ankommen sollte dann nicht an.

Die Beraterin für Klima und EEG für unsere Berliner Politikkaste ist allerdings kaum besser. Sie hat auch keine Lösungen, meint aber zu wissen, welche es sind:

[6] Prof. C. Kemfert: Nicht die erneuerbare Energie von morgen braucht zusätzliche Netze, sondern der hohe Überschuss des Kohlestroms von gestern. Die erneuerbaren Energien sollen hier nur als Sündenbock herhalten, um einen überdimensionierten Stromnetzausbau zu rechtfertigen. Dabei wären dezentrale, intelligente Netze samt Lastmanagement und mittelfristig mehr Speicher viel wichtiger.

Auch diese „Fachfrau“ belegt, dass man mit Wissen nicht weiterkommt, sondern indem man weiss, was die Wichtigen als Wissen wissen wollen. Trotz ihrer vielen, oft hanebüchenen Aussagen [6] wird sie mit Ehrungen und Posten überhäuft.

Der bdew als ein Verband mit Fachwissen könnte etwas zur (Er-)Klärung beitragen. Macht er aber nicht.

Stattdessen philosophieren seine Fachleute über unerfüllbare Wünsche und Speicher und dass der Grund, warum sie fehlen „regulatorische Hemmnisse“ wären, die man schnell abschaffen könnte. Dass Speicher im erforderlichen Umfang nicht möglich sind, alternativ (als Powert to Gas mit Rückverstromung [11] [13]) die Stromkosten explodieren lassen [11], wagt der Verband nicht zu erwähnen.

… welche sich durch GRÜNE „Forschungskompetenz“ selbst bestätigt …

Welche Kompetenz hat nun das Forschungsinstitut, von dem die Studie für die GRÜNEN verfasst wurde? Anbei eine Nachschau:

era (energy research architecture) ist eine international tätige Beratungsfirma, die sich mit den Energie- und Ressorcenfragen unserer Zeit beschäftigt. Das Ziel von era ist, einen Beitrag zur Entwicklung einer nachhaltigen Ära zu leisten, die auf einer sauberen, sicheren und erneuerbaren Energieversorgung und auf den effizienten Einsatz von Ressourcen basiert.

Der Haupt-Studienautor ist mit-Gründer von era:

Björn Pieprzyk

2001: Studium der Landschaftsplanung mit Schwerpunkt Umweltschutz an der Universität Hannover

Diplomarbeit: Der Beitrag von ÖKOPROFIT zur nachhaltigen Entwicklung – Analyse der Kooperation staatlicher Institutionen und Unternehmen zur Förderung nachhaltiger Produktion

2001-2006: Referent für den Bundesverband Erneuerbare Energie Deutschland (BEE)

2006-2007: Referent für die Agentur für Erneuerbare Energien (AEE)

Seit 2008: Referent für den Bundesverband Erneuerbare Energie Deutschland (BEE)

2008: Gründung der Firma ERA energie research architecture mit Paula Rojas Hilje

Seit 2011: Doktorand an der Technischen Universität Darmstadt

Hochschule Ostwestfalen-Lippe: Lehrbeauftragter für Energiepolitik, Energierecht

Er hat auch bereits Studien zum EEG Im Auftrag des Bundesverbandes Erneuerbare Energie e.V. verfasst:

Irgendwie erschütternd, was inzwischen alles als „Forschungsinstitut“ bezeichnet wird. Für das wenige und dazu noch ideologisch beschränkte Wissen, welches die GRÜNEN benötigen, reicht aber wohl jedes „Kleinbüro“, sofern es die geforderten Daten verspricht, aus. Der gerade erschienene Artikel von Andrea Andromidas trifft das wie die Faust aufs Auge:

EIKE 02.09.2017: Die Science Fiction des Jeremy Rifkin oder: die schöne neue Welt der Öko-Kollektive

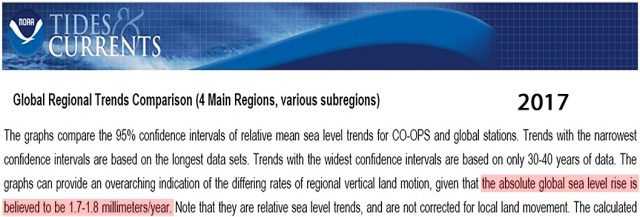

Der Autor hat spasseshalber die Daten für die EEG-Zukunft hochgerechnet.

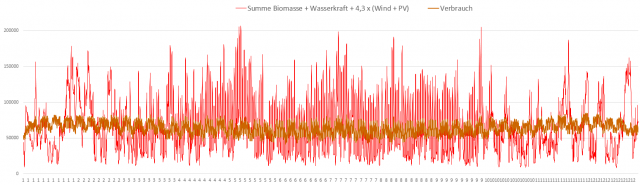

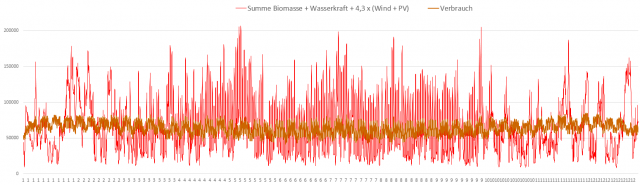

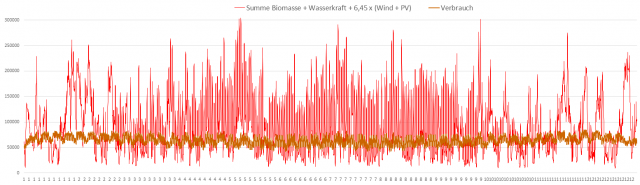

Wenn die EEG-Einspeisung den Strombedarf decken soll, müssten Wind- und PV gegenüber dem Ausbaustand im Jahr 2016 nochmals um den Faktor 4,3 ausgebaut werden. Die hochgerechneten Ganglinien sehen dann wie im Bild 10 aus.

… kommt dieses Desaster heraus

Bild 12 EEG-Einspeisung linear hochgerechnet, so dass EEG-Jahreseinspeisung = Verbrauch. Datenquelle: Agora

Bild 13 EEG-Einspeisung linear hochgerechnet, so dass EEG-Jahreseinspeisung = Verbrauch + Speicherverluste. Datenquelle: Agora

Dass unser Versorgungsnetz bei diesen Einspeisungen nicht mehr stabil bleiben kann, drastisch umgebaut werden muss und massivste, restriktive Maßnahmen erforderlich werden, welche unabhängig davon, ob sie ausreichend Wirkung zeigen, auf jeden Fall wirklich viel, viel Geld kosten, ist sicher. Doch was interessiert die elektrische Wirklichkeit schon ernannten Energie-„Fachpersonen“ – und Bürgerinitiativen, welche gegen die notwendigen Umbaumaßnahmen genau so demonstrieren, wie gegen das Verbleiben im aktuell noch sicheren Energiesystem.

… welches bedingungslos zum totalen Kampf gegen das Klima weitergeführt wird

Das klingt schon recht verwegen. Den „Fachpersonen“ jagt es jedoch keine Angst ein, nein, es ihnen Ansporn, zur Rettung des Klimas noch mehr zu tun. Diesmal sind es zur Entschuldigung nicht die GRÜNEN, sondern Greenpeace Energy und der Bundesverband Erneuerbare Energien in Verbindung mit einer Energie-Fachperson aus dem Dunstkreis der Klimaberaterin C. Kemfert.

Greenpeace Energie, 20.06.2016, Pressemitteilung: [13] Deutschland braucht 100 Prozent erneuerbare Energien bis 2040, den Kohleausstieg bis 2030 und raschen Ausbau von Langzeitspeichern

In dieser Studie wird erklärt:

… Um die Vorgaben des Pariser Klimaabkommens einzuhalten, muss Deutschland erheblich mehr Ökostrom produzieren als bislang geplant …Demnach braucht Deutschland spätestens im Jahr 2040 jährlich 1.320 Terawattstunden an erneuerbarem Strom. Das ist mehr als doppelt so viel wie heute. Der deutlich höhere Strombedarf entsteht nach der „Sektorkopplungsstudie“, weil auch Verkehr, Wärme und Industrie zum Erreichen der Klimaschutzziele in Deutschland von fossilen Energieträgern auf erneuerbaren Strom umschwenken müssen. „Mit den geringen Zubaukorridoren des Erneuerbare-Energien-Gesetzes ist ein Einhalten der Paris-Ziele praktisch unmöglich. Entweder fehlt den politisch Verantwortlichen der nötige Sachverstand oder sie beabsichtigen das Klimaschutzabkommen gar nicht einzuhalten“, urteilte Studienleiter Prof. Dr. Volker Quaschning bei der Präsentation in Berlin.

Wenigstens sagt dieser Professor endlich einmal, was dann an Speicher benötigt wird, ein Problem, von dem die GRÜNE Fachfrau gar nichts weiß:

[13] … „Um den von Professor Quaschnings Team ermittelten Energiebedarf durch erneuerbare Speicher abzusichern, brauchen wir bis 2040 eine Elektrolyseurleistung von mindestens 80 Gigawatt, um den nötigen Wasserstoff zu erzeugen“, …

Mit dem 14-fachen EEG-Ausbau könnte Deutschland seine Klimaziele erreichen …

Dieser Prof. Quaschning (Promotion über die Abschattung von Solarzellen) fordert so ganz nebenbei nichts weniger, als mindestens eine Vervierzehnfachung des aktuellen EEG-Ausbaus (mehr als 2 x 6,5, siehe Bild 11), da ansonsten die Welt mit dem Klima untergehen würde. Wer das nicht glaubt, dem fehle der nötige Sachverstand. Das erste Mal dass man froh ist, dass wenigstens einem Teil unserer Politikern dieser Sachverstand fehlt.

Ansonsten ist dieser Professor ein typisches Beispiel für die Forschertypen, welche mit Freude und konsequent etwas (zum eigenen Nutzen) umsetzen, den Sinn und die Notwendigkeit jedoch nicht hinterfragen, sondern froh sind, dass er „von Oben“ vorgegeben wird. Solche gibt es in jedem Zeitabschnitt der Geschichte.

… und mit dem 40-fachen ganz auf Ökoenergie umsteigen

Wie man das leicht ausrechnen kann, steht im Artikel:

EIKE 08.09.2017: Welcher EEG-Ausbau wird benötigt, wenn man – wie es die GRÜNEN fordern – alle Energie aus EEG-Erzeugern generiert?

Was es kostet, kann man ebenfalls abschätzen:

EIKE, 10. Oktober 2016: Neue Studie enthüllt: Die Energiewende wird uns bis 2025 rd. 520 Mrd € kosten

Fazit

Wie schon in den Artikeln:

EIKE 26.08.2017: Holen sich die GRÜNEN ihre „Kernkompetenz“ zum Klimawandel von der Bundesregierung?

EIKE 28.8.2015: Wenn Politologinnen „Klimastudien“ machen – zur „Klimastudie“ von Bündnis 90/Die Grünen

dargelegt wurde, geht es den GRÜNEN nicht darum, irgendwo „Kernkompetenz“ zu erhalten. Es werden nur Personen gesucht, die willig ihre ideologisch vorgefasste Meinung begründen helfen.

Oder sollte es inzwischen eine Ausnahme geben?

Angeblich ist das auch dem bayerischen Ministerpräsidenten aufgefallen. Vor Kurzem konnte er sich noch eine Koalition CSU / GRÜNE in Bayern vorstellen, nun hat er sich anders entschieden.

N24: Seehofer kann sich Koalition mit den Grünen nicht mehr vorstellen

Nur weiß man bei Seehofer nie, ist es (Nach-)Denken, oder reines Parteikalkül. Zum Beispiel weil die FDP inzwischen bessere Umfragewerte als die GRÜNEN vorweisen kann.

Um es als Nachdenken zu belegen, müsste er erst einmal seine Umweltministerin gegen eine Person auswechseln, die sich nicht nur als hohle, grüne Mainstream-Sprechpuppe darstellt und Frau Hendricks Klimahysterie und fachliche Inhaltsleere teilt [14].

Quellen

[1] KLIMARETTER.INFO, 25. August 2017: Kohlestrom verstopft auch Exportleitungen

[2] era, August 2017: Analyse des Exports von Stein- und Braunkohlestrom Erstellt im Auftrag von: Bundestagsfraktion Bündnis 90/Die Grünen

[3] bdew Bundesverband der Energie- und Wasserwirtschaft e.V.: Stefan Kapferer zum aktuellen Kraftwerke-Papier der Grünen

[4] Annalena Baerbock 25.08.2017: Studie: Stromexporte von Stein- und Braunkohlestrom

[5] TYCHIS EINBLICK, 4. Februar 2017: Anspruch und Wirklichkeit „Energiewende“ trifft frostige Wirklichkeit

[6] EIKE 05.06.2016: Eine Professorin klärt den VDI auf, wie das EEG „wirklich“ funktioniert

[7] EIKE 01.01.2016: Die neuen Energien im Jahr 2015 und im Jahr 2050 für Dummies Teil 2 intelligente Versorgungsnetze

[8] EIKE 06.02.2016: Nachgefragt: Ein lokaler Versorger bricht die Macht der Stromgiganten

[9] EIKE, 01. September 2017: SPIELER AM WERK? Die Energiewende und Grünsprech – Die Kaskadierung

[10] EIKE 15.08.2017: Cem Özdemir versucht sich in Energie

[11] EIKE 18.06.2015: Elektro-Energiespeicherung, Notwendigkeit, Status und Kosten. Teil 3 (Abschluss)

[13] Greenpeace Energie, 20.06.2016: Deutschland braucht 100 Prozent erneuerbare Energien bis 2040, den Kohleausstieg bis 2030 und raschen Ausbau von Langzeitspeichern

[14] EIKE 21.11.2015: Die bayerische Umweltministerin Frau Scharf: Extremwetter, Extrem-Hochwasser und die Unberechenbarkeit des Wetters nehmen zu. Doch stimmt das wirklich?

[15] EIKE 21. Dezember 2012: Ein Weihnachtsmärchen: Minister Altmaier, die Energiewende und die Geisterfahrer

[16] EIKE 21. August 2017: POLITISCHE BILANZ: Nicht „ob“, sondern „wie schnell“

[17] EIKE: Immer wieder muss der Tschad-See unter dem Klimawandel leiden, oder: Warum steht in Studien der GRÜNEN immer so viel Falsches drin?