September 2017: Leicht unterkühlt, oft schon wie der Oktober – wo bleibt die Klimaerwärmung?

Die langfristige Entwicklung der Septembertemperaturen in Deutschland

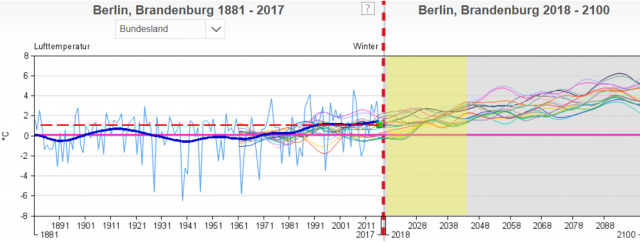

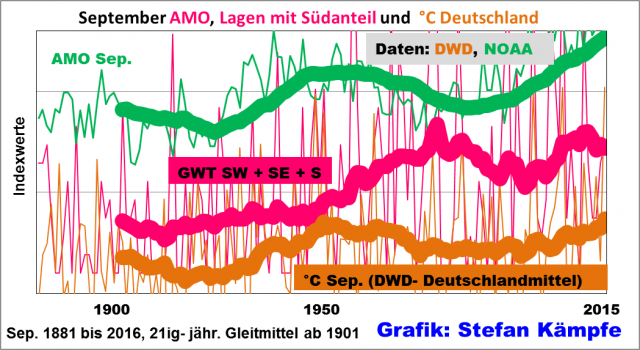

Zunächst lohnt ein Blick auf die langfristige Entwicklung der Septembertemperaturen und deren Ursachen. Von 1881 bis 2016 erwärmte sich der September in Deutschland lediglich um etwa 1 Kelvin (1 Kelvin = 1°C) und damit weit weniger stark, als die meisten anderen Monate. Zwei mögliche Erwärmungsursachen, eine leichte Häufigkeitszunahme der Großwetterlagen mit südlichem Strömungsanteil sowie die insgesamt gestiegenen AMO- Werte (ein Indexwert für die Wassertemperaturen im zentralen Nordatlantik), zeigt die folgende Grafik gleich mit. Eine dritte mögliche Ursache, die Verstädterung sowie die geänderte Landnutzung („Wärmeinseleffekte“ im weitesten Sinne) wurde hier bei EIKE schon oft erläutert und soll bloß erwähnt werden.

Abb. 1: Höhere Septembertemperaturen traten in Deutschland besonders während der AMO- Warmphasen zur Mitte des 20. Jahrhunderts und gegenwärtig auf. Die momentanen Werte erreichen aber bislang nur knapp das Niveau der vorigen Jahrhundertmitte. Außerdem nahm die Häufigkeit der Großwetterlagen mit Südanteil tendenziell mit den AMO- Werten zu, wobei Spitzenwerte bevorzugt am Ende der AMO- Warmphasen auftraten. Hier mussten Indexwerte berechnet werden, um die sehr unterschiedlichen Größen in einer Grafik darstellen zu können.

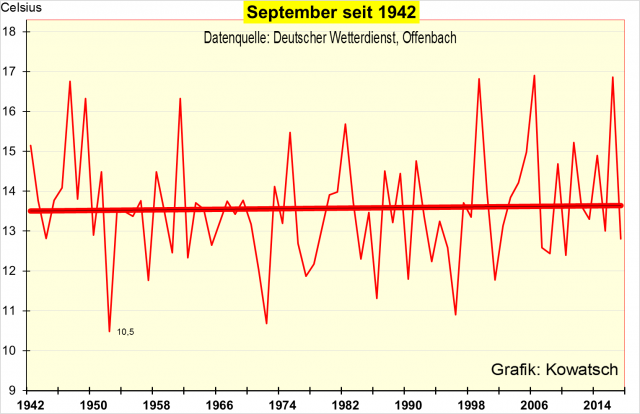

KOWATSCH hat das Temperaturverhalten in verschiedenen Zeitabschnitten genauer untersucht. Der größte Teil der bescheidenen Septembererwärmung fand bis etwa 1920 statt. Seit 1942, dem etwaigen Höhepunkt der vergangenen AMO- Warmphase, zeigt sich keinerlei Erwärmung:

Abb. 2: Keine Septembererwärmung in Deutschland seit über 70 Jahren, und das trotz stetig steigendem Wärmeinselanteil bei den DWD-Stationen. In diesem Zeitraum nahm die CO2- Konzentration in der Atmosphäre um etwa 90 ppm zu; das entspricht einer Steigerung um etwa 30%. Man achte auf die sehr warmen September 1947, 1949 und 1961. Erst 1999, 2006 und 2016 wurden deren Werte wieder erreicht, beziehungsweise knapp übertroffen.

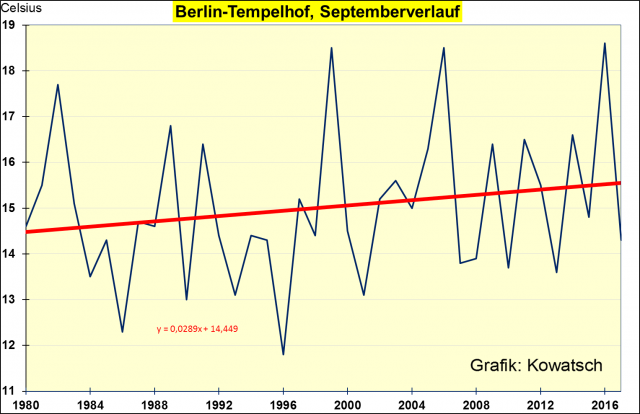

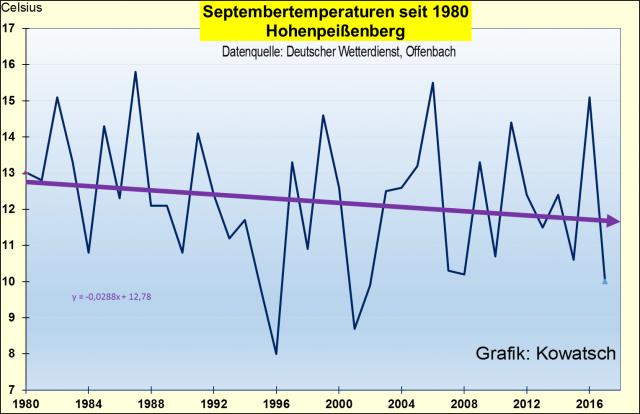

Betrachtet man den Zeitraum ab 1980, so zeigen einzelne Stationen sehr unterschiedliche September- Temperaturtrends:

Abb. 3 und 4: Seit 1980 verhielten sich die Septembertemperaturen gebietsweise sehr unterschiedlich. Während es in Tempelhof (Berliner Innenstadt) milder wurde, was zumindest teilweise mit Wärmeinseleffekten erklärt werden kann, kühlte es sich auf dem Hohenpeißenberg (Südbayern) ab. Freilich ist auch diese Station nicht WI- frei, aber weniger WI-beeinflusst als die Berliner Innenstadt. Da an beiden Stationen die CO2- Konzentration seitdem stark anstieg, wird klar, dass diese CO2- Zunahme keine wesentliche Ursache für die Entwicklung der Septembertemperaturen in Deutschland sein kann.

Überhaupt zeigt sich der Monat September, über einen längeren Zeitraum betrachtet, sehr stabil. Ausgeprägte kalte bzw. warme Jahrzehnte treten kaum auf. Das zeigt die nächste Grafik vom Hohenpeißenberg seit Beginn der dortigen Messreihen vor über 230 Jahren. Bis 1934 stand die Wetterstation noch bei einem Kloster am höchsten Punkt des Berges, heute etwas tiefer gelegen in einem neu erbauten DWD-Wetterzentrum. Inzwischen ist der Berg touristisch gut erschlossen (siehe http://www.dwd.de/DE/forschung/atmosphaerenbeob/zusammensetzung_atmosphaere/hohenpeissenberg/start_mohp_node.html ).

Abb. 5: Das Temperaturverhalten des Monates September ist recht stabil. Zu Mozarts Zeiten war es allerdings etwas wärmer als heute. Der wärmste September im Alpenvorland war jedoch 1961. Eingezeichnet sind noch die kalten Jahre 1881, hier beginnt der DWD mit seinen Grafiken und das Jahr 1931, ein sehr kaltes Jahr, das der grüne Baden- Württembergische Umweltminister Untersteller gerne als Vergleichsjahr nimmt. Zweifellos war der relativ kühle September 2017 immer noch deutlich wärmer als 1931.

Septembertemperaturen in Zentralengland und Nordamerika – auch dort fehlt eine besorgniserregende Erwärmung

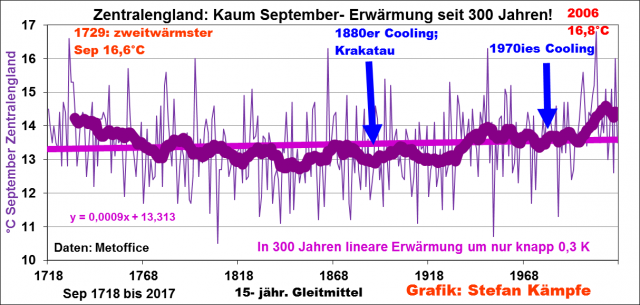

In Zentralengland liegen langfristige Temperaturaufzeichnungen seit mindestens 300 Jahren vor. Die Messreihe ist nicht WI- bereinigt, trotzdem zeigt sich dort eine nur unwesentliche September- Erwärmung:

Abb. 6: Im frühen 18. Jahrhundert war der September in Zentralengland fast genauso mild wie gegenwärtig; während er sich vom späten 18. bis zum frühen 20. Jahrhundert dort kühler zeigte. Der lineare Erwärmungstrend von knapp 0,3 K ist kaum größer als der Messfehler bei Temperaturaufzeichnungen.

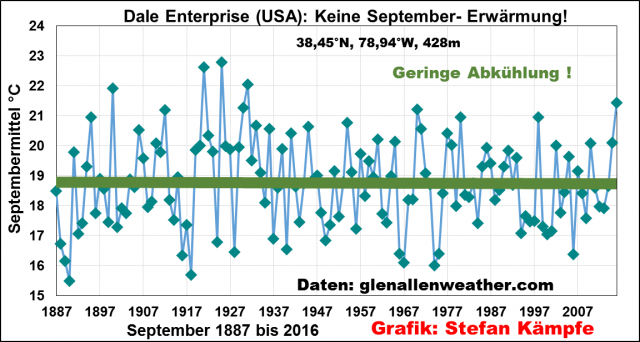

An der von Wärmeinseleffekten weitgehend verschonten, weil ländlichen Station Dale Enterprise in Virginia/USA gab es während der vergangenen 130 Jahre sogar eine minimale September- Abkühlung:

Abb. 7: keine langfristige September- Erwärmung trotz stark steigender CO2- Werte an der Station Dale Enterprise/USA.

Warum waren der September 2016 und 2017 so unterschiedlich?

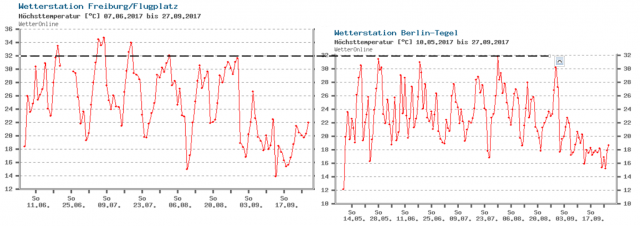

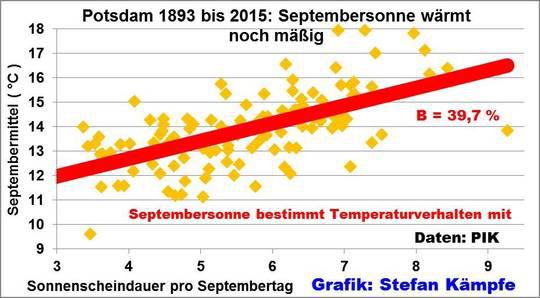

Die astronomisch mögliche Sonnenscheindauer und die Sonnenstandhöhe fallen im Septemberverlauf vom Niveau Mitte April auf das von Mitte März zurück. Wenn es so spät im Jahr über viele Tage noch hochsommerlich heiß werden soll, müssen stets drei Voraussetzungen zugleich erfüllt sein, die auch 2016 gegeben waren; nämlich eine maximale Sonnenscheindauer von 10 bis fast 13 Stunden pro Tag, dazu eine Hochdruckwetterlage, bei der die Luftmasse absinkt und sich adiabatisch erwärmt (ein ähnlicher Effekt wie das warm werdende Ventil beim Aufpumpen eines Reifens), und eine Luftströmung mit Südanteil, welche eine subtropische oder gar tropische Luftmasse nach Deutschland führt. Der September ist der letzte Monat im Jahresverlauf, bei dem die Sonnenscheindauer das Verhalten der Lufttemperaturen wesentlich (signifikant) mitbestimmt:

Abb. 8: Die Varianz der Septembertemperaturen wird zu einem guten Drittel von der Sonnenscheindauer bestimmt. Der Zusammenhang ist schwächer als im Spätfrühling und Sommer, aber dennoch signifikant. Das PIK gibt die Sonnenscheindauer nicht als Monatssumme in Stunden, sondern als Stundenmittel je Tag, bezogen auf den ganzen Monat, an. Ein Stundenmittel von 8 (sehr sonnenscheinreich) entspricht einer Monatssumme von 240 Sonnenstunden.

Seit 1893 wird in Potsdam-Telegrafenberg die Sonnenscheindauer erfasst. Sie nahm etwas zu, was eine vierte Ursache für die geringe Septembererwärmung in Deutschland ist:

Abb. 9: Leicht zunehmende Sonnenscheindauer im September in Potsdam. Für ganz Deutschland fehlen leider langfristige Aufzeichnungen, doch dürfte auch im ganzen Land der September etwas sonniger geworden sein.

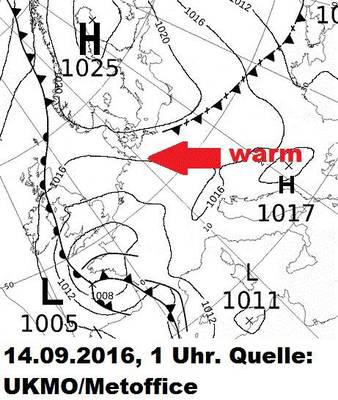

Mit fast 140% (215 Stunden) übererfüllte der September 2016 sein Monatssoll der Sonnenscheindauer deutlich; doch wie sah es mit den anderen zwei erforderlichen „Zutaten“ für die Septemberhitze aus? Die folgende Wetterkarte zeigt einen leichten Hochdruckeinfluss und eine südöstliche Strömung über Deutschland am 14. September:

Abb. 10: Am 14. September 2016 herrschte mit einer südöstlichen Strömung am Rande einer von Skandinavien zum Balkan reichenden Hochdruckzone noch perfektes, heißes Spätsommerwetter über Deutschland. Über der Bretagne lag bereits ein Tief, welches ostwärts zog und ab 16. September einen jähen Temperatursturz mit starken Regenfällen einleitete.

Doch 2017 dominierte eine ganz andere Luftdruckverteilung, welche besonders zur Monatsmitte maritime Subpolarluft (mP) mit Wind, Kälte und Regenschauern heranlenkte:

Abb.11: Genau ein Jahr später, am 14. September 2017, bestimmten Tiefdruckgebiete über Skandinavien unser Wetter. Stürmischer Südwestwind, wenig Sonne und häufige Regenfälle oder Schauer bei nur noch 13 bis 18°C dominierten in der feucht- kalten Subpolarluft für viele Tage. Nur im Raum Weimar- Erfurt blieben die Niederschläge, bedingt durch den Lee- Effekt des Thüringer Waldes, gering, so dass dort der September erheblich zu trocken ausfiel.

Außerdem schien die Septembersonne 2017 kaum 140 Stunden; auch das trug zu dem insgesamt unfreundlichen, kühlen Charakter dieses Septembers 2017 bei.

Stefan Kämpfe, unabhängiger Natur- und Klimaforscher

Josef Kowatsch, unabhängiger Natur-und Klimaforscher