PEINLICH: Klimawandel-Hysteriker beschwert sich beim PRESSERAT in Berlin!!

In diesen Tagen bemerkten wir auf Twitter folgenden Tweet vom 07.10.2017: Darin wurde auf zwei Seiten die Antwort des Presserats vom 14.09.2017 öffentlich gemacht. Der Presserat hat sich darin mit einer Beschwerde über einen WELT-ONLINE-MEINUNGS-Artikel von Prof. Josef H. Reichholf vom 28.05.2017 mit dem Titel „Schnell wird man als Klimaleugner abgestempelt“ befasst.

Darin wurde auf zwei Seiten die Antwort des Presserats vom 14.09.2017 öffentlich gemacht. Der Presserat hat sich darin mit einer Beschwerde über einen WELT-ONLINE-MEINUNGS-Artikel von Prof. Josef H. Reichholf vom 28.05.2017 mit dem Titel „Schnell wird man als Klimaleugner abgestempelt“ befasst.

Zur besseren Lesbarkeit haben wir die Antwort des Presserates auch nochmal separat als .pdf-Datei zur Verfügung gestellt:

Die Indizien auf dem Twitter-Account von Andreas Lieb sprechen für die These, dass Andreas Lieb auch einer der beiden Beschwerdeführer der Presseratsbeschwerde gewesen ist, da die Fotos der beiden Antwortseiten des Presserates auch in seinem Twitter-Account hinterlegt sichtbar sind:

An dieser Beschwerde und der Antwort des Presserates sind nun mehrere Punkte interessant, weil die nun folgenden Kritikpunkte die Notwendigkeit auch früherer Blogtexte erneut bestätigen.

So führt der Beschwerdeführer folgende zwei Sätze von Prof. Reichholf an und es ist auch erkennbar, dass der Presserat diese zwei Sätze von Prof. Reichholf auch als den Kern der Beschwerde ansieht:

Die globale Temperatur steigt trotz wachsenden CO2-Ausstoßes nicht an.

und:

Die letzten eineinhalb Jahrzehnte lang stieg die globale Temperatur nicht mehr an.

Und der/die Beschwerdeführer argumentieren dann allen Ernstes, wie man in der Antwort vom Presserat vom 14.09.2017 lesen kann, wie folgt:

An dieser Begründung und den nachfolgenden Begründungen des Presserates wird erneut deutlich, wie seit Jahren und Jahrzehnten am eigentlichen Schwindel der Erderwärmung „vorbei-argumentiert“ wird, denn der Kern des globalen Temperaturschwindels bleibt jedesmal aussenvor. Kein Journalist, auch nicht der Presserat, hinterfragt den Absolut-Temperaturwert der Erderwärmung, obwohl der Chef-Redakteur von „DER WELT“ vom Presserat im Schreiben vom 14.09.2017 auf der Seite 2 wie folgt zitiert wird:

Sehe man im Internet nach, so würden die Spitzenwerte als Abweichungen vom Durchschnitt der Jahre 1961 – 1990 und nicht in Absolutwerten der Globaltemperaturen angegeben, was die Vergleichbarkeit sehr erschwere bzw. unmöglich mache.

Im Prinzip stimmt das, was er sagt, aber das ist trotzdem auch nur die halbe Wahrheit: Die WMO hat am 18.01.2017 sehr wohl einen Absolut-Globaltemperaturwert für das Jahr 2016 von 14,8(3) °C auf Basis von 1961 bis 1990 angegeben, was der ZDF-Wetterfrosch Benjamin Stöwe am 19.01.2017 – also einen Tag später – im „ZDF MORGENMAGAZIN“ eindrücklich präsentierte:

Video nicht mehr verfügbar

Das Problem ist nur – und dieses Problem verschweigen Politiker, Klima(folgen)forscher und auch Journalisten seit Jahren -, dass die angeblich gefährliche globale Erderwärmung vor und seit ca. 30 Jahren mit viel höheren Globaltemperaturen begründet worden ist, was die folgende 23-seitige Recherche-Liste dokumentiert:.pdf

Ein ganz grosses „Problem“ hat dabei „DER SPIEGEL„, was in dem folgenden 18-minütigen Video dokumentiert wird:

Aber nicht nur DER SPIEGEL. Auch die Journalisten bei ARD und ZDF können ihre Unwahrheiten aus der Vergangenheit offensichtlich nicht mehr verwalten, was in dem folgenden 18-minütigen Video insbesondere an dem ARD- (früher: ZDF-) Wissenschaftsjournalisten und Meteorologen Karsten Schwanke deutlich wird:

Wenn Sie den obigen Recherchen im Detail nachgehen, werden Sie feststellen, dass offensichtlich weder Klimafolgenforscher, noch Politiker, noch Journalisten begreifen, wie elementar-notwendig eine glaubwürdige globale Absolutmitteltemperatur ist, um überhaupt eine Globale Erderwärmung glaubwürdig auszuweisen.

Und vergleichen Sie ganz aktuell auch die folgende Grafik aus einem RBB-TV-Bericht über „25-Jahre PIK Potsdam“ vom 11.10.2017 bei Minute 2:49:

Sie erkennen: Es wird aktuell ein globaler Temperaturwert von ca. 14,5 °C ausgewiesen, jedenfalls erkennbar deutlich unterhalb von 15°C.

Sie erkennen: Es wird aktuell ein globaler Temperaturwert von ca. 14,5 °C ausgewiesen, jedenfalls erkennbar deutlich unterhalb von 15°C.

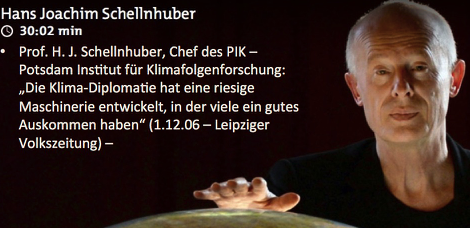

So, und nun schauen Sie, mit welchem globalen Temperaturwert für 1990 am 24.05.1990 die Enquete-Kommission des deutschen Bundestags in der Drucksache 11/8030 auf Seite 29 argumentiert hatte, um eine damals angeblich gefährliche Erderwärmung zu begründen, nämlich 15,5 °C : Und Hans Joachim Schellnhuber propagierte noch am 22.11.2009 (auf PHOENIX zeitversetzt ausgestrahlt einen Tag später am 23.11.2009) – auf der Bundespressekonferenz unmittelbar vor der Klimakonferenz von Kopenhagen – noch einen globalen Temperaturmittelwert von 15,3 °C:

Und Hans Joachim Schellnhuber propagierte noch am 22.11.2009 (auf PHOENIX zeitversetzt ausgestrahlt einen Tag später am 23.11.2009) – auf der Bundespressekonferenz unmittelbar vor der Klimakonferenz von Kopenhagen – noch einen globalen Temperaturmittelwert von 15,3 °C:

Wer auch das nicht glaubt: Der O-Ton von Schellnhuber findet sich in diesem 5-minütigen Video !!

Wer auch das nicht glaubt: Der O-Ton von Schellnhuber findet sich in diesem 5-minütigen Video !!

So kommt es, dass sogar in mehreren deutschen Schulbüchern Schulkindern die angebliche Notwendigkeit von Klimaschutz propagiert wird, obwohl man im gleichen Schulbuch durch Einsatz des gesunden Menschenverstandes feststellen kann, dass seit über 150 Jahren überhaupt keine gefährliche Erderwärmung existiert.

Glauben Sie nicht?

Dann schauen Sie auch noch das folgende, sehr informative 18-minütige Recherche-Video:

Die Argumentation, die in diesem aktuellen KLETT-GEOGRAPHIE-Schulbuch auf Seite 194 ausgewiesen wird, finden Sie auch in den Drucksachen der Enquete-Kommission des Deutschen Bundestages, die damals mit den gleichen Argumenten vor der Gefährlichkeit einer Erderwärmung Politiker und Öffentlichkeit gewarnt hatte, nur mit dem Unterschied, dass damals (1990) eine globale Absoluttemperatur von 15,5°C ausgewiesen worden ist. Sogar bis 1995 wurde nachweislich – und das belegen unsere eindrücklichen Recherchen in deutlicher Konsequenz – immer eine Globaltemperatur bei oberhalb von 15°C ausgewiesen. Und heutzutage werden für 2016 bekanntlich nur 14,8°C ausgewiesen, was wir oben im Blogtext dokumentiert haben.

Und damit ist auf einen Schlag die Gefährlichkeit der Erderwärmung als Schwindel entlarvt.

Ohne, dass wir und Sie dazu auch nur ein einziges vermeintlich klimaskeptisches Argument verwenden mussten: Das „unheilige Triumvirat“ aus Klimafolgenforschern, Politikern und Journalisten hat sich beim Thema „gefährliche Erderwärmung“ nach nunmehr 30 Jahren ganz alleine selbst „die Karten gelegt.“ Wirklich Pech, wenn man die eigenen Lügen nicht mehr verwalten kann.

Und ärgerlich wird es zusätzlich, wenn auch vermeintlich kritische Professoren diese Diskrepanz bei den globalen Temperaturwerten ebenfalls nicht erkennen (wollen).

Ähnlich agiert aber leider auch Prof. Josef Reichholf, der in seinem DIE WELT-Meinungsartikel am 28.05.2017 geschrieben hatte:

Die anscheinend nötigen Nachbesserungen bei den Berechnungen zur globalen Temperatur und die vielen Änderungen in den Vorhersagen zum Klimawandel drücken für mich als Wissenschaftler eines klar aus: Die letztgültige Weisheit gibt es nicht.

Auch Prof. Reichholf scheint die allzuvielen „Unschärfen“ der Klimafolgenforschung ebenfalls „weichzuspülen“, anstatt diese nachweisbaren Unschärfen konkret zu thematisieren und auf den Punkt zu bringen. Ärgerlich auch, dass Prof. Reichholf von „Vorhersagen zum Klimawandel“ spricht. Auch schreibt Prof. Reichholf:

Die globale Temperatur steigt trotz wachsenden CO2-Ausstoßes nicht an. Dies passt nicht in die Prognosen von Politik und Wissenschaft.

und

Die letzten eineinhalb Jahrzehnte lang stieg die globale Temperatur nicht mehr an. Diese Pause in der Erwärmung passte jedoch nicht zu den Prognosen.

Und dann schreibt auch noch der Presserat in der Beschwerdeablehnung am 14.09.2017 wortwörtlich:

Diese Forschungsergebnisse nimmt der Autor zum Anlass diese gängigen Klimaprognosen kritisch zu hinterfragen.

Denn es ist sogar in Schulbüchern nachzulesen, dass klimawirksame Prozesse nicht vorhersagbar sind und man deshalb von „Klimaprojektionen“ spricht und eben nicht von Prognosen:

Also, Fakt ist: Klimamodelle liefern gar keine Prognosen! Das wissen auch die Klima(folgen)forscher, was sich auch durch zahlreiche O-Ton-Nachweise belegen lässt. Denn die Klima(folgen)forscher werden wissen, dass man das komplexe und chaotische Atmosphärensystem der Erde nicht allein auf Basis von Daten der Vergangenheit vorhersagen lässt. Es funktioniert ja noch nicht mal die Ziehung der Lottozahlen oder den kommenden deutschen Meister der Fussball-Bundesliga auf der Datenbasis der Bundesliga-Vergangenheit vorherzusagen. Eine Vorhersage/Prognose auf Daten der Vergangenheit ist bei einem chaotischen System definitiv nicht möglich. Eine Prognose basiert zu 100% auf fixen, nicht-veränderbaren Daten aus der Vergangenheit, die dann linear in die Zukunft fortgeschrieben werden. Eine Prognose enthält also keine Zukunftsvariablen und keine zusätzlichen Annahmen über die Zukunft, im Gegensatz zu einer Projektion. Deshalb ist auch die „Sonntagsfrage“ über den Ausgang der Bundestagswahl KEINE Prognose, sondern eine Projektion, wie damals bei der Sonntagsfrage zur „Bremenwahl im 30. April 2015 in den „TAGESTHEMEN“, wo dem TV-Zuschauer deutlich zu verstehen gegeben wurde, dass dieser damalige „BremenTREND“ eben KEINE PROGNOSE darstellt:

und auch aktuell zur Bundestagswahl 2017 in den ARD „TAGESTHEMEN“ am 14.09.2017 um 22Uhr15 ein deutlicher Hinweis, dass das Ergebnis der „Sonntagsfrage“ eben KEINE PROGNOSE darstellt:

und auch aktuell zur Bundestagswahl 2017 in den ARD „TAGESTHEMEN“ am 14.09.2017 um 22Uhr15 ein deutlicher Hinweis, dass das Ergebnis der „Sonntagsfrage“ eben KEINE PROGNOSE darstellt:

Und ein gutes #kurzerklärt-Video der TAGESSCHAU-Redaktion erklärt am 23.09.2017 – also unmittelbar vor der Bundestagswahl, wo es eigentlich schon für eine effektive Aufklärung zu spät ist – ebenfalls, dass die „Sonntagsfrage“ eben KEINE PROGNOSE (sondern per Definition eine PROJEKTION) ist:

und hier auch beim ZDF wird der korrekte Begriff „PROJEKTION“ (statt Prognose) verwendet:

und hier auch beim ZDF wird der korrekte Begriff „PROJEKTION“ (statt Prognose) verwendet:

Sie sehen, dass sogar die ZDF HEUTE+ Moderatorin Eva Maria Lemke den Unterschied zwischen „Projektion“ und „Prognose“ nun verstanden hat, denn zum Zeitpunkt der „Sonntagsfrage“ ist noch mindestens eine, nicht-fixe Variable vorhanden, denn die Wahllokale haben weder geöffnet gehabt, noch sind sie wieder geschlossen worden. Deshalb wird die erste (und einzige) Prognose (!) von ARD bzw. ZDF bei einer Landtags- und/oder Bundestagswahl erst 1 Sekunde nach 18Uhr erstellt, weil erst dann davon auszugehen ist, dass alle vorherigen Variablen fix sind und nicht mehr verändert werden können, weil u.a. die Wahllokale um Punkt 18Uhr geschlossen haben.

Sie sehen, dass sogar die ZDF HEUTE+ Moderatorin Eva Maria Lemke den Unterschied zwischen „Projektion“ und „Prognose“ nun verstanden hat, denn zum Zeitpunkt der „Sonntagsfrage“ ist noch mindestens eine, nicht-fixe Variable vorhanden, denn die Wahllokale haben weder geöffnet gehabt, noch sind sie wieder geschlossen worden. Deshalb wird die erste (und einzige) Prognose (!) von ARD bzw. ZDF bei einer Landtags- und/oder Bundestagswahl erst 1 Sekunde nach 18Uhr erstellt, weil erst dann davon auszugehen ist, dass alle vorherigen Variablen fix sind und nicht mehr verändert werden können, weil u.a. die Wahllokale um Punkt 18Uhr geschlossen haben.

Und vergleichen Sie mal die obigen Werte der Projektion (!) des ZDF vom 20.07.2017 (!) über den damals angeblich „wahrscheinlichen“ Ausgang der Bundestagswahl mit dem vorläufigen amtl. Ergebnis der Bundestagswahl vom 24.09.2017 am 25.09.2017:

Dann verstehen Sie, was von Projektionen im Vergleich zu Prognosen zu halten ist, nämlich nix. Im Gegensatz zur Projektion vom 20.07.2017 war die 18-Uhr-Prognose des ZDF am 24.09.2017 im Vergleich zum Endergebnis dann relativ genau:

Aber es kann auch eine definitive Prognose trotzdem beim Endergebnis vollends daneben liegen. Die Wahrscheinlichkeit aber, dass eine Projektion beim realen Endergebnis der Zukunft vollends daneben liegt, liegt bei einer Projektion bei weitem höher als bei einer Prognose.

Obwohl man bei der ARD eigentlich mittlerweile wissen müsste, dass die Klima(folgen)forscher mit ihren Szenarien/Projektionen keine Prognosen erstellen, behauptet die ARD „TAGESSCHAU“ trotzdem im Mai 2017 weiterhin FALSCH, der Meeresspiegelanstieg für das Jahr 2100 liesse sich angeblich „prognostizieren“:

Denn auch der Weltklimarat IPCC erstellt nachweislich KEINE „Prognosen“:

Denn auch der Weltklimarat IPCC weiss: ES KÖNNEN KEINE PROGNOSEN ÜBER DAS KLIMASYSTEM ERSTELLT WERDEN.

Warum?

Weil es sich um ein chaotisches Atmosphären-System handelt, was man nicht auf Basis historischer, fixer Daten vorhersagen kann. Das ist die ureigenste Eigenschaft eines chaotischen Systems. Auch die Ziehung der Lottozahlen, ein Billardspiel oder jedwede Fussball-Saison von Liga-Mannschaften sind chaotische Systeme, die definitiv nicht vorhersagbar sind.

Warum ärgert mich die Verwendung des Begriffs „Prognose“ so ausserordentlich?

Weil der Ausdruck „Prognose“ die Klima-Abschätzungen in ungerechtfertigter Weise wertschätzt und positiv überbewertet und eine angebliche Vorhersagbarkeit und Prognose-Fähigkeit suggeriert, die in Wirklichkeit bei einem solchen chaotischen System definitiv nicht existiert.

Deshalb müssen alle Behauptungen, die sich aus Klimacomputermodellberechnungen ergeben, abgeleitet und errechnet worden sind, konsequent als „szenarienbedingte Projektionen“ und/oder „Schätzungen“ oder „Abschätzungen“ bezeichnet werden, aber auf keinen Fall als „Prognose“ oder „Vorhersage“ tituliert werden. Denn das ist definitiv FALSCH.

Wenn Sie DAS dann alles wissen, welche Rolle auch Journalisten beim SPIEGEL und bei ARD und ZDF beim Schwindel mit der angeblichen Erderwärmung spielen, dann lesen Sie auch, wie der Presserat den WELT-Chefredakteur am 14.09.2017 ebenfalls zitiert:

Nochmals: In seinem [Reichholfs] Kommentar sei es darum gegangen, die Vorgehensweise im Umgang mit den Daten aufzuzeigen, und nicht um eine Infragestellung der globalen Klimaerwärmung.

(rot-Markierung www.klimamanifest.ch)

Was für eine scheinheilige Argumentation. Darin spiegelt sich auch deutlich die regelrechte Angst deutscher Journalisten wider, um die globale Klimaerwärmung überhaupt in Frage zu stellen.

Dabei stellen auch wir die globale Klimaerwärmung nicht in Frage, sondern wir stellen begründend in Frage, dass die globale Klimaerwärmung für irgendjemanden gefährlich ist.

Fragen Sie sich selbst einmal: Würden Sie sich selbst oder ihr Kind mit 36,8 °C Körpertemperatur zum Arzt schicken, weil angeblich erhöhtes Fieber vorliegen könnte?

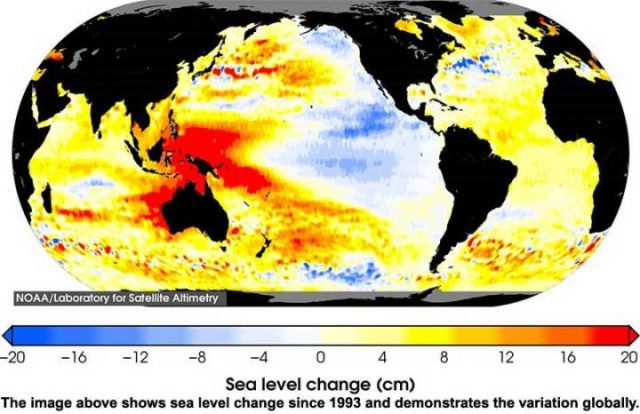

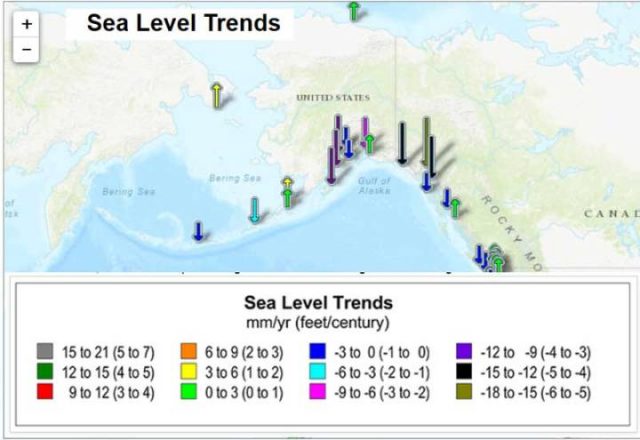

Da durch historische Dokumente belegbar ist – was oben in diesem Blogtext umfangreich dokumentiert wurde – , dass eine gefährliche Erderwärmung seit 150 Jahren definitiv bis heute nicht stattgefunden hat, ist die Gefährlichkeit einer globalen Klimaerwärmung vehement in Frage zu stellen. Alle Thesen vom angeblichen Meeresspiegelanstieg, angeblich mehr Extremwettern, angeblich verstärkte Gletscherschmelze können nachweislich nicht auf eine gefährliche globale Erderwärmung zurückzuführen sein, weil die historischen Daten und Archive der Klima(folgen)forschung solche Thesen nicht stützen, sondern genau das Gegenteil dokumentieren.

Das liegt insbesondere auch daran, weil Klima(folgen)forscher, Journalisten und Politiker ihre Lügen nach ca. 30 Jahren nicht mehr verwalten konnten. Aber auch ein Presserat in Berlin und auch ein Prof. Reichholf weigern sich offenkundig, diese offensichtlichen Lügen (ohne Anführungszeichen) der Klimafolgenforschung – insbesondere beim PIK in Potsdam – zu thematisieren.

Zuerst veröffentlicht am 14.10.2017 auf www.klimamanifest.ch