Statt Klimakonferenz – Schnorchelkurs für Barbara Hendricks

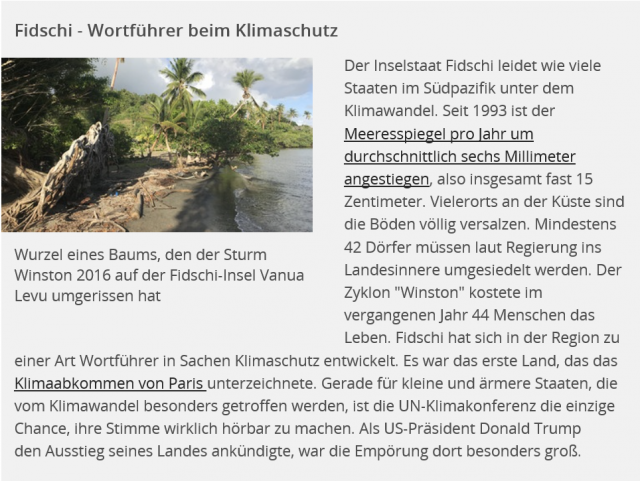

Stattdessen muss ich jetzt in der Süddeutschen Zeitung vom Untergang der letzten Paradiese lesen: „Da stehen Menschen in ihren Wohnzimmern zum Teil bis zu den Knöcheln im Wasser, wenn sie morgens aufstehen“, berichtet in dem Blatt ein Entwicklungshelfer der Deutschen Gesellschaft für Internationale Zusammenarbeit (GIZ) über die Insel Ono. Die Lage sei dramatisch: „Ein ganzes Dorf soll deshalb umgesiedelt werden.“

Die Süddeutsche sieht bereits eine Katastrophe globalen Ausmaßes: „Bei insgesamt 106 bewohnten Inseln dürfte das erst der Anfang sein, die Regierung arbeitet bereits an einem Umsiedlungsplan, der auf der Klima-Konferenz in Bonn vorgestellt werden soll.“ Deo Saran, Fidschis Sondergesandter für den Klimaschutz, wisse: „Viele Inseln sind schon verloren.“ Und die Süddeutsche assistiert: „Den gut 1200 Kilometer entfernten Nachbarn in Samoa hat seine Regierung sogar schon Klimaasyl angeboten: Dort sind die Auswirkungen noch spürbarer als auf den Fidschi-Inseln.“ Auch die deutsche Umweltministerin Barbara Hendricks weiß Bescheid: „Mit Fidschi leitet erstmals ein Mitglied jener Staatengruppe den Weltklimagipfel, die vom Klimawandel in besonders akuter Weise betroffen ist.“

Ja, da muss man doch was tun! Auf der Suche nach Hilfe für die Dorfbewohner bin ich sofort auf die Website der internationalen Fluchthelfer „tripadvisor“ gegangen und habe zunächst mal auf Ono nach geeigneten Not-Unterkünften gesucht. Empfehlen kann ich das Mai Dive Astrolabe Reef Resort, es liegt gleich um die Ecke direkt am Strand, kleiner Fußmarsch für die Flutopfer von nebenan. Auf der Homepage des Hotels heißt es: „You can take it easy. Relax on our beach, an environment that is medicine for your sole.“ Ono hat sieben Dörfer und gerade mal fünf Kilometer Durchmesser, die höchste Erhebung ist immerhin 354 Meter über dem Meeresspiegel (viele der Fidschi Inseln sind vulkanischen Ursprungs). „Auf den beiden großen Inseln liegen zerklüftete Gebirgsketten, die sich über schmalen Küstenebenen und vorgelagerten Korallenriffen erheben,“ beschreibt Wikipedia die Geographie Fidschis. Der höchste Berg ist 1324 Meter hoch. Uff, es kann also noch ein paar tausend Jahre dauern mit dem Untergang. Ich werde die Paradiese also doch noch sehen, im gleichen Licht wie Gaugin.

Die Tourismusbranche hat den Untergang nicht mitgekriegt

Es gibt offenbar eine gewisse Diskrepanz zwischen der regierungsamtlichen Schilderung und derjenigen der örtlichen Tourismus-Branche. Letztere scheint den Untergang des Eilands bislang nicht bemerkt zu haben, die Gäste auch nicht, denn die meisten Läden sind ausgebucht. Und von Beschwerden ist nichts bekannt, trotz 200 Euro pro Nacht aufwärts. In einer Bewertung eines Gastes heißt es aufmunternd und auf Deutsch: „Ich empfehle dieses Abenteuer sehr für Familien mit Kindern.“

Den Fachleuten des Umweltministeriums kann ich Tripadvisor für die nächste Minister-Vorlage zum Thema Fidschi nur wärmstens empfehlen. Möglicherweise würde ein Schnorchelkurs auf Ono den Horizont der deutschen Umweltministerin erweitern. Falls das nicht luxuriös genug ist, gibt es auf Fidschi noch hunderte andere wunderbare Strand-Unterkünfte, an denen der akute Meeresspiegel-Anstieg auf mysteriöse Weise vorüber geht, mein Favorit ist der hier. Das wäre sicherlich „medicine for Barbara Hendricks sole“ und fürs Klima deutlich weniger schädlich, als wenn die halbe Welt auf Spesen nach Bonn fliegt, um klimamäßig einen drauf zu machen. Denn dort beginnen am Montag die großen Klimafestspiele unter dem Motto „Karneval ohne Grenzen“. Die Feierlichkeiten werden mit Festumzügen, Rathauserstürmungen und dem ausgelassenen Treiben der Jecken auf den Straßen und in den Kneipen begangen. Den Höhepunkt der Session bildet morgen der große Montagsumzug in der Innenstadt.

Möglicherweise hängt die Aufregung um das Abtauchen der Südsee also gar nicht mit der Südsee zusammen, sondern mit der Klimakonferenz. Die Tage und Wochen vor einer solchen Veranstaltung sind stets von anschwellendem Alarm-Pegel gekennzeichnet, der aus einer Schwemme von düsteren Studien besteht, die von garantiert unabhängigen Wissenschaftlern rein zufällig so termingerecht gebacken werden, wie die Brötchen fürs Frühstückbüffet im Bonner Hilton. „Der größte Weltklimagipfel aller Zeiten“ (FAZ), kurz GröWaz, sichert eindrucksvoll die Stellung Deutschlands als führende Exportnation von Weltuntergangs-Szenarien.

Beim Untergang der Südsee handelt es sich gewissermaßen um ein in unregelmässigen Abständen wiederkehrendes Phänomen, so ähnlich wie die warme Meeresströmung El Niño („Das Christkind“). Während El Niño die Menschheit meist so um Weihnachten heimsucht, gehen die Südsee-Inseln stets vor Klimakonferenzen unter, tauchen dann aber wieder auf. Vor der Klimakonferenz in Doha 2012 und der Klimakonferenz in Lima 2014 versanken sie im deutschen Medienwald bereits in gleichlautenden Worten, etwa auf Focus Online („Massenmigration wegen steigenden Meeresspiegels“) und ZEIT ONLINE ( „Vor dem Untergang“). Zwischenzeitlich erhoben sie sich dann wieder aus den Fluten, auch dieses Mal müssen die Südseeinseln wieder auftauchen, um dann pünktlich 2018 zur nächsten Kilmakonferenz im polnischen Kattowitz wieder untergehen zu können.

Herrn Tongs Gespür für Kohle

In diesem Jahr sind die Kappensitzungen auch deshalb von großer dramaturgischer Bedeutung, weil der Gipfel zwar in Bonn stattfindet, Fidschi aber der Gastgeber der Klimafestspiele ist. Südsee-Politiker haben den Klimawandel längst als Goldesel entdeckt und können damit wunderbar von selbst verursachten Problemen ablenken. Das trifft sich mit der ideologischen Agenda von westlicher Depressionisten, die der Industriegesellschaft an den Kragen wollen. Koste es, was es wolle.

Die Rechnung fürs Bankett zahlt deshalb, klar doch, Berlin, es ist von vorsichtig geschätzten 117 Millionen Euro Steuergeldern die Rede. Hinzu kommen noch – zur Unterstützung der Präsidentschaft von Fidschi – rund sieben Millionen Euro aus dem Haushalt des Entwicklungsministeriums.

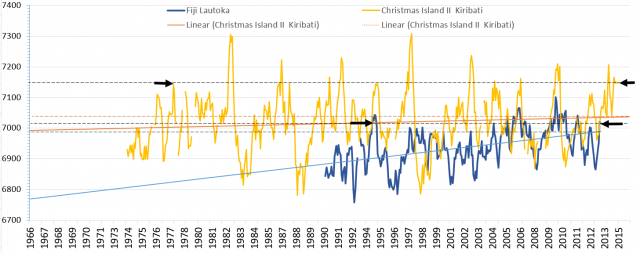

„Wollen Sie, dass wir zu Ihnen kommen?“ drohte Anote Tong Präsident der Inselstaates Kiribati schon 2015, ein echtes PR-Talent (und in Bonn tönt es im Refrain: Wolle mer se reinlasse?). Mal verlegen die Herrschaften aus der Südsee eine Kabinettsitzung unter Wasser, mal jetten sie erster Klasse um die halbe Welt und sehen sich vor laufenden Kameras die kalbenden Gletscher in Grönland an, sie sind also immer genau da, wo sie gebraucht werden. Mit Herrn Tongs Frage deutet sich bereits der nächste Plot an, der in deutschen Weltretter-Kreisen sicherlich dankbar aufgenommen wird. Künftigen Asylsuchenden kann ich nur den Rat geben, ihren Pass wegzuwerfen und in einfacher Sprache die beiden Worte „Ich Fidschi“ auszusprechen. Der Klimaflüchtling erlaubt die Fortsetzung der bisherigen Politik aus anderen Gründen, ist das nicht wunderbar?

Ansonsten steht eher zu befürchten, dass nicht Fidschi, sondern Bonn landunter geht (nur 60 Meter über dem Meeresspiegel!). „Klimagipfel bringt Bonn an Grenzen“, berichtet die online-Ausgabe der „Rheinischen Post“, denn bis zu 30.000 Klimatiker aus aller Welt werden sich zu diesem Konzil vom 6. bis 17. November an den stoischen Ufern des Rheins treffen. Es ist im übrigen ein kleines Wunder, dass dies überhaupt möglich ist. Schließlich sah DER SPIEGEL doch auf seinem Cover schon 1986 voraus, dass der Kölner Dom demnächst im Meer versinken werde. Erstaunlicherweise hat der Dom immer noch keine nassen Füße.

Hinweis auf die Faktenlage als olympisches Unterfangen

Ein Hinweis auf die Faktenlage ist in diesen Angelegenheiten nur noch von begrenzter Wirkung, der Versuch ist aber olympisch. Oder mit Albert Camus gesprochen: „Wir müssen uns Sisyphos als einen glücklichen Menschen vorstellen, der Kampf gegen Gipfel vermag ein Menschenherz auszufüllen.“

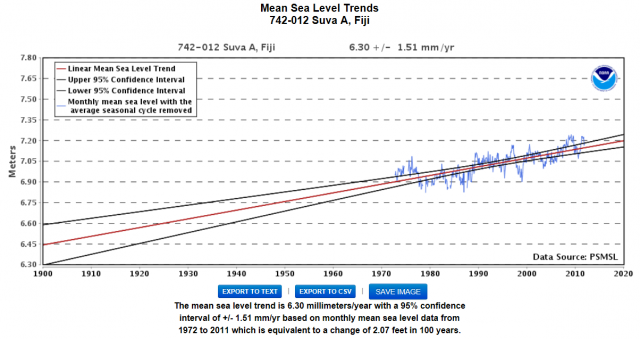

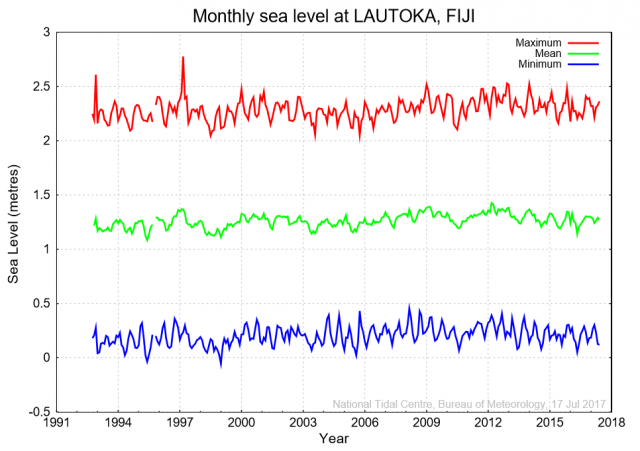

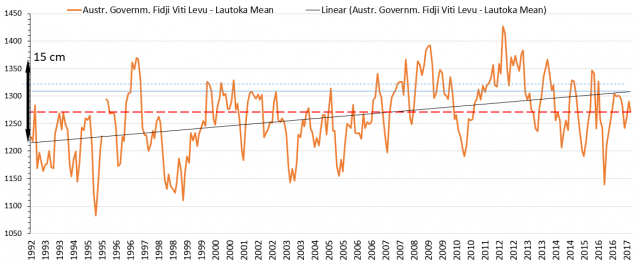

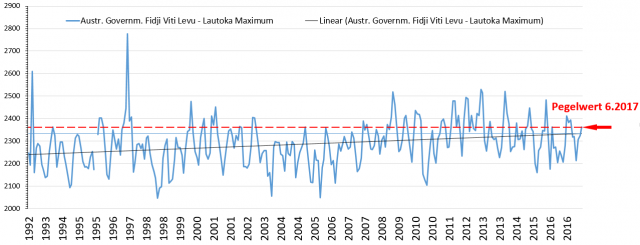

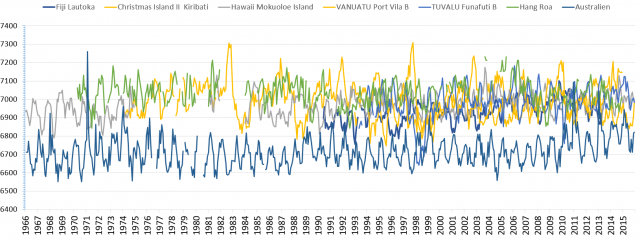

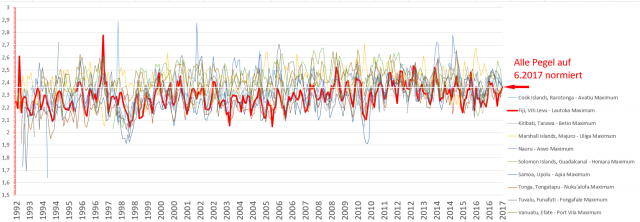

„Es gibt neue Nachrichten von den untergehenden Inseln: Sie gehen nicht unter“, schrieb Achse-Autor Ulli Kulke schon 2014 hier. Von einem generellen dramatischen Anstieg des Meeresspiegels in der Südsee kann keine Rede sein. Viele Inseln wachsen sogar. Des Rätsels Lösung ist nach Angaben von Forschern das Material, aus dem die Inseln bestehen. Viele setzten sich aus Korallentrümmern zusammen, die von den umliegenden Riffen angespült werden. Weil die Korallen lebende Organismen sind, wird immer neues Material produziert. Atolle bestehen aus einst lebendem Material, deshalb wachsen sie beständig.

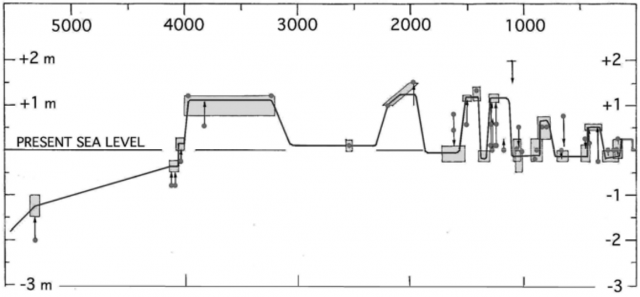

Die Malediven wuchsen vor 5.000 Jahren auf einem untergetauchten Korallenriff bis über die Wasseroberfläche. Seitdem ist der Meeresspiegel bereits um zweieinhalb Meter gestiegen, ohne dass die Inseln verschwunden wären. Sie wachsen einfach mit. Zwar gibt es an manchen Inseln an den Küsten durchaus Schäden, Erosion sowie die Versalzung von Trinkwasser-Reservoiren.

Dies ist aber menschlichen Eingriffen geschuldet. Etwa der Entnahme von Sand für den Hausbau (oder für den von Touristen-Ressorts), unbedachter Straßenbau oder auch der Vernachlässigung von Deichen und anderen Schutzbauten. Hinzu kommt das rasche Bevölkerungswachstum, das zahlreiche soziale Probleme erzeugt. Auch auf Fidschi wurden über Generationen hinweg Mangrovenwälder an der Küste abgeholzt – um damit zu heizen, zu kochen, zu bauen. Vielerorts löst sich der Sandboden jetzt auf wie Strickzeug, aus dem jemand die Nadeln gerissen hat. Nichts mehr hält das Wasser auf.

Ein anderer Klassiker der Weltuntergangsliteratur, der dieser Tage wieder aus der Gruft aufsteigt, lautet: „Luft so verpestet wie seit 800.000 Jahren nicht mehr“. Das war schon vor fast zehn Jahren eine Top News „C02-Konzentration auf Höchststand seit 800.000 Jahren“, macht sich aber immer wieder gut als letzter Alarmisten-Schrei. Die Aussage „Luft so verpestet wie seit 800 000 Jahren nicht mehr“ deutet im übrigen tatsächlich auf einen Notstand hin: In deutschen Schulen fallen offenbar zu viele Biologiestunden aus.

Ohne Kohlendioxid nix Möhre und schon gar nix Banane

Kohlendioxid verpestet mitnichten die Luft (und hat auch nichts mit Smog zu tun), sondern ist ein natürlicher Bestandteil derselben. Simpel erklärt wandeln Pflanzen mit Hilfe der Photosynthese und der Nutzung des Sonnenlichts energiearme Stoffe, in diesem Fall Kohlenstoff und Wasser, in energiereiche Stoffe um. Für fast alle Lebensformen dieses Planeten ist Kohlendioxid unentbehrlich. Auch dieser Umstand sei hier noch einmal in einfacher Sprache formuliert, besonders für Veganer und Vegetarier: Ohne Kohlendioxid nix Möhre und schon gar nix Banane (die kommt ja mit dem Schiff).

„Künftige Generationen erben einen deutlich unwirtlicheren Planeten“, sagt WMO-Generalsekretär Petteri Taalas. Da drängt sich natürlich auch die Frage auf, wie die Menschheit, die ja immerhin mindestens zwei Millionen Jahre auf dem Buckel hat (die gesamte Entwicklungsgeschichte des Hominiden umfasst sogar 15 Millionen Jahre), die Zeit vor 800.000 Jahren ohne UN-Klimasekretariat überleben konnte.

Sie hat wärmere und kältere Zeiten, Zeiten mit mehr und weniger Kohlendioxid in der Luft als heute weggesteckt. Besonders übel waren übrigens die Kaltzeiten. Genetische Analysen legen nach Ansicht von Molekularbiologen nahe, dass die Zahl unserer frühen Vorfahren während der letzten Eiszeit des Pleistozän um 90 Prozent auf nur etwa 10.000 Urmenschen zurückgegangen sein könnte (vor etwa 100.000 Jahren). Ja wie hätten sie es denn gerne bei der WMO? Die Aussage „Unsere Zeit ist nun die wärmste in der Geschichte der modernen Zivilisation“, sagt für sich genommen zunächst mal gar nichts. Derzeit leben auf dem Planeten gut 7,5 Milliarden Erdenbewohner, seit 1900 – also dem Beginn der Industrialisierung – sind 6 Milliarden hinzugekommen. So lebensfeindlich scheint unsere Klima-Epoche also nicht zu sein. Den Klimarettern, die mitunter ja sogar Babies als Klimaschädlinge besteuern wollen, wären bloße 10.000 Menschen natürlich lieber, vorausgesetzt es handelt sich dabei um die Klimagipfel-Delegierten.

Die Lastwagenladungen voll wissenschaftlicher Klima-Studien, die den verängstigten Bürger unter sich begraben, sind mittlerweile vollkommen selbstreferenziell. Annahmen türmen sich auf Annahmen, Schätzungen auf Schätzungen, Hochrechnungen auf Hochrechnungen. Nur im zentralen entscheidenden Punkt, auf dem das ganze provisorische Gebäude aufbaut, ist man nicht viel weiter gekommen. Und deshalb spricht auch keiner darüber: Die Rede ist von der sogenannten „Klimaempfindlichkeit“. Sie ist die Schlüsselgröße der gegenwärtigen Treibhaus-Hypothese – und über deren Größenordnung wird nach wie vor heftig gestritten.

Wir lassen uns unsere Klimakatastrophe nicht kaputt machen

Sie gibt an, um wie viel sich die Luft erwärmt, wenn man ihren Kohlendioxidgehalt verdoppelt. Der Wert ergibt sich nun aber nicht aus der Treibhauswirkung des Kohlendioxids allein – die ist nämlich relativ gering. Vielmehr vermutet man eine „positive Rückkopplung“ mit dem Wasserdampf, der mit mindestens zwei Dritteln Anteil das weitaus wichtigste Treibhausgas ist. Die Reaktionskette muss man sich in etwa so vorstellen: Mehr Kohlendioxid führt zu höheren Temperaturen, die wiederum mehr Wasser verdunsten lassen, was die Luft noch weiter erwärmt. Doch um wie viel?

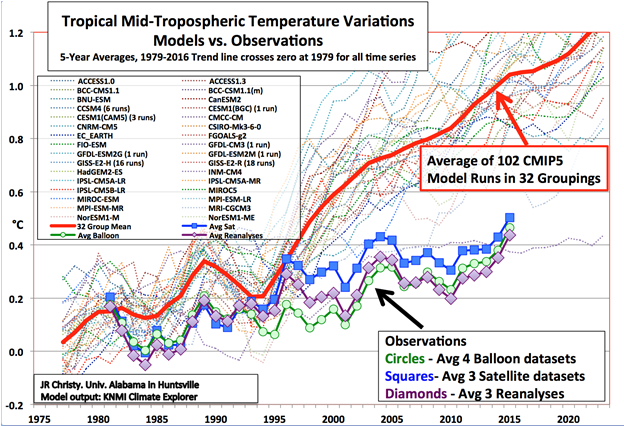

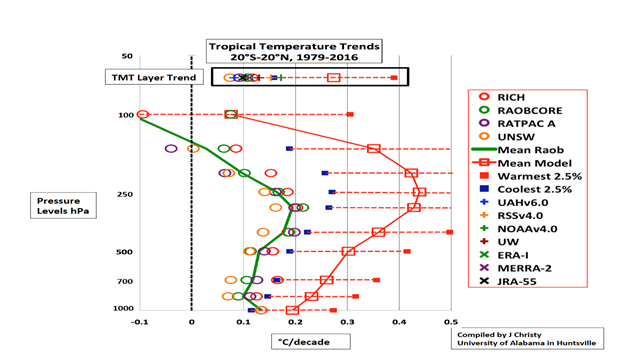

Wie erwähnt, liegen die Schätzungen der Klimasensitivität seit beinahe 30 Jahren im Bereich zwischen 1,5 und 4,5 Grad. Der „Erfinder“ der Treibhausthese, Svante Arrhenius, schätzte sie Anfang des 20. Jahrhunderts auf 5 bis 6 Grad Celsius, war also gar nicht so weit vom heutigen oberen Schätzwert entfernt. Die tatsächliche Temperatur-Entwicklung deutet jedoch auf einen Wert hin, der am unteren Ende der Skala, also bei undramatischen 1 bis 1,5 Grad liegt. Die Schätzungen werden mit jeder neuen Studie immer geringer.

Auf Nature-Geoscience, einem Fachmagazin, erschien Mitte September eine Studie, in der die Horror-Szenarien des IPCC von der angeblichen, durch menschliches Zutun zu erwartenden, globalen Erwärmung von bis zu fünf Grad in diesem Jahrhundert zurückgenommen werden mussten. „Wir haben die schnelle Erwärmung nach dem Jahr 2000, die wir in den Modellen sehen, in der Realität nicht beobachten können“, sagte Mitautor Myles Allen von der University of Oxford.

Dahinter stecken nicht etwa sogenannte Klimaskeptiker. sondern Wissenschaftler, die sich maßgeblich beim Weltklimarat engagieren. Ihr Fazit in einfacher Sprache: Sorry, wir haben uns verrechnet, unsere Klima-Simulationen waren fehlerhaft. Die Menschheit darf – theoretisch – noch viermal mehr CO2 ausstoßen, als bisher geschehen und berechnet, bevor sich die Steigerung der Erdtemperatur (vermutlich) der 1,5 Grad Marke nähert. Keine Rede mehr von fünf Grad und einem unglaublichen Meeresanstieg.

Ihre Erkenntnisse haben sie so gut versteckt wie eine Elster die geklaute Perlenkette. Die Studie heißt: „Emissionsbudget und Emissionspfad vereinbar mit dem Ziel, die Erwärmung auf 1,5 Grad zu begrenzen“. Dennoch sind die Kassandras vom Potsdamer Institut für Klimafolgenforschung schon ganz aufgebracht. Die wollen sich auf keinen Fall ihre Klima-Katastrophe kaputt machen lassen. Vielleicht sollte Barbara Hendricks sie zum Tauchkurs mitnehmen, damit die Jungs ein bisschen entspannter werden.

Übernommen von ACHGUT hier