IPCC-Ziele und -Verfahren verlangten Eliminierung, Reduktion und Manipulation ungeeigneter Daten sowie die Erzeugung falscher Daten

Die folgende Aussage aus dem 4. Zustandsbericht ist völlig unhaltbar angesichts der Ergebnisse der Projektion:

Es gibt beträchtliches Vertrauen [considerable confidence], dass Klimamodelle glaubwürdige quantitative Schätzungen des zukünftigen Klimawandels liefern, besonders im Maßstab von Kontinenten und darüber. Dieses Vertrauen ergibt sich aus der Grundlage der Modelle, also aus anerkannten physikalischen Prinzipien und aus deren Fähigkeit, beobachtete Vorgänge des gegenwärtigen Klimas und Klimaänderungen der Vergangenheit zu reproduzieren. Das Vertrauen in die Modellschätzungen ist für manche Klimavariablen (z. B. Temperatur) höher als bei anderen (z. B. Niederschlag). Über viele Jahrzehnte der Entwicklung hinweg haben die Modelle konsistent ein robustes und eindeutiges Bild einer signifikanten Klimaerwärmung als Folge von zunehmenden Treibhausgasen gezeigt.

Dies ist genau so, als ob man sagt, dass eine Seifenkiste eine gute Approximation eines Rolls Royce oder eines Ferrari ist. Als Beweis führen sie an, dass die Seifenkiste anscheinend einige Spuren-Charakteristika hat und der Straße in der gleichen Richtung folgt – falls sie sich auf einem Hügel befindet.

Selbst ein einfaches Systemdiagramm der Atmosphäre (Abbildung 2) ist tausend mal komplizierter als die gezeigten Grundmaterialien für die Seifenkiste.

In der Liste der Variablen in diesem Diagramm sowie der vielen fehlenden Variablen stecken keine bedeutsamen Daten. Mit bedeutsam meine ich, dass falls es sie gibt, sie unzureichend sind hinsichtlich Länge, Abdeckung oder Genauigkeit. Sie sind unzureichend als Grundlage eines Computermodells, und die Modellergebnisse sind vollkommen unrepräsentativ bzgl. der Realität und gänzlich ungeeignet als Grundlage für jedwede Politik. Der Beweis für diese Behauptung ist im Scheitern der Validierung der Modelle zu finden, außer wenn man Variablen hinzufügt oder adjustiert dergestalt, dass sie zu den Modellbedingungen passen. Das Scheitern dieser Taschenspielertricks liegt in den gescheiterten Projektionen. Die einzige Lehre, die sie daraus ziehen, ist die Notwendigkeit, sich total auf die Datensammlung zu konzentrieren, weil die Klimawissenschaft schon jetzt der Warnung von Sherlock Holmes genügt:

„Es ist ein kapitaler Fehler zu theoretisieren, bevor man Daten hat. Unmerklich beginnt man dann, Fakten zu verdrehen, damit sie zu den Theorien passen, anstatt die Theorien nach den Fakten auszurichten“.

Ich habe schon oft über das Datenproblem geschrieben, aber es ist von so grundlegender Bedeutung, dass eine fortwährende Wiederholung desselben erforderlich ist. Es scheint, als ob die Trump-Regierung dafür sorgt, dass die Verdrehung von Tatsachen, bis sie zur Theorie passen, gestoppt wird. Sie könnte beschließen, weitere Förderungen der Klimawandelforschung einzustellen mit der Rechtfertigung, dass die Förderungen bis jetzt missbraucht worden sind. Falls sie jedoch auf diesem Weg voranschreitet, wird jedes Weiterkommen wegen fehlender Daten fehlschlagen.

Hubert Lamb, der möglicherweise mehr Klimadaten zusammengetragen hat als irgendjemand vor oder nach ihm, erklärte in seiner Autobiographie (1997), dass er die Climate Research Unit gegründet hatte, weil:

„…klar war, dass es die erste und größte Notwendigkeit war, die Fakten auf der Grundlage der Aufzeichnungen des natürlichen Klimas der Vergangenheit zu etablieren, bevor irgendwelche Nebeneffekte menschlicher Aktivitäten bedeutsam geworden sind“.

In unserer persönlichen Kommunikation beschrieb er die Probleme, welche das Fehlen von Daten hervorrufen würde, und bedauerte, dass genau das an der CRU der Fall war. Er schrieb:

„Mein direkter Nachfolger, Prof. Tom Wigley, war hauptsächlich interessiert an den Perspektiven des Weltklimas, das sich als Folge menschlicher Aktivitäten ändert, hauptsächlich durch das Verbrennen von Holz, Kohle, Öl und Erdgas… Nach nur wenigen Jahren war praktisch die gesamte Arbeit an der historischen Rekonstruktion von Klima und Wetterlagen der Vergangenheit, welche die Unit weithin bekannt gemacht hatte, aufgegeben worden“.

Wigley war der Urvater des IPCC, die zentrale Institution, der Fels inmitten der zentralen Gestalten während des Debakels, zu dem die CRU wurde, nachdem sie den 3. Zustandsbericht entworfen und kontrolliert hatte. Man lese die veröffentlichten Klimagate-E-Mails und beachte, wie oft sie seine Ausführungen zur Lösung von Streitfragen herangezogen hatten. Es ist eine surreale Erfahrung, weil seine Kommentare ausnahmslos in Warnungen bestanden vor Dingen, die ihre AGW-Objektive bedrohen könnten. Es ging ihm nie darum, nach Wahrheit zu trachten.

Viele Kommentatoren beschreiben sehr markant einige unverrückbare Tatsachen hinsichtlich Daten und Statistiken:

„Falls man die Daten nur ausreichend frisiert, wird die Natur immer mitspielen“ – Ronald Coase.

„Fakten sind stur, aber Statistiken sind formbarer“. – Anonym

„Wir alle sind gewaltigen Mengen von Rohmaterial ausgesetzt, welche Daten, Gedanken und Schlussfolgerungen enthalten – vieles davon falsch oder missverstanden oder einfach nur durcheinander. Es besteht eine schreiende Notwendigkeit für intelligentere Kommentare und Begutachtungen“. – Murray Gell-Mann

„Wissenschaft ist ein Gebäude aus Fakten, so wie ein Haus aus Ziegelsteinen gebaut ist; aber eine Ansammlung von Fakten ist nicht mehr Wissenschaft als ein Stapel von Ziegelsteinen schon ein Haus ist“. – Henri Poincare.

Ich habe zu fehlenden Daten schon oft auf dieser Website und anderswo Stellung genommen:

https://wattsupwiththat.com/2014/03/21/ipcc-scientists-knew-data-and-science-inadequacies-contradicted-certainties-presented-to-media-public-and-politicians-but-remained-silent/

https://wattsupwiththat.com/2015/09/27/approximately-92-or-99-of-ushcn-surface-temperature-data-consists-of-estimated-values/

https://wattsupwiththat.com/2013/10/22/lack-of-data-for-all-phases-of-water-guarantees-failed-ipcc-projections/

https://wattsupwiththat.com/2013/10/02/ipcc-climate-a-product-of-lies-damn-lies-and-statistics-built-on-inadequate-data/

https://wattsupwiththat.com/2016/04/24/particulates-aerosols-and-climate-the-more-important-story/

https://wattsupwiththat.com/2015/11/04/more-ipcc-inadequacies-and-failures-precipitation/

In einem der Artikel wies ich darauf hin, dass das IPCC und zentrale Figuren des AGW-Betrugs genau wussten, dass es keine Daten gibt.

Im Jahre 1993 ist Stephen Schneider, eine an vorderster Stelle stehende Figur der AGW-Hypothese und dem Gebrauch von Modellen verschrieben, über die Zweifel an der Sicherheit hinausgegangen, als er sagte:

Unsicherheit bzgl. bedeutender Rückkopplungs-Mechanismen ist ein Grund, warum das ultimative Ziel der Modellierung des Klimas – also die zuverlässige Vorhersage der Zukunft von Schlüsselvariablen wie Temperatur und Niederschlagsverteilung – nicht realisierbar ist“.

Am 3. Februar 1999 hieß es in einem Report des US National Research Council:

Defizite hinsichtlich Genauigkeit, Qualität und Kontinuität der Aufzeichnungen stellen ernste Begrenzungen des Vertrauens dar, das man den Forschungsergebnissen entgegen bringen kann.

Kevin Trenberth erwiderte darauf:

Es ist sehr eindeutig – wir haben kein Klimabeobachtungs-System … Dies könnte für viele Menschen als Schock kommen, die annehmen, dass wir adäquat darüber Bescheid wissen, was mit dem Klima los ist; aber das ist nicht der Fall!“

Zwei CRU-Direktoren, Tom Wigley und Phil Jones sagten:

Viele Unsicherheiten rund um die Gründe des Klimawandels werden niemals erkannt werden, weil es an den notwendigen Daten fehlt“.

Sie haben diese Tatsache nicht verschleiert, weil diese es ihnen erlaubte, die Daten, die sie als Beweis für ihre Hypothese brauchten, zu fabrizieren und die Modelle dann als repräsentativ für die reale Welt auszugeben. Sie wussten auch, dass die Öffentlichkeit wie in den meisten Bereichen der Klimawissenschaft nicht wusste, dass die Datenlage völlig unzureichend war [und die, die es wissen, dürfen das bis auf den heutigen Tag nicht laut sagen, wenn sie keine Schwierigkeiten bekommen wollen. O heilige Welt der Wissenschaft! Anm. d. Übers.]

Auslöser zum Schreiben dieses Artikels war der Vortrag eines mächtigen Vertreters der AGW-Hypothese, der von ,synthetischen‘ Daten so sprach, als seien es reale Daten. Die meisten Menschen wissen einfach nicht, dass die meisten Daten synthetischer Natur sind. Um dem Mangel von Daten für globale Klimamodelle zu begegnen, ist es allgemein üblich, synthetische Daten mit einem Modell zu erzeugen, die dann als ,reale‘ Daten in ein anderes Modell eingehen. Da es praktisch keine Daten für irgendeine aus der Vielfalt der Variablen gibt, die in Kombination Wetter und Klima bewirken, erzeugen sie eine virtuelle Realität.

Das IPCC hat Fortschritte im Bereich Klimawissenschaft seit seiner Gründung im Jahre 1990 eingefroren, indem man den Schwerpunkt absichtlich auf menschliche Gründe richtete. Dann widersprachen sie der wissenschaftlichen Methodik, als sie versuchten, die AGW-Hypothese zu beweisen anstatt sie zu widerlegen. Diese Maßnahmen führte zu einer ganzen Reihe von Dilemmata:

● Nationale Wetterbüros beriefen die IPCC-Mitglieder und kontrollierten die Finanzierung der Klimaforschung in ihren Ländern.

● Dieses Vorgehen führte dazu, dass es die politische oder wissenschaftliche Kontrolle umging. Skeptiker wurden eliminiert.

● Der größte Teil der Förderung floss in Theorien und Forschungen, welche die AGW-Hypothese ,bewiesen‘.

● In vielen Fällen wurde das für die Datensammlung gedachte Geld abgezogen, als sich der politische Schwerpunkt festigte. Hier folgen Kommentare von Ken Green aus einer Untersuchung dessen, was bei Environment Canada vor sich gegangen war:

Die Behauptung wissenschaftlicher Unehrlichkeit angemessen zu unterstützen war schwierig infolge der vertraulichen Natur eines großen Teils der internen Kommunikation der Regierungen und dem offensichtlichen Zögern von Beamten auszusagen. Allerdings wurden als Folge einer jüngst erhobenen Forderung nach Informationen [Access to Information request] wissenschaftliche Unehrlichkeit und „aufgebrezelte Schlussfolgerungen“ entdeckt in einem der größten Wissenschafts- und Technologie-Projekte Kanadas jemals – die Bemühung, Klimawandel und die Wissenschaft zu „managen“, welche vermeintlich die Kyoto-Bemühungen unterstützt. Dies wird enthüllt durch die folgende Analyse des anhängenden ,contract reports‘ des Consulting-Unternehmens „The Impact Group“ sowie in damit zusammenhängenden internen Kommunikationen zwischen dem Meteorological Service of Canada (MSC) von Environment Canada und anderen und dem „ADM Committee on Climate Change Science“.

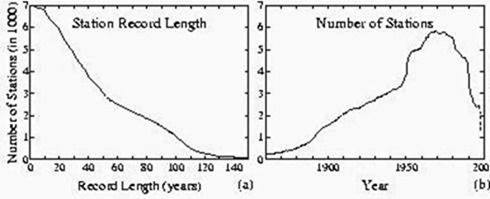

●Wetterstationen auf der ganzen Welt wurden stillgelegt, angeblich um sie durch Satellitendaten zu ersetzen. NASA GISS stellte diese Änderungen graphisch dar, in welchen sich zwei verschiedene Abnahmen während der sechziger und der neunziger Jahre zeigten:

● Das Problem ist sogar noch viel größer, weil Daten verloren gegangen sind, Aufzeichnungen beendet oder gestutzt worden sind, und weil Proxy-Rekonstruktionen pervertiert wurden, als deren Historie zugunsten einer politischen Agenda umgeschrieben wurde.

Ich hörte von den Kommentaren über synthetische Daten nach meinem Engagement in Australien mit Senator Malcolm Roberts und Tony Heller. Ich war nach Australien gereist, um Senator Roberts zu unterstützen bei seiner Anforderung empirischer Daten als Beweis für die AGW-Behauptungen seitens der Bürokraten beim Commonwealth Scientific and Industrial Research Organization (CSIRO), der Organisation also, die die Regierung bzgl. Klimawandel berät. Wir wollten tatsächliche Daten haben mit begleitenden Beweisen von Ursache und Wirkung, nicht Simulationen von Computermodellen. Sie reagierten mit einem Report, der nichts enthielt außer den mittels Computern erzeugten Behauptungen des IPCC. Aber das war keine Überraschung, weil sie ihnen Daten des IPCC-Mitglieds Australian Bureau of Meteorology übermittelt hatten.

Aber es geht nicht nur um empirische Daten und Beweise für AGW. Die Anzahl realer, direkt gemessener Daten zur Erstellung von Computermodellen sowie die Politik beeinflussender Beweise ist vollkommen unzureichend. Die synthetischen Daten, von der die Person sprach, wurden in einem Computermodell von einem Anteil des riesigen Systems Ozean-Atmosphäre erzeugt und dann als reale Daten in ein größeres Modell gesteckt.

Einer der größten absichtlichen Schwindel ist der Unterschied zwischen den Sicherheiten des IPCC, welche in der Summary for Policymakers (SPM) beschrieben werden, und der beängstigenden Liste von Unzulänglichkeiten im Physical Science Report der Arbeitsgruppe I. Die folgenden Zitate stammen direkt aus jenem Report, aber nur sehr wenige Menschen lesen diesen jemals. Grund hierfür ist, dass die SPM mit großem Tamtam schon Monate vor dem Erscheinen des Science-Reports veröffentlicht wird. Der Experten-Begutachter des IPCC David Wojick schrieb:

Eklatante Auslassungen sind nur für Experten eklatant. Darum werden die „Policymakers“ – einschließlich der Medien und der Öffentlichkeit – welche die SPM lesen, nicht bemerken, dass ihnen nur die eine Seite der Story aufgetischt wird. Aber die Wissenschaftler, die die SPM verfasst haben, kennen die Wahrheit natürlich, wie durch die manchmal kunstvolle Art und Weise enthüllt, mit der sie diese Wahrheit verheimlichen.

…

Was in den SPM systematisch ausgelassen wird, sind genau die Unsicherheiten und positiven Gegenbeweise, die der Theorie der menschlichen Interferenz entgegen stehen. Anstatt diese Objektionen zu bewerten, beschreiben die SPM vertrauensselig nur jene Ergebnisse, die den Fall stützen. Kurz gesagt, das ist Verfechten und nicht Einschätzung.

In der SPM zum 5. Zustandsbericht wird behauptet:

Anthropogene Treibhausgas-Emissionen haben seit der vorindustriellen Ära zugenommen, getrieben hauptsächlich durch ökonomisches Wachstum und Zunahme der Bevölkerung, und sie sind derzeit höher denn je. Dies hat zu atmosphärischen Konzentrationen von Kohlendioxid, Methan und Stickoxiden geführt, die beispiellos sind zumindest während der letzten 800.000 Jahre. Deren Auswirkungen wurden zusammen mit anderen anthropogenen Antrieben im gesamten Klimasystem entdeckt und waren extrem wahrscheinlich der dominante Grund der beobachteten Erwärmung seit Mitte des 20. Jahrhunderts.

Der Terminus „extrem wahrscheinlich“ ist 95% bis 100%. Man stelle diese Einschätzung in den Zusammenhang mit den folgenden Daten-Begrenzungen aus dem Science Report. Er beginnt mit der Anerkennung der ernsten Begrenzungen in einem allgemeinen Statement.

Unsicherheiten bei den gemessenen Aufzeichnungen

Die große Mehrheit historischer (und moderner) Wetterbeobachtungen wurde nicht explizit zum Zweck des Klima-Monitorings durchgeführt. Messungen haben sich ihrer Natur nach verändert, als sich Anforderungen an die Daten, Beobachtungsverfahren und Technologien entwickelt haben. Diese Änderungen ändern die Charakteristika von Mess-Aufzeichnungen fast immer, ändern deren Mittelwerte, deren Variabilität oder beides. Darum ist es notwendig, die Rohdaten zu bearbeiten, bevor sie als nützlich eingestuft werden können zur Einschätzung der wahren Klimaentwicklung. Dies gilt für sämtliche Messverfahren von physikalischen atmosphärischen Quantitäten. Die Unsicherheit in Messaufzeichnungen umfassen instrumentelle Fehler bzw. Fehler bei der Aufzeichnung, Auswirkungen auf die Repräsentanz (z. B. Position, Häufigkeit von Messungen oder deren Timing) ebenso wie Auswirkungen infolge physikalischer Änderungen bei der Instrumentierung (wie etwa Verlagerung von Stationen oder neue Satelliten). Alle weiteren Bearbeitungsschritte (Übermittlung, Speicherung, Interpolation, Mittelwertbildung) haben jeweils ihre eigenen speziellen Unsicherheiten. Weil es keinen einheitlichen, eindeutigen Weg gibt zur Identifizierung oder zur Berücksichtigung nicht klimabezogener Artefakte in der großen Mehrzahl der Aufzeichnungen, muss es einen Grad der Unsicherheit geben, wie sich das Klimasystem verändert hat. Die einzigen Ausnahmen sind bestimmte Messungen der atmosphärischen Zusammensetzung und der Flüsse, deren Messungen und Unsicherheiten rigoros miteinander verbunden sind mittels einer ununterbrochenen Kette international anerkannter absoluter Mess-Standards (z. B. die CO2-Aufzeichnungen am Mauna Loa; Keeling et al. 1976a).

Unsicherheiten bei der Erstellung von Datensätzen können entweder resultieren aus der Auswahl der Parameter innerhalb einer speziellen analytischen Struktur – parametrische Unsicherheit; oder aus der Auswahl einer analytischen Gesamtstruktur – strukturelle Unsicherheit. Strukturelle Unsicherheiten werden am besten abgeschätzt, wenn mehrere voneinander unabhängige Gruppen die gleichen Daten mit unterschiedlichen Verfahren bewerten. Mehr jetzt bewertete Analysen als im AR 4 enthalten u. A. veröffentlichte Schätzungen parametrischer oder struktureller Unsicherheiten. Es ist wichtig anzumerken, dass es in der Literatur eine sehr große Bandbreite von Verfahren gibt. Große Sorgfalt hatte man walten lassen beim Vergleich der veröffentlichten Unsicherheits-Bandbreiten, weil sie fast niemals einen Punkt-für-Punkt-Vergleich enthalten [as they almost always do not constitute a like- for-like comparison]. Im Allgemeinen zeigen Studien, die multiplen potentiellen Fehlerquellen in rigoroser Weise Rechnung tragen, größere Unsicherheits-Bandbreiten. Dies führt zu einem offensichtlichen Paradoxon in der Interpretation, weil man denken könnte, dass geringere Unsicherheits-Bandbreiten ein besseres Produkt vorgaukeln. Allerdings wäre dies in vielen Fällen eine falsche Herangehensweise, weil die geringere Unsicherheits-Bandbreite stattdessen reflektieren könnte, dass die veröffentlichte Abschätzung nur einen Teil der plausiblen Unsicherheitsquellen berücksichtigt hat. Innerhalb der Zahlen einer Zeitreihe, bei denen dieses Problem am akutesten ist, sind derartige parametrische Abschätzungen daher nicht allgemein enthalten.

Fazit: die große Mehrheit der Rohmessungen, die zum Monitoring des Klima-Zustandes herangezogen werden, enthält Residuen nicht-klimatischer Einflüsse. Die Entfernung dieser Einflüsse kann nicht definitiv vorgenommen werden, ebensowenig wie die Unsicherheiten nicht eindeutig abgeschätzt werden können. Daher ist Sorgfalt erforderlich sowohl bei der Interpretation der Daten-Erzeugnisse und deren festgestellter Unsicherheits-Abschätzungen. Vertrauen kann entstehen aus: Redundanz bei Bemühungen zur Erzeugung der Produkte; Datensatz-Eigenschaften [data set heritage] und Quervergleiche von Variablen, von denen man erwartet, dass sie aus physikalischen Gründen gleichlaufend variieren, wie etwa LSATs [?] und Wassertemperatur an Küsten. Und schließlich werden Trends oftmals als eine Möglichkeit herangezogen, die Daten in eine einzige Zahl zu destillieren.

Warum steht dies nicht auf der ersten Seite der SPM?

Die folgenden Zitate stammen direkt aus dem AR 5 und wurden ausgewählt, weil darin die Datenprobleme eingeräumt werden. Der Bericht verwendet verschiedene Termini, welche ihre Einschätzung der Verfügbarkeit der Beweise anzeigen sollen, das heißt die Menge, das Ausmaß und die Qualität, während ein zweiter Terminus ihr Vertrauen in ihre Wissensgrundlage für Prophezeiungen andeutet. Ich habe ihre Einschätzungen fett und unterstrichen dargestellt sowie Prozentzahlen eingefügt, wo es angebracht war, und die unzulängliche, irreführende Analyse und Ausdrucksweise kommentiert.

In diesem Bericht wurden die folgenden zusammenfassenden Termini verwendet, um die verfügbaren Beweise zu beschreiben: begrenzt, mittel oder robust; und für den Grad an Übereinstimmung: niedrig, mittel und hoch. Ein Vertrauensniveau ist ausgedrückt mittels fünf Kriterien: sehr niedrig, niedrig, mittel, hoch und sehr hoch sowie durch Kursivdruck. Für einen bestimmten Beweis und ein Statement zu Übereinstimmung können unterschiedliche Vertrauensniveaus eingeschätzt werden, aber zunehmendes Vertrauensniveau und Grad an Übereinstimmung sind korreliert mit zunehmendem Vertrauen.

In diesem Bericht wurden die folgenden Termini verwendet, um die eingeschätzte Wahrscheinlichkeit eines Ergebnisses zu zeigen: Fast Sicherheit 99% bis 100% Wahrscheinlichkeit, sehr wahrscheinlich 90% bis 100%; wahrscheinlich 66% bis 100%; eher wahrscheinlich als unwahrscheinlich 33% bis 60%; unwahrscheinlich 0 bis 33%; sehr unwahrscheinlich 0 bis 10%; außerordentlich unwahrscheinlich 0 bis 1%. Zusätzliche Termini (Extrem wahrscheinlich: 95% bis 100%; eher wahrscheinlich als unwahrscheinlich >50% bis 100% und extrem unwahrscheinlich 0 bis 5%) können auch verwendet werden, wo es angebracht ist. Die abgeschätzte Wahrscheinlichkeit ist kursiv.

Wegen der großen Variabilität und relativ kurzen Perioden mit Datenaufzeichnungen ist das Vertrauen in Trends des stratosphärischen Wasserdampfes niedrig. (Dies ist wichtig, weil sichtbar werdende Eiskristalle in Gestalt von Leuchtenden Nachtwolken und Polar Stratospheric Clouds vor allem in Ozonschichten bedeutsam sind, was wahrscheinlich die Ursache für ihre Probleme beim nächsten Punkt ist).

Vertrauen ist mittel in die großräumige Zunahme troposphärischen Ozons auf der Nordhemisphäre seit den siebziger Jahren.

Vertrauen ist niedrig in Ozonänderungen auf der Südhemisphäre infolge begrenzter Messungen. Die Öffentlichkeit glaubt, dass wir in vollem Umfang bzgl. Ozon Bescheid wissen und dass das Montreal-Protokoll allen diesbezüglichen Bereichen Rechnung getragen hat.

Satellitenaufzeichnungen von Strahlenflüssen an der Obergrenze der Atmosphäre sind seit dem AR 4 substantiell ausgeweitet worden, und es ist unwahrscheinlich (0 bis 33%), dass es signifikante Trends gibt im globalen und tropischen Strahlungshaushalt seit dem Jahr 2000.

Die die Erdoberfläche erreichende Solarstrahlung durchlief wahrscheinlich (66% bis 100%) verbreitete dekadische Änderungen nach dem Jahr 1950, mit Abnahme (dimming) bis zu den achtziger Jahren und nachfolgender Zunahme (brightening), welche an vielen Stellen auf dem Festland gemessen worden ist. Es gibt mittleres Vertrauen in eine zunehmende abwärts gerichtete thermische und Gesamt-Strahlung an landbasierten Beobachtungsstellen seit Anfang der neunziger Jahre.

Während die Trends der Wolkenbedeckung in bestimmten Gebieten konsistent in unabhängig voneinander bestehenden Datensätzen sind, verbleibt eine substantielle Vieldeutigkeit und daher geringes Vertrauen in Beobachtungen der Wolkenvariabilität bzw. deren Trends im globalen Maßstab.

Es ist wahrscheinlich (66% bis 100%), dass seit etwa 1950 die Anzahl von Starkregenereignissen auf dem Festland in mehr Gebieten zu- als abgenommen hat. (Eine völlig bedeutungslose Bemerkung).

Das Vertrauen in einen beobachteten Trend hinsichtlich Dürre oder Trockenheit im globalen Maßstab ist seit Mitte des 20. Jahrhunderts niedrig, was dem Fehlen direkter Beobachtungen, methodischer Unsicherheiten und geographischen Inkonsistenzen in den Trends geschuldet ist. (Die Niederschlagsdaten sind in jeder Hinsicht weit stärker begrenzt als Temperaturdaten, und sie sind völlig unzulänglich. Aber trotzdem wird der Öffentlichkeit weisgemacht, dass die Wahrscheinlichkeit von Dürren infolge AGW signifikant zugenommen hat).

Das Vertrauen für langfristige Änderungen (nach Jahrhunderten) der Aktivität tropischer Zyklone bleibt niedrig nach den Veränderungen der Beobachtungs-Kapazitäten in der Vergangenheit. (Heißt dies, dass es nutzlos ist, bevor man diesen Änderungen der Vergangenheit Rechnung trägt?).

Das Vertrauen in großräumige Trends von Stürmen oder Proxys hierzu während des vorigen Jahrhunderts ist niedrig wegen der Inkonsistenzen zwischen Studien oder fehlenden langzeitlichen Daten in einigen Regionen der Welt (vor allem der Südhalbkugel). (Es ist nicht nur die Südhalbkugel, obwohl schon diese den halben Planeten ausmacht).

Infolge unzureichender Studien und Belangen der Datenqualität ist das Vertrauen auch niedrig in Trends kleinräumiger schwerer Wetterereignisse wie etwa Hagel oder Gewitter. (Die hier gemeinten Stürme sind ein grundlegender Mechanismus für den Transfer von Treibhausgasen und latenter Wärme in der gesamten Atmosphäre).

Es ist wahrscheinlich (66% bis 100%), dass sich Zirkulationsmuster seit den siebziger Jahren polwärts verschoben haben, was eine Ausweitung des tropischen Gürtels involviert, eine polwärts gerichtete Zugbahn von Stürmen und Jet Streams sowie eine Konzentration der nördlichen Polarwirbels. (Es liegt vermutlich am unteren Ende von „wahrscheinlich“, weil es viel zu wenig Messpunkte gibt, um die Ausdehnung zu belegen).

Große Variabilität von Jahr zu Jahr sowie im Zeitmaßstab von Jahrzehnten behindert robuste Erkenntnisse hinsichtlich langzeitlicher Änderungen der atmosphärischen Zirkulation in vielfacher Hinsicht. (Was heißt hier „robust“? In der Atmosphäre, bei Wetter und Klima ist alles Zirkulation! Diese Bemerkung ist so grob und vage, dass der Schluss nahe liegt, sie wissen nicht, was los ist).

Das Vertrauen in die Existenz langfristiger Änderungen der übrigen Aspekte der globalen Zirkulation ist niedrig infolge Grenzen von Beobachtungen und Verständnis. (Dies passt zu obiger Erkenntnis, dass sie nicht wissen, was eigentlich los ist).

Unsicherheiten in Datensätzen des Wärmeflusses Luft ↔ Ozean sind zu groß (wie groß ist zu groß?), um eine Änderung des globalen mittleren Wärmeflusses zwischen Ozean und Atmosphäre zu erkennen mit einer Größenordnung von 0,5 W/m² seit 1971, was erforderlich ist, um direkt Trends zu identifizieren in der regionalen oder globalen Verteilung von Verdunstung oder Niederschlag über den Ozeanen im Zeitmaßstab der beobachteten Änderungen des Salzgehaltes seit 1950. (Dies sind massive Maschinen des Transfers latenter Wärme und sind allein schon ausreichend, um zu sagen, dass jedwede Aussagen zu ihrer Wirkungsweise bedeutungslos sind).

Wind-Trends im Maßstab von Ozeanbecken und im Zeitmaßstab von Jahrzehnten bis Jahrhunderten wurden beobachtet im Nordatlantik, dem Tropischen Pazifik und dem Südlichen Ozean mit niedrigem bis mittlerem Vertrauen. (Wind ist eine fast vergessene Variable und mit der geringsten Anzahl von Daten behaftet, aber dennoch unabdingbar für genaue Messungen von Verdunstung und Energie-Transfer).

Beobachtete Änderungen der Eigenschaften von Wassermassen reflektieren wahrscheinlich (66% bis 100%) die kombinierte Auswirkung langzeitlicher Trends des Oberflächen-Antriebs (z. B. Erwärmung der Ozean-Wasseroberfläche und Änderungen bei E – P) sowie die Variabilität von Jahren und Jahrzehnten in Bezug auf Klimazustände. (Eigenschaften von Wassermassen bestimmen den Meeresspiegel. Darum macht diese Bemerkung Behauptungen über einen Anstieg des Meeresspiegels infolge AGW zum Gespött).

Es ist wahrscheinlich (66% bis 100%), dass sich die jährliche Periode des Schmelzens von mehrjährigem arktischen Eis um 5,7 ± 0,9 Tage pro Jahrzehnt im Zeitraum von 1979 bis 2012 verlängert hat. (Die Daten bzgl. des Meereises waren bis 1981 völlig unzuverlässig, und eine Datensammlung über nur 30 Jahre ist absolut unzureichend für jedwede klimarelevante Variable trotz des von der WMO festgelegten Zeitraumes von 30 Jahren als Normalperiode).

Nach fast einem Jahrzehnt stabiler CH4-Konzentrationen seit Ende der neunziger Jahre haben atmosphärische Messungen einen erneuten Anstieg der CH4-Konzentrationen seit dem Jahr 2007 gezeigt. Die Auslöser dieser erneuten Zunahme sind immer noch Gegenstand von Diskussionen. (Offenbar nicht. Die Medien stecken voller Stories über die zunehmende Bedrohung durch Methan aus menschlichen Quellen).

Viele der von den Klimamodellen in wärmeren Klimaten simulierten Änderungen von Bewölkung und Feuchtigkeit werden jetzt als Folge von langfristigen Zirkulationsänderungen angesehen, die nicht stark von Modellprozessen im Meso-Maßstab abhängig zu sein scheinen, was das Vertrauen in diese Änderungen zunehmen lässt. (Aber gerade eben haben sie uns gesagt, dass sie großräumige Zirkulationsänderungen nicht verstehen). Zum Beispiel zeigen mehrere Beweislinien Beiträge durch positive Rückkopplung aus zirkulations-getriebenen Änderungen sowohl der Höhe von hohen Wolken und breitenkreis-abhängige Verteilung von Wolken (mittleres bis hohes Vertrauen). Einige Aspekte der Reaktion der Bewölkung insgesamt variieren jedoch substantiell von Modell zu Modell, und diese scheinen stark abhängig von mesoskaligen Prozessen, in welche es geringeres Vertrauen gibt. (Wie viel weniger? Tatsächlich wissen sie es nicht).

Klimarelevante Aerosol-Prozesse sind besser verstanden, und klimabezogene Aerosol-Eigenschaften werden besser beobachtet als zur Zeit des AR4 (Aber damals waren sie nicht gut verstanden oder gemessen, weshalb dies ein relatives und bedeutungsloses Statement ist). Die Repräsentanz relevanter Prozesse variiert jedoch erheblich in globalen Aerosol- und Klimamodellen, und es bleibt unklar, welches Niveau der Güte [sophistication] erforderlich ist, um deren Auswirkung auf das Klima zu modellieren. Global sind zwischen 20% und 40% der optischen Dichte von Aerosolen (mittleres Vertrauen) und zwischen einem Viertel und zwei Drittel der Konzentration von Wolken-Kondensationskernen (niedriges Vertrauen) anthropogenen Ursprungs. (Dies ist gleichbedeutend der Aussage, dass man bei einer 20/20-Vision 20% aller Dinge über 20% der Zeit sieht. Dazu auch das nächste Zitat).

Die Quantifizierung von Wolken und konvektiver Vorgänge in den Modellen sowie die von Wechselwirkungen zwischen Aerosolen und Wolken bleibt eine Herausforderung. Klimamodelle enthalten inzwischen mehr relevante Prozesse als zu Zeiten des AR 4, aber das Vertrauen in die Repräsentanz dieser Prozesse bleibt schwach. (Ein weiteres relatives Statement, welches bedeutungslos ist. Es ist, als ob man sagt, es war früher nutzlos, aber ich glaube, jetzt ist es etwas besser).

Rückkopplungen Aerosole ↔ Klima erfolgen hauptsächlich mittels Änderungen der Stärke der Quelle natürlicher Aerosole oder Änderungen der Effizienz von Senken bzgl. natürlicher und anthropogener Aerosole; eine gewisse Anzahl von Modellierungs-Studien haben den Rückkopplungs-Parameter als innerhalb ± 0,2 W/m² °C, mit niedrigem Vertrauen. (Was ist eine gewisse Anzahl? Wie viele Studien würden es bedeutsam machen?)

Modelle des Klimas und des Systems Erde beruhen auf physikalischen Prinzipien, und sie reproduzieren viele bedeutende Aspekte des gemessenen Klimas. (Viele, aber nicht alle Aspekte). Beide Aspekte (dies ist irreführend. Sie sprechen über ihre Aspekte und nicht über die des gemessenen Klimas) tragen zu unserem Vertrauen bei in die Eignung der Modelle für Erkennungs- und Zuordnungs-Studien (Kapitel 10) und für quantitative zukünftige Prophezeiungen und Projektionen (Kapitel 11 bis 14). Im Allgemeinen gibt es kein direktes Mittel, quantitative Messungen der Vergangenheit in sichere Statements über die Genauigkeit zukünftiger Klimaprojektionen zu übersetzen. (Das ist ein politisch vollkommen bedeutungsloses Statement. Sagen sie damit, dass das Verhalten in der Vergangenheit keine Messgröße oder kein Prädiktor ihres zukünftigen Verhaltens ist? Also machen wir bitte weiter, vorwärts zu stolpern und Milliarden Dollar zu verschwenden, wenn das gesamte Problem unlösbar ist, weil es keine Daten gibt).

Die projizierte Änderung der globalen mittleren Temperatur wird wahrscheinlich (66% bis 100%) innerhalb der Bandbreite zwischen 0,3°C und 0,7°C liegen (mittleres Vertrauen). (Heißt das, sie sind sich zu 60% sicher, dass sie zu 50% recht haben?)

Klimamodelle haben sich seit dem AR 4 weiterentwickelt und verbessert, und viele Modelle wurden zu Modellen des Systems Erde erweitert, indem die Repräsentanz biogeochemischer Zyklen einbezogen wurden, die für Klimawandel bedeutsam sind. (Sie haben sich seit dem AR 4 nicht verbessert!) Diese Modelle gestatten es, politisch relevante Berechnungen wie etwa CO2-Emissionen durchzuführen, die mit einem speziellen Ziel der Stabilisierung des Klimas kompatibel sind. (Sie gestatten keine „politisch relevanten Berechnungen“, und sie haben sich nicht verbessert, weil sie in jeder erzeugten Projektion versagt haben).

Die Fähigkeit von Klimamodellen, die Temperaturen zu simulieren, haben sich hinsichtlich vieler, jedoch nicht aller Aspekte verbessert relativ zu den in AR 4 eingesetzten Modellen. (Wie viele Modelle haben sich verbessert, und wie viele werden gebraucht, um bedeutsam zu sein? Dies bestätigt, was am vorhergehenden Statement nicht stimmt).

Die Simulation der großräumigen Verteilung von Niederschlag hat sich seit dem AR 4 etwas verbessert, obwohl sich die Modelle weiterhin bzgl. Niederschlag schlechter verhalten als bzgl. Temperatur. (Es gibt praktisch keine Verbesserung. Dies ist eine erhebliche Untertreibung).

Die Simulation von Wolken in Klimamodellen bleibt eine Herausforderung. Es gibt sehr hohes Vertrauen, dass Unsicherheiten bei den Wolkenprozessen einen großen Teil des Spreads der modellierten Klimasensitivität erklären (Ein klassisches Beispiel Orwell’scher Doppeldeutigkeit [double talk]. Sie sind sich sehr sicher, dass sie unsicher sind.

Modelle sind in der Lage, die allgemeinen Charakteristika von Zugbahnen von Stürmen und außertropischen Zyklonen abzubilden, und es gibt einige Beweise der Verbesserung seit dem AR 4. Verzerrungen bzgl. der Zugbahn von Stürmen im Nordatlantik haben etwas abgenommen, aber die Modelle erzeugen immer noch eine Zugbahn, die zu stark zonal ausgerichtet ist, und sie unterschätzen die Intensität der Zyklonen. (Ja was denn nun? Sind sie besser geworden oder nicht? Ich vermute eher nicht. Sonst hätten sie es nämlich gesagt).

Viele bedeutende Zustände der Klimavariabilität und Phänomene innerhalb von Jahreszeiten oder von Jahreszeit zu Jahreszeit werden von den Modellen reproduziert mit einigen belegten Verbesserungen seit dem AR 4. (jene bedeutungslose Relativ-Messung. Die Verbesserung von fast nichts ist immer noch fast nichts). Die Statistik des globalen Monsuns, der Nordatlantischen Oszillation, der ENSO, des Indischen Ozean-Dipols und der Quasi-zweijährigen Oszillation QBO werden von vielen Modellen gut simuliert, obwohl diese Einschätzung abgeschwächt wird durch den begrenzten Umfang der bislang veröffentlichten Analysen oder durch begrenzte Beobachtungen. (Noch ein Beispiel Orwell’scher Doppeldeutigkeit: Die Modelle haben sich verbessert, außer da, wo sie sich nicht verbessert haben).

AGW-Befürworter und IPCC-Mitglieder machen die Öffentlichkeit glauben, dass sie über eine riesige Menge Daten verfügen zur Stützung ihrer Analyse, und sie behaupten, dass sie sich zu 95% sicher sind, dass menschliches CO2 globale Erwärmung verursacht. Sie verkünden auch, dass 97% aller Wissenschaftler dieser Schlussfolgerung zustimmen. Sie tun das mittels spezieller Statements, unterlassen es aber, die Güte der Daten zu untersuchen oder zu sagen, wenn sie wissen, dass sie falsch sind.

Die meisten Menschen, vermutlich mindestens 97%, haben die SPM nie gelesen, einschließlich Wissenschaftler, Politiker und die Medien. Vermutlich 99% aller Menschen haben nie den Science Report gelesen. Wie viele Menschen würden ihre Ansicht ändern, falls ihnen die o. g. Informationen unterkommen? Vielleicht ist das zu viel. Vielleicht ist all das notwendig für die Erfahrung, dass jede jemals vom IPCC erzeugte Projektion falsch war.

Dieser kurze und auszugsweise Blick auf das, was das IPCC selbst sagt, bestätigt den Vorwurf des Prof. Em. Hal Lewis, den er in seinem Brief anlässlich seines Rückzugs aus der American Physical Society im Oktober 2010 erhoben hat:

„Der Betrug um die globale Erwärmung ist der größte und erfolgreichste pseudowissenschaftliche Betrug, den ich je in meinem langen Leben als Physiker erlebt habe“.

Es ist in der Tat ein pseudowissenschaftlicher Betrug, weil es keinerlei Daten als Grundlage für irgendeine ihrer Arbeiten gibt. Die auserwählten Wissenschaftler, deren Aufgabe es war, die Objektive des IPCC hochzuhalten, der zufolge ,wissenschaftlich‘ bewiesen werden soll, dass menschliches CO2 ursächlich für globale Erwärmung ist, mussten die unpassenden realen Daten modifizieren oder eliminieren sowie falsche Daten erzeugen. Selbst wenn unter dem neuen Regime der Betrug bloßgestellt wird und ordentliche Wissenschaft und wissenschaftliche Verfahren wiederhergestellt werden, wird es sehr lange dauern, bis man die minimale Anzahl der erforderlichen Daten beisammen hat. Bis dahin ist alles nichts als eine Handbewegung. Allerdings gibt es genügend Beweise als Beleg, dass das Vorsorgeprinzip hier nicht anwendbar ist. Diese Beweise legen nahe, dass es sicherer ist, wenn wir gar nichts tun..

Link: https://wattsupwiththat.com/2017/01/29/ipcc-objectives-and-methods-mandated-elimination-reduction-manipulation-of-inadequate-real-data-and-creation-of-false-data/

Übersetzt von Chris Frey EIKE