24. Januar 2017 – Der Tag, an dem Merkels Energiewende auf der Kippe stand

Dieser Zustand kann ohne weiteres mehrere Tage anhalten. Während dieser Zeit muss die gesamte notwendige Erzeugungsleistung, die im Winter mindestens 80.000 Megawatt beträgt, von den konventionellen Kraftwerken kommen – also von Kohle- und Kernkraftwerken sowie von Gaskraftwerken.

Die bis Ende 2016 durch die extreme Subventionierung errichteten Windkraftanlagen haben eine theoretische Maximalleistung von 44.600 MW und die Photovoltaik-Anlagen erreichten 39.300 MW. Wie man weiß, bringt diese geradezu ungeheuerlich große Stromerzeugungs-Kapazität im häufigen Ernstfall der Dunkelflaute real absolut nichts.

Dieses riesige System der sogenannten erneuerbaren Energien ist daher nichts anderes als ein die Landschaft verschandelndes paralleles bzw. zweites Stromerzeugungssystem, das wetterbedingt immer wieder einmal total ausfällt, weshalb die konventionellen Kraftwerke immer bereit sein müssen, allein die gesamte Stromversorgung des Landes sicherzustellen.

Wenn es ebenfalls wetterbedingt und daher zufällig eine riesenhafte Leistung produziert, bringt es die Stabilität des Stromnetzes in Gefahr.

Dieser energiepolitische Irrsinn kostet jährlich ca. 24 Mrd. Euro – und er wird gegen alle Vernunft fortgesetzt.

Der 24. Januar 2017 war nun wieder einmal ein Tag, an dem der Ernstfall – der völlige Zusammenbruch der deutschen Stromversorgung – gefährlich nahe kam. Dieser große Blackout wurde gerade noch vermieden, weil die Energieversorger „auch noch das letzte Reservekraftwerk heranzogen“, wie Michael Vassiliadis, der Chef der für die Kraftwerkswirtschaft zuständigen IG Bergbau, Chemie, Energie Reportern mitteilte (1).

Nach dem Bericht von RP-Online führte Vassiliadis auf einer Veranstaltung in Haltern am See vor Journalisten aus, dass „der Zustand am 24. Januar kritisch wurde. Energieunternehmen und Netzbetreiber hätten an diesem Tage die Stromversorgung nur mit größter Mühe aufrechterhalten können.“ Denn die Deutschen forderten – wie an anderen Tagen auch – mehr als 80.000 MW Leistung ab. Vassiliadis: „Die Erneuerbaren konnten nicht einmal fünf Prozent davon bieten“.

Man kennt inzwischen die Zahlen: Die im Winter vorherrschende Quelle von „grünem“ Strom ist die Windkraft. Solarstrom fällt fast völlig aus. In der fraglichen Januarwoche gab es in den Tagen vom 21.1. bis 15.1. Windstromleistungen zwischen 499 und 1518 MW; der Durchschnittswert war 873 MW. Bezogen auf die o.e. „mehr als 80.000 MW Nachfrage“ waren das gerade einmal 1,1 Prozent (und nicht fünf). (Daten von Rolf Schuster).

Mit anderen Worten: Die „Erneuerbaren“ waren buchstäblich nicht vorhanden.

RP-Online weiter: „Auch der Import von Strom war keine Option. Frankreich hatte zu diesem Zeitpunkt angesichts der Kältewelle selbst enorme Schwierigkeiten, den eigenen Bedarf zu decken. Denn viele Franzosen heizen mit Strom. Schon Mitte Januar hatte Paris einen Anti-Kälte-Plan in Gang gesetzt und in den betroffenen Präfekturen Krisenstäbe eingesetzt. Einem Blackout entgingen die Franzosen nur, weil die Inspektion mehrerer Kernkraftwerke verschoben wurde. Frankreich hatte also genug mit sich selbst zu tun.“

Auch britische Nachrichtendienste berichteten über diese Ereignisse (2).

Ein- und auch mehrtägige Flauten, die alle Windräder in Deutschland zur Ruhe kommen ließen, gab es in den letzten Jahren zahlreich. Das Auffüllen dieser Erzeugungslücke durch Solarstromanlagen fand dabei meistens nicht statt, weil es tagsüber nicht immer strahlenden Sonnenschein gibt und in der Dämmerung und nachts überhaupt nichts produziert wird.

Ein Auszug aus diesen Ereignissen:

– Vom 10. bis 16.10.2008 kümmerte die Erzeugung zwischen 50 und 500 MW dahin.

– Vom 4. bis 7.2.2009 lag die Gesamtleistung zwei Tage bei Null und zwei Tage zwischen

400 und 2000 MW.

– Am 25.7. 2012 erreichte die Leistung insgesamt nur 115 MW.

– Im März 2013 wurden kurzzeitig magere 104 MW erzeugt.

– Am 15.10. und am 18.10.2013 leisteten die WKA nur zwischen 150 und 200 MW.

– Am 13.3.2014 leisteten alle deutschen Windräder klägliche 35 MW und tags darauf 215

MW – bei einer installierten Gesamtleistung von 34.000 MW. – also 0,1% und 0,63%.

– Am 16.7.2014 kamen die WKA auf 120 MW – und tags darauf herrschte völlige Windstille in

ganz Deutschland: 20 MW Gesamtleistung – ein Negativrekord mit 0,06%.

– Am 1.10.2014 waren es 482 MW – etwa ein Drittel der Leistung eines einzigen

Kohlekraftwerkes und mit 1,4% der installierten Wind-Gesamtleistung ebenfalls fast nichts.

– Im Januar 2015 erreichte der Windstrom an 4 Tagen (19.-23.1.) zwischen 248 u. 733 MW.

– Vom Februar bis Anfang August 2015 gab es an 17 Tagen nur Windstromleistungen

sämtlicher deutschen WKA zwischen 163 MW und 655 MW.

– Vom 17. bis 20.10.15 gab es hintereinander 554, 901, 506 und 491 MW.

– Eine noch schwächere Phase folgte unmittelbar: Vom 29.10. bis 3.11.15 leisteten alle

Windkraftanlagen 359, 725, 861, 181 und 93 MW.

– Das Jahr 2016 wurde nicht besser: Vom 25.5. bis 27.5. lag die Leistung zwischen 460 und

539 MW.

– Im Juni 2016 gab es an 6 Tagen Leistungen von 468, 642, 209, 517, 407 und 316 MW.

– Im Juli folgte eine zusammenhängende Flauteperiode: Vom 23.7. bis zum 31.7. leisteten

die WKA 689, 128, 893, 689, 773 und 546 MW.

– Es folgten der 16.8. bis 19.8. mit 775, 573 und 295 MW.

– Im September vom 20. bis 22.9. betrugen die Leistungen 457, 742 und 414 MW.

– Im Oktober gab es zwischen dem 23. und 26,10. 583, 745 und 357 MW.

– Der Monat des Beinahe-Blackouts war der Januar 2017. Zwischen dem 21.1. und dem

25.1. leisteten alle Windräder zusammen 740, 499, 851, 755 und 1518 MW. Im

Durchschnitt weniger als 1,1 Prozent der Nachfrage. Weil die Stromimporte fehlten –

unsere Nachbarn benötigten ihren Strom selbst – war das deutsche Stromnetz in größter

Gefahr. Ein einziges Kraftwerk, das ausfällt, ein einziger Leitungsdefekt – und es wäre aus gewesen.

Die obige Liste ist unvollständig; etliche Schwachwind-Tage wurden nicht aufgeführt. Für die Jahre 2015 und 2016 ist festzustellen, dass es in 2015 178 Tage gab, in denen die von allen WKA erzeugte Leistung unterhalb von 3.400 MW lag; 2016 waren es 163 Tage.

Damit erreichten alle deutschen Windräder zusammen in knapp der Hälfte aller Tage beider Jahre weniger als 10 Prozent ihrer Installations-Gesamtleistung. Sie stellen deshalb zum einen nichts anderes als eine gigantische Fehlinvestition dar. Zum anderen aber sorgt die Energiewende dafür, dass der durch die Stromverbraucher zwangsweise subventionierte Ausbau der Windkraft- und der Solarstromanlagen auch weiterhin stattfindet – bei gleichzeitigem Abbau der zuverlässigen konventionellen Kraftwerke. Damit steigt die Wahrscheinlichkeit für den großen Blackout weiter an.

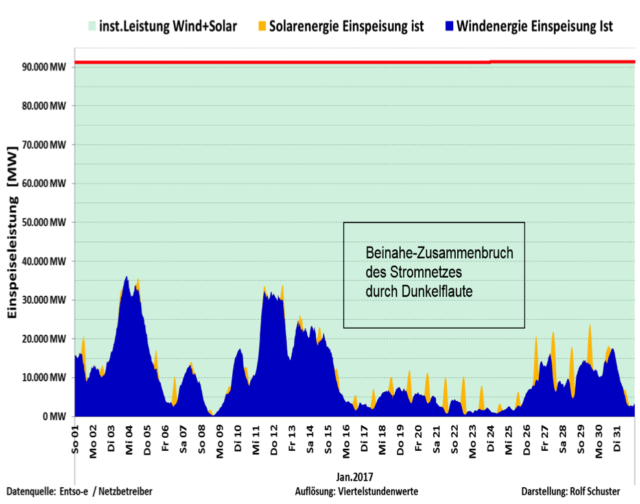

Abb.1: Der Januar 2017 war durch eine 11-tägige Flaute gekennzeichnet, die in einer frostigen Wetterperiode in Europa stattfand. Das war in keiner Weise ungewöhnlich und ist im Zusammenhang mit den windschwachen Russland-Hochdrucklagen in jedem Winter mehrfach zu erwarten. Deshalb gab es keine Stromimporte aus den Nachbarstaaten. Bereits am 24.1. drohte in Deutschland der völlige Zusammenbruch des Stromnetzes, der nur knapp vermieden werden konnte. Die sog. Erneuerbaren leisteten in diesem Zeitraum einen vernachlässigbaren Leistungsbeitrag von 1.1 Prozent; typisch für Flauten.

Die rote Linie bei 91.000 MW zeigt die vorhandene Gesamtkapazität sämtlicher „Erneuerbaren“ (also auch Wasserkraft, Müllkraftwerke etc.) Darstellung: Rolf Schuster.

Mit einem weiteren Ausbau der unzuverlässigen Windkraft sowie der weitergehenden Stilllegung der verbliebenen Kernkraftwerke mit ihrem nur durch Braunkohlekraftwerke ersetzbaren Grundlaststrom rutscht Deutschland immer weiter in die Gefahr einer nicht mehr beherrschbaren Situation im Netz und eines landesweiten Blackouts hinein. Vielleicht war der Morgen des 25.Januar 2017 ohne ein zusammengebrochenes Stromnetz der letzte erfreuliche Moment, den die Netzbetreiber erlebten. Sie hatten einfach das Glück, dass am 24.1. alle zusammengekratzten Erzeugungskapazitäten ohne Ausfälle funktionierten.

Mit der fortschreitenden Destabilisierung des Stromnetzes werden sie künftig noch mehr Glück benötigen.

Den meisten Bürgern ist nicht klar, was ein großer Blackout bedeutet, stellten die Fachleute des Büros für Technologiefolgen-Abschätzung beim Deutschen Bundestag (TAB) in einem sehr ausführlichen Bericht (5) fest, der zwar bereits 2011 erstellt wurde, dessen Aktualität jedoch heute mit jedem Monat zunimmt.

Zitat: „Hinsichtlich der Informiertheit und der Einstellung der Bevölkerung ist ein erhebliches Defizit zu konstatieren. Die Stromversorgung als kritische Infrastruktur ist für die Bevölkerung kein Thema, die Möglichkeit von Stromausfällen und die Folgen einer Unterbrechung der Stromversorgung werden ausgeblendet. Erlebte Stromausfälle werden meist schnell vergessen“.

Aus diesem Bericht werden hier weitere wichtige Ergebnisse zitiert:

„Aufgrund der Erfahrungen mit bisherigen nationalen und internationalen Stromausfällen sind erhebliche Schäden zu erwarten. Bisherige Stromausfälle dauerten höchstens einige Tage, einige verursachten jedoch geschätzte Kosten von mehreren Mrd. US-Dollar. Für den Fall eines mehrwöchigen Stromausfalls sind Schäden zu erwarten, die um Größenordnungen höher liegen.

Die Folgen eines großräumigen, langfristigen Stromausfalls für Informationstechnik und Telekommunikation müssen als dramatisch eingeschätzt werden. Telekommunikations- und Datendienste fallen teils sofort, spätestens aber nach wenigen Tagen aus.

Die für zentrale Kommunikationseinrichtungen vorgehaltenen Reservekapazitäten wie »Unterbrechungsfreie Stromversorgung« und Notstromaggregate sind nach wenigen Stunden oder Tagen erschöpft bzw. aufgrund ausgefallener Endgeräte wirkungslos.

Damit entfällt innerhalb sehr kurzer Zeit für die Bevölkerung die Möglichkeit zur aktiven und dialogischen Kommunikation mittels Telefonie und Internet.

Im Sektor »Transport und Verkehr« fallen die elektrisch betriebenen Elemente der Verkehrsträger Straße, Schiene, Luft und Wasser sofort oder nach wenigen Stunden aus. Dies betrifft sowohl die Transportmittel als auch die Infrastrukturen sowie die Steuerung und Organisation des entsprechenden Verkehrsträgers. Zu Brennpunkten werden der abrupte Stillstand des Schienenverkehrs und die Blockaden des motorisierten Individual- und öffentlichen Personennahverkehrs in dichtbesiedelten Gebieten….Der Straßenverkehr ist unmittelbar nach dem Stromausfall besonders in großen Städten chaotisch. Kreuzungen ebenso wie zahlreiche Tunnel und Schrankenanlagen sind blockiert, es bilden sich lange Staus. Es ereignen sich zahlreiche Unfälle, auch mit Verletzten und Todesopfern. Rettungsdienste und Einsatzkräfte haben erhebliche Schwierigkeiten, ihren Aufgaben, wie Versorgung und Transport von Verletzten oder Bekämpfung von Bränden, gerecht zu werden. Durch den Ausfall der meisten Tankstellen bleiben zunehmend Fahrzeuge liegen, der motorisierte Individualverkehr nimmt nach den ersten 24 Stunden stark ab. Der Öffentliche Personennahverkehr kann wegen knappen Treibstoffs allenfalls rudimentär aufrechterhalten werden.

Im Bereich der Wasserversorgung wird elektrische Energie in der Wasserförderung,

-aufbereitung und -verteilung benötigt. Besonders kritisch für die Gewährleistung der jeweiligen Funktion sind elektrisch betriebene Pumpen. Fallen diese aus, ist die Grundwasserförderung nicht mehr möglich, die Gewinnung von Wasser aus Oberflächengewässern zumindest stark beeinträchtigt. Zudem können Aufbereitungsanlagen und das Verteilsystem nur noch durch natürliche Gefälle gespeist werden, sodass erheblich weniger Wasser bereitgestellt und höher gelegene Gebiete gar nicht mehr versorgt werden können.

Eine Unterbrechung der Wasserversorgung wirkt sich umfassend auf das häusliche Leben aus: Die gewohnte Körperpflege ist nicht durchführbar; für die Mehrzahl der Haushalte gibt es kein warmes Wasser. Das Zubereiten von Speisen und Getränken ist nur reduziert möglich, und die Toilettenspülung funktioniert nicht. Mit fortschreitender Dauer des Ausfalls ist mit einer Verschärfung der Probleme zu rechnen.

Da als Folge der reduzierten oder ausgefallenen Wasserversorgung die Brandbekämpfung beeinträchtigt ist, besteht insbesondere in Städten wegen der hohen Besiedelungsdichte die Gefahr der Brandausbreitung auf Häuserblöcke und möglicherweise sogar auf ganze Stadtteile.

Als Folge des Stromausfalls ist die Versorgung mit Lebensmitteln erheblich gestört; deren bedarfsgerechte Bereitstellung und Verteilung unter der Bevölkerung werden vorrangige Aufgaben der Behörden. Von ihrer erfolgreichen Bewältigung hängt nicht nur das Überleben zahlreicher Menschen ab, sondern auch die Aufrechterhaltung der öffentlichen Ordnung.

Die weiterverarbeitende Lebensmittelindustrie fällt zumeist sofort aus, sodass die Belieferung der Lager des Handels unterbrochen wird.

Trotz größter Anstrengungen kann aber mit hoher Wahrscheinlichkeit die flächendeckende und bedarfsgerechte Verteilung der Lebensmittellieferungen nur ungenügend gewährleistet werden. Eine Kommunikation über Vorrat und Bedarf zwischen Zentrale, Lager und Filiale ist wegen des Ausfalls der Telekommunikationsverbindungen erheblich erschwert.

Nahezu alle Einrichtungen der medizinischen und pharmazeutischen Versorgung der Bevölkerung sind von Elektrizität unmittelbar abhängig. Das dezentral und hocharbeitsteilig organisierte Gesundheitswesen kann den Folgen eines Stromausfalls daher nur kurz widerstehen. Innerhalb einer Woche verschärft sich die Situation derart, dass selbst bei einem intensiven Einsatz regionaler Hilfskapazitäten vom weitgehenden Zusammenbrechen der medizinischen und pharmazeutischen Versorgung auszugehen ist. Bereits nach 24 Stunden ist die Funktionsfähigkeit des Gesundheitswesens erheblich beeinträchtigt. Krankenhäuser können mithilfe von Notstromanlagen noch einen eingeschränkten Betrieb aufrechterhalten, Dialysezentren sowie Alten- und Pflegeheime aber müssen zumindest teilweise geräumt werden und Funktionsbereiche schließen. Die meisten Arztpraxen und Apotheken können ohne Strom nicht mehr weiterarbeiten und werden geschlossen. Arzneimittel werden im Verlauf der ersten Woche zunehmend knapper, da die Produktion und der Vertrieb pharmazeutischer Produkte im vom Stromausfall betroffenen Gebiet nicht mehr möglich sind und die Bestände der Krankenhäuser und noch geöffneten Apotheken zunehmend lückenhaft werden. Insbesondere verderbliche Arzneimittel sind, wenn überhaupt, nur noch in Krankenhäusern zu beziehen. Dramatisch wirken sich Engpässe bei Insulin, Blutkonserven und Dialysierflüssigkeiten aus.

Der dezentral strukturierte Sektor ist schon nach wenigen Tagen mit der eigenständigen Bewältigung der Folgen des Stromausfalls überfordert. Die Leistungsfähigkeit des Gesundheitswesens wird nicht nur durch die zunehmende Erschöpfung der internen Kapazitäten, sondern auch durch Ausfälle anderer Kritischer Infrastrukturen reduziert. Defizite bei der Versorgung, beispielsweise mit Wasser, Lebensmitteln, Kommunikationsdienstleistungen und Transportdienstleistungen, verstärken die Einbrüche bei Umfang und Qualität der medizinischen Versorgung. Die Rettungsdienste können nur noch begrenzt für Transport- und Evakuierungseinsätze eingesetzt werden.

Der Zusammenbruch der in Krankenhäusern konzentrierten Versorgung droht. Einige Krankenhäuser können zunächst eine reduzierte Handlungsfähigkeit bewahren und sind dadurch zentrale Knotenpunkte der medizinischen Versorgung.

Spätestens am Ende der ersten Woche wäre eine Katastrophe zu erwarten, d.h. die gesundheitliche Schädigung bzw. der Tod sehr vieler Menschen sowie eine mit lokal bzw. regional verfügbaren Mitteln und personellen Kapazitäten nicht mehr zu bewältigende Problemlage. Ohne weitere Zuführung von medizinischen Gütern, Infrastrukturen und Fachpersonal von außen ist die medizinisch-pharmazeutische Versorgung nicht mehr möglich.

Bricht die Stromversorgung zusammen, sind alltägliche Handlungen infrage gestellt und gewohnte Kommunikationswege größtenteils unbrauchbar. Stockt die Versorgung, fehlen Informationen und beginnt die öffentliche Ordnung zusammenzubrechen, entstehen Ohnmachtsgefühle und Stress.

Einer dialogischen Krisenkommunikation mit der Bevölkerung wird durch die Ausfälle im Sektor »Informationstechnik und Telekommunikation weitgehend der Boden entzogen.

FAZIT: Wie die zuvor dargestellten Ergebnisse haben auch die weiteren Folgenanalysen des TAB gezeigt, dass bereits nach wenigen Tagen im betroffenen Gebiet die flächendeckende und bedarfsgerechte Versorgung der Bevölkerung mit (lebens)notwendigen Gütern und Dienstleistungen nicht mehr sicherzustellen ist. Die öffentliche Sicherheit ist gefährdet, der grundgesetzlich verankerten Schutzpflicht für Leib und Leben seiner Bürger kann der Staat nicht mehr gerecht werden. Die Wahrscheinlichkeit eines langandauernden und das Gebiet mehrerer Bundesländer betreffenden Stromausfalls mag gering sein. Träte dieser Fall aber ein, kämen die dadurch ausgelösten Folgen einer nationalen Katastrophe gleich. Diese wäre selbst durch eine Mobilisierung aller internen und externen Kräfte und Ressourcen nicht »beherrschbar«, allenfalls zu mildern“.

(Ende des Zitats)

Der Bericht des Technikfolgen-Büros enthält neben diesen Aussagen eine eingehende Analyse der verschiedenen Problembereiche und diskutiert alle denkbaren Optionen, wie der Schaden durch geeignete Maßnahmen zu begrenzen wäre. Aber die Schlussfolgerung – das o.e. „Fazit“ – ist die ungeschminkte Darstellung des zu Erwartenden. Es ist dem Autor nicht bekannt, ob die Bundeskanzlerin oder die betroffenen Minister (des BMU und des BMWi) diesen Bericht jemals gelesen haben. Vermutlich nicht, denn anders ist die geradezu sture weitere Verfolgung der irrealen Ausbauziele für Wind- und Solarstrom und damit das näher kommende Eintreten der Blackout-Katastrophe nicht erklärbar. Sie würden dann auch erkennen, dass sie jetzt nur noch erneut durch Glück die nächste kritische Situation überstehen könnten – aber was ist mit der übernächsten ? Die Lektüre des TAB-Berichts und die Kenntnis der Folgen würde ihnen auch klar machen, dass eine derartige Katastrophe zum Sturz der Regierung führen würde.

Aber es ist ja gerade noch mal gut gegangen….

Quellen:

(1): C.Longin und M.Plück: „Deutsches Stromnetz schrammt am Blackout vorbei, 27.2.2017; RP-Online; http://www.rp-online.de/wirtschaft/unternehmen/deutsches-stromnetz-schrammt-am- blackout-vorbei-aid-1.6636489

(2): Andrew Follet: „Germany facing mass blackouts because of unreliable renewable

energy”; The Daily Caller, USA, 01/03/17;

http://dailycaller.com/2017/02/28/germany-facing-mass-blackouts-because-the-wind-

and-sun-wont-cooperate/

(3): Christian Schlesiger: „Windräder stehen still – und kosten Hunderte Millionen Euro“,

Wirtschaftswoche; 28.4.2016;

(4): Günter Keil: „Am Ende der Energiewende-Sackgasse lauert das Dunkelflaute-Gespenst“,

14.9.2014; https://eike.institute/2014/09/14/am-ende-der-energiewende-

sackgasse-lauert-das-dunkelflaute-gespenst/

(5): Thomas Petermann, Harald Bradtke, Arne Lüllmann, Maik Poetzsch, Ulrich

Riehm: „Gefährdung und Verletzbarkeit moderner Gesellschaften – am Beispiel

eines großräumigen und langandauernden Ausfalls der Stromversorgung“,

17.5.2011; Arbeitsbericht Nr. 141;

Publikation: „Was bei einem Blackout geschieht“, Studie des Büros für

Technikfolgenabschätzung beim Deutschen Bundestag, Bd. 33, 2011, Verlag

edition sigma, Berlin, ISBN 9783836081337, Volltext