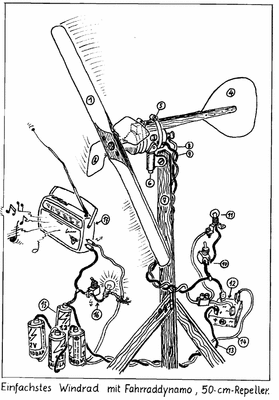

Bild rechts: Wolken und Wasserdampf werden durch die heute verfügbaren Programme zur Simulation des Klimas gar nicht, falsch oder mit viel zu geringer Genauigkeit berücksichtigt. Somit sind alle heutigen Klimaprognosen falsch.

Die Theorie von der menschengemachten katastrophalen Erderwärmung (AGW, Anthropogenous Global Warming) ist, wenn man ihre Auswirkungen auf Politik und Zivilisation betrachtet, tatsächlich schon per se eine Katastrophe. Hinzu kommt, dass sie aus einer bösen Tat – der Verbreitung von Unwahrheiten – resultiert. Auf diese Unwahrheiten trifft sehr exakt das zu, wovor bereits Schiller mit seinem berühmten Spruch aus dem Wallenstein-Drama gewarnt hatte: „Das eben ist der Fluch der bösen Tat, dass sie, fortzeugend, immer Böses muß gebären“. Im Fall der angeblichen Bedrohung des Weltklimas durch CO2 bedeutet dies, dass man zur Deckung der ersten Lüge immer neue zusätzliche Ausflüchte erfinden muss, um die Widersprüche, die sich aus der ursprünglichen Unwahrheit ergeben, „wegzuerklären“. Kriminalbeamten ist diese Vorgehensweise aus Verhören „kreativer“ Verdächtiger bestens bekannt, wenn diese versuchen, Unstimmigkeiten ihrer ersten Aussage durch immer neue Falschbehauptungen zu maskieren.

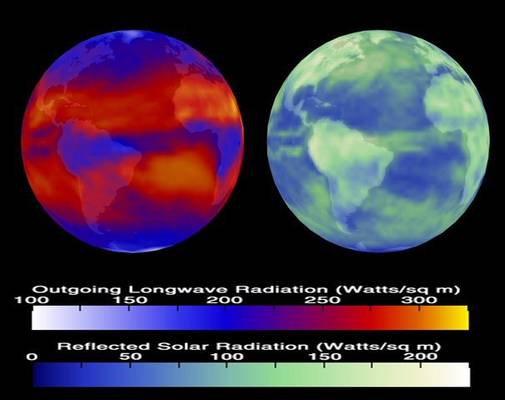

Die Energiebilanz der Erde

Nahezu die gesamte Energie, welche die Erde mit der Sonne und dem Weltall austauscht, wird durch Strahlung transportiert. Die Gesetze der Physik legen fest, dass jeder Körper, der im Vakuum des Weltalls Energie in Form von Strahlung empfängt, diese irgendwann wieder durch Strahlung abgeben muss. Anderenfalls würde seine Temperatur immer weiter ansteigen, da wegen des Vakuums die zugeführte Energie nicht durch Wärmeleitung abführen kann. Die entsprechende Energieabstrahlung erfolgt bei festen und flüssigen Körpern bei jeder Temperatur oberhalb des absoluten Nullpunkts ständig. Das Wellenlängenspektrum der ausgesandten Strahlung hängt vor allem von der Temperatur der Körperoberfläche ab. Fall keine nennenswerte Energiezufuhr von innen erfolgt, stellt sich an der Oberfläche dasjenige Temperaturniveau ein, bei dem empfangene und abgegebene Strahlungsenergie gleich groß sind. Ein solcher Körper befindet sich dann im Strahlungsgleichgewicht mit seinem Umfeld. Im Falle der Erde besteht dieses aus einer sehr heißen Sonne, einem unbedeutenden Mond sowie einem ziemlich „kalten“ Weltraum. Bei der Sonne führt die hohe Oberflächentemperatur dazu, dass diese den Löwenanteil ihrer Strahlungsenergie im Bereich des sichtbaren Lichts emittiert, Bild 1.

Bild 1. Intensität der Sonnenstrahlung bei AM0 (erdnaher Weltraum) und AM1,5 (etwa zum Zenit in Karlsruhe) im Vergleich zur Emission eines idealen Schwarzen Körpers bei einer Temperatur von 5900 K (Grafik: Degreen/ Baba66, Wikimedia Commons [WIC1])

Die Erde strahlt dagegen aufgrund ihrer wesentlich niedrigeren Temperatur fast ausschließlich im infraroten Bereich ab Wellenlängen von etwa 3,5 µm. Für diesen Spektralbereich ist die Atmosphäre wesentlich weniger transparent als für sichtbares Licht. Dies liegt nicht an den Hauptbestandteilen Sauerstoff, Stickstoff und Argon: Diese sind auch für Infrarotstrahlung zumeist ziemlich transparent. In der Atmosphäre gibt es jedoch eine Reihe von Spurengasen wie CO2, Wasserdampf und Methan, deren Moleküle mit jeweils bestimmten Wellenlängen des infraroten Spektrums Energie austauschen können. Diese Gase wirken deshalb wie Filter, die den Strahlungsfluss der IR-Strahlung in jeweils spezifischen Wellenlängenbereichen verringern, indem sie entsprechende Strahlungsquanten absorbieren. Die absorbierte Energie wird in den Gasmolekülen in Form mechanischer Energie (Molekülschwingungen) zwischengespeichert und später wieder abgegeben, oft nicht als Strahlung, sondern als kinetische (thermische) Energie an die Moleküle anderer Gase. Andererseits können diese Moleküle auch kinetische Energie, die ihnen z.B. durch elastische Stöße anderer Moleküle zugeführt wird, in Form von Strahlung wieder aussenden. Die IR-Absorptionsbanden dieser Gase überlagern sich im wichtigen Wellenlängenbereich von 3,5 – 30 µm so dicht, dass nur ein kleines Strahlungsfenster zwischen etwa 8 – 12 µm offen bleibt, Bild 2.

Bild 2. Die IR-Absorptionsbanden der „Treibhausgase“ überlagern sich im Wellenlängenbereich von 3,5 – 30 µm so dicht, dass nur ein schmales „atmosphärisches Fenster“ zwischen ca. 8 und 12 µm offen bleibt (Grafik: [TREA])

Bild 3 zeigt die Energieflüsse, die sich aus Sicht des IPCC aufgrund dieses Strahlungsaustauschs im Bereich der Erdatmosphäre und der obersten Boden- und Wasserschichten ergeben.

Bild 3. Strahlungs- und Energiebilanz der Erde laut IPPC (Grafik: [IP02])

Zum Verständnis ist anzumerken, dass die Zahlenangaben sich auf globale Durchschnittswerte beziehen, also keine Unterschiede zwischen Äquator und Polen berücksichtigen. Ausgangspunkt ist die durchschnittliche Intensität der Sonneneinstrahlung an der Grenze der Erdatmosphäre, die ziemlich konstant bei rund 1.367 W/m2 liegt. Da die Sonne jedoch jeweils nur auf die Tagseite einwirkt und die pro Quadratmeter empfangene Energie aufgrund der Kugelgestalt der Erde zu den Polen hin bis auf Null absinkt, erhält jeder Quadratmeter der oberen Atmosphäre im zeitlichen und räumlichen Mittel lediglich 340 W/m2. Hiervon werden – ebenfalls im Mittel – rund 100 W/m2 direkt zurück ins Weltall reflektiert. Diese reflektierte Strahlungsenergie hat keinen Anteil an den Umwandlungs- und Transportvorgängen an der Erdoberfläche oder in den tieferen Schichten der Atmosphäre.

Die Reflexion ist abhängig von den optischen Eigenschaften der jeweiligen Oberflächen. Charakterisiert wird sie durch den Fachbegriff „Albedo“. Dieser ist eine dimensionslose Größe zwischen 0 und 1. Die Erde hat einen Albedo-Wert von 0,29. Dies bedeutet, dass sie 71 % der auftreffenden Strahlungsenergie absorbiert und 29 % reflektiert. Eine Albedo gibt es übrigens auch für die Emissivität (Emissionsgrad) des gleichen Körpers beim Aussenden von Strahlung. Ein Albedo-Wert von 0,29 für die Emissivität besagt deshalb, dass der betreffende Körper beim Aussenden nur 0,29 x so viel Strahlungsenergie aussendet wie einer, der eine Albedo von 1 aufweist. Zu beachten ist hierbei zusätzlich, dass der Wert der Albedo von der jeweiligen Wellenlänge abhängt. Ein Körper, der im Bereich des sichtbaren Lichts eine Albedo von 0,29 hat, kann bei Abstrahlung im Infrarotbereich unter Umständen eine Albedo von 0,8 oder sogar nahe an 1 aufweisen. Deshalb sollte man sich bei der Kalkulation von Strahlungsbilanzen vergewissern, wie die konkreten Albedowerte für absorbierte und emittierte Strahlung aussehen. Einen Überblick über Absorptions-Albedowerte wichtiger Strukturen auf der Erde und in der Atmosphäre gibt Bild 4.

Bild 4. Verschiedene Oberflächen haben eine unterschiedliche Rückstrahlung: Anhand der Landschaft werden ausgewählte Albedowerte dargestellt (Grafik: eskp.de, Creative Commons, [WIME])

Den Löwenanteil der direkt in der Atmosphäre erfolgenden Reflexion (Bild 3) bewirken mit rund 47 W/m2 die Wolken [STEP]. Von der restlichen Strahlung verbleiben noch weitere Anteile in der Atmosphäre oder werden von Boden und Wasser reflektiert, so dass letztlich nur rund 161 W/m2 der solaren Strahlungsenergie auf Bodenniveau absorbiert werden. Die Erdoberfläche gibt diese Energie nahezu vollständig wieder nach oben in die Atmosphäre ab, zum größten Teil in Form von infraroter Strahlung, den Rest in Form fühlbarer Wärme durch atmosphärische Konvektion oder als latente Wärme aufgrund der Verdunstung von Wasser. Die Infrarotstrahlung vom Boden und vom Wasser gelangt wegen des kleinen offenen Strahlungsfensters der Atmosphäre nur zu einem vergleichsweise geringen Anteil direkt in den Weltraum. Ein Großteil wird von den sogenannten Treibhausgasen, vom Wasserdampf sowie von Wolken abgefangen. Ein Teil hiervon wird – häufig mit geänderter Wellenlänge – wieder in Richtung Erdboden zurückgestrahlt, während der Rest letztlich ins Weltall abgegeben wird. Dieser Energietransport erfolgt meist über zahlreiche Einzelschritte mit zwischengeschalteter Umwandlung in andere Energieformen oder Wellenlängen. Es kommt zu Umlenkungen und Richtungswechseln. Zu diesem „Strahlungskreislauf“ tragen auch die bereits erwähnten Wärme- und Verdunstungsanteile sowie die in der Atmosphäre direkt absorbierten Anteile der Sonnenstrahlung bei, welche den Energiegehalt der unteren Atmosphäre erhöhen. Auch diese Energie muss letztlich, wenn sie sich nach oben „durchgearbeitet“ hat, in Form von Wärmestrahlung abgeführt werden.

Entscheidend ist aus Sicht der AGW-Theorie das behauptete Ungleichgewicht der Strahlungsbilanz (Imbalance). Gemeint ist ein kleiner, im Bild 6 unten links eingezeichneter Energiefluss von 0,6 W/m2 (mit einer Streuung zwischen 0,2 und 1,0 W/m2), der nach Auffassung des IPCC langfristig im System Erdoberfläche/ Wasser/ Atmosphäre verbleibt und die behauptete „Klimaerwärmung“ bewirken soll.

Da die reine AGW-Lehre besagt, dass nur das CO2 der Haupt-Bösewicht sein kann und darf…

Schon diese Behauptung, dass nämlich das vom Menschen durch Verbrennung fossiler Rohstoffe in die Atmosphäre eingebrachte CO2 die Hauptursache für eine katastrophale Veränderung des Weltklimas sei, ist grob unwissenschaftlich. Das lässt sich leicht erkennen, wenn man sich die hierzu präsentierten Darstellungen des IPCC (Bild 5) genauer ansieht. In dieser Darstellung wird für die Wirkung der einzelnen Gase bzw. Aerosole ein „Strahlungsantrieb“ (radiative forcing) angegeben. Damit ist die von den „Treibhausgasen“ angeblich durch vermehrte Reflexion infraroter Wärmestrahlung zurück auf die Erdoberfläche verursachte dauerhafte Veränderung der Energiebilanz gemeint.

Bild 5. Bezeichnung und angeblicher Strahlungsantrieb der wichtigsten „Treibhausgase“ laut IPCC (Grafik: IPCC AR 2007, [IP01])

In der Summe wird den im Bild 5 aufgeführten Treibhausgasen ein kumulierter „Strahlungsantrieb“ von 1,6 W/m² (Streubereich 0,6 – 2,4 W/m²) zugeordnet. Grundlage der entsprechenden Theorie ist der sogenannte „Treibhauseffekt“ der Atmosphäre. Dieser soll dafür sorgen, dass die Gleichgewichtstemperatur der Erdoberfläche bei 15 °C statt bei lediglich -18 °C (255 K) liegt. Hervorgerufen werden soll dies durch die Rück-Reflexion der von der Erde ausgehenden infraroten Wärmestrahlung durch die „Treibhausgase“, wodurch das Temperaturniveau um 33 °C ansteigen soll. Durch menschengemachte Erhöhung des Anteils dieser „Treibhausgase“ soll die Temperatur jetzt noch deutlich stärker ansteigen. An dieser Stelle sei noch angemerkt, dass dies eine Hypothese ist. Viele Wissenschaftler bestreiten diesen Ansatz und führen aus, dass hierfür bisher noch kein Beweis erbracht werden konnte.

….wird die Rolle des Wassers als entscheidender Faktor einfach unterschlagen

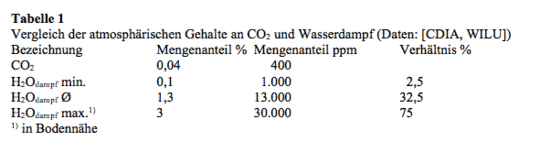

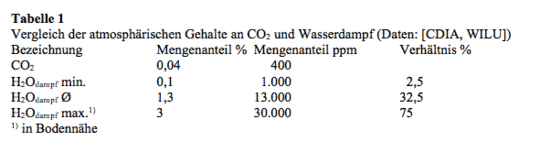

Ein genauerer Blick auf Bild 5 offenbart eine klaffende Lücke, die ein Schlaglicht auf die wissenschaftliche Redlichkeit des IPCC bzw. auf den Mangel an derselben wirft: Das Wasser bzw. der in der Atmosphäre befindliche Wasserdampf fehlt gänzlich, der lächerlich geringe „cloud albedo effect“ von ca. -1,5 W/m² ist ein geradezu groteskes Beispiel wissenschaftlicher Unehrlichkeit. Man vergleiche dies mit den Zahlen, die weiter unten noch aufgeführt werden. Dabei ist Wasserdampf ebenso wie CO2 ein infrarotaktives Gas. Seine Wirkung übertrifft sogar diejenige des CO2 sowie auch die aller anderen „Treibhausgase“ zusammengenommen ganz erheblich. Doch obwohl je nach Quelle zugegeben wird, dass Wasserdampf für 36 bis >85 % des „Treibhauseffekts“ verantwortlich sei, wird es vom IPCC sowie von meinungsführenden Institutionen wie Wikipedia oder der US-Umweltschutzbehörde EPA noch nicht einmal in der Kategorie „Treibhausgase“ geführt. Wichtiger Grund für seine starke Wirksamkeit ist der im Vergleich zu allen anderen „Treibhausgasen“ sehr viel höhere Gehalt in der Atmosphäre. Der Mengenanteil des CO2 in der Atmosphäre liegt nach aktueller Lehrmeinung bei ziemlich genau 400 ppm. Den Unterschied zum Wasserdampfgehalt verdeutlicht die folgende Tabelle:

Aus der Tatsache, dass Wasserdampf vom IPCC trotz seiner IR-Eigenschaften nicht als Treibhausgas gewertet wird, folgt für zahlreiche Vertreter der AGW-Hypothese, die sich möglicherweise noch einen gewissen Rest an Schamgefühl beim Vorbringen wissenschaftlich klar erkennbarer Unwahrheiten bewahrt haben, ein Gewissenskonflikt, der zu einer Vielzahl teils lächerlicher und oft sehr plump vorgetragener Ausflüchte führt. So überschreibt man in der deutschen Ausgabe von Wikipedia den Absatz im Treibhausgas-Beitrag, in dem Wasserdampf behandelt wird, lediglich mit „Weitere zum Treibhauseffekt beitragende Stoffe“. Doch schon im ersten Satz sahen sich die Redakteure anscheinend außerstande, die unwürdieg Scharade weiterzuführen, und sagen klipp und klar: „Wasserdampf ist das wichtigste Treibhausgas. Sein Beitrag zum natürlichen Treibhauseffekt wird auf etwa 60 % beziffert“ [WITR].

Ihre englischsprachigen Kollegen rechnen den Wasserdampf dagegen bereits in der Einleitung zu den wichtigsten Treibhausgasen und stellen fest: „Wasserdampf trägt am meisten zum Treibhauseffekt bei, und zwar zwischen 36 % und 66 % bei klarem Himmel und zwischen 66 % und 85 %, wenn Wolken mit berücksichtigt werden“ [WITE].

Besonders knapp gehalten ist die Erläuterung der US-Umweltschutzbehörde EPA (Environmental Protection Agency), einer Bastion der US-Grünen. Auch auf deren Webseite werden Grafiken über den Einfluss wichtiger, vom Menschen verursachter Treibhausgase gezeigt [EPA], und auch hier wird Wasser(dampf) nicht aufgeführt. Hierzu steht nur lapidar: „Wasserdampf ist ein Gas: Wasser kann als unsichtbares Gas vorkommen, das als Wasserdampf bezeichnet wird. Wasserdampf kommt in der Atmosphäre als natürlicher Bestandteil vor und hat einen starken Einfluss auf Wetter und Klima“. Anschließend folgt noch eine kurze Erläuterung zu seinem angeblich positiven Rückkopplungseffekt aufgrund der verstärkten Verdunstung in einer wärmer werdenden Atmosphäre, was aufgrund der Treibhausgaswirkung des Wasserdampfs zu noch mehr Erwärmung und damit zu einer immer weiter voranschreitenden Erwärmung führen soll.

Eine ganz andere Einschätzung findet man dagegen bei einer Untergliederung der NASA. Zur Erinnerung: Das ist der frühere Arbeitgeber des Dr. Michael E. Mann, der mit seiner hoch umstrittenen „Hockeystick“-Kurve zu einem der prominentesten Frontmänner der AGW-Theorie avancierte. Es gibt dort aber anscheinend auch noch integre Wissenschaftler. Im Goddard Institute for Space Studies (GISS) der NASA beschäftigt man sich im Rahmen des International Satellite Cloud Climatology Project (ISCCP) intensiv mit Klimasimulationen [WONA]. In dieser Veröffentlichung findet sich die bemerkenswerte Aussage, dass Wasserdampf den größten Teil der von der Oberfläche aufsteigenden langwelligen Wärmestrahlung absorbiere und dadurch auch den größten Anteil am Treibhauseffekt habe – der jetzt durch menschengemachte Verschmutzung verstärkt werde. Ohne den Wasserdampf in der Atmosphäre wäre die Erdoberfläche im Mittel um 31 °C (!) kälter als heute. Damit werden dem Wasser mindestens 90 % am gesamten atmosphärischen „Treibhauseffekt“ zugesprochen.

Der angebliche Verstärkungseffekt…

Nächste zentrale Unwahrheitsbaustelle am Kartenhaus der AGW-Theorie ist die sogenannte „Wasserdampfverstärkung“. Dieser behauptete positive Rückkopplungseffekt des Wasserdampfs ist ein entscheidender Dreh- und Angelpunkt der AGW-Hypothese, weil die Wirkung der „offiziell anerkannten“ Treibhausgase nicht ausreicht, um den bisher beobachteten Temperaturanstieg zu erklären. Auf dieser Verstärkungs-Fiktion bauen dann weitere unwissenschaftliche Scheinargumente auf, mit denen versucht wird, die Rolle des eigentlich dominierenden Wassers im Strahlungs- und Wärmehaushalt der Erdoberfläche zu leugnen. Stattdessen wird dessen Einfluss dem CO2 sowie den anderen „Klimagasen“ zugesprochen, obwohl sie bei weitem nicht die gleiche Wirksamkeit haben. Hauptgrund für diese seltsam anmutende Argumentation ist sicherlich, dass man die Fiktion vom Menschen als Ursache des behaupteten Klimawandels auf Biegen und Brechen aufrechterhalten will. Deshalb werden wir uns das Argument der „Wasserdampfverstärkung“, das in unzähligen Variationen ständig wiederholt wird, etwas genauer anschauen. Eine grafische Darstellung dessen, was dabei ablaufen soll, zeigt Bild 6.

Bild 6. Die AGW-Modellvorstellung der verstärkenden Wirkung von Wasserdampf auf die vom CO2 nebst den anderen „Klimagasen“ hervorgerufene Erwärmung (Grafik: [NOAA])

Diese Modellannahme ist schon vom Ansatz her unsinnig, denn sie würde darauf hinauslaufen, dass sich das Klimasystem bereits nach einem kleinen „Stupser“ von selbst immer weiter hochschaukeln würde, bis es schließlich gegen eine Art Anschlag liefe. Bei dieser Argumentation wird zudem ein wichtiger zusätzlicher Aspekt unterschlagen, denn eigentlich müsste man berücksichtigen, dass in den Ozeanen nicht nur enorme Wassermengen, sondern auch rund 38.000 Gigatonnen (Gt) Kohlenstoff als CO2 gespeichert sind *). Das ist rund das 50-60fache dessen, was in der Atmosphäre vorhanden ist. Träfe die Theorie von der „Wasserdampfverstärkung“ zu, so würde mit steigenden Temperaturen ein erheblicher Teil dieses CO2 ebenfalls in die Atmosphäre entweichen und seinerseits den Effekt weiter verstärken **). Dies wäre unvermeidlich, weil die Löslichkeit des CO2 mit steigender Temperatur stark abnimmt. Ein sich erwärmendes Klima würde, wenn die Hypothese von der „Wasserdampfverstärkung“ zuträfe, gleich zwei parallele Mechanismen aktivieren, die unser Klimasystem in eine sich katastrophal immer weiter steigernde Erwärmung katapultieren würden. Dieser Prozess würde solange voranschreiten, bis alles CO2 und alles Wasser aus den Ozeanen entwichen bzw. verdunstet wäre, um dann in einem lebensfeindlichen Endzustand zu verharren. Der C-Inhalt der Atmosphäre läge dann bei rund 40.000 Gt statt der heutigen rund 750 Gt, und sie bestünde hauptsächlich aus Wasserdampf.

Diese Hypothese ist demnach offenkundig schon dann wenig glaubhaft, wenn man sie lediglich als Gedankenexperiment durchspielt. Träfe sie zu, dann gäbe es wohl kaum höheres Leben auf der Erde, wir hätten Zustände, die stark denjenigen der Venus-Atmosphäre ähnelten. Dass so etwas auch in der Realität zumindest in den letzten 550 Mio. Jahren nie vorgekommen ist, beweist der Blick in die Erdgeschichte. Als sich damals aufgrund der Photosynthese unsere heutige „moderne“ Atmosphäre mit ihrem hohen Sauerstoffanteil gebildet hatte, lag deren CO2-Gehalt bis zum 20fachen höher als vor Beginn des Industriezeitalters. Seither ist er unter großen Schwankungen nur ganz allmählich auf das heutige Niveau von 300-400 ppm abgesunken, siehe Bild 7.

Bild 7. Entwicklung des CO2-Gehalts der Atmosphäre in den letzten ca. 570 Mio. Jahren. Der Parameter RCO2 bezeichnet das Verhältnis des Massenanteils an CO2 in der Atmosphäre des jeweiligen Zeitpunkts im Vergleich zum vorindustriellen Wert von ca. 300 ppm (Grafik: W. H. Berger, [CALU])

Wer dies berücksichtigt, kann die Theorie der Überschreitung eines „Kipppunktes“ in der Temperaturentwicklung aufgrund einer „Wasserdampfverstärkung“ der CO2-Wirkung nicht mehr ernst nehmen. Unterstrichen wird ihre Unhaltbarkeit zusätzlich durch die grafische Auftragung der in verschiedenen Erdzeitaltern seither aufgetretenen Kombinationen aus CO2-Gehalt und Temperatur, Bild 8.

Bild 8. Im Verlauf der Erdzeitalter vom Kambrium (vor etwa 541 bis 485,4 Mio. Jahren) bis heute gab es keine erkennbare Kopplung zwischen atmosphärischem CO2-Gehalt und Temperaturniveau (Daten: Wikipedia)

Als weitere Widerlegung der AGW-Theorie vom CO2 als entscheidendem „Klimagas“ können die recht massiven Schwankungen der Temperaturen im Verlauf vergangener Eiszeiten und Zwischeneiszeiten herangezogen werden. Schließlich haben nach aktuellem Stand der Untersuchungen an Eisbohrkernen die CO2-Gehalte in diesem Zeitraum nicht einmal entfernt an heutige Pegel herangereicht. Dennoch schwankten die Temperaturen seit 450.000 Jahren um insgesamt 15 °C um das heutige Niveau, Bild 9.

Bild 9. Im Verlauf der letzten 450.000 Jahre schwankten die Temperaturen im Verlauf mehrerer Eiszeiten und Zwischeneiszeiten bei wenig veränderlichem CO2-Gehalt der Atmosphäre mit einer Spanne von bis zu 15 °C (zwischen etwa – 9 und + 6 °C) um die heutigen Werte (Grafik: Langexp, GNU Wikimedia Commons, [WIC2])

Diese Fakten beweisen eindeutig, dass es egal ist, wie viele Seiten voller einfacher oder auch komplexer mathematisch-physikalischer Herleitungen und Begründungen die Vertreter der AGW-Hypothese zur Untermauerung ihrer Theorien über Wasserdampfverstärkung und Kipppunkte vorbringen: Sie werden durch die Realität der Erdgeschichte ad absurdum geführt.

…und andere Gutenachtgeschichten zum Thema Wasserdampf

Wie bereits dargelegt, wird Wasserdampf ungeachtet seiner starken „Klimawirksamkeit“ seitens des IPCC nicht als „Treibhausgas“ eingestuft. Eine Erklärung für diese seltsam anmutende Haltung finden sich u.a. auf der Webseite der American Chemical Society [ACS]. Zwar wird auch dort zunächst die starke Wirkung von Wasserdampf anerkannt, die in diesem Fall mit 60 % beziffert wird. Dann wird jedoch behauptet: „Allerdings bestimmt der Wasserdampf nicht die Erdtemperatur, stattdessen wird der Wasserdampf durch die Temperatur bestimmt“. Der Treibhauseffekt werde ausschließlich durch nicht-kondensierende Gase bestimmt. Die entscheidende Rolle spiele das CO2, ergänzt um kleinere Beiträge durch Methan, Stickstoffmonoxid, Lachgas und Ozon. Hinzu kämen kleinere Anteile durch die menschliche Zivilisation erzeugter Gase auf Basis von Chlor- bzw. Fluorverbindungen. Schließlich wird die Katze aus dem Sack gelassen: Als Begründung für den Ausschluss des Wasserdampfs dient auch den US-Chemikern ausschließlich die im vorigen Absatz bereits umfassend widerlegte Theorie von der „Wasserdampfverstärkung“. In die gleiche Kerbe schlagen sowohl das deutschsprachige Wikipedia als auch die englische Version [WITR, WITE].

In der englischen Fassung findet sich allerdings noch ein weiteres und besonders abenteuerliches Argument: Man vergleicht die Verweildauer von CO2 in der Atmosphäre von „Jahren oder Jahrhunderten“ mit der viel kürzeren durchschnittlichen Verweildauer eines H2O-Moleküls in der Atmosphäre von lediglich 9 Tagen. Das wird dann als Begründung dafür angeführt, dass Wasserdampf lediglich „auf die Wirkung anderer Treibhausgase reagiere und diese verstärke“. Dieses Argument ist an Lächerlichkeit kaum zu überbieten. Im Mittel tritt ja bei Vorliegen geeigneter Bedingungen ebenso viel Wasserdampf durch Verdunstung neu in die Atmosphäre über, wie durch Kondensation ausgefällt wird, so dass die Konzentration im Großen und Ganzen unverändert bleibt. Das an den Haaren herbeigezogene Argument von der geringen Verweildauer ist somit hinfällig. Bei geschlossenen Kreisläufen wie dem des Wassers zwischen Gewässern, Atmosphäre und Land ist es völlig unerheblich, ob ein einzelnen Molekül nur fünf Sekunden oder 5.000 Jahre in einem der Stadien des Kreislaufs verbleibt. Das einzige was zählt ist die Gesamtmenge bzw. der jeweilige Anteil des betreffenden Stoffs in diesem Stadium, und diese bleiben im statistischen Mittel unverändert oder driften höchstens vergleichsweise langsam über längere Zeiträume nach oben oder unten. Das kann schon ein Gymnasiast im Physikunterricht leicht nachvollziehen.

Von entscheidender Bedeutung wäre dieses Argument dagegen bei Stoffen, die durch bestimmte Ereignisse mehr oder weniger plötzlich in großen Mengen in die Atmosphäre freigesetzt und von der Natur entweder schnell, langsam oder gar nicht resorbiert bzw. in Senken abgelagert werden. Dies ist beim CO2 z.B. nach dem Ausbruch von Supervulkanen der Fall. Hier ist eine möglichst genaue Kenntnis der zugrundeliegenden Kreisläufe, ihrer Stoffflüsse und deren Gesetzmäßigkeiten unabdingbar. Doch auch hier wird von den AGW-Propheten massiv geschummelt. Aus Platzgründen wird hierauf in einem weiteren Artikel noch detailliert eingegangen.

Die Wolken sind der Hund, das CO2 höchstens der Schwanz

Der nächste Aspekt, bei dem sich die AGW-Vertreter mit ihren Theorien regelrecht an Strohhalme klammern, ist das Thema Wolken. Zunächst sei angemerkt, dass es sich auch hierbei um Wasser handelt, allerdings liegt es im flüssigen (Wassertröpfchen) bzw. festen (Eiskristalle) Aggregatzustand vor. Und diese Wolken haben es in sich. Das IPCC behauptet ja, dass ein angenommener Energiefluss (siehe Bild 3) von 0,6 W/m2 das Erdklima bedrohen soll. Das sind jedoch gerade mal etwa 1,3 % des Betrags von 47 W/m2, den die Wolken direkt wieder ins Weltall reflektieren [STEP]. Nun weiß jeder Mensch aus eigener Erfahrung, dass kaum ein Wetterphänomen so unstet ist wie die Wolken. An einem schönen Sommer-Sonnentag kann es sein, dass ihre Abschattung kaum ins Gewicht fällt, bei Unwettern kann es dagegen selbst mitten am Tage so dunkel werden, dass man im Haus das Licht einschalten muss. Ihre Wirkung auf den Energie- und damit Temperaturhaushalt der Erde ist daher ebenso erratisch wie gewaltig. Diese Phänomene konnten früher mangels geeigneter Instrumente nicht gemessen werden. Eine Erfassung durch Satelliten ist erst seit wenigen Jahrzehnten möglich, doch deckt diese wesentliche Aspekte wie die Transparenz für verschiedene Wellenlängen nur unvollständig ab. Hier ist eine Erfassung vom Boden aus nicht zu ersetzen.

Ein weiterer, ebenso wichtiger Aspekt ist der, dass Wolken eine ganz besondere Eigenschaft haben: Sie absorbieren und emittieren Licht aus allen Bereichen des Spektrums, also auch die infrarote Strahlung, die von der Erdoberfläche ebenso ausgeht wie von den IR-strahlungsfähigen Gasen in der Atmosphäre. Zudem geben sie als flüssige Körper mit Masse und Temperatur selbst IR-Strahlung in einem annähernd kontinuierlichen Spektralbereich sowohl nach oben als auch nach unten ab. Während sie also einerseits die Erde nach oben gegen die Sonnenstrahlen abschirmen, sorgen sie „nach unten“ dafür, dass mehr Strahlungsenergie wieder Richtung Erdoberfläche reflektiert wird als bei freiem Himmel. Hinzu kommt der nicht unerhebliche Anteil „Eigenstrahlung“ in alle Richtungen. Die entsprechenden Energiebeträge liegen um zwei Größenordnungen über dem angenommenen „Imbalance“-Betrag und um mehr als anderthalb Größenordnungen über dem Beitrag, der den angeblichen „Klimagasen“ zugeordnet wird. Schon geringe Unsicherheiten bei der Erfassung der Wirkung der Wolken reduzieren daher den „Imbalance-Effekt durch Klimagase“ auf den Rang einer nicht maßgeblichen Störgröße. Wenn man sich dies vergegenwärtigt, kann man nur staunen, auf welch wackliger Grundlage die AGW-Theoretiker ihre Gedankengebäude aufgebaut haben.

Die Uneinigkeit der Wissenschaft beim Thema Wolken

Eines der meistgebrauchten Totschlags-Argumente gegen die sogenannten Klimaskeptiker ist bekanntlich die Behauptung, „die Wissenschaft“ sei sich in der Frage der menschengemachten Klimaerwärmung zu 97 % einig und diejenigen, die nicht damit übereinstimmten, seien Querulanten, Spinner oder Laien ohne die erforderliche wissenschaftliche Qualifikation. In Anlehnung an die rechtlichen Regelungen bezüglich des Verbots der Leugnung von Nazi-Vergehen wird besonders gerne der diskriminierende Begriff „Klimaleugner“ verwendet. Für diese fordern manche besonders forsche Exponenten der Mehrheitsmeinung teils bereits die Todesstrafe, teils bereiten sie wie einige US-amerikanische Staatsanwälte Strafverfolgungsverfahren auf der Grundlage von Gesetzen vor, die für die Bekämpfung des organisierten Verbrechens geschaffen wurden. Angesichts dieser massiven Drohungen und Diskriminierungen macht es daher Sinn, sich mit dem angeblichen „Konsens der Wissenschaft“ beim Thema Wolken und ihrer Wirkung auf das Klima etwas näher zu beschäftigen.

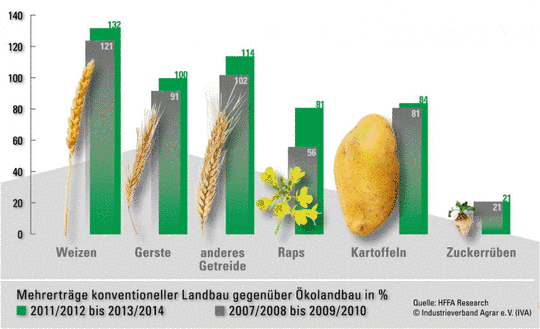

In der englischen Fassung von Wikipedia [WITE] werden Wolken unter Berufung auf eine Untersuchung von Schmidt et al. aus dem Jahre 2010 [SCHM] als Hauptverursacher der Klimaerwärmung eingestuft. Die Autoren ordnen dem Wasserdampf rund 50 % des Treibhauseffekts zu, die Wolken sollen weitere 25 % ausmachen, 20 % kommen demnach vom CO2 und die restlichen 5 % werden Aerosolen und den sogenannten „minor greenhouse gases“ zugeschrieben.

Weniger sicher ist man sich dagegen bei den Redakteuren der deutschen Fassung von Wikipedia [WITR]. Dort wird zunächst erläutert, dass Wolken als kondensierter Wasserdampf streng genommen kein Treibhausgas darstellten. Sie absorbierten aber IR-Strahlung und verstärkten dadurch den Treibhauseffekt ***). Zugleich reflektierten sie jedoch auch die einfallende Sonnenenergie und hätten daher auch einen kühlenden Einfluss. Die Frage, welcher Effekt überwiege, hänge von Faktoren wie der Höhe, Tageszeit/Sonnenhöhe, Dichte oder geografischen Position der Wolken ab. Inwieweit eine Erderwärmung die im gegenwärtigen Klima insgesamt kühlende Wirkung der Wolken abschwäche oder verstärke, sei die unsicherste Rückkopplungswirkung der derzeitigen globalen Erwärmung. Der letzte Satz ist übrigens so geschickt formuliert, dass man ihn erst genauer lesen muss. Erst dann erkennt man, dass hier den Wolken in der jetzigen klimatischen Situation de facto eine kühlende Wirkung zugesprochen wird. Die Unsicherheit bezieht sich lediglich auf den Fall, dass es in Zukunft tatsächlich zu einer Erwärmung des Klimas kommen sollte.

Ziemlich präzise sind dagegen die Angaben des Wiki-Bildungsservers [WIBI]. Dort wird ausgesagt, dass Wolken einerseits die planetare Albedo um ca. -50 W/m2 erhöhten, auf der anderen Seite jedoch auch durch Absorption und Emission der langwelligen Wärmestrahlung mit etwa + 30 W/m2 zum Treibhauseffekt beitrügen. Der Netto-Strahlungseffekt liege damit bei ungefähr -20 W/m2, was eine deutliche Abkühlung des gegenwärtigen Klimas bewirke. Nach Umrechnung der beiden gegenläufigen Effekte in Temperaturen ergebe sich aus einer Abkühlung um -12 °C und einer Erwärmung um +7 °C eine netto-Abkühlung von -5 °C.

Eine sehr fundierte Einschätzung findet man bei dem bereits erwähnten International Satellite Cloud Climatology Project (ISCCP) der NASA [WONA], wo man sich intensiv mit den extrem komplexen Zusammenhängen der Bildung von Wolken und ihres Einflusses auf das Klima beschäftigt. Dabei kommt man zu sehr klaren Aussagen: So wird im Zusammenhang mit Strahlungs- und Niederschlagswechselwirkungen von Wolken lapidar festgestellt, dass man derzeit nicht wisse, wie groß diese Effekte seien. Deshalb sei eine korrekte Vorhersage eventueller Auswirkungen auf den Klimawandel nicht möglich. Und dann kommt es (zumindest für die AGW-Vertreter) knüppeldick, findet sich dort doch die Einschätzung, dass die aktuell verwendeten Programme zur Simulation des Klimas insbesondere mit Blick auf die Vorhersagegenauigkeit bezüglich Wolkenbildung und Regenmengen viel zu ungenau seien. Für eine vertrauenswürdige Klimavorhersage müsse die diesbezügliche Vorhersagegenauigkeit um den Faktor 100 (!) besser werden. Dies setze auch entsprechend verbesserte Messverfahren voraus. Damit ist im Prinzip alles, was bisher an Klimasimulationen präsentiert wurde, aus berufenem Munde (NASA/GISS) für unbrauchbar erklärt worden.

Auf Satellitenmessungen des „Earth Radiation Budget Experiment“ (ERBE) stützt sich die Einschätzung von Prof. Walter Roedel in seinem Buch über Physik der Atmosphäre [ROED]. Diese Daten zeigten, dass global die Abkühlung durch die Erhöhung der planetaren Albedo (immer im Vergleich zu einer wolkenfreien Atmosphäre) gegenüber der Erwärmung durch die Reduzierung der langweiligen Abstrahlung weit überwiege, wenn auch mit starker regionaler Differenzierung. Einem globalen Verlust von etwa 45 bis 50 W/m² aufgrund der erhöhten Albedo stehe nur ein Gewinn von etwas über 30 W/m² durch die Reduktion der thermischen Abstrahlung gegenüber; die Strahlungsbilanz wird also durch die Bewölkung um 15 bis 20 W/m² negativer. Das liegt etwa um den Faktor 10 über dem behaupteten Einfluss des CO2.

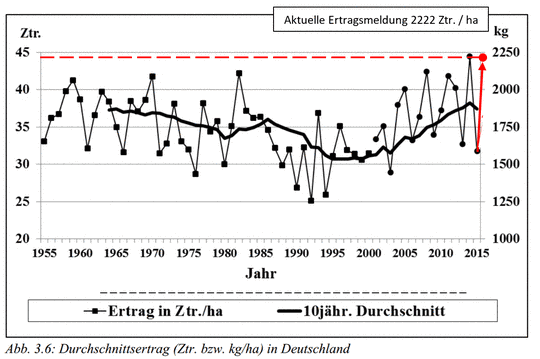

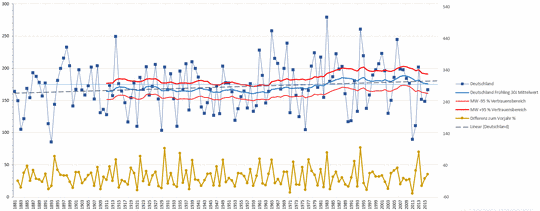

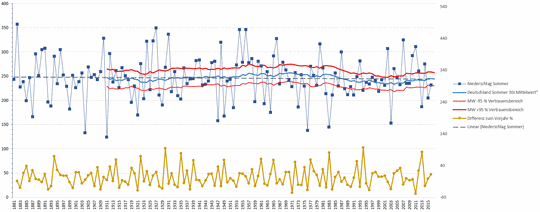

Interessante Erkenntnisse zur Größe und Variation der IR-Strahlung aus der Atmosphäre zum Boden liefern Messungen von E.I. Nezval et al. [NEZV] bei Untersuchungen in Russland über mehrere Jahre. Obwohl hierbei nur die abwärtsgerichteten Strahlungskomponenten erfasst wurden, sind die Daten sehr aufschlussreich, da sie die erhebliche Größenordnung sowie die enorme Variabilität der von Wolken und Wasserdampf gelieferten Beiträge zum Energiehaushalt der Atmosphäre verdeutlichen, Bild 10.

Bild 10. Messdaten zur abwärtsgerichteten IR-Strahlung in der Region Moskau über drei Jahre. Der Beitrag aller „offiziellen Klimagase“ (vergl. Bild 5) ist nur etwa halb so groß wie die Strichdicke der Achseinteilung, auf die der Pfeil zeigt (Grafik: E.I. Nezval et al. [NEZV])

Die höchste abwärtsgerichtete IR-Strahlungsintensität wurde an einem wolkenreichen Juliabend 2009 mit 424 W/m2 gemessen, die niedrigste Wert von 169 W/m2 wurde bei klarem Himmel in den Morgenstunden eines Februartags registriert. Vergleicht man diese Zahlen und ihre Variationsbreite mit dem vom IPCC angegebenen „Strahlungsantrieb“ der Klimagase von lediglich 1,6 W/m2, so kommt man auf einen Multiplikator von bis zu 265 (!). In Sommermonaten variierte der nach unten gerichtete IR-Strahlungsanteil innerhalb eines Tages um bis zu 33 W/m2. Man vergleiche dies mit aktuellen Simulationen, die mit festen Mittelwerten von beispielsweise ganzjährig 1,6 W/m2 arbeiten. Zudem werden die atmosphärischen Eingangsdaten wie Temperatur oder Luftfeuchtigkeit bis heute oft nur mit einstelliger Genauigkeit gemessen. Daher ist die Nonchalance, mit der die Creme der „Klimawissenschaft“ meint, dem Einfluss des „anthropogenen CO2“ die Hauptrolle zuordnen zu müssen und Simulationen auf der Grundlage von solch unsicheren Daten vertrauen zu dürfen, selbst für jemanden ohne wissenschaftlichen Hintergrund nur sehr schwer nachvollziehbar. Stattdessen sollte man besser darangehen, zunächst einmal die Hauptfaktoren des Wetter-und Klimageschehens flächendeckend mit ausreichender Genauigkeit und zeitlicher Auflösung zu ermitteln, bevor man Klimasimulation betreibt

Mangelnde Wissenschaftlichkeit: Das Dilemma der AGW-Vertreter

Die hier aufgeführten Beispiele zeigen, dass die ganze auf dem angeblichen Effekt des „wichtigsten Treibhausgases CO2“ basierende AGW-Theorie wissenschaftlich kaum haltbar ist. Hier wird vor allem Ideologie unter wissenschaftlichem Mäntelchen verpackt und dem Volk mit dem dicken Knüppel der Medien (Prof. Lesch, Schellnhuber und Konsorten) und der Politik (massive Einflussnahme auf Stellenbesetzungen und Fördergelder) schon ab Kindergartenalter in die Gehirne geprügelt. Kritische Meinungen versucht man nicht nur durch Verweis auf einen angeblichen „Konsens der Wissenschaft“, sondern zunehmend auch durch Einschüchterung, Verleumdung sowie direkte Diskriminierung zu unterdrücken. Und das, obwohl sich die Aussagen der AGW-Vertreter schon bei elementaren Grundlagen teils diametral widersprechen.

Präzise auf den Punkt gebracht hat dies der emeritierte Associate Professor für Meteorologie vom Geophysikalischen Institut der Universität in Fairbanks (Alaska, USA), Dr. rer. nat. Gerhard Kramm, in einer kürzlichen Stellungnahme zur Klimadiskussion [KRAM]: „Der sogenannte atmosphärische Treibhauseffekt beruht auf pseudowissenschaftlichem Müll. Mit Physik hat dieser Müll nichts zu tun. Wäre es ein physikalischer Effekt, dann wäre er eindeutig definiert. Das Gegenteil ist der Fall. Es gibt eine Vielzahl von unterschiedlichen Definitionen und Erklärungen, die sich z.T. sogar widersprechen. Selbst die Esoterik stellt höhere Ansprüche als die sogenannte Klimaforschung“.

Fred F. Mueller

Fußnoten

*) Bei der Quantifizierung von CO2-Kreisläufen wird aus praktischen Erwägungen nur der Kohlenstoffanteil im CO2 berücksichtigt, weil der Kohlenstoff in Reservoirs wie z.B. Pflanzen oder Humus auch in völlig anderen Verbindungen vorliegen kann, aus denen sich erst später wieder CO2 bildet.

**) In der Regelungstechnik entspräche dies einer „Mitkopplung“, also einem Effekt, den man z.B. dann erlebt, wenn man mit dem Mikrofon eines Verstärkers zu nahe an die Lautsprecher kommt: Es kommt zu einem immer lauter werdenden Brummen oder Pfeifen, das solange zunimmt, bis die Anlage an ihre Grenzen gekommen ist. Die Geowissenschaften beweisen jedoch, dass Temperaturen und Klimaentwicklung der Erde seit hunderten Millionen von Jahren trotz gelegentlicher schwerer Katastrophen (Vulkane oder Meteoreinschläge) stets innerhalb vergleichsweise vernünftiger Grenzen verblieben sind und die Effekte solcher Katastrophen ausbaalaciert werden konnten. Statt einer katastrophalen Mitkopplung wurde unser Klima demnach offensichtlich von einer sehr gutmütigen Gegenkopplung erstaunlich stabil auf einem lebensfreundlichen Kurs gehalten.

***) Diese Erklärung hätte bei Physiklehrern alter Schule noch die Bemerkung „Sechs, setzen“ ausgelöst, verbunden mit einer Strafarbeit zum Thema, dass nicht die Absorption, sondern höchstens die (Re-)Emission von IR-Strahlung einen Beitrag zu einem „Treibhauseffekt“ leisten könne. Aber Wikipedia als angeblich seriöses Nachschlagewerk mit dem Anspruch wissenschaftlicher Korrektheit ist schon längst fest in der Hand einer neuen Generation „moderner“ Wissenschaftler, denen ideologische Überzeugungen wichtiger sind als Mathematik, Physik oder Naturwissenschaften.

Quellen

[ACS] https://www.acs.org/content/acs/en/climatescience/climatesciencenarratives/its-water-vapor-not-the-co2.html

[CALU] Berger, W. H.: Carbon Dioxide through Geologic Time, http://earthguide.ucsd.edu/virtualmuseum/climatechange2/07_1.shtml

[CDIA] http://cdiac.ornl.gov/trends/co2/recent_mauna_loa_co2.html

[EPA] https://www3.epa.gov/climatechange/kids/basics/today/greenhouse-gases.html

[IP01] spm2 https://www.ipcc.ch/report/graphics/index.php?t=Assessment%20Reports&r=AR4%20-%20WG1&f=SPM

[IP02] Climate Change 2013: The Physical Science Basis. Working Group I contribution to the IPPC Fifth Assessment Report

[KRAM] http://www.eike-klima-energie.eu/climategate-anzeige/klimaforschung-eine-spielvariante-der-zukunftsforschung-was-ist-zukunftsforschung-was-kann-sie-leisten/#comment_8

[NEZV] E. I. Nezval, N. E. Chubarova, J. Gröbner, and A. Omura. Influence of Atmospheric Parameters on Downward Longwave Radiation and Features of Its Regime in Moscow. ISSN 00014338, Izvestiya, Atmospheric and Oceanic Physics, 2012, Vol. 48, No. 6, pp. 610–617. © Pleiades Publishing, Ltd., 2012.DOI: 10.1134/S0001433812060102

[NOAA] Image provided by NOAA ESRL Chemical Sciences Division, Boulder, Colorado, USA http://www.esrl.noaa.gov/csd/news/2013/144_0930.html

[ROED] Walter Roedel. Physik unserer Umwelt: Die Atmosphäre. ISBN 978-3-540-67180-0

[SCHM] Schmidt, G. A.; R. Ruedy; R. L. Miller; A. A. Lacis (2010), "The attribution of the present-day total greenhouse effect" (PDF), J. Geophys. Res., 115, Bibcode:2010JGRD..11520106S, doi:10.1029/2010JD014287

[STEP] Stephens et al. The albedo of Earth. http://webster.eas.gatech.edu/Papers/albedo2015.pdf

[TREA] http://www.theresilientearth.com/files/images/Greenhouse_Gas_Absorption-dlh.png

[WIC1] https://commons.wikimedia.org/wiki/File:Sonne_Strahlungsintensitaet.svg abgerufen am 10.9.2016

[WIC2] https://commons.wikimedia.org/wiki/File:Ice_Age_Temperature_de.png…abgerufen am 11.9.2016

[WILU] https://de.wikipedia.org/wiki/Luft …abgerufen am 30.8.2016

[WIME] https://commons.wikimedia.org/wiki/File:Albedo-R%C3%BCckstrahlung_Infografik.png ….heruntergeladen am 4.9.2016

[WITE] https://en.wikipedia.org/wiki/Greenhouse_gas abgerufen am 30.8.2016

[WITR] https://de.wikipedia.org/wiki/Treibhausgas….abgerufen am 30.8.2016

[WONA] http://isccp.giss.nasa.gov/role.html….abgerufen am 4.9.2016