Kein sicherer Untergang – Klimamodelle können aus systematischen Gründen die Zukunft nicht berechnen.

Bild rechts: Dr. Pat Frank bei seinem Vortrag. Bild: Screenshot aus dem Video

1. Die allgegenwärtigen Klimamodelle

Dr. Frank beginnt mit einer schönen Wortwahl: „Klimamodelle sind das schlagende Herz des modernen Wahnsinns um CO2“. Er wiederholt, dass das IPCC sagte „es ist extrem wahrscheinlich, dass menschlicher Einfluss die dominante Ursache für die beobachtete Erwärmung seit Mitte des 20. Jahrhunderts ist“. Dies ist eine „Konsens“-Schlussfolgerung, die von vielen wissenschaftlichen Institutionen und Universitäten [und natürlich Medien und Politik! Anm. d. Übers.] übernommen worden ist. Nichtsdestotrotz – wenn es darum geht, die zukünftige Erwärmung vorherzusagen, sieht es schon gar nicht mehr so toll aus:

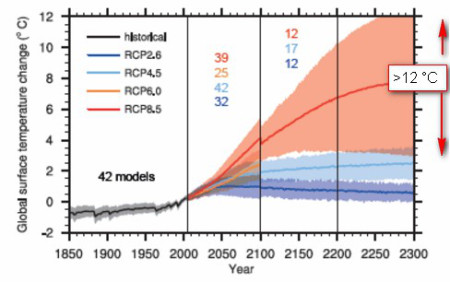

Diese Abbildung aus dem AR 5 zeigt, dass beim RCP 8.5-Szenario die Unsicherheit von 2300 Erwärmung [?] (w.r. Zu vorindustriellen Zeiten) möglicherweise über 12°C beträgt. Dieser enorme Spread der Ergebnisse einer sehr großen Zahl von Modellen ist das verräterischste Anzeichen ihrer geringen Zuverlässigkeit. Dabei enthält diese große Unsicherheit noch nicht einmal die Fehler der individuellen Modelle und deren Fortpflanzung, wenn zukünftige Temperaturen Schritt für Schritt berechnet werden. Wirklich erstaunlich ist, dass keine veröffentlichte Studie diese Fehlerfortpflanzung durch die GCM-Projektionen anspricht, welche folglich also als unbekannt gelistet werden muss.

2. Ein Modell von Modellen

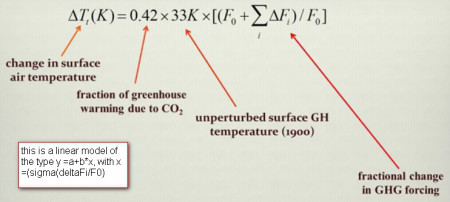

Dr. Frank erinnert daran, dass alle Modelle essentiell eine lineare Abhängigkeit der Erwärmung annehmen sowie der Änderung des Strahlungsantriebes während des Berechnungs-Schrittes. Er führt ein einfaches „Modell von Modellen“ ein und vergleicht das Ergebnis mit denen der Supercomputer-Modelle:

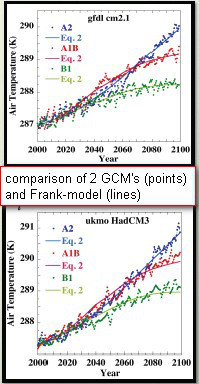

Später wird ein Zusatz-Term von 4 hinzugefügt, bevor die rechte Klammer geschlossen wird. Vergleicht man das Ergebnis dieses „Frank-Modells“ mit den GCMs, muss man überrascht sein, wie gut es bei diesem Vergleich abschneidet:

Die Linien repräsentieren das Ergebnis des „Frank-Modells“, die Punkte jene der verschiedenen GCM-Prophezeiungen (Grundlage ist HadCRUT3). Das außerordentlich gute Ergebnis gestattet Dr. Frank die Aussage: „Falls man die auf Supercomputern laufenden Projektionen duplizieren möchte, kann man das auch mit einem einfachen Taschenrechner tun“.

3. Wolken, der Elefant im Raum

Der Einfluss von Wolken auf die globale Temperatur ist enorm. Global nimmt man an, dass ihre Auswirkungen zu einer Abkühlung um 25 W/m² führen mit einer jährlichen Unsicherheit in den GCMs von ± 4 W/m². Diese Zahl muss verglichen werden mit dem Konsens-Wert der anthropogen erzeugten Treibhausgase von 2,8 W/m² seit dem Jahr 1900. Daher schluckt die Unsicherheit durch die Wolken ganz einfach die vermeintliche anthropogene Erwärmung. Normalerweise nimmt man an, dass die Fehler in den Modellen zufällig sind, so dass sie sich zumindest teilweise mit etwas Glück gegenseitig aufheben. Dr. Frank zeigt, dass nichts weiter von der Wahrheit entfernt sein kann: die Fehler der Modelle sind sehr stark korreliert (R > 0,95 für 12 und R > 0,5 für 46 Modelle).

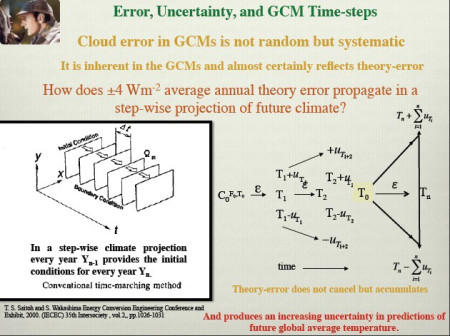

Wie pflanzt sich diese Wolken-Unsicherheit fort durch das Berechnungs-Schema der GCMs?

Die jährliche Unsicherheit von 4 W/m² setzt sich von Schritt zu Schritt fort, und die resultierende Unsicherheit ist die Quadratwurzel der (Summe von Quadraten der individuellen Fehler):

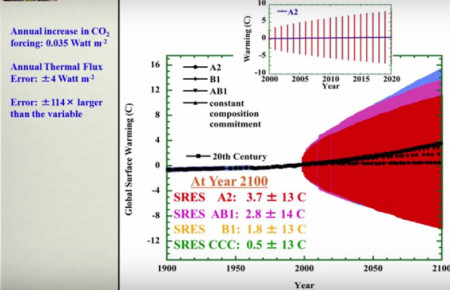

Das Ergebnis ist eine zunehmende Unsicherheit, die sich bis zu 13°C aufschaukelt, wenn man die prophezeite Erwärmung bis zum Jahr 2100 zugrundelegt:

Diese Erwärmungsrate liegt eindeutig „außerhalb jedweder physikalischen Möglichkeit“; die Temperatur-Projektionen selbst der fortschrittlichsten Modelle werden bedeutungslos, falls die Wolken-Unsicherheit angemessen angewendet wird.

3. Schlussfolgerung

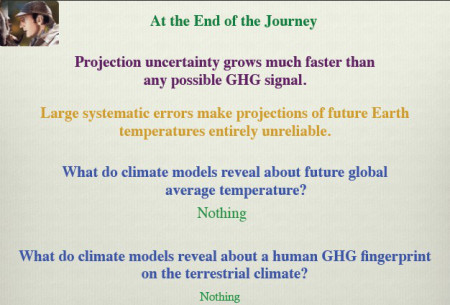

Was können die Klimamodelle als Vorhersage-Tools liefern: Die folgende Folie macht es kristallklar:

[Bildinschriften: Am Ende der Reise

Die Projektions-Unsicherheit wächst viel schneller als jedwedes GHG-Signal.

Große systematische Fehler machen die Projektionen der zukünftigen Temperaturen auf der Erde vollständig unzuverlässig.

Was zeigen die Modelle hinsichtlich der zukünftigen globalen Mitteltemperatur? Gar nichts!

Was zeigen die Modelle hinsichtlich eines anthropogenen GHG-Fingerabdrucks bzgl. des terrestrischen Klimas? Gar nichts!]

Haben unsere Politiker, die vor Begeisterung von einem Fuß auf den anderen springen, um den Paris-Vertrag zu unterzeichnen, auch den blassesten Schimmer von diesem Unsicherheits-Problem?

Link: https://meteolcd.wordpress.com/2016/09/04/no-certain-doom/

Übersetzt von Chris Frey EIKE

Und hier jetzt das oben verlinkte Video: Video (leider nur in Englisch) von Pat Frank (Juli 10, 2016, Omaha, Nebraska.) als Ergänzung zu den im Beitrag behandelten immensen Unsicherheiten, die den historischen Temperaturdaten zwangsläufig und unabänderlich innewohnen. (Details dazu u. hier und hier und hier) Im Video zeigt der Vortragende unmissverständlich und unwiderlegbar auf, dass bei Anwendung der Fehlertheorie mit ihrem Fehlerforpflanzungsgesetz jegliche Klima-Modellaussage völlig bedeutungslos wird. Weil ihre berechneten Änderungen z.B. der Temperatur, z.B. allein auf Grund der ungenauen Kenntnis der Wolkenbedeckung 140 mal kleiner ist als die unvermeidbare Unsicherheit, die aufgrund des Gesetzes der Fehlerfortpflanzung zwangsläufig entsteht. Und der Fehler durch die Wolkenbedeckung ist nur einer von vielen Fehlern.

Anmerkung: Die Folien wurden nach Rücksprache mit Dr. Frank Anfang August 16 aktualisiert