Sommer 2016 in Deutschland – viel geschmäht, doch besser als sein Ruf?

Bild rechts: Ein bunter Sonne- Wolken- Mix mit häufigeren, aber nur kurzen, wenig ergiebigen Regenphasen bei meist angenehmen Temperaturen, so zeigte sich der 2016er Sommer in Thüringen. Foto: Stefan Kämpfe

Die Mär vom „nassen, verregneten, unwetterträchtigen“ Sommer 2016

Dieser Sommer (wir betrachten stets den „meteorologischen“ Sommer vom 1. Juni bis zum 31. August) traf mit geschätzten 240mm Niederschlag im Deutschland- Flächenmittel fast genau den Langjährigen Sommer-Mittelwert 1881 bis 2015 von 246mm (die „amtlichen“ Werte fehlten zum Redaktionsschluss; geringe Abweichungen sind noch möglich). Dabei fiel der Juni deutlich zu nass, Juli und August aber etwas zu trocken aus. Einen „verregneten“ Sommer, speziell in den Ferienmonaten Juli/August, gab es nicht; einziges Manko war die insgesamt leicht unterdurchschnittliche Sonnenscheindauer. Die „Klimamodelle“ prophezeien uns ja seit langem eine abnehmende sommerliche Niederschlagsmenge mit mehr Dürren in Deutschland, doch die Realität weigert sich beharrlich, diesen Horror- Prognosen zu folgen:

Abb. 1: In Deutschland wurde der Sommer seit 1881 weder feuchter, noch trockener (ebene, blaugrüne Trendlinie). Auch die Schwankungsbreite von Sommer zu Sommer, also zu immer extremerer Nässe oder Trockenheit, nahm nicht zu. Die Werte für 2016 sind geschätzt und können um wenige Millimeter abweichen, was auf den Trend und die Gesamtaussagen keinen Einfluss hat.

Und die Juni-Unwetter? Der Begriff „Unwetter“ ist relativ, es gibt nur willkürlich festgelegte Grenzwerte für Starkregen, wie sie auch der DWD (Deutscher Wetterdienst) gebraucht. Die politischen, wirtschaftlichen sowie technischen Bedingungen und Fähigkeiten einer Gesellschaft entscheiden, ob ein stärkeres Regenereignis zum „Unwetter“ wird. Falsche Siedlungspolitik, wie übermäßige Bebauung von Bach- und Flussauen, Bodenverdichtungen und fehlender oder unzureichender Hochwasserschutz (oft würde schon die Wiederaufnahme der früher geregelten Pflege vieler kleinerer Gräben und Vorfluter helfen!) machen aus normalen Sommergewittern Katastrophen. Die meisten sommerlichen Starkregenereignisse sind gewittrig. Daher sollte die Anzahl der je Sommer beobachteten Gewittertage grobe Hinweise auf deren „Unwetterträchtigkeit“ geben. Leider liegt hierfür kein Deutschland- Mittel vor, wohl aber gibt es zuverlässige Aufzeichnungen an der Station Potsdam. Dort traten im Juni mit 6 und im Juli mit 7 Gewittertagen in etwa so viele auf, wie im Langjährigen Mittel; auch der August verlief nach Sichtung der Wetterkarten nicht ungewöhnlich gewitterreich. Wir schätzten höchstens 20 Gewittertage für den gesamten Sommer, das langjährige Mittel beträgt 17,25 Tage. Erstaunliches zeigt sich aber beim Langzeittrend der Häufigkeit sommerlicher Gewittertage (Aufzeichnungen seit 1893):

Abb. 2: In Potsdam zeigt sich keine langfristige Zunahme der Gewittertage. Wegen der hohen Schwankung der Einzelwerte (in gewitterarmen Sommern treten weniger als 10, in gewitterreichen aber mehr als 25 Gewittertage auf) ist der leicht fallende Trend nicht signifikant.

War der Sommer 2016 wirklich zu kühl?

Nein. Viele werden ihn wohl nur wegen der sehr wechselhaften Witterung und der relativ kühlen ersten Augusthälfte in schlechter Erinnerung behalten. Das Deutschland- Mittel für den Sommer in der aktuellen klimatologischen Normalperiode („CLINO“) 1981 bis 2010 beträgt 17,1°C; der Sommer 2016 erreichte mit etwa 17,7°C ein leichtes Temperaturplus. Auch in Zentralengland fiel er um etwa ein halbes Grad zu warm aus. Solche geringfügigen Temperaturabweichungen spürt man kaum, also war dieser Sommer fast normal temperiert. Normal ist auch der stete Wechsel kürzerer sonniger und längerer bewölkter Phasen mit Schauern, Gewittern oder Regenfällen, denn wir liegen in einer Westwindzone, in der sich (meist) seltenere Hochdruckwetterphasen mit längerem Tiefdruckwetter abwechseln. Bemerkenswert, aber nicht völlig ungewöhnlich ist das vereinzelte, örtlich aber eng begrenzte Auftreten von Bodenfrösten schon im August, was in Mitteldeutschland beispielsweise am 11. und am 18.08. besonders in den Mittelgebirgen und deren Vorländern beobachtet wurde, Quelle http://www.mdr.de/nachrichten/vermischtes/sommer-frost-minusgrade-im-august-100.html . Man darf das nicht voreilig als Beginn einer Abkühlungsphase werten, aber es weckt erhebliche Zweifel an der stets behaupteten „starken Erwärmungswirkung“ durch CO2.

Die langfristige Entwicklung der Sommertemperaturen in England und Deutschland

Der Einfachheit halber betrachten wir in diesem Abschnitt nur die Sommerwerte bis einschließlich 2015, denn 2016 fällt langfristig kaum ins Gewicht. Vertrauenswürdige Daten („DWD- Mittel“) liegen leider erst ab 1881 vor. Seitdem erwärmte sich der Sommer um knapp 1,3 Kelvin (1 K entspricht 1°C), was zunächst an eine „CO2- verursachte Klimaerwärmung“ denken lässt. Erstaunt waren wir jedoch über die Messreihe aus Zentralengland (CET), die bis 1659 zurückreicht und damit den Höhepunkt der „Kleinen Eiszeit“ mit erfasst. Seit dieser sehr kalten Zeit sollte sich der Sommer dort doch kräftig erwärmt haben; so 1,5 bis 2 K wären angesichts der „besorgniserregenden Klimaerwärmung“ in mehr als 350 Jahren sicher zu erwarten. Aber die Realität zeigt etwas anderes:

Abb. 3: In Zentralengland (CET = Central England Temperature Records) stieg die Sommertemperatur (Juni bis August) in mehr als 350 Jahren um lediglich 0,36 K (linearer Trend), das sind nur etwa 0,1 K pro 100 Jahre. Es dominiert ein wellenförmiger Verlauf. Den bisher tiefsten Werten um 1700 folgte ein der heutigen Erwärmung ähnelnder Anstieg bis etwa 1750; weitere Warmphasen sind Mitte des 20. Jahrhunderts und in der Gegenwart (1990er bis 2000er Jahre) zu erkennen.

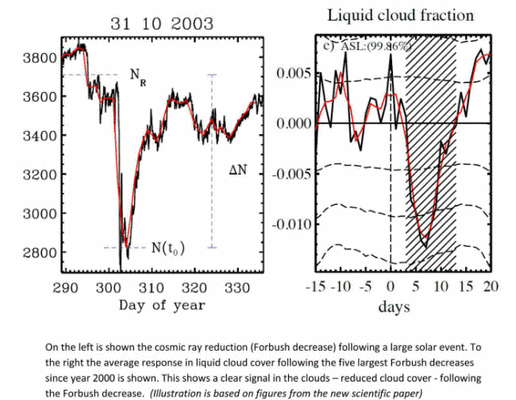

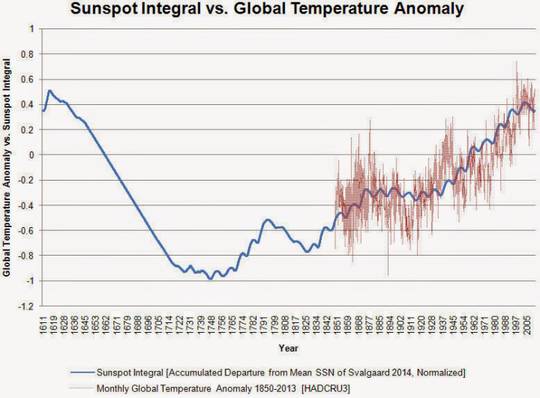

Problematisch für die (zweifelhafte) CO2- basierte Klimaerwärmungstheorie sind besonders die starke Erwärmung im frühen 18. Jahrhundert (damals wohl kaum steigende CO2- Konzentration) sowie die Abkühlungsphase der 1960er bis 1980er Jahre trotz stark steigender CO2- Konzentrationen. Und seit 1986 stagniert die sommerliche Erwärmung in Zentralengland auf hohem Niveau. Bei der Suche nach anderen Ursachen stießen wir auf die Sonnenaktivität. Zahlreiche Wissenschaftler (u. a. SVENSMARK, MALBERG, VAHRENHOLT/LÜNING) haben sich mit dem Einfluss der Sonnenaktivität auf das Klima beschäftigt. In Zeiten höherer Sonnenaktivität erwärmte sich das Klima. Aufzeichnungen der Sonnenfleckenhäufigkeit, welche ein grobes Maß für die Sonnenaktivität ist, liegen mit gewissen Unsicherheiten mittlerweile bis 1700 vor (Datenquelle https://www.quandl.com/data/SIDC/SUNSPOTS_A-Total-Sunspot-Numbers-Annual ). Wir setzen nun die Temperaturreihe von Zentralengland (CET) mit der Sonnenfleckenhäufigkeit in Relation. Die Sonnenaktivität wirkt vor allem langfristig und zeitversetzt (verzögert), was wir bei der folgenden Abbildung berücksichtigt haben:

Abb. 4: Mit gewissen Abstrichen (grüner Pfeil) besteht eine gute Übereinstimmung zwischen Sonnenaktivität (gelb, unten) und den Augusttemperaturen in Zentralengland (rot). Die glatten Kurven sind die Polynome zweiten Grades. Weil die Sonnenaktivität mit einer Verzögerung von 10 bis 30 Jahren am stärksten temperaturwirksam wird, wurde hier ein zwölfjähriger Versatz betrachtet (das 31ig jährige Gleitmittel der Sonnenfleckenzahlen beginnt schon mit dem Jahr 1730 und endet 2003). Anmerkung: Wir verwenden die für die Sonnenaktivität nur bedingt aussagefähigen Sonnenfleckenzahlen, weil sie numerisch vorliegen und gut für Excel- Grafiken verarbeitbar sind. Mehr über die Sonnenaktivität siehe Quellenangabe am Beitragsende.

Allerdings erklärt uns die Sonnenaktivität die Abkühlungsphase der 1960er bis 1980er Jahre und den anschließenden, markanten Anstieg bis etwa 2000 auch nicht, denn trotz berücksichtigtem „Zeitversatz“ erreichte sie ihr absolutes Maximum seit Aufzeichnungsbeginn etwa auf dem Höhepunkt der Abkühlung. Es muss also noch andere Einflussfaktoren auf den Temperaturverlauf geben, welche wir nun kurz betrachten wollen.

Die AMO- Wie der Atlantik unser Klima beeinflusst

Gewissen Einfluss auf das Temperaturverhalten der drei Jahreszeiten Frühling bis Herbst hat die so genannte AMO (Atlantische Mehrzehnjährige Oszillation, ein Maß für die Schwankung der Wassertemperaturen im zentralen Nordatlantik), wobei nach den Untersuchungen von KÄMPFE der Einfluss im Sommer und Herbst am größten ist. In AMO- Warmphasen, welche etwa alle 50 bis 80 Jahre für etwa 20 bis 35 Jahre auftreten, sind die Sommer tendenziell deutlich wärmer, als in den AMO- Kaltphasen. Die AMO- Werte liegen bis 1856 vor; wir haben sie anhand der 31ig- jährigen Gleitmittel in Relation zu den Sommertemperaturen Zentralenglands gesetzt, somit beginnt die folgende Grafik mit dem Jahre 1886:

Abb. 5: Die Atlantische Mehrzehnjährige Oszillation (AMO, eine Schwankung der Wassertemperaturen im Nordatlantik, untere, grüne Kurve), stieg seit 1856, dem Beginn ihrer Erfassung, merklich an und weist außerdem eine etwa 70ig jährige Rhythmik mit Maxima von den späten 1930er bis 1950er und den 1990er bis in die 2000er Jahre auf. In den AMO- Maxima waren die Sommertemperaturen in Zentralengland tendenziell erhöht; Ähnliches gilt auch für Deutschland. Nach 2010 deutet sich eine Stagnation oder gar ein Rückgang aller Werte an; doch muss die weitere Entwicklung hier noch abgewartet werden.

Die bislang letzte AMO- Kaltphase (1960er bis 1980er) fiel mit der Phase der stärksten Sonnenaktivität zusammen und überkompensierte vermutlich deren Wirkung. Auch die Sonnenscheindauer beeinflusst die Sommertemperaturen stark. Vertrauenswürdige langfristige Sonnenscheindauer- Aufzeichnungen fehlen für das Deutschland- Mittel und für Zentralengland. KÄMPFE hat aber die bis 1893 reichenden Aufzeichnungen von Potsdam untersucht und fand für die einzelnen Sommermonate hoch signifikante Bestimmtheitsmaße von 60 bis über 70%, die höchsten Werte für den Juli. Im gesamten Sommer ließen sich knapp 2/3 der Variabilität der Sommertemperaturen mit der Länge der Sonnenscheindauer erklären; sehr sonnenscheinreiche Sommer sind fast immer deutlich wärmer, als sonnenscheinarme. Die starke Luftverschmutzung der späten 1950er bis 1980er Jahre (SO2, Staub) könnte nun Intensität und Dauer der Sonneneinstrahlung vermindert haben, was ebenfalls leicht kühlend wirkte. Zumindest in Potsdam verhielt sich die Sonnenscheindauer ähnlich wie die AMO; bei ihr ist allerdings nur ein leichter Rückgang von etwa 1960 bis in die späten 1980er Jahre erkennbar:

Abb. 6: In Potsdam zeigen Sonnenscheindauer (unten, gelb), Lufttemperaturen (rotbraun, Mitte) und AMO (grün, oben) ein ähnliches Verhalten. Die fetten Ausgleichskurven sind die 15- jährigen gleitenden Mittelwerte. In den relativ warmen 1930er bis 1950er und ab den 1990er Jahren waren alle Werte erhöht; dazwischen lag eine Abkühlungsphase. Auch bei der Globalstrahlung zeigt sich ein Rückgang von etwa 1960 bis 1985; leider liegen Werte aber erst seit 1937 vor.

Die Großwetterlagen entscheiden – Badehose oder Ostfriesennerz?

Ein weiterer Einflussfaktor verdient Beachtung und spielt vermutlich in Deutschland eine viel größere Rolle als in Zentralengland bei der langfristigen sommerlichen Erwärmung- die Änderung der Häufigkeitsverhältnisse der Großwetterlagen. Diese lassen sich mit einiger Sicherheit bis 1881 zurückverfolgen und mit den Sommertemperaturen in Beziehung setzen. Im Sommer kühlende und meist wolkenreiche Großwetterlagen (Klassifikation nach HESS/BREZOWSKY) sind alle West-, Nordwest- und Nordlagen. In der folgenden Abbildung sind die Summen der Häufigkeiten der Großwettertypen West, Nordwest und Nord als Indexwerte zusammen mit dem Sommermittel der Deutschland- Temperaturen dargestellt:

Abb. 7: Eine „Schere“ öffnet sich: Auch weil im Sommer kühlende Großwettertypen (solche aus West, Nordwest oder Nord) langfristig seltener auftraten, wurden die Sommer in Deutschland etwas wärmer. Dominierten diese 3 Großwettertypen am Anfang der Beobachtungsreihe noch mit etwa 62 Tagen je Sommer (Mittelwert 1881 bis 1910) die gesamte Jahreszeit, so waren es im Mittel 1991 bis 2010 nur noch 44 Tage- ein Rückgang um 30%. Zugenommen hat vor allem die Häufigkeit der Lagen mit südlichem Strömungsanteil (hier nicht gezeigt).

Wie stark kühlend Einbrüche feucht- kalter Polarluft sein können, zeigte sich im Thüringer Flachland kurzzeitig am 15. Juli und am 10. August 2016, da wurden nur Tageshöchstwerte von 14 bis 17°C gemessen. Hätten sie länger angedauert, wäre dieser Hochsommer viel kühler ausgefallen, wie etwa teilweise der Sommer 2000, als im kalten, sonnenscheinarmen Juli (24 von 31 Tagen mit West- und Nordwetter!) fast alle Freibäder wochenlang schließen mussten. Und bei häufigeren Hitzewellen wie der von Ende August mit sonnigem Südwetter, hätten wir eine Kopie des 2015er Hitzesommers erlebt.

Der UHI- Effekt- die wirklich menschengemachte Hitzeplage in den Städten

Als wesentliche Einflussfaktoren gelten so genannte Wärmeinsel- Effekte (WI). Über diese hatten KOWATSCH/KÄMPFE häufig berichtet. Wir verzichten im Interesse der Knappheit auf ausführliche Erklärungen. Anhand der Vergleiche von in der Großstadt Berlin gelegenen Stationen mit denen des Berliner Umlandes (höhenbereinigt) und der Relation des Temperaturverlaufs in Jena- Sternwarte zur Entwicklung der Einwohnerzahlen Jenas hatten wir den aktuellen UHI- Effekt auf etwa 0,5 bis 0,8 K geschätzt (in Großstädten ist es gegenüber ländlicheren Stationen im Mittel um diesen Betrag wärmer). Der UHI entstand mit der Verstädterung Deutschlands zwischen etwa 1870 und 1940; sein Erwärmungspotential ist weitgehend (bis auf wenige Ausnahmen, wie etwa Frankfurt/Main) ausgeschöpft:

Abb. 8a und 8b: In der aktuellen CLINO- Periode 1981 bis 2010 traten im Mittel zwischen in der Großstadt Berlin und ländlicheren, nahe gelegenen Stationen in Brandenburg höhenbereinigte Stadt- Umlanddifferenzen im Sommer von 0,8 K (Juni) und knapp über 0,6 K (August) auf (obere Abb.). In Jena gab es seit 1880- besonders nach 1900- einen beträchtlichen Temperaturanstieg von gut 2 K, ein gutes Drittel davon dürfte UHI- bedingt gewesen sein; der dort beträchtliche „neuzeitliche“ Temperaturanstieg ab etwa 1988 hatte aber andere Ursachen (AMO, Sonneneinstrahlung und geänderte Großwetterlagenhäufigkeiten).

Flächenhafte Wärmeinseleffekte (WI) in den DWD- Sommertemperaturreihen

Die von den DWD- Stationen gemessenen Sommertemperaturen sind nicht wärmeinselbereinigt. Besonders nach dem letzten Weltkrieg dehnten sich mittels Straßenbau, Entwässerung und Zersiedlung die WI- Effekte in das Umland aus, zusammenhängende Wärmeregionen sind entstanden wie der Oberrheingraben, der Mittlere Neckarraum oder der Bodenseeraum in Baden-Württemberg. Wir unterscheiden somit zwischen UHI-Effekt (größtenteils vor 1945 entstanden) und dem sich zunehmend entwickelnden flächenhaftem WI- Effekt, letzterer ist vom Betrag her höher (siehe letzte Quellenangabe), und wird neuerdings stark durch die ausufernden Wind- und Solarparks beschleunigt. Ein Teil der Sommererwärmung der letzten Jahrzehnte ist somit WI- bedingt, weil die Messstationen des Deutschen Wetterdienstes (DWD) größtenteils dort stehen, wo die Menschen leben und arbeiten. Betrachten wir zunächst die Entwicklung der Sommertemperaturen nach 1945 (DWD- Originaldaten). Wie alle anderen Jahreszeiten zeigt der Sommer zunächst nach der Jahrhundertmitte eine Abkühlung. Hatte etwa die angebliche CO2-Erwärmungswirkung knapp 30 Jahre lang ausgesetzt, wo doch allein CO2 die Temperatur bestimmen soll? Eine schlüssige Antwort der CO2- Erwärmungstheoretiker auf dieses Problem steht aus.

Abb. 9: Keineswegs wurden die drei Sommermonate konstant wärmer, sondern nach dem Krieg erfolgte zunächst eine Abkühlung und die Temperaturen verharrten zwei Jahrzehnte in einem Wellental. Trotz der nun eventuell erneut beginnenden Abkühlungstendenz ist das aktuelle Temperaturniveau immer noch höher als zu Beginn der Betrachtung um 1945. Eine lineare Trendlinie hätte die Steigung von y = 0,017x.

Der beschleunigte Wärmeinseleffekt hatte an dieser Erwärmung einen erheblichen Anteil. (Beschreibung und Gründe dieses eindeutig anthropogenen, in den DWD- Messreihen verborgenen Effektes siehe Quellenangaben am Schluss des Artikels). Um den WI- Anteil beim Sommertemperatur -Anstieg annähernd zu ermitteln, suchten wir fast WI- freie Stationen und fanden Amtsberg am Fuße des Erzgebirges und Schneifelforsthaus, nahe der Belgischen Grenze.

Wir beginnen 1953, weil die Daten der 2 Vergleichsstationen so weit zurückreichen. Wir vergleichen zunächst das DWD- Mittel mit der Station Amtsberg-Dittersdorf in Sachsen. Leider stand diese Station vor 1982 an einem anderen Ort. Der Stationsleiter hat uns gegenüber beteuert, dass er die Temperaturen vor 1982 richtig auf den jetzigen Standort umgerechnet habe. Trotzdem sollte die nächste Grafik 10 unter diesem Vorbehalt betrachtet werden, da beide Standorte doch räumlich einige Kilometer auseinander lagen.

Abb. 10a/10b: Auch an WI-armen Standorten wurde es ab 1953 bis heute wärmer. Die Trendlinie weist jedoch – wie erwartet – mit eine deutlich geringere Steigung auf, was am Ende 0,8 K weniger Erwärmung seit 1953 für die drei Sommermonate im Raum Amtsberg am Fuße des Erzgebirges ausmacht.

Ab 1975 wurden die Sommer aus verschiedenen Gründen (siehe oben) wieder wärmer. Auch bei der WI- armen Station Schneifelforsthaus zeigt sich ein moderater Anstieg:

Abb. 11: Mit y = 0,0248x hat Schneifelforsthaus seit 1975 einen ähnlichen Anstieg der Trendlinie wie Amtsberg-Dittersdorf mit y = 0,027x. Die DWD-Trendlinie mit y = 0,038x ist deutlich steiler, was letztlich 0,5 K Temperaturgewinn in 41 Jahren zwischen DWD und Schneifelforsthaus ausmachen würde. (0,4K zu Amtsberg). Aus Platzgründen wollen wir auf diese beiden Grafiken verzichten.

Anhand der letzten Grafiken erkennt man überall in Deutschland nach der Kaltphase (um 1970) eine Erwärmung. Bei WI- armen Standorten wie Amtsberg und Schneifelforsthaus ist der Wärmezugewinn aber wesentlich moderater.

Aus dem Verlauf der Grafik 9 – Sommer seit 1945- deutet sich seit gut einem Jahrzehnt möglicherweise wieder eine Abkühlung an. Wir fragen uns zum Schluss, auf welchem Temperaturniveau wir 2016 wieder angekommen sind, bzw. seit wann die Sommertemperaturen stagnieren. Eine WI-arme Klimastation müsste über einen längeren Zeitraum stagnierend sein wie eine WI-behaftete. Das zeigt uns Amtsberg:

Abb. 12: Die drei Sommermonate zeigen in der ländlichen Region am Fuße des Erzgebirges seit 35 Jahren eine Stagnation der Sommertemperaturen.

In der Region Amtsberg fand also seit 1982 keine sommerliche Erwärmung mehr statt; noch ist das ein Einzelfall. Schneifelforsthaus zeigt ab 1990 keine Erwärmung mehr. Die DWD- Sommer-Trendlinie ist im Gegensatz dazu erst seit 1999 eben.

Damit gilt mit aller Vorsicht und Vorbehalt: In der freien Fläche Deutschlands, das sind immerhin 85% der Fläche unseres Staates, stagnieren die Sommertemperaturen möglicherweise bereits seit etwa 30 Jahren. Aber selbst beim Schnitt der wärmeinselbehafteten DWD Orte – etwa 15% der Fläche Deutschlands – stagnieren die Sommertemperaturen seit 1999.

Zusammenfassung

Der Sommer 2016 war nach den offiziellen Daten des Deutschen Wetterdienstes weder besonders reich an Unwettern, noch zu nass oder zu kalt. Insgesamt ein ganz normaler, wechselhafter Sommer mit Höhen und Tiefen. Langfristig betrachtet, wurden die Sommer in Deutschland etwas wärmer, was vor allem auf eine höhere Sonnenaktivität und Sonnenscheindauer, gestiegene AMO- Werte, seltener werdende West-, Nordwest- und Nordlagen sowie verschiedene WI- Effekte zurückzuführen ist. Nur für Zentralengland liegen seit über 350 Jahren Temperaturaufzeichnungen vor; dort erwärmte sich der Sommer seit 1659 nur um knapp 0,4 Kelvin- von einer „katastrophalen Klimaerwärmung“ ist nichts zu spüren. Die sommerliche Erwärmung vollzog sich nicht kontinuierlich, sondern folgte grob der Rhythmik der AMO. Die beschleunigt steigende CO2- Konzentration vermag dieses rhythmische Temperaturverhalten, vor allem aber die Abkühlungsphase um 1970, sowie die Stagnation in Zentralengland seit gut 30 Jahren, hingegen nicht zu erklären. Der Mensch beeinflusste jedoch durch seine Bau- und Siedlungstätigkeit sowie durch geänderte Landnutzung (WI- Effekte) die Erwärmung wesentlich. Mit dem Ausbau der so genannten „Erneuerbaren Energien“ sind nicht nur massive Landschaftszerstörungen und neue Umweltschäden, sondern auch weitere massive Erwärmungen in der Fläche zu erwarten.

Quellen

Großwetterlagen und AMO

http://www.eike-klima-energie.eu/news-cache/im-takt-der-amo-und-der-nao-1-das-haeufigkeitsverhalten-der-grosswetterlagenund-dessen-auswirkungen-auf-die-deutschland-temperaturen/

http://www.eike-klima-energie.eu/news-cache/im-takt-der-amo-und-der-nao-2-das-haeufigkeitsverhalten-der-grosswetterlagenund-dessen-auswirkungen-auf-die-deutschland-temperaturen/

http://www.eike-klima-energie.eu/news-cache/im-takt-der-amo-und-der-nao-3-das-haeufigkeitsverhalten-der-grosswetterlagen-und-dessen-auswirkungen-auf-die-deutschland-temperaturen/

Sonnenscheindauer und Sonnenaktivität

http://www.eike-klima-energie.eu/klima-anzeige/der-heisse-ueberwiegend-trockene-juli-2013-k-ein-ungewoehnliches-ereignis/

http://www.eike-klima-energie.eu/climategate-anzeige/erst-zum-gipfel-dann-wieder-talwaerts-die-temperaturentwicklung-in-deutschland-seit-1980-und-deren-wesentliche-ursachen/

http://www.eike-klima-energie.eu/news-cache/eine-kleine-sensation-von-der-presse-unbemerkt-sonnenaktivitaet-erreichte-im-spaeten-20-jahrhundert-nun-doch-maximalwerte/

Literatur Wärmeinseleffekte in den Temperaturreihen.

http://www.eike-klima-energie.eu/climategate-anzeige/der-waermeinseleffekt-wi-als-antrieb-der-temperaturen-eine-wertung-der-dwd-temperaturmessstationen/

http://www.eike-klima-energie.eu/news-cache/der-waermeinseleffekt-als-massgeblicher-treiber-der-gemessenen-temperaturen/

http://www.eike-klima-energie.eu/news-cache/der-waermeinsel-effekt-eine-bestandsaufnahme-teil-1/

Wärmeinseleffekt in deutschen Wetterdaten

http://www.eike-klima-energie.eu/news-cache/der-waermeinseleffekt-die-station-frankfurtmain-flughafen-ffm-ein-extremer-erwaermungsfall-teil-2/

http://www.eike-klima-energie.eu/news-cache/der-wi-effekt-eine-bestandsaufnahme-teil-3-und-schluss-die-umland-problematik-flaechiger-wi-effekt-mehr-fragen-als-antworten/

http://www.eike-klima-energie.eu/news-cache/extremes-winterwetter-in-europa-der-waermeinseleffekt-und-das-maerchen-vom-co2-treibhauseffekt-teil-2-die-waermeinseln-breiten-sich-aus/

http://www.eike-klima-energie.eu/news-cache/die-zunahme-der-waermeinseln-brachte-den-grossteil-des-temperaturanstieges-der-letzten-125-jahre/

Stefan Kämpfe, Diplom- Agraringenieur, unabhängiger Natur- und Klimaforscher

Josef Kowatsch, unabhängiger Natur- und Klimaforscher