Der unaufhaltsame, gestufte Fall der „Deutschen Energiewende“ – ein ganzheitliches Desaster

Aber Strom aus Wind und Sonne schwankt zwischen praktisch Null und ihrer jeweiligen Nennleistung – das gilt genau so für den ständig als grundlastfähig bezeichneten Offshore-Strom.

Die daraus resultierende Frage, woher der Strom nachts bei Windstille kommen soll, bleibt unbeantwortet – Speicherverfahren in Deutschland sind weder praktikabel noch bezahlbar.

Aber spätestens in 2018 wird massiv Strom über Wind und Sonne erzeugt werden, der oberhalb des höchsten Strombedarfes liegen wird, in 2050 ist es bereits die Hälfte, d.h.dieser Strom muß zwingend gespeichert werden oder die Anlagen müssen still gesetzt werden (das gilt auch für den Stromtransfer von Nord nach Süd).

Eine geistige Auseinandersetzung mit diesen Fakten findet in Deutschland nicht statt, vielmehr folgt man kritiklos einem ökoideologischen Mainstream.

Das erinnert an das religiöse Mittelalter, als Hexen für den Klimawandel verantwortlich gemacht und verbrannt wurden. So rennen wir wie die Lemminge in einen mittelalterlichen Agrarstaat.

Die in den letzten Jahren vermehrt aufgekommene ökologische Ausrichtung der Parteien im Gefolge mit den Medien- oder umgekehrt- haben basierend auf den Angst-einflößenden Aussagen von sog. Wissenschaftlern zum quasi tödlichen Klimawandel durch die angebliche Wirkung des CO2 diverse „Energiewenden“ in Deutschland ausgelöst.

Ziel ist die möglichst weitgehende Vermeidung des Weltunterganges durch die Verminderung des CO2-Ausstoßes.

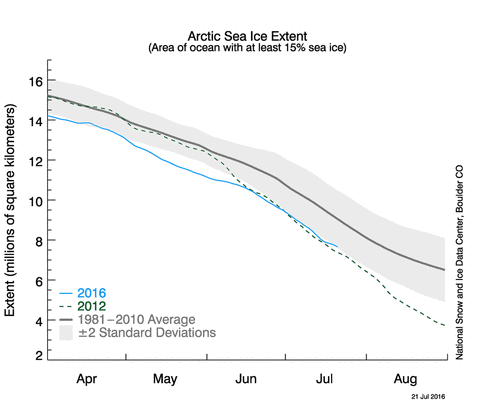

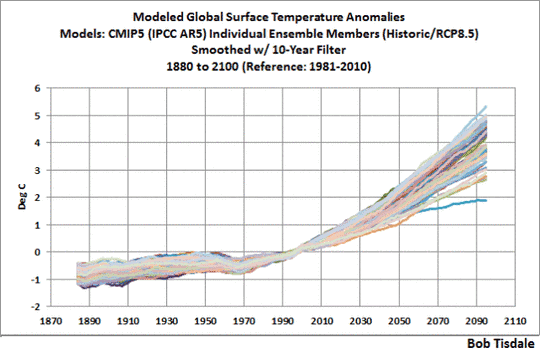

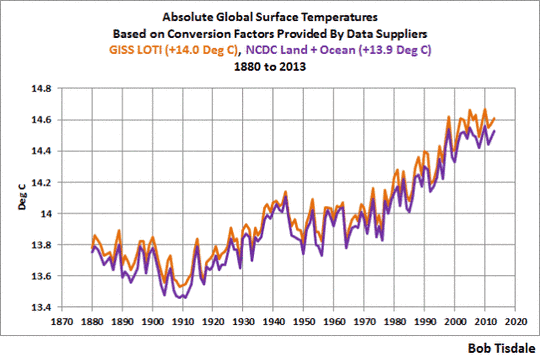

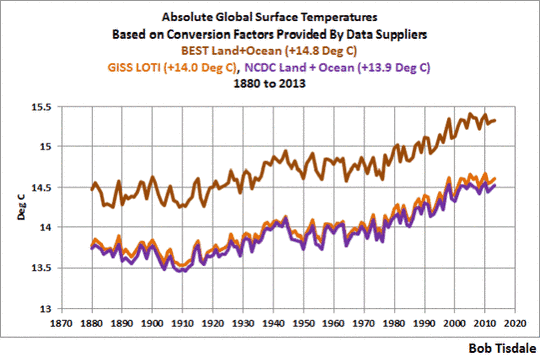

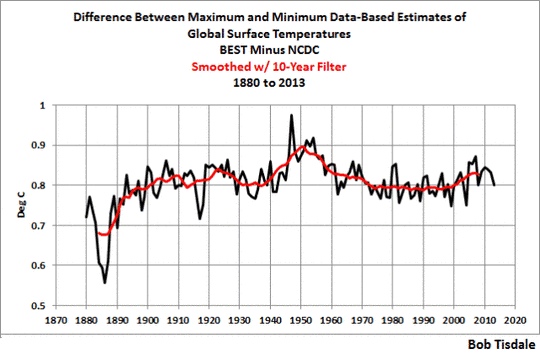

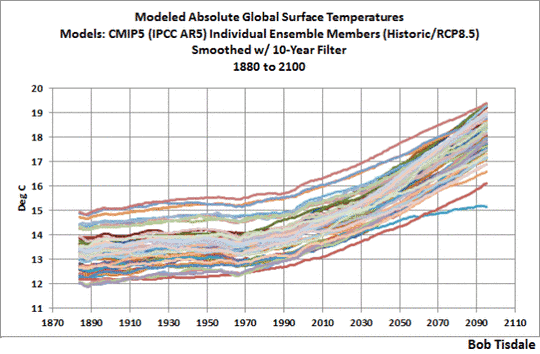

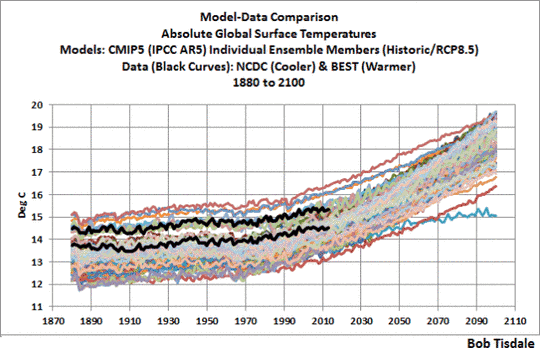

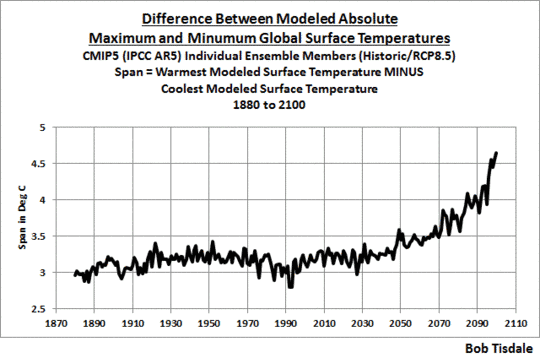

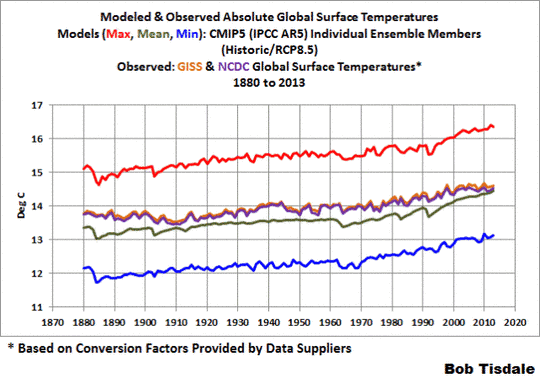

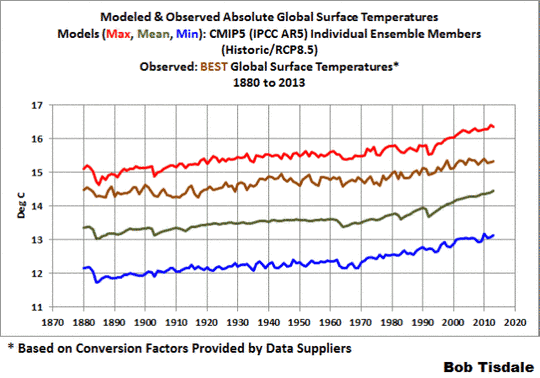

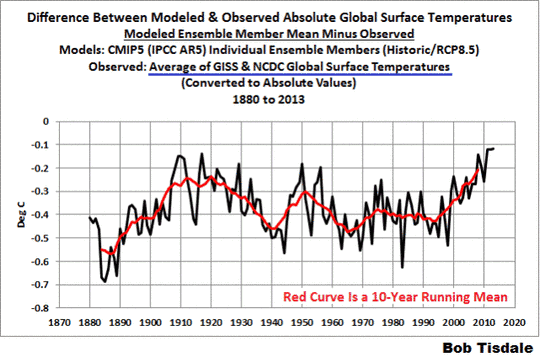

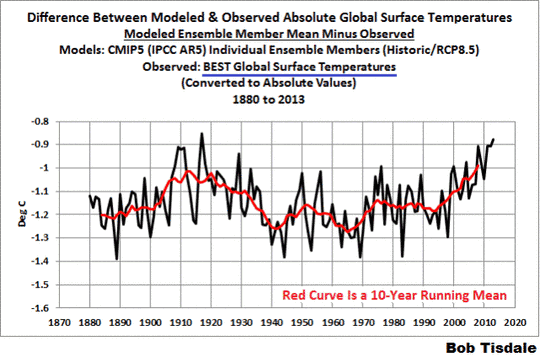

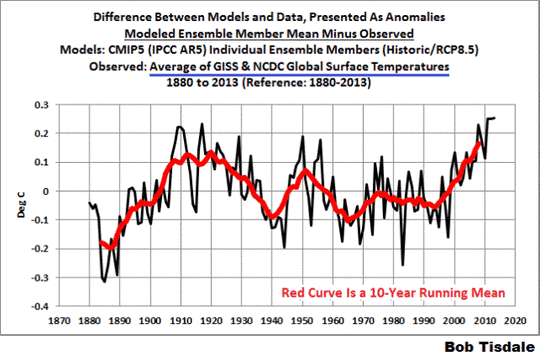

Dabei interessiert nicht die Aussage, dass CO2 aus thermodynamischen Gründen das Klima nicht beeinflussen kann sowie das erwartungsgemäße völlige Versagen all dieser von diversen Wissenschaftlern erstellten Klimamodelle bezüglich der Temperaturvorhersage (Bild 1) (1) oder die Aussage, dass die jährliche Zunahme des weltweiten CO2- Ausstoßes bei etwa 0,50 Mrd. t/a liegt, die Minderung des Ausstoßes in Deutschland durch die „Energiewende“ bei lediglich etwa 0,01 Mrd. t/a – so sie denn gelänge.

Bild 1 (rechts oben) zeigt die mit Satelliten gemessenen weltweiten Temperaturen UAH und RSS, die seit etwa 19 Jahren nicht mehr ansteigen trotz steigender CO2-Gehalte, und die hoffnungslosen Ergebnisse der letzten 44 Modellrechnungen mit ihren ausgewiesenen Temperaturanstiegen, die sich von den restlichen etwa 50 Modellrechnungen -die im Bild nicht dargestellt sind – in ihren peinlichen Aussagen in Nichts unterscheiden.

Das Geschäft mit der Angst fällt in Deutschland schon immer auf fruchtbaren Boden und die Ergebnisse der philosophischen Betrachtungen zu den Ursachen der „German Angst“ sind vielfältig.

So ist Deutschland am konsequentesten –basierend auf einer gezielt geschürten Strahlenangst ohne jede Versachlichung- aus der Atomkraft ausgestiegen. So gab es in den 80er Jahren nur in Deutschland eine apokalyptische Angst vor dem „Waldsterben“, das nie eintrat.

So überrascht es auch nicht, dass es in Deutschland in den letzten Jahren ohne Verifikation der Fakten an diversen „Energiewenden“ nicht gefehlt hat, zumal die Energiewirtschaft mit 42% CO2-Äquivalenten gemessen an der Landwirtschaft mit 7,5%, den Gebäuden mit 12%, dem Verkehr mit 17% und Industrie&Gewerbe/Handel/Dienstleistungen mit 20% den größten Verursacher der sog.„Treibhausgasemissionen" darstellt (Angaben 2013).(2)

Hier nun eine kurze Betrachtung der letzten „Energiewendevariationen“ und einen Ausblick auf den zur Zeit in der Diskussion befindlichen „Klimaschutzplan 2050“ mit den wesentlichen Zielen:

a) „Energiewende 2010/2011“

|

|

2020 |

2050 |

|

Anteil erneuerbarer Energien |

35% |

Mind. 80% |

|

Stromverbrauch |

-20% |

– 50% |

|

CO2-Minderung |

|

80-95% |

b) „Energiewende 2014“

|

|

2025 |

2035 |

2050 |

|

Anteil erneuerbarer Energien |

40-50% |

55-60% |

Mind. 80% |

|

Stromverbrauch |

keine Angaben |

||

Stromerzeugungskapazitäten

|

|

Solar (GW) |

Wind Land (GW) |

Wind See (GW) |

„Sonstige“ (GW) |

Summe (GW) |

|

Stand 2013 |

35 |

33 |

10 |

78 |

|

|

Zuwachs bis 2030 |

40 |

40 |

21,5 |

1,5 |

103 |

|

Stand 2030 |

75 |

94,5 |

11,7 |

181 |

|

|

Zuwachs 2030/2050 |

50 |

50 |

? |

2,0 |

102 |

|

Stand 2050 |

125 |

144,5 |

13,5 |

283 |

|

(keine Angaben zu Wind See in 2030-2050)

c) „Eckpunkte für die geplante Novelle des EEG“ (Beschluß am 08.06.2016) (3)

|

|

Solar |

Wind Land |

Wind See |

„Sonstige“ |

|

Zuwachs bis 2019 (GW/a) |

2,5 |

2,8 |

1,1 |

0,15 (nur Biomasse) |

|

Zuwachs nach 2019 (GW/a) |

2,5 |

2,9 |

1,1 |

0,20 (nur Biomasse) |

(Wind See 15 GW bis 2030)

(keine Begrenzung mehr für Solar mit 52 GW)

d) „Klimaschutzplan 2050“

|

„Dekarbonisierung“ (Verzicht auf die Verbrennung von Kohle, Öl, Gas): |

bis 2050 |

|

Abbau der CO2-Emissionen gegenüber 1990: |

100% bis 2050 |

Die nun im „Klimaschutzplan 2050“ angesprochene Forderung bzw. die von Frau Merkel auf dem G7-Gipfel in Elmau in 2015 bereits eingebrachte „Dekarbonisierung“ – eine bereits 2007 von Herrn Schellnhuber, dem Gründer und Chef des Potsdam Institut für Klimaforschungsfolgen (PIK) geforderte Maßnahme – soll nun bis 2050 in allen Bereichen vollendet werden.

Diese Forderung ist eigentlich für die Energieerzeugung obsolet, wird sie doch in den zahlreichen „Energiewenden“ immer wieder zumindest bis 95% gefordert – von diversen Parteien und Nichtregierungsorganisationen schon längst bis 100%.

Es stellt sich jedoch bei all diesen nicht enden wollenden Aktivitäten zu den„Energiewenden“ stets die Frage nach ihrer Funkionalität, insbesondere nach dem Umgang mit den durch das volatile Verhalten der Stromerzeuger Wind und Solar anfallenden Stromüberschußmengen.

1.„Energiewende 2014“ und die Gründe für das gestufte Scheitern

Es soll daher einmal am Beispiel der „Energiewende 2014“ die Nichtfunktionalität dieser Energiewenden beleuchtet werden.

Die fogenden Auswertungen fußen auf den Angaben der „Energiewende 2014“ sowie folgenden Annahmen:

· gleichbleibende Stromerzeugung bis 2050 von 600 TWh/a (ohne Berücksichtigung Elektroautos)

· angesetzter Anteil der erneuerbaren Energien an der Stromerzeugung: 80%

· Basisjahr für die Wind- und Solardaten ist zunächst das Jahr 2013 mit Nutzungsgraden für Wind von 19, von Solar von 9% (4)

Bild 2

In Bild 2 sind zunächst gemäß dem Plan der „Energiewende 2014“ der Kapazitätsanteil der „Sonstigen“ (Wasser, Biomasse etc.) über die Laufzeit der Energiewende bis 2015 aufgetragen, dann additiv die Summe Wind+Solar+„Sonstige“ sowie schließlich additiv die Stromerzeugungskapazitäten von Wind+Solar+„Sonstige“+konventionelle Stromerzeuger.

Nun haben statistische Auswertungen der Stromerzeugung von Wind, Sonne und Wind+Sonne bezogen auf die jeweilige Nennleistung der Jahre 2011-2013 gezeigt, dass zwar bei der ausschließlichen Betrachtung der Windleistung diese zwischen praktisch Null und 85% und bei der Solarleistung zwischen 0 und 80% an die Nennleistung heranreichen, bei der summarischen Betrachtung aber nur zu 60%. (Bild 3) (5)

Bild 3

Da diese Auswertungen auf gemittelten Stundenwerten basieren, ist davon auszugehen, dass bei allen drei Größen in der Spitze auch Werte von jeweils 100% kurzzeitig erreicht werden.

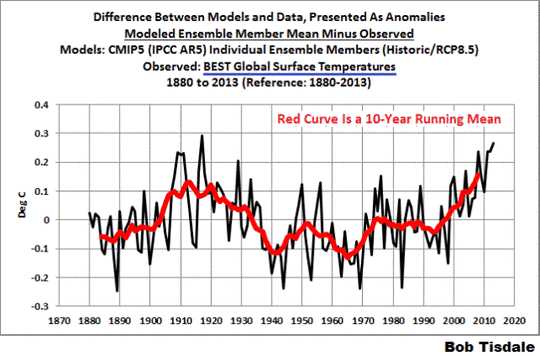

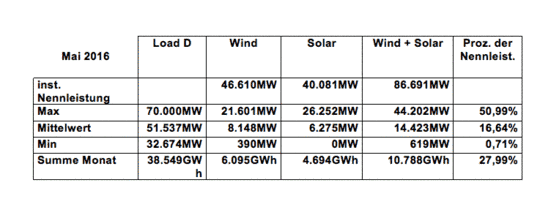

Als Beleg für den Rückgang der Stromerzeugung von Wind+Sonne gegen Null sei auch als Beispiel auf die Einspeiseleistung von Wind+Solar, die installierte Wind-+Solarleistung sowie den Stromverbrauch im Mai 2016 in Bild 4 verwiesen. (6) Bei installierten Leistungen von Wind+Solar von etwa 87 000 MW schwanken die Leistungen von Wind+Solar zwischen 619 MW (0,79% bezogen auf die Nennleistung) und 44 202 MW (entsprechend 50,99%) bei einem Mittelwert von 14 423 MW (entsprechend 16,64%).

Aus Bild 4 wird weiter deutlich, dass die Schwankungen in der Stromerzeugungskapazität über Wind und Sonne kurzzeitig mit bis über 30 000 MW beträchtlich sein können bei z.Z. etwa 30 % Stromerzeugung über alternative Energien, was der Leistung von drei Kraftwerken entspricht, die dann kurzfristig abgeregelt oder hochgefahren werden müssen.

Es stellt sich schon hier die Frage nach der Lösung dieses Problems bei einem Anteil an erneuerbaren Energien von 100% in 2050, wenn keine konventionellen Kraftwerke mehr vorhanden sind (vgl.auch später).

Bild 4

Zum Funktionieren der Energiewende gehört auch, dass die über Wind+Solar in Bild 2 eingezeichnete mittlere Nutzung von Wind, Sonne und "Sonstigen" nur erreicht werden kann, wenn die über dem Mittelwert anfallende Stromkapazität gespeichert wird und in Zeiten nicht ausreichender Leistungen unterhalb der mittleren Stromerzeugungskapazität wieder eingepeist werden kann (im Sinne von Bild 5; im Bild wird die unterhalb des Mittelwertes fehlene Leistung durch Gas ausgeglichen).(7)

Nun wird es wirtschaftlich wenig Sinn machen, die letzten vernachlässigbaren Stromerzeugungsspitzen von Wind+Solar aufzufangen und zu speichern, sondern nur bis zu der in der statistischen Auswertung dargelegten 60%-Stromleistung aus Wind+Solar(Bild 3).(5)

Bild 5

So ist in Bild 2 die Stromerzeugungskapazität von 60% Wind+Solar und additiv dazu der Anteil der „Sonstigen“ eingetragen, praktisch als eine weitere zu diskutierende Größe für den nutzbringenden Kapazitätsanteil über die erneuerbaren Energien.

Außerdem enthält Bild 2 die Schwankungsbreite des Strombedarfes zwischen 32 und 76 GW basierend ebenfalls auf der statistischen Auswertung der Jahre 2011-2013 (Stundenwerte).(5) Die Netzkapazität liegt zur Zeit bei etwa 80 GW.

Unter den gegebenen Annahmen errechnet sich z.B. für das Jahr 2050 bei einem angesetzten Stromanteil über die erneuerbaren Energien von 80% eine zu installierende Erzeugungskapazität von 350 GW, für die konventionellen von nur 15 GW. (4)

Das bedeutet, dass die Stromerzeugungskapazität über Wind und Solar bei den gegebenen Nutzungsgraden in den kommenden Jahren bei wenig Strom aus Offshore-Anlagen um 7,3 GW/a angehoben werden muß (bei Vernachlässigung des geringen Anstieges der „Sonstigen“), was man bei den „Eckpunkten für die geplante Novelle des EEG“ (08.06.2016) nicht erkennen kann.

Aber die Leistungsangaben in GW machen noch keine Aussagen zu der eigentlichen Stromerzeugung.

Aus Bild 3 wird deutlich, dass die Stromerzeugung oberhalb von 60% der Nennleistung von Wind+Solar durch den schlechten Nutzungsgrad von Wind und Sonne gegen Null geht und daher eine hohe Leistungskapazität bereit gestellt werden muß. (Bild 2).

Die 60%-Linie von Wind+Solar+“Sonstige“ schneidet die obere Strombedarfslinie bereits im Jahre 2018, d.h. es fällt ab diesem Jahr durch den vermehrten Anteil an alternativen Energien Strom an, der völlig am Bedarf vorbei geht und der zum Gelingen der „Energiewende 2014“ zwingend gespeichert werden muß oder die Wind- und Solaranlagen müssen still gesetzt werden (Bild 2).

Stufe 1 des Scheiterns der „Energiewende 2014“ (bis 2018)

In der Zeit vor 2018, in der die 60%-Linie der alternativen Energien unterhalb der oberen Strombedarfslinie liegt, kann zumindest noch theoretisch der insgesamt erzeugte Strom über die alternativen Energien dem Strombedarf teilweise zugeordnet werden.

Das schließt jedoch vor 2018 nicht aus, dass z.B. an den Wochenenden, wenn die untere Strombedarfslinie niedrig liegt (vgl.Bild 4), dennoch z.B.bei starkem Wind und viel Sonne die untere Strombedarfslinie massiv überschritten wird, was zu erheblichem Überschußstromanfall führen kann (vgl.später).

Das heißt, man bewegt sich vor dem Jahre 2018 in einem sich überlagernden stochastischen Bereich von Stromerzeugung über die alternativen Energien und dem stochastischen Bereich der Stromnachfrage, so dass eine mathematische Berechnung der Stromüberschußmengen nur schwer möglich ist.

Aber in der Zeit vor 2018 ist die volatile Stromerzeugung über Wind und Sonne noch eingebettet in die Flexibilität einer noch hohen Stromerzeugung über konventionelle Kraftwerke (wobei praktisch ausschließlich Kohlekrafterke für eine hohe Flexibilität sorgen können), so dass der durch die alternativen Stromerzeuger anfallende Überschußstrom noch einigermaßen abgefedert werden kann, nicht zuletzt auch über die Stromabgabe an Nachbarländer über eine Zuzahlung („negative Strompreise“).

So war im Jahre 2013 der physikalische Stromaustausch mit unseren Nachbarländern mit 72,1 Mrd. kWh/a bereits beträchtlich. Der höchste Stromexport fand mit den Niederlanden (24,5), Österreich (14,4) und der Schweiz (11,7 Mrd. kWh/a) statt, der höchste Import mit den Ländern Frankreich (11,8) und Tschechien (9,4 Mrd. kWh/a) über Atomstrom.(8)

Dies führte durch die "negativen Strompreise" in den Niederlanden zu deutlich abfallenden Strompreisen, außerdem sind Arbeitsplätze in einigen Ländern durch das notwendige Zurückfahren ausgerechnet von Pumpspeicherwerken durch den billigen deutschen subventionierten Stromimport gefährdet (Österreich, Schweiz).

In der Stufe 1 nähert sich bis 2018 die 60%-Linie aus Wind+Sonne+“Sonstige“ immer mehr dem oberen Strombedarf, so dass insbesondere an den Wochenenden von ständig steigenden Stromüberschußmengen auszugehen ist.

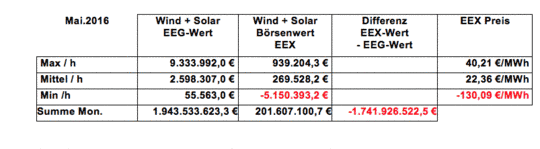

So zeigt Bild 6 an einem Beispiel im Mai 2016, wie der Börsenwert des Stroms stark "negativ" wird- insbesondere an Wochenenden- , wenn das Überangebot an Überschußstrom nicht abgefedert werden kann.(8) So fällt am ersten Wochenende im Mai 2016 der Börsenwert auf minus 130 €/MWh bzw. 13 ct/kWh an der Börse EEX Leipzig ab bei Mittelwerten von nur noch 22,36 €/MWh.

Bild 6

|

|

|

Schließlich war im Monat Mai, 2016, der Strom aus Wind und Sonne durch den niedrigen Börsenwert nur 202 Mio. € wert, d. h. es mußten über EEG 1 742 Mio. € an die Erzeuger des alternativen Stroms gezahlt werden, was von den Stromverbrauchern übernommen werden muß.

Damit sind die konventionellen Kraftwerke nicht mehr konkurrenzfähig.

Die Anzahl der Stunden mit „negativen Strompreisen“ hat erwartungsgemäß seit 2010 ständig zugenommen, was zu erheblichen Zusatzkosten geführt hat (Bild 7). (10) So lagen z.B. die „negativen Strompreise“ an der Börse bereits 2012 teilweise bei minus 58,80 €/MWh bzw. minus 5,80 ct/kWh, die von den Stromverbrauchern übernommen werden müssen, da die Stromerzeugung über alternative Stromerzeuger stets Vorrang hat.

Bild 7

Durch den zunehmendem Anteil an erneuerbaren Energien hat sich durch das zunehmende kostenfreie Angebot des bereits über das EEG bezahlten Wind- und Solarstroms der Börsenpreis für Strom in den letzten 6-7 Jahren mehr als halbiert.

Außerdem führt die Zunahme der alternativen Energien über die damit verknüpfte volatile Stromerzeugung und der Rückgang der konventionellen Kraftwerke zu einer Zunahme der Netzeingriffe (Bild 8; vergleiche auch „Stufe 3“). (11)

Bild 8

Die Folgen dieser überbordenden, am Stromverbrauch vorbei produzierten Überschussmengen führen bereits jetzt in den europäischen Nachbarländern zu fortschreitenden Schwierigkeiten mit ihren Stromnetzen.

An den Grenzen zu Polen und Tschechien werden schon Phasenschieber gebaut, die ungeplante Stromflüsse abblocken sollen.

Dänemark, Norwegen und Schweden haben sich jüngst bei der EU-Kommission über Deutschland beklagt. Das überfüllte und unzureichend ausgebaute deutsche Stromnetz verhindere den Durchfluß ihres günstigen (Öko-)Stroms Richtung Süden.(12)

Stufe 2 des Scheiterns der „Energiewende 2014“ (2018-2050)

Ab dem Jahre 2018 wird nun Strom erzeugt, der völlig am Verbrauch vorbei geht.

Der gewaltig zunehmende Abstand der 60%-Linie für Wind+Sonne+“Sonstige“ zur oberen Strombedarfslinie nach 2018 steigt über 38 GW in 2025 und 81 GW in 2035 auf 139 GW in 2050 an (Bild 2).

Mit Hilfe von Bild 3 lassen sich nun die sich daraus ergebenden Strommengen abgreifen (4):

Der tägliche Strombedarf liegt bei 600 TWh/a oder 600 000 GWh/a bei 1644 GWh/Tag, d.h. in 2050 entspricht die Überschußmenge mit 726 GWh/Tag fast der Hälfte der täglichen Stromerzeugung.

Entweder können diese Strommengen gespeichert werden oder die Wind- und Solaranlagen müssen still gesetzt werden, was naturgemäß mit erheblichen Kosten verbunden ist.(13)

Das größte deutsche Pumpspeicherwerk Goldisthal hat eine Leistung von 8,4 GWh/Tag, was –wollte man die Speicherung über Pumpspeicher lösen – folgende Anzahl erforderlich machen würde: (4)

Eine solche Lösung scheidet jedoch aus leicht nachzuvollziehenden Gründen aus.

Geht man davon aus, dass andere Speicherverfahren für Strom wie „Power to Gas“, Batterien, etc. hoffnungslos am Wirkungsgrad und den Kosten scheitern (z.B. Wirkungsgrad der Erzeugungskette "Power to Gas" über H2- Erzeugung, Methanherstellung, Stromherstellung über Methan liegt bei rd. 25%), muß das Vorhaben „Energiewende“ so schnell wie möglich gestoppt werden bis praktikable und bezahlbare Lösungen erarbeitet wurden.

Hinzu kommt, dass durch die „Energiewende 2014“ – so sie denn gelänge – der CO2-Gehalt der Atmosphäre nur um 0,000 008% vermindert werden könnte- bei Ausgangsgehalten von 0,039%. (13)

Schließlich muß noch auf die notwendige Erweiterung der Netzkapazität in der Stufe 2 hingewiesen werden – z.B. in 2050 auf 220 GW – mit all den damit verknüpften Kosten, die bereits jetzt die Abgaben über EEG übersteigen(Bild 2).

Stufe 3 des Scheiterns der „Energiewende 2014“ (2040-2050)

Parallel zur Stufe 2 gesellt sich spätestens ab 2040 ein weiteres Problem: die Stromversorgungssicherheit.

In Bild 8 war bereits im Bereich der noch erträglichen Stufe 1 auf die Zunahme der Eingriffe zur Stabilisierung der Stromversorgung hingewiesen worden.

Wenn der elektrische Strom nicht gespeichert werden kann, muß in einem Stromversorgungsnetz der an irgendeiner Stelle entnommene Strom unmittelbar in gleicher Menge wieder eingespeist werden, d.h. es ist muß stets ein Gleichgewicht zwischen Stromentnahme und Stromerzeugung aufrecht erhalten werden.

Die Vergangenheit hat gezeigt, dass bei Stromausfall den Netzbetreibern oft nur Sekunden zur Vermeidung eines flächendeckenden Stromausfalles verbleiben, eine Zeit, in der selbst primär regelfähige Kraftwerke ihre Leistungsabgabe nur um Bruchteile des erforderlichen Betrages heraufsetzen können.

Die einzige sofort verfügbare Leistungsreserve, auf die ein Netzbetreiber in den ersten entscheidenden Sekunden zurückgreifen kann, ist die in den rotierenden Massen der Turbinen und Generatoren konventioneller Kraftwerke (Kohle-, Kern-, Gas- und Wasserkraftwerke) gepeicherte kinetische Energie.

Daher sollte bei einem immer höheren Aufkommen an volatilen Stromerzeugern eine kritische Grenze für konventionelle Kraftwerke von rd. 28 GW nicht unterschritten werden, um eine erforderliche Mindestreserve an Primärleistung vorzuhalten, die ab 2040 ständig unterschritten würde.(14)

Diese kritische Grenze wird jedoch bereits heute teilweise bei dem derzeitigen Anteil von Strom aus Wind und Solar teilweise unterschritten (Bild 4), was sich in einer zunehmenden Zahl an Eingriffen äußert.

Solaranlagen besitzen überhaupt keine rotierenden Massen, die rotierenden Massen der Windkraftanlagen sind gemessen an den konventionellen Stromerzeugern verschwindend gering.

Bei einem Blackout können selbst Gaskraftwerke wenig ausrichten, da es auch bei diesen mehrere Minuten dauert, bis der Generator nennenswerte Leistungen abgeben kann (etwa 5 Minuten bis zur vollen Leistung). (15)

Auch die Aussagen der Stufe 3 belegen, dass eine Erzeugung des Stroms von mind. 80% über alternative Energien nicht möglich ist, geschweige denn von 100% nach der Vorstellung diverser Parteien und Nichtregierungsorganisationen bzw. der Vorstellung einer „Dekarbonisierung“.

Eine zur „Energiewende 2014“ analoge kritische Betrachtung der am 08.06.2016 beschlossenen „Eckpunkte für die geplante Novelle des EEG“ kann hier wegen der bisher unvollständigen Angaben nicht vorgenommen werden.

2. Geplanter „Klimaschutzplan 2050“ mit vollständiger „Dekarbonisierung“ und das Problem des Stromtransfers nach Süden

Das Bundesministerium für Umwelt plant nach jetzigem Kenntnisstand im Herbst den „Klimaschutzplan 2050“ in die Gesetzgebung einzubringen. Ziel ist u.a. nicht nur der vollständige Wechsel von fossilen zu erneuerbaren Energieträgern bis 2050 in der Stromerzeugung (Energiesektor) mit z.Z. 42% CO2-Äquivalenten – wo die „Dekarbonisierung“ praktisch schon vollzogen ist – sondern auch in den Bereichen

· Landwirtschaft mit 7,5% CO2-Äquivalenten

· Gebäuden mit 12% CO2-Äquivalenten

· Verkehr mit 17% CO2-Äquivalenten

· Industrie&Gewerbe/Handel/Dienstleistungen mit 20% CO2-Äquivalenten.

Hierbei ist zu bedenken, dass z. Z. der Primärenergiebedarf Deutschlands durch erneuerbare Energien gerade einmal mit weniger als 10% gedeckt ist. Alleine für die Energiewende im Energiesektor mit 42% CO2-Äquivalenten ist bei einem Anteil von 80% erneuerbarer Energien ein Flächenbedarf von etwa 25% der Gesamtfläche Deutschlands erforderlich. (4,13) Wird nun der Anteil der erneuerbaren Energien im Rahmen der Energiewende von 80 auf 100% aufgestockt und zudem in den Bereichen Landwirtschaft, Gebäude, Verkehr sowie Industrie&Gewerbe/Handel/Dienstleistungen mit insgesamt 58% CO2-Äquivalenten die "Dekarbonisierung" durchgezogen, müßte weit mehr als die Hälfte der Fläche Deutschlands mit erneuerbaren Energien zugepflastert werden. Zudem stellt sich auch hier die schlichte Frage, wo nachts bei Windstille der Strom herkommen soll – bei fehlenden Stromspeichern.

Wie bereits erwähnt stellt sich für den Energiesektor die Frage nach der „Dekarbonisierung“ aufgrund des bisher Dargelegten in 2050 wegen des ganzheitlichen Scheiterns der Energiewende ohnehin nicht mehr, außerdem können bei dem Ansatz der Stromerzeugung über alternative Energien von 80% ohnehin nur noch 15 GW von 365 GW über konventionelle Kraftwerke dargestellt werden.

Im Folgenden soll dennoch der Umrechnung der 15 GW in alternative Energien nachgegangen werden.

Eine zu installierende Leistung von 15 GW über konventionelle Kraftwerke entsprechen bei einer Nutzungszeit von 90% 13,5 GW, die über die alternative Energien aus Wind und Sonne erzeugt werden müßten.

In 2013 lag der mittlere Nutzungsgrad von Wind und Sonne bei 13,4% (19% über Wind, 9% über Sonne) bei fast gleichen Anteilen von Wind-und Solarstrom. (4)

Für 13.5 GW müßten dann 13,5/0,134 = 101 GW über die alternativen Energien Wind und Sonne erstellt werden, was in Summe einer Gesamtinstallation von

350 +101 GW = 451 GW

über die alternativen Energien entspräche.

Bei einer Installation von rd.14 GW über „Sonstige“ verbleiben dann in 2050 437 GW für Wind und Sonne.

Diese gewaltige zu installierende Leistung könnte nur vermindert werden durch die Installtion eines hohen Anteiles an Wind Offshore-Anlagen, deren Nutzungsgrade zur Zeit bei etwa 30% gesehen werden.

Würde in 2050 das Verhältnis von Wind offshore zu Wind onshore zu Solar im günstigsten Falle gleich liegen, ergäben sich folgende mittlere Nutzungsgrade

146x 9 + 146x 19 + 146x 30 /437 = 19,3%,

was dann einer verminderten Leistungskapazität für Wind und Sonne von 303 GW entspräche.

Welche Leistungskapazität auch immer entstünde, der Strom müßte zu großen Teilen über „Stromautobahnen“ nach Süden gebracht werden.

Das Problem des Stromtransfers nach Süden

Eigentlich sollten die „Stromautobahnen“ nach dem Auslaufen der Kernkraftwerke in 2022 fertig gestellt sein. Aber die Fertigstellung verzögert sich über einen vermehrten Ausbau über Erdkabel, die eine Fertigstellung erst nach 2025 erlauben.

Würde theoretisch in einem Gedankenexperiment unterstellt, dass lediglich nur die angesetzten rd. 100 GW über Offshore-Wind nach Süden zu transferieren wären, so müßte dieser Nord-Süd-Link für eine solche Kapazität ausgelegt sein.

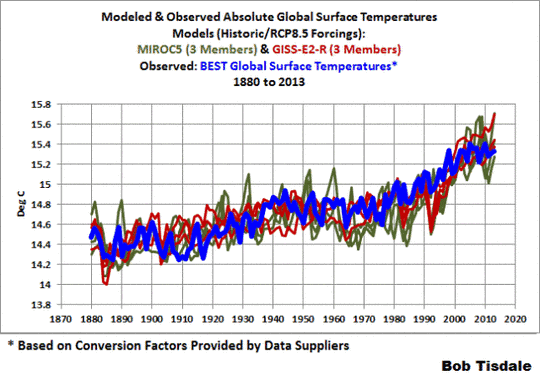

Es zeigt sich aber, dass sich Strom aus Wind offshore- obwohl stets behauptet- nicht als Grundlast einstufen läßt (z.B. Mai 2016; Bild 9). (16)

Bild 9

Offshore-Strom folgt in seinen Schwankungen dem Onshore-Strom, d.h. Windflauten an Land decken sich mit Windflauten auf See.

In gleicher Weise kann bei Windstrom generell nicht davon ausgegangen werden, dass irgendwo in Europa stets ausreichend Wind weht, um Windflauten an anderer Stelle auszugleichen (Bild 10).(10) Im Bild sind die Windstromkapazitäten von praktisch allen Deutschland nahe liegenden Ländern neben denen von Deutschland eingetragen. Eindeutig überlappen sich Stark- und Schwachwindzeiträume in allen Ländern.

Folglich würden bei einem mittleren Nutzungsgrad von Wind offshore von 30% dann im Mittel 30 GW für den Süden angeboten werden, wobei die Schwankungsbreite zwischen praktisch Null und 100 GW läge.(Z.Z. sind 5 HGÜ-Verbindungen mit einer Übertragungskapazität von je 2 GW vorgesehen (Internet)).

Bild 10

Um eine mittlere Leistung von 30 GW anbieten zu können, müßten dann im Sinne von Bild 5 die oberhalb des mittleren Leistungsangebotes von 30 GW anfallende Stromkapazität gespeichert werden und in Zeiten nicht ausreichender Leistungen unterhalb der mittleren Stromerzeugungskapazität wieder eingespeist werden.

Wie soll nun ein für die mannigfaltige und auf Strom mit hoher Qualität angewiesene Industrie im Süden Deutschlands ein entsprechender Strom geliefert werden- ohne Stromspeicher- von den immensen Netzkosten abgesehen?

4.Fazit

Das für eine Industrienation beschämende und stümperhafte Vorhaben „Energiewende“ wird kläglich scheitern – das Ausland lacht.

Etwa 90% der Deutschen glauben an einen durch den menschlichen CO2-Ausstoß verursachten tödlichen Klimawandel, obwohl es dafür keinen einzigen Beweis gibt.

Seit dem es die Erde gibt, gibt es Klimawandel – im Mittelalter wurden sogar teilweise zu Weihnachten Erdbeeren geerntet.

Wie konnten sich die Deutschen so verrennen?

Das „Intergovernmentel Panel on Climate Change“ (IPCC), der Klimarat der Vereinten Nationen (gegründet 1988), hatte durch gefälschte Temperaturmessungen und über wissenschaftlich fragwürdige Modelle zum Einfluß von CO2 auf die Klimaerwärmung die Welt aufhorchen lassen.

Gleichzeitig nahm El Gore u.a. diese Aussage als Vorlage für eine beispiellose Kampagne gegen das CO2 in weltweiten Vorträgen und sparte nicht mit atemberaubenden Aussagen zum Anstieg des Meeresspiegels, was ihm auch noch den Nobelpreis einbrachte und ihn schließlich auch noch zu einem reichen Mann machte.

Die deutschen, grün ausgerichteten Politikjournalisten (26,9% stehen den Grünen nahe, 15,5% der SPD, 9% der CDU, 7,4% der FDP, 4,2% den Linken; 37% politisch neutral) nahmen diese Vorlage gerne auf und setzten in Bildern z.B. den Kölner Dom unter Wasser, sprachen von unerträglichen Temperaturanstiegen, vom Abschmelzen der Pole, vom Schwund der Eisbärpopulationen,etc..Die Kirchen riefen zum Kampf gegen das Höllenfeuer auf Erden durch zunehmende CO2-Gehalte auf, ganz zu schweigen von deutschen Wissenschaftlern, die davor warnten, dass sich die Ozeane in „Sprudelwasser verwandeln“ oder den Tropen der „Ökozid“ droht, etc., etc..

Aber auch bestimmte Parteien und die weitgehend von Spenden abhängigen Nichtregierungsorganisationen folgten ohne Verifikation von Fakten diesem Trend. Sogar ein „Ethikrat“, bestehend aus Bischhöfen, Soziologen, Politikern etc.wurde für technische Fragestellungen mißbraucht (Ausstieg Kernenergie).

Der Start einer emotionalen Irrationalität hatte hinsichtlich Klimawandel und Energiewende begonnen, Fakten wurden mit einer absoluten Moralisierung zugedeckt.

Damit war in der deutschen Öffentlichkeit die Basis für eine einzigartige Ausbreitung von Angst gelegt, von der der Soziologe N.Luhmann sagte:“Angst widersteht jeder Kritik der reinen Vernunft. Wer Angst hat, ist moralisch im Recht“.

Der Philosoph N.Bolz ging noch weiter:“Wenn christliche Religionen die Menschen nicht mehr ansprechen, suchen sie Ersatzreligionen. Und die mächtigste der gegenwärtigen Ersatzreligionen ist die grüne Bewegung, das Umweltbewußtsein“.

Damit ist der Weg verschlossen zu dem, was Horaz schon vor 2000 Jahren sagte:“Sapere aude“ (wage zu verstehen, deinen Verstand zu gebrauchen).

Im religiösen Mittelalter wurde dieser Verantwortung nicht nachgekommen. Hexen wurden für klimatische Veränderungen verantwortlich gemacht und verbrannt.

Erst Immanuel Kant übersetzte dann in der Aufklärung das „Sapere aude“ mit „Habe den Mut, dich deines Verstandes zu bedienen“.

Bei der geistigen Schaffung dieser Energiewende wird die Anwendung des eigenen Verstandes wieder außer Kraft gesetzt – wir sind wieder im Mittelalter angekommem. Wir bewegen uns auf dem geistigen Niveau von Aussagen wie:“Die Sonne schickt keine Rechnung“ oder „Der Strom aus den konventionellen Kraftwerken verstopft das Netz. Die Forderung muß deshalb lauten, Kohlekraftwerke aus dem Markt zu nehmen“ (Umweltminister NRW). (17)

Nun rennen wir wie die Lemminge von einem bestens funktionierenden Industriestaat zurück in einen mittelalterlichen Agrarstaat.

Dr.-Ing. Erhard Beppler

Quellen

1. Spencer, R: www.drroyspencer.com

3. FAZ, 09.06.2016

4. Beppler,E.: „Energiewende 2014- ein Debakel“BoD 2015; ISBN 978-3-7386-9418-5

5. Schuster, R.: Mitteilung vom 02.05.2014 – siehe auch (4)

6. Schuster, R.: Mitteilung von Juni 2016

7. Öllerer, K.: Windenergie in der Grund-, Mitte- und Spitzenlast: www.oellerer.net; siehe auch (4)

8. Bundesverband der Energie- und Wasserwirtschaft (BDEW)

9. Schuster, R.: Mitteilung Juni 2016

10. Schuster, R.: Mitteilung Januar 2016

11.Mueller, F.F.: „Netzstörungen: Der unheilbare Erbdefekt der Energiewende“, EIKE, 27.01.2016

12. FAZ, 04.05.2016

13. Beppler, E.: Energiewende- Zweite industrielle Revolution oder Fiasko“, BoD, 2013; ISBN 978-3-7322-0034-4

14. Mueller,F.F.: EIKE,29.01.2014

15. Mueller, F.F.: EIKE, 03.05.2015

16. Schuster, R.: Mitteilung 14.06.2016

17. FAZ, 16.06.2016