Teil 2

Die Pause

Nicht nur EIKE Leser wissen, dass die Erwärmung seit langem, beginnend irgendwo zwischen 1995 bis 1998, eine Pause eingelegt hat. Das wissen auch die Kollegen von Stocker und suchen verzweifelt nach Erklärungen dafür. Hier haben wir die ersten 66 davon zusammengetragen. Nur Stocker sieht die Pause nicht und versucht mit spitzfindigen Hinweisen auf Feinheiten der Trendbestimmung den Eindruck zu erwecken, dass es „die Pause „ gar nicht gibt.

Daher hier ein paar Kostproben seiner Einlassungen dazu:

Min 8:35 … es kommt sehr darauf an, wann sie beginnen die 15 Jahre zu berücksichtigen…Min 9:45 von 1998 bis 2012 kriegen Sie einen Trend von 0,05 pro Jahrzehnt … …Min 10:16 …das sollte genügend Hinweis sein, dass man nicht 15 Jahre nehmen darf um einen Klimatrend festzustellen. Min 10:41 nicht nur 2015 war ein Rekordjahr sondern auch 2014 war schon wärmer als alle Jahre zuvor – Anmerkung des Verfassers Widerspruch zu Minute 08:55 ….und zuvor nicht jedes Jahr ist wärmer, nicht jedes Jahrzehnt ist wärmer ….. Min 10:50– ich sage nicht, dass wir den Klimawandel beweisen mit 2015, das geht nicht….. es geht nicht einmal mit nur 15 Jahren. Wie ich zuvor ausgeführt habe… sie müssen die Trends genau ausrechnen aus genügend langen Zeitreihen (11:07)…

Video als Audio incl. aller Folien des Vortrages von Prof. Thomas Stocker am 10.5.16 in Vaduz

Nun hat niemand von den Skeptikern behauptet, dass 15 Jahre für sich die Bestimmung eines Klimatrends erlaubten, d.i. eine Beachtung wissenschaftlicher Prinzipien, denen sich die Alarmisten um Stocker und Gefährten allerdings nicht verpflichtet fühlen, denn sie ordnen ungerührt jeden Starkregen, jede Hitzewelle, jeden Sturm oder Tornado, jede Überschwemmung regelmäßig dem „Klimawandel“ á la IPCC zu. Div. Äußerungen zu den jüngsten Regenfällen und Überschwemmungen (Siehe auch Video des Teams von „Klimamanifest von Heiligenroth) dokumentieren das vielfach.

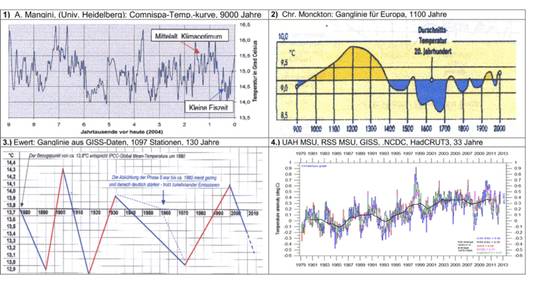

Doch hier geht es um die „Pause“, also den Stopp weiterer Erwärmung trotz ständig steigenden CO2 Emissionen. Und alle offiziellen Datenreihen zeigen sie. Mit einer Ausnahme, das ist die jüngste Datenreihe des Goddard Institute for Space Sciences kurz GISS.

Robert Brown von der DUKE Universität hat sich deshalb die Zeitreihen daraufhin genau angesehen und Werner Brozek und Walter Dnes haben sie in Auszügen veröffentlicht[11].

Dort finden wir: Zusammenfassung

For UAH[12]: There is no statistically significant warming since May 1993

For RSS: There is no statistically significant warming since October 1993

For Hadsst3: There is no statistically significant warming since July 1996.

For GISS: The warming is significant for all periods above a year.

Interessant dabei: RSS und UAH greifen auf denselben Datensatz zu, in diesem Fall von Satelliten erfasst, wie auch HadCrut[13] und GISS auf den terrestrisch erhobenen Datensatz

Da die Auswertungen von Hadcrut und GISS stark voneinander abweichen, aber nicht beide gleichzeitig richtig sein können, ist es möglich stundenlag darüber zu streiten welche der beiden richtig ist. Das GISS ist seit längerem dafür bekannt, seine Datenreihen ständig in Richtung Erwärmung zu „adjustieren“[14]. Daher empfiehlt es sich der Vernunft zu folgen und die Satelliten-Werte von RSS und UAH als Schiedsrichter zu verwenden.

Und damit erkennen wir den Beginn der „Pause“

irgendwo zwischen 1993 bis 1996 und dauert bis heute

d.h die „Pause“ dauert nun schon zwischen 20 bis 23 Jahre!

Sie beginnt also deutlich vor der Stocker´schen Angabe von 1998

Rückgang der Gletscher

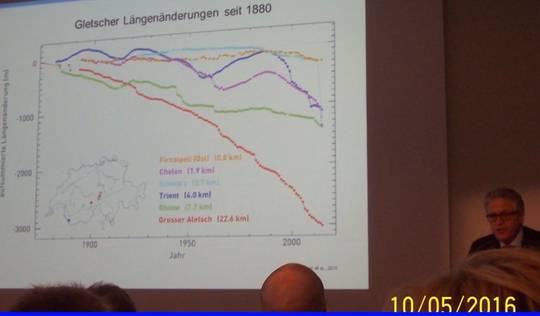

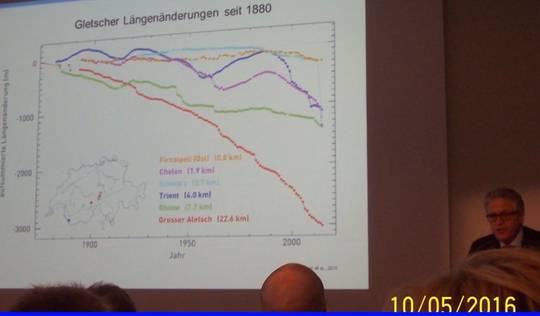

Stocker fährt fort die Auswirkungen des „Klimawandels“ nach IPCC Regeln in den schwärzesten Tönen zu malen. Zunächst kommt der Rückgang der Gletscher und „Eiskörper“ dran.

Min 12:04 …der große Aletschgletscher, … der sehr stark zurückgegangen ist …Min 12:08 sicher eine Kombination der natürlichen Klimavariabilität und eine erste Reaktion von Eisköpern und Gletschern auf die Erwärmung

Abbildung 8 Folie von Stocker der Rückgänge einiger Alpengletscher seit 1880. Er führt sie auf eine Kombination von „natürlicher Klimavariabilität“ und (menschgemachter) Erwärmung zurück

Kleine Eiszeit vs. Aletschgletscher

Mehr bringt Stocker zu diesem Thema nicht, kann er sich doch sicher sein, dass in der Alpenrepublik Schweiz und dem eingelagerte Fürstentum Liechtenstein jede Erwähnung des Rückganges der Gletscher als große Bedrohung empfunden wird.

Er erwähnt auch mit keinem Wort die „kleine Eiszeit“, also die Zeit vor der jüngsten Klimaphase, die in allen vorhandenen Berichten als sehr schlechte Zeit für Mensch und Tier beschrieben wurde und immerhin um die 500 Jahre dauerte. Auf dieses Manko von mir angesprochen weicht er aus und verweist fälschlich auf seine Aussagen zum Aletschgletscher

Doch die Gletscher-Geschichte hat mit der Erwärmung durch den „Klimawandel“ á la Stockers IPCC und anders als dieser behauptet, nichts Erkennbares zu tun.

Der inzwischen emeritierte Glaziologe der Universität Innsbruck Prof. em. Gernot Patzelt, kommt daher auf eine ganz andere Erklärung. Seinen intensiven Gletscherforschungen nach, ist die momentane Erwärmung nichts Besonderes. So gab es sehr, sehr häufig in den letzten 10.000 Jahren sowohl wesentlich höhere Temperaturen, aber auch steilere Rückgänge als heute,. In mehr als 66 % der Zeit, lag die Sommertemperatur der Alpen z.T. deutlich über der heutigen.

Abbildung 9 Temperaturverlauf (Sommertemperaturen) der Alpen und in Grönland der letzten 10.000 Jahre. Es ist klar erkennbar, dass mehr als 2/3 der Zeit die Temperaturen deutlich höhere Temperaturen zu beobachten waren als heute. Grafik und Daten Gernot Patzelt. Aus Wald- und Gletscherentwicklung in den Alpen in den letzten 10.000 Jahren, zur 9.IKEK 11.12 Essen

Video Teil 1 des Faktenchecks den das Team von Klimamanifest von Heiligenroth mit z.T. anderen Schwerpunkten angefertigt hat

Extremereignisse

Dann wurde vom Vortragenden vom allgemeinen „Klimawandel“ ins Besondere übergegangen. Doch auch hier nur Schreckensbotschaften.

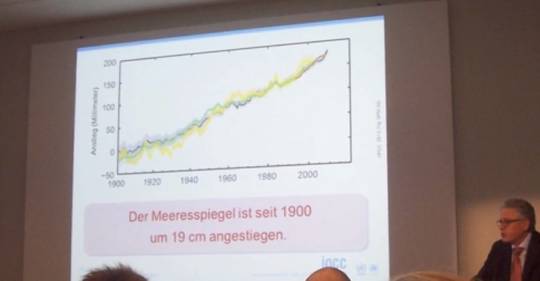

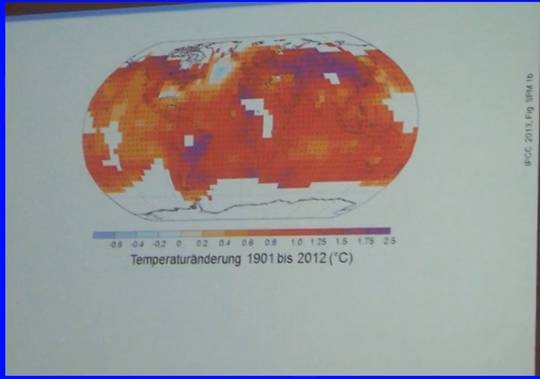

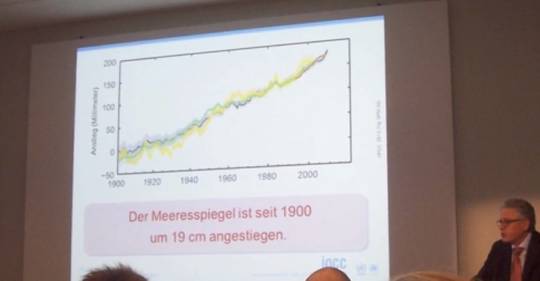

O-Ton Stocker Min 15:14 Der Klimawandel manifestiert sich nicht nur in der Temperatur (Bild Meerespiegelanstieg) es sind viele Größen, die sich verändern u.a. der Meeresspiegel (Bild der Msp ist seit 1900 um 19 cm angestiegen)

Abbildung 10: zeigte die Stocker Folie „nach verschiedenen unabhängigen Daten“ des Meerespiegelanstiegs von 1900 bis 2012

Und….Min 15:40 Meereisbedeckung hat sich verändert (Bild Arktis) …und so gibt es viele Messungen …viel Größen im (16:15) Klimasystem dann folgt (Min 16:17 ohne weitere Erklärung)… aus dem Synthesereport

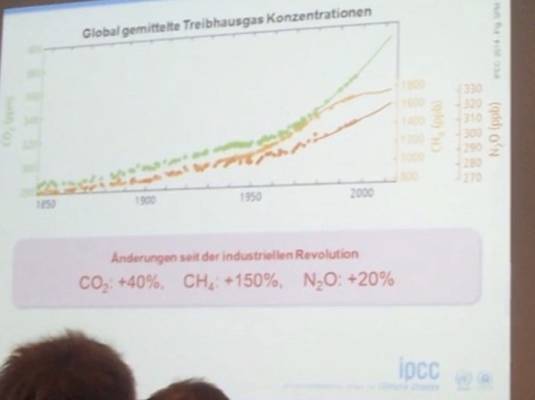

… sie zeigt die Ursache des Klimawandels

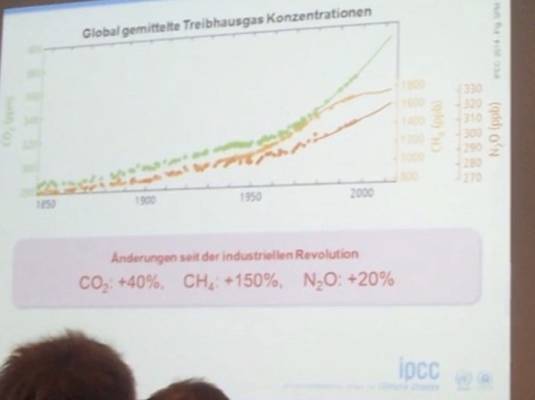

Abbildung 11: zeigt die Ursachen des Klimawandels „nach genauen Messungen“ von 1850 bis 2013

…dann folgen Zahlen über den Anstieg.. (Tonstörung) von CO2, CH4 etc. Min 18:10 Bild: Die mensch-verursachten Emissionen sind die höchsten der Geschichte

(Anmerkung erst seit 1956 werden sie hinreichend genau gemessen, davor nur sehr ungenaue Messungen aus Eisbohrkernen)

…Der (globale) Meeresspiegel steigt…

Schauen wir uns zunächst den (globalen) Meeresspiegel an. Zunächst einmal sollten wir fragen, ob es den denn gibt? Jeder weiß, oder glaubt zu wissen, dass es ihn gibt. Aber gibt es den globalen Meeresspiegel überhaupt? Und was macht die Erwärmung für seinen Anstieg aus? Weiß doch jeder, dass sich Wasser bei Erwärmung ausdehnt.

…durch Erwärmung…

Zunächst sollte man sich die Frage stellen: Kann eine äußerst geringe – und nur um die handelt es sich hier – und auch nur vermutete- Erwärmung der Luft, um 0,8 bis 1,0 C die Riesenwassermenge der Ozeane wirklich so schnell erwärmen? Wer das einfach so glaubt, möge bitte nur ein paar überschlägige Berechnungen mit Wissen aus der frühen Oberstufe vornehmen.

…gerade einmal um 3cm –pro Jahrhundert!

Hierzu ein Beispiel:

Erwärmt[15] sich eine durchgängig 15 Grad warme und 3.700 m lange Meeressäule um 1 Grad, wächst sie um 55 cm. Es muss aber noch eingerechnet werden, dass die Temperatur mit zunehmender Tiefe und der Ausdehnungskoeffizient mit sinkender Temperatur rapide sinken, dann reduziert sich der Anstieg auf gerade mal 3 cm. d.h. die wenn sich die gesamte Erwärmung des letzten Jahrhunderts auf das Meerwasser übertragen hätte, wäre das gerade mal um 3 cm, zwar mit großer Verzögerung, aber insgesamt gestiegen. Mehr geht nicht. Doch auch diese Annahme ist unrealistisch denn…

…Es wird allgemein geglaubt und verkündet, dass sich das Meer erwärmt, weil die Luft darüber wärmer wird. Wer das verinnerlichen möchte, der möge sich vor eine mit kaltem Wasser gefüllte Badewanne hocken und so lange mit seinen Atem über die Oberfläche blasen, bis das Wasser die Nähe von 37 Grad erreicht. Die Gesetze der Wärmeübertragung besagen, dass kaum die Luft, sondern überwiegend die Strahlung zur Erwärmung führt, und die wird durch die Wolkenbedeckung bestimmt.

Und was liefern die Gletscher?

Würde das gesamte Eis Grönlands schmelzen, wird der Meeresspiegel um circa 6 m steigen. Würde sich die gegenwärtige Abschmelzrate von 250 km^3 auf angenommen üppige 500 km^3 erhöhen, dann würde das komplette Abschmelzen ca. 6.000 Jahre dauern, d.h. es gäbe einen Anstieg um ca. 10 cm in einem Jahrhundert.

Nur, die weitaus größte Eismenge von über 90 % ist in der Antarktis gebunden. Doch die Antarktis denkt nicht daran zu schmelzen, was sie früher, als es dort deutlich wärmer war als heute – besser gesagt : deutlich weniger kalt als heute- auch nicht tat. Wie eine neue Studie herausfand[16] war die Antarktis häufiger in den letzten 8000 Jahren wärmer als heute. Ganz ohne anthropogenes CO2.

Nur in Grönland, das weitere 9 % der Eismasse beherbergt, tauen die Ränder. Die von Stocker als Beispiel gezeigte schmelzende Arktis taugt hingegen nicht dazu, denn es handelt sich um Meereis, dessen Schmelzen keinen Einfluss auf den Meeresspiegel hat.

Und dass das Schmelzen der Alpengletscher oder anderswo einen messbaren Einfluss auf den Meeresspiegel hat, glaubt Stocker sicher selber nicht.

Globaler Meeresspiegel

Und damit sind wir wieder bei der Frage gibt es ihn, oder gibt es ihn nicht. Man braucht ja nur an die Küste fahren, auf endlose Meer blicken, sich an die Schulphysik, mit der Sache von den kommunizierenden Röhren erinnern und schon ist klar, dass es

a) einen globalen Meeresspiegel gibt und

b) dass dieser – glaubt man Stocker und dem Rest des IPCC- steigt durch die globale Erwärmung.

Doch an diesen beiden Aussagen ist fast alles falsch. Es gibt den globalen Meeresspiegel ebenso wenig wie die globale Mitteltemperatur, sondern viele verschiedene Meeresspiegel, die an manchen Standorten[17] an der Küste seit vielen Jahrzehnten eher weniger als mehr genau – per Pegelmessung- gemessen werden. Und alle sind verschieden und verhalten sich auch sehr verschieden. Insgesamt definiert die Forschung ca. 15 Einflussgrößen, welche auf den Meeresspiegel wirken. Die thermische und der Zufluss von Gletscherwasser gehören zu den kleinsten.

Die lokalen Pegelstände werden – zwar nicht vollständig- seit 1933 in der PSMSL Datenbank erfasst und stehen dort der Forschung zu Verfügung Die dort abrufbaren lokalen Pegelmessungen können allerdings nicht direkt zur Berechnung des GMSL herangezogen werden. Sie müssen, wie die lokalen Temperaturdaten, einer Fülle von Anpassungen und Korrekturen unterzogen werden, um verwendet werden zu können. Man versucht dazu aus den relativ wenigen vorhandenen Langzeitbeobachtungen der Pegelhöhe von div. Küstenorten, die Veränderungen des Pegels auf den gedachten Meeresspiegel zu beziehen, d.h. herauszurechnen. Das ist mindestens so schwierig wie die Temperaturbestimmung. Manche meinen, es sei noch schwieriger, weil die Datenbasis noch viel dünner ist und es keinen absoluten Bezugspunkt gibt.

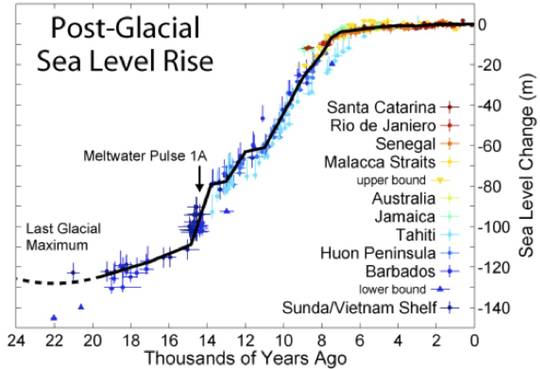

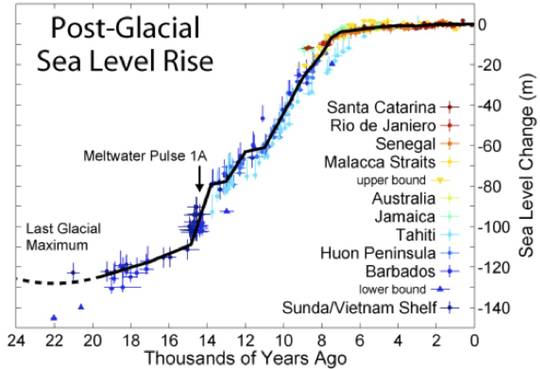

Abbildung 12:Anstieg des globalen Meeresspiegels seit dem Ende der Eiszeit. Deutlich zu erkennen, dass dieser seit ca 9.000 Jahren nur noch moderat und seit ca. 6000 Jahren sehr moderat ansteigt. (Weitere Details dazu u.a. hier ) Einen wunderbaren Überblick über den gegenwärtigen Stand der Meerespiegelforschung hatte zuletzt EIKE Autor Kuntz[18] zusammengetragen. Er untersuchte viele Forschungsergebnisse, welche die letzen 10.000 Jahre (Holozän) abdecken

Sein Fazit lässt an Deutlichkeit nicht zu wünschen übrig:

Auch in den AR5 übernommene Daten spiegeln die in den vorherigen Kapiteln aufgezeigte Problematik direkt wieder. Es ist nicht erkennbar, dass die Datenlage darin verlässlich besser wäre. Jedoch wird dies im AR5 nicht erwähnt, sondern Aussagen mit Vertrauensbereichen abgeleitet, welche bezweifelt werden dürfen.

Fazit zum Pegelverlauf der letzten zwei Jahrtausende

Es ergibt sich das gleiche Bild wie schon bei der Recherche der Temperaturproxis [11] “Rekonstruierte Temperaturverläufe der vergangenen zwei Jahrtausende”: Eine verlässliche Datenbasis liegt nicht vor. Von einer hohen Sicherheit über die wirklichen Pegelverläufe (mit der erforderlichen Genauigkeit) kann keine Rede sein.

Und es fällt wieder auf, dass es in historischer Zeit mit ziemlicher Sicherheit erheblich größere und auch schnellere Schwankungen gegeben hat, als es die Verläufe im AR5 zeigen. Der Verdacht einer unzulässigen Glättung, vergleichbar der Hockeystick-Darstellung zur Temperatur drängt sich geradezu auf [11].

Die einzige mögliche Folgerung daraus ist:

Mit einer so widersprüchlichen bzw. ungenauen Datenbasis ist keine Zukunfts-Pegelsimulation auch nur im Ansatz glaubhaft kalibrierbar oder verifizierbar! Auch eine Aussage, ob die aktuelle Schwankung nicht doch natürlich sein kann ist nicht möglich. Was aktuell von der Klima-“Wissenschaft” an Zukunft simuliert wird, ist eher ein Würfelspiel welches nur auf immer teureren Rechnern durchgeführt wird.

Und damit ist es auch kein Wunder, dass “Jeder” beim Simulieren etwas Anderes ausgespuckt bekommt.

Wer nun richtig liegt, Stocker oder der kritische Ingenieur Kuntz, mag sich der Leser aussuchen. Es bleibt die Frage, wie Stocker und Kollegen auf ihre spektakuläre Aussage vom gefährlich ansteigenden Meeresspiegel kommen? Dies ist nicht recht ersichtlich, dient aber dem Alarmismus.

Fazit:

Die Ausführungen von Stocker sind zwar IPCC konform, in der Sache aber völlig unbestimmbar und daher spekulativ übertrieben. Ihre Zuordnung zur Ursache ist daher rein alarmistisch und durch nichts begründbar

Hitzewellen und Starkniederschläge

Im Vortrag (etwa um Minute 30) und später zu meinem Kommentar (ca. Minute 49:00) äußerte sich Stocker auch zur Zunahme der Extremereignisse, namentlich von „Hitzewellen und Starkniederschlägen, die als einzige dem Klimawandel zugeordnet werden können“.

Trotz Widerspruchs beharrte Stocker auf dieser Behauptung. Ich bat ihn daher in einer Mail zur Klärung der Fakten diese zu belegen. Diese Klärung erfolgte leider nicht.

Warum?

Weil 40 Jahre Klimawandel à la IPCC diese Erhöhung der Extremwetter bisher nicht erkennen lassen. Im Gegenteil, viele Extrem-Wetterphänomene wurden weniger und manche sogar schwächer. Im den IPCC Bericht zu „Extremereignissen“ zu lesen wir dazu:

Über tropische Stürme und Hurrikane [IPCC 2013, AR5, WGI, Kapitel 2, Seite 216]: “No robust trends in annual numbers…“

Über tropische Zyklone

[IPCC 2013, AR5, WGI, Kapitel 2, Seite 216]: “Current datasets indicate no significant observed trends….”

Über außer-tropischeZyklone[IPCC 2013, AR5, WGI, Kapitel 2, Seite 220]: “In summary, confidence in large scale changes in the intensity of extreme extra tropical cyclones is low …“

Über Dürren [IPCC 2013, AR5, WGI, Technical Summery,

Seite 50]:”There is low confidence in a global-scale observed trend in drought or dryness …“.[IPCC 2013, AR5, WGI, Kapitel 2, Seite 215]: “In summary, the current assessment concludes that there is not enough evidence at present…“

Zu Überflutungen

[IPCC 2013, AR5, WGI, Technical Summery, Seite 112]: ”There continues to be a lack of evidence and thus low confidence …“

Über Hagel und Gewitter (Starkniederschläge)_ [IPCC 2013, AR5, WGI, Kapitel 2, Seite 216]: “In summary, there is low confidence in observed trends in small-scale ..“

Zusammenfassung des_[IPCC 2013, AR5, WGI, Kapitel 2, Seite 219]:

“There is limited evidence of changes in extremes associated with other climate variables since the mid-20th century.”

Fazit:

Extremwetterzunahmen im jüngeren Klimazeitraum sind von den Wetterdiensten nicht auffindbar.

Zur kleinen Eiszeit bzw. der Rückerwärmung danach

Als ich dann in der Diskussionsrunde erwähnte, dass er die kleine Eiszeit in seinem Vortrag und die (u.E.n. völlig natürliche) Rückerwärmung danach nicht erwähnte, korrigierte Stocker mich und verwies auf Ihre Ausführungen zum Aletsch-Gletscher. Doch auch da erwähnten er die kleine Eiszeit mit keinem Wort – er stellte nur fest, dass der Rückzug des Aletsch „..sicher eine Kombination der natürlichen Klimavariabilität …und der ersten Reaktion von Gletschern und Eiskörpern auf die Erwärmung, die stattgefunden hat…..ist“.

Wieder zeigten er allein Klima-Phänomene, aber lieferte keinerlei Beleg für seine „wirkliche Realität“, (O-Ton Stocker) dass das CO2 ursächlich daran schuld sei.

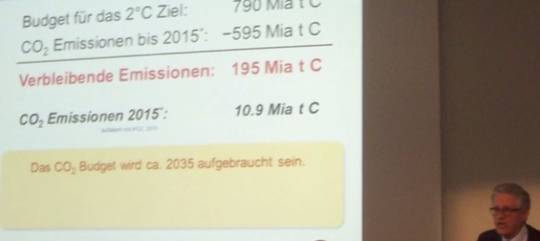

Zum Carbon Budget

Mit dem Aufzeigen des sog. Carbonbudget kam Stocker zum eigentlichen Ziel seines Vortrages. Nach den Schrecken des Klimawandels – ausgelöst durch das anthropogene CO2- und umgerechnet auf die seiner Meinung gerade noch zulässige Erzeugung desselben (wenn man das 2 ° Ziel noch halten will), forderte er dann die vollständige

Dekarbonisierung der Wirtschaft.

Dazu zeigte er eine Folie mit der er das sog. Carbonbudget einführte. Sie zeigt dessen Veränderung seit Beginn der Industrialisierung (was immer das heißen mag), sowie das, was nach Meinung „der Wissenschaft“ noch zulässig emittierbar wäre. Ausdrücklich deklarierte Stocker das dort Gezeigte mit viel Nachdruck als „wissenschaftlich“ und damit als unabweisbar und wahr.

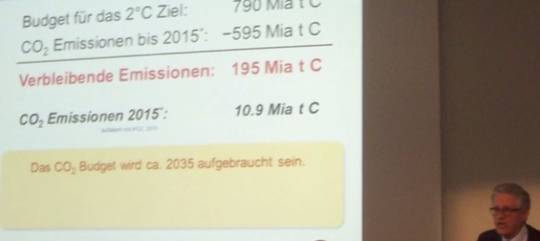

Abbildung 13:Bereits verbrauchtes und noch zulässiges „Budget“ an Kohlenstoff Äquivalent nach Stocker

Dann berichteten er kurz über die Idee des Budgets an Emissionen -je nach zulässiger Erhöhung um 2°, 3° oder gar 4,7 °- CO2. Doch wie er zu dieser Budget-Berechnung überhaupt gekommen waren (ab Min 32:25), erklärte er – auch auf Mail-Nachfrage- nicht.

Seine Konsequenz ist, dass für das 2° Ziel noch 195 Mio t Cequiv (Anmerkung: Ceqiv ist die Menge an Kohlenstoff C die im CO2 gebunden ist, sowie die aus anderen Treibhausgasen umfguerechnete CO2 Menge, bzw. deren Ceqiv) an Emissionen zur Verfügung stünden, dann wäre das „Budget“ von 790 Mio t Cequiv erreicht.

Abgesehen von der nicht unwichtigen Frage, warum er dem Publikum den erheblichen Unterschied zwischen Emissionen und atmosphärischer CO2 Konzentration und die Tatsache, das es einen um knapp zwei Potenzen größeren natürlichen CO2-Kreislauf gibt, nicht einmal im Ansatz zu erklären versuchte, bleibt auch offen, was ihn zu dieser Behauptung gebracht hat.

Ich vermute, dass er sich zur Berechnung des Budget im Wesentlichen der (Equilibrium) Climate Sensitivity (CS oder ECS) bediente. Die gibt an, um wieviel die Temperatur rechnerisch bei Verdopplung der Treibhausgaskonzentration ansteigt. Das Problem mit diesem rein hypothetischer Rechenwert ist jedoch, dass er als Wert sich -bisher jedenfalls – jeder genauen Bestimmung entzogen hat. Das mussten auch seine Kollegen einsehen, welche die Summary für Policymakers (SPM) schrieben bzw . redigierten, denn dort steht– wenn auch in einer Fußnote versteckt – auf S.16:

„ No best estimate for equlibrium climate sensitivity can now be given because of lack of agreement on values across assessed lines of evidence and studies“.

Doch in seinem Vortrag ignorierte Stocker nicht nur dieses IPCC Eingeständnis, er beschäftigte sich nicht einmal mit dieser wichtigen Frage, sondern stellte einfach die o.a. Behauptungen in den Raum.

Wir wollten versuchen dem Geheimnis auf die Spur zu kommen und baten Stocker um Aufklärung. Doch die kam nicht. Daher können wir nur vermuten, dass er mit großer Wahrscheinlichkeit den politisch „offiziellen“ IPCC Wert von 3 °C für seine Berechnungen einsetzte. Anders kommen die von ihm genannten Zahlen auch nicht zustande.

Also per THG Verdopplung ergibt sich eine Temperaturerhöhung von 3 °C.

Thomas Stocker müsste jedoch wissen – und weiß es sicher auch – dass ein ECS mit 3 °C nach heutigem Wissen völlig unhaltbar ist, weil sich gerade in jüngster Zeit die Studien häufen, welche diesen Wert auf unter 1 °C verorten, manche gehen sogar bis auf 0,45 °C ± 30 % und noch weiter herunter.

Wendet man diese Werte an, dann erledigt sich das „Problem Klimaerwärmung“ von selbst. Auch deswegen, weil selbst bei Verwendung des sog. Berner Modells zur Berechnung der CO2 Konzentration aus den Emissionen, (ein Modell, welches erlauben soll, die Zunahme der CO2 Konzentration aus den anthropogenen Emissionen zu bestimmen – an dessen Definition Stocker vielleicht sogar beteiligt war- mit 3 verschiedenen Halbwertzeiten für den „Zerfall“ des CO2 in der Atmosphäre,) die Berechnungen zeigen, dass, selbst wenn man ein exponentielles Wirtschafts-Wachstum für die nächsten acht Jahrzehnte annimmt und man dafür jeden Tropfen der 1580 Gigatonnen-High-End-Schätzung der fossilen Reserven verbrennen würde, der CO2-Gehalt immer noch nicht doppelt so hoch wäre wie heute.[19]

Auch die 600 ppm Marke, also eine Verdopplung gegenüber dem -auch nur vermuteten- vorindustriellen Wert, würde schwerlich erreicht werden. All diese wichtigen Ergänzungen fehlten leider in Stockers Vortrag.

Und last but not least ließ er auch die – im Gegensatz zur Klimahypothese- eindeutig belegte positive Wirkung des CO2 Anstiegs auf den Pflanzenwuchs und damit auf die Welternährung völlig unberücksichtigt.

Angeblich fehlende Mitwirkung Skeptiker

Am Ende seiner Ausführungen sagte Stocker die folgenden Sätze

Min 50:45 ..Sie haben 3 x Gelegenheit gehabt unseren Bericht zu begutachten. Drei mal!… wir haben insgesamt 54.677 Kommentare erhalten, …wir haben auf jeden Kommentar schriftlich reagiert…im Internet verfügbar…Ich hatte eigentlich gehofft als Vorsitzender der Arbeitsgruppe 1, als ich das Amt übernommen hatte..in einer turbulenten Zeit wie Sie sich erinnern können, dass ich sehr viele intelligente Kommentare von Klimaskeptikern kriege, die wir dann Punkt für Punkt adressieren können….leider hat es sich dann herausgestellt, dass niemand von diesen Leuten, die in den Blogs(?) sehr aktiv waren, bei uns beigetragen haben. Tut mir Leid! Wir konnten auf diese Expertise nicht zurückgreifen. (Zwischenruf Limburg) Das stimmt nicht

Und es stimmt auch nicht. Bspw. hat Dr. Vincent Gray aus Neuseeland überschlägig ca. 800 Kommentare eingereicht, ebenso reichten, um nur einige weitere zu nennen, Prof Singer und Lord Monckton viele tlw. umfangreiche Kommentare ein, aber erhielten nie eine Antwort.

Auf meine spätere Nachfrage räumte Stocker dies auch ein, hielt es aber nicht für angebracht sich für seine öffentliche Falschinformation zu entschuldigen. Er sandte mir aber eine pdf Datei mit allen Kommentaren von V. Gray und deren Behandlung seitens seiner Arbeitsgruppe. Nach erster Sichtung wurden die allermeisten Kommentare „rejected“.

Ob dies aus objektiven oder subjektiven Gründen geschah, ist für diese Thematik eigentlich jetzt nicht relevant. Denn Tatsache bleibt, dass entgegen seiner klaren Ansage vor dem LIFE Auditorium, die „Klimaskeptiker“ hätten „trotz dreimaliger Gelegenheit“ zu diesen 54.677 Kommentaren nichts dazu mit „ihrer Expertise“ beigetragen, falsch ist. Und, da er es besser wusste, sogar vorsätzlich falsch. Auch die umfangreichen Kommentare von S.F. Singer und Ch Monckton räumte Stocker nachträglich ein, verwies jedoch nur auf die IPCC Website um sie zu finden. Das ist uns bis heute nicht gelungen.

Fazit:

Ab Min 42:20, wies Stocker auf die so wichtige Glaubwürdigkeit hin

„Das Grundlegende was wir in dieser komplexen Situation tun können ist unsere Glaubwürdigkeit pflegen…damit die Entscheidungsträger nicht auf irgendwelchen Halbwahrheiten oder Partikular Interessen entscheiden müssen sondern auf den Fakten die die Wissenschaft zur Verfügung stellt.“

Prof. Thomas Stocker hat also seine Aussagen bei klarem Bewusstsein, klarer einfacher Sprache, ohne jeden Zweifel und im Brustton des ehrlichen Wissenschaftlers vorgetragen.

Und er hat damit die Zuhörer überzeugt.

Nach seinen Worten gibt es keinen Zweifel, dass der „Klimawandel“ menschgemacht ist und fürchterlich für diesen Planeten wird, wenn wir nicht durch „Dekarbonisierung“ massiv und unverzüglich gegensteuern.

Als Ergebnis dieses Gegensteuerns mittels Dekarbonisierung schildert er -wieder ohne jeden Zweifel- als zukünftiges Paradies, mit einer Energieversorgung aus „Erneuerbaren“!

Die Fragwürdigkeit von Stockers Behauptungen und „Beweisen“.

Auf den vorigen vielen Seiten – kürzer ging leider mal wieder nicht, wofür ich mich entschuldige- habe ich versucht die ganze Fragwürdigkeit, der mir am wichtigsten erscheinenden Behauptungen und Beweisführungen Stockers aufzuzeigen. Nun dürfte das alles auch Stocker gut bekannt sein, aber wenn er trotzdem so berichtet wie er berichtet, dann kommt es ihm allein auf die Wirkung der Botschaft an sich an. Und damit verlässt er die Position des neutralen und ehrlichen Wissenschaftlers – obwohl er sie immer und immer wieder für sich beansprucht- und wird zum Aktivisten mit eigener Agenda. Er wäre in der Riege der bekannten alarmistischen Klimaforscher bei weitem nicht der einzige. Was die Sache nur schlechter und nicht besser macht.

In Würdigung dessen, drängt sich mir deshalb als sachkundigem Chronisten der Verdacht auf, dass Thomas Stocker ein würdiger Schüler des bereits verstorbenen Klimaforschers und (ebenfalls)– Aktivisten Stephen Schneider ist, der, seinerzeit Leitautor des IPCC seine Kollegen eindringlich zu folgendem Verhalten in der Öffentlichkeit ermahnte:

„Deshalb müssen wir Schrecken einjagende Szenarien ankündigen. Um Aufmerksamkeit zu erregen, brauchen wir dramatische Statements und kein Zweifel am Gesagten. Jeder von uns Forschern muss entscheiden, wie weit er ehrlich oder effektiv sein will.“

An dramatischen Statements fehlt es in Stockers Vortrag nicht, ebenso erlaubte er sich und dem Publikum keinerlei Zweifel am Gesagten.

Daher bleibt Ihnen liebe Leser überlassen, zu entscheiden, ob Thomas Stocker eher ehrlich oder effektiv war.

Teil 1 finden Sie hier

[2]Quelle ist die IPCC- Webseite 2009 in About IPCC: http://www.ipcc.ch/about/index.htm “Its role is to assess on a comprehensive, objective, open and transparent basis the latest scientific, technical and socio-economic literature produced worldwide relevant to the understanding of the risk of human-induced climate change”

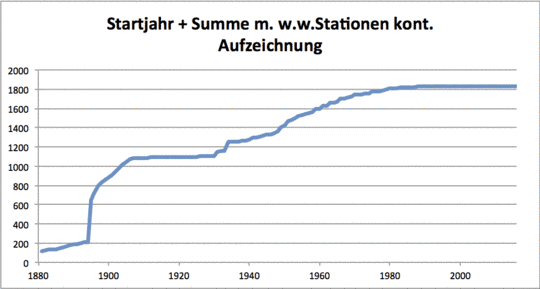

Quelle: Global Historical Climatology Network (GHCN) hier, ausgewertet über die GISS Seite (hier) von Friedrich Karl Ewert Details dazu hier

[6] Siehe auch die Auswertugnen von J. D´aleo und A, Watts in SURFACE TEMPERATURE RECORDS:

[7] NEW SYSTEMATIC ERRORS IN ANOMALIES OF GLOBAL MEAN TEMPERATURE TIME-SERIES; Michael Limburg (Germany) ENERGY & ENVIRONMENT VOLUME 25 No. 1 2014

[8] P. Frank, “Uncertainty in the Global Average Surface Air Temperature Index: A Representative Lower Limit,” Energy & Environment , vol. 21 , no. 8, pp. 969-989, 2010

[9] P. Frank, “Imposed and Neglected Uncertainty in the Global Average Surface Air Temperature Index,” Energy & Environment · , vol. Vol. 22, N, pp. 407-424, 2011.

Quelle „Can Both GISS and HadCRUT4 be Correct? (Now Includes April and May Data) hier

[12] UAH steht für Satellitenauswertung der Erdmitteltemperatur der Universität von Alabama Huntsville, RSS steht für Remote Sensing Systems eine zweite unabhängige Einheit die ebenfalls mit der Satellitenauswertung der Erdmitteltemperatur befasst ist. HadCrut steht für Hadley Center und Climate Research Unit der Universität von East Anglia die offiziell die terrestrischen und seegestützten Daten auswerten

[13] Vermutlich auf Grund dieser klaren Erkenntnis – was nicht ist, was nicht sein darf- hat das Hadley Center die Datensätze noch mal einer kosmetischen Behandlung unterzogen und veröffentlicht die unter HadCrut 4: Die zeigen: „There is no statistically significant warming since March 2005“. Erfreulicherweise kann man aber immer noch die Daten von HadCrut 3 herunterladen.

Details dazu z.B. hier NASA-GISS ändert rückwirkend die Temperaturdaten – warum ? von Friedrich-Karl Ewert

The Antarctic Has Been Warmer Than Now For Most Of The Last 8000 Years, aus Geophysical Newsletters:

[17] Von um die 10 Stationen nur auf der Nordhalbkugel um 1880 stieg die Zahl bis 1985 auf ca. 300 auf der NH und ca. 60 auf der SH an, um dann auf insgesamt ca. 160 zurückzufallen. (Quelle IPCC AR4, Ch5)

Der Verlauf des Meeresspiegels im Holozän und seit 2.000 Jahren hier http://www.eike-klima-energie.eu/climategate-anzeige/der-verlauf-des-meeresspiegels-im-holozaen-und-seit-2000-jahren/

Details dazu hier Willis Eschenbach : CO2 in der Atmosphäre durch Verbrennung verdoppeln? Kann man total vergessen!