Klimawandel wird Sie nicht töten – jedoch der Mangel an Energie

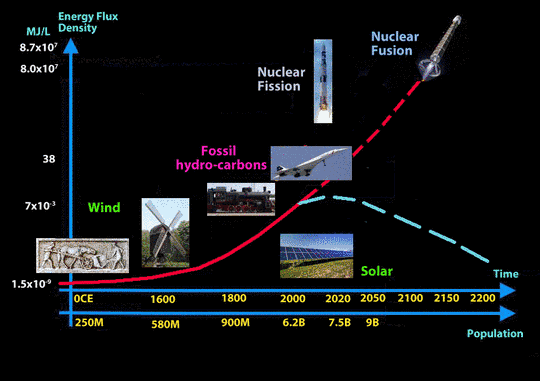

Zur gleichen Zeit werden weltweit jährlich über 1000 Milliarden US-$ ausgegeben, für Studien über den Klimawandel, für Berater¸ im Zusammenhang mit staatlichen Stellen und für die schnell wachsende aber völlig wirkungslos grüne und erneuerbare Energieindustrie. Dies hat auch zur Entstehung der Emissionshandels-Makler-Industrie geführt. Dies basiert auf betrügerischer Wissenschaft, da der extrem kleine "Treibhaus-Effekt" von CO2 bei weitem übertroffen wird durch den Wasserdampf aus den Ozeanen. Nur fossile Treibstoffe und die Kernenergie können aufgrund ihrer viele Größenordnungen höherer Energieflussdichten die benötigten Energiemengen liefern, im Gegensatz zu sogenannten erneuerbaren Energien.

Weit über die Hälfte der Welt hat wirtschaftlich erzielbare fossile Brennstoffe verbraucht, während über 3 Milliarden menschlicher Bewohner in "Energiearmut“ leben, mehr als 1,5 Milliarden [überhaupt] ohne Strom. Sobald fossile Brennstoffe über den Punkt einer wirtschaftlich rentablen Produktion aufgebraucht sind, ist es nur noch eine Energiequelle, die der Erde zur Verfügung steht, um den Energiebedarf zu decken. Das ist die Umwandlung von Materie in Energie, wie in der Gleichung E = mc2 formuliert. Man muss lernen, Energie auf der Grundlage seiner Kenntnisse über die Gesetze der Physik und der Austauschbarkeit der Materie zu erzeugen. Heute haben wir mit dem „Baby Schritt“ der Kernspaltung begonnen. Kernspaltung ist praktisch und arbeitet heute, ist aber nicht nachhaltig aufgrund radioaktiver Abfälle.

Deshalb müssen wir sofort in das experimentelle Verständnis der Wissenschaft investieren, die zur erfolgreichen Demonstration der kontrollierten Kernfusion führt, gefolgt von Forschung & Entwicklung, die nötig sind um es zu vermarkten. Fusion ist 100% sicher, nutzt einen nahezu unbegrenzten Brennstoffkreislauf, leichter, nicht-radioaktiver Komponenten und erzeugt keine signifikanten radioaktiven Nebenprodukte. In der Alternative [also ohne Fusion] wird der Mensch fossile Brennstoffe nicht mehr nutzen können. AGW ist dann ein 100% strittiger Punkt, da Kohlenwasserstoffe in nennenswerten Mengen nicht mehr verbrannt werden. Unter diesen Bedingungen wird die weltweite Bevölkerung auf das Niveau der vorindustriellen Revolution von etwa 10% der heutigen Bevölkerung schrumpfen oder etwa 750 Millionen Menschen weltweit.

Vom Menschen verursachte globale Erwärmung (AGW) oder der Klimawandel ist nicht das große Problem zu dem seine Befürworter es machen. Auch wenn es mal bewiesen werden sollte, dass der Mensch es durch seine Verwendung von fossilen Brennstoffen verursacht, ist es nicht das wirklich große Problem.

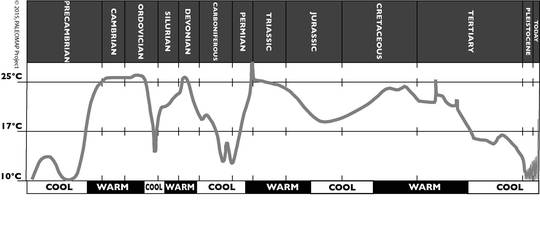

Der Klimawandel war schon immer ein Teil des dynamischen atmosphärischen Systems der Erde. In den letzten 2 Milliarden Jahren hat sich das Klima der Erde gewandelt, zwischen einem gefrorenen „Kühlhaus“ Klima und dem heutigen gemäßigten Klima und einem dampfenden „Sauna" Klima, wie in der Zeit der Dinosaurier.

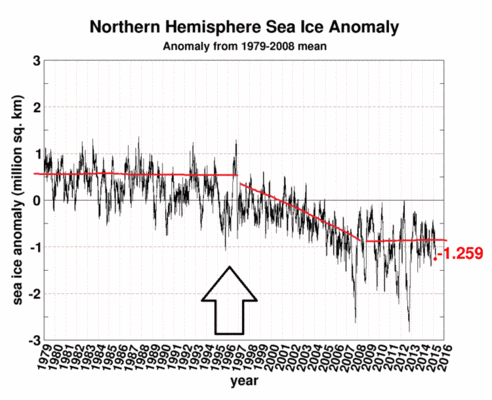

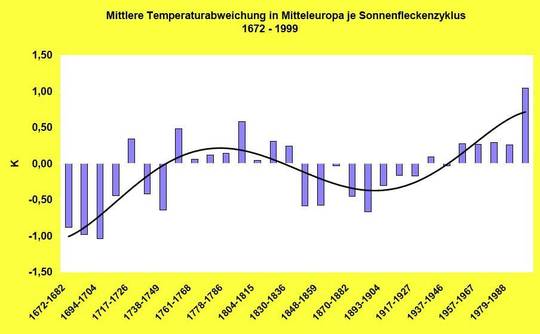

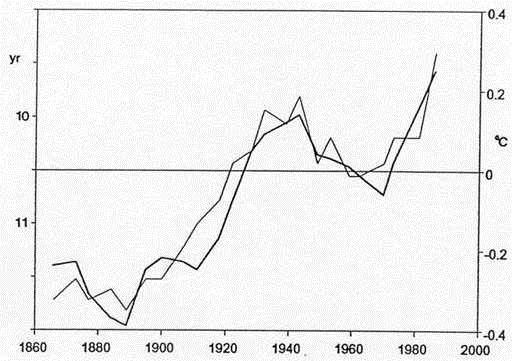

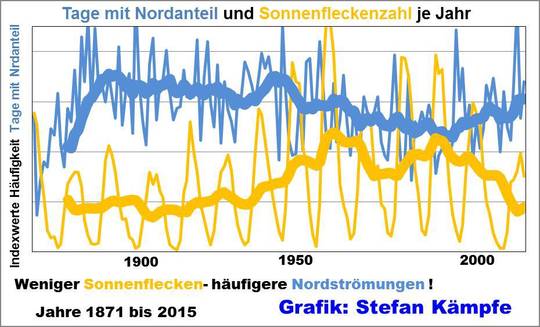

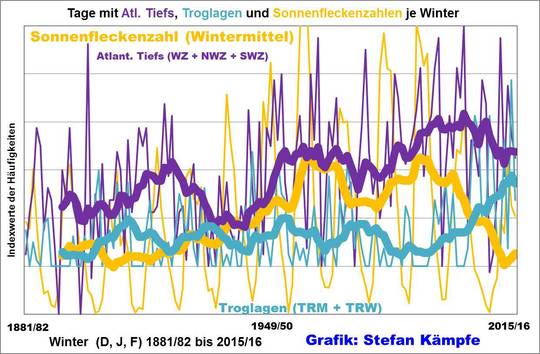

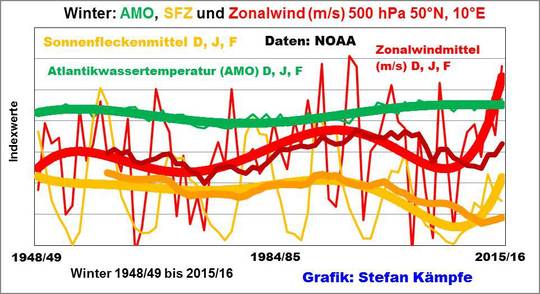

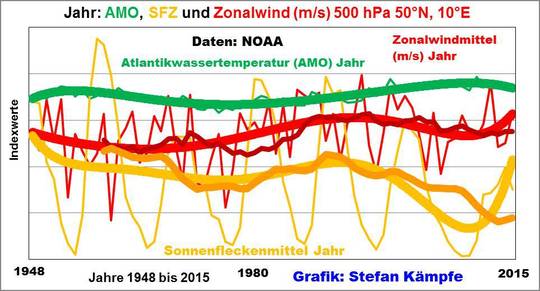

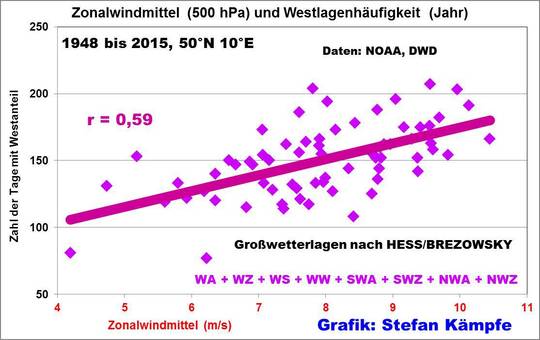

Haupteinflussfaktoren für die Variabilität der mittleren Temperatur und Klima auf der Erde ist die komplexe Umlaufbahn der Erde im Sonnensystem, wie durch die Milankovitch Zyklen definiert, die variable Ausstrahlung der Sonnenenergie und die geologischen Faktoren auf der Erde wie unterseeische vulkanische Aktivität führen zu inkonsistenten Temperatur Gradienten in den Ozeanen.

Diese Grafik zeigt, wie sich das globale Klima sich im Laufe der geologischen Zeit verändert hat.

Temperatur-Zeiten Diagramm

Leider wurde die potenzielle Bedrohung durch einen vorhergesagten zukünftigen Klimawandel dazu verwendet, enorme Mengen an Geld von reichen Nationen zu den armen Ländern [1] zu übertragen. Dies hat die Mechanismen des Überlebensinstinkts der Klimawandels Community aktiviert. Dazu gehören Regierungen, Berater und wissenschaftliche Forscher, die einfach das empfundene Problem untersuchen und akademische Zeitschriftenartikel und Berichte erstellen. Die unwirksamen grünen Energielösungen der Industrie verdanken ihr Leben … den staatlichen Subventionen … und dem Schrecken eines Klimawandels. Kein ernsthaftes, durch die „Klimaschrecken" entrichtetes Geld, wurde für die Lösung des großen Problems verwendet.

Das große Problem ist die Tatsache, dass der Mensch seit etwa 400 Jahren fossile Brennstoffe auf Kohlenstoff Basis zur Verfügung hat, welche über mehrere hundert Millionen Jahre auf der Erde geschaffen wurden. Die Energie kam von der Sonne [2]. Integriert über lange geologische Zeiträume, es wurde täglich Sonnenenergie in Chemikalien durch die Photosynthese der Pflanzen umgewandelt. Diese Chemikalien können, anders herum, wieder gezündet werden, um die gespeicherte Energie durch eine Reaktion mit Sauerstoff (Oxidationsreduktion) wieder freizusetzen [3]. Sobald sie verbraucht sind, stehen sie dem menschlichen Lebenszyklus nicht mehr zur Verfügung.

Was ist Energie? Ein Physiker wird antworten: "die Fähigkeit, Arbeit zu verrichten": Ausführlicher wird er sagen: "Energie ist eine Eigenschaft von Objekten, die in andere Objekte übertragen oder in verschiedene Formen umgewandelt werden können, kann aber nicht erschaffen oder zerstört werden."

Eine Hausfrau wird sagen: Energie ist das, was unsere Autos bewegt, unsere Flugzeuge antreibt, unser Essen kocht, und uns im Winter warm hält – im Sommer kühlt.

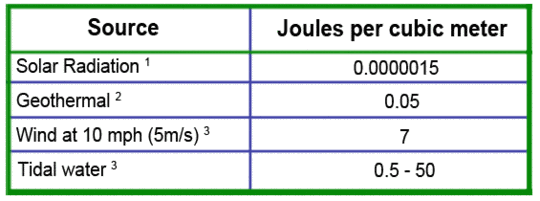

[Jedoch] können Sie keine Welt mit geschätzten 9 Milliarden Menschen im Jahr 2060 mit Energie aus Solarzellen und Windturbinen versorgen. Sie sind nicht von nachhaltiger Bedeutung, sie können Energie nicht schnell genug schaffen, um sich selbst zu reproduzieren (zu erweitern) und Energie für die Menschen bieten. Der Grund dafür ist, dass die Menge an Energie die von der Sonne empfangen wird, zu sehr „verdünnt“ ist, das bedeutet, wir erhalten nur eine sehr geringe Menge an Energie pro Fläche und nur für eine relativ kurze Zeit angesichts des Tag-Nacht-Zyklus und der Wetterbedingungen [4 ].

Die Windenergie ist ein Nebeneffekt der Solarenergie, weil Wind durch die Absorption der Wärmeenergie der Sonne durch die Atmosphäre erzeugt wird, in Verbindung mit dem Coriolis-Effekt [5]. Dies basiert auf der Drehung der Erde in Verbindung mit Unterschieden im Atmosphärendruck in Bezug auf Elevation, Berge und dergleichen [6].

Wasserkraft aus aufgestauten Flüssen ist auch ein Nebeneffekt der Solarenergie. Die Bewegung des Wassers in dem weiten System von Flüssen der Erde geschieht durch Sonnenenergie. Dies geschieht, weil Meerwasser verdunstet, Wolken bildet und schließlich Wasser als Regen und Schnee unsere Flüsse füllt und zum Meer fließt, von den höheren Lagen durch die Schwerkraft angetrieben. Im Gegensatz zu Solar- und Wind, kann Wasserkraft kontinuierlich Material [Masse = Wasser] bewegen, hat aber begrenzte Mengen an Energie.

Die obige Abbildung zeigt die Energieflussdichte in Million Joule per litter [je Entwicklungszeitraum?] auf der linken vertikalen Achse mit einer Skala die von 10^-9 bis 10^7 in wissenschaftlicher Notation umspannt. Die horizontale Achse zeigt in der oberen Reihe die Zeit ab Null der aktuellen Zeitrechnung bis 2200. Die untere Reihe zeigt die direkt der weltweite Bevölkerung zur Verfügung stehende Energie, um Nahrung, Trinkwasser zu produzieren und für die Menschen Komfort zu bieten. Wie man sieht, wenn fossile Kohlenwasserstoff-Kraftstoffe in der Menge nicht mehr verfügbar sind, muss die Fusionsenergie entwickelt werden oder die weltweite Bevölkerung wird zu dem vorindustriellen Zeitalter, wie in den 1600er Jahren schrumpfen. Die Energieflussdichte gibt an, wie viel Energie je Volumeneinheit in einer Energiequelle enthalten ist.

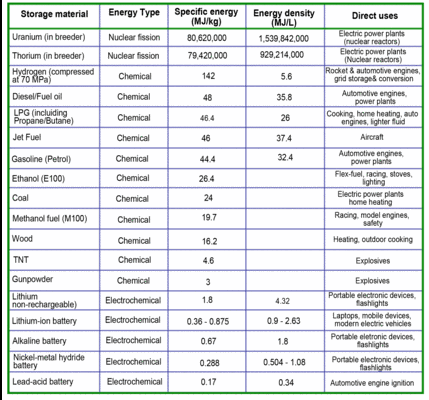

Anlage 1 zeigt eine Tabelle für verschiedene Energiequellen.

Wir müssen beginnen, dass zu entwickeln, was Dr. Steve Cowley in Großbritannien "Energie aus dem Wissen" nennt, die Umwandlung von Masse in Energie [7]. Albert Einstein formulierte die Beziehung zwischen Energie und Masse in seiner berühmten Gleichung E = mc2. Dies bedeutet, dass eine sehr kleine Menge an Masse gleich einer sehr großen Menge an Energie ist, wie Dr. Einstein in seiner eigenen Stimme beschreibt [8].

Wir müssen es lösen, Energie langfristig durch die Umwandlung von Materie in Energie zu bekommen. Keine andere Energiequelle hat eine geeignetere Energieflussdichte, um unseren Strom-, Transport-, Trinkwasser und landwirtschaftlichen Bedarf bereitzustellen, wenn fossile -Kraftstoffe mal nicht mehr rentabel zu liefern sind [9].

Wir müssen jetzt beginnen, weil es mehrere Jahrzehnte dauern wird, diese Wissenschaft zu beherrschen. Wir begannen diese Reise, als wir die Kernspaltung entwickelten. Allerdings ist Kernspaltung keine langfristige Lösung aus mehreren Gründen; vor allem weil es langfristige radioaktive Abfälle produziert.

Der nächste Schritt ist die Entwicklung von Kernfusion. Fusion ist ganz anders als Kernspaltung [10-11-12]. Es nutzt leichte Elemente in dem Brennstoffkreislauf, ist ausfallsicher und kann keiner Umwelt schaden. Es hat die höchste Flussdichte von jeder Energiequelle, kurz vor der Materie-Antimaterie Zerstrahlung.

Es wird noch einige Jahre der reinen experimentellen wissenschaftlichen Forschung dauern, eine nachhaltige Fusionsreaktion im Labor zu demonstrieren, die einen Netto-Energiegewinn produziert, das heißt mehr Energie abgibt als „hineingesteckt" wurde, um die Energieproduktion zu starten [13].

Sobald die kontrollierte Kernfusion in einer kontrollierten Umgebung erprobt ist, unabhängig davon, wie teuer und kompliziert der Reaktor Mechanismus und die Einrichtung ist, wird der Einfallsreichtum des Menschen im privaten Sektor übernehmen. Die Komplexität und die Kosten werden nach unten getrieben, wie die Wende des 20. Jahrhunderts, als Vakuumröhren Transistoren wichen und später durch Microcomputer-on-a-Chip abgelöst wurden.

Das ist das große Problem. Wenn wir das nicht lösen kann, werden wir in 50 bis 100 Jahren unsere Kohle, Öl und Erdgas-Ressourcen nicht mehr wirtschaftlich und ökologisch nutzen können [14].

Dann kehrt die Menschheit wieder zurück im 16. Jahrhundert zu Leben. Wenn wir die Energiefrage nicht lösen, ist das ganze Argument von guten Umweltstandards strittig. Warum? Denn in weniger als 100 Jahren werden wir nicht länger fossile Kohlenwasserstoff-Kraftstoffe verbrennen. Die globale Erwärmung und den durch den Menschen verursachten Klimawandel, ist kein Thema mehr. Das Problem löst sich von selbst. In wenigen tausend Jahren wird die Natur …in geologischen und geochemischen Prozessen … die meisten Zeichen unserer Vergangenheit und der Industrialisierung löschen.

Wenn es nicht genügend kognitiv intelligente Menschen gibt, die fähig sind zu denken und das Beste [für unsere Zukunft] unterscheiden können, ist es ein nicht daraus folgender Punkt, dass Außerirdische nicht zu unserem Planeten strömen [it is a nonconsequential point as aliens are not flocking to our planet] Niemand oder kein Ding wird jemals den Unterschied kennen. Damit stellt sich die Frage: "Gibt es intelligentes Leben auf der Erde" Dieser Autor glaubt es so. Wie Bill & Melinda Gates in ihrer jüngsten Ausgabe des jährlichen offenen Briefes vor kurzem erklärten, braucht unsere Jugend die Herausforderung, um zu entwickeln, was sie ein "Energiewunder" [15] nennen.

Dies ist das größte Problem dem sich die Menschheit gegenüber sieht. Klimawandel … wenn durch den Menschen verursacht … kehrt sich automatisch in den nächsten 100 Jahren um. Aber wenn wir die Energiefrage nicht lösen, wird sich die Bevölkerung um mehr als einen Faktor 10 im Laufe der folgenden 100 Jahren reduzieren. Zusammengefasst, als Spezies müssen wir diese Realität erkennen und das Rennen um Energie heute beginnen.

Referenzen:

[1] Another Climate Alarmist Admits Real Motive Behind Warming Scare, Investor’s Business Daily, March 29, 2016.

[Ein weiterer Klimaalarmist gibt die wahren Motive hinter der Angst vor Erwärmung zu. – hier und hier berichtet]

[2] Tamarkin, Tom D., Energy Basics; Where does energy on our planet come from?, Fusion 4 Freedom.

[3] Heats of Combustion, UC Davis Chemistry Wiki.

[4] Lawson, Barrie & Tamarkin, Tom D., Going Solar-System Requirements For Solar Generated Utility Baseload Power, Fusion 4 Freedom.

[5] Consequences of Rotation for Weather; Coriolis Forces, Universe of Tennessee Knoxville.

[6] Atmospheric Pressure at Different Altitudes, AVS Science & Technology of Materials, Interfaces, & Processing, https://www.avs.org/.

[7] Fusion energy with Professor Steven Cowley, Culham Centre for Fusion Energy, UK.

[8] William Tucker, Ph.D., Understanding E = MC2, Dr. Albert Einstein in his own voice & explanation, Energytribune.com.

[9] Tamarkin, Tom D., Energy Basics, Comparison of fuel energy flux densities, Fusion 4 Freedom.

[10] Duke Energy Nuclear Information Center, Fission vs. Fusion – What’s the Difference?

[11] Lawson, Barrie, Nuclear Fission Theory, Fusion 4 Freedom.

[12] Lawson, Barrie, Nuclear Fusion-The Theory, Fusion 4 Freedom.

[13] Tamarkin, Tom D., Fusion Energy; Too Important to Fail – Too Big To Hoard, Fusion 4 Freedom.

[14] Tamarkin, Tom D. 2060 And Lights Out: How Will America Survive Without Oil?, Inquisitir Special Report, http://www.inquisitr.com.

[15] Gates, Bill & Melinda, Gates Foundation Annual Open Letter, James, Murray, Guardian, February 24, 2016.

Anhang 1

Vergleiche der Energieflussdichte

Energiedichte ist die Menge an Energie, die in einem gegebenen System oder Volumeneinheit gespeichert ist. Spezifische Energie ist die gespeicherte Menge der Energie pro Einheitsmasse (Gewicht). Nur die nützliche oder extrahierbare Energie wird gemessen. Es ist sinnvoll, die Energiedichten der verschiedenen Energiequellen zu vergleichen. An der Spitze der Liste ist Fusion, gefolgt durch Kernspaltung und dann den aus Erdöl, Kohle und Erdgas abgeleiteten Treibstoffen. Am unteren Ende der Liste sind Batterien, die entweder Energie erzeugen oder Energie speichern sowie "Erneuerbare Energien" wie Solar.

1 kg Deuterium fusioniert mit 1,5 kg Tritium kann 87,4 GWh Elektrizität erzeugen

Hier sind die zugrunde liegenden Berechnungen, zur Unterstützung der vorstehenden Feststellung:

Die Energie, die durch Fusion von 1 Atom Deuterium mit 1 Atom Tritium freigesetzt ist 17,6 MeV = 2,8 X 10^12 Joules.

Dann entspricht die Energie, die durch die Fusion von 1 kg Deuterium mit 1,5 kg Tritium freigesetzt wird: 2,8 X 10^12x 2,99 X 10^26 = 8,3 X 10^14 Joules = (8,3 · 10^14) / (3,6 x 10^12) = 230 GWh.

Diese Energie wird als Wärme freigesetzt. Ein konventionelles Dampfturbinen-Kraftwerk mit einem Wirkungsgrad von 38%, würde 87.4GWh Strom erzeugen

1 Deuterium ist ein natürlich vorkommendes Isotop von Wasserstoff, leicht erhältlich aus Meerwasser.

2 Tritium wird in einem Fusionsreaktor als Teil des Brennstoffzyklus und des Energie-Austauschverfahrens aus Lithium hergestellt. Lithium ist ein reichlich und natürlich vorkommendes Element.

Vergleich der Energiedichte konventioneller Brennstoffe

[Anmerkung: „Nuclear fission = Kernspaltung“]

Vergleich von „erneuerbaren“ Energiedichten

1 Wie viel Sonnenenergie pro Kubikmeter ist das? Das Volumen des Raumes zwischen einem Quadratmeter-Fleck auf der Erde und im Mittelpunkt unserer Umlaufbahn um die Sonne beträgt 50 Milliarden Kubikmeter (die Erde ist 150 Milliarden Meter von der Sonne entfernt oder 4.000 Erd-Umfänge). Die Aufteilung der nutzbaren 100 Watt pro Quadratmeter auf dieses Volumen ergibt zweimillionstel Watt pro Kubikmeter. Sonnenlicht braucht etwa acht Minuten (499 Sekunden), um die Erde zu erreichen. Multipliziert man 499 Sekunden mit sechsundzwanzig millionstel W / m3 ergibt, dass die Sonnenstrahlung eine Energiedichte von 1,5 Mikrojoule pro Kubikmeter (1,5 x 10-6 J / m3) hat.

2 Die einzige Möglichkeit, Wärmeenergie aus der Atmosphäre zu extrahieren ist, ein isoliertes Rohr zwischen dieser und einem Reservoir mit einer niedrigeren Temperatur (vorzugsweise eine viel niedrigere) zu konstruieren. So funktionieren Erdwärmepumpen. Die typische Bodentemperatur ist 11,1° C (284 K). An einem 32°C Tag, hat ein solches System einen Spitzenwirkungsgrad von 7% und eine Leistungsdichte von nur 0,05 mW / m3 (Stopa und Wojnarowski 2006): typische Oberflächenleistungsflüsse für Geothermie-Bohrungen sind in der Größenordnung von 50 mW / m2 und haben eine typische Tiefe von 1 km. Um die Energiedichte zu finden, muss eine charakteristische Zeit enthalten sein. Die verwendete Zeit entspricht der Zeit um Wasser in den Boden zu pumpen und einmal durch das System zu zirkulieren. Diese Zahl ist in der Größenordnung von zehn Tagen (Sanjuan et al. 2006). Die daraus resultierende Energiedichte beträgt 0,05 J / m3 oder rund zwei bis drei Größenordnungen niedriger als Wind oder Wellen.

3 Wind wird durch Änderungen in der Wetterstruktur angetrieben, die wiederum durch thermische Gradienten angetrieben wird. Gezeiten werden durch Schwankungen der Schwerkraft angetrieben, erzeugt durch den Umlauf des Mondes um die Erde. Die Energiedichten von Wind- und Wassersystemen sind proportional zur Masse m, die durch sie bewegt wird und dem Quadrat der Geschwindigkeit v, dieser Masse oder ½mv2. Auf Meereshöhe, hat Luft mit einer Dichte von etwa 1 kg pro Kubikmeter die sich mit fünf Metern pro Sekunde bewegt (18 km/h) eine kinetische Energie von 12,5 Joule pro Kubikmeter. Die Anwendung des Betz Gesetzes (Betz 1926) begrenzt die Effizienz auf 59%, ergibt etwa sieben Joule pro Kubikmeter. So ist die Energiedichte der Windenergie an einem mäßig windigen Tag, mehr als eine Million Mal größer als Solarenergie.

Es gibt zwei vorherrschende Mechanismen, um Gezeitenenergie zu extrahieren. In [dem] einen System bewegen sich Dämme mit dem Aufstieg und Abstieg der Gezeiten nach oben und nach unten, um Energie zu extrahieren. Bei der zweiten Strategie wirken Gezeitensysteme wie Unterwasser-Windkraftanlagen, die Energie aus Tidenströmungen extrahieren, wenn sie sich vorbei bewegen. Wie bei Wind, ist die Energie einer sich bewegenden Wassermenge auch ½mv2. Tidal-Systeme haben den Vorteil gegenüber Windsystemen, dass Wasser rund tausend Mal dichter als Luft ist.

Ihr Nachteil liegt in der Regel bei zu niedrigen Gezeitengeschwindigkeiten von nur zehn Zentimetern pro Sekunde bis zu einem Meter pro Sekunde. Somit ergibt ein Kubikmeter Wasser, mit einer Masse von ungefähr 1000 kg, eine Energiedichte von etwa fünf Joule pro Kubikmeter für langsame Wasserbewegungen1 und fünfhundert Joule pro Kubikmeter für schnelle Wasserbewegungen2. Diese sind ebenfalls Gegenstand des Betz‘chen Gesetzes und stellen nur Spitzenwerte dar, so dass die mittleren Energiedichten näher an der Hälfte eines Joule pro Kubikmeter bis fünfzig Joule pro Kubikmeter liegen oder etwa die gleiche wie bei Wind.

1 kinetische Energie (Tidal niedrige Geschwindigkeit) = ½ mv2 = ½ · 1000 kg · (0,1 m / s)² = 5 Joule.

2 kinetische Energie (Tidal hohe Geschwindigkeit) = ½ mv2 = ½ · 1000 kg · (1 m / s)² = 500 Joule.

Erschienen auf WUWT am 14. April 2016 und auch auf Fusion for freedom am 15. April 2016

Übersetzt durch Andreas Demmig

https://wattsupwiththat.com/2016/04/14/climate-change-wont-kill-you-having-no-electrical-power-will/

+++++++++++++

Für unsere Leser gefunden und übersetzt; Andreas Demmig:

Ein Kommentar auf WUWT von ristvan, 14. April 2016 um 10:35 Uhr

Abgebrannte Brennelemente können mit dem MOX-Verfahren recycelt werden, wie Frankreich und Japan zu tun. Diese reduziert das Volumen radioaktiver Abfälle stark, die dann in Glas eingeschlossen werden können. In den 1970er Jahren beschlossen die USA auf Grund der nicht Weitergabe von Atomwaffen dieses Verfahren weiter anzuwenden. Diese Idee hat nicht funktioniert. Aus politischen Gründen haben die US dann die Endlagerung nicht verfolgt.

Die Antwort auf IMO [International Maritime Organization regulations] ist ein geschmolzenes LiF (nicht Natrium) Salzreaktor der im U-P-Zyklus läuft, angetrieben mit all den abgebrannten Brennelementen die herumliegen. Das brütet und verbraucht dann seinen Brennstoff und hinterlässt nur geringe Mengen an radioaktiven Abfällen. Die Empfehlung [white paper] der Transatomic Power auf ‚WAMSR‘ [Waste Annihilating Molten Salt Reactor] ist ein seriöser Augenöffner über die Möglichkeiten der Gen 4 Spaltung. Keines der technischen Probleme, die sie ansprechen [diskutieren] sieht aus wie reine „Engineering Showstopper“.

Trägheitsfusion ist eine Chimäre, wie die National Ignition Facility gezeigt hat. ITER kann oder kann auch nicht funktionieren, aber das Programm deutet darauf hin, dass bereits die Wirtschaftlichkeit suspekt ist. Lockheed Skunkworks „high beta magnetic confinement“ [hoher Beta magnetischer Einschluss -?] sieht vielversprechend aus, ist aber unterfinanziert. Ob es jemals ‚real‘ sein wird, ist unbekannt. Hohe Beta-Plasmaeinschluss Beweis des Prinzips ist sehr weit von einem Pilotfusionsreaktor.

Der Nachweis des “High beta plasma confinement” Prinzips ist weit entfernt von einer Pilotanwendung in einem Fusionsreaktor.

Nehmen Sie die über $ 2,3 Milliarden jährlich die für US-Klimaforschung ausgegeben wird und verwenden Sie $ 0,3 für verbesserte Wettervorhersagen, $ 1.5 auf WAMSR und $ 0,5 auf der Skunkworks mit “High beta plasma confinement” Fusion. Schließlich ist die die Klimawissenschaft abgeschlossen [settled], sodass weitere Klimaforschung nicht erforderlich ist. Trenberth und Schmidt können sich schon mal sinnvolle Arbeitsplätze suchen.