Vor 30 Jahren: Tschernobyl, ein Rückschlag für die Menschheit

Aber so weit kam es in dieser Nacht gar nicht. Der Lastverteiler meldete sich nach ein paar Stunden und unterbrach die Lasteinsenkung bei etwa der Hälfte der Nennleistung – das schwache Landesnetz brauchte jetzt am Morgen die Energie unbedingt. Erst 12 Stunden später, also nach der Abendspitze, konnte die Leistungsabsenkung fortgesetzt werden.

Was weiß schon ein Lastverteiler über die Kernphysik? In den 12 Stunden, in denen die Lasteinsenkung gestoppt wurde, war die „Xenonvergiftung“ auf ihren höchstmöglichen Wert angestiegen. Xenon ist ein Spaltprodukt und entsteht durch die natürlichen Weiterzerfallsketten im Reaktorkern. Normalerweise wird es sofort wieder ausgebrannt. Nur bei niedrigerer Leistung reichert es sich 12 Stunden lang an und klingt erst danach durch Eigenzerfall wieder ab. Es wird als „Neutronengift“ bezeichnet, weil es Neutronen „auffrisst“, die somit nicht mehr für die Kernspaltung zur Verfügung stehen. Der Reaktor war am „ausgehen“, da am Ende der Kampagne nicht mehr genug frischer Brennstoff zum Kompensieren des Xenonverlustes zur Verfügung stand. Die Reaktorleistung fiel auf weniger als 5%, weit unter die für den Versuch geforderte Leistung.

Jetzt hätte das sicherheitsbewusste Personal den Versuch absagen und den Reaktor konsequent herunterfahren müssen und kein Mensch würden den Namen Tschernobyl heute kennen. Aber es sollte ja unbedingt der „Auslaufversuch“ gefahren werden.

Inzwischen war es wieder Nacht geworden und die Operatoren bemühten sich, das für den Versuch erforderliche Leistungsniveau von 30% zu erreichen. Durch den Leiter des Auslaufversuches, einen Elektroingenieur, der auch bloß nichts von Kernphysik verstand, wurde die Fahrmannschaft massiv unter Druck gesetzt. Das Einhalten der Sicherheitsvorschriften gehörte in der Sowjetunion ohnehin nicht zu den alltäglich gepflegten Gewohnheiten – wichtiger als Sicherheit war im Sozialismus stets „Produktivität für den Sieg des Sozialismus“ und das Ausführen der Befehle von Oben.

Das Noteinspeisesystem wurde unwirksam gemacht, damit es bei Druckabfall nicht den Versuch stört. Dann schalteten die Operatoren verbotenerweise mehrere Umwälzpumpen gleichzeitig ein, während sie – auch verbotenerweise – gleichzeitig viele Regelstäbe schnell aus dem Reaktor fuhren, um durch den Effekt des kälteren Wassers den leistungssteigernden Regeleffekt der Stäbe zu verstärken und im Reaktor mehr Neutronen zu gewinnen. Sie wollten die Leistung um jeden Preis erhöhen. Eine solche Fahrweise war mit gutem Grund streng verboten.

Es funktionierte, nur viel zu schnell. Ein Teil des Reaktorkerns wurde durch diese Handlungen „prompt kritisch“ – das heißt, die Leistung stieg so blitzartig an, dass ein Gegenregeln und Abschalten mit den Regelstäben nicht mehr möglich war. Es kam zu einem sprungartigen Temperaturanstieg im Reaktor – gefolgt von einem Dampfdruckanstieg und einer heftigen Dampfexplosion, die einige hundert Druckröhren bersten ließ. Die Explosion des Dampfes war so stark, dass der tausend Tonnen schwere Betondeckel oberhalb des Reaktors angehoben wurde und schräg offen hängenblieb. Damit entstand ein sehr großes Leck aus dem Reaktor in die darüber liegende Leichtbau-Turbinenhalle, deren Dach einstürzte. Das Schutzgas, bestehend aus Helium und Stickstoff, welches ein Entzünden des Graphitkerns im Reaktor verhindern sollte, entwich vollständig. Die 1700 Tonnen radioaktiven Graphitziegel des Reaktorkerns begann zu brennen. Das Feuer entfachte eine Sogwirkung, von der die aus dem Reaktorleck entweichende Radioaktivität in große Höhen getragen und somit weltweit verbreitet wurde. Der nicht mehr gekühlte Brennstoff schmolz zum Teil und Spaltmaterial wurden freigesetzt.

Die Reaktorkatastrophe von Tschernobyl, der gefürchtete GAU, war am 26. April 1986 um 01:23:40 Uhr eingetreten. Und er konnte trotz großer Anstrengungen des kommunistischen Sowjetsystems nicht mehr verheimlicht werden.

Warum konnte es geschehen?

Der Tschernobyl Reaktor ist ein RBMK (Реактор Большой Мощности Канальный – Reaktor Großer Leistung in Kanalbauweise), ein russischer graphitmoderierter Siedewasser-Druckröhrenreaktor, einer von insgesamt 15 ausschließlich in der Sowjetunion gebauten Anlagen dieses Typs. Zehn von ihnen sind heute in den Ländern der ehemaligen Sowjetunion noch in Betrieb, der letzte soll 2030 geschlossen werden.

Es ist interessant zu wissen, dass der RBMK ursprünglich kein „ziviles“ AKW war. Die Konstruktion erlaubt es nämlich, während des Betriebes den Brennstoff zu dem Zeitpunkt zu bergen, wenn die Anreicherung des Plutoniums am höchsten ist. Das geht bei kommerziellen Reaktoren nicht. Die RBMK’s sind Militär-Anlagen, konstruiert zum Erbrüten von Waffenplutonium. Der Dampf war ursprünglich nur ein Abfallprodukt. So hat man an den ersten RBMK gar keine Turbine angeschlossen und mit dem Dampf einfach einen Fluss aufgewärmt. Später gab es in der UdSSR zwar genug Bombenplutonium, aber viel zu wenig Strom. So wurde die RBMK‘s umgewidmet. So wie man mit einem Panzer einen Pflug ziehen könnte, verwandelte man nun die RBMK‘s in kommerzielle Reaktoren zur Stromproduktion.

Um den Brennstoff während des Betriebes bergen zu können, besteht ein RBMK nicht aus einem Druckgefäß, sondern aus 1693 miteinander verbundenen Druckröhren. Jede könnte während des Leistungsbetriebes abgesperrt und geöffnet werden, um die zwei darin befindlichen Brennelemente zu bergen. Weil durch diese Bauweise aber den Brennstoff im Reaktor viel weniger Wasser umgibt als in einem kommerziellen Siedewasser- oder Druckwasserreaktor, benötigt man einen zusätzlichen Graphit-Moderator. Graphit, das ist reiner Kohlenstoff, war zu einem schweizerkäseartigen zylindrischen Block von 7 m Höhe und 12 m Durchmesser aufgeschichtet, in dessen Löchern die Druckröhren saßen. Dadurch war das Volumen des RBMK-Reaktorkerns mehr als 10-mal größer als bei einem normalen Reaktor der Bundesrepublik Deutschland.

Dieses monströse Design barg enorme Sicherheitsmängel:

Der RBMK hatte keinen „negativen Reaktivitätskoeffizienten“. Das heißt, er steigerte bei Kühlwasserverlust seine Leistung, statt zu verlöschen, wie es kommerzielle Reaktoren tun.

Tausende absperrbare Verbindungen der 1700 Druckröhren sind ein konstruktiver und instandhaltungstechnischer Albtraum. Die Radioaktivitätsabgabe ist um ein vielfaches höher, als bei normalen Anlagen.

Der riesige Graphitblock stellt eine extreme Brandgefahr dar. Deshalb muss er unter Schutzgas gehalten werden.

Der RBMK hat auch keinen Sicherheitseinschlussbehälter, genannt Containment, welches das Entweichen von Radioaktivität im Störfalle verhindert. Und das sind nur die wichtigsten Sicherheitsschwächen.

So unsicher, wie der Reaktor konstruiert war, wurde er auch betrieben. Die Anlage war so störanfällig, dass das Personal sich daran gewöhnt hatte, um nicht funktionierende Einrichtungen einfach herumzuarbeiten oder sie außer Betrieb zu setzen. Das betraf auch Sicherheitssysteme. Dieser laxe Umgang, verbunden mit einem kommunistischen Kommissar-Führungsstil mündeten in einem eklatanten Mangel an Sicherheitskultur. Das war in der UdSSR beileibe nicht nur in der Kernenergie so. Zu Gorbatschows Zeiten erfuhr die Welt durch „Glasnost“, die neue Offenheit, von einer sich immer schneller drehenden Spirale großer Industrieunfälle, die im Westen ironisch als „Katastroika“ bezeichnet wurde, statt „Perestroika“, das für „Umgestaltung“ stand. Wobei ich glaube, dass seinerzeit im Westen nur ganz wenige Menschen die Zusammenhänge, die zum GAU führten, überhaupt verstehen konnten. Schließlich waren die Details der RBMK-Technologie geheim.

Gravierende Konstruktionsmängel in Verbindung mit unsicherer Betriebsführung führte am 26igsten April 1986 zum GAU des Blockes 4 im AKW Tschernobyl, bei dem mindestens 60 Menschen den Tod fanden.

Was waren die Folgen der Tschernobyl-Katastrophe?

Für mich ist es schlimm genug, dass bei der Tschernobyl-Katastrophe laut einem Untersuchungs-Bericht der Vereinten Nationen zufolge mindestens 60 Menschen den Tod fanden. Schlimm genug ist auch, dass die Schilddrüsenkrebsrate für Kinder stark anstieg, eine Krebsart die zum Glück heilbar ist. Es ist schlimm genug, dass Hunderttausende ihre Heimat durch Umsiedlung verloren, entwurzelt wurden und leiden mussten. Das alles ist furchtbar und traurig genug. Ich mag nicht teilnehmen an dem Wettbewerb: „Wer schätzt die meisten Todesopfer von Tschernobyl“. Es gibt abenteuerliche Zahlen von ebenso abenteuerlichen Studien, wo von Millionen Toten die Rede ist.

GAU heißt „Größter Anzunehmender Unfall“. Nach meinem Wissen lässt sich das Wort „größter“ nicht mehr steigern. Trotzdem gibt es Leute, die den Super-GAU erfunden haben. Ist für sie „Super-Grösster Anzunehmender Unfall“ überzeugender, weil furchteinflößender?

Der Block 4 des AKW Tschernobyl wurde in einer mörderischen Anstrengung provisorisch eingesargt. Dabei wurde auf die tausenden dort arbeitenden Menschen wenig Rücksicht genommen. Sie wurden als die „Liquidatoren“ berühmt für ihre Opferbereitschaft.

Derzeit errichtet man ein neues Einschlussgebäude – New Safe Confinement, ein Euphemismus für den neuen Sarkophag, der 100 Jahre halten soll. Die anderen Blöcke wurden weiter betrieben und sukzessive bis zum Jahre 2000 zum Rückbau abgeschaltet. Die halbfertig im Bau befindlichen Blöcke 5 und 6 sind konserviert und sollen eventuell eines Tages fertiggebaut werden, was aber extrem unwahrscheinlich ist. Am 23. April 2008 war der Kernbrennstoff aus der Anlage Tschernobyl entfernt. Am gleichen Tag nahm dort die Atommüll-Verarbeitungsanlage „Vektor“ den Betrieb auf, wo die kontaminierten Teile verarbeitet werden, um diese für eine Endlagerung vorzubereiten.

Um das Kraftwerk wurde eine Zone von 30 km im Radius evakuiert, um die Bevölkerung vor radioaktivem Fallout zu schützen. Insgesamt wurden bis zu 350.000 Menschen umgesiedelt. Die Stadt Prypjat wurde zu einer Geisterstadt. Die Zone wurde abgesperrt und sich selbst überlassen. Von 190,3 t radioaktivem Material, welches sich im Reaktorkern befand, wurden nach Schätzungen in den ersten zehn Tagen vom 26. April bis 5. Mai 1986 6,7 t in die Umwelt freigesetzt. Auch über die Auswirkungen der freigesetzten Radioaktivität auf Mensch, Tier und Pflanzenwelt gibt es je nach Überzeugung der Autoren und Interpreten höchst unterschiedliche und widersprüchliche Angaben.

Die Tschernobyl-Katastrophe bestätigte die Besorgnisse der Bevölkerung vieler Länder Europas gegenüber der Nutzung der Kernenergie und gab der grünen Bewegung großen Auftrieb. In einigen Ländern brach eine regelrechte Strahlenangst aus. Die katastrophal restriktive und beschönigende Informationspolitik der Sowjets und der Medien in den Ostblock-Staaten trug dazu bei, das Misstrauen und die Angst der Menschen ins Pathologische zu steigern. Die Westmedien hingegen steigerten die Panik der Bevölkerung durch immer neue Horrormeldungen. Auch im Krieg der Meinungen über Atomkraftwerke war die Wahrheit das erste Opfer. Eine vernünftige Diskussion über die Tschernobyl-Folgen scheint bis heute unmöglich zu sein.

Tschernobyl leitete das Ende der Kernenergieeuphorie in vielen Staaten ein. Italien und Österreich stiegen endgültig aus, bevor sie überhaupt richtig einstiegen. Es brauchte noch eine zweite Katastrophe in Fukushima, bis auch Deutschland panisch beschloss, endgültig aus der Kernenergie auszusteigen.

Tschernobyl aus heutiger Sicht

Tschernobyl war die furchtbarste Katastrophe der Nuklearindustrie und wurde zum Mythos der Gefährlichkeit der Nukleartechnologie. Fukushima war schlimm, aber harmlos im Vergleich mit Tschernobyl. Die „Zone“ von Fukushima ist bereits zu großen Teilen wieder besiedelt. Kein einziges Strahlenopfer ist zu beklagen. Japan ist nicht die Sowjetunion. Trotzdem wurden in Deutschland durch Fukushima mehr Reaktoren zerstört, als in Japan. Wir Deutschen haben eine Neigung zu Extremreaktionen – wir tun Dinge ganz oder gar nicht.

Als Resultat von Tschernobyl und Fukushima haben wir unsere einsame Energiewende. Derweil befindet sich die Welt inmitten einer energetischen Revolution, die „Fracking“ heißt. In Deutschland verbieten wir Fracking vorsichtshalber erst mal, ohne dass wir uns weiter den Kopf darüber zerbrechen, dass die USA durch Fracking zum großen Ölexporteur aufgestiegen ist, was die geopolitische Weltlage dramatisch verändert. Öl und Gas wurden billig wie lange nicht mehr. Dies macht die deutsche Energiewende noch absurder. Noch können die meisten Deutschen sich die extrem hohen Stromkosten leisten und weiter von ökologischen Kreisläufen träumen. Die Physik spricht da eine andere Sprache, aber wen interessiert schon die langweilige Physik? So muss es eben die Zeit richten.

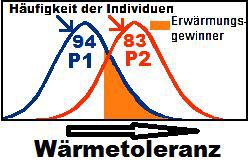

Die „Todeszone“ von Tschernobyl wurde zum riesigen Naturschutzpark. Hier leben auf 4200 Quadratkilometer gerade mal etwa 120 Menschen. Sie sind heimlich zurückgekommen und werden stillschweigend geduldet. Die Zone ist heute ein Tummelplatz diverser Forschungsteams und ein Touristenmagnet. Die Bestände von Elch, Reh, Rotwild, Wildschwein und Wolf wachsen und gedeihen, trotz Kontamination und Strahlung. Offensichtlich ist die Störung durch den Menschen für die Natur schlimmer, als die Schädigung durch Strahlung, die sich bei den Tieren und Pflanzen in der Zone nicht erkennbar auswirkt. Britische Forscher fanden gerade heraus, dass die Population seltener Vögel profitiert und weniger Erbgutschäden hat, als anderswo. Tiere und Pflanzen messen halt keine Becquerel und passen sich an. Vielleicht wird die gesundheitsschädigende Wirkung geringer Strahlendosen überschätzt. Großangelegte Langzeitstudien über die Überlebenden von Hiroshima und Nagasaki lassen diesen Schluss zu. In Hiroshima und Nagasaki konnte bisher bei Nachkommen der bestrahlten Atombomben-Überlebenden keine erhöhte Rate von vererbbaren Erkrankungen im Vergleich zur übrigen japanischen Bevölkerung festgestellt werden. Aber auch hier weisen andere Studien das genaue Gegenteil aus.

Die Welt steht erst am Anfang der Nukleartechnologie, ob Kernspaltung oder Kernfusion. Beide Prozesse erzeugt Radioaktivität und Abfälle. Viele Menschen denken, dass dieses Feuer ausschließlich den Göttern vorbehalten ist und der Mensch lieber seine Finger davonlassen sollte. Und vielleicht stimmt das ja auch, zumindest für manche Länder.

Die Zukunft der Nukleartechnologie wird nicht in Deutschland entschieden. Erst weltweit wird sich künftig zeigen, ob die Kernenergie eine saubere, sichere und ökonomische Technologie der Energiegewinnung zum Wohle der Menschheit ist. Ist sie nicht sauber, sicher und ökonomisch, wird sie verdientermaßen untergehen. Ist sie aber auf Dauer akzeptabel, wird sie ihren Beitrag zur Versorgung mit Energie leisten, so wie es all die anderen Energieträger auch tun. Gegebenenfalls dann eben außerhalb Deutschlands.

Eines ist für mich sicher: Es macht keinen Sinn, Technologien zur Energieerzeugung in Freund und Feind einzuteilen. Jede hat ihre Vor- und Nachteile. Durch jede Technologie können Menschen umkommen, durch jede Technologie können aber auch Menschen versorgt werden. Technologie ist keine Frage von Ideologie, sondern der Abwägung von Nutzen und Risiken. Das Falsche zu tun, ist Sünde. Nicht das Nötige zu tun, ist auch Sünde.

Aber – wenn irgendwo Menschen auf der Erde hungern, ist es fast immer das Resultat eines Mangels an Energie. Ohne Energie kann man nicht pflügen, sähen, düngen, ernten, transportieren, Nahrung verarbeiten und lagern. Wenn ein Land arm ist, ist es in erster Linie arm an Energie. Schauen Sie auf die nächtliche Weltkarte – Afrika ist der „dunkle Kontinent“ weil dort kein Licht zu sehen ist. Deshalb wird um Energie in Kriegen und Bürgerkriegen gekämpft. Wir werden bald neun Milliarden sein. Die Menschheit braucht jeden Zipfel Energie, den sie bekommen kann.

Tschernobyl war eben nicht nur ein GAU der Nukleartechnologie, sondern ein Rückschlag für das Wohl der Menschheit.

Über den Autor

Der Autor Manfred Haferburg ist Kernenergetiker und hat viele Jahre für eine internationale Organisation Kernkraftwerke und andere Risikoindustrien weltweit bei der Verbesserung der Sicherheitskultur und Organisationseffektivität unterstützt. Er hat so viele Kernkraftwerke von innen gesehen, wie kaum ein anderer Mensch.

Er gehört zum Autorenteam der „Achse des Guten“, einem der meistgelesenen deutschen Internet-Blogs. Sein Roman „Wohn-Haft“ mit einem Vorwort von Wolf Biermann erschien im KUUUK-Verlag.

- Tschernobyl Reaktor Bild Wikipedia CC von Carl Montgomery – Flickr

- Autor Manfred Haferburg