Wo andere, auf unbewiesene Theorien zurückgreifen und alles, was mit dem Temperaturanstieg zusammenhängt, auf den sog. Treibhauseffekt (THE), basierend auf sog. Treibhausgasen (THG) fixieren, differenzieren wir und erkennen mehrere Ursachen, für die vom DWD ausgewiesene Temperaturerhöhung für Deutschland in den letzten 125 Jahren.

Ausgangspunkt unserer Betrachtungen ist die von Einstein in die Welt gebrachte Erkenntnis: Die Zeit ändert den Raum. Stimmt dies, dann ändert sie all seine Eigenschaften und eine seiner Eigenschaften ist die mittlere Bewegungsenergie seiner Gase. Die Wissenschaft hat dafür den Begriff „Temperatur“ eingeführt und misst diese Energie in °C oder °K.

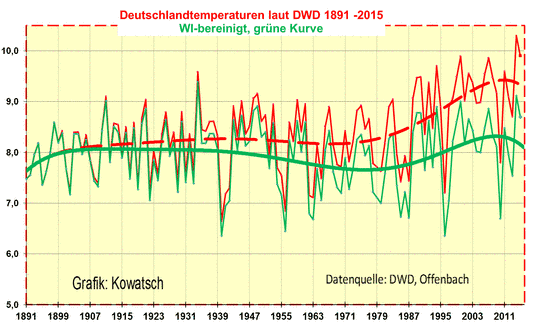

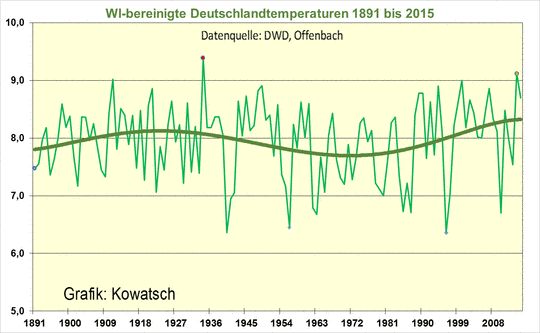

Wäre die Welt und Deutschland genauso geblieben wie im Diagramm-Startjahr 1891 in Abb.1 (nach DWD-Daten):

– die gleiche Einwohnerzahl

– der gleiche, geringe Lebensstandard

– der geringe Energieverbrauch und würden die Temperaturmessstationen

– auch noch am gleichen Standort stehen wie damals, z.B. bei unbeheizten Klöstern, bei Forsthäusern am Waldrand, bei noch viel kleineren Ansiedlungen oder bei Fischerhütten am Fischteich, dann sehen die gemessenen Temperaturen des Deutschen Wetterdienstes ganz anders aus.

Wir wollen dem DWD damit nicht unterstellen, dass er falsch misst, sondern, dass seine Vergleichsbetrachtungen von heute zu früher falsch sind, weil der DWD sozusagen das o.g. Postulat Einsteins nicht berücksichtigt und Einsteins Erkenntnis nicht in die Temperatur- Vergleichsbetrachtungen mit einbezieht. Verstärkt wird der Fehler in den Vergleichsbetrachtungen durch geänderte Messwertsysteme, räumliche Verlagerung, sowie geänderte Erfassungszeiten und andere Datenmengen (wie oft wird z.B. gemessen = Basis des Mittelwertes). Ändert sich jedoch die Basis des Mittelwertes, so ändert sich auch der Mittelwert selbst. Diese Gegebenheiten sind in den Korrekturberechnungen von R. LEISTENSCHNEIDER enthalten.

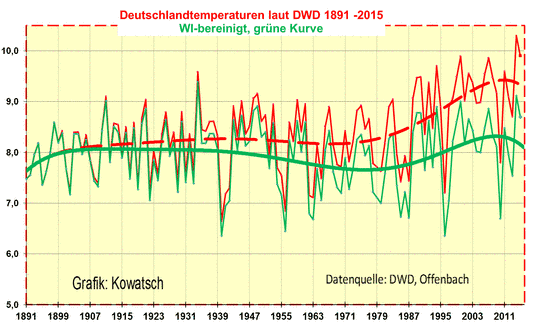

Wird diese Berechnung vorgenommen und der flächenmäßige WI, in dem diese Veränderungen zusammengefasst sind, in den Vergleichsbetrachtungen berücksichtigt, so zeigt die folgende, grüne Temperaturkurve den korrekten Temperaturvergleich der letzten 125 Jahre.

Abbildung 1: Die WI-bereinigten Deutschlandtemperaturen. Die hier dargestellte WI- Bereinigung (Berechnung: R. LEISTENSCHNEIDER) entspricht der Vergleichsbetrachtung der DWD-Referenzstation Hohen Peißenberg (diese wird vom DWD selbst als Referenz ausgewiesen) mit den gemessenen Deutschlandtemperaturen des DWD. Es handelt sich also bei dem zu Grunde gelegten Datenmaterial um Original-DWD-Messwerte. Basis der Überlegungen von R. LEISTENSCHNEIDER bilden zwei fundamentale physikalische Gesetze:

– Strahlungsgesetz nach Plank

– Abkühlungsgesetz nach Newton

Die Berechnung ergibt eine Wärmeinselerwärmung für den DWD-Temperaturdatensatz Deutschland von 0,9°C – 1,2 °C für die letzten 125 Jahre, wobei sich ab ca. 1980 der WI-Anstieg beschleunigt. Folgende WI-Werte ergeben sich:

– 1881 – 1952 = +0,2°C

– 1953 – 1982 = +0,3°C

– 1983 – 2009 = +0,6°C

Der erhöhte WI ab 1983 deckt sich im Übrigen mit den Untersuchungen des Instituts für Meteorologie der Freien Universität Berlin in seiner Ausarbeitung: “Vor- und Nachteile durch die Automatisierung der Wetterbeobachtungen und deren Einfluss auf vieljährige Klimareihen“. Siehe hierzu (http://www.eike-klima-energie.eu/climategate-anzeige/sommerhitze-2015-klimawandel-oder-normales-wettergeschehen-teil-1/)

Die o.g. Bandbreite 0,9°C – 1,2°C hängt davon ab, inwieweit Raumveränderungen an der Referenzstation HPB berücksichtigt werden oder ob nicht. Wir geben den flächenhaften WI-Effekt daher mit einer Streubreite von 0,3°C an.

Das ständig wechselnde Auf und Ab der Temperaturen hat bekanntlich viele natürliche Gründe, wie Sonnenschein, Sonnenaktivität und Großwetterlagenänderungen. Der Anstieg in der DWD-Reihe ist indes größtenteils auf den flächenhaften zunehmenden WI-Effekt zurück zu führen.

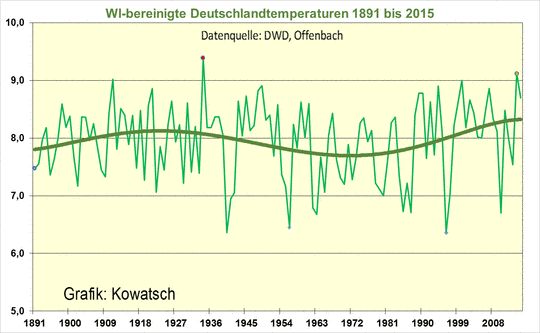

Abbildung 2: Deutlich zu sehen, dass der größte Teil der vom DWD gemessenen Erwärmung der letzten 125 Jahre auf den stetig steigenden Wärmeinseleffekt zurückzuführen ist. Von der postulierten, angeblichen C02-Erwärmung ist nach der WI-Bereinigung nichts mehr übrig. WI-bereinigt wäre 1934 das wärmste Jahr und nicht 2014. Auch haben wir WI-bereinigt zwischen 1955 und 1980 ein Kälteloch. In dieser Zeit waren Politik und Medien übrigens schon einmal falsch unterwegs: Befürchteten sie doch eine beginnende Abkühlung.

Der DWD gibt auf Nachfrage mittlerweile zu, dass seine erhobenen Daten nicht wärmeinselbereinigt sind. Man erhebe die Daten vom heutigen Deutschland und vergleiche mit früher und da gäbe es nun mal eine Erwärmung, meinte der DWD. Alles richtig, nur darf man so nicht vergleichen, denn dann vergleicht man Äpfel mit Birnen (siehe auch die Aussage der TU Berlin, die in ihrem o.g. Artikel zur selbigen Aussage kommt).

Und weiter: Die Interpretation der Erwärmung überlasse man anderen. Wie unsere Abb.2 zeigt, kommt der Hauptteil der Erwärmung seit 1891 aus den immer weiter sich ausbreitenden Wärmeregionen, bzw. geänderte Messerfassung, in denen auch die DWD-Messstationen stehen/betroffen sind. R. LEISTENSCHNEIDER hat hierzu DWD-Stationen einem Belastungstest unterzogen, inwieweit diese für Vergleichsbetrachtungen (Messungen) geeignet sind, insbesondere Flughafenstationen (http://www.eike-klima-energie.eu/climategate-anzeige/was-sind-temperaturmessungen-auf-grossflughaefen-wert-oder-wie-das-zdf-mit-bewusst-falschen-temperaturaussagen-die-oeffentlichkeit-taeuscht-und-die-abkuehlung-in-deutschland-verschleiert/). Das Ergebnis: Gut 40% der DWD-Temperaturmessstationen sind für Vergleichsbetrachtungen zu früher nicht geeignet. Obwohl der DWD selbstverständlich korrekt misst, nur seine Vergleiche sind falsch oder, mit den Worten des DWD: Die Interpretation der Erwärmung überlasse man anderen und deren Aussage ist falsch.

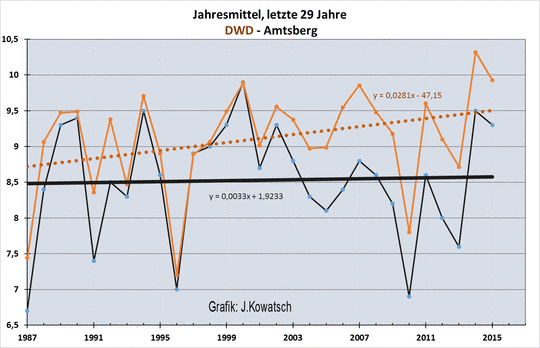

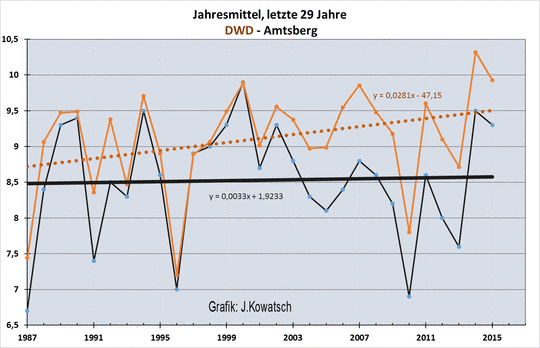

Der Idealfall zur Überprüfung unserer ermittelten WI-Größe wäre natürlich eine Region, die sich seit 1891 in ihrem weiten Umland nicht verändert hätte. Das gibt es aber nach Einstein nicht. In den alten Bundesländern wurden wir dahingehend fündig, eine Station in Amtsberg, am Fuße des Erzgebirges zu finden, die seit 1982 eine Wetterstation, in einer fast gleich gebliebenen Umgebung hat, in 425 Metern Höhe und daher mit vergleichsweise geringen WI-Änderungen behaftet ist.

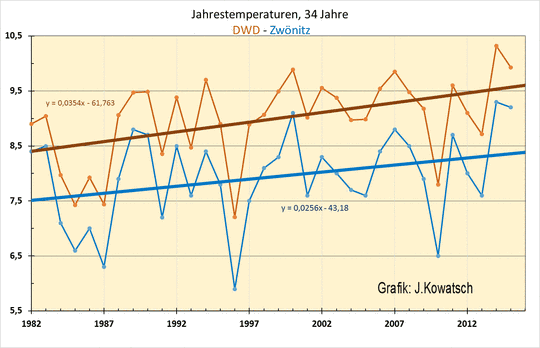

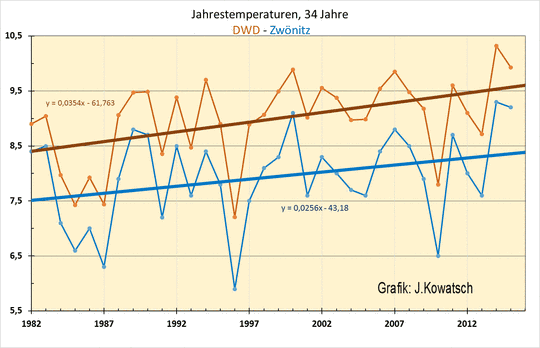

Eine weitere Station: Mitten im Erzgebirge auf 550m Höhe liegt die Kleinstadt Zwönitz, die im Vergleich zu westdeutschen Kleinstädten seit 1982 bis auf die letzten fünf, sechs Jahre noch keine übermäßig große Urbanisierung in der Fläche erfahren hat (Der Volksmund sagt dazu: Da ist die Zeit stehen geblieben). So dass die Station (ihr Standort) als eine Station, mit einem mäßigen flächenhaften Wärmeinseleffekt zu kategorisieren ist. Zur Erinnerung: Der flächenhaft sich entwickelnde WI betrachtet die Umgebungsveränderungen einer Station und vergleicht deren Messwerteentwicklung mit denen, vor den Änderungen, um Auffälligkeiten in den Temperaturgängen zu einer Referenzstation zu erkennen.

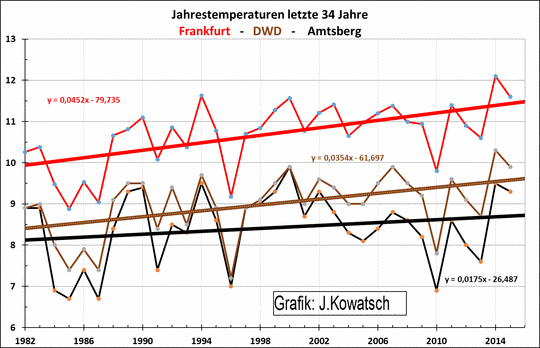

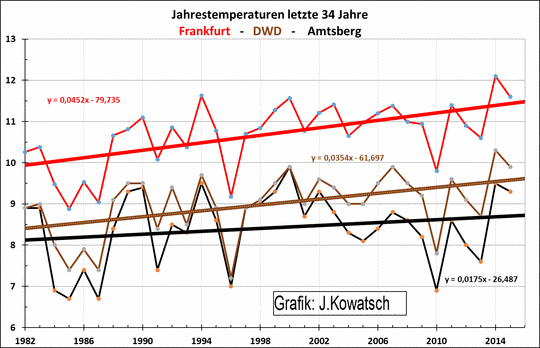

Folgend werden vier Standorte über die letzten 34 Jahre betrachtet (ab dem o.g. Jahr 1982). Als einen Standort mit dem höchsten WI-Effekt haben wir den Frankfurter Flughafen beschrieben (siehe http://www.eike-klima-energie.eu/climategate-anzeige/was-sind-temperaturmessungen-auf-grossflughaefen-wert-oder-wie-das-zdf-mit-bewusst-falschen-temperaturaussagen-die-oeffentlichkeit-taeuscht-und-die-abkuehlung-in-deutschland-verschleiert/).

Im Folgenden werden die Temperaturreihen dieser drei Standorte dargestellt, immer im Vergleich mit dem vom DWD erhobenen Deutschlandmittel. Wir wollen die Frage beantworten, wie sich die Temperaturreihen zueinander verhalten.

Abbildung 3: Vom Startjahr 1982 gehen die beiden Trendlinien leicht auseinander. Die Gesamtheit aller DWD-Messstationen hat zusammen einen etwas höheren WI-Effekt als die Kleinstadt Zwönitz. Auch die ermittelten Steigungsformeln zeigen dies.

Das folgende Diagramm vergleicht die Klimastation am Frankfurter Flughafen mit der fast WI-freien Station Amtsberg und mit dem Mittel der Deutschlandtemperaturen, erhoben vom DWD.

Abbildung 4: Auffällig ist die Entwicklung der Temperaturreihe des Frankfurter Flughafens im Vergleich zur weitgehend WI-freien Station Amtsberg. Die Spreizung ist deutlich und sie beträgt nach 34 Jahren etwa 1,1 °C Mehrerwärmung gegenüber dem Vergleichsjahr 1982. Die Trendlinie des DWD-Mittels liegt etwa in der Mitte.

Wir betonen nochmals, diese starke WI-Erwärmung des Frankfurter Flughafens ist auch eine menschengemachte Erwärmung, sie hat aber nichts mit einem CO2-Treibhauseffekt zu tun. Darin spiegelt sich vielmehr das erhöhte Flugaufkommen der letzten Jahre. Die Erwärmung basiert auf den heißen Triebwerksabgasen. Ob der DWD für diese Erkenntnis eine teure Messstation braucht oder das erhöhte Flugaufkommen auch hätte leichter erfahren können, darüber lässt sich gewiss streiten. Siehe hierzu auch unseren o.g. EIKE-Artikel und folgende Abb.5.

Abbildung 5 zeigt die Wetterstation auf dem Frankfurter Flughafen. Sie liegt nicht nur sehr nah am Rollfeld (ca. 70m), sondern in direkter Richtung zu den Abgasstrahlen der Jets, wie in der rechten Abbildung zu sehen. Das Bild erinnert frappierend an die Zustände auf dem Flughafen Rom, wie von Anthony Watts gezeigt wird (http://wattsupwiththat.com/2009/03/28/how-not-to-measure-temperature-part-86-when-in-rome-dont-do-as-the-romans-do/).

Beide Bilder sprechen für sich und bedürfen keiner weiteren Erklärung, was die Temperaturmesswerte dieser Stationen wert sind. Hält man sich vor Augen, dass über 50% aller globalen Messwerte, die das IPCC für seine globalen Temperaturreihen verwendet, von solchen Flughafenstationen stammen, wird schnell klar, was die globalen Temperaturaussagen des IPCC und seiner nahen Institute wert sind: Nichts!

Abbildung 6 zeigt alle vier Stationen zueinander:

Abbildung 6: Die Trendlinien der vier Standorte sind aufgrund der unterschiedlichen Zunahme an Wärmeinseleffekten seit 1982 auch unterschiedlich steigend. Zwönitz zeigt seit 2006 eine Erwärmungszunahme, sonst wäre die Trendlinienspreizung gegenüber der braunen DWD-Trendlinie noch größer.

Ergebnis: Die Trendlinien von Frankfurt (rot), DWD (braun), Amtsberg (dunkel) und Zwönitz (blau) spreizen sich immer mehr.

Fazit: Auch im fast WI-freien Amtsberg ist eine leichte Erwärmung in den letzten 34 Jahren festzustellen, die auf der Zunahme der solaren Aktivität beruht (Abb.7 und Abb.8).

Abbildung 7: (Quelle: http://bobtisdale.blogspot.com/2008/08/reference-graphs-total-solar-irradiance.html) zeigt die PMOD-TSI-Kurve von 1900 – 2007 (blau, vor 1980 rekonstruiert) und in rot die Satelliten-ACRIM-TSI-Kurve. Deutlich ist erkennbar, dass die solare Aktivität zum ausgehenden 20. Jahrhundert deutlich ansteigt und ihr Maximum erreicht. Dies wird noch mehr in der Abbildung rechts deutlich, wird jeweils der polynomische Trend angelegt. Anzumerken ist noch, dass der 23. Zyklus aufgrund der anderen Messcharakteristik von ACRIM III gegenüber ACRIM I im Vergleich zu seinen beiden Vorgängerzyklen gedämpft ist, also, würde auf ACRIM I normiert, nochmals höher ausfiele. Sie sehen, auch hier die Vergleichsproblematik aufgrund anderer Rahmenbedingungen,

Werden die NASA-Satellitenmessungen ab 1980 mit den rekonstruierten TSI-Werten zusammengefahren, so ergibt sich die nachfolgende Datenreihe links in Abb.8.

Abbildung 8: Die Datenreihe zeigt den TSI von 1850 bis 2007. Sie passt deutlich besser zur Protonenaktivität (Hochenergie: >10 MeV) der Sonne, die als Maß ihrer Gesamtaktivität gilt, Abbildung rechts, Quelle: NOAA Space Environment Center. Ebenso zum Hauptsonnenzyklus, dem im Mittel 208-jährigen de Vries/Suess-Zyklus, der in 2003 sein Maximum hatte und der den Schwabe-Zyklus unmittelbar beeinflusst, sowie zur Aussage der Max Planck Gesellschaft aus 2004, “Sonne seit über 8.000 Jahren nicht mehr so aktiv wie heute“.

Abb 7 und 8 zeigen: Mitte der 1970-Jahre lag die solare Aktivität auf einem vergleichsweise geringen Niveau, was nicht nur in Deutschland zu einem Kälteeinbruch bei den Temperaturreihen führte. In Abb.2 wird dies für im Temperaturgang deutlich. Ab 1987/88 zeigen alle Stationen einen Temperatursprung (siehe solare Aktivität) und bleiben dann auf einem höheren Niveau. Ab diesem Zeitpunkt hat Amtsberg eine fast ausgeglichene Trendlinie.

Abbildung 9: Die vergleichsweise WI-freie Station Amtsberg hat bereits seit 29 Jahren eine fast ausgeglichene Trendlinie. Das Klima ist seitdem recht stabil und die Berechnung von R. LEISTENSCHNEIDER zeigt, dass dies auch in Deutschland ohne die beschriebenen Veränderungen so ist – die Vergleichstemperaturen, aufgrund der Raumänderung, die sich im Flächen-WI widerspiegelt, anders sind, als der DWD dies in seinen statischen Messwerten und damit ungeeigneten Vergleichswerten zeigt. Die festgestellte WI-Erwärmung ist z.B. auf die geänderte Landnutzung, auf die Ausbreitung der Wärmeinseln zurückzuführen, sowie auf geänderte Messwerteerfassung (siehe Untersuchungen der TU Berlin).

Eingangs zeigten wir, dass der DWD anhand seiner Datenbasis zu einer Erwärmung für Deutschland von ca. 1,8°C für die vergangenen 125 Jahre kommt. Wir konnten belegen, dass davon ca. 1°C auf den flächenmäßigen WI zurückgeht. Wir wollen anhand der bereits erwähnten DWD-Referenzstation HPB noch zeigen, auf was die verbliebenen 0,8°C basieren.

Abbildung 10 links zeigt die Temperaturentwicklung am HPB von 1786 – 2006. Deutlich ist ein natürliches Schwingverhalten zu sehen, deren Periode bei ca. 206 Jahren liegt (Maxima der 5 und 10-Jahrestrends). Diese Schwingung stimmt exakt mit dem Hauptsonnenzyklus, dem im Mittel 208-jährigen de Vries/Suess-Zyklus überein, der in 2003 sein (im Mittel) 208-jähriges Aktivitätsmaximum hatte, als ganz Europa unter einem Jahrhundertsommer stöhnte.

Abbildung 10 rechts, Quelle: Hathaway et al. 1999 ”A synthesis of solar cycle prediction techniques", Journal of Geophysical Research, 104 (A10), zeigt den aa-Index (gilt als Maß für die solare Aktivität) und den Schwabe-Zyklus (gepunktete Linie). Deutlich ist dieser im aa-Index abgebildet. Im 20. Jahrhundert steigt dieser parallel zum de Vries/Suess-Zyklus stark an. Temperaturverlauf der DWD-Referenzstation HPB und solare Aktivität sind identisch.

Ergebnis

Die Zunahme der Wärmeinseln brachte Deutschland den Großteil des gemessenen Temperaturanstiegs von 1,8°C. Durch die Berechnung von R. LEISTENSCHNEIDE und den Stationsvergleichen konnten wir zeigen, dass der WI-Effekt mit rund 1°C der Haupttreiber der gemessenen Temperaturzunahme darstellt. Ohne die WI-Effekte wäre die gemessene (!) Erwärmung Deutschlands in den letzten 150 Jahren viel moderater ausgefallen. Nämlich nur um den durch die solare Aktivitätszunahme verursachten 0,8°C Temperaturanstieg.

Die tatsächliche Temperaturentwicklung Deutschlands zeigen die Messstationen, deren Umgebungs- und damit Raumveränderungen gering sind, denn:

Die Zeit ändert den Raum und damit alle seine Eigenschaften und eine seiner Eigenschaften ist seine Temperatur. Also müssen für Vergleichsbetrachtungen diese Raumänderungen herausgefiltert (gerechnet) werden.

Vor diesem Hintergrund sind alle Temperaturzeitreihen des DWD, für Vergleichsbetrachtungen ungeeignet und liefern falsche Aussagen und Schlussfolgerungen.

Fazit

Der Haupttreiber der gemessenen Erwärmung seit 1891 ist menschengemacht. Es handelt sich jedoch nicht um eine C02-Erwärmung (dessen Temperatursignal konnte noch nirgends gefunden werden, auch nicht von der IPCC), sondern um die seitdem anhaltende Urbanisierung in die freie Landschaft hinein und durch Messwerterfassungsänderungen. Diese Urbanisierung der Landschaft geht natürlich weiter, da sich die Menschen und Menschheit weiter entwickeln. Täglich werden in Deutschland etwa 110ha überbaut und weltweit etwa 50 km2 Regenwald täglich gerodet. Allein jedes zusätzliche (energetisch und damit volkswirtschaftlich unsinnige) Windrad zerstört 1ha freie Fläche.

Die politische Vorgabe einer CO2-Minderung ändert nichts am weiteren Temperaturverlauf, sondern führt vielmehr der Natur und der Menschheit erheblichen Schaden zu, sofern eine CO2-Minderung überhaupt durchsetzbar wäre. Direkt, durch ein falsches Lenkungsprinzip, hin, zu unsinnigen, allein nicht überlebensfähigen und damit hoch subventionierten Industriezweigen und zeitverzögert, wird dadurch das Wachstum aller Pflanzen behindert.

Denn deren Wachstum ist unmittelbar von CO2 abhängig. Diese haben ihr Optimum bei ca. der 2-3-fachen CO2-Menge in der Atmosphäre wie heute, was, würde tatsächlich der atmosphärische CO2-Gehalt verringert, zu Ernteausfällen führt. Zudem würden sich die Wüsten weiter ausbreiten. Ein Zusammenhang, den die NASA bereits vor mehr als 10 Jahren festgestellt hat. Eine CO2-Minderung wäre somit schädlich für das Leben auf der Erde.

In der CO2-Debatte in Politik und Medien geht es erkennbar nicht um die Aufklärung der Öffentlichkeit anhand belastbarer Fakten, sondern um Stimmungsmache, zum Erreichen diverser Ziele. Zu denen Sensationsmache, Abgabenerhöhung und Bauernfängerei, zugunsten eigener politischen Ziele gehören. Insbesondere Lobbyisten, wie die Partei, die vermeintlich die Umwelt in ihrem Namen trägt, versuchen damit auf Stimmenfang zu gehen. Unser Artikel zeigt jedoch einmal mehr, dass kein Raum für Sensationen, Panikmache oder zum Abkassieren vorhanden ist. Möge jeder selbst entscheiden, ob er politischen Gauklern auf den Leim geht oder sich stattdessen über die naturwissenschaftlichen Zusammenhänge und Fakten bei unabhängigen Naturwissenschaftlern informiert.

Raimund Leistenschneider – EIKE

Josef Kowatsch, Naturbeobachter und unabhängiger Klimaforscher

Stefan Kämpfe, Diplom- Agraringenieur, unabhängiger Natur- und Klimaforscher