Frühlingsbeginn in Deutschland – zeitiger oder leicht verspätet?

Bild rechts: Märzenveilchen blühten dieses Jahr erst Ende März. Aprilveilchen wäre dieses Jahr der exaktere Name. Foto Kowatsch

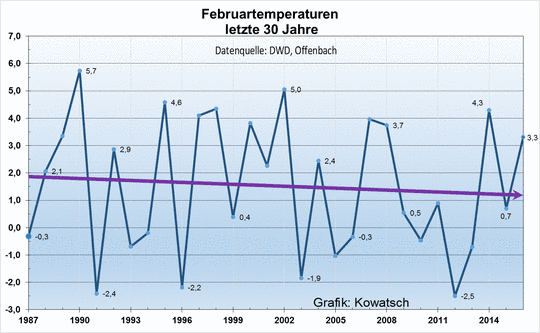

Wann der Frühling mit seinen ersten Boten wie Huflattich, Märzenveilchen, Scharbockskraut und Anemone erscheint, bestimmen vor allem die Temperaturen des letzten Wintermonates Februar und des ersten Frühlingsmonates März. Die Frühblüher könnten nur dann zeitiger erscheinen, wenn auch die Temperaturen in diesen beiden Monaten deutlich wärmer geworden wären. Diese fälschlicherweise in den „Qualitätsmedien“ behauptete Erwärmung zeigen die offiziellen Daten des Deutschen Wetterdienstes (DWD) jedoch nicht. Diese Temperaturbetrachtungen anhand der Daten des Deutschen Wetterdienstes stehen im Mittelpunkt dieses Artikels. Schauen wir uns zunächst die Temperaturen der beiden Monate Februar/März über einen Zeitraum von 30 Jahren näher an. 30 Jahre sind nach dem WMO- Standard ein klimatisch relevanter Zeitraum. Die Daten des Deutschen Wetterdienstes in Offenbach zeigen:

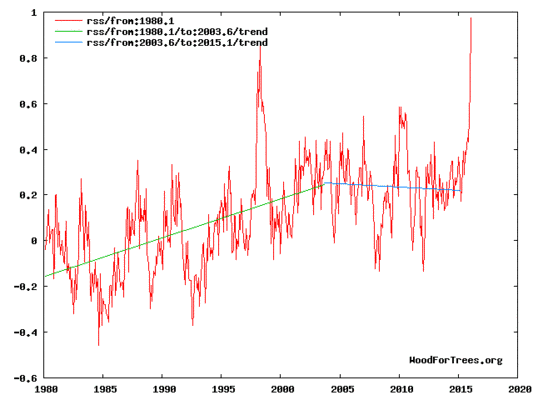

Bild 1: Das Ergebnis ist überraschend. Der Monat Februar wurde in den letzten 30 Jahren in Deutschland keinesfalls wärmer. Wir haben eine leicht fallende Trendlinie. Fallende Trendlinien sind das Gegenteil der ständigen Erwärmungsbehauptungen.

Diese Daten des Deutschen Wetterdienstes sind nicht wärmeinselbereinigt. Pflanzen aus den Vorgärten der meist wachsenden und wärmeren Siedlungen oder Ortschaften entwickeln sich schneller als solche in der freien, weniger wärmeinselbeeinflussten Landschaft. Von den etwa 2000 Messstationen des DWD stehen nur wenige in der freien Landschaft, die meisten befinden sich in oder am Rande der Ortschaften und Städte oder gar an den Landebahnen der Flughäfen im Strahl der gut 600 C heißen Flugzeugabgase.

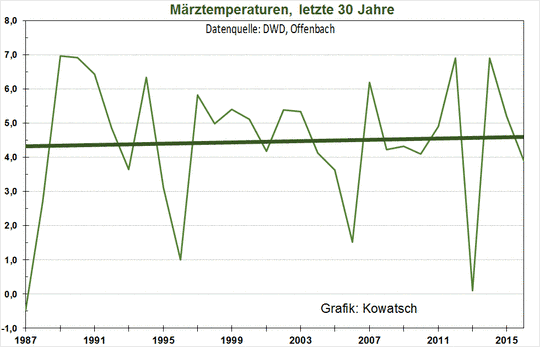

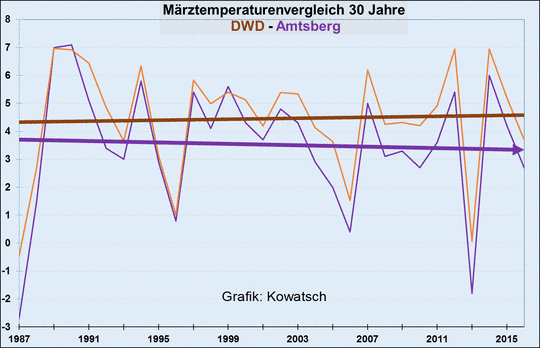

Abb.2: Die Temperaturkurve des ersten Frühlingsmonats März zeigt über die letzten 30 Jahre nur eine sehr geringe, nicht signifikante Erwärmung.

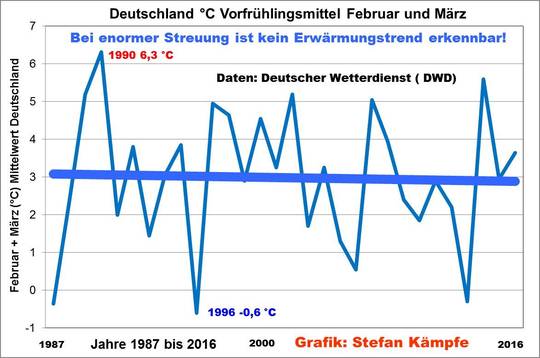

Die CO2-Erwärmungsgläubigen stuften diesen Winter und vor allem den Februar als besonders mild ein. Dieser angeblich steigende Vorfrühlingstrend der letzten Jahre werde anhalten und die „Erwärmungstendenz“ sich beschleunigen, so die Falschmeldungen. Die Realität sieht anders aus. Betrachtet man den Gesamtzeitraum vom 1. Februar bis zum 31. März, so wird klar: Eine Erwärmung gab es im Spätwinter/Vorfrühling während der letzten 30 Jahre nicht (Abb. 3):

Abb. 3: Das Diagramm zeigt den Durchschnitt des Monates Februar und März. Im Spätwinter/Vorfrühling (Februar und März) blieb die von den „Klimamodellen“ vorhergesagte Erwärmung in Deutschland bislang aus. Die zusammengefasste Trendlinie beider Monate ist leicht fallend.

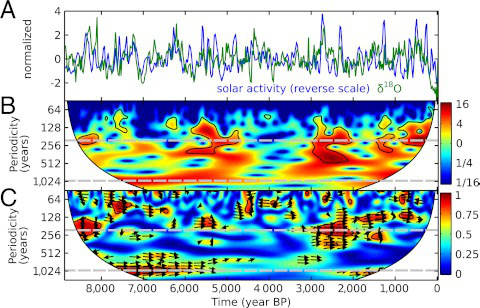

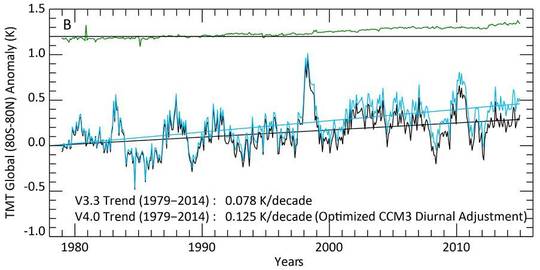

Aber weltweit soll doch dieser Februar neue Rekorde gebracht haben. Das würden sogar die Satellitendaten beweisen. Doch Vorsicht, diese sind gerade in jüngster Zeit noch oben korrigiert worden, um den langjährigen Stillstand per Softwareumschreibung zu beenden.

Näheres siehe hier: http://www.kaltesonne.de/university-of-alabama-in-huntsville-uah-lehnt-fragwurdige-veranderungen-am-rss-satelliten-temperaturdatensatz-ab/ Die folgende Grafik haben wir aus dem Link entnommen

Abb.4: Globale Temperaturentwicklung seit 1980 laut RSS. In schwarz die Original-Version, in blau die nachjustierte Kurve. Graphik aus Mears & Wentz 2016. Softwaremanipulation zur Bereinigung der tatsächlichen Werte, das kennen wir doch aus einem anderen Bereich.

Bleiben wir bei den Daten des Deutschen Wetterdienstes. Was bedeuten die drei ersten Grafiken für die Vegetation und den Frühlingsbeginn in Deutschland?

Die Autoren dieses Artikels verfügen über langjährige Berufserfahrungen auf den Fachgebieten Naturschutz und Pflanzenbau. Sie beobachten die Natur seit vielen Jahrzehnten. Zusätzlich werteten wir Literatur über Frühjahrsblüher und das Erwachen der Vögel und Kröten aus. Auch einige Frühlingskinderlieder und Frühjahrsgedichte sind mehr als hundert Jahre alt. Man kann ihre Aussagen mit der heutigen Realität des Frühlingsbeginns vergleichen.

Die blauen Veilchen werden seit jeher Märzenveilchen genannt, weil sie auch schon damals im März blühten. Wäre der März vor über 100 Jahren kälter gewesen, hätte man sie Aprilveilchen genannt. Auch die Winterlinge heißen so, weil sie oft schon im Januar oder Februar blühen, heute genauso wie in früheren Zeiten.

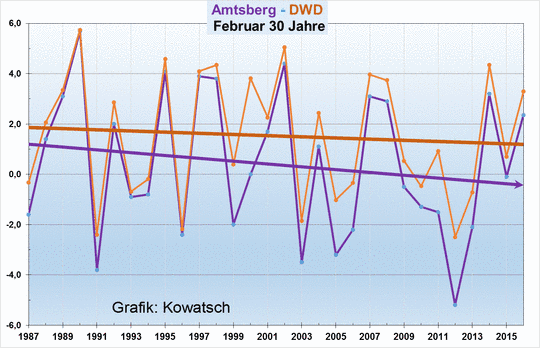

Für vergleichende Vegetationsbeobachtungen sollte die freie Natur außerhalb der Wärmeinseln an unveränderten Örtlichkeiten bevorzugt werden. Mit Amtsberg-Dittersdorf haben wir sogar einen kleinen Ort mit privater Wetterstation am Fuße des Erzgebirges gefunden, den man zumindest für die letzten 30 Jahre als fast WI-frei bezeichnen kann.

Abb.5. Die braune Trendlinie sind die Aufzeichnungen des Deutschen Wetterdienstes wie in Grafik 1. Orte wie Amtsberg am Fuße des Erzgebirges, deren Umgebung sich in den letzten 30 Jahren kaum verändert hat, zeigen einen viel stärkeren Abwärtstrend der Februartemperaturen als der Mittelwert der DWD-Stationen.

Ergebnis: In der freien Fläche ist der Februar in den letzten 30 Jahren deutlich kälter geworden. Ohne Bevölkerungswachstum, Industrialisierung und Urbanisierung in die freie Fläche hinein wären die heute in Deutschland gemessenen Februartemperaturen um etwa ein Grad Celsius niedriger.

Den Monat März in Amtsberg im Vergleich zu dem Gesamtschnitt der Stationen des Deutschen Wetterdienstes zeigt das nächste Diagramm. Die DWD-Erhebungen sind in brauner Farbe dargestellt und entsprechen der Abb. 2

Auch der März folgt nicht dem Orakel der Erwärmungsverkünder. Er kühlte sich im WI-armen Standort Amtsberg leicht ab, auch wenn es 2012 und 2014 zwei sehr warme Monate gab. Der März 2016 lag im unteren Drittel der letzten 30 Jahre:

Abb.6 Fast wärmeinselfreie Orte wie Amtsberg-Dittersdorf (blau-violett) haben seit 30 Jahren eine leicht fallende Trendlinie im März.

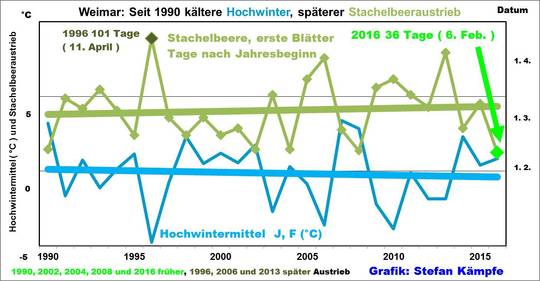

Ein wichtiger Zeiger für den Beginn des sogenannten „Erstfrühlings“ ist die Laubentfaltung der Wild- Stachelbeere (Ribes uva- crispa). Diese fällt in klimatisch durchschnittlichen Regionen Deutschlands, zu denen auch die Kleinstadt Weimar/Thüringen zählt, meist in den Zeitraum um Anfang März.

Abb. 7: Die ersten, entfalteten Laubblätter der Wild- Stachelbeere zeigen den Beginn des Erstfrühlings an. Foto: Stefan Kämpfe

Einer der beiden Autoren, der Botaniker, Phänologe und Klimaforscher STEFAN KÄMPFE, hat seit 1990 im Park an der Ilm, der wegen seines Denkmalschutzes inklusive seiner näheren Umgebung weitgehend unverändert blieb, den Stachelbeeraustrieb dokumentiert. Zwar gab es im Jahr 2016 den bisher frühesten Laubaustrieb, doch konnte dieser den leichten, seit Beobachtungsbeginn erkennbaren (nicht signifikanten!) Verspätungstrend nicht ausgleichen:

Abb. 8: Achtung: Eine steigende Trendlinie heißt Verspätung. Auf der x-Achse sind die Tage nach Neujahr aufgetragen. In Weimar zeigt sich seit 1990 keine Verfrühung des Wildstachelbeer- Austriebes- im Gegenteil!

Auf den Stachelbeer- Austrieb hat freilich der März fast keinen Einfluss, umso mehr aber das Temperaturniveau der vorangehenden Wintermonate. Trotz eines eher kühlen Januars erfolgte der Austrieb 2016 so zeitig, weil es einen rekordmilden Dezember 2015 gab. In den meisten Fällen bestimmt jedoch das Temperaturniveau der Monate Januar und Februar den Zeitpunkt des Austriebes:

Abb. 9: Geringfügig fallende Temperaturmittelwerte im Januar/Februar an der Station Erfurt/Weimar, etwas späterer Stachelbeeraustrieb. Wegen der großen Streuung sind die Trends nicht signifikant, von einer „Verfrühung“, wie sie viele Klimaforscher vorhergesagt haben, ist jedoch nichts zu sehen.

Im Jahr 2016 „schleppten“ sich Vor- und Erstfrühling auch deshalb so quälend lange hin, weil die wärmende Sonne viel zu selten schien (Februar und März waren sehr sonnenscheinarm). So konnten sich auch Pflanzen an windgeschützten Südhängen diesmal nicht schneller entwickeln. Wegen des extrem milden Dezembers dauerte die Haselblüte in Weimar rekordverdächtige 118 Tage, auch Schwarzerle, Schneeglöckchen, Winterlinge, Krokusse, Märzenbecher und die Kornelkirsche blühten anderthalb bis 3 Monate! Pollenallergiker klagten seit Mitte Dezember über Beschwerden, doch ist dies keine Folge des „Klimawandels“, sondern eine Folge der ungünstigen Wetterlagenverteilung: Viel mildes Süd- und Westwetter im Frühwinter, dann kälteres Nordwetter im Spätwinter. Unter http://www.eike-klima-energie.eu/climategate-anzeige/extremes-winterwetter-in-europa-der-waermeinseleffekt-und-das-maerchen-vom-co2-treibhauseffekt-teil-1-die-gegenwaertigen-witterungsextreme-und-wesentliche-hintergruende-der-erwaermung-in-deutschland/ hatten wir über die Ursachen dieser Witterungsextreme berichtet.

Abb. 10: Quälgeist Haselkätzchen: Von den allerersten Blüten (5. Dezember) bis zu den allerletzten (um den 31. März) vergingen diesmal in Weimar rekordverdächtige 118 Tage. Foto: Stefan Kämpfe

Fazit: Der Frühling beginnt seit 30 Jahren etwas später, weil die Temperaturen der Monate Februar und März laut den Temperaturerhebungen des Deutschen Wetterdienstes gleichbleibend oder sogar leicht sinkend sind. Und weil auch die Temperaturen im Winter stagnierten, lässt sich ebenfalls kein zeitigerer Vegetationsbeginn beobachten.

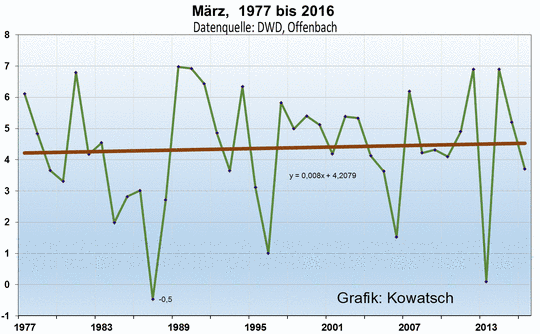

Gehen wir noch 10 Jahre weiter zurück in die Vergangenheit. Da ab dem Jahr 1977 fünf wärmere Märzmonate folgten, ist die Trendlinie des Monates März schon seit 40 Jahren fast ausgeglichen. Würden sich Pflanzen nur nach den Temperaturen richten, dann müsste die Forsythie dieses Jahr den gleichen Blütenbeginn wie um 1977 haben, falls nicht andere Faktoren wie winterharte Züchtungen auf die Pflanzen Einfluss gewonnen haben. In der freien Fläche und im Erzgebirge müsste die Verspätung deutlich erkennbar sein.

Abb. 11: Der erste Frühlingsmonat März zeigt laut Temperaturangaben des Deutschen Wetterdienstes schon seit 40 Jahren eine fast ebene Trendlinie. Die Erwärmung dieses Monates hörte schon vor 40 Jahren fast auf. Der Monat März ist somit der Monat, der am längsten sein Temperaturniveau hält und nicht mehr wärmer wird. Wärmeinselbereinigt würde er sogar eine leichte Abkühlung zeigen.

Wir möchten hier ausdrücklich betonen, dass die CO2-Konzentrationen in dem Zeitraum der letzten 30 bis 40 Jahre besonders gestiegen sind. Die Temperaturen Deutschlands halten sich nicht daran.

Warum können wir gegen die Erwärmungsfalschbehauptungen der Medien und des DWD nicht gerichtlich vorgehen? Die Führungsriege des DWD argumentiert schließlich gegen die eigenen Daten.

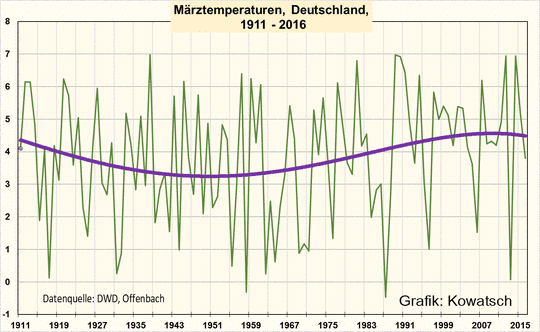

Die Antwort zeigt die letzte Grafik. Nahezu jeder Monat verhält sich über einen längeren Zeitraum wie der Monat März. Im letzten Jahrhundert gab es zwei Temperaturhöhen und eine Kältedelle um die Jahrhundertmitte

Abb.12: Um die Mitte des letzten Jahrhunderts war der März genauso wie die anderen Monate kälter als heute, auch kälter als in den 20er Jahren. Die Daten sind die Originaldaten des Deutschen Wetterdienstes, also nicht einmal wärmeinselbereinigt.

Im Zeitraum seit 1911 ist die CO2-Konzentration natürlich ständig gestiegen. Allein diese Grafik zeigt, dass der Erwärmungsglaube CO2-Treibhauseffekt nicht richtig sein kann.

Zum Temperaturvergleich ziehen sowohl DWD als auch die CO2-Erwärmungsgläubigen mitsamt den Medien immer die etwas tieferen Temperaturen der Jahrhundertmitte oder der 60er Jahre als Betrachtungszeitraum heran. Und die waren nun einmal kälter als heute, aber auch kälter als zu Beginn des letzten Jahrhunderts. Ironischerweise wird dieser Zeitpunkt des Kältelochs auch noch als „Normal“ bezeichnet. Ein Diagramm mit dem Startjahr beispielsweise 1966 zeigt deshalb eine 50ig jährige steigende Trendlinie bis heute. In Wirklichkeit sind es aber ein 20ig -jähriger Anstieg und seit 1987 ein 30ig -jähriger Stillstand bzw. wärmeinselbereinigt ein leichter Abfall. Lohnt es sich deshalb, vor Gericht zu gehen? Denn die Aussage, vor 50 Jahren waren die Winter, einschließlich März kälter als heute, würde sogar stimmen. Verschwiegen wird nur der Stillstand seit 30 Jahren.

Josef Kowatsch, Naturbeobachter und unabhängiger Klimaforscher

Stefan Kämpfe, Diplom- Agrar- Ingenieur, Naturbeobachter und Klimaforscher